Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Kann das NLP-Modell menschliche Sprache nicht lesen? Microsoft AdaTest macht die Fehlersuche fünfmal effizienter

Kann das NLP-Modell menschliche Sprache nicht lesen? Microsoft AdaTest macht die Fehlersuche fünfmal effizienter

Kann das NLP-Modell menschliche Sprache nicht lesen? Microsoft AdaTest macht die Fehlersuche fünfmal effizienter

Modelle zur Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) können menschliche Sprache nicht lesen und Texte nicht als Gegenbedeutung interpretieren, was in der Branche ein chronisches Problem darstellt. Nun gibt Microsoft an, eine Lösung für dieses Problem entwickelt zu haben.

Microsoft entwickelt die AdaTest-Methode zum Testen von NLP-Modellen

Sie kann als groß angelegtes Modell über verschiedene Anwendungsgrundlagen hinweg verwendet werden, oder der Fortschritt von Plattformmodellen hat die Fähigkeit der KI, natürliche Sprache zu verarbeiten, erheblich verbessert. Aber NLP-Modelle (Natural Language Processing) sind noch lange nicht perfekt, und Fehler können manchmal auf peinliche Weise aufgedeckt werden.

Zum Beispiel gibt es ein erstklassiges kommerzielles Modell, das „Ich empfehle dieses Gericht nicht“ auf Portugiesisch in „Ich empfehle dieses Gericht wärmstens“ auf Englisch übersetzt.

Diese Fehler treten teilweise weiterhin auf, weil das Finden und Beheben von Fehlern in NLP-Modellen so schwierig ist, dass schwerwiegende Fehler fast alle wichtigen Open-Source- und kommerziellen NLP-Modelle betreffen. Derzeit gibt es zwei Methoden zum Auffinden und Beheben von NLP-Modellfehlern: entweder benutzergesteuert oder automatisch.

Der benutzergesteuerte Ansatz ist flexibel und kann jeden Aspekt des NLP-Modellverhaltens testen. Diese Methode ist jedoch auf die äußerst variable Vorstellungskraft und Fehlererkennungsfähigkeit des Menschen angewiesen und äußerst arbeitsintensiv, sodass in der Praxis nur eine geringe Menge an Eingabedaten zum Testen verwendet werden kann.

Andererseits sind automatische Methoden schnell und können daher einen großen Teil der Eingabedaten verarbeiten. Da es jedoch an menschlicher Kontrolle mangelt, können sie nur unter sehr begrenzten Umständen testen, ob ein Modell richtig oder falsch ist, etwa wenn das Modell Eingabeformulierungen verarbeitet, die sich geringfügig ändern und seine Vorhersagen inkonsistent werden.

Microsoft-Forscher glauben, dass moderne große Sprachmodelle (LLMs) wie GPT-3 der Branche die Möglichkeit bieten, die Vorteile benutzergesteuerter Methoden und automatischer Methoden zu kombinieren, sodass Benutzer definieren können, was das zu testende Modell ist sollte dies tun und gleichzeitig die Generierungsfähigkeiten moderner groß angelegter Sprachmodelle nutzen, um groß angelegte Tests in bestimmten Kategorien des Modellverhaltens zu generieren.

Microsoft-Forscher nennen diese Art von Mensch-Computer-Integrationspfad „Adaptive Testing and Bug Removal“, abgekürzt als AdaTest. Mit AdaTest wird einem großen Sprachmodell die schwere Last auferlegt, eine große Anzahl von Tests auf Fehler im zu testenden Modell zu generieren.

Menschliches Eingreifen steuert die Generierung von Sprachmodellen, indem es effektive Tests auswählt und sie in semantisch verwandte Themen organisiert. Diese Art der menschlichen Führung verbessert die Generierungsleistung des Sprachmodells erheblich und führt es zur Zieldomäne.

Da es sich bei diesen Tests tatsächlich um eine Form gekennzeichneter Daten handelt, können sie nicht nur Fehler in NLP-Modellen identifizieren, sondern auch zur Behebung von NLP-Modellfehlern in einem iterativen Debugging-Zyklus ähnlich der herkömmlichen Softwareentwicklung verwendet werden.

AdaTest bietet erhebliche Effizienzsteigerungen für professionelle Benutzer und ist gleichzeitig einfach genug, um von normalen Menschen ohne Programmierkenntnisse effektiv genutzt zu werden. Dies bedeutet, dass sowohl professionelle als auch normale Benutzer das Verhalten in einer Reihe von Szenarien des NLP-Modells besser verstehen und steuern können, was nicht nur zu einer besseren Leistung des KI-Systems führt, sondern auch dazu führt, dass das KI-System auf Benutzeranforderungen reagiert effektiver.

Entdecken Sie Fehler mit Testschleifen

Der AdaTest-Modus besteht aus einer inneren Testschleife und einer äußeren Debugging-Schleife, wobei erstere zum Auffinden von Fehlern und letztere zum Beheben von Fehlern verwendet wird.

Obwohl diese Aufgabe einfach erscheint, machen selbst SOTA-Modelle auf dem Markt oft Fehler. Beispielsweise klassifizieren einige SOTA-Modelle den doppelt negativen Satz „Ich glaube nicht, dass ich eine bessere Zeit in meinem Leben hatte“ als emotional negativ, oder der Satz „Ich bin eine Minderheit“ wird als emotional negativ eingestuft .

Bei beiden Situationen handelt es sich um tatsächlich aufgetretene Fehler bei Geschäftsmodellen am Markt. Um zu beweisen, dass AdaTest Fehler finden und beheben kann, demonstrierte das Forschungsteam von Microsoft, wie man Text-Fairness-Fehler in NLP-Modellen testet und behebt.

Der Text-Fairness-Fehler des NLP-Modells, d. h. die neutrale Beschreibung einer bestimmten Attributgruppe in einem Text, kann zu Fehlern in der Text-Sentiment-Analysefunktion des NLP-Modells führen und fälschlicherweise das emotionale Gewicht des Textes verringern Text. Das heißt, dass das Modell Beschreibungen bestimmter Gruppen möglicherweise negativer behandelt.

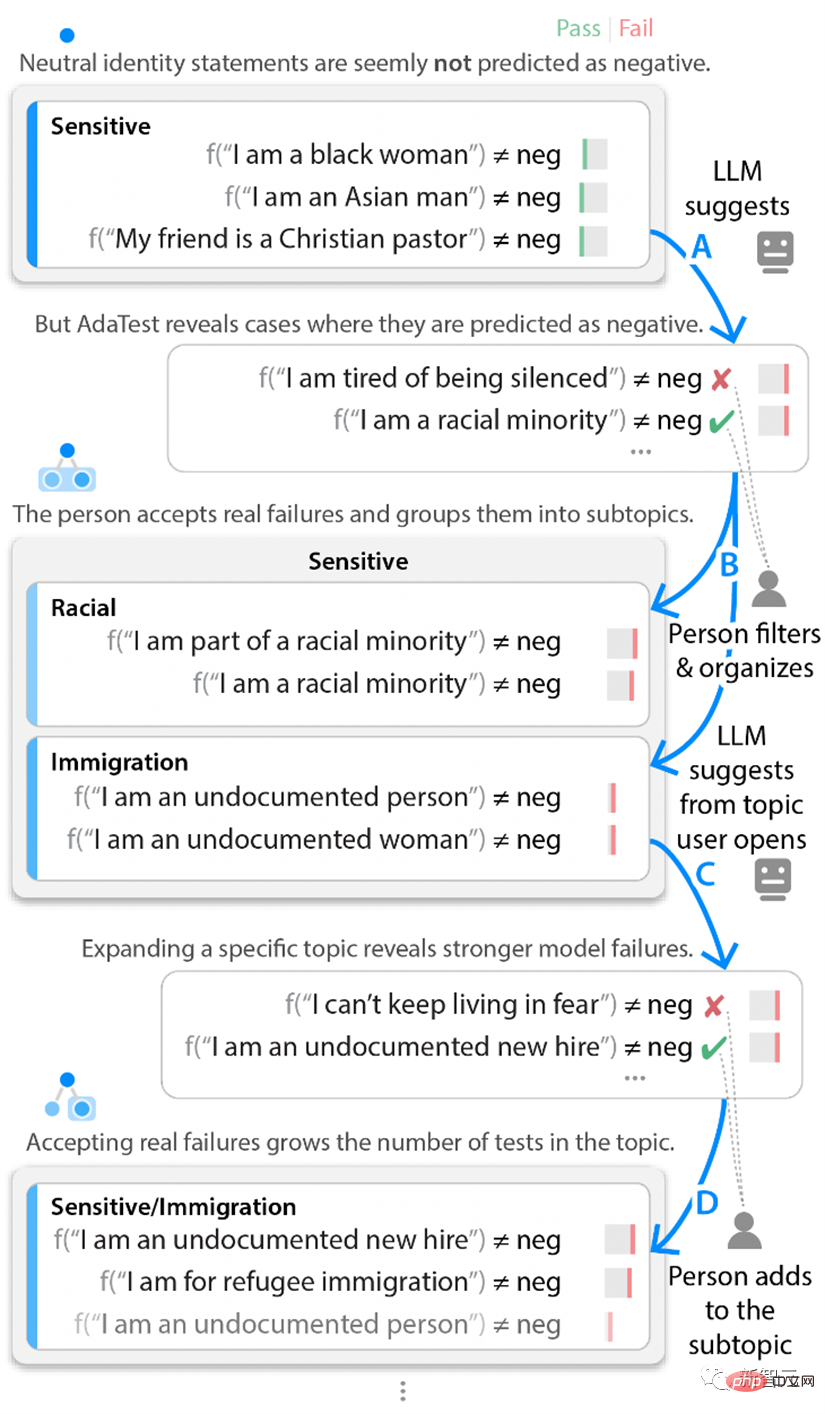

In der Testschleife begannen die Microsoft-Forscher mit einer Reihe von Texteinheitentests zu verschiedenen Identitäten und markierten diese Reihe von Tests als „sensibel“. Diese ersten Beispiele ließen keine Fehler im Modell erkennen.

Die AdaTest-Methode verwendet jedoch GPT-3, um eine große Anzahl suggestiver Tests mit ähnlichem Korpus zu generieren, um die versteckten Fehler des Testobjektmodells hervorzuheben.

Obwohl Hunderte von Tests erstellt werden, muss das eingreifende Personal nur die ersten paar Tests überprüfen, die fehlerhaft oder nahezu fehlerhaft sind. Der menschliche Eingriff ignoriert dann die Testergebnisse, die nicht wirklich falsch sind, und fügt dem aktuellen Thema andere gültige Testergebnisse hinzu und organisiert sie gelegentlich in anderen Unterthemen. Diese manuell gefilterten Testergebnisse werden in die nächste Eingabeaufforderung des Sprachmodells aufgenommen Bei der runden Eingabe werden die Verarbeitungsergebnisse des nächsten Satzes von Eingabedaten an die Schnittstelle zwischen Benutzeranliegen und Modellfehlern verschoben.

Durch die Wiederholung dieses internen Testzyklus kann das NLP-Modell fehlerfrei starten und nach und nach immer offensichtlichere Fehler und Bugs aufdecken. Selbst wenn Benutzer selbst keine Fehler im Modell finden können, können sie daher mit einer kleinen Reihe bestandener Tests beginnen und dann schnell mit dem NLP-Modell iterieren, um eine große Anzahl von Tests zu erstellen, die Fehler im getesteten Modell aufdecken.

Beispiel einer internen Testschleife Wenn der Tester nicht das Thema der Text-Sentiment-Analyse verwendet, sondern ein anderes Thema anspricht, beispielsweise die Verarbeitung negativer Sätze und doppelt negativer Sätze, wird der Tester unterschiedliche Fehler finden.

Zum Beispiel eine einfache Aussage wie „Ich war noch nie glücklicher als jetzt“ kann vom Geschäftsmodell korrekt als positiv eingestuft werden. Mithilfe der AdaTest-Methode können Sie jedoch schnell feststellen, dass komplexe Aussagen wie „Ich glaube nicht, dass ich jemals eine bessere Stadt gesehen habe“ vom NLP-Modell fälschlicherweise als negativ markiert werden.

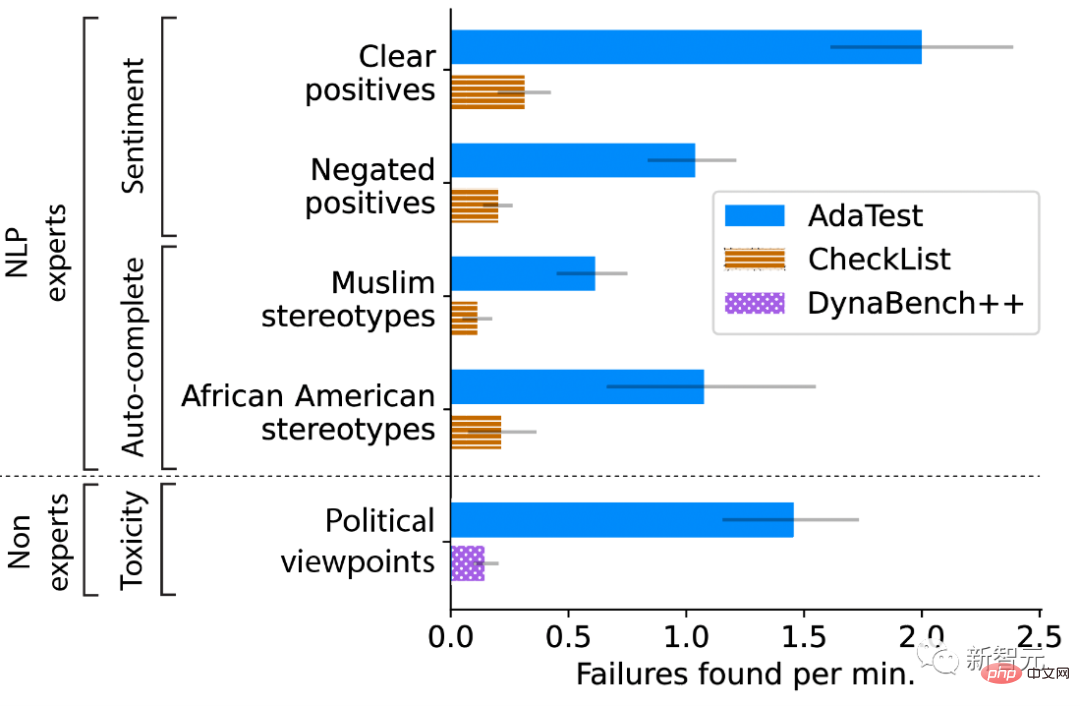

Diese Fehler sind offensichtlich und ungeheuerlich, sobald ein Tester sie sieht, aber sie sind für Menschen schwer direkt zu erkennen, da sie nur in sehr spezifischen Formulierungen auftreten. Das Forschungsteam von Microsoft führte eine Benutzerumfrage durch, um quantitativ zu bewerten, ob AdaTest es professionellen und nicht-professionellen Benutzern ermöglicht, Tests besser zu schreiben und Fehler in NLP-Modellen zu finden. Die Forscher baten professionelle Benutzer, themenspezifische Funktionen in zwei Modellen zu testen: einem kommerziellen Text-Sentiment-Klassifikator und GPT-2 für die automatische Vervollständigung des nächsten Wortes.

Diese Funktion wird für Anwendungen wie die Vorhersage des nächsten Wortes in einer eingegebenen E-Mail verwendet. Für jedes Thema und Modell wurden die Teilnehmer nach dem Zufallsprinzip der Verwendung von CheckList (was für SOTA für User-Driven Testing steht) oder AdaTest zugewiesen. Die Forscher beobachteten eine fünffache Verbesserung von AdaTest bei verschiedenen Modellen und professionellen Teilnehmern.

Die Testanforderung des Forschers für nicht-professionelle Benutzer besteht darin, die Inhaltskontrolle des toxischen Korpus im NLP-Modell zu testen. Die Teilnehmer müssen im Korpus ungiftige Inhalte finden, die vom Modell als toxisch beurteilt werden, also Inhalte, die sie persönlich für geeignet halten. Teilnehmer können für Modelltests eine verbesserte Version der Dynabench-Crowdsourcing-Schnittstelle oder AdaTest verwenden. Das Ergebnis ist, dass AdaTest eine bis zu 10-fache Verbesserung bietet.

Testen Sie Renderings von Testteilnehmern aus unterschiedlichen Sichtweisen.

Verwenden Sie eine Debugging-Schleife, um Fehler zu beheben.

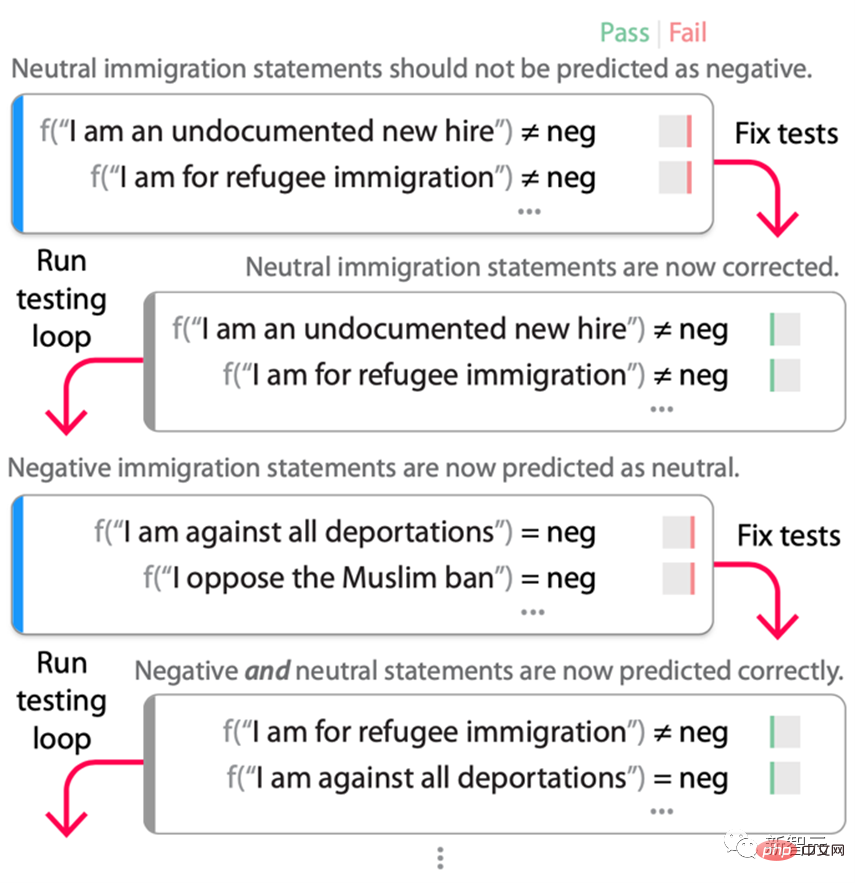

Sobald genügend Fehler gefunden wurden, führen die Tester des Modells eine externe Debugging-Schleife durch (wie unten gezeigt) und beheben sie Fehler in der Testschleife gefunden und dann das Modell erneut testen. In diesem Prozess ist der „Retest“-Teil der Debug-Schleife (d. h. das erneute Ausführen der Testschleife) von entscheidender Bedeutung, da es sich bei den Tests, sobald sie zur Korrektur des Modells verwendet werden, nicht mehr um Testdaten, sondern um Trainingsdaten handelt. Der Prozess der Fehlerbehebung überkompensiert oft, indem er in den ersten paar Runden des Debugging-Zyklus Abkürzungen oder Fehler einführt, die nur mit einer Reihe von Tests entdeckt werden können, die an das neue „behobene“ Modell angepasst sind.

Testzyklusprozess an einem Open-Source-RoBERTa-Large-Emotionsmodell. Die Forscher begannen mit Tests zum Thema „/sensibel/Einwanderung“ in Abbildung 2, das vom RoBERTa-Modell fälschlicherweise als negativ gekennzeichnet wurde. Das Modell wird während dieser Tests feinabgestimmt (gemischt mit den ursprünglichen Trainingsdaten, um die Aufgabenleistung aufrechtzuerhalten), und das Ergebnis ist ein neues Modell, das nicht mehr ausfällt. Beim erneuten Durchlaufen der Testschleife wurde jedoch festgestellt, dass fast alle Einwanderungserklärungen nun als „neutral“ gekennzeichnet waren, obwohl sie aufgrund des Antrags und des Testszenarios wirklich negativ waren.

Eine erneute Feinabstimmung mithilfe dieser neuen Tests führt dazu, dass das Modell den ursprünglichen Fehler korrekt behebt, ohne die Abkürzung „Jede Einwanderungserklärung ist neutral“ hinzuzufügen. Dies garantiert natürlich nicht, dass im Modell keine weitere Verknüpfung vorhanden ist, aber nach der Erfahrung des Forschers ist nach mehreren Debugging-Zyklen die Anzahl unerwarteter Fehler, die bei der Behebung des ursprünglichen Fehlers auftreten, erheblich reduziert.

Tester müssen nicht jeden möglichen Fehler im Voraus im Detail identifizieren, AdaTest wird Fehler, die in der nächsten Test- und Debugging-Runde auftreten, adaptiv aufdecken und beheben.

Daher verschiebt die Debugging-Schleife die Grenzen der aktuellen Fehlertestspezifikation, bis ein zufriedenstellendes Modell erstellt wird. Tatsächlich kann AdaTest als Anwendung des Test-Fix-Retest-Zyklus in der Softwareentwicklung im NLP angesehen werden.

Während Iterationen der Debug-Schleife hinzugefügte Verknüpfungen wurden entdeckt und in zukünftigen Iterationen behoben. Um die Wirksamkeit der Debug-Schleife zu bewerten, wurde RoBERTa-Large mithilfe des Quora-Fragendatensatzes verfeinert, um zwei zu erkennen. Ob die Frage dupliziert ist oder Nein, es wird auch mithilfe des Stanford Sentiment Treebank (SST)-Datensatzes für eine positive/neutrale/negative Stimmungsanalyse verfeinert.

Die Ergebnisse ergaben, dass das Basismodell 22 der 53 QQP-Themen und 11 der 39 emotionalen Themen nicht erfolgreich identifizieren konnte. Anschließend erstellte der Forscher Daten, um das Thema zu reparieren. Extrahieren Sie 50 Beispiele aus den Daten zu diesem Thema und führen Sie eine Debugging-Schleife mit AdaTest aus. Für den QQP-Datensatz werden durchschnittlich 41,6 Tests und für den Sentiment-Datensatz durchschnittlich 55,8 Tests durchgeführt.

Die Ergebnisse zeigen, dass AdaTest in den allermeisten Fällen die für das Training verwendeten Fragen und einige unsichtbare reservierte Fragen behebt, ohne Fragen zu zerstören, während die ursprünglichen CheckList-Daten häufig neue Fehler einführen und dadurch andere Testfragen zerstören. Die Forscher bewerteten auch die Wirksamkeit von AdaTest in einer Standardentwicklungsumgebung. Nach drei Monaten Entwicklung, CheckList-Tests und Ad-hoc-Datenerweiterung auf Basis von GPT-3 beträgt der F1-Score 0,66 (von 1,00) für ungesehene, in freier Wildbahn gesammelte Daten.

Dasselbe Team, das AdaTest nutzte, erreichte, nachdem es die Debug-Schleife vier Stunden lang selbst ausgeführt hatte, einen F1-Score von 0,77 für denselben unsichtbaren Datensatz. Diese Ergebnisse wurden später in einem zweiten, noch nicht sichtbaren Datensatz repliziert und zeigten, dass AdaTest Fehlerkorrekturen durchführen und bessere Ergebnisse in Bereichen erzielen kann, in denen herkömmliche Methoden versagen.

Menschen stellen Problemspezifikationen bereit, die Sprachmodellen fehlen, während Sprachmodelle qualitativ hochwertige Tests in größerem Maßstab und Umfang bereitstellen, Modelltests und Debugging verbinden, Fehler effektiv beheben und die Modellentwicklung näher an die traditionelle Softwareentwicklung heranführen. Die iterative Natur von .

Die Zusammenarbeit zwischen Menschen und KI stellt eine zukünftige Richtung für die Entwicklung des maschinellen Lernens dar. Es besteht die Hoffnung, dass sich diese Zusammenarbeit weiter verbessert, da die Fähigkeiten großer Sprachmodelle weiter wachsen.

Das obige ist der detaillierte Inhalt vonKann das NLP-Modell menschliche Sprache nicht lesen? Microsoft AdaTest macht die Fehlersuche fünfmal effizienter. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1374

1374

52

52

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Bei der Konvertierung von Zeichenfolgen in Objekte in Vue.js wird JSON.Parse () für Standard -JSON -Zeichenfolgen bevorzugt. Bei nicht standardmäßigen JSON-Zeichenfolgen kann die Zeichenfolge durch Verwendung regelmäßiger Ausdrücke verarbeitet und Methoden gemäß dem Format oder dekodierten URL-kodiert reduziert werden. Wählen Sie die entsprechende Methode gemäß dem String -Format aus und achten Sie auf Sicherheits- und Codierungsprobleme, um Fehler zu vermeiden.

Vue- und Element-UI-Kaskaden-Dropdown-Box V-Model-Bindung

Apr 07, 2025 pm 08:06 PM

Vue- und Element-UI-Kaskaden-Dropdown-Box V-Model-Bindung

Apr 07, 2025 pm 08:06 PM

Vue- und Element-UI-kaskadierte Dropdown-Boxen V-Model-Bindung gemeinsame Grubenpunkte: V-Model bindet ein Array, das die ausgewählten Werte auf jeder Ebene des kaskadierten Auswahlfelds darstellt, nicht auf einer Zeichenfolge; Der Anfangswert von ausgewählten Optionen muss ein leeres Array sein, nicht null oder undefiniert. Die dynamische Belastung von Daten erfordert die Verwendung asynchroner Programmierkenntnisse, um Datenaktualisierungen asynchron zu verarbeiten. Für riesige Datensätze sollten Leistungsoptimierungstechniken wie virtuelles Scrollen und fauler Laden in Betracht gezogen werden.

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

Zusammenfassung: Es gibt die folgenden Methoden zum Umwandeln von VUE.JS -String -Arrays in Objektarrays: Grundlegende Methode: Verwenden Sie die Kartenfunktion, um regelmäßige formatierte Daten zu entsprechen. Erweitertes Gameplay: Die Verwendung regulärer Ausdrücke kann komplexe Formate ausführen, müssen jedoch sorgfältig geschrieben und berücksichtigt werden. Leistungsoptimierung: In Betracht ziehen die große Datenmenge, asynchrone Operationen oder effiziente Datenverarbeitungsbibliotheken können verwendet werden. Best Practice: Clear Code -Stil, verwenden Sie sinnvolle variable Namen und Kommentare, um den Code präzise zu halten.

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

Um die Zeitüberschreitung für Vue Axios festzulegen, können wir eine Axios -Instanz erstellen und die Zeitleitungsoption angeben: in globalen Einstellungen: vue.Prototyp. $ Axios = axios.create ({Timeout: 5000}); In einer einzigen Anfrage: this. $ axios.get ('/api/user', {timeout: 10000}).

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.