Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Anwendung der Text-Emotionserkennungstechnologie basierend auf Deep Learning in der 5G-Sicherheitsmanagement- und Kontrollplattform für schlechte Nachrichten

Anwendung der Text-Emotionserkennungstechnologie basierend auf Deep Learning in der 5G-Sicherheitsmanagement- und Kontrollplattform für schlechte Nachrichten

Anwendung der Text-Emotionserkennungstechnologie basierend auf Deep Learning in der 5G-Sicherheitsmanagement- und Kontrollplattform für schlechte Nachrichten

Autor | Sun Yue, Abteilung: China Mobile (Hangzhou) Information Technology Co., Ltd. | mit 5G-Netzen in Kontakt kommen und diese nutzen. 5G-Netzwerke können nicht nur Sprache, Video, Text und andere Informationen herkömmlicher Netzwerke übertragen, sondern können auch in praktischeren Anwendungsszenarien mit geringerer Latenz und hochpräzisen Positionierungsfunktionen verwendet werden, wie zum Beispiel: Live-Gefechtsfeldinformationen, Satellitenpositionierung, Navigation, usw.

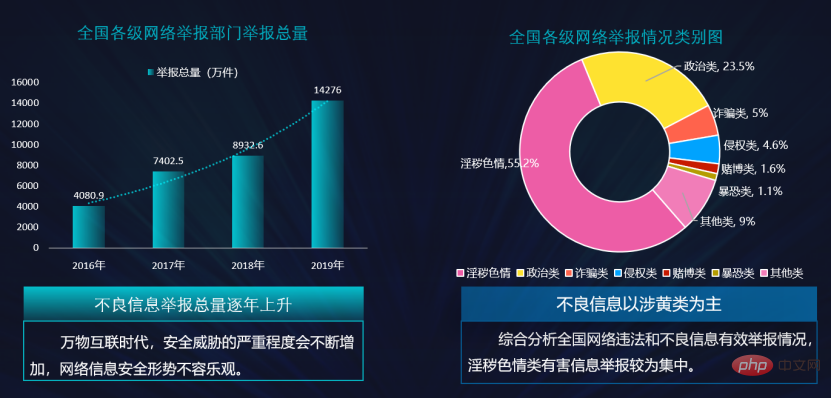

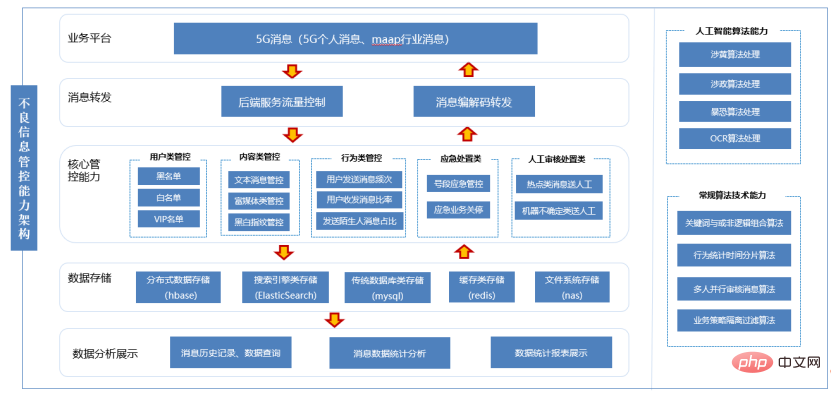

Internetinformationen werden oft mit schlechten Informationen vermischt, wie z. B. politischen Informationen, pornografischen Informationen, Informationen zu Schwarzen, Betrugsinformationen, kommerziellen Werbeinformationen usw. und der Menge an Schlechte Informationen nehmen von Jahr zu Jahr zu, was zu massiver Belästigung der Benutzer führt. Um die Netzwerkumgebung zu reinigen und die Verbreitung schlechter Informationen wirksam zu kontrollieren, wurde die 5G-Sicherheitsmanagement- und Kontrollplattform für schlechte Nachrichten von China Mobile ins Leben gerufen. Datenquelle: China Mobile Group Information Security Center Netzwerke In der Informationsumgebung, wie Textnachrichten, Sprachinformationen, Videoinformationen, Rich-Media-Informationen usw., werden die Informationen in folgende Kategorien eingeteilt: politisch, pornographisch, bandenbezogen, betrugsbezogen, kommerzielle Werbebotschaften, normal Nachrichten usw. und führen Sie dann durch entsprechende Strategien eine rechtzeitige Abfang- und Folgestrafe basierend auf der Schwere der schlechten Nachrichten durch, bereinigen Sie die Netzwerkumgebung von der Grundursache und schaffen Sie einen guten Cyberspace. 2. Technische Punkte der bestehenden 5G-Plattform für das Management und die Kontrolle schlechter Informationen

①Schlüsselwörter der ersten Ebene festlegen

: Schlüsselwörter der ersten Ebene werden normalerweise auf einige äußerst sensible Wörter festgelegt. Wenn der Benutzer eine Nachricht mit Schlüsselwortinhalten der ersten Ebene sendet, wird die Nachricht sofort abgefangen und der Nachrichteninhalt kann nicht verteilt werden , und Markieren Sie diesen Benutzer.

: Allgemeine Schlüsselwörter werden auf einige relativ sensible Wörter festgelegt. Wenn der Benutzer innerhalb eines bestimmten Zeitraums eine Nachricht mit häufigem Schlüsselwortinhalt sendet, überschreitet die Häufigkeit, mit der der Benutzer die sensible Nachricht sendet Die vom System vorgegebene Anzahl Wenn der Abfangschwellenwert festgelegt ist, zieht das System den Benutzer in die schwarze Liste und innerhalb eines bestimmten Zeitraums kann der Benutzer nicht den vollständigen 5G-Netzwerkdienst nutzen.

③Setzen Sie die Überwachung komplexer Textinformationen ein: Wenn der Benutzer eine PDF-Datei sendet, die Text und Bilder enthält, wird der Text in der Datei extrahiert und die Schlüsselwörter der ersten Ebene und allgemeine Schlüsselwörter werden gefiltert und die Bilder werden verarbeitet. Die Rich-Media-Mechanismus-Filterung basiert auf den Filterergebnissen von Text und Bildern und übernimmt das Prinzip der starken Verarbeitung als Verarbeitungsergebnis der Datei.

3. Technische Schwächen der bestehenden 5G-Plattform zur Kontrolle schlechter Nachrichten

4. Technische Implementierungsdetails des 5G-Schlechtmanagement- und Kontrollsystems basierend auf Deep Learning

Diese Technologie enthält drei Hauptkomponenten: Jieba-Wortsegmentierungssystem, Phrasenvektorisierung und Text-Emotionserkennungsalgorithmus, die Interaktion zwischen den einzelnen Themen ist wie folgt:

Interaktionsflussdiagramm jedes Moduls

Verwenden Sie die Crawler-Technologie, um Internetwörter und Nachrichtennachrichten als Originaltext zu crawlen, und teilen Sie den Originaltext im Verhältnis 8:2 in einen Trainingssatz und einen Testsatz auf, beschriften Sie die Textinformationen im Trainingssatz und übergeben Sie dann den Text Informationen im Testsatz durch Das Jieba-Wortsegmentierungstool führt eine Wortsegmentierungsverarbeitung durch, zum Beispiel: Er kam zum Mobile Hangyan Building. Nach der Wortsegmentierung durch das Jieba-Wortsegmentierungstool lautet das Ergebnis: he/came/moved/Hangyan/building, und schließlich wurden die Daten nach der Wortsegmentierung in einem Korpus organisiert. Da die Textinformationsmenge im Trainingssatz und Testsatz sehr groß ist (normalerweise Millionen Daten), ist auch die Datenmenge im Post-Wort-Segmentierungskorpus sehr groß (zig Millionen Daten). Obwohl diese Korpora in nummerierter Form im Korpus gespeichert werden können, ist es aufgrund der großen Datenmenge leicht, unter der Dimensionalitätskatastrophe zu leiden. Für die Modalpartikel, die in Textinformationen vorkommen, wie zum Beispiel: „le“, „的“, „我“ usw., kommen diese Wörter zwar sehr häufig vor, tragen aber kaum zur emotionalen Wirkung bei, daher werden wir eine Auswahl treffen Entfernen dieser Wörter aus dem Phrasenkorpus, um den Zweck der Dimensionsreduzierung zu erreichen. Wir senden die vektorisierten Phrasen im Trainingssatz zum Lernen und Trainieren und erhalten das entsprechende Modell. Schließlich fügen wir die Daten im Testsatz in das Modell ein, um die entsprechenden Erkennungsergebnisse anzuzeigen Das Modell kann eine bessere Genauigkeit erzielen. Wenn die Genauigkeitsrate gut ist, wird das Modell mit der 5G-Bad-Management- und Kontrollplattform verbunden und der Benutzer sendet End-to-End-Informationen zum Filtern. Wenn während des Filtervorgangs schlechte Informationen gefunden werden, werden diese rechtzeitig abgefangen, wodurch das Abfangen schlechter Informationen durch das 5G-System zur Verwaltung und Kontrolle schlechter Informationen systematischer und umfassender wird. Die spezifischen Schritte sind wie folgt: Verwenden Sie Deep-Learning-Technologie, um eine effektive Identifizierung mit hoher Zuverlässigkeit und Authentizität zu gewährleisten. Verwenden Sie Deep-Learning-Technologie zur Emotionserkennung mit weniger manuellem Eingriff und hoher Arbeitseffizienz Mithilfe der Text-Emotionserkennung kann die Strategie automatisch aktualisiert und zeitnah mit neuen Eintragsinformationen ergänzt werden, um die Effizienz zu verbessern.

Das obige ist der detaillierte Inhalt vonAnwendung der Text-Emotionserkennungstechnologie basierend auf Deep Learning in der 5G-Sicherheitsmanagement- und Kontrollplattform für schlechte Nachrichten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Methoden und Schritte zur Verwendung von BERT für die Stimmungsanalyse in Python

Jan 22, 2024 pm 04:24 PM

Methoden und Schritte zur Verwendung von BERT für die Stimmungsanalyse in Python

Jan 22, 2024 pm 04:24 PM

BERT ist ein vorab trainiertes Deep-Learning-Sprachmodell, das 2018 von Google vorgeschlagen wurde. Der vollständige Name lautet BidirektionalEncoderRepresentationsfromTransformers, der auf der Transformer-Architektur basiert und die Eigenschaften einer bidirektionalen Codierung aufweist. Im Vergleich zu herkömmlichen Einweg-Codierungsmodellen kann BERT bei der Textverarbeitung gleichzeitig Kontextinformationen berücksichtigen, sodass es bei Verarbeitungsaufgaben in natürlicher Sprache eine gute Leistung erbringt. Seine Bidirektionalität ermöglicht es BERT, die semantischen Beziehungen in Sätzen besser zu verstehen und dadurch die Ausdrucksfähigkeit des Modells zu verbessern. Durch Vorschulungs- und Feinabstimmungsmethoden kann BERT für verschiedene Aufgaben der Verarbeitung natürlicher Sprache verwendet werden, wie z. B. Stimmungsanalyse und Benennung

Analyse häufig verwendeter KI-Aktivierungsfunktionen: Deep-Learning-Praxis von Sigmoid, Tanh, ReLU und Softmax

Dec 28, 2023 pm 11:35 PM

Analyse häufig verwendeter KI-Aktivierungsfunktionen: Deep-Learning-Praxis von Sigmoid, Tanh, ReLU und Softmax

Dec 28, 2023 pm 11:35 PM

Aktivierungsfunktionen spielen beim Deep Learning eine entscheidende Rolle. Sie können nichtlineare Eigenschaften in neuronale Netze einführen und es dem Netz ermöglichen, komplexe Eingabe-Ausgabe-Beziehungen besser zu lernen und zu simulieren. Die richtige Auswahl und Verwendung von Aktivierungsfunktionen hat einen wichtigen Einfluss auf die Leistung und Trainingsergebnisse neuronaler Netze. In diesem Artikel werden vier häufig verwendete Aktivierungsfunktionen vorgestellt: Sigmoid, Tanh, ReLU und Softmax. Beginnend mit der Einführung, den Verwendungsszenarien und den Vorteilen. Nachteile und Optimierungslösungen werden besprochen, um Ihnen ein umfassendes Verständnis der Aktivierungsfunktionen zu vermitteln. 1. Sigmoid-Funktion Einführung in die Sigmoid-Funktionsformel: Die Sigmoid-Funktion ist eine häufig verwendete nichtlineare Funktion, die jede reelle Zahl auf Werte zwischen 0 und 1 abbilden kann. Es wird normalerweise verwendet, um das zu vereinheitlichen

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Heute diskutieren wir darüber, wie Deep-Learning-Technologie die Leistung von visionbasiertem SLAM (Simultaneous Localization and Mapping) in komplexen Umgebungen verbessern kann. Durch die Kombination von Methoden zur Tiefenmerkmalsextraktion und Tiefenanpassung stellen wir hier ein vielseitiges hybrides visuelles SLAM-System vor, das die Anpassung in anspruchsvollen Szenarien wie schlechten Lichtverhältnissen, dynamischer Beleuchtung, schwach strukturierten Bereichen und starkem Jitter verbessern soll. Unser System unterstützt mehrere Modi, einschließlich erweiterter Monokular-, Stereo-, Monokular-Trägheits- und Stereo-Trägheitskonfigurationen. Darüber hinaus wird analysiert, wie visuelles SLAM mit Deep-Learning-Methoden kombiniert werden kann, um andere Forschungen zu inspirieren. Durch umfangreiche Experimente mit öffentlichen Datensätzen und selbst abgetasteten Daten demonstrieren wir die Überlegenheit von SL-SLAM in Bezug auf Positionierungsgenauigkeit und Tracking-Robustheit.

Latente Raumeinbettung: Erklärung und Demonstration

Jan 22, 2024 pm 05:30 PM

Latente Raumeinbettung: Erklärung und Demonstration

Jan 22, 2024 pm 05:30 PM

Latent Space Embedding (LatentSpaceEmbedding) ist der Prozess der Abbildung hochdimensionaler Daten auf niedrigdimensionalen Raum. Im Bereich des maschinellen Lernens und des tiefen Lernens handelt es sich bei der Einbettung latenter Räume normalerweise um ein neuronales Netzwerkmodell, das hochdimensionale Eingabedaten in einen Satz niedrigdimensionaler Vektordarstellungen abbildet. Dieser Satz von Vektoren wird oft als „latente Vektoren“ oder „latent“ bezeichnet Kodierungen". Der Zweck der Einbettung latenter Räume besteht darin, wichtige Merkmale in den Daten zu erfassen und sie in einer prägnanteren und verständlicheren Form darzustellen. Durch die Einbettung latenter Räume können wir Vorgänge wie das Visualisieren, Klassifizieren und Clustern von Daten im niedrigdimensionalen Raum durchführen, um die Daten besser zu verstehen und zu nutzen. Die Einbettung latenter Räume findet in vielen Bereichen breite Anwendung, z. B. bei der Bilderzeugung, der Merkmalsextraktion, der Dimensionsreduzierung usw. Die Einbettung des latenten Raums ist das Wichtigste

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

In der heutigen Welle rasanter technologischer Veränderungen sind künstliche Intelligenz (KI), maschinelles Lernen (ML) und Deep Learning (DL) wie helle Sterne und führen die neue Welle der Informationstechnologie an. Diese drei Wörter tauchen häufig in verschiedenen hochaktuellen Diskussionen und praktischen Anwendungen auf, aber für viele Entdecker, die neu auf diesem Gebiet sind, sind ihre spezifische Bedeutung und ihre internen Zusammenhänge möglicherweise noch immer rätselhaft. Schauen wir uns also zunächst dieses Bild an. Es ist ersichtlich, dass zwischen Deep Learning, maschinellem Lernen und künstlicher Intelligenz ein enger Zusammenhang und eine fortschreitende Beziehung besteht. Deep Learning ist ein spezifischer Bereich des maschinellen Lernens und des maschinellen Lernens

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Fast 20 Jahre sind vergangen, seit das Konzept des Deep Learning im Jahr 2006 vorgeschlagen wurde. Deep Learning hat als Revolution auf dem Gebiet der künstlichen Intelligenz viele einflussreiche Algorithmen hervorgebracht. Was sind Ihrer Meinung nach die zehn besten Algorithmen für Deep Learning? Im Folgenden sind meiner Meinung nach die besten Algorithmen für Deep Learning aufgeführt. Sie alle nehmen hinsichtlich Innovation, Anwendungswert und Einfluss eine wichtige Position ein. 1. Hintergrund des Deep Neural Network (DNN): Deep Neural Network (DNN), auch Multi-Layer-Perceptron genannt, ist der am weitesten verbreitete Deep-Learning-Algorithmus. Als er erstmals erfunden wurde, wurde er aufgrund des Engpasses bei der Rechenleistung in Frage gestellt Jahre, Rechenleistung, Der Durchbruch kam mit der Datenexplosion. DNN ist ein neuronales Netzwerkmodell, das mehrere verborgene Schichten enthält. In diesem Modell übergibt jede Schicht Eingaben an die nächste Schicht und

So verwenden Sie CNN- und Transformer-Hybridmodelle, um die Leistung zu verbessern

Jan 24, 2024 am 10:33 AM

So verwenden Sie CNN- und Transformer-Hybridmodelle, um die Leistung zu verbessern

Jan 24, 2024 am 10:33 AM

Convolutional Neural Network (CNN) und Transformer sind zwei verschiedene Deep-Learning-Modelle, die bei verschiedenen Aufgaben eine hervorragende Leistung gezeigt haben. CNN wird hauptsächlich für Computer-Vision-Aufgaben wie Bildklassifizierung, Zielerkennung und Bildsegmentierung verwendet. Es extrahiert lokale Merkmale auf dem Bild durch Faltungsoperationen und führt eine Reduzierung der Merkmalsdimensionalität und räumliche Invarianz durch Pooling-Operationen durch. Im Gegensatz dazu wird Transformer hauptsächlich für Aufgaben der Verarbeitung natürlicher Sprache (NLP) wie maschinelle Übersetzung, Textklassifizierung und Spracherkennung verwendet. Es nutzt einen Selbstaufmerksamkeitsmechanismus, um Abhängigkeiten in Sequenzen zu modellieren und vermeidet so die sequentielle Berechnung in herkömmlichen rekurrenten neuronalen Netzen. Obwohl diese beiden Modelle für unterschiedliche Aufgaben verwendet werden, weisen sie Ähnlichkeiten in der Sequenzmodellierung auf

Verbesserter RMSprop-Algorithmus

Jan 22, 2024 pm 05:18 PM

Verbesserter RMSprop-Algorithmus

Jan 22, 2024 pm 05:18 PM

RMSprop ist ein weit verbreiteter Optimierer zum Aktualisieren der Gewichte neuronaler Netze. Es wurde 2012 von Geoffrey Hinton et al. vorgeschlagen und ist der Vorgänger des Adam-Optimierers. Das Aufkommen des RMSprop-Optimierers besteht hauptsächlich darin, einige Probleme zu lösen, die im SGD-Gradientenabstiegsalgorithmus auftreten, wie z. B. das Verschwinden des Gradienten und die Explosion des Gradienten. Durch den Einsatz des RMSprop-Optimierers kann die Lernrate effektiv angepasst und Gewichte adaptiv aktualisiert werden, wodurch der Trainingseffekt des Deep-Learning-Modells verbessert wird. Die Kernidee des RMSprop-Optimierers besteht darin, einen gewichteten Durchschnitt von Gradienten durchzuführen, sodass Gradienten in unterschiedlichen Zeitschritten unterschiedliche Auswirkungen auf Gewichtsaktualisierungen haben. Konkret berechnet RMSprop das Quadrat jedes Parameters