Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die National University of Singapore und die Tsinghua University wurden speziell für Entscheidungsbäume entwickelt und schlagen gemeinsam ein schnelles und sicheres neues föderiertes Lernsystem vor

Die National University of Singapore und die Tsinghua University wurden speziell für Entscheidungsbäume entwickelt und schlagen gemeinsam ein schnelles und sicheres neues föderiertes Lernsystem vor

Die National University of Singapore und die Tsinghua University wurden speziell für Entscheidungsbäume entwickelt und schlagen gemeinsam ein schnelles und sicheres neues föderiertes Lernsystem vor

Federated Learning ist ein sehr heißes Feld im maschinellen Lernen, das sich auf das gemeinsame Training von Modellen durch mehrere Parteien ohne Datenübertragung bezieht. Mit der Entwicklung des föderierten Lernens entstehen immer mehr föderierte Lernsysteme wie FATE, FedML, PaddleFL, TensorFlow-Federated und so weiter. Die meisten föderierten Lernsysteme unterstützen jedoch kein föderiertes Lerntraining von Baummodellen. Im Vergleich zu neuronalen Netzen zeichnen sich Baummodelle durch schnelles Training, gute Interpretierbarkeit und Eignung für Tabellendaten aus. Baummodelle haben vielfältige Anwendungsszenarien in den Bereichen Finanzen, medizinische Versorgung, Internet und anderen Bereichen, wie z. B. Werbeempfehlungen, Aktienprognosen usw.

Das repräsentative Modell des Entscheidungsbaums ist der Gradient Boosting Decision Tree (GBDT). Da die Vorhersagefähigkeit eines Baums begrenzt ist, trainiert GBDT mehrere Bäume nacheinander mithilfe der Boosting-Methode und erzielt schließlich einen guten Vorhersageeffekt, indem jeder Baum an den Rest des aktuellen Vorhersagewerts und des Etikettenwerts angepasst wird. Zu den repräsentativen GBDT-Systemen gehören XGBoost, LightGBM, CatBoost und ThunderGBM. Unter ihnen wurde XGBoost viele Male vom KDD-Cup-Meisterschaftsteam verwendet. Allerdings unterstützt keines dieser Systeme das GBDT-Training in föderierten Lernszenarien. Kürzlich haben Forscher der National University of Singapore und der Tsinghua University ein neues föderiertes Lernsystem FedTree vorgeschlagen, das sich auf das Training von Baummodellen konzentriert.

- Papieradresse: https://github.com/Xtra-Computing /FedTree/blob/main/FedTree_draft_paper.pdf

- Projektadresse: https://github.com/Xtra-Computing/FedTree

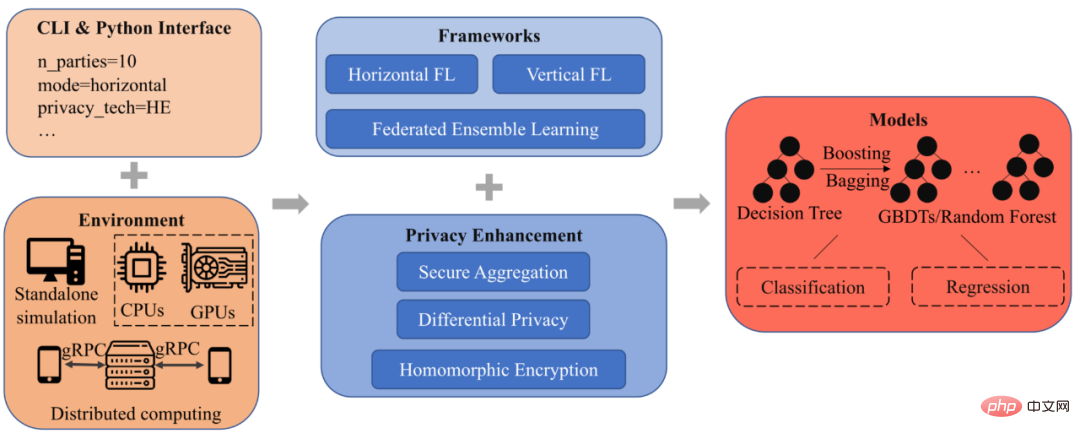

Einführung in das FedTree-System Das FedTree-Architekturdiagramm ist in Abbildung dargestellt 1 Anzeige, es gibt insgesamt 5 Module: Schnittstelle, Umgebung, Framework, Datenschutz und Modell.

Abbildung 1: FedTree-Systemarchitekturdiagramm ##🎜 🎜#

Schnittstelle: FedTree unterstützt zwei Schnittstellen: Befehlszeilenschnittstelle und Python-Schnittstelle. Benutzer müssen lediglich Parameter angeben (Anzahl der Teilnehmer, Verbundszenario usw.) und können FedTree zum Training mit einem einzeiligen Befehl ausführen. Die Python-Schnittstelle von FedTree ist mit scikit-learn kompatibel und Sie können fit() und Predict() für Training und Vorhersage aufrufen.

Environment: FedTree unterstützt die simulierte Föderationsbereitstellung auf einem einzigen maschinelles Lernen und die Bereitstellung von verteiltem föderiertem Lernen auf mehreren Maschinen. In einer eigenständigen Umgebung unterstützt FedTree die Aufteilung von Daten in mehrere Unterdatensätze, und jeder Unterdatensatz wird als Teilnehmer trainiert. In einer Umgebung mit mehreren Maschinen unterstützt FedTree jede Maschine als Teilnehmer und Maschinen kommunizieren über gRPC. Gleichzeitig unterstützt FedTree zusätzlich zur CPU die Verwendung von GPUs, um das Training zu beschleunigen.

Framework: FedTree unterstützt horizontale und vertikale föderierte Lernszenarien Ausbildung unter GBDT. Im horizontalen Szenario verfügen verschiedene Teilnehmer über unterschiedliche Trainingsbeispiele und denselben Funktionsraum. Im vertikalen Szenario verfügen verschiedene Teilnehmer über unterschiedliche Funktionsräume und dieselben Trainingsbeispiele. Um die Leistung sicherzustellen, nehmen in beiden Szenarien mehrere Parteien am Training jedes Knotens teil. Darüber hinaus unterstützt FedTree auch Ensemble-Lernen, bei dem die Teilnehmer Bäume parallel trainieren und sie dann aggregieren, um den Kommunikationsaufwand zwischen den Teilnehmern zu reduzieren.

Privatsphäre: Aufgrund des während des Trainings durchlaufenen Gefälles Im Prozess können Informationen über Trainingsdaten durchgesickert sein, und FedTree bietet verschiedene Methoden zum Schutz der Privatsphäre, um Gradienteninformationen weiter zu schützen, einschließlich homomorpher Verschlüsselung (HE) und sicherer Aggregation (SA). Gleichzeitig bietet FedTree differenzielle Privatsphäre, um das endgültig trainierte Modell zu schützen.

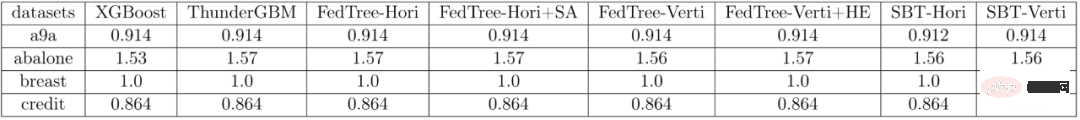

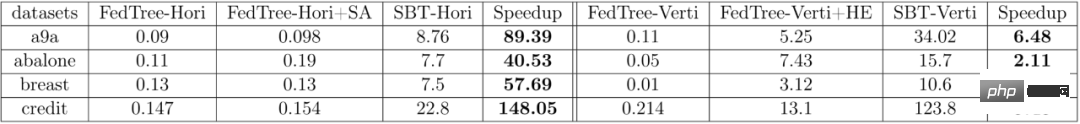

Model: Basierend auf dem Training eines Baumes unterstützt FedTree Training von GBDT/Random Forest durch Boosting/Bagging-Methoden. Durch die Festlegung verschiedener Verlustfunktionen unterstützt das von FedTree trainierte Modell eine Vielzahl von Aufgaben, einschließlich Klassifizierung und Regression. ExperimentTabelle 1 fasst die AUC verschiedener Systeme für a9a, Brust und Kredit sowie den RMSE für Abalone, den Modelleffekt von FedTree und das Training von GBDT (XGBoost) mit allen zusammen data , ThunderGBM) und SecureBoost (SBT) in FATE sind nahezu identisch. Darüber hinaus haben die Datenschutzrichtlinien SA und HE keinen Einfluss auf die Modellleistung. Tabelle 1: Vergleich der Modelleffekte verschiedener Systeme # 🎜🎜# Tabelle 2 fasst die Trainingszeit (Einheit: Sekunden) jedes Baums in verschiedenen Systemen zusammen. Es ist ersichtlich, dass FedTree viel schneller ist als FATE. In horizontalen föderierten Lernszenarien kann ein Beschleunigungsverhältnis von mehr als dem Hundertfachen erreicht werden. Tabelle 2: Vergleich der Trainingszeit für jeden Baum in verschiedenen Systemen# 🎜 🎜# Weitere Forschungsdetails finden Sie im Originalpapier von FedTree.

Das obige ist der detaillierte Inhalt vonDie National University of Singapore und die Tsinghua University wurden speziell für Entscheidungsbäume entwickelt und schlagen gemeinsam ein schnelles und sicheres neues föderiertes Lernsystem vor. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

CLIP-BEVFormer: Überwacht explizit die BEVFormer-Struktur, um die Leistung der Long-Tail-Erkennung zu verbessern

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: Überwacht explizit die BEVFormer-Struktur, um die Leistung der Long-Tail-Erkennung zu verbessern

Mar 26, 2024 pm 12:41 PM

Oben geschrieben und das persönliche Verständnis des Autors: Derzeit spielt das Wahrnehmungsmodul im gesamten autonomen Fahrsystem eine entscheidende Rolle Das Steuermodul im autonomen Fahrsystem trifft zeitnahe und korrekte Urteile und Verhaltensentscheidungen. Derzeit sind Autos mit autonomen Fahrfunktionen in der Regel mit einer Vielzahl von Dateninformationssensoren ausgestattet, darunter Rundumsichtkamerasensoren, Lidar-Sensoren und Millimeterwellenradarsensoren, um Informationen in verschiedenen Modalitäten zu sammeln und so genaue Wahrnehmungsaufgaben zu erfüllen. Der auf reinem Sehen basierende BEV-Wahrnehmungsalgorithmus wird von der Industrie aufgrund seiner geringen Hardwarekosten und einfachen Bereitstellung bevorzugt, und seine Ausgabeergebnisse können problemlos auf verschiedene nachgelagerte Aufgaben angewendet werden.

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Zu den häufigsten Herausforderungen, mit denen Algorithmen für maschinelles Lernen in C++ konfrontiert sind, gehören Speicherverwaltung, Multithreading, Leistungsoptimierung und Wartbarkeit. Zu den Lösungen gehören die Verwendung intelligenter Zeiger, moderner Threading-Bibliotheken, SIMD-Anweisungen und Bibliotheken von Drittanbietern sowie die Einhaltung von Codierungsstilrichtlinien und die Verwendung von Automatisierungstools. Praktische Fälle zeigen, wie man die Eigen-Bibliothek nutzt, um lineare Regressionsalgorithmen zu implementieren, den Speicher effektiv zu verwalten und leistungsstarke Matrixoperationen zu nutzen.

Entdecken Sie die zugrunde liegenden Prinzipien und die Algorithmusauswahl der C++-Sortierfunktion

Apr 02, 2024 pm 05:36 PM

Entdecken Sie die zugrunde liegenden Prinzipien und die Algorithmusauswahl der C++-Sortierfunktion

Apr 02, 2024 pm 05:36 PM

Die unterste Ebene der C++-Sortierfunktion verwendet die Zusammenführungssortierung, ihre Komplexität beträgt O(nlogn) und bietet verschiedene Auswahlmöglichkeiten für Sortieralgorithmen, einschließlich schneller Sortierung, Heap-Sortierung und stabiler Sortierung.

Kann künstliche Intelligenz Kriminalität vorhersagen? Entdecken Sie die Möglichkeiten von CrimeGPT

Mar 22, 2024 pm 10:10 PM

Kann künstliche Intelligenz Kriminalität vorhersagen? Entdecken Sie die Möglichkeiten von CrimeGPT

Mar 22, 2024 pm 10:10 PM

Die Konvergenz von künstlicher Intelligenz (KI) und Strafverfolgung eröffnet neue Möglichkeiten zur Kriminalprävention und -aufdeckung. Die Vorhersagefähigkeiten künstlicher Intelligenz werden häufig in Systemen wie CrimeGPT (Crime Prediction Technology) genutzt, um kriminelle Aktivitäten vorherzusagen. Dieser Artikel untersucht das Potenzial künstlicher Intelligenz bei der Kriminalitätsvorhersage, ihre aktuellen Anwendungen, die Herausforderungen, denen sie gegenübersteht, und die möglichen ethischen Auswirkungen der Technologie. Künstliche Intelligenz und Kriminalitätsvorhersage: Die Grundlagen CrimeGPT verwendet Algorithmen des maschinellen Lernens, um große Datensätze zu analysieren und Muster zu identifizieren, die vorhersagen können, wo und wann Straftaten wahrscheinlich passieren. Zu diesen Datensätzen gehören historische Kriminalstatistiken, demografische Informationen, Wirtschaftsindikatoren, Wettermuster und mehr. Durch die Identifizierung von Trends, die menschliche Analysten möglicherweise übersehen, kann künstliche Intelligenz Strafverfolgungsbehörden stärken

Verbesserter Erkennungsalgorithmus: zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern

Jun 06, 2024 pm 12:33 PM

Verbesserter Erkennungsalgorithmus: zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern

Jun 06, 2024 pm 12:33 PM

01Ausblicksübersicht Derzeit ist es schwierig, ein angemessenes Gleichgewicht zwischen Detektionseffizienz und Detektionsergebnissen zu erreichen. Wir haben einen verbesserten YOLOv5-Algorithmus zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern entwickelt, der mehrschichtige Merkmalspyramiden, Multierkennungskopfstrategien und hybride Aufmerksamkeitsmodule verwendet, um die Wirkung des Zielerkennungsnetzwerks in optischen Fernerkundungsbildern zu verbessern. Laut SIMD-Datensatz ist der mAP des neuen Algorithmus 2,2 % besser als YOLOv5 und 8,48 % besser als YOLOX, wodurch ein besseres Gleichgewicht zwischen Erkennungsergebnissen und Geschwindigkeit erreicht wird. 02 Hintergrund und Motivation Mit der rasanten Entwicklung der Fernerkundungstechnologie wurden hochauflösende optische Fernerkundungsbilder verwendet, um viele Objekte auf der Erdoberfläche zu beschreiben, darunter Flugzeuge, Autos, Gebäude usw. Objekterkennung bei der Interpretation von Fernerkundungsbildern

Üben und denken Sie an die multimodale große Modellplattform DataCanvas von Jiuzhang Yunji

Oct 20, 2023 am 08:45 AM

Üben und denken Sie an die multimodale große Modellplattform DataCanvas von Jiuzhang Yunji

Oct 20, 2023 am 08:45 AM

1. Die historische Entwicklung multimodaler Großmodelle zeigt den ersten Workshop zur künstlichen Intelligenz, der 1956 am Dartmouth College in den Vereinigten Staaten stattfand Pioniere der symbolischen Logik (außer dem Neurobiologen Peter Milner in der Mitte der ersten Reihe). Diese symbolische Logiktheorie konnte jedoch lange Zeit nicht verwirklicht werden und leitete in den 1980er und 1990er Jahren sogar den ersten KI-Winter ein. Erst mit der kürzlich erfolgten Implementierung großer Sprachmodelle haben wir entdeckt, dass neuronale Netze dieses logische Denken tatsächlich tragen. Die Arbeit des Neurobiologen Peter Milner inspirierte die spätere Entwicklung künstlicher neuronaler Netze, und aus diesem Grund wurde er zur Teilnahme eingeladen in diesem Projekt.

Anwendung von Algorithmen beim Aufbau einer 58-Porträt-Plattform

May 09, 2024 am 09:01 AM

Anwendung von Algorithmen beim Aufbau einer 58-Porträt-Plattform

May 09, 2024 am 09:01 AM

1. Hintergrund des Baus der 58-Portrait-Plattform Zunächst möchte ich Ihnen den Hintergrund des Baus der 58-Portrait-Plattform mitteilen. 1. Das traditionelle Denken der traditionellen Profiling-Plattform reicht nicht mehr aus. Der Aufbau einer Benutzer-Profiling-Plattform basiert auf Data-Warehouse-Modellierungsfunktionen, um Daten aus mehreren Geschäftsbereichen zu integrieren, um genaue Benutzerporträts zu erstellen Und schließlich muss es über Datenplattformfunktionen verfügen, um Benutzerprofildaten effizient zu speichern, abzufragen und zu teilen sowie Profildienste bereitzustellen. Der Hauptunterschied zwischen einer selbst erstellten Business-Profiling-Plattform und einer Middle-Office-Profiling-Plattform besteht darin, dass die selbst erstellte Profiling-Plattform einen einzelnen Geschäftsbereich bedient und bei Bedarf angepasst werden kann. Die Mid-Office-Plattform bedient mehrere Geschäftsbereiche und ist komplex Modellierung und bietet allgemeinere Funktionen. 2.58 Benutzerporträts vom Hintergrund der Porträtkonstruktion im Mittelbahnsteig 58

Fügen Sie SOTA in Echtzeit hinzu und explodieren Sie! FastOcc: Schnellere Inferenz und ein einsatzfreundlicher Occ-Algorithmus sind da!

Mar 14, 2024 pm 11:50 PM

Fügen Sie SOTA in Echtzeit hinzu und explodieren Sie! FastOcc: Schnellere Inferenz und ein einsatzfreundlicher Occ-Algorithmus sind da!

Mar 14, 2024 pm 11:50 PM

Oben geschrieben & Das persönliche Verständnis des Autors ist, dass im autonomen Fahrsystem die Wahrnehmungsaufgabe eine entscheidende Komponente des gesamten autonomen Fahrsystems ist. Das Hauptziel der Wahrnehmungsaufgabe besteht darin, autonome Fahrzeuge in die Lage zu versetzen, Umgebungselemente wie auf der Straße fahrende Fahrzeuge, Fußgänger am Straßenrand, während der Fahrt angetroffene Hindernisse, Verkehrszeichen auf der Straße usw. zu verstehen und wahrzunehmen und so flussabwärts zu helfen Module Treffen Sie richtige und vernünftige Entscheidungen und Handlungen. Ein Fahrzeug mit autonomen Fahrfähigkeiten ist in der Regel mit verschiedenen Arten von Informationserfassungssensoren ausgestattet, wie z. B. Rundumsichtkamerasensoren, Lidar-Sensoren, Millimeterwellenradarsensoren usw., um sicherzustellen, dass das autonome Fahrzeug die Umgebung genau wahrnehmen und verstehen kann Elemente, die es autonomen Fahrzeugen ermöglichen, beim autonomen Fahren die richtigen Entscheidungen zu treffen. Kopf