Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

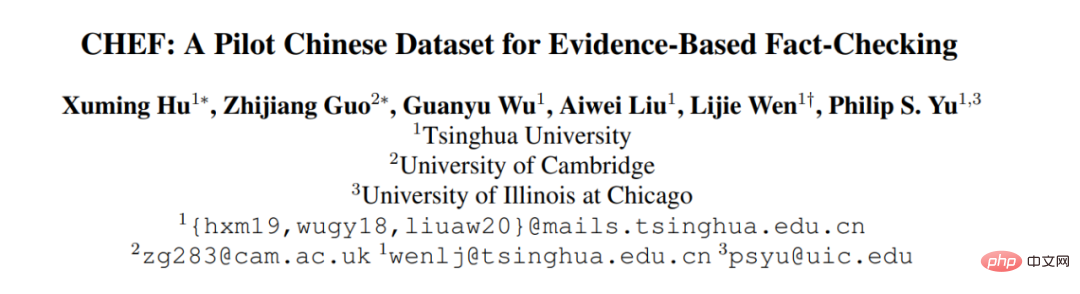

Tsinghua, Cambridge und UIC starten gemeinsam den ersten chinesischen Datensatz zur Faktenprüfung: basierend auf Beweisen und für mehrere Bereiche wie die medizinische Gesellschaft

Tsinghua, Cambridge und UIC starten gemeinsam den ersten chinesischen Datensatz zur Faktenprüfung: basierend auf Beweisen und für mehrere Bereiche wie die medizinische Gesellschaft

Tsinghua, Cambridge und UIC starten gemeinsam den ersten chinesischen Datensatz zur Faktenprüfung: basierend auf Beweisen und für mehrere Bereiche wie die medizinische Gesellschaft

- Papieradresse: https://arxiv.org/pdf/2206.11863.pdf

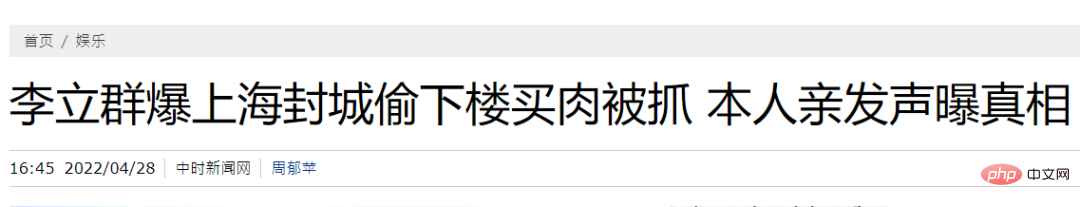

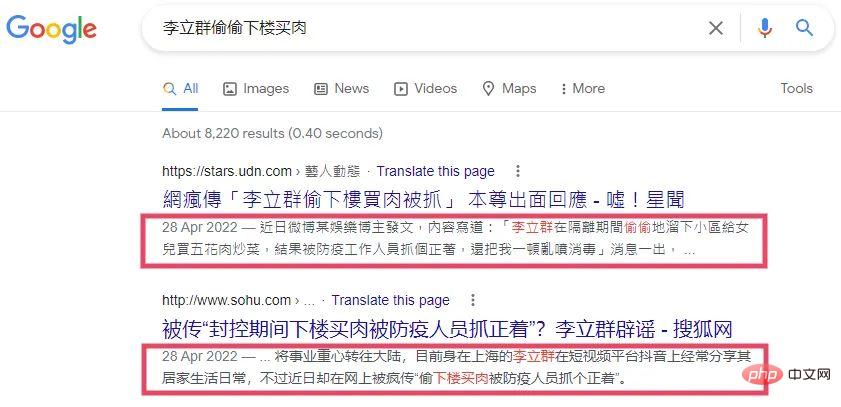

- Datensatz CHEF Datensatz-Link: https://github.com/THU-BPM/CHEF ?? Li Liqun hat gestohlen. Ich wurde dabei erwischt, wie ich nach unten ging, um Fleisch zu kaufen.“ Allein aufgrund dieser Behauptung (Claim) können wir tatsächlich nicht feststellen, ob er heimlich nach unten gegangen ist, um Fleisch zu kaufen, und dabei erwischt wurde. Um die Echtheit dieser Aussage zu überprüfen, besteht die intuitivste Idee darin, nach Beweisen zu suchen (Beweise sind Informationen, die Sie sammeln können und die uns helfen können, die Echtheit einer Aussage zu überprüfen). Auf dem Bild unten habe ich es beispielsweise einfach mit den Händen zerrissen, was als Beweis dienen kann.

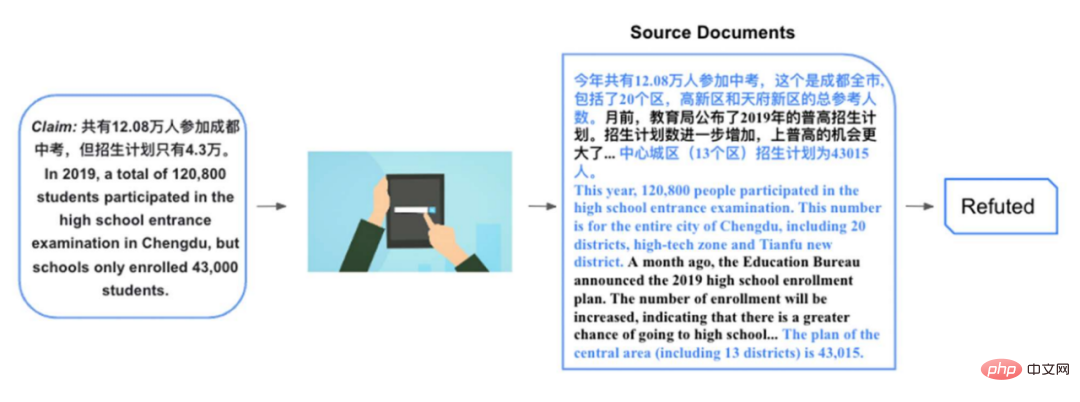

Die oben zitierte Aussage ist relativ einfach und erfordert nur einfache Beweise und keine Begründung auf der Grundlage von Beweisen. Schauen wir uns unten ein relativ komplexes Beispiel an. Es gibt beispielsweise eine Aussage: „Im Jahr 2019 haben insgesamt 120.800 Menschen die Aufnahmeprüfung für die Chengdu High School abgelegt, aber der Einschreibungsplan sieht nur 43.000 vor.“ Es ist relativ schwierig, diese Aussage zu überprüfen:

Die oben zitierte Aussage ist relativ einfach und erfordert nur einfache Beweise und keine Begründung auf der Grundlage von Beweisen. Schauen wir uns unten ein relativ komplexes Beispiel an. Es gibt beispielsweise eine Aussage: „Im Jahr 2019 haben insgesamt 120.800 Menschen die Aufnahmeprüfung für die Chengdu High School abgelegt, aber der Einschreibungsplan sieht nur 43.000 vor.“ Es ist relativ schwierig, diese Aussage zu überprüfen:

...In diesem Jahr haben insgesamt 120.800 Personen an der Aufnahmeprüfung für die High School teilgenommen Stadt Chengdu, einschließlich 20. Bezirk, High-Tech-Zone und Tianfu New District. Vor einigen Monaten gab das Bildungsbüro den allgemeinen Einschreibungsplan für die High School für 2019 bekannt. Die Zahl der Einschreibungen ist weiter gestiegen und die Chancen auf den Einstieg in die allgemeinbildende Oberschule sind noch größer. ...

Dieses Dokument enthält viele Informationen im Zusammenhang mit der Aussage, aber was direkt relevant ist und uns helfen kann, die Aussage zu überprüfen, ist die zweite Hälfte des zweiten Absatzes oben und nach vielen Absätzen der erste Satz. Basierend auf diesen Beweisstücken können wir wissen, dass in den 20 Bezirken von Chengdu tatsächlich 120.800 Menschen die Aufnahmeprüfung für das Gymnasium ablegen, und dass der Einschreibungsplan für das zentrale Stadtgebiet (das nur 13 Bezirke umfasst) tatsächlich nur 43.000 beträgt. Obwohl die Zahlen korrekt sind, wird das Konzept hier geändert. Bei der Erörterung der Anzahl der Personen, die die Aufnahmeprüfung für die weiterführende Schule ablegen, wird die Anzahl der Personen in 20 Bezirken verwendet. Bei der Erörterung des Einschreibungsplans wird der Bereich jedoch auf 20 Bezirke reduziert 13 Bezirke, was den Leser in die Irre führt. Um diese Art von Aussage zu überprüfen, müssen wir häufig direkt relevante Beweise aus einem oder mehreren Dokumenten extrahieren und gleichzeitig auf der Grundlage der extrahierten Beweise Schlussfolgerungen ziehen. Um chinesische Systeme für maschinelles Lernen zur Faktenprüfung zu fördern, schlagen wir einen solchen evidenzbasierten chinesischen Datensatz vor. 2. Verwandte Arbeiten

Künstlich (künstlich): Der Annotator wird gebeten, den Satz gemäß Wikipedia als Aussage umzuschreiben. Die relevanten Absätze im Dokument können als Beweis zur Überprüfung dieser Aussage verwendet werden. Wenn es sich um eine synonyme Konvertierung handelt, wird die Aussage durch die Beweise gestützt (Unterstützt). Wenn die Entitäten im Satz ersetzt werden oder eine Reihe von Modifikationen wie etwa eine Verneinung hinzugefügt werden, wird die Aussage durch die Beweise abgelehnt (Widerlegt). .

Dieses Annotationsparadigma war ursprünglich FEVER[2], und viele spätere berühmte Datensätze wie TabFact[3] folgten ebenfalls diesem Paradigma. Der Vorteil dieser Art von künstlichem Datensatz besteht darin, dass Annotatoren aufgefordert werden, 100.000 Aussagen zu kennzeichnen, was sich sehr gut für das Training neuronaler Netze eignet. Andererseits sind relevante Beweise auch leicht zu beschaffen. Der Nachteil besteht darin, dass es sich bei diesen Aussagen nicht um Aussagen handelt, denen wir im täglichen Leben begegnen und die in der breiten Öffentlichkeit beliebt sind. Beispielsweise würde man die Aussage „Er ging heimlich nach unten, um Fleisch zu kaufen und wurde dabei erwischt“ nicht auf der Grundlage von Li Liquns Wikipedia umschreiben . Andererseits wird bei dieser Art von Datensatz davon ausgegangen, dass Wikipedia über das gesamte Wissen zur Überprüfung der Behauptungen verfügt, was eine relativ starke Annahme ist. Diese Annahme wird in realen Szenarien oft nicht erfüllt. Das einfachste Problem ist, dass Wikipedia eine Zeitverzögerung hat.

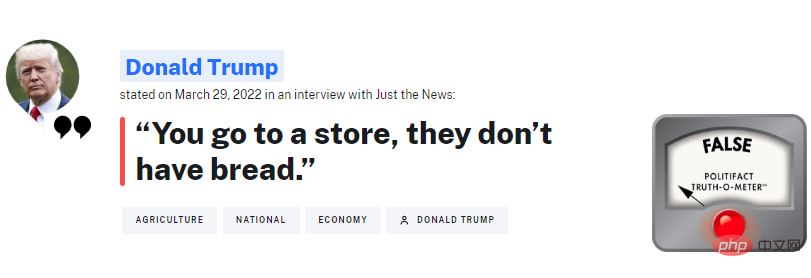

Natürlich: von der Faktencheck-Plattform Für direkt gecrawlte Aussagen, Eine bekannte ausländische Organisation ist PolitiFact, die oft bestätigt, was Trump sagt. Der Vorteil dieser Art von Datensätzen besteht darin, dass es sich um eine Aussage handelt, mit der die breite Öffentlichkeit jeden Tag konfrontiert wird und die die Wahrheit wissen möchte. Es ist auch eine Aussage, die menschliche Faktenprüfer durchgehen müssen.

Wenn wir letztendlich ein System aufbauen wollen, das menschliche Prüfer bis zu einem gewissen Grad ersetzen kann, muss der Input dieses Systems eine Aussage dieser Art sein. Der Nachteil dieser Art von Datensätzen liegt ebenfalls auf der Hand, nämlich dass die Anzahl der Behauptungen, die von Menschen überprüft wurden, sehr begrenzt ist. Wie die Tabelle zeigt, sind die meisten Datensätze tatsächlich um eine Größenordnung kleiner als die manuell erstellten.

Andererseits ist die Suche nach Beweisen ein sehr schwieriges Problem. Vorhandene Datensätze verwenden im Allgemeinen direkt Artikel zur Faktenprüfung [4] als Beweis oder verwenden Aussagen zur Eingabe von Google-Suchanfragen [5][6] und verwenden dann die zurückgegebene Suchzusammenfassung (im roten Feld angezeigt) als Beweis. Bei diesen Methoden der Beweisfindung gibt es zwei Probleme: #

Verwenden Sie den Artikel zur Faktenprüfung selbst als Beweis: In realen Szenarien ist dieser Ansatz unrealistisch, wenn wir wollen Um ein System zur Überprüfung von Fakten zu starten, benötigt das System. Wenn es um die Überprüfung neuer Behauptungen geht, gibt es oft noch keine Artikel zur Überprüfung von Fakten. Auf diese Weise kann das System nicht lernen, Beweise zu sammeln.

Verwenden Sie Google-Snippets als Beweis: Dieser Ansatz überwindet die oben genannten Probleme und ist näher an der Realität. Faktenprüfer müssen sich häufig auf Suchmaschinen verlassen, um relevante Informationen zu finden. Allerdings hat diese Methode auch Nachteile, nämlich dass die Informationsmenge erheblich unzureichend ist. Wie in der Abbildung oben gezeigt, kann die regelbasierte Zusammenfassung von Google nicht genügend Informationen liefern, um die Authentizität der Aussage zu beurteilen.

Verwenden Sie die von der Suchmaschine zurückgegebenen Dokumente als Originalbeweise, die der realen Szene näher kommen.

- Als Reaktion auf die oben genannten Probleme haben wir CHEF mit den folgenden Eigenschaften konstruiert: #🎜🎜 #

- verwendet reale Behauptungen, ist aber auf Chinesisch und füllt so die Lücke in chinesischen Datensätzen zur Faktenprüfung.

Verwendung menschlicher Anmerkungen, um relevante Sätze des Dokuments als feinkörnige Beweise zurückzugeben, die zum Trainieren des Verifizierungssystems verwendet werden können, um zu lernen, wie man Beweise sammelt.

- 3. Datensatzaufbau

- Der Aufbau des Datensatzes besteht aus 4 Teilen: Datenerfassung, Aussage Annotation, Beweisabruf und Datenvalidierung

.- 3.1 Datenerfassung

Originalaussage hauptsächlich von vier chinesischen Websites zur Faktenprüfung oben (laut Duke News Platform) gibt es zwei in vereinfachtem Chinesisch: China Rumor Refuting Center und Tencent's True Truth. Traditionelles Chinesisch kommt von zwei Plattformen in Taiwan: MyGoPen und dem Taiwan Fact-Checking Center. Da die überwiegende Mehrheit (über 90 %) der Behauptungen, die von Websites zur Faktenprüfung gecrawlt werden, falsch sind, ist es eigentlich ganz intuitiv, dass die meisten populären Gerüchte/Aussagen falsch sind und von der Verifizierungsplattform widerlegt/verifiziert werden. Unter Bezugnahme auf frühere Methoden (PublicHealth [7]) haben wir die Titel des China News Network als echte Behauptungen gecrawlt und einen Datensatz mit relativ ausgewogenen Bezeichnungen erstellt.

3.2 Erklärungsanmerkung

Im Vergleich zu relativ ausgereiften ausländischen Organisationen zur Faktenprüfung Die von Chinas Verifizierungsplattformen veröffentlichten Artikel sind relativ unstandardisiert. PolitiFact sagt Ihnen beispielsweise genau, um welchen Anspruch es sich handelt, wie die Überprüfungszusammenfassung lautet und welche Beweise und Begründungsdetails vorliegen (wie im Bild oben dargestellt). In chinesischen Artikeln wird dies jedoch im Allgemeinen nicht klar angegeben. Daher bitten wir die Kommentatoren, den Artikel zu lesen und die durch den Artikel bestätigte Aussage zu extrahieren. Gleichzeitig wird die Aussage auch bereinigt, um die darin enthaltene Verzerrung zu reduzieren.

Frühere Arbeiten haben gezeigt [8], dass die Aussagen im Datensatz zur Faktenprüfung relativ starke Verzerrungen enthalten (z. B. haben unwahre Aussagen im Allgemeinen negative Wörter), BERT Wenn PLM diese Vorurteile direkt erfassen kann, können Behauptungen ohne Beweise überprüft werden. Zu den Reinigungsmethoden gehört es, rhetorische Fragen in Aussagesätze umzuwandeln und einige Wörter zu entfernen, die möglicherweise voreingenommen sind, wie zum Beispiel: schwer, schockierend usw. Nach dem Extrahieren der Behauptungen haben wir die Kommentatoren außerdem gebeten, die Behauptungen anhand von Artikeln zur Faktenprüfung zu kennzeichnen. Wir übernehmen eine Klassifizierung ähnlich der einer Werkreihe wie FEVER und verwenden die drei Klassifizierungen „Unterstützt“, „Widerlegt“ und „Nicht genügend Informationen“ (NEI). Unter ihnen ist Refuted das größte und NEI das kleinste.

3.3 Beweisabfrage

Wir verwenden die Anweisung als Abfrageanweisung, um die Google-Suche abzufragen, und filtern dann einige Dokumente heraus, einige davon Der andere Teil sind die Dokumente der Fake-News-Verbreitungsplattform, und schließlich werden die Top-5-Dokumente aufbewahrt. Anschließend wurden die Kommentatoren gebeten, bis zu 5 Sätze als Beleg für jede Aussage auszuwählen.

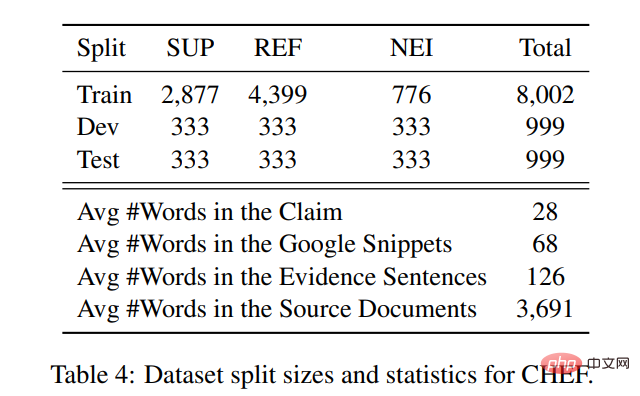

Die Statistiken für die Ansprüche und Beweise im Datensatz lauten wie folgt: Die durchschnittliche Länge der pro Anspruch zurückgegebenen Dokumente beträgt 3691 Wörter, wobei der Annotator die letzte Strafe extrahiert Detaillierte Beweissätze enthalten 126 Wörter bzw. durchschnittlich 68 Wörter, wenn man die regelbasierten Zusammenfassungen von Google zugrunde legt. Der einfache Vergleich von Zahlen unter Verwendung zurückgegebener Dokumente und kommentierter Sätze liefert mehr Kontextinformationen als die direkte Verwendung von Zusammenfassungen.

3.4 Datenüberprüfung

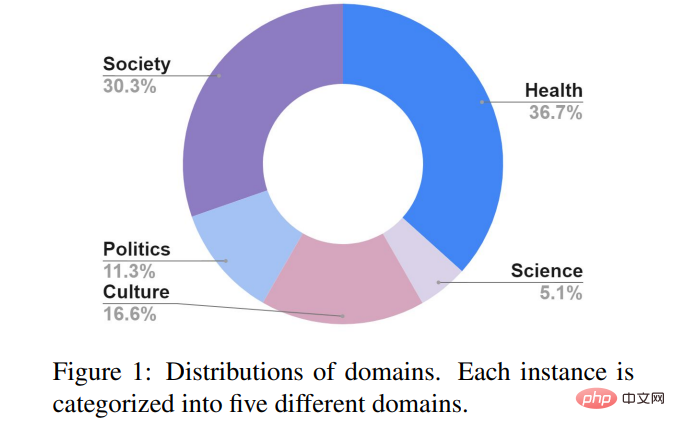

Um die Konsistenz der Anmerkung sicherzustellen, haben wir hinzugefügt Eine Runde Zur Datenüberprüfung wurden 3 % der beschrifteten Aussagen zufällig ausgewählt und insgesamt 310 Aussagen zur Neubeschriftung an 5 Annotatoren verteilt. Der Fleiss-K-Score erreichte 0,74, was etwas höher ist als der von FEVER mit 0,68 und der von Snopes[5] mit 0,70, was darauf hindeutet, dass die Qualität der Datenannotation den von früheren Personen erstellten Datensätzen nicht unterlegen ist. Die Stellungnahme in CHEF ist hauptsächlich in fünf Themenbereiche unterteilt: Gesellschaft, öffentliche Gesundheit, Politik, Wissenschaft und Kultur. Im Gegensatz zu europäischen und amerikanischen Plattformen zur Faktenprüfung, die sich auf den politischen Bereich konzentrieren, widmen chinesische Plattformen Fragen der öffentlichen Gesundheit mehr Aufmerksamkeit, wie dem neuen Coronavirus, der Gesundheitsversorgung, der medizinischen Behandlung usw. Ein weiteres großes Thema ist die Gesellschaft, wie zum Beispiel: Betrug, Weiterbildung, gesellschaftliche Veranstaltungen usw.

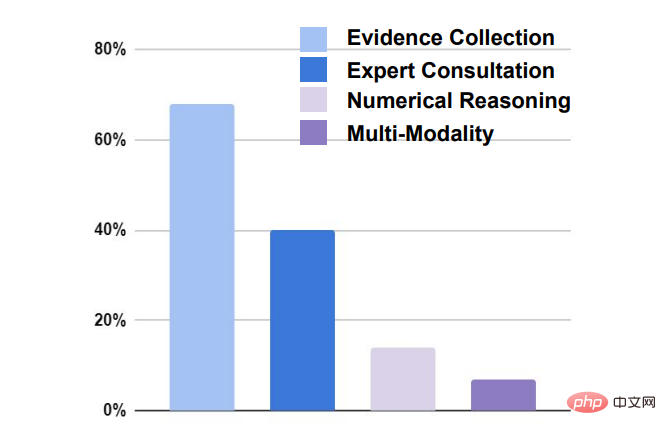

Es gibt vier Hauptherausforderungen bei der Überprüfung von Ansprüchen:

# 🎜🎜#

- Beweissammlung: Bei fast 70 % der Ansprüche ist die Suche nach relevanten Beweisen erforderlich, bevor sie überprüft werden können.

- Expertenberatung: Fast 40 % der Schadensfälle erfordern die Beratung durch Experten, um relevante Informationen zu erhalten.

- Numerisches Denken: 18 % der Anspruchsüberprüfungen erfordern numerisches Denken, um zu einer Schlussfolgerung zu gelangen.

- Multimodal: Etwa 8 % der Ansprüche erfordern nicht-textuelle Beweise wie Bilder, Videos usw.

4 . Das Basissystem

ähnelt früheren klassischen Datensätzen zur Faktenprüfung (z. B. FEVER). ) und die Maschine Das lernende System muss zunächst relevante Sätze in einem bestimmten Dokument als Beweismittel auswählen (Beweisabruf) und dann die Aussage anhand der Beweise überprüfen (Anspruchsüberprüfung).

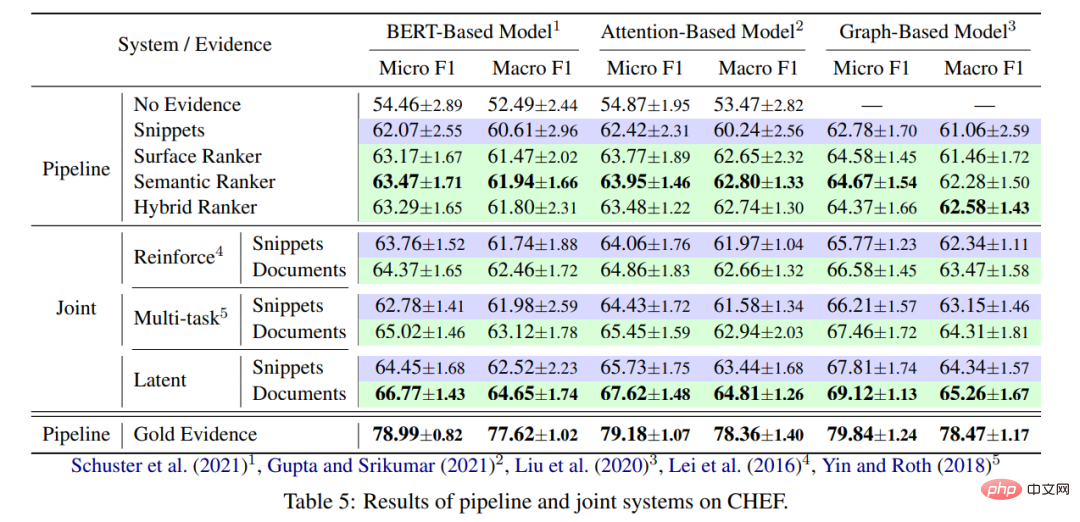

Basierend auf der Arbeit Tausender Menschen schlägt dieser Artikel zwei Hauptkategorien von Basissystemen vor: Rohrleitungs- und Verbindungssysteme. Pipeline: Beweisabruf und Anspruchsüberprüfung sind zwei separate Module. Der Beweisabruf dient zunächst dazu, Beweise zu extrahieren, und dann werden die kombinierten Ansprüche zur Klassifizierung an das Anspruchsüberprüfungsmodul übergeben.

- Beweisbeschaffungsteil: Wir verwenden 4 verschiedene Extraktoren, um Sätze als feinkörnige Beweise aus den zurückgegebenen Dokumenten zu extrahieren. Der erste basiert auf dem Abgleich von Zeichenmerkmalen: TF-IDF; der zweite basiert auf dem Abgleich von semantischen Merkmalen: Wir verwenden chinesisches BERT und berechnen dann die Kosinusähnlichkeit. Das dritte sind Hybridfunktionen: Nehmen Sie die beiden oben genannten Funktionen und verwenden Sie dann rankSVM zum Sortieren. Das endgültige Basissystem ist das klassische von Google zurückgegebene Snippet.

- Teil der Aussageüberprüfung: Wir verwenden 3 verschiedene Modelle. Die erste basiert auf dem chinesischen BERT, wobei die Aussage und die oben erhaltenen Beweise zusammengefügt und für drei Klassifizierungen an BERT übergeben werden. Das zweite ist ein aufmerksamkeitsbasiertes Modell, das Beweise anhand unterschiedlich gewichteter Behauptungen klassifiziert. Das dritte ist ein graphbasiertes Modell: Wir verwenden das SOTA-Graphmodell KGAT[9] für FEVER, das verschiedene Beweise für die Argumentation besser synthetisieren kann.

Gemeinsam: Die Module zur Beweiserhebung und Anspruchsüberprüfung werden gemeinsam optimiert. Es werden drei verschiedene Modelle verwendet. Das erste ist das gemeinsame Modell von SOTA on FEVER [10], das ein Multitasking-Lernframework verwendet, um zu lernen, Beweise und Behauptungen gleichzeitig zu kennzeichnen. Die zweite Möglichkeit besteht darin, die Beweisextraktion als latente Variable [11] zu verarbeiten und jeden Satz des zurückgegebenen Dokuments mit 0 oder 1 zu kennzeichnen. Die mit 1 gekennzeichneten Sätze werden als Beweis belassen und zusammen mit der Aussage klassifiziert, wobei REINFORCE für das Training verwendet wird . Die dritte Methode ähnelt der zweiten Methode, außer dass sie HardKuma und die Methode mit schweren Parametern für das gemeinsame Training [12] verwendet, anstatt den Richtliniengradienten zu verwenden. 5. Experimentelle Ergebnisse 5.1 Hauptergebnisse Allgemein, vor allem, weil das Beweisabrufmodul optimiert werden kann, um Beweise zu finden, die für die Validierung von Ansprüchen nützlicher sind. Andererseits ist die Verwendung des zurückgegebenen Dokuments immer besser als die Verwendung des Google-Snippets, vor allem weil das Dokument umfangreichere Informationen enthält. Schließlich geht die Evidenzwirkung der direkten Verwendung menschlicher Anmerkungen weit über die der beiden aktuellen Hauptkategorien von Basismodellen hinaus. Ähnlich wie bei anderen Datensätzen zur Faktenprüfung (FEVEROUS) stellt die Beweisbeschaffung eine Schwierigkeit bei der Überprüfung von Behauptungen dar. Die Optimierung des Evidence-Retrieval-Moduls auf der Grundlage von menschlich markierten Beweisen ist eine Richtung, die es wert ist, in Zukunft untersucht zu werden.

Aus Sicht der Anspruchsüberprüfung: Das graphbasierte Modell (KGAT) bietet eine bessere Leistung als einfache BERT-basierte und aufmerksamkeitsbasierte Modelle und ist eine effektive Methode, um die Beweiskette durch die Erstellung eines Diagramms zu erfassen. Andererseits ist die Verbesserung des Diagrammmodells jedoch nicht besonders offensichtlich, und für den Datensatz selbst ist möglicherweise eine gewisse Optimierung basierend auf den lokalen Bedingungen erforderlich.

5.2 Die Anzahl der feinkörnigen Beweise Beweise im Pipeline-System Der Beweisextraktor erzielte die besten Ergebnisse, als 10 und 15 Sätze als Beweis extrahiert wurden. Wir vermuten, dass mehr Rauschen in die extrahierten Sätze eingeführt wurde, was sich auf das Modell der Aussageüberprüfung auswirkte. Richter.

- 5.3 Auswirkung der Aussagelänge

Je länger die Länge, desto besser ist der Modelleffekt. Der Hauptgrund liegt vermutlich darin, dass die Aussage detaillierter und einfacher ist Detaillierte Beweise helfen dem Modell, Urteile zu fällen. Wenn die Aussagelänge relativ kurz ist, ist die Lücke zwischen den zentralisierten Basismodellen nicht sehr groß. Wenn die Aussagelänge relativ lang ist, ist der Effekt der Aussageüberprüfung umso besser, was auch die Bedeutung des Beweisabrufs verdeutlicht.

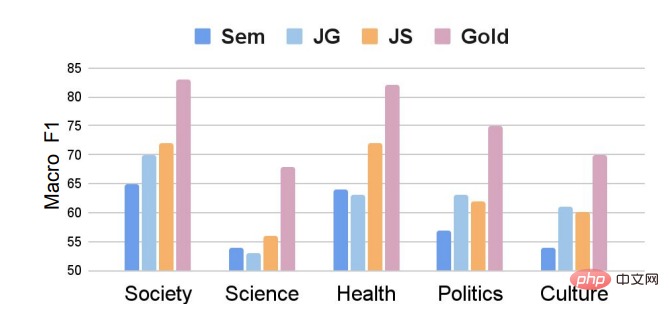

5.4 Feldwirkungserklärung

aus dem Bereich der Wissenschaft Die Aussage ist am schwierigsten zu überprüfen und der Modelleffekt überschreitet grundsätzlich nicht 55. Einerseits ist es schwieriger, relevante Beweise zu sammeln, andererseits sind Aussagen zu wissenschaftlichen Fragestellungen relativ komplex und erfordern oft eine implizite Begründung, um zu Ergebnissen zu gelangen.

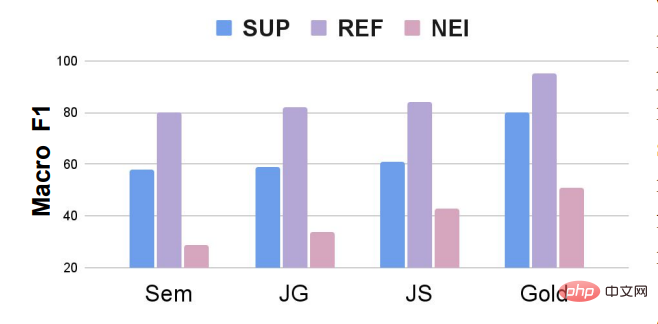

5.5 Auswirkungen von Deklarationskategorien

Wie in der Abbildung gezeigt, auch wenn wir Führen Sie eine teilweise unterstützte Anweisung ein, aber der gesamte Datensatz leidet immer noch unter einem Klassenungleichgewicht. Der Effekt des Modells auf die NEI-Kategorie ist viel schwächer als auf die Kategorien „Unterstützt“ und „Widerlegt“. Zukünftige Arbeiten können untersuchen, wie das Anspruchsüberprüfungsmodell für kategorieunausgeglichene Faktenprüfungsdatensätze angepasst werden kann, oder Datenerweiterungsmethoden verwenden, um die Anzahl der NEIs während des Trainingsprozesses zufällig zu erhöhen. FEVEROUS [13] erhöht beispielsweise zufällig die Anzahl NEIs verwerfen während des Schulungsprozesses die Beweise für einige Behauptungen und ändern die Kategorie dieser Behauptungen in NEI.

Das obige ist der detaillierte Inhalt vonTsinghua, Cambridge und UIC starten gemeinsam den ersten chinesischen Datensatz zur Faktenprüfung: basierend auf Beweisen und für mehrere Bereiche wie die medizinische Gesellschaft. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1393

1393

52

52

1206

1206

24

24

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

ICCV'23-Papierpreis „Fighting of Gods'! Meta Divide Everything und ControlNet wurden gemeinsam ausgewählt, und es gab einen weiteren Artikel, der die Jury überraschte

Oct 04, 2023 pm 08:37 PM

ICCV'23-Papierpreis „Fighting of Gods'! Meta Divide Everything und ControlNet wurden gemeinsam ausgewählt, und es gab einen weiteren Artikel, der die Jury überraschte

Oct 04, 2023 pm 08:37 PM

ICCV2023, die Top-Computer-Vision-Konferenz in Paris, Frankreich, ist gerade zu Ende gegangen! Der diesjährige Preis für das beste Papier ist einfach ein „Kampf zwischen Göttern“. Zu den beiden Arbeiten, die den Best Paper Award gewannen, gehörte beispielsweise ControlNet, eine Arbeit, die das Gebiet der vinzentinischen Graphen-KI untergrub. Seitdem ControlNet als Open-Source-Lösung verfügbar ist, hat es auf GitHub 24.000 Sterne erhalten. Ob es sich um Diffusionsmodelle oder den gesamten Bereich der Computer Vision handelt, die Auszeichnung für dieses Papier ist wohlverdient. Die lobende Erwähnung für die beste Arbeit ging an eine andere ebenso berühmte Arbeit, Metas „Separate Everything“ „Model SAM“. Seit seiner Einführung ist „Segment Everything“ zum „Benchmark“ für verschiedene Bildsegmentierungs-KI-Modelle geworden, auch für solche, die von hinten kamen.

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

Chat-Screenshots enthüllen versteckte Regeln für KI-Rezensenten! AAAI 3000 Yuan ist stark zu akzeptieren?

Apr 12, 2023 am 08:34 AM

Chat-Screenshots enthüllen versteckte Regeln für KI-Rezensenten! AAAI 3000 Yuan ist stark zu akzeptieren?

Apr 12, 2023 am 08:34 AM

Gerade als die Einreichungsfrist für AAAI 2023-Papiere näher rückte, erschien plötzlich ein Screenshot eines anonymen Chats in der AI-Einreichungsgruppe auf Zhihu. Einer von ihnen behauptete, er könne „3.000 Yuan pro starkem Akzept“ anbieten. Sobald die Nachricht bekannt wurde, erregte sie sofort öffentliche Empörung unter den Internetnutzern. Aber beeilen Sie sich noch nicht. Zhihu-Chef „Fine Tuning“ sagte, dass dies höchstwahrscheinlich nur ein „verbales Vergnügen“ sei. Laut „Fine Tuning“ sind Begrüßungen und Bandenkriminalität in jedem Bereich unvermeidbare Probleme. Mit dem Aufkommen von OpenReview werden die verschiedenen Nachteile von cmt immer deutlicher. Der Spielraum für kleine Kreise wird in Zukunft kleiner, aber es wird immer Platz geben. Denn es handelt sich um ein persönliches Problem und nicht um ein Problem mit dem Einreichungssystem und -mechanismus. Wir stellen Open R vor

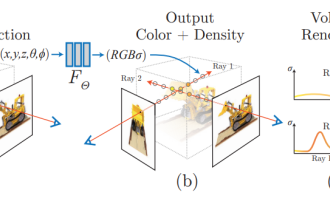

NeRF und die Vergangenheit und Gegenwart des autonomen Fahrens, eine Zusammenfassung von fast 10 Artikeln!

Nov 14, 2023 pm 03:09 PM

NeRF und die Vergangenheit und Gegenwart des autonomen Fahrens, eine Zusammenfassung von fast 10 Artikeln!

Nov 14, 2023 pm 03:09 PM

Seit Neural Radiance Fields im Jahr 2020 vorgeschlagen wurde, hat die Zahl verwandter Arbeiten exponentiell zugenommen. Es hat sich nicht nur zu einem wichtigen Zweig der dreidimensionalen Rekonstruktion entwickelt, sondern ist auch allmählich an der Forschungsgrenze als wichtiges Werkzeug für autonomes Fahren aktiv geworden . NeRF ist in den letzten zwei Jahren plötzlich aufgetaucht, hauptsächlich weil es die Merkmalspunktextraktion und -anpassung, die epipolare Geometrie und Triangulation, PnP plus Bündelanpassung und andere Schritte der traditionellen CV-Rekonstruktionspipeline und sogar die Netzrekonstruktion, Kartierung und Lichtverfolgung überspringt , direkt aus 2D Das Eingabebild wird verwendet, um ein Strahlungsfeld zu lernen, und dann wird aus dem Strahlungsfeld ein gerendertes Bild ausgegeben, das einem echten Foto nahekommt. Mit anderen Worten: Lassen Sie ein implizites dreidimensionales Modell, das auf einem neuronalen Netzwerk basiert, zur angegebenen Perspektive passen

Auch Papierillustrationen können mithilfe des Diffusionsmodells automatisch generiert werden und werden auch vom ICLR akzeptiert.

Jun 27, 2023 pm 05:46 PM

Auch Papierillustrationen können mithilfe des Diffusionsmodells automatisch generiert werden und werden auch vom ICLR akzeptiert.

Jun 27, 2023 pm 05:46 PM

Generative KI hat die Community der künstlichen Intelligenz im Sturm erobert. Sowohl Einzelpersonen als auch Unternehmen sind daran interessiert, entsprechende modale Konvertierungsanwendungen wie Vincent-Bilder, Vincent-Videos, Vincent-Musik usw. zu erstellen. In jüngster Zeit haben mehrere Forscher von wissenschaftlichen Forschungseinrichtungen wie ServiceNow Research und LIVIA versucht, Diagramme in Aufsätzen basierend auf Textbeschreibungen zu erstellen. Zu diesem Zweck schlugen sie eine neue Methode von FigGen vor, und das entsprechende Papier wurde auch als TinyPaper in ICLR2023 aufgenommen. Adresse des Bildpapiers: https://arxiv.org/pdf/2306.00800.pdf Manche Leute fragen sich vielleicht: Was ist so schwierig daran, die Diagramme im Papier zu erstellen? Wie hilft dies der wissenschaftlichen Forschung?

Das chinesische Team gewann die Auszeichnungen „Best Paper' und „Best System Paper' und die CoRL-Forschungsergebnisse wurden bekannt gegeben.

Nov 10, 2023 pm 02:21 PM

Das chinesische Team gewann die Auszeichnungen „Best Paper' und „Best System Paper' und die CoRL-Forschungsergebnisse wurden bekannt gegeben.

Nov 10, 2023 pm 02:21 PM

Seit ihrer ersten Veranstaltung im Jahr 2017 hat sich die CoRL zu einer der weltweit führenden akademischen Konferenzen an der Schnittstelle von Robotik und maschinellem Lernen entwickelt. CoRL ist eine themenspezifische Konferenz für Roboterlernforschung, die mehrere Themen wie Robotik, maschinelles Lernen und Steuerung, einschließlich Theorie und Anwendung, abdeckt. Die CoRL-Konferenz 2023 findet vom 6. bis 9. November in Atlanta, USA, statt. Nach offiziellen Angaben wurden in diesem Jahr 199 Arbeiten aus 25 Ländern für CoRL ausgewählt. Beliebte Themen sind Operationen, Reinforcement Learning und mehr. Obwohl CoRL von kleinerem Umfang ist als große akademische KI-Konferenzen wie AAAI und CVPR, wird die Beliebtheit von Konzepten wie großen Modellen, verkörperter Intelligenz und humanoiden Robotern in diesem Jahr zunehmen, aber auch relevante Forschung verdient Aufmerksamkeit

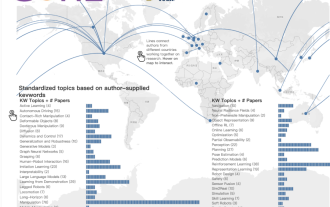

CVPR-Rangliste 2023 veröffentlicht, die Akzeptanzrate beträgt 25,78 %! 2.360 Beiträge wurden angenommen und die Zahl der Einreichungen stieg auf 9.155

Apr 13, 2023 am 09:37 AM

CVPR-Rangliste 2023 veröffentlicht, die Akzeptanzrate beträgt 25,78 %! 2.360 Beiträge wurden angenommen und die Zahl der Einreichungen stieg auf 9.155

Apr 13, 2023 am 09:37 AM

Gerade hat CVPR 2023 eine Erklärung herausgegeben, in der es heißt: In diesem Jahr haben wir eine Rekordzahl von 9.155 Beiträgen erhalten (ein Anstieg von 12 % gegenüber CVPR 2022) und 2.360 Beiträge angenommen, was einer Annahmequote von 25,78 % entspricht. Laut Statistik stieg die Zahl der Einreichungen beim CVPR in den sieben Jahren von 2010 bis 2016 lediglich von 1.724 auf 2.145. Nach 2017 stieg sie rasant an und trat in eine Phase rasanten Wachstums ein. Im Jahr 2019 überstieg sie erstmals die 5.000-Marke, und bis 2022 lag die Zahl der Einreichungen bei 8.161. Wie Sie sehen, wurden in diesem Jahr insgesamt 9.155 Beiträge eingereicht, was einen Rekord darstellt. Nachdem sich die Epidemie abgeschwächt hat, wird der diesjährige CVPR-Gipfel in Kanada stattfinden. In diesem Jahr wird das Format einer eingleisigen Konferenz übernommen und die traditionelle mündliche Auswahl entfällt. Google-Recherche

Verwenden Sie den Artikel zur Faktenprüfung selbst als Beweis: In realen Szenarien ist dieser Ansatz unrealistisch, wenn wir wollen Um ein System zur Überprüfung von Fakten zu starten, benötigt das System. Wenn es um die Überprüfung neuer Behauptungen geht, gibt es oft noch keine Artikel zur Überprüfung von Fakten. Auf diese Weise kann das System nicht lernen, Beweise zu sammeln.

Verwenden Sie den Artikel zur Faktenprüfung selbst als Beweis: In realen Szenarien ist dieser Ansatz unrealistisch, wenn wir wollen Um ein System zur Überprüfung von Fakten zu starten, benötigt das System. Wenn es um die Überprüfung neuer Behauptungen geht, gibt es oft noch keine Artikel zur Überprüfung von Fakten. Auf diese Weise kann das System nicht lernen, Beweise zu sammeln.