Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

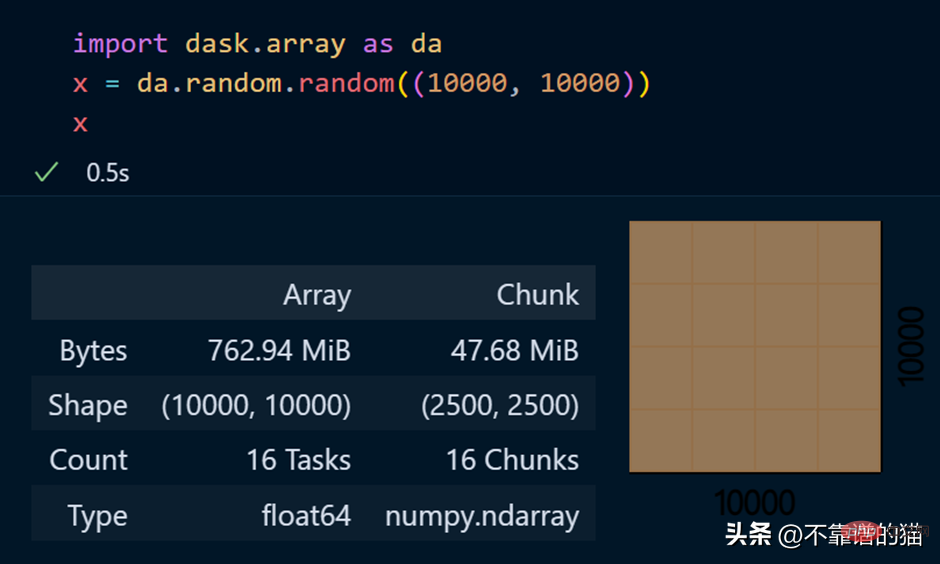

Eine einfache Möglichkeit, große Datensätze für maschinelles Lernen in Python zu verarbeiten

Eine einfache Möglichkeit, große Datensätze für maschinelles Lernen in Python zu verarbeiten

Eine einfache Möglichkeit, große Datensätze für maschinelles Lernen in Python zu verarbeiten

Die Zielgruppe dieses Artikels:

- Menschen, die Pandas/NumPy-Operationen an großen Datensätzen durchführen möchten.

- Personen, die Python verwenden möchten, um maschinelle Lernaufgaben für Big Data auszuführen.

In diesem Artikel werden Dateien im CSV-Format verwendet, um verschiedene Vorgänge von Python sowie andere Formate wie Arrays und Textdateien zu demonstrieren , usw. .

Warum können wir Pandas nicht für große Datensätze für maschinelles Lernen verwenden?

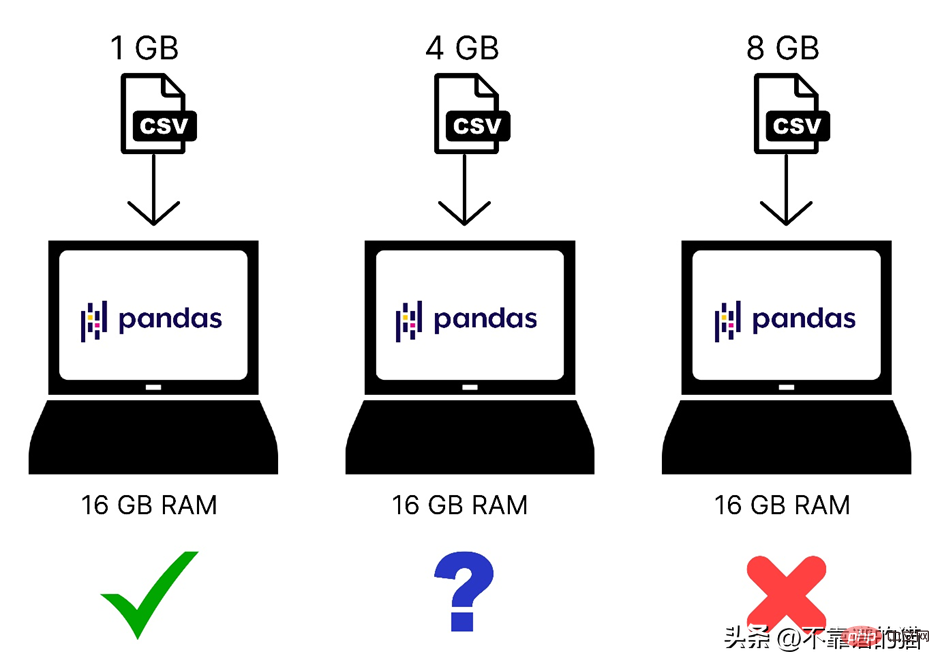

Wir wissen, dass Pandas Computerspeicher (RAM) verwendet, um Ihren Datensatz für maschinelles Lernen zu laden. Wenn Ihr Computer jedoch über 8 GB Speicher (RAM) verfügt, warum können Pandas dann immer noch nicht 2 GB davon laden? Was ist damit? der Datensatz? Der Grund dafür ist, dass das Laden einer 2-GB-Datei mit Pandas nicht nur 2 GB RAM, sondern auch mehr Speicher erfordert, da der Gesamtspeicherbedarf von der Größe des Datensatzes und den Vorgängen abhängt, die Sie an diesem Datensatz ausführen.

Hier ist ein schneller Vergleich unterschiedlich großer Datensätze, die in den Computerspeicher geladen werden:

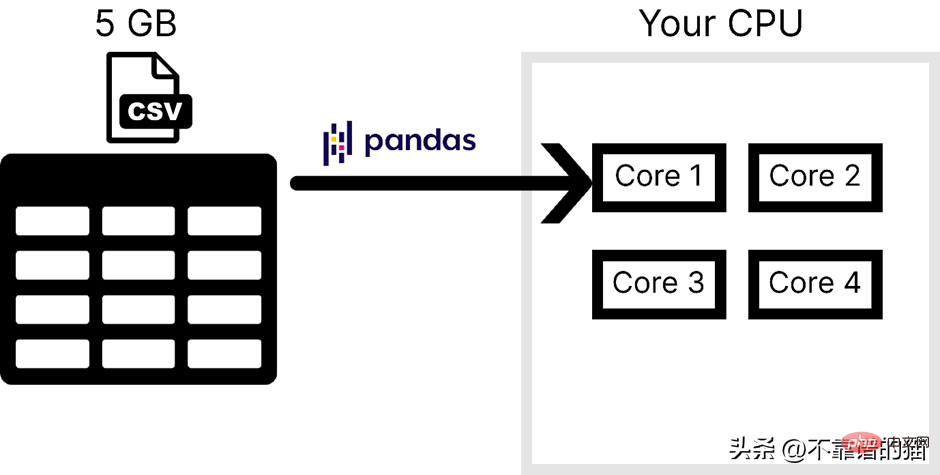

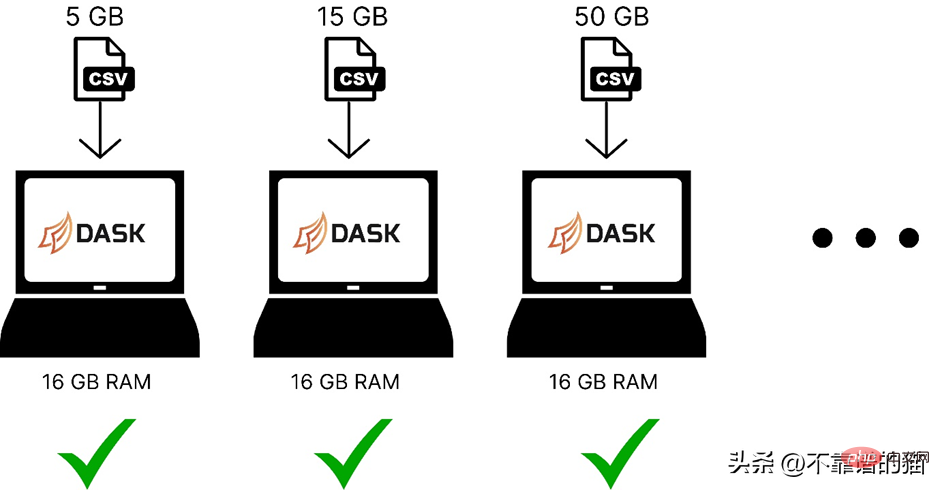

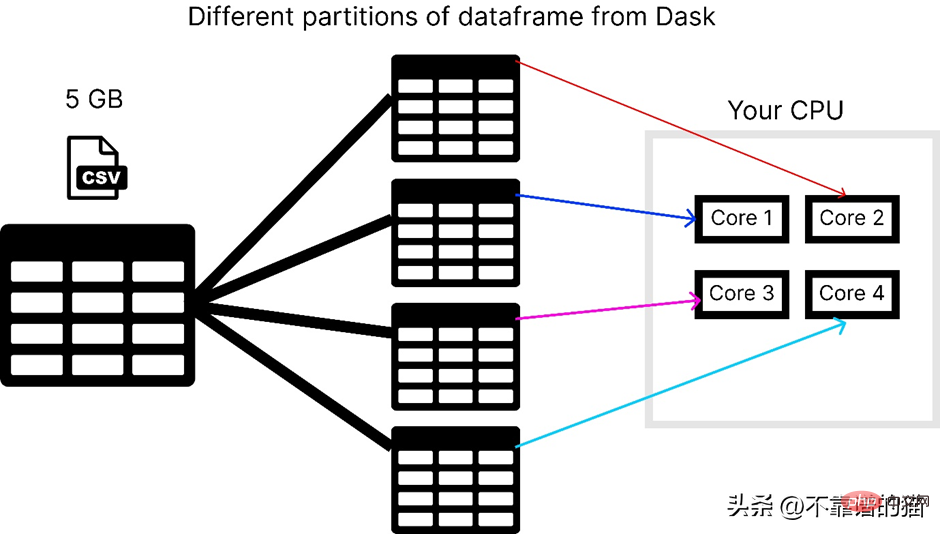

Darüber hinaus verwendet Pandas nur einen Kern des Betriebssystem, was die Verarbeitung verlangsamt. Mit anderen Worten können wir sagen, dass Pandas keine Parallelität (Aufteilung eines Problems in kleinere Aufgaben) unterstützt.

Unter der Annahme, dass der Computer über 4 Kerne verfügt, zeigt das folgende Bild die Anzahl der von Pandas beim Laden einer CSV-Datei verwendeten Kerne:

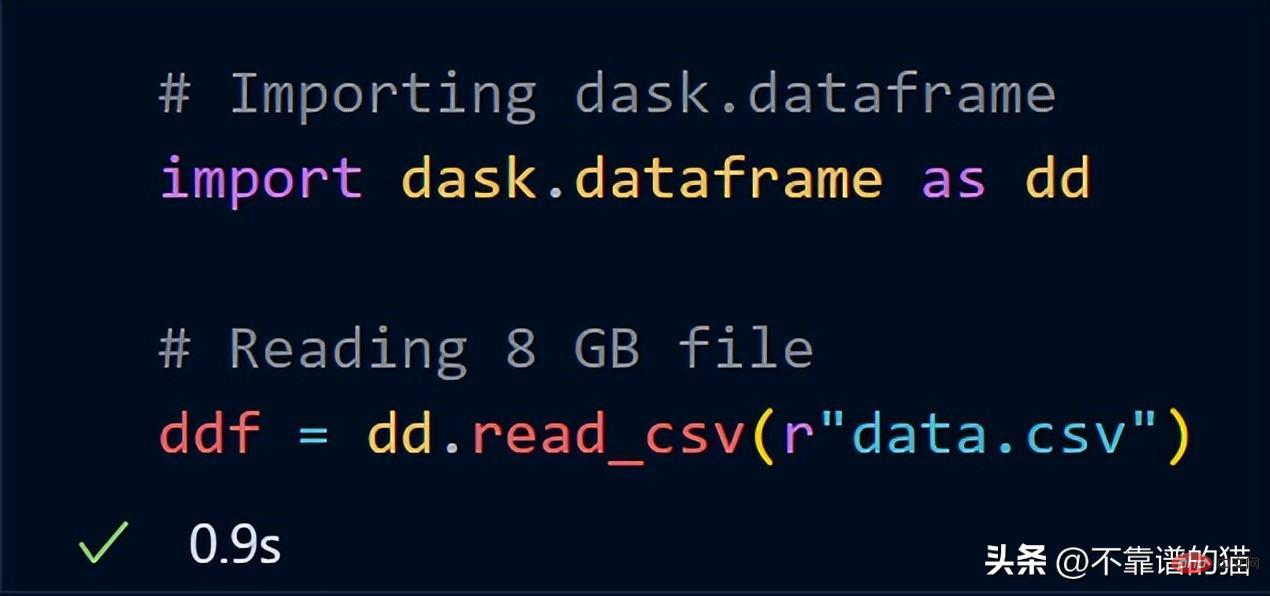

<span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">pip</span> <span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">install</span> <span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">dask</span>

<span style="color: rgb(215, 58, 73); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">import</span> <span style="color: rgb(0, 92, 197); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">pandas</span> <span style="color: rgb(215, 58, 73); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">as</span> <span style="color: rgb(0, 92, 197); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">pd</span><br><span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">df</span> <span style="color: rgb(215, 58, 73); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">=</span> <span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">pd</span>.<span style="color: rgb(0, 92, 197); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">read_csv</span>(<span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">“data</span>.<span style="color: rgb(0, 92, 197); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">csv”</span>)

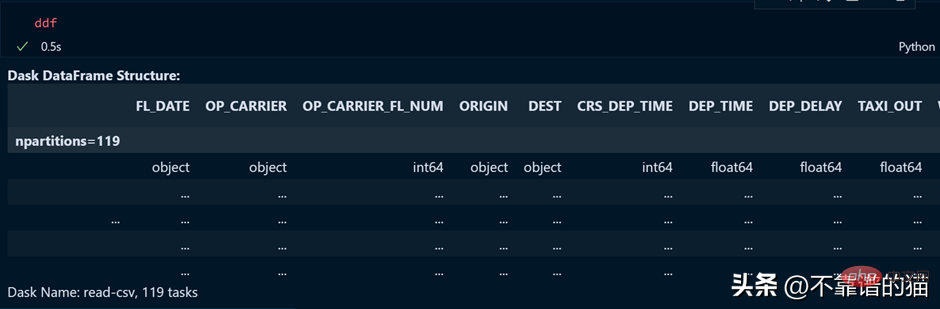

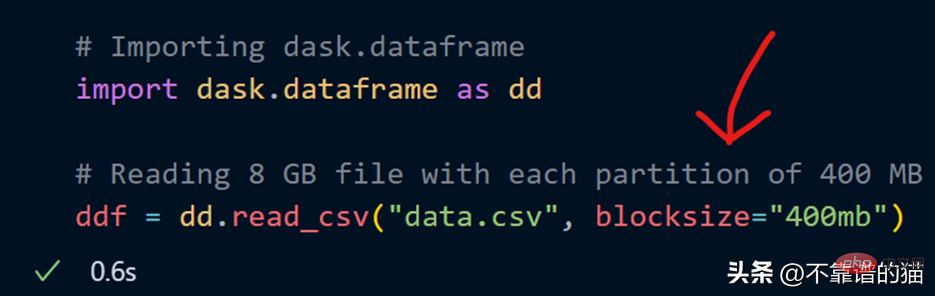

Ich kann beim Laden der CSV-Datei auch meine eigene Anzahl an Partitionen angeben, indem ich den Blocksize-Parameter verwende.

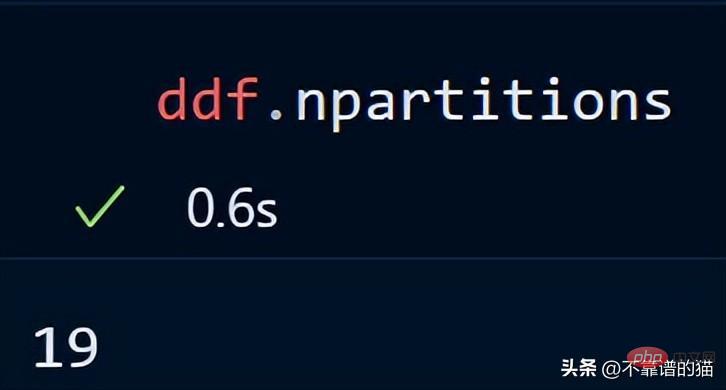

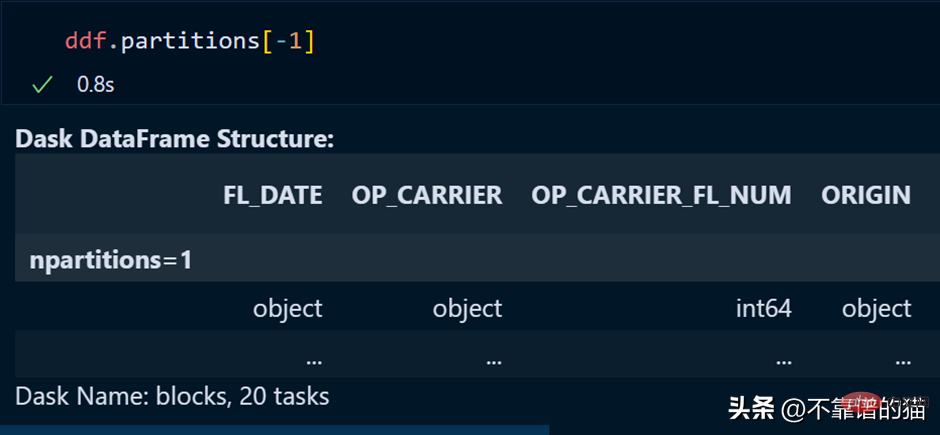

Jetzt wird ein Blocksize-Parameter mit einem String-Wert von 400 MB angegeben, wodurch jede Partition 400 MB groß ist. Schauen wir uns an, wie viele Partition #🎜 es gibt 🎜#

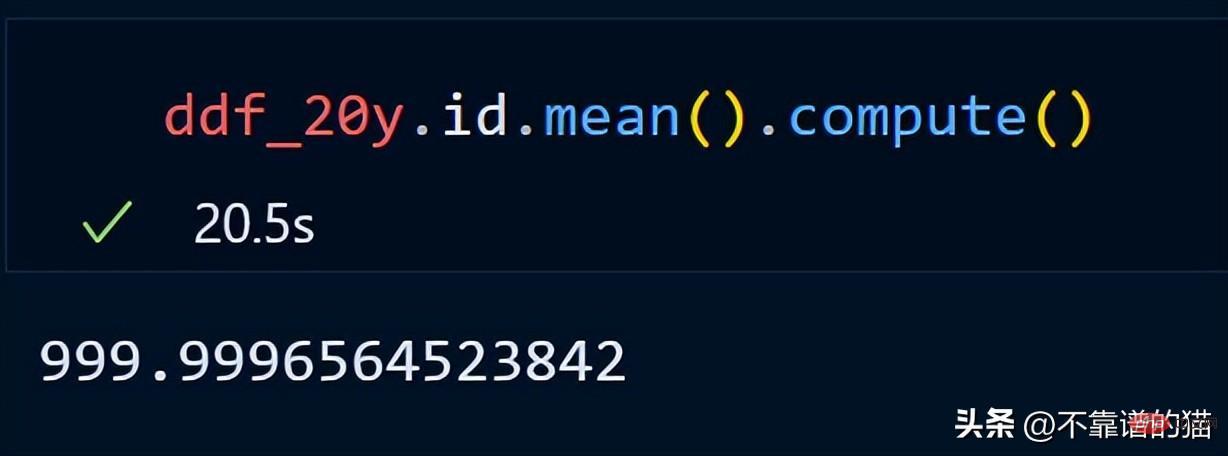

Durchlaufen Sie die Spalten, ermitteln Sie die Minimal- und Maximalwerte für jede Spalte und normalisieren Sie die Spalten mithilfe einer einfachen mathematischen Formel.

Durchlaufen Sie die Spalten, ermitteln Sie die Minimal- und Maximalwerte für jede Spalte und normalisieren Sie die Spalten mithilfe einer einfachen mathematischen Formel.

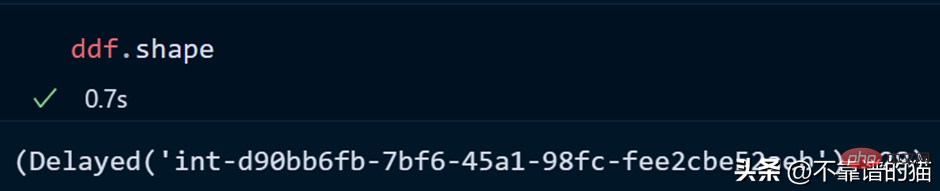

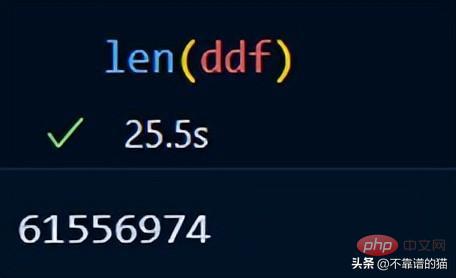

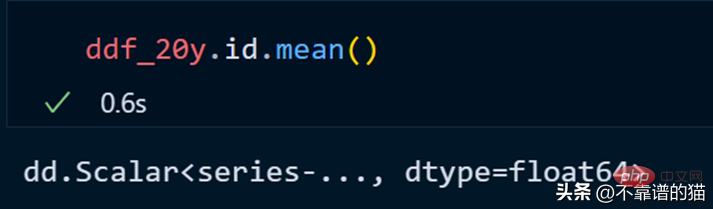

Kernpunkt: Denken Sie in unserem Normalisierungsbeispiel nicht, dass eine tatsächliche numerische Berechnung stattfindet, es handelt sich lediglich um eine verzögerte Auswertung (die Ausgabe wird Ihnen erst angezeigt, wenn sie benötigt wird).

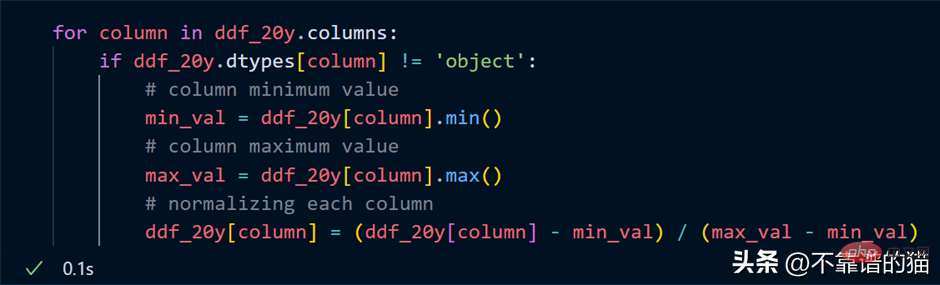

Warum Dask-Array verwenden?

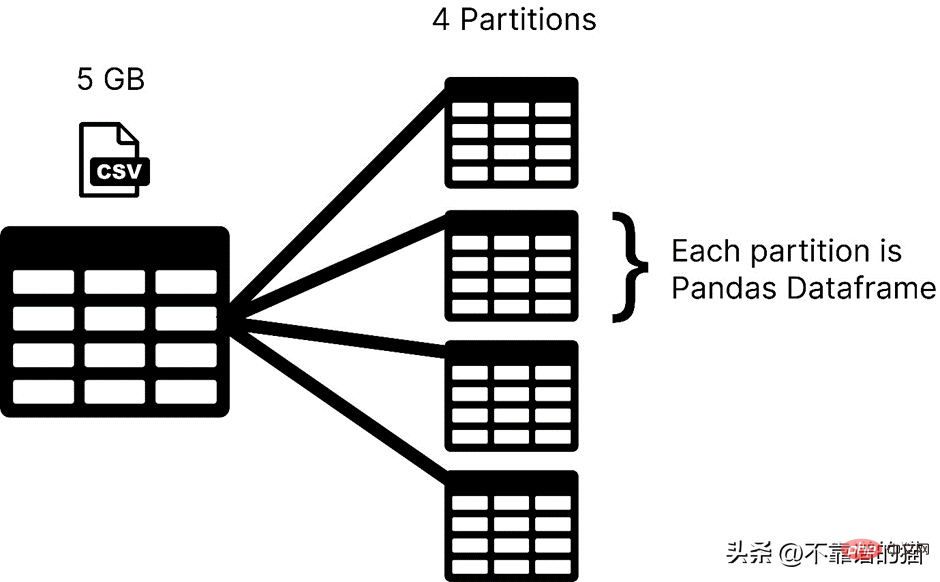

Dask teilt ein Array in kleine Blöcke auf, wobei jeder Block ein NumPy-Array ist.

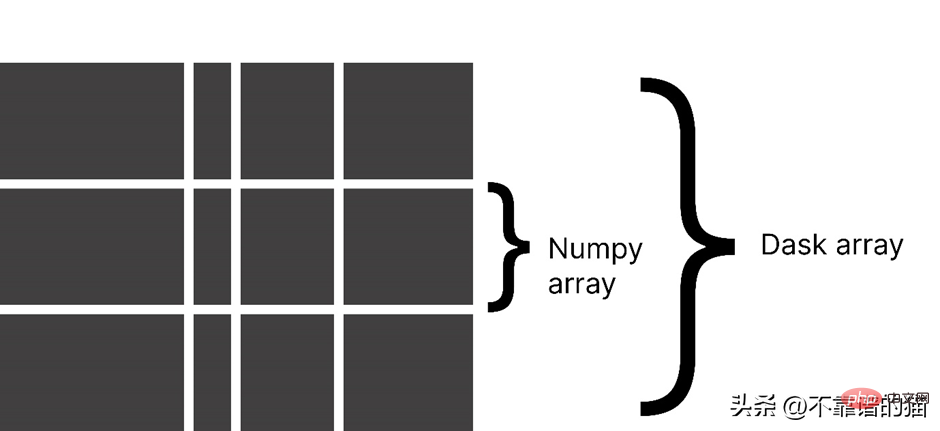

dask.arrays wird verwendet, um große Arrays zu verarbeiten. Der folgende Python-Code verwendet dask, um ein Array von 10000 x 10000 zu erstellen und es im x zu speichern variabel.

dask.arrays wird verwendet, um große Arrays zu verarbeiten. Der folgende Python-Code verwendet dask, um ein Array von 10000 x 10000 zu erstellen und es im x zu speichern variabel.

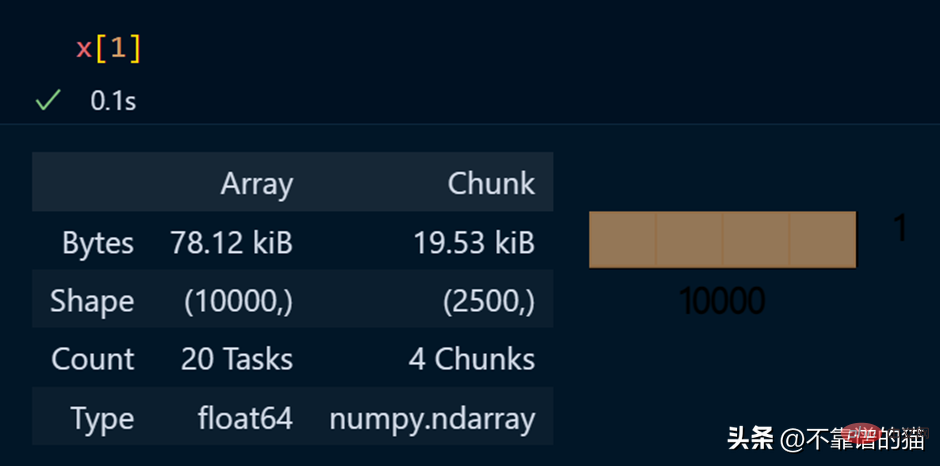

Der Aufruf der x-Variablen erzeugt verschiedene Informationen über das Array.

Der Aufruf der x-Variablen erzeugt verschiedene Informationen über das Array.

Spezifische Elemente eines Arrays anzeigen

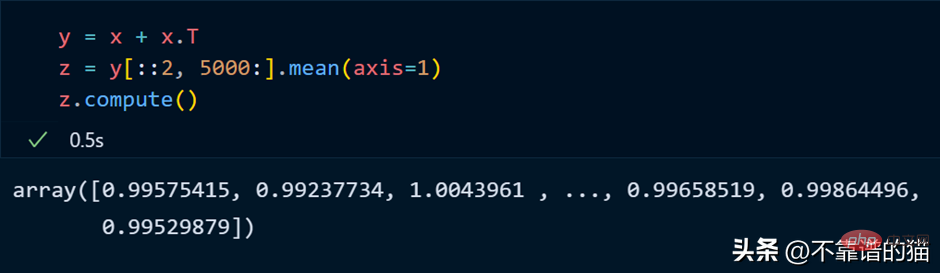

Python-Beispiel für die Ausführung mathematischer Operationen an einem Dask-Array:

Python-Beispiel für die Ausführung mathematischer Operationen an einem Dask-Array:

正如您所看到的,由于延迟执行,它不会向您显示输出。我们可以使用compute来显示输出:

dask 数组支持大多数 NumPy 接口,如下所示:

- 数学运算:+, *, exp, log, ...

- sum(), mean(), std(), sum(axis=0), ...

- 张量/点积/矩阵乘法:tensordot

- 重新排序/转置:transpose

- 切片:x[:100, 500:100:-2]

- 使用列表或 NumPy 数组进行索引:x[:, [10, 1, 5]]

- 线性代数:svd、qr、solve、solve_triangular、lstsq

但是,Dask Array 并没有实现完整 NumPy 接口。

你可以从他们的官方文档中了解更多关于 dask.arrays 的信息。

什么是Dask Persist?

假设您想对机器学习数据集执行一些耗时的操作,您可以将数据集持久化到内存中,从而使数学运算运行得更快。

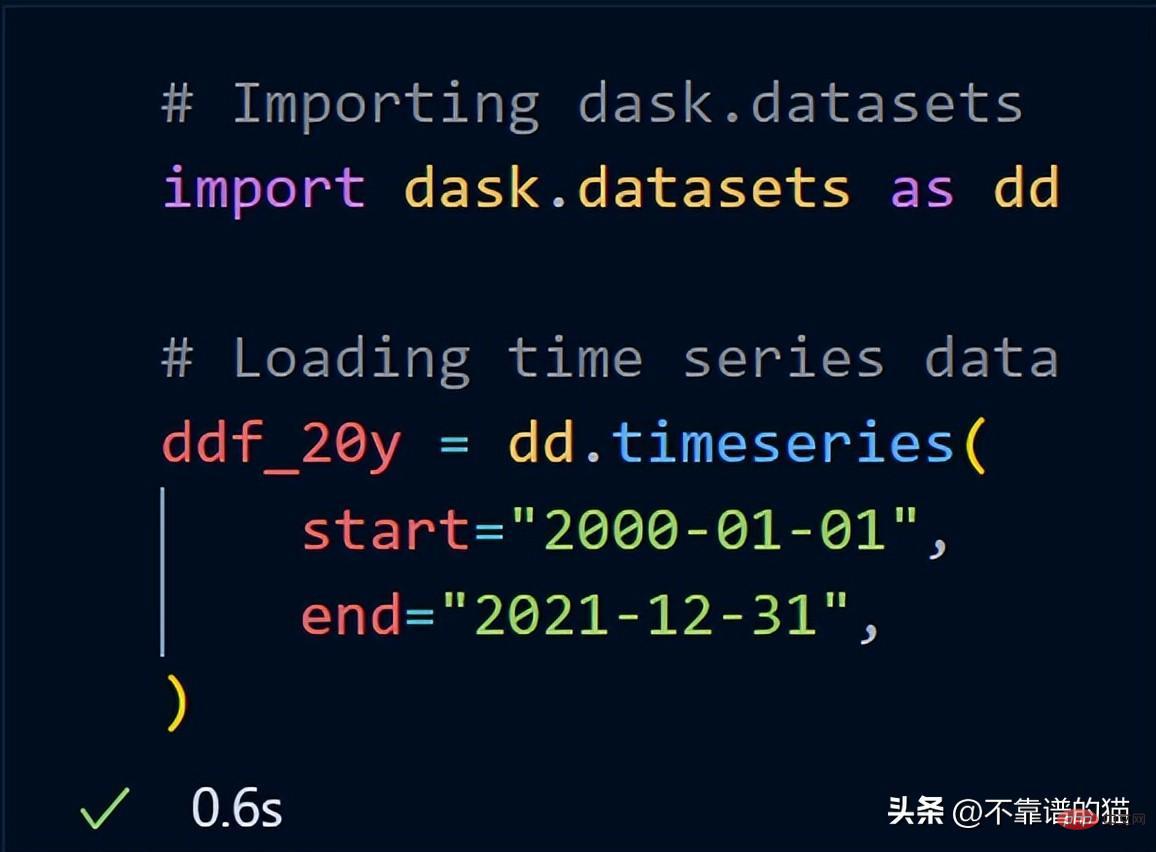

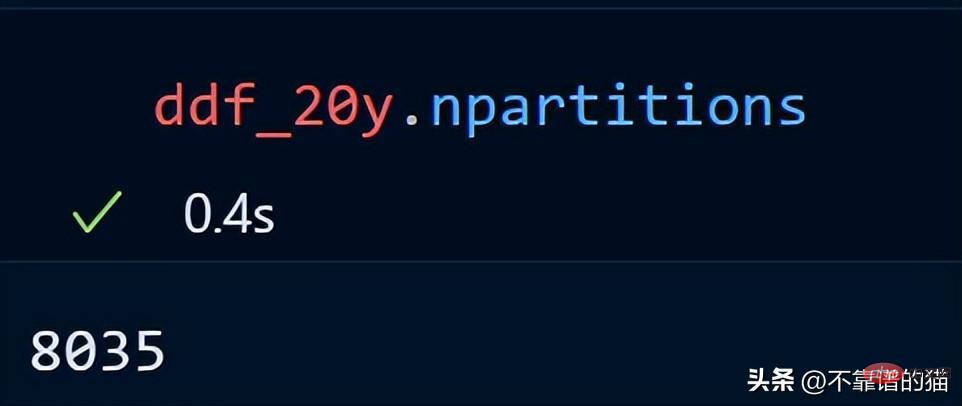

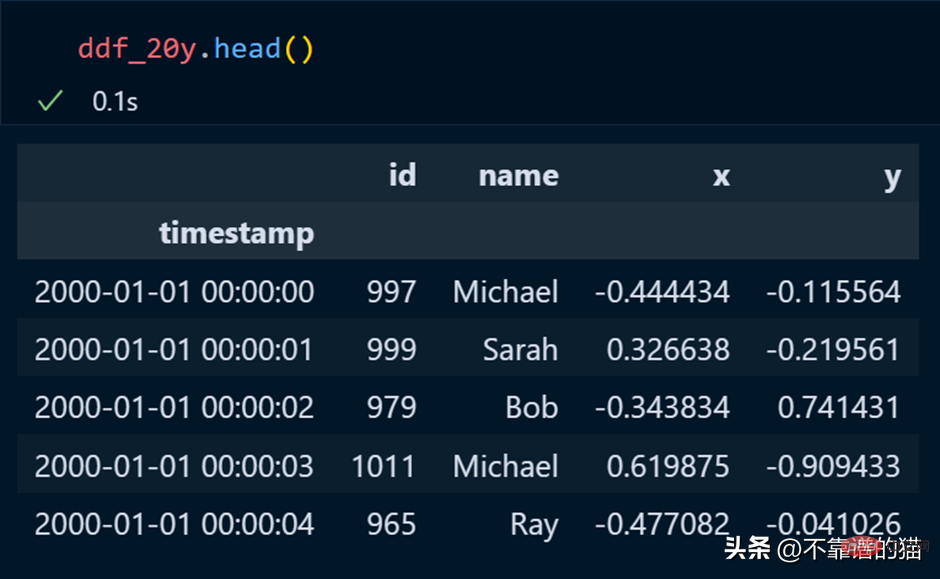

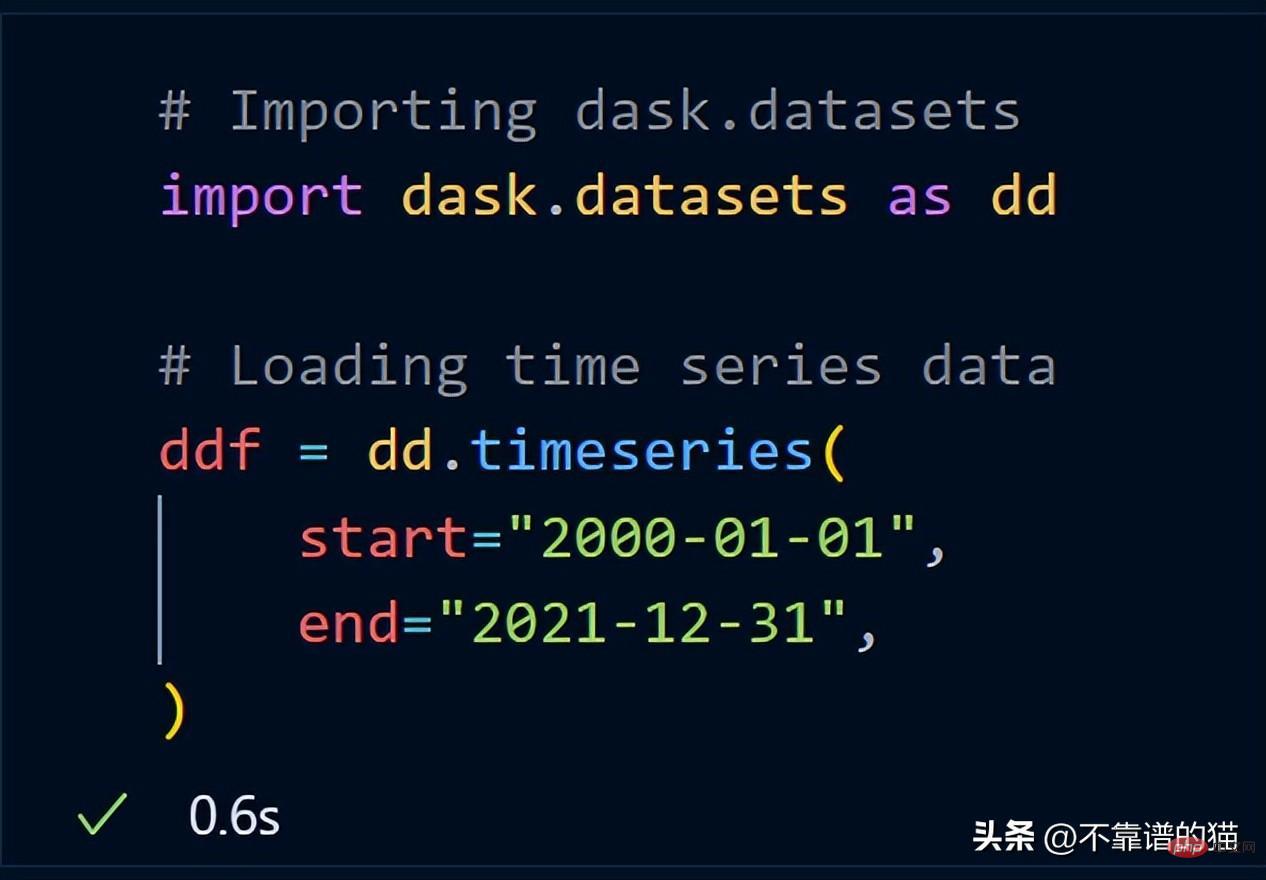

从 dask.datasets 导入了时间序列数据

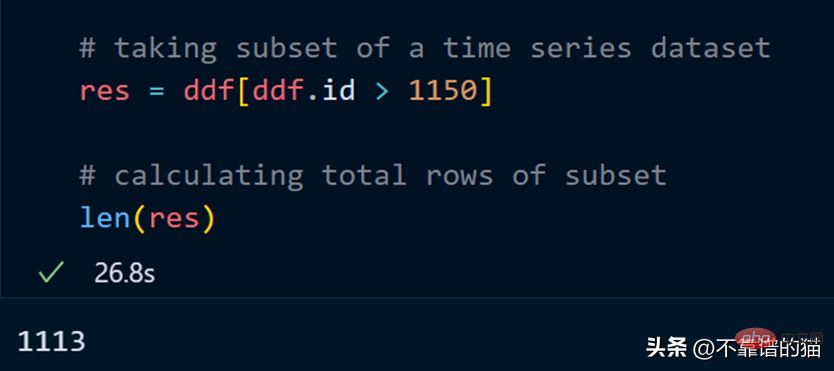

让我们取数据集的一个子集并计算该子集的总行数。

计算总行数需要 27 秒。

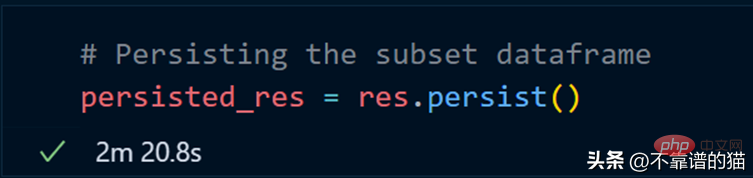

我们现在使用 persist 方法:

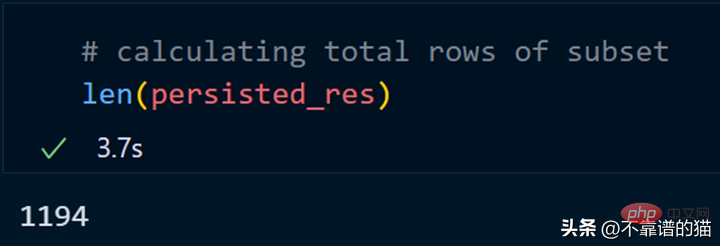

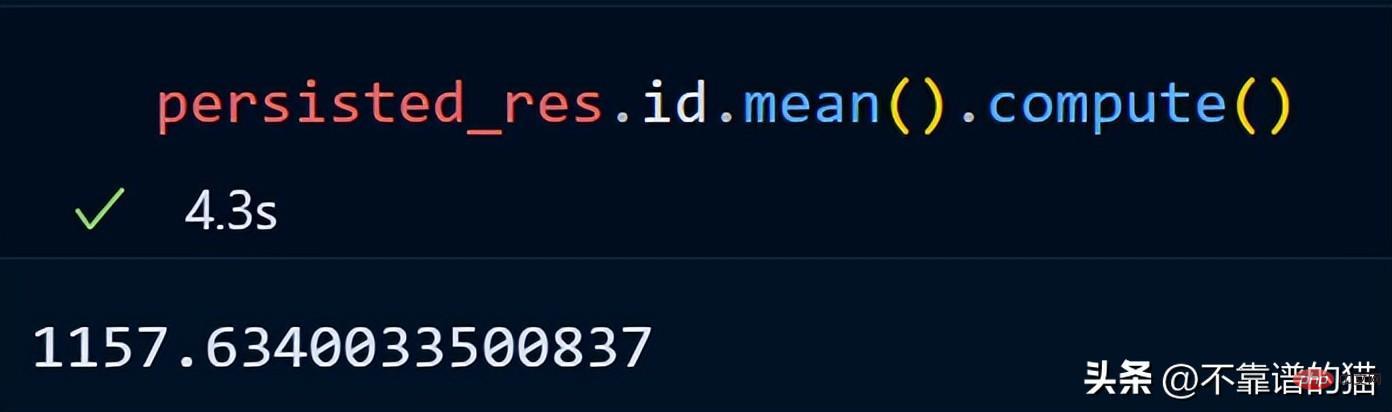

持久化我们的子集总共花了 2 分钟,现在让我们计算总行数。

同样,我们可以对持久化数据集执行其他操作以减少计算时间。

persist应用场景:

- 数据量大

- 获取数据的一个子集

- 对子集应用不同的操作

为什么选择 Dask ML?

Dask ML有助于在大型数据集上使用流行的Python机器学习库(如Scikit learn等)来应用ML(机器学习)算法。

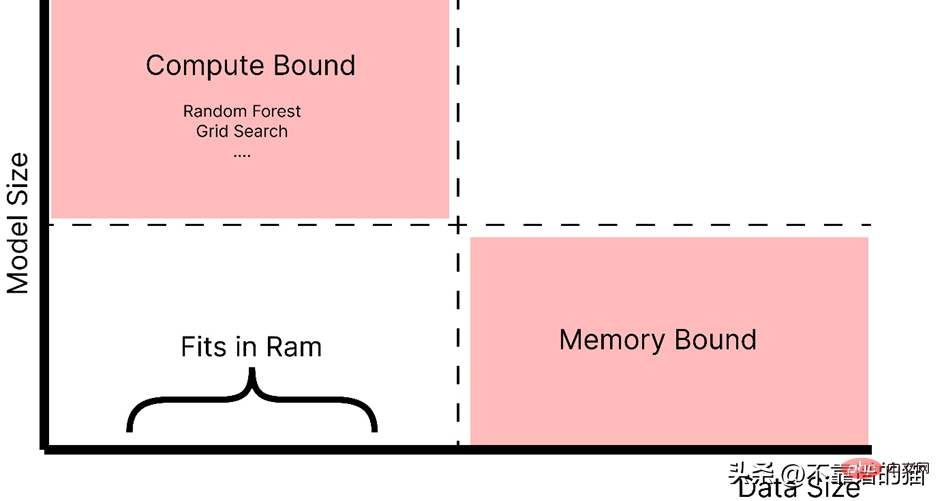

什么时候应该使用 dask ML?

- 数据不大(或适合 RAM),但训练的机器学习模型需要大量超参数,并且调优或集成技术需要大量时间。

- 数据量很大。

正如你所看到的,随着模型大小的增加,例如,制作一个具有大量超参数的复杂模型,它会引起计算边界的问题,而如果数据大小增加,它会引起内存分配错误。因此,在这两种情况下(红色阴影区域)我们都使用 Dask 来解决这些问题。

如官方文档中所述,dask ml 库用例:

- 对于内存问题,只需使用 scikit-learn(或其他ML 库)。

- 对于大型模型,使用 dask_ml.joblib 和scikit-learn estimators。

- 对于大型数据集,使用 dask_ml estimators。

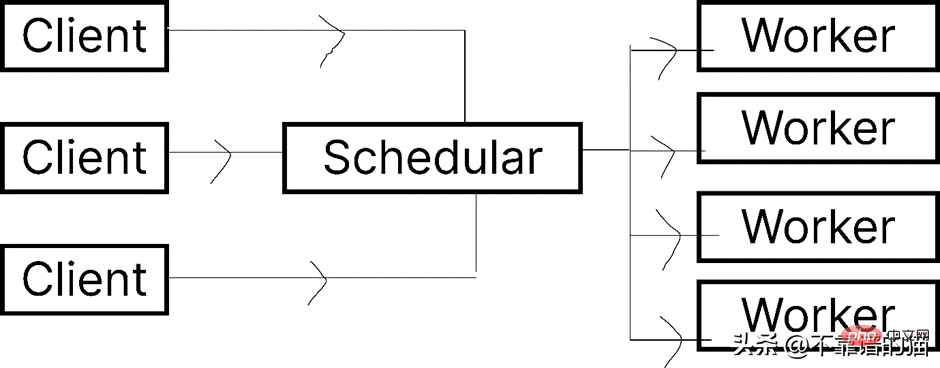

让我们看一下 Dask.distributed 的架构:

Dask 让您能够在计算机集群上运行任务。在 dask.distributed 中,只要您分配任务,它就会立即开始执行。

简单地说,client就是提交任务的你,执行任务的是Worker,调度器则执行两者之间通信。

python -m <span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">pip</span> <span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">install</span> <span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">dask</span> distributed –upgrade

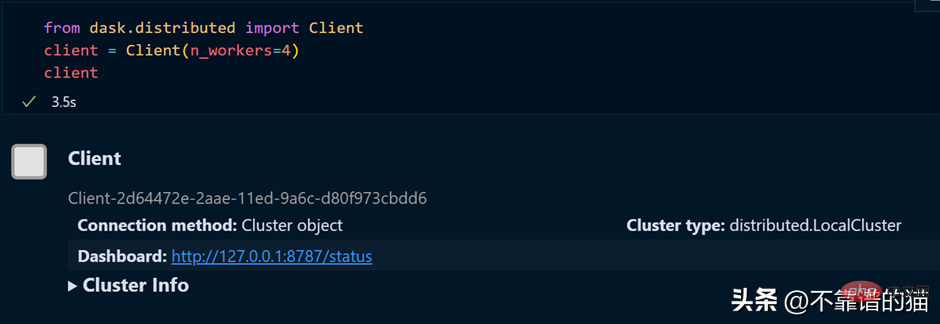

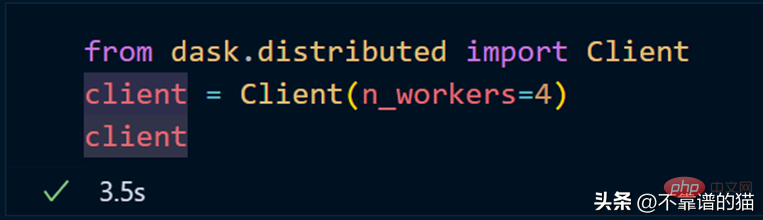

如果您使用的是单台机器,那么就可以通过以下方式创建一个具有4个worker的dask集群

如果需要dashboard,可以安装bokeh,安装bokeh的命令如下:

<span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">pip</span> <span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">install</span> <span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">bokeh</span>

就像我们从 dask.distributed 创建客户端一样,我们也可以从 dask.distributed 创建调度程序。

要使用 dask ML 库,您必须使用以下命令安装它:

<span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">pip</span> <span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">install</span> <span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">dask</span>-ml

我们将使用 Scikit-learn 库来演示 dask-ml 。

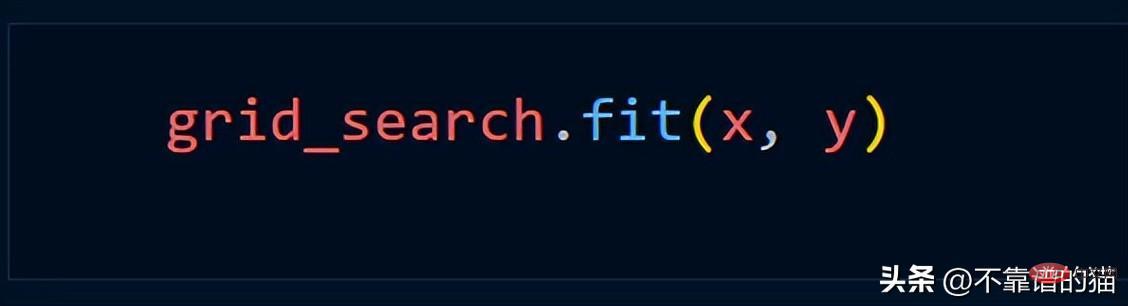

Angenommen, wir verwenden die Grid_Search-Methode, verwenden wir normalerweise den folgenden Python-Code

Erstellen Sie einen Cluster mit dask.distributed:

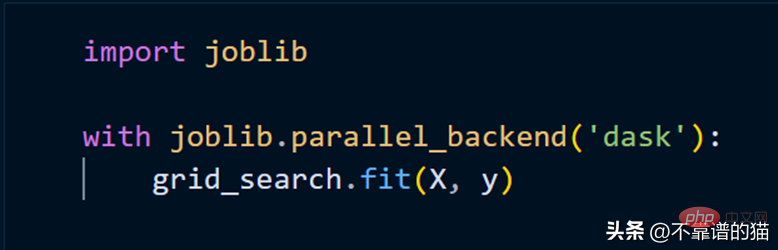

Um das Scikit-Learn-Modell mithilfe von Clustern anzupassen, müssen wir lediglich joblib verwenden.

Das obige ist der detaillierte Inhalt vonEine einfache Möglichkeit, große Datensätze für maschinelles Lernen in Python zu verarbeiten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

MySQL hat eine kostenlose Community -Version und eine kostenpflichtige Enterprise -Version. Die Community -Version kann kostenlos verwendet und geändert werden, die Unterstützung ist jedoch begrenzt und für Anwendungen mit geringen Stabilitätsanforderungen und starken technischen Funktionen geeignet. Die Enterprise Edition bietet umfassende kommerzielle Unterstützung für Anwendungen, die eine stabile, zuverlässige Hochleistungsdatenbank erfordern und bereit sind, Unterstützung zu bezahlen. Zu den Faktoren, die bei der Auswahl einer Version berücksichtigt werden, gehören Kritikalität, Budgetierung und technische Fähigkeiten von Anwendungen. Es gibt keine perfekte Option, nur die am besten geeignete Option, und Sie müssen die spezifische Situation sorgfältig auswählen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Die MySQL -Download -Datei ist beschädigt und kann nicht installiert werden. Reparaturlösung

Apr 08, 2025 am 11:21 AM

Die MySQL -Download -Datei ist beschädigt und kann nicht installiert werden. Reparaturlösung

Apr 08, 2025 am 11:21 AM

Die MySQL -Download -Datei ist beschädigt. Was soll ich tun? Wenn Sie MySQL herunterladen, können Sie die Korruption der Datei begegnen. Es ist heutzutage wirklich nicht einfach! In diesem Artikel wird darüber gesprochen, wie dieses Problem gelöst werden kann, damit jeder Umwege vermeiden kann. Nach dem Lesen können Sie nicht nur das beschädigte MySQL -Installationspaket reparieren, sondern auch ein tieferes Verständnis des Download- und Installationsprozesses haben, um zu vermeiden, dass Sie in Zukunft stecken bleiben. Lassen Sie uns zunächst darüber sprechen, warum das Herunterladen von Dateien beschädigt wird. Dafür gibt es viele Gründe. Netzwerkprobleme sind der Schuldige. Unterbrechung des Download -Prozesses und der Instabilität im Netzwerk kann zu einer Korruption von Dateien führen. Es gibt auch das Problem mit der Download -Quelle selbst. Die Serverdatei selbst ist gebrochen und natürlich auch unterbrochen, wenn Sie sie herunterladen. Darüber hinaus kann das übermäßige "leidenschaftliche" Scannen einer Antiviren -Software auch zu einer Beschädigung von Dateien führen. Diagnoseproblem: Stellen Sie fest, ob die Datei wirklich beschädigt ist

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

Die Hauptgründe für den Fehler bei MySQL -Installationsfehlern sind: 1. Erlaubnisprobleme, Sie müssen als Administrator ausgeführt oder den Sudo -Befehl verwenden. 2. Die Abhängigkeiten fehlen, und Sie müssen relevante Entwicklungspakete installieren. 3. Portkonflikte müssen Sie das Programm schließen, das Port 3306 einnimmt, oder die Konfigurationsdatei ändern. 4. Das Installationspaket ist beschädigt. Sie müssen die Integrität herunterladen und überprüfen. 5. Die Umgebungsvariable ist falsch konfiguriert und die Umgebungsvariablen müssen korrekt entsprechend dem Betriebssystem konfiguriert werden. Lösen Sie diese Probleme und überprüfen Sie jeden Schritt sorgfältig, um MySQL erfolgreich zu installieren.

Lösungen für den Dienst, der nach der MySQL -Installation nicht gestartet werden kann

Apr 08, 2025 am 11:18 AM

Lösungen für den Dienst, der nach der MySQL -Installation nicht gestartet werden kann

Apr 08, 2025 am 11:18 AM

MySQL hat sich geweigert, anzufangen? Nicht in Panik, lass es uns ausprobieren! Viele Freunde stellten fest, dass der Service nach der Installation von MySQL nicht begonnen werden konnte, und sie waren so ängstlich! Mach dir keine Sorgen, dieser Artikel wird dich dazu bringen, ruhig damit umzugehen und den Mastermind dahinter herauszufinden! Nachdem Sie es gelesen haben, können Sie dieses Problem nicht nur lösen, sondern auch Ihr Verständnis von MySQL -Diensten und Ihren Ideen zur Fehlerbehebungsproblemen verbessern und zu einem leistungsstärkeren Datenbankadministrator werden! Der MySQL -Dienst startete nicht und es gibt viele Gründe, von einfachen Konfigurationsfehlern bis hin zu komplexen Systemproblemen. Beginnen wir mit den häufigsten Aspekten. Grundkenntnisse: Eine kurze Beschreibung des Service -Startup -Prozesses MySQL Service Startup. Einfach ausgedrückt, lädt das Betriebssystem MySQL-bezogene Dateien und startet dann den MySQL-Daemon. Dies beinhaltet die Konfiguration

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Die MySQL-Datenbankleistung Optimierungshandbuch In ressourcenintensiven Anwendungen spielt die MySQL-Datenbank eine entscheidende Rolle und ist für die Verwaltung massiver Transaktionen verantwortlich. Mit der Erweiterung der Anwendung werden jedoch die Datenbankleistung Engpässe häufig zu einer Einschränkung. In diesem Artikel werden eine Reihe effektiver Strategien zur Leistungsoptimierung von MySQL -Leistung untersucht, um sicherzustellen, dass Ihre Anwendung unter hohen Lasten effizient und reaktionsschnell bleibt. Wir werden tatsächliche Fälle kombinieren, um eingehende Schlüsseltechnologien wie Indexierung, Abfrageoptimierung, Datenbankdesign und Caching zu erklären. 1. Das Design der Datenbankarchitektur und die optimierte Datenbankarchitektur sind der Eckpfeiler der MySQL -Leistungsoptimierung. Hier sind einige Kernprinzipien: Die Auswahl des richtigen Datentyps und die Auswahl des kleinsten Datentyps, der den Anforderungen entspricht, kann nicht nur Speicherplatz speichern, sondern auch die Datenverarbeitungsgeschwindigkeit verbessern.

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

Die MySQL -Leistungsoptimierung muss von drei Aspekten beginnen: Installationskonfiguration, Indexierung und Abfrageoptimierung, Überwachung und Abstimmung. 1. Nach der Installation müssen Sie die my.cnf -Datei entsprechend der Serverkonfiguration anpassen, z. 2. Erstellen Sie einen geeigneten Index, um übermäßige Indizes zu vermeiden und Abfrageanweisungen zu optimieren, z. B. den Befehl Erklärung zur Analyse des Ausführungsplans; 3. Verwenden Sie das eigene Überwachungstool von MySQL (ShowProcessList, Showstatus), um die Datenbankgesundheit zu überwachen und die Datenbank regelmäßig zu sichern und zu organisieren. Nur durch kontinuierliche Optimierung dieser Schritte kann die Leistung der MySQL -Datenbank verbessert werden.

Braucht MySQL das Internet?

Apr 08, 2025 pm 02:18 PM

Braucht MySQL das Internet?

Apr 08, 2025 pm 02:18 PM

MySQL kann ohne Netzwerkverbindungen für die grundlegende Datenspeicherung und -verwaltung ausgeführt werden. Für die Interaktion mit anderen Systemen, Remotezugriff oder Verwendung erweiterte Funktionen wie Replikation und Clustering ist jedoch eine Netzwerkverbindung erforderlich. Darüber hinaus sind Sicherheitsmaßnahmen (wie Firewalls), Leistungsoptimierung (Wählen Sie die richtige Netzwerkverbindung) und die Datensicherung für die Verbindung zum Internet von entscheidender Bedeutung.