Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wie viel wissen Sie über die Trägheitsnavigationstechnologie für autonomes Fahren?

Wie viel wissen Sie über die Trägheitsnavigationstechnologie für autonomes Fahren?

Wie viel wissen Sie über die Trägheitsnavigationstechnologie für autonomes Fahren?

Die Trägheitsnavigation ist im Allgemeinen in GPS-Geräte integriert und wird von den Lieferanten integriert. Was muss hier also besprochen werden? Wir müssen wissen, dass wir die Gier- und Geschwindigkeitssignale des GPS und des Fahrzeugs empfangen können Es gibt auch eine Reihe von Sensoren zur Ermittlung von Gierrate und Geschwindigkeit. Da die Flugbahnschätzung ein wichtiger Bestandteil des autonomen Fahrens ist, kann uns das Verständnis des Funktionsprinzips der Trägheitsnavigation dabei helfen, körperbasierte Flugbahnschätzungen durchzuführen.

Trägheitsnavigation

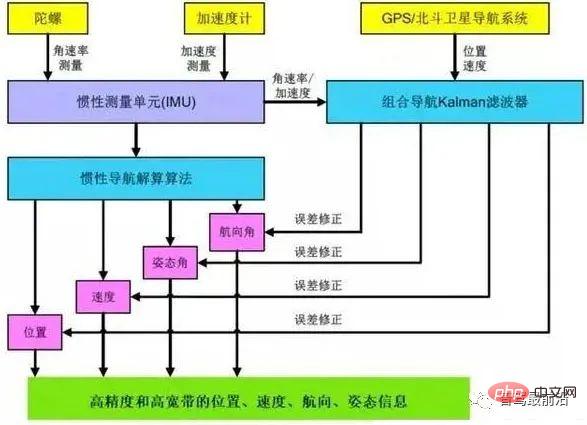

Derzeit ist das integrierte Navigationssystem aus GNSS+IMU die gängige Positionierungssystemlösung. Das Trägheitsnavigationssystem ist das einzige Gerät, das vollständige Daten mit sechs Freiheitsgraden ausgeben kann. Die Datenaktualisierungsfrequenz ist hoch und es handelt sich um die wichtigste Positionierungsinformation des Zentrums.

Die in der Trägheitsnavigation verwendeten Kernalgorithmen umfassen hauptsächlich drei Typen: 1. Trägheitsnavigationslösungsalgorithmus; 2. Kalman-Filterkopplung der integrierten Navigation. 3. Integration von Umgebungsmerkmalsinformationen und Trägheitsnavigation.

Integriertes Navigationssystem-Kernalgorithmus-Framework

Hardware und Prinzip

Das Trägheitsnavigationssystem (INS) verwendet einen Trägheitssensor (IMU), um die spezifischen Kraft- und Winkelgeschwindigkeitsinformationen von zu messen Der Träger integriert in Kombination mit bestimmten Anfangsbedingungen Informationen von Systemen wie GNSS, um ein autonomes Navigationssystem zu betreiben, das Geschwindigkeit, Position, Fluglage und andere Parameter in Echtzeit berechnet. Konkret handelt es sich bei dem Trägheitsnavigationssystem um eine Art Koppelnavigationsnavigation. Das heißt, die Position des nächsten Punktes wird aus der Position eines bekannten Punktes basierend auf dem kontinuierlich gemessenen Kurswinkel und der Geschwindigkeit des Trägers berechnet, sodass die aktuelle Position des sich bewegenden Körpers kontinuierlich gemessen werden kann.

Diagramm zum Funktionsprinzip des Trägheitssystems

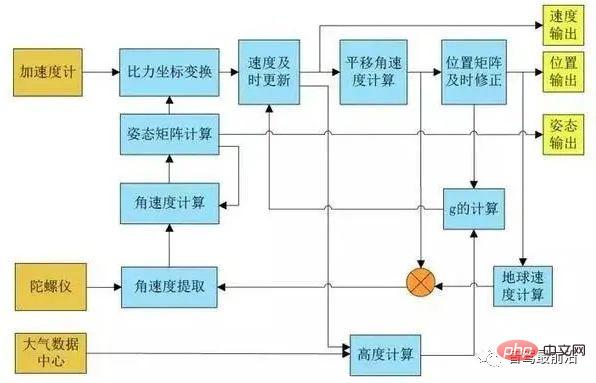

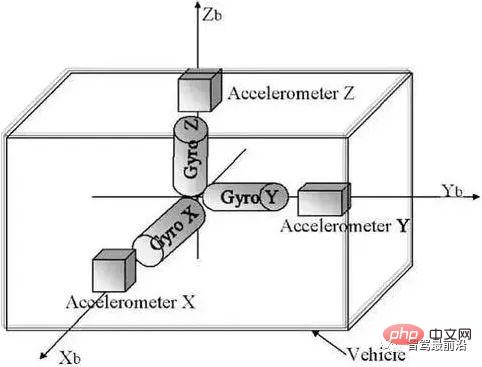

Das Trägheitsnavigationssystem verwendet Beschleunigungsmesser und Gyroskopsensoren, um die Bewegungsparameter des Trägers zu messen. Drei vertikal angeordnete Gyroskope messen die Winkelgeschwindigkeit des Trägers um seine drei Koordinatenachsen und reagieren auch empfindlich auf die Winkelgeschwindigkeit der Erdrotation.

Der Beschleunigungsmesser basiert auf dem zweiten Newtonschen Gesetz und nutzt kapazitive, piezoresistive oder thermische Konvektionsprinzipien, um Beschleunigungswerte zu erhalten, indem er die entsprechende Trägheitskraft des Massenblocks während der Beschleunigung misst. Wird verwendet, um die Beschleunigung jeder Achse im Koordinatensystem des sich bewegenden Körpers zu messen.

Diagramm zum Funktionsprinzip des Trägheitssystems

Die Trägheitsnavigation berechnet den Lagewinkel (Roll-, Nickwinkel) und den Azimutwinkel der Fahrzeugkarosserie durch Integration der vom Gyroskop gemessenen Winkelgeschwindigkeit und Koordinatentransformation. Die Komponenten der Erdbeschleunigung auf jeder Koordinatenachse können auf der Grundlage des Lagewinkels berechnet werden. Die vom Beschleunigungsmesser gemessene Beschleunigung jeder Achse wird nach Abzug der Erdbeschleunigungskomponente integriert, um die Geschwindigkeit und Position zu erhalten. Der durch die Trägheitsnavigation berechnete Zustand wird zur Vorhersage der aktuellen Position des Fahrzeugs verwendet und dann mit der vom Satellitenortungsempfänger ermittelten Position (oder Beobachtungsdaten) verglichen. Die verglichenen Abweichungen umfassen den Trägheitsnavigationsschätzfehler und den Positionierungsfehler des Satellitenempfängers. Nach der Gewichtung durch den Datenfusionsalgorithmus werden sie zur Korrektur der Trägheitsnavigationsvorhersage verwendet, wodurch die Trägheitsnavigationsvorhersage immer genauer wird.

Trägheitsnavigationslösungsalgorithmus

normalerweise in die folgenden Schritte unterteilt:

- Lageaktualisierung: Integrieren Sie die vom Gyroskop ausgegebene Winkelgeschwindigkeit, um das Lageinkrement zu erhalten, das der letzten Fluglage überlagert wird; 🎜 🎜#Koordinatenkonvertierung: vom IMU-Trägerkoordinatensystem zum Positions- und Geschwindigkeitslösungskoordinatensystem (Trägheitskoordinatensystem); muss berücksichtigt werden, und wir erhalten Beschleunigung im Inertialsystem. Die Geschwindigkeit wird durch Integration erhalten. #?

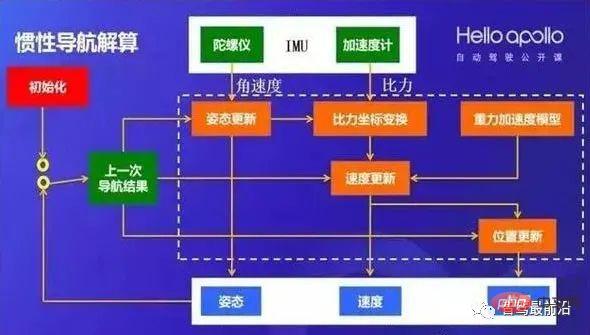

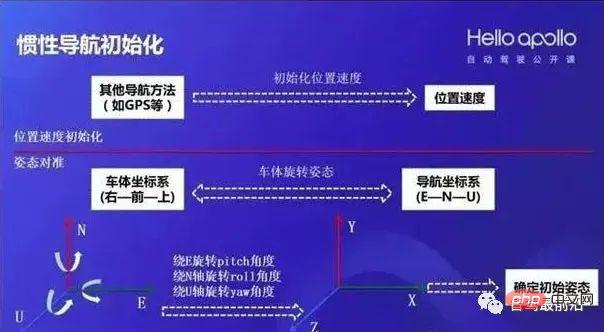

- Bei der Trägheitsnavigation muss jede Iteration der Navigationsgleichung das letzte Navigationsergebnis als Anfangswert verwenden, daher ist die Initialisierung der Trägheitsnavigation einer der wichtigeren Teile. Die Ausrichtung der Fluglage bezieht sich auf das Ermitteln der Roll-, Nick- und Gierbewegungen der IMU. Der Ausrichtungsprozess von Roll und Nick wird allgemein als Nivellierung bezeichnet. Wenn das Auto stillsteht, wird die vom Beschleunigungsmesser gemessene spezifische Kraft nur durch die Schwerkraft verursacht, die für eine hochpräzise IMU gelöst werden kann. Wenn das Auto steht, kann die Methode zur Kompassausrichtung verwendet werden Im stationären Zustand wird die vom Beschleunigungsmesser gemessene spezifische Kraft im Trägersystem gemessen. Die Rotation der Erde wird zur Bestimmung der Ausrichtung (Gieren) des Trägers verwendet. #🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#Inertial Navigation Initialisierungsschema#🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜 🎜#Kopplung des Kalman-Filters für die kombinierte Navigation

- Verwenden Sie die Kopplung des Kalman-Filters, um IMU und GNSS, also Punktwolkenpositionierungsergebnisse, zu fusionieren. Es kann in zwei Methoden unterteilt werden: lose Kopplung und feste Kopplung.

- Der lose Kopplungsfilter verwendet die Differenz zwischen dem Positions-, Geschwindigkeitsmesswert und der berechneten Positionsgeschwindigkeit als Eingabe des kombinierten Navigationsfilters, also der Mengenmessung des Kalman-Filters. Zu den eng gekoppelten Daten gehören GNSS-Navigationsparameter, Pseudoentfernungen bei der Positionierung, Entfernungsänderungen usw. #? #

#🎜 🎜##🎜🎜 #

Vergleich der Vor- und Nachteile der losen Kopplung und der engen Kopplung des Kalman-Filters

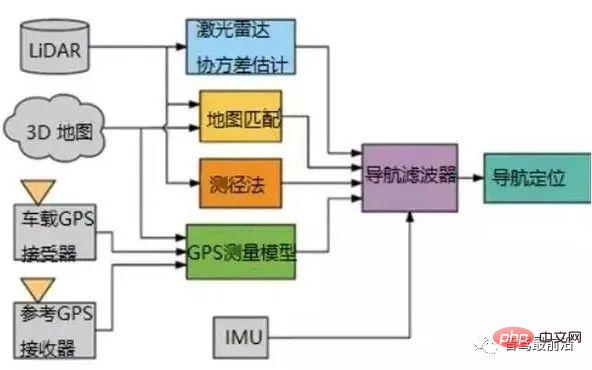

#🎜 🎜##🎜 🎜# Am Beispiel des von Baidu Apollo verwendeten Trägheitsnavigationssystems verwendet es eine lose Kopplungsmethode und einen Fehler-Kalman-Filter. Die Ergebnisse der Trägheitsnavigationslösung werden für die Zeitaktualisierung des Kalman-Filters, also die Vorhersage, verwendet, während die GNSS- und Punktwolkenpositionierungsergebnisse für die Messaktualisierung des Kalman-Filters verwendet werden. Der Kalman-Filter gibt die Positions-, Geschwindigkeits- und Lagefehler aus, um das Trägheitsnavigationsmodul zu korrigieren, und die Fehler während der IMU-Periode werden zur Kompensation der ursprünglichen IMU-Daten verwendet.

Am Beispiel des von Baidu Apollo verwendeten Trägheitsnavigationssystems verwendet es eine lose Kopplungsmethode und einen Fehler-Kalman-Filter. Die Ergebnisse der Trägheitsnavigationslösung werden für die Zeitaktualisierung des Kalman-Filters, also die Vorhersage, verwendet, während die GNSS- und Punktwolkenpositionierungsergebnisse für die Messaktualisierung des Kalman-Filters verwendet werden. Der Kalman-Filter gibt die Positions-, Geschwindigkeits- und Lagefehler aus, um das Trägheitsnavigationsmodul zu korrigieren, und die Fehler während der IMU-Periode werden zur Kompensation der ursprünglichen IMU-Daten verwendet.

Lose Kopplung des Baidu Apollo Kalman-Filters #🎜🎜 #

Kalman-Filter-Fusionsdiagramm

Integration von Umgebungsmerkmalsinformationen und Trägheitsnavigation

Die derzeit häufig verwendete kombinierte Trägheitsnavigationslösung aus GNSS + IMU kann in einigen Szenarien die Anforderungen des autonomen Fahrens hinsichtlich Positionierungsgenauigkeit und Stabilität immer noch nicht vollständig erfüllen. Beispielsweise ist es in Szenarien, in denen GNSS-Signale über einen längeren Zeitraum schwach sind, wie z. B. in städtischen Gebäudegruppen und Tiefgaragen, nicht stabil genug, sich auf GNSS-Signale zu verlassen, um die genaue Positionierung zu aktualisieren. Daher müssen neue Quellen für die Aktualisierung präziser Positionierungsdaten eingeführt werden Lidar/Lidar/ Es ist zu einem unvermeidlichen Trend geworden, visuelle Positionierungssensoren und andere Umgebungsinformationen für die Positionierung zu integrieren.

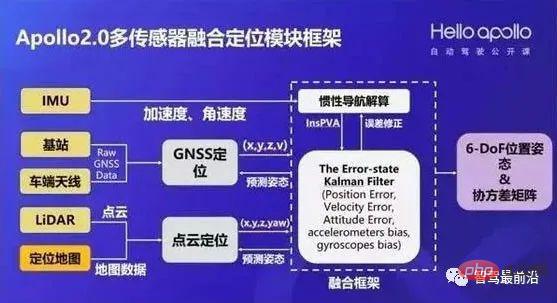

Ein schematisches Diagramm einer Architektur für die integrierte Fusion von Navigations- und Umweltbewusstseinsinformationen

Am Beispiel der Multisensor-Fusion-Positionierungssystemlösung von Baidu Apollo steht das Trägheitsnavigationssystem im Mittelpunkt Das Positionierungsmodul integriert IMU-, GNSS-, Lidar- und andere Positionierungsinformationen und gibt schließlich hochpräzise Positionsinformationen mit 6 Freiheitsgraden aus, die den Anforderungen des autonomen Fahrens gerecht werden, nachdem sie vom Trägheitsnavigationssystem gelöst und korrigiert wurden.

Baidu Apollos Trägheitsfusions-Positionierungsmodul-Framework

Das obige ist der detaillierte Inhalt vonWie viel wissen Sie über die Trägheitsnavigationstechnologie für autonomes Fahren?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1379

1379

52

52

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Oben geschrieben und persönliches Verständnis des Autors. Dreidimensionales Gaussplatting (3DGS) ist eine transformative Technologie, die in den letzten Jahren in den Bereichen explizite Strahlungsfelder und Computergrafik entstanden ist. Diese innovative Methode zeichnet sich durch die Verwendung von Millionen von 3D-Gaußkurven aus, was sich stark von der Neural Radiation Field (NeRF)-Methode unterscheidet, die hauptsächlich ein implizites koordinatenbasiertes Modell verwendet, um räumliche Koordinaten auf Pixelwerte abzubilden. Mit seiner expliziten Szenendarstellung und differenzierbaren Rendering-Algorithmen garantiert 3DGS nicht nur Echtzeit-Rendering-Fähigkeiten, sondern führt auch ein beispielloses Maß an Kontrolle und Szenenbearbeitung ein. Dies positioniert 3DGS als potenziellen Game-Changer für die 3D-Rekonstruktion und -Darstellung der nächsten Generation. Zu diesem Zweck geben wir erstmals einen systematischen Überblick über die neuesten Entwicklungen und Anliegen im Bereich 3DGS.

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich während des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt hätte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randfälle bei autonomen Fahrzeugen, also mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschränken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gelöst, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschränkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen gehören eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der „Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randfälle in autonomen Fahrzeugen (AVs). Randfälle sind mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

0. Vorab geschrieben&& Persönliches Verständnis, dass autonome Fahrsysteme auf fortschrittlichen Wahrnehmungs-, Entscheidungs- und Steuerungstechnologien beruhen, indem sie verschiedene Sensoren (wie Kameras, Lidar, Radar usw.) verwenden, um die Umgebung wahrzunehmen, und Algorithmen und Modelle verwenden für Echtzeitanalysen und Entscheidungsfindung. Dies ermöglicht es Fahrzeugen, Verkehrszeichen zu erkennen, andere Fahrzeuge zu erkennen und zu verfolgen, das Verhalten von Fußgängern vorherzusagen usw. und sich so sicher an komplexe Verkehrsumgebungen anzupassen. Diese Technologie erregt derzeit große Aufmerksamkeit und gilt als wichtiger Entwicklungsbereich für die Zukunft des Transportwesens . eins. Aber was autonomes Fahren schwierig macht, ist herauszufinden, wie man dem Auto klarmachen kann, was um es herum passiert. Dies erfordert, dass der dreidimensionale Objekterkennungsalgorithmus im autonomen Fahrsystem Objekte in der Umgebung, einschließlich ihrer Standorte, genau wahrnehmen und beschreiben kann.

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

Originaltitel: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Paper-Link: https://arxiv.org/pdf/2402.02519.pdf Code-Link: https://github.com/HKUST-Aerial-Robotics/SIMPL Autor: Hong Kong University of Science und Technologie DJI-Papieridee: Dieses Papier schlägt eine einfache und effiziente Bewegungsvorhersagebasislinie (SIMPL) für autonome Fahrzeuge vor. Im Vergleich zum herkömmlichen Agent-Cent

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

Vorab geschrieben und Ausgangspunkt Das End-to-End-Paradigma verwendet ein einheitliches Framework, um Multitasking in autonomen Fahrsystemen zu erreichen. Trotz der Einfachheit und Klarheit dieses Paradigmas bleibt die Leistung von End-to-End-Methoden für das autonome Fahren bei Teilaufgaben immer noch weit hinter Methoden für einzelne Aufgaben zurück. Gleichzeitig erschweren die in früheren End-to-End-Methoden weit verbreiteten Funktionen der dichten Vogelperspektive (BEV) die Skalierung auf mehr Modalitäten oder Aufgaben. Hier wird ein Sparse-Search-zentriertes End-to-End-Paradigma für autonomes Fahren (SparseAD) vorgeschlagen, bei dem die Sparse-Suche das gesamte Fahrszenario, einschließlich Raum, Zeit und Aufgaben, ohne dichte BEV-Darstellung vollständig abbildet. Insbesondere ist eine einheitliche, spärliche Architektur für die Aufgabenerkennung einschließlich Erkennung, Verfolgung und Online-Zuordnung konzipiert. Zudem schwer

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Im vergangenen Monat hatte ich aus bekannten Gründen einen sehr intensiven Austausch mit verschiedenen Lehrern und Mitschülern der Branche. Ein unvermeidliches Thema im Austausch ist natürlich End-to-End und der beliebte Tesla FSDV12. Ich möchte diese Gelegenheit nutzen, einige meiner aktuellen Gedanken und Meinungen als Referenz und Diskussion darzulegen. Wie definiert man ein durchgängiges autonomes Fahrsystem und welche Probleme sollten voraussichtlich durchgängig gelöst werden? Gemäß der traditionellsten Definition bezieht sich ein End-to-End-System auf ein System, das Rohinformationen von Sensoren eingibt und für die Aufgabe relevante Variablen direkt ausgibt. Bei der Bilderkennung kann CNN beispielsweise als End-to-End bezeichnet werden, verglichen mit der herkömmlichen Methode zum Extrahieren von Merkmalen + Klassifizieren. Bei autonomen Fahraufgaben werden Eingabedaten verschiedener Sensoren (Kamera/LiDAR) benötigt

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren