Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Marcus veröffentlichte einen Artikel, in dem er LeCun kritisierte: Deep Learning allein kann keine menschenähnliche Intelligenz erreichen

Marcus veröffentlichte einen Artikel, in dem er LeCun kritisierte: Deep Learning allein kann keine menschenähnliche Intelligenz erreichen

Marcus veröffentlichte einen Artikel, in dem er LeCun kritisierte: Deep Learning allein kann keine menschenähnliche Intelligenz erreichen

Im März dieses Jahres sorgte Gary Marcus für Aufsehen in der akademischen Gemeinschaft der künstlichen Intelligenz, nachdem er die Idee vorschlug, dass „Deep Learning an eine Wand gestoßen ist“.

Damals konnten selbst die drei Giganten des Deep Learning nicht stillstehen. Zunächst widerlegte Geoffrey Hinton diese Ansicht in einem Podcast.

Im Juni schrieb Yann LeCun einen Artikel als Antwort darauf und wies darauf hin, dass man vorübergehende Schwierigkeiten nicht so behandeln sollte, als würde man gegen eine Wand stoßen.

Jetzt hat Marcus im US-amerikanischen NOEMA-Magazin einen Artikel mit dem Titel „Deep Learning Alone Isn’t Getting Us To Human-Like AI“ veröffentlicht.

Ebenso hat er seine Ansicht immer noch nicht geändert – Deep Learning allein kann keine menschenähnliche Intelligenz erreichen.

und schlug vor, dass sich die aktuelle Forschung zur künstlichen Intelligenz hauptsächlich auf Deep Learning konzentriert und es an der Zeit ist, dies zu überdenken.

In den letzten 70 Jahren war die grundlegendste Debatte im Bereich der künstlichen Intelligenz: ob künstliche Intelligenzsysteme auf „symbolischen Operationen“ oder auf gehirnähnlichen „neuronalen Netzwerk“-Systemen aufgebaut werden sollten.

Tatsächlich gibt es hier noch eine dritte Möglichkeit: Hybridmodelle – die das Deep Learning neuronaler Netze mit den leistungsstarken Abstraktionsfähigkeiten symbolischer Operationen kombinieren.

LeCuns kürzlich im NOEMA-Magazin veröffentlichter Artikel „What AI Can Tell Us About Intelligence“ befasste sich ebenfalls mit diesem Thema, aber Marcus wies darauf hin, dass sein Artikel klar schien, aber offensichtliche Mängel aufwies, nämlich die Logik der Vergangenheit und die Zukunft.

Am Anfang des Artikels lehnen sie das Hybridmodell ab, doch am Ende des Artikels wird die Existenz von Hybridmodellen anerkannt und als möglicher Weg nach vorne erwähnt.

Hybrides Modell aus neuronalem Netzwerk und symbolischen Operationen

Marcus wies darauf hin, dass der Hauptpunkt von LeCun und Browning darin besteht, dass „ein Modell nicht hybrid ist, wenn es symbolische Operationen lernt.“

Aber das Problem des maschinellen Lernens ist ein Entwicklungsproblem (wie ist das System entstanden?)

Und wie das System funktioniert, sobald es entwickelt ist, ist ein Rechenproblem (z. B. funktioniert es?). einen Mechanismus verwenden oder nicht? Zwei Mechanismen?), das heißt: „Jedes System, das sowohl Symbole als auch neuronale Netze verwendet, ist ein Hybridmodell.“

Vielleicht wollen sie wirklich sagen, dass künstliche Intelligenz eher ein erlernter Hybrid als ein geborener Hybrid ist. Aber ein Hybrid des Lernens ist immer noch ein Hybrid.

Und Marcus‘ Standpunkt ist, dass „symbolische Operationen selbst angeboren sind, oder es gibt etwas anderes, das angeboren ist, was indirekt zur Entstehung symbolischer Operationen beiträgt.“

Unser Forschungsschwerpunkt sollte also darauf liegen, wie man dieses Medium entdeckt, das indirekt symbolische Operationen fördert.

Die Hypothese lautet: Solange wir herausfinden können, welches Medium es dem System ermöglicht, den Punkt zu erreichen, an dem es symbolische Abstraktionen lernen kann, können wir Systeme aufbauen, die das gesamte Wissen der Welt nutzen.

Als nächstes zitierte Marcus Klassiker und durchkämmte die Geschichte der Debatten über symbolische Manipulation und neuronale Netze im Bereich der künstlichen Intelligenz.

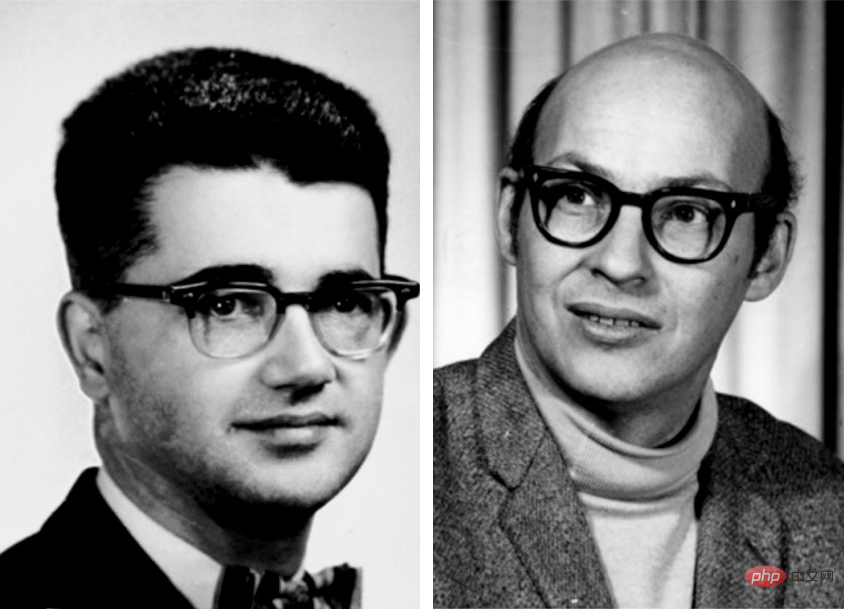

Frühe Pioniere der künstlichen Intelligenz wie Marvin Minsky und John McCarthy glaubten, dass symbolische Manipulation der einzig vernünftige Weg nach vorne sei.

Und der Neuronale-Netzwerk-Pionier Frank Rosenblatt glaubt, dass KI auf der Grundlage einer Struktur, in der neuronale Knoten digitale Eingaben überlagern und verarbeiten, möglicherweise eine bessere Leistung erbringt.

Tatsächlich schließen sich diese beiden Möglichkeiten nicht gegenseitig aus.

Das von der KI verwendete neuronale Netzwerk ist kein buchstäbliches biologisches Neuronennetzwerk, sondern ein vereinfachtes digitales Modell verfügt über einige Eigenschaften des menschlichen Gehirns, jedoch mit minimaler Komplexität.

Grundsätzlich können diese abstrakten Symbole auf viele verschiedene Arten verbunden werden, von denen einige logische und symbolische Operationen direkt implementieren können. „A Logical Calculus of the Ideas Inmanent in Nervous Activity“, veröffentlicht von Warren S. McCulloch und Walter Pitts im Jahr 1943 , erkennt diese Möglichkeit eindeutig an. Andere sind Frank Rosenblatt in den 1950er Jahren sowie David Rumelhart und Jay McClelland in den 1980er Jahren, die neuronale Netze als Alternativen zu symbolischen Operationen vorschlugen. Auch Geoffrey Hinton unterstützt diese Position grundsätzlich.

Dann rief Marcus nacheinander Turing-Award-Gewinner wie LeCun, Hinton und Yoshua Bengio an.

Ich meine, es spielt keine Rolle, was ich gesagt habe, andere große Jungs haben es gesagt!

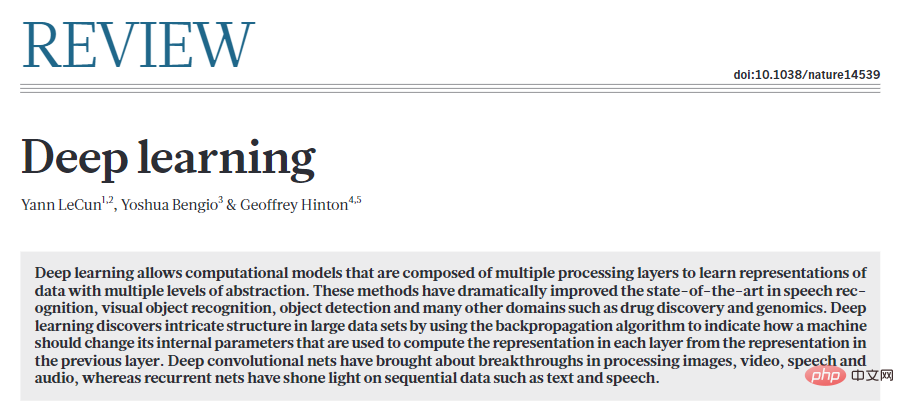

Im Jahr 2015 schrieben LeCun, Bengio und Hinton eine Arbeit im Manifest-Stil über Deep Learning in der Natur.

Der Artikel endet mit einem Angriff auf Symbole und argumentiert, dass „neue Paradigmen erforderlich sind, um die Operationen auf großen Vektoren basierend auf Regular zu ersetzen.“ symbolische Ausdrucksoperationen“. Tatsächlich war Hinton so überzeugt, dass Symbole eine Sackgasse seien, dass er im selben Jahr an der Stanford University einen Vortrag mit dem Titel „Das Symbol des Äthers“ hielt und das Symbol mit einem der größten Fehler in der Geschichte der Wissenschaft verglich. In den 1980er Jahren brachten zwei seiner ehemaligen Mitarbeiter, Rumelhart und McClelland, ähnliche Argumente vor. In einem berühmten Buch argumentierte er, dass Symbole nicht „die Essenz menschlicher Berechnungen“ seien, was eine große Debatte auslöste.

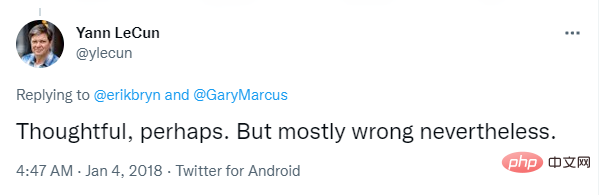

Marcus sagte, als er 2018 einen Artikel zur Verteidigung der Symbolmanipulation schrieb, wies LeCun ihn ohne Begründung zurück es auf Twitter als „größtenteils falsch“.

Dann sagte er, zwei berühmte Experten auf dem Gebiet des Deep Learning äußerte auch seine Unterstützung für hybride KI.

Nach LeCuns und Brownings neuer Sichtweise ist symbolische Manipulation tatsächlich entscheidend, wie Marcus und Steven Pinker seit 1988 vorschlagen.

Marcus beschuldigte Lecun dann: „Ich habe Ihren Standpunkt schon vor Jahrzehnten vertreten, und Ihre Forschung liegt Jahrzehnte zurück.“

Und nicht nur ich, auch andere große Jungs denken so.

Der Rest des Artikels von LeCun und Browning lässt sich grob in drei Teile unterteilen: 1. Falsche Charakterisierung meiner Position 2 . Bemühungen, den Anwendungsbereich hybrider Modelle einzuschränken. 3. Symbolische Manipulation kann eher erlernt als angeboren sein. Als nächstes widerlegte Marcus die Ansichten in LeCuns Artikel: #🎜🎜 #Sagten LeCun und Browning „Marcus hat gesagt, wenn man überhaupt keine symbolische Manipulation hat, wird man sie nie haben.“ Tatsächlich habe ich in meinem 2001 erschienenen Buch „Algebraic Thinking“ ausdrücklich zugegeben, dass wir nicht sicher sind, ob symbolische Operationen mit angeborenem Denken zusammenhängen . Sie kritisierten meine Aussage, dass „Deep Learning keine weiteren Fortschritte machen kann“, und mein eigentlicher Punkt ist nicht, dass DL darauf Einfluss hat Bei jedem Problem wird es keine weiteren Fortschritte geben, aber Deep Learning selbst ist für bestimmte Aufgaben wie Komposition und Argumentation das falsche Werkzeug. In ähnlicher Weise verleumdeten sie mich, indem sie sagten, dass es im System symbolische Argumente gibt oder nicht (1 oder 0). Das ist einfach Unsinn. Es ist wahr, dass DALL-E keine Symbole zum Denken verwendet, aber das bedeutet nicht, dass irgendein System symbolisches Denken enthält muss Oder nicht. Zumindest bereits mit dem System MYCIN in den 1970er Jahren gab es ein rein symbolisches System, das verschiedene quantitative Überlegungen durchführen konnte. Kann die Fähigkeit zur Symbolmanipulation erlernt und nicht von Anfang an aufgebaut werden? Die Antwort ist ja. Marcus sagte, dass frühere Experimente zwar nicht garantieren konnten, dass die Fähigkeit, Symbole zu bedienen, angeboren war, sie aber fast mit diesem identisch war Der Standpunkt ist derselbe. Sie stellen eine Herausforderung für jede Lerntheorie dar, die auf großen Erfahrungsmengen beruht. und bringen Sie folgende 2 Hauptargumente vor: 1. Lernbarkeit wurde 2001 in The Algebraic Mind veröffentlicht Marcus zeigt, dass bestimmte Systeme in der Lage sind, symbolische Operationen zu lernen. Ein System mit einigen integrierten Ausgangspunkten wird die Welt effektiver verstehen als eine reine leere Tafel. Tatsächlich ist sogar LeCuns berühmtestes Werk „On Convolutional Neural Networks“ ein gutes Beispiel: Integrierte Einschränkungen beim Wie Neuronale Netze lernen und verbessern so die Effizienz erheblich. Wenn symbolische Operationen gut integriert sind, können sogar noch größere Gewinne erzielt werden. 2. Menschliche Säuglinge zeigen eine gewisse Fähigkeit, Symbole zu manipulieren #🎜🎜 # Darüber hinaus hat die Forschung gezeigt, dass Bienen beispielsweise die Sonnenazimutfunktion auf Lichtverhältnisse übertragen können, die sie noch nie zuvor gesehen haben.

Was rätselhaft ist, ist, dass LeCun, nachdem er Einwände gegen die angeborene Natur von Symboloperationen erhoben hatte, keine starken Beweise lieferte, um diese symbolische Manipulation zu beweisen wird gelernt. Wenn ein Ziegenbaby kurz nach der Geburt einen Hügel hinunterklettern kann, warum können dann neu entstehende neuronale Netze nicht sofort integriert werden? ? Wie wäre es mit einer kleinen symbolischen Manipulation?

Gleichzeitig haben LeCun und Browning nicht spezifiziert, wie die bekannten spezifischen Probleme beim Sprachverständnis und -schlussfolgern gelöst werden können, da der intrinsische Mechanismus der symbolischen Manipulation fehlt. Sie geben nur eine schwache Verallgemeinerung: Da Deep Learning das Problem von 1 bis N überwunden hat, sollten wir zuversichtlich sein, dass es das N+1-Problem überwinden kann. Die Leute sollten sich fragen, ob Deep Learning an seine Grenzen gestoßen ist. Angesichts der kontinuierlichen schrittweisen Verbesserungen der Missionen, die kürzlich in DALL-E 2, Gato und PaLM zu sehen waren, scheint es ratsam, momentane Schwierigkeiten nicht mit „Mauern“ zu verwechseln. Das unvermeidliche Scheitern von Deep Learning wurde bereits vorhergesagt, aber es lohnt sich nicht, darauf zu wetten. Optimismus ist eine Sache, aber man muss die Realität klar sehen. Deep Learning steht im Prinzip vor einigen spezifischen Herausforderungen, vor allem in Bezug auf Kompositionalität, Systematisierung und Sprachverständnis, die sich alle um Generalisierung und „verteilten Transfer“ drehen. Jetzt erkennt jeder, dass die Verteilungsmigration die Achillesferse aktueller neuronaler Netze ist. Natürlich hat Deep Learning Fortschritte gemacht, aber bei diesen grundlegenden Problemen wurden keine großen Fortschritte erzielt. Aus Sicht von Marcus ist die Situation, in der symbolische Operationen angeboren sein können, ungefähr die gleiche wie in der Vergangenheit: 1. Das aktuelle System, 20 Jahre nach der Entstehung des „algebraischen Denkens“ Selbst angesichts umfangreicher Datensätze und Schulungen ist es immer noch unmöglich, symbolische Operationen (z. B. Multiplikation) zuverlässig zu extrahieren. 2. Das Beispiel menschlicher Säuglinge zeigt, dass sie vor dem Erhalt einer formalen Bildung die Fähigkeit besitzen, komplexe Aspekte der natürlichen Sprache und des logischen Denkens zu verallgemeinern. 3. Eine kleine innere symbolische Bedeutung kann die Lerneffizienz erheblich verbessern. Ein Teil der Leistungsfähigkeit von AlphaFold 2 beruht auf sorgfältig konstruierten angeborenen Darstellungen der Molekularbiologie. Kurz gesagt, die Welt lässt sich grob in drei Klassen einteilen: Eins ist ein System mit Symbolmanipulationsgeräten, die vollständig in der Fabrik installiert sind. Das zweite ist, dass dem System mit angeborenem Lerngerät symbolische Operationen fehlen, es aber mit den richtigen Daten und der richtigen Trainingsumgebung über genügend Fähigkeiten verfügt, diese zu erhalten. Das dritte System ist selbst bei ausreichender Schulung nicht in der Lage, einen vollständigen Symbolmanipulationsmechanismus zu erhalten. Aktuelle Deep-Learning-Systeme scheinen in die dritte Kategorie zu fallen: keine symbolischen Manipulationsmechanismen am Anfang und keine zuverlässigen symbolischen Manipulationsmechanismen im Prozess. Derzeit hat das Verständnis der Ursprünge symbolischer Manipulation für uns oberste Priorität. Selbst die eifrigsten Befürworter neuronaler Netze erkennen mittlerweile die Bedeutung symbolischer Operationen für die Verwirklichung von KI. Und genau darauf hat sich die Neurosemiotik-Community konzentriert: Wie können datengesteuertes Lernen und symbolische Darstellung in einer einzigen, leistungsfähigeren Intelligenz harmonieren?

Das obige ist der detaillierte Inhalt vonMarcus veröffentlichte einen Artikel, in dem er LeCun kritisierte: Deep Learning allein kann keine menschenähnliche Intelligenz erreichen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Methoden und Schritte zur Verwendung von BERT für die Stimmungsanalyse in Python

Jan 22, 2024 pm 04:24 PM

Methoden und Schritte zur Verwendung von BERT für die Stimmungsanalyse in Python

Jan 22, 2024 pm 04:24 PM

BERT ist ein vorab trainiertes Deep-Learning-Sprachmodell, das 2018 von Google vorgeschlagen wurde. Der vollständige Name lautet BidirektionalEncoderRepresentationsfromTransformers, der auf der Transformer-Architektur basiert und die Eigenschaften einer bidirektionalen Codierung aufweist. Im Vergleich zu herkömmlichen Einweg-Codierungsmodellen kann BERT bei der Textverarbeitung gleichzeitig Kontextinformationen berücksichtigen, sodass es bei Verarbeitungsaufgaben in natürlicher Sprache eine gute Leistung erbringt. Seine Bidirektionalität ermöglicht es BERT, die semantischen Beziehungen in Sätzen besser zu verstehen und dadurch die Ausdrucksfähigkeit des Modells zu verbessern. Durch Vorschulungs- und Feinabstimmungsmethoden kann BERT für verschiedene Aufgaben der Verarbeitung natürlicher Sprache verwendet werden, wie z. B. Stimmungsanalyse und Benennung

Latente Raumeinbettung: Erklärung und Demonstration

Jan 22, 2024 pm 05:30 PM

Latente Raumeinbettung: Erklärung und Demonstration

Jan 22, 2024 pm 05:30 PM

Latent Space Embedding (LatentSpaceEmbedding) ist der Prozess der Abbildung hochdimensionaler Daten auf niedrigdimensionalen Raum. Im Bereich des maschinellen Lernens und des tiefen Lernens handelt es sich bei der Einbettung latenter Räume normalerweise um ein neuronales Netzwerkmodell, das hochdimensionale Eingabedaten in einen Satz niedrigdimensionaler Vektordarstellungen abbildet. Dieser Satz von Vektoren wird oft als „latente Vektoren“ oder „latent“ bezeichnet Kodierungen". Der Zweck der Einbettung latenter Räume besteht darin, wichtige Merkmale in den Daten zu erfassen und sie in einer prägnanteren und verständlicheren Form darzustellen. Durch die Einbettung latenter Räume können wir Vorgänge wie das Visualisieren, Klassifizieren und Clustern von Daten im niedrigdimensionalen Raum durchführen, um die Daten besser zu verstehen und zu nutzen. Die Einbettung latenter Räume findet in vielen Bereichen breite Anwendung, z. B. bei der Bilderzeugung, der Merkmalsextraktion, der Dimensionsreduzierung usw. Die Einbettung des latenten Raums ist das Wichtigste

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Heute diskutieren wir darüber, wie Deep-Learning-Technologie die Leistung von visionbasiertem SLAM (Simultaneous Localization and Mapping) in komplexen Umgebungen verbessern kann. Durch die Kombination von Methoden zur Tiefenmerkmalsextraktion und Tiefenanpassung stellen wir hier ein vielseitiges hybrides visuelles SLAM-System vor, das die Anpassung in anspruchsvollen Szenarien wie schlechten Lichtverhältnissen, dynamischer Beleuchtung, schwach strukturierten Bereichen und starkem Jitter verbessern soll. Unser System unterstützt mehrere Modi, einschließlich erweiterter Monokular-, Stereo-, Monokular-Trägheits- und Stereo-Trägheitskonfigurationen. Darüber hinaus wird analysiert, wie visuelles SLAM mit Deep-Learning-Methoden kombiniert werden kann, um andere Forschungen zu inspirieren. Durch umfangreiche Experimente mit öffentlichen Datensätzen und selbst abgetasteten Daten demonstrieren wir die Überlegenheit von SL-SLAM in Bezug auf Positionierungsgenauigkeit und Tracking-Robustheit.

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

In der heutigen Welle rasanter technologischer Veränderungen sind künstliche Intelligenz (KI), maschinelles Lernen (ML) und Deep Learning (DL) wie helle Sterne und führen die neue Welle der Informationstechnologie an. Diese drei Wörter tauchen häufig in verschiedenen hochaktuellen Diskussionen und praktischen Anwendungen auf, aber für viele Entdecker, die neu auf diesem Gebiet sind, sind ihre spezifische Bedeutung und ihre internen Zusammenhänge möglicherweise noch immer rätselhaft. Schauen wir uns also zunächst dieses Bild an. Es ist ersichtlich, dass zwischen Deep Learning, maschinellem Lernen und künstlicher Intelligenz ein enger Zusammenhang und eine fortschreitende Beziehung besteht. Deep Learning ist ein spezifischer Bereich des maschinellen Lernens und des maschinellen Lernens

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Fast 20 Jahre sind vergangen, seit das Konzept des Deep Learning im Jahr 2006 vorgeschlagen wurde. Deep Learning hat als Revolution auf dem Gebiet der künstlichen Intelligenz viele einflussreiche Algorithmen hervorgebracht. Was sind Ihrer Meinung nach die zehn besten Algorithmen für Deep Learning? Im Folgenden sind meiner Meinung nach die besten Algorithmen für Deep Learning aufgeführt. Sie alle nehmen hinsichtlich Innovation, Anwendungswert und Einfluss eine wichtige Position ein. 1. Hintergrund des Deep Neural Network (DNN): Deep Neural Network (DNN), auch Multi-Layer-Perceptron genannt, ist der am weitesten verbreitete Deep-Learning-Algorithmus. Als er erstmals erfunden wurde, wurde er aufgrund des Engpasses bei der Rechenleistung in Frage gestellt Jahre, Rechenleistung, Der Durchbruch kam mit der Datenexplosion. DNN ist ein neuronales Netzwerkmodell, das mehrere verborgene Schichten enthält. In diesem Modell übergibt jede Schicht Eingaben an die nächste Schicht und

AlphaFold 3 wird auf den Markt gebracht und sagt die Wechselwirkungen und Strukturen von Proteinen und allen Lebensmolekülen umfassend und mit weitaus größerer Genauigkeit als je zuvor voraus

Jul 16, 2024 am 12:08 AM

AlphaFold 3 wird auf den Markt gebracht und sagt die Wechselwirkungen und Strukturen von Proteinen und allen Lebensmolekülen umfassend und mit weitaus größerer Genauigkeit als je zuvor voraus

Jul 16, 2024 am 12:08 AM

Herausgeber | Rettichhaut Seit der Veröffentlichung des leistungsstarken AlphaFold2 im Jahr 2021 verwenden Wissenschaftler Modelle zur Proteinstrukturvorhersage, um verschiedene Proteinstrukturen innerhalb von Zellen zu kartieren, Medikamente zu entdecken und eine „kosmische Karte“ jeder bekannten Proteininteraktion zu zeichnen. Gerade hat Google DeepMind das AlphaFold3-Modell veröffentlicht, das gemeinsame Strukturvorhersagen für Komplexe wie Proteine, Nukleinsäuren, kleine Moleküle, Ionen und modifizierte Reste durchführen kann. Die Genauigkeit von AlphaFold3 wurde im Vergleich zu vielen dedizierten Tools in der Vergangenheit (Protein-Ligand-Interaktion, Protein-Nukleinsäure-Interaktion, Antikörper-Antigen-Vorhersage) deutlich verbessert. Dies zeigt, dass dies innerhalb eines einzigen einheitlichen Deep-Learning-Frameworks möglich ist

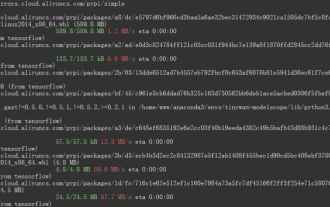

TensorFlow Deep-Learning-Framework-Modell-Inferenzpipeline für Porträtausschnitt-Inferenz

Mar 26, 2024 pm 01:00 PM

TensorFlow Deep-Learning-Framework-Modell-Inferenzpipeline für Porträtausschnitt-Inferenz

Mar 26, 2024 pm 01:00 PM

Übersicht Um ModelScope-Benutzern die schnelle und bequeme Nutzung verschiedener von der Plattform bereitgestellter Modelle zu ermöglichen, wird eine Reihe voll funktionsfähiger Python-Bibliotheken bereitgestellt, die die Implementierung offizieller ModelScope-Modelle sowie die erforderlichen Tools für die Verwendung dieser Modelle für Inferenzen umfassen , Feinabstimmung und andere Aufgaben im Zusammenhang mit der Datenvorverarbeitung, Nachverarbeitung, Effektbewertung und anderen Funktionen und bietet gleichzeitig eine einfache und benutzerfreundliche API und umfangreiche Anwendungsbeispiele. Durch den Aufruf der Bibliothek können Benutzer Aufgaben wie Modellinferenz, Schulung und Bewertung erledigen, indem sie nur wenige Codezeilen schreiben. Auf dieser Basis können sie auch schnell eine Sekundärentwicklung durchführen, um ihre eigenen innovativen Ideen zu verwirklichen. Das derzeit von der Bibliothek bereitgestellte Algorithmusmodell ist:

Verbesserter RMSprop-Algorithmus

Jan 22, 2024 pm 05:18 PM

Verbesserter RMSprop-Algorithmus

Jan 22, 2024 pm 05:18 PM

RMSprop ist ein weit verbreiteter Optimierer zum Aktualisieren der Gewichte neuronaler Netze. Es wurde 2012 von Geoffrey Hinton et al. vorgeschlagen und ist der Vorgänger des Adam-Optimierers. Das Aufkommen des RMSprop-Optimierers besteht hauptsächlich darin, einige Probleme zu lösen, die im SGD-Gradientenabstiegsalgorithmus auftreten, wie z. B. das Verschwinden des Gradienten und die Explosion des Gradienten. Durch den Einsatz des RMSprop-Optimierers kann die Lernrate effektiv angepasst und Gewichte adaptiv aktualisiert werden, wodurch der Trainingseffekt des Deep-Learning-Modells verbessert wird. Die Kernidee des RMSprop-Optimierers besteht darin, einen gewichteten Durchschnitt von Gradienten durchzuführen, sodass Gradienten in unterschiedlichen Zeitschritten unterschiedliche Auswirkungen auf Gewichtsaktualisierungen haben. Konkret berechnet RMSprop das Quadrat jedes Parameters