Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

So cool, dass es explodiert! Die Online-Demonstration von HuggingGPT hatte einen beeindruckenden Auftritt und Internetnutzer testeten die Bilderzeugung persönlich

So cool, dass es explodiert! Die Online-Demonstration von HuggingGPT hatte einen beeindruckenden Auftritt und Internetnutzer testeten die Bilderzeugung persönlich

So cool, dass es explodiert! Die Online-Demonstration von HuggingGPT hatte einen beeindruckenden Auftritt und Internetnutzer testeten die Bilderzeugung persönlich

Die stärkste Kombination HuggingFace+ChatGPT="Jarvis" ist jetzt zur Demo geöffnet.

Vor einiger Zeit veröffentlichten die Zhejiang-Universität und Microsoft HuggingGPT, ein großes Modell-Kollaborationssystem, das sofort ein Erfolg wurde.

Die Forscher schlugen vor, ChatGPT als Controller zu verwenden, um verschiedene KI-Modelle in der HuggingFace-Community zu verbinden, um multimodale komplexe Aufgaben zu erledigen.

Im gesamten Prozess müssen Sie lediglich: Ihre Anforderungen in natürlicher Sprache ausgeben.

NVIDIA-Wissenschaftler sagten, dies sei der interessanteste Artikel, den ich diese Woche gelesen habe. Seine Idee kommt der „Everything App“, die ich zuvor erwähnt habe, sehr nahe, das heißt, alles ist eine App und die Informationen werden direkt von der KI gelesen.

Erste Schritte

Jetzt hat HuggingGPT die Gradio-Demo hinzugefügt.

Projektadresse: https://github.com/microsoft/JARVIS

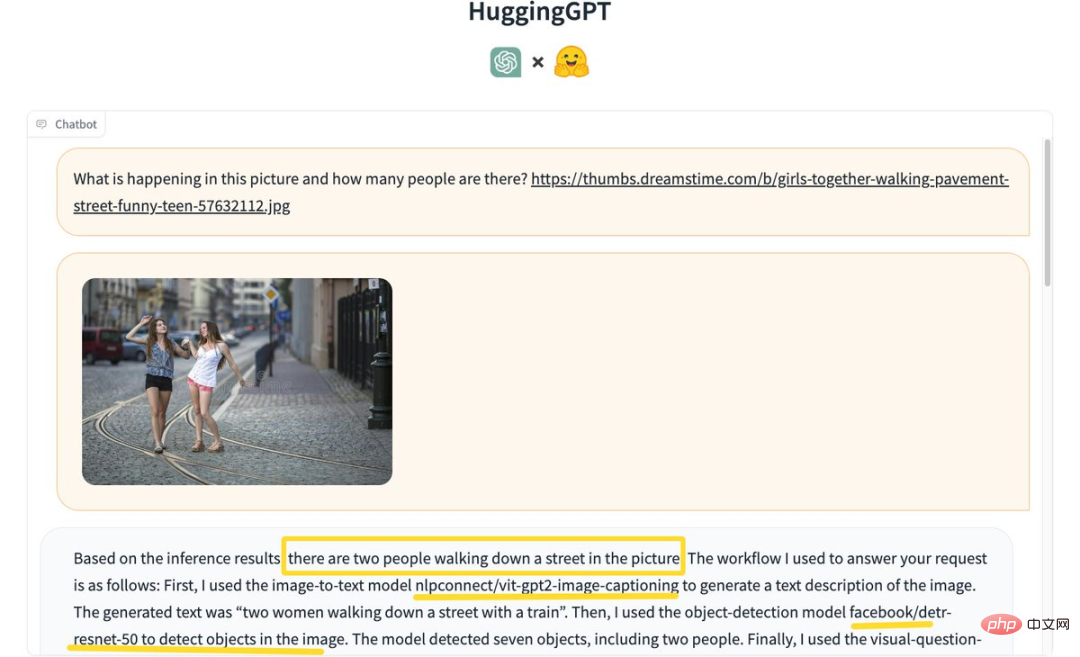

Einige Internetnutzer begannen es zu erleben: „Erkennen Sie, wie viele Personen auf dem Bild sind“?

HuggingGPT kam aufgrund der Inferenzergebnisse zu dem Schluss, dass auf dem Bild zwei Personen auf der Straße gehen.

Der spezifische Prozess ist wie folgt:

Verwenden Sie zunächst das Bild-zu-Text-Modell nlpconnect/vit-gpt2-image-captioning, um das Bild und den generierten Text „2 Frauen, die mit einem Zug auf einer Straße gehen“ zu beschreiben ".

Als nächstes wird das Objekterkennungsmodell facebook/detrresnet 50 verwendet, um die Anzahl der Personen auf dem Bild zu erkennen. Das Modell hat 7 Objekte und 2 Personen erkannt.

Verwenden Sie dann das visuelle Frage-Antwort-Modell dandelin/vilt-b32-finetuned-vqa, um die Ergebnisse zu erhalten. Abschließend liefert das System detaillierte Antworten und Modellinformationen zur Beantwortung der Frage.

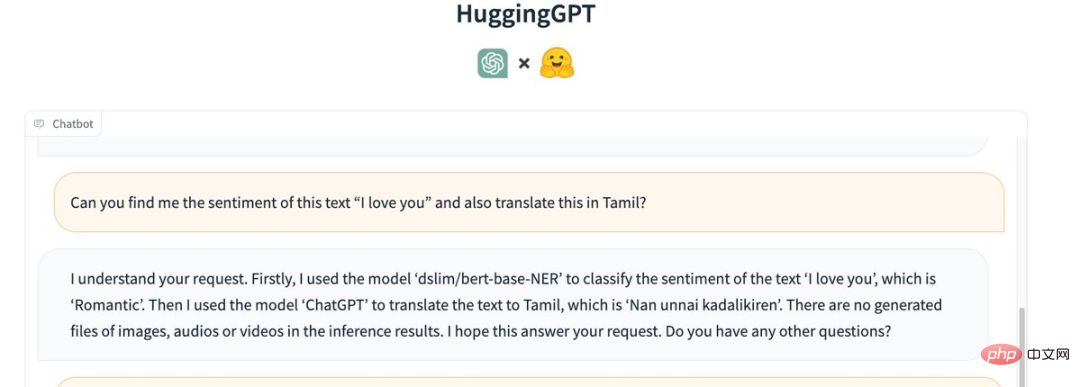

Machen Sie außerdem die Emotion des Satzes „Ich liebe dich“ verständlich und übersetzen Sie ihn ins Tamilische (Tamiḻ).

HuggingGPT nannte das folgende Modell:

Zunächst wurde das Modell „dslim/bert-base-NER“ verwendet, um die Emotion des Textes „Ich liebe dich“ zu klassifizieren, der „romantisch“ ist.

Dann verwenden Sie „ChatGPT“, um den Text ins Tamilische zu übersetzen, das „Nan unnai kadalikiren“ lautet.

In den Inferenzergebnissen sind keine generierten Bilder, Audio- oder Videodateien enthalten.

HuggingGPT ist beim Transkribieren von MP3-Dateien fehlgeschlagen. Ein Internetnutzer sagte: „Ich bin mir nicht sicher, ob das ein Problem mit meiner Eingabedatei ist.“

Schauen wir uns die Bildgenerierungsfunktionen an.

Geben Sie das Bild „Eine tanzende Katze“ ein und fügen Sie den Text „I LOVE YOU“ als Overlay hinzu.

HuggingGPT verwendete zunächst das Modell „runwayml/stable-diffusion-1-5“, um basierend auf dem angegebenen Text ein Bild der „tanzenden Katze“ zu generieren.

Dann wurde das gleiche Modell verwendet, um basierend auf dem vorgegebenen Text ein Bild von „ICH LIEBE DICH“ zu generieren.

Fügen Sie abschließend die beiden Bilder zusammen und das Ergebnis ist wie folgt:

Jarvis wird Wirklichkeit

Nur wenige Tage nach der Veröffentlichung des Projekts hat Jarvis bereits 12,5.000 Sterne und 811 Sterne auf dem GitHub-Fork erhalten .

Forscher wiesen darauf hin, dass die Lösung der aktuellen Probleme großer Sprachmodelle (LLMs) der erste und entscheidende Schritt in Richtung AGI sein könnte.

Da die aktuelle Technologie großer Sprachmodelle noch einige Mängel aufweist, gibt es auf dem Weg zum Aufbau von AGI-Systemen einige dringende Herausforderungen.

Um komplexe KI-Aufgaben zu bewältigen, sollten LLMs in der Lage sein, sich mit externen Modellen zu koordinieren, um deren Fähigkeiten zu nutzen.

Der entscheidende Punkt ist daher die Auswahl der geeigneten Middleware zur Überbrückung von LLMs und KI-Modellen.

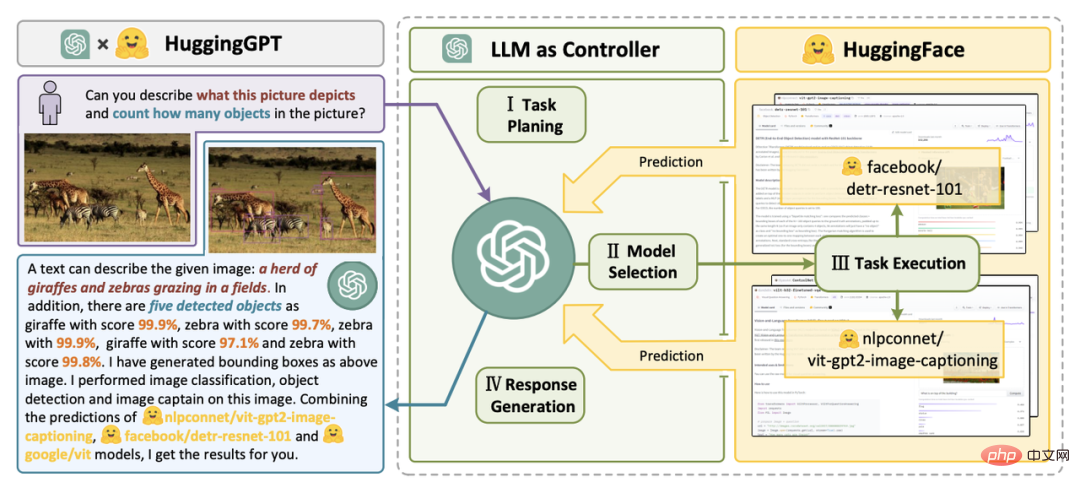

In dieser Forschungsarbeit schlägt der Forscher vor, dass Sprache eine universelle Schnittstelle in HuggingGPT ist. Der Arbeitsablauf ist hauptsächlich in vier Schritte unterteilt:

Papieradresse: https://arxiv.org/pdf/2303.17580.pdf

Der erste ist die Aufgabenplanung. ChatGPT analysiert Benutzeranfragen und konvertiert Sie zerlegen es in mehrere Aufgaben und planen die Aufgabensequenz und Abhängigkeiten basierend auf seinem Wissen.

Als nächstes fahren Sie mit der Modellauswahl fort. LLM weist geparste Aufgaben Expertenmodellen basierend auf der Modellbeschreibung in HuggingFace zu.

Führen Sie dann die Aufgabe aus. Das Expertenmodell führt die zugewiesenen Aufgaben am Inferenzendpunkt aus und zeichnet die Ausführungsinformationen und Inferenzergebnisse im LLM auf.

Der letzte Schritt ist die Antwortgenerierung. LLM fasst Ausführungsprozessprotokolle und Inferenzergebnisse zusammen und gibt die Zusammenfassung an den Benutzer zurück.

Angenommen, eine solche Anfrage wird gestellt:

Bitte erstellen Sie ein Bild eines Mädchens, das ein Buch liest. Ihre Haltung ist die gleiche wie die des Jungen in example.jpg. Beschreiben Sie dann mit Ihrer Stimme das neue Bild.

Sie können sehen, wie HuggingGPT es in 6 Unteraufgaben zerlegt und das auszuführende Modell auswählt, um das Endergebnis zu erhalten.

Durch die Integration von KI-Modellbeschreibungen in Eingabeaufforderungen kann ChatGPT als das Gehirn betrachtet werden, das KI-Modelle verwaltet. Daher ermöglicht diese Methode ChatGPT, externe Modelle aufzurufen, um praktische Aufgaben zu lösen.

Einfach ausgedrückt ist HuggingGPT ein Kollaborationssystem, kein großes Modell.

Seine Funktion besteht darin, ChatGPT und HuggingFace zu verbinden, um Eingaben in verschiedenen Modalitäten zu verarbeiten und viele komplexe Aufgaben der künstlichen Intelligenz zu lösen.

Jedes KI-Modell in der HuggingFace-Community verfügt also über eine entsprechende Modellbeschreibung in der HuggingGPT-Bibliothek und ist in die Aufforderung zum Herstellen einer Verbindung mit ChatGPT integriert.

HuggingGPT nutzt dann ChatGPT als Gehirn, um die Antwort auf die Frage zu ermitteln.

Bisher hat HuggingGPT Hunderte von Modellen auf HuggingFace rund um ChatGPT integriert und 24 Aufgaben wie Textklassifizierung, Zielerkennung, semantische Segmentierung, Bildgenerierung, Frage und Antwort, Text-to-Speech und Text-to-Video abgedeckt.

Experimentelle Ergebnisse belegen, dass HuggingGPT bei verschiedenen Formen komplexer Aufgaben eine gute Leistung zeigen kann.

Heiße Kommentare von Internetnutzern

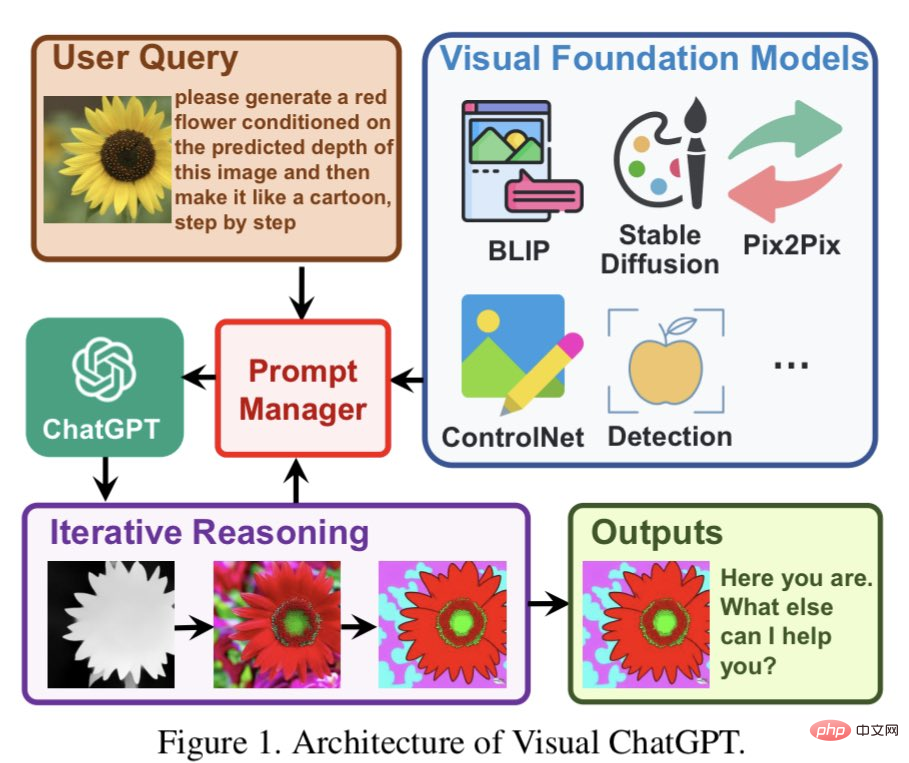

Einige Internetnutzer sagten, dass HuggingGPT dem zuvor von Microsoft vorgeschlagenen Visual ChatGPT ähnelt. Es scheint, dass sie die ursprüngliche Idee auf einen riesigen Satz vorab trainierter Modelle erweitert haben.

Visual ChatGPT basiert direkt auf ChatGPT und fügt viele visuelle Modelle (VFMs) ein. Prompt Manage wird im Artikel vorgeschlagen.

Mit Hilfe von PMs kann ChatGPT diese VFMs nutzen und ihr Feedback iterativ erhalten, bis die Anforderungen des Benutzers erfüllt oder die Endbedingung erreicht ist. Einige Internetnutzer glauben, dass diese Idee tatsächlich ChatGPT sehr ähnlich ist. Die Nutzung von LLM als Zentrum für semantisches Verständnis und Aufgabenplanung kann die Fähigkeiten von LLM unendlich verbessern. Durch die Kombination von LLM mit anderen Funktions- oder Domänenexperten können wir leistungsfähigere und flexiblere KI-Systeme schaffen, die sich besser an eine Vielzahl von Aufgaben und Anforderungen anpassen können.

Das habe ich immer über AGI gedacht, Modelle der künstlichen Intelligenz sind in der Lage, komplexe Aufgaben zu verstehen und dann zu integrieren Kleinere Aufgaben werden anderen, professionelleren KI-Modellen zugewiesen.

Genau wie das Gehirn hat es auch verschiedene Teile, um bestimmte Aufgaben zu erfüllen, was sehr logisch klingt.

Das obige ist der detaillierte Inhalt vonSo cool, dass es explodiert! Die Online-Demonstration von HuggingGPT hatte einen beeindruckenden Auftritt und Internetnutzer testeten die Bilderzeugung persönlich. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1374

1374

52

52

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Bei der Konvertierung von Zeichenfolgen in Objekte in Vue.js wird JSON.Parse () für Standard -JSON -Zeichenfolgen bevorzugt. Bei nicht standardmäßigen JSON-Zeichenfolgen kann die Zeichenfolge durch Verwendung regelmäßiger Ausdrücke verarbeitet und Methoden gemäß dem Format oder dekodierten URL-kodiert reduziert werden. Wählen Sie die entsprechende Methode gemäß dem String -Format aus und achten Sie auf Sicherheits- und Codierungsprobleme, um Fehler zu vermeiden.

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

Zusammenfassung: Es gibt die folgenden Methoden zum Umwandeln von VUE.JS -String -Arrays in Objektarrays: Grundlegende Methode: Verwenden Sie die Kartenfunktion, um regelmäßige formatierte Daten zu entsprechen. Erweitertes Gameplay: Die Verwendung regulärer Ausdrücke kann komplexe Formate ausführen, müssen jedoch sorgfältig geschrieben und berücksichtigt werden. Leistungsoptimierung: In Betracht ziehen die große Datenmenge, asynchrone Operationen oder effiziente Datenverarbeitungsbibliotheken können verwendet werden. Best Practice: Clear Code -Stil, verwenden Sie sinnvolle variable Namen und Kommentare, um den Code präzise zu halten.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Vue- und Element-UI-Kaskaden-Dropdown-Box V-Model-Bindung

Apr 07, 2025 pm 08:06 PM

Vue- und Element-UI-Kaskaden-Dropdown-Box V-Model-Bindung

Apr 07, 2025 pm 08:06 PM

Vue- und Element-UI-kaskadierte Dropdown-Boxen V-Model-Bindung gemeinsame Grubenpunkte: V-Model bindet ein Array, das die ausgewählten Werte auf jeder Ebene des kaskadierten Auswahlfelds darstellt, nicht auf einer Zeichenfolge; Der Anfangswert von ausgewählten Optionen muss ein leeres Array sein, nicht null oder undefiniert. Die dynamische Belastung von Daten erfordert die Verwendung asynchroner Programmierkenntnisse, um Datenaktualisierungen asynchron zu verarbeiten. Für riesige Datensätze sollten Leistungsoptimierungstechniken wie virtuelles Scrollen und fauler Laden in Betracht gezogen werden.

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

Um die Zeitüberschreitung für Vue Axios festzulegen, können wir eine Axios -Instanz erstellen und die Zeitleitungsoption angeben: in globalen Einstellungen: vue.Prototyp. $ Axios = axios.create ({Timeout: 5000}); In einer einzigen Anfrage: this. $ axios.get ('/api/user', {timeout: 10000}).

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.