Nachdem ChatGPT Ende November 2022 eingeführt wurde, erregte es weltweite Aufmerksamkeit und seine Popularität ist immer noch groß! Durch die Ersetzung von Suchmaschinen, den Singularitätspunkt und den Wendepunkt stehen mehrere Berufe vor einer Arbeitslosigkeitskrise und die Menschheit steht vor der ultimativen Herausforderung ... Angesichts solch aktueller Themen teilt dieser Artikel unser Verständnis und begrüßt Diskussionen und Korrekturen .

Im Allgemeinen hat ChatGPT erhebliche technologische Fortschritte gemacht. Obwohl es Mängel gibt, ist die Entwicklung hin zu AGI (künstliche allgemeine Intelligenz, allgemeine künstliche Intelligenz) immer noch voller Herausforderungen!

Abbildung 1: https://openai.com/blog/chatgpt/ Screenshot der Webseite

Lassen Sie uns zunächst den Eliza-Effekt (Eliza-Effekt) in der KI-Forschung vorstellen. was auch mit Chatbots zusammenhängt.

Der Eliza-Effekt bedeutet, dass Menschen die Ergebnisse der Maschine überinterpretieren und Bedeutungen vorlesen, die sie ursprünglich nicht hatten. Menschen neigen psychologisch dazu, unbewusst zu glauben, dass natürliche Phänomene dem menschlichen Verhalten ähneln, was in der Psychologie als menschlicher Anthropomorphismus (Anthropomorphisierung) bezeichnet wird, insbesondere wenn Menschen kein ausreichendes Verständnis für neue Phänomene haben. In der Antike glaubten die Menschen beispielsweise, dass der Donner von einem im Himmel lebenden Donnergott verursacht wurde. Wenn der Donnergott wütend wurde, donnerte er.

Der Name „Eliza“ stammt von einem Chat-Roboter, der 1966 vom MIT-Informatiker Joseph Weizenbaum entwickelt wurde. Der Chatbot Eliza war als psychologischer Berater konzipiert. Das clevere Eliza-Projekt erzielte damals einen unerwarteten Erfolg und sorgte für Aufsehen.

Ein gewisses Verständnis der Prinzipien von ChatGPT sollte in der Lage sein, den Eliza-Effekt zu reduzieren beim Verständnis von ChatGPT. Nur mit einem richtigen Urteil können wir gesund und weitreichend sein. Zu diesem Zweck bemühen wir uns um Genauigkeit und stellen den Lesern Referenzen zum besseren Verständnis zur Verfügung. Das Folgende wird in drei Teile unterteilt:

Persönliche Homepage : http://oa .ee .tsinghua.edu.cn/ouzhijian

Autor: Ou Zhijian, außerordentlicher Professor und Doktorvater in der Abteilung für Elektrotechnik der Tsinghua-Universität. War stellvertretender Herausgeber des IEEE Audio Speech Language Journal (TASLP), Redaktionsmitglied von Computer Speech & Language, Mitglied des IEEE Speech Language Technology Committee (SLTC), Vorsitzender der IEEE Speech Technology (SLT) 2021 Conference und angesehenes Mitglied von China Computer Föderation (CCF) und Speech Dialogue and Hearing Mitglieder von Sonderausschüssen usw. Er hat fast 100 Artikel veröffentlicht und drei Provinz- und Ministerpreise sowie mehrere in- und ausländische Auszeichnungen für herausragende Artikel gewonnen. Führte grundlegende Originalforschung zu Zufallsfeld-Sprachmodellen, Lernalgorithmen für diskrete latente Variablenmodelle, End-to-End-Dialogmodelle und deren halbüberwachtes Lernen durch.

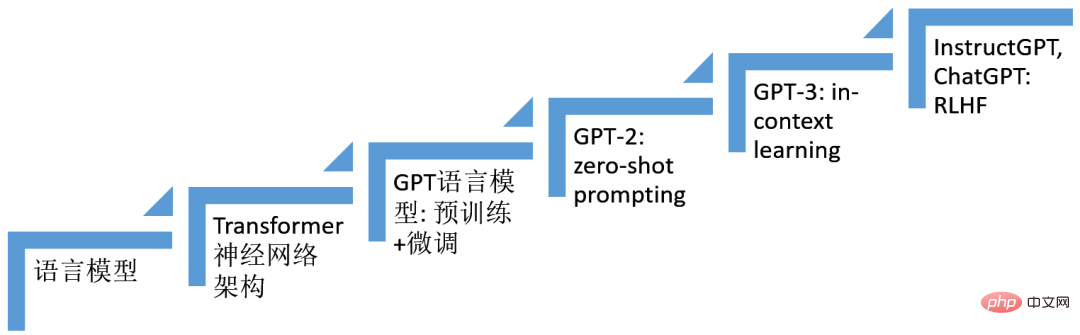

Der Fortschritt von ChatGPT steht seit vielen Jahren auf den Schultern von Giganten der künstlichen Intelligenzforschung, insbesondere der Deep-Learning-Technologie, also der Technologie, die mehrschichtige neuronale Netze nutzt. Wir haben mehrere Technologien herausgesucht, die beim Systemaufbau von ChatGPT eine wichtige Rolle spielen, wie in der folgenden Abbildung dargestellt. Es ist die kombinierte Wirkung dieser Technologien (sechs Schritte), die ChatGPT hervorgebracht hat. Das Modellskelett von

ChatGPT ist ein autoregressives Sprachmodell (Sprachmodell), das auf der neuronalen Netzwerkarchitektur Transformer basiert. Technologie basierend auf Feinabstimmung (Finetuning), Technologie basierend auf Prompt (Prompt), Situationslernen (In-Context-Lernen), verstärkendes Lernen aus menschlichem Feedback (RLHF) Die Technologie entwickelte sich nach und nach und trug schließlich dazu bei Die Geburt von ChatGPT.

Abbildung 2: Fortschritt von ChatGPT

1. Sprachmodell (LM, Sprachmodell)

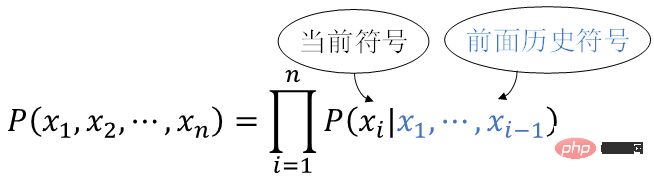

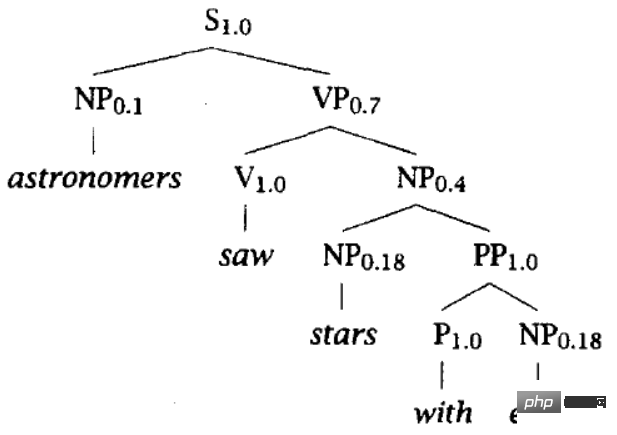

Sprachmodell ist ein Wahrscheinlichkeitsmodell der menschlichen natürlichen Sprache. Die menschliche natürliche Sprache ist ein Satz, und ein Satz ist eine Folge natürlicher Sprachsymbole x1,x2,…,xn#🎜 🎜 #, gehorche der Wahrscheinlichkeitsverteilung

Mit der Multiplikationsformel der Wahrscheinlichkeitstheorie können wir erhalten # 🎜🎜#

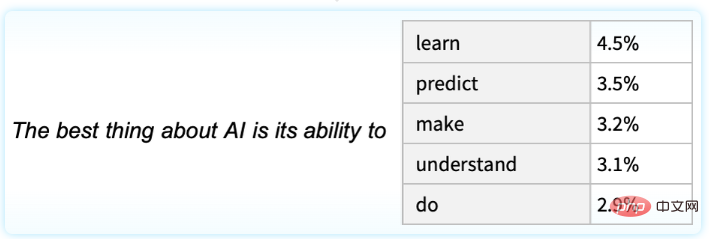

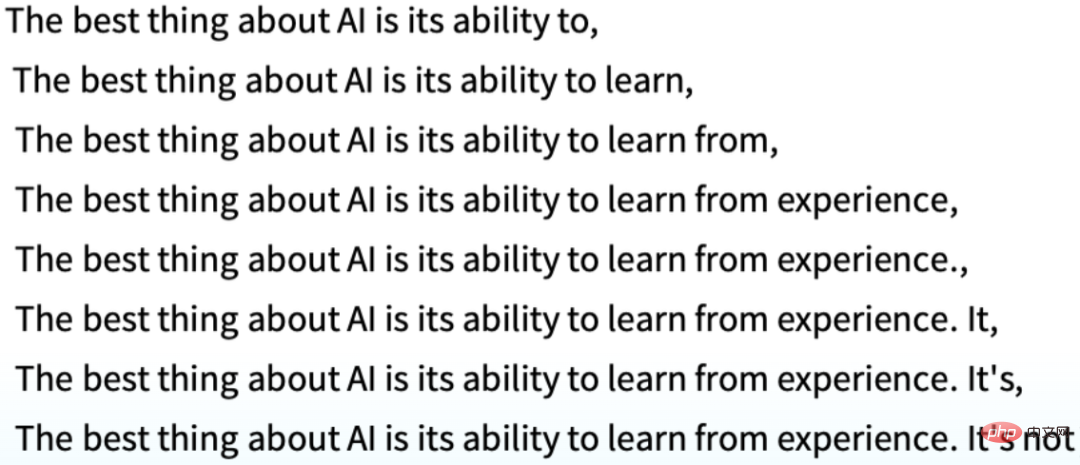

, jede Position verwendet das vordere historische Symbol #🎜🎜 #x1,x2,…,xi-1 (d. h. oben), Berechnen Sie die aktuelle (bedingte) Wahrscheinlichkeit, dass das Symbol erscheint um das aktuelle Symbol unter den oben genannten Bedingungen zu generieren. Die folgende Abbildung veranschaulicht beispielsweise die Auftrittswahrscheinlichkeit des nächsten Symbols angesichts des obigen Textes „Das Beste an KI ist ihre Fähigkeit,“. kann rekursiv generiert werden, # 🎜🎜#Der Schlüssel zum Problem des Sprachmodells liegt darin, welche Art von Funktionsfamilie konstruiert werden muss, um die bedingte Verteilung darzustellen P(x

i |. Ein auf ChatGPT basierender technologischer Fortschritt ist die Verwendung neuronaler Netze zur Darstellung von  P(x

P(x

| 🎜#).

2. Transformer Neural Network Architecture Für sequenzbedingte Verteilung P(xi | 🎜#Eine der Herausforderungen bei der Modellierung ist die Modellierung von Langstreckenabhängigkeiten. Sequenzmodelle, die gewöhnliche wiederkehrende neuronale Netze (RNN) verwenden, werden während des Trainings auf explodierende und verschwindende Gradienteneffekte [1] stoßen, so dass es sehr schwierig ist, lange Zeit RNN zu verwenden, das auf langem basiert Kurzzeitgedächtnis (LSTM) [2] zur Sequenzmodellierung. LSTM lindert die Mängel der Gradientenexplosion und des Gradientenverschwindens bis zu einem gewissen Grad durch die Einführung eines Gating-Mechanismus. Die 2017 entwickelte Transformer neuronale Netzwerkarchitektur [3] verzichtet vollständig auf rekursive Berechnungen und nutzt den Selbstaufmerksamkeitsmechanismus, um ein Feed-Forward-Neuronales Netzwerk (FFNN) durchzuführen, das die Defekte der Gradientenexplosion besser löst und Verschwinden.

Lassen Sie uns die Vorteile von Transformer gegenüber RNN bei der Sequenzmodellierung intuitiv verstehen. Betrachten Sie zwei Positionen in der Sequenz, die n sind. Das Signal zwischen den beiden Positionen in der Vorwärts- und Rückwärtsberechnung und die Pfadlänge, die im neuronalen Netzwerk zurückgelegt wird, sind ein wichtiger Faktor beeinflusst die Fähigkeit des neuronalen Netzwerks, Abhängigkeiten über große Entfernungen zu lernen. RNN ist O(n) und Transformer ist

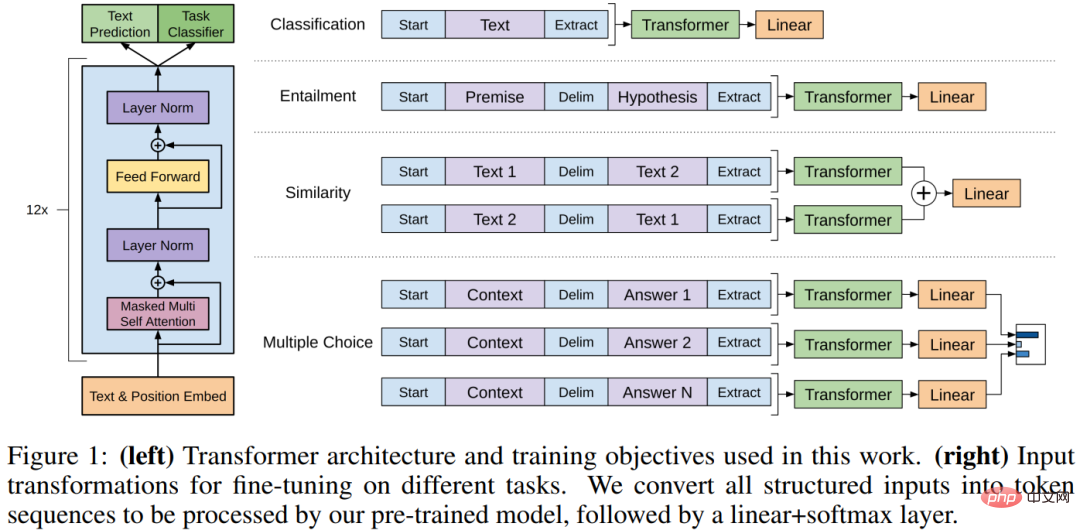

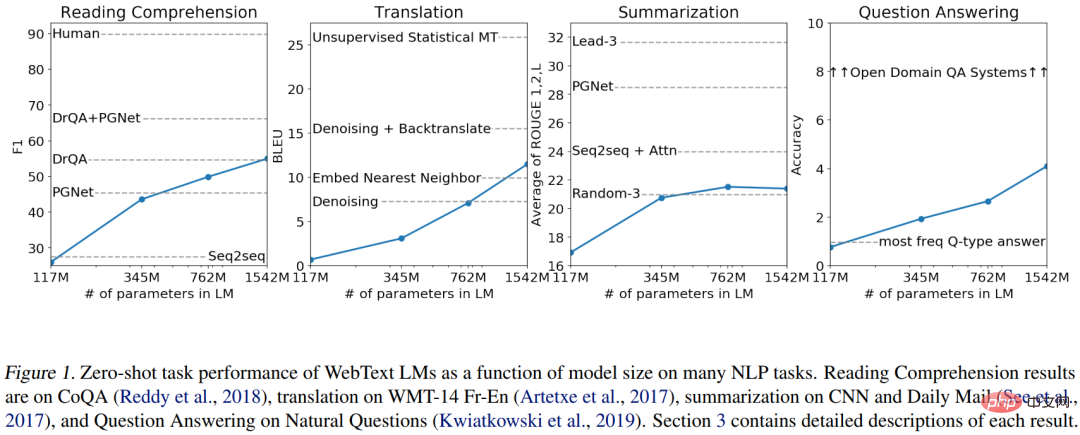

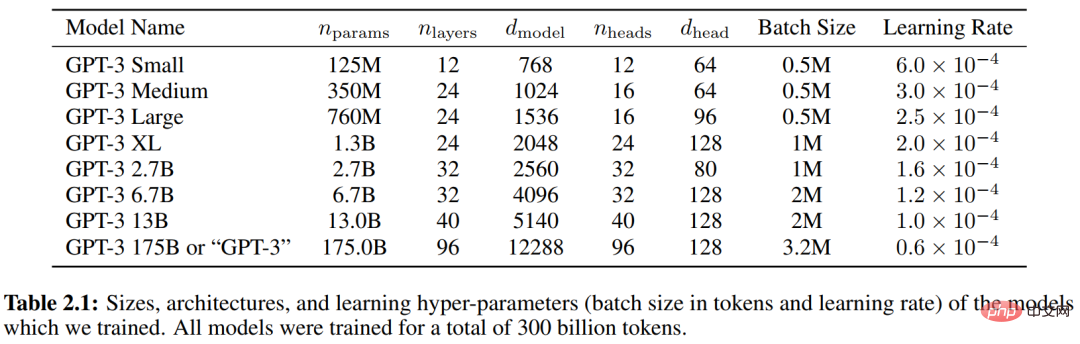

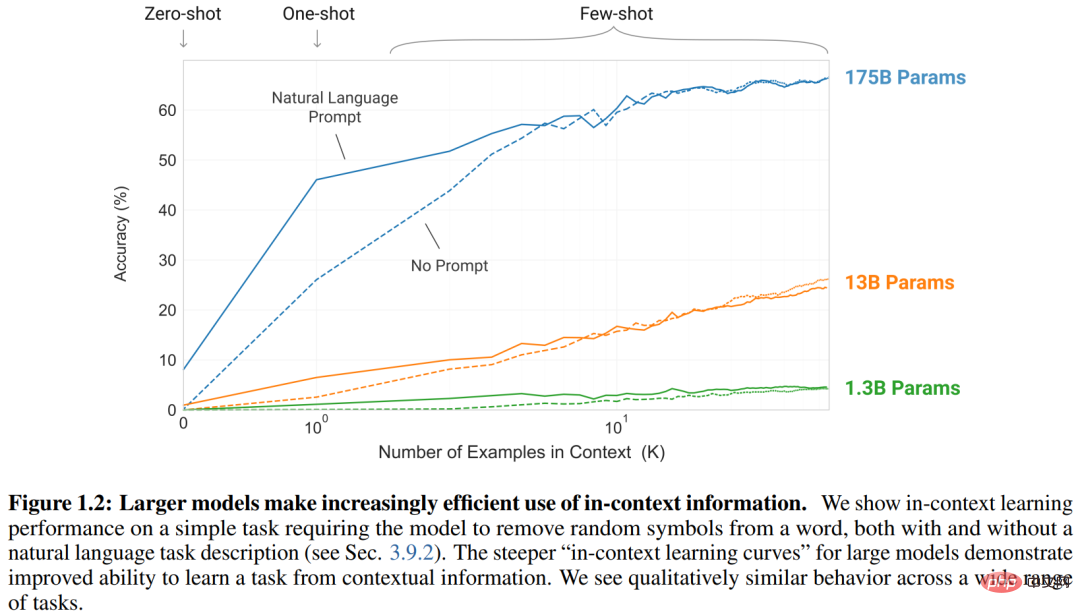

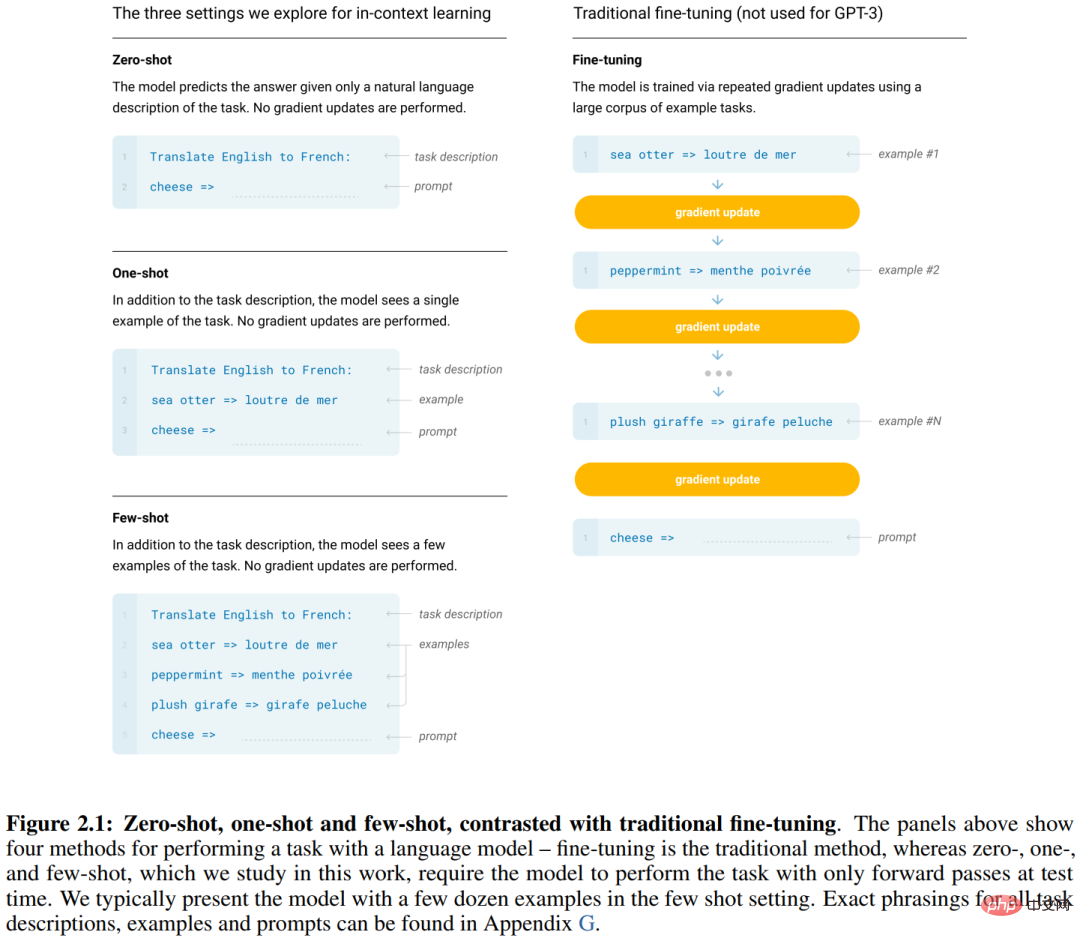

O(1). Leser, die diesen Abschnitt nicht verstehen, können ihn überspringen, ohne dass die Lektüre des folgenden Inhalts beeinträchtigt wird:-) 3. GPT-Sprachmodell und Vorschulung + Feinabstimmungstechnologie#🎜 🎜# Das Verstehen natürlicher Sprache umfasst eine Vielzahl unterschiedlicher Aufgaben, wie z. B. die Beantwortung von Fragen, die Bewertung der semantischen Ähnlichkeit, die Beurteilung von Textimplikationsbeziehungen, die Klassifizierung von Dokumenten, die maschinelle Übersetzung, das Leseverständnis, die Zusammenfassung usw. Es wurde festgestellt, dass man zunächst einen großen Transformer-LM (oft als Skelett bezeichnet) auf einer großen Menge an (unbeschriftetem) Text trainieren und dann dieses große Transformer-Netzwerk mithilfe der jeweiligen Annotationsdaten der nachgelagerten Aufgaben bei unterschiedlichen Aufgaben feinabstimmen kann Downstream-Aufgaben haben große Leistungsverbesserungen erzielt. Dies ist die sogenannte Pre-Training + Fine-Tuning-Technologie (Pre-Training + Fine-Tuning). BERT wurde 2018–2019 entwickelt [5]. GPT ist ein autoregressives Sprachmodell, das auf Transformer basiert, und BERT ist ein maskiertes Sprachmodell (MLM), das auf Transformer basiert. Wie im Originaltext von GPT heißt es: „Unsere Arbeit fällt im Großen und Ganzen in die Kategorie des halbüberwachten Lernens für natürliche Sprache.“ (unüberwachtes Vortraining) kombiniert mit überwachter Feinabstimmung (überwachte Feinabstimmung), ist eine Art halbüberwachtes Lernen , dessen Kern darin besteht, überwachtes Lernen und unüberwachtes Lernen gemeinsam durchzuführen. (aus GPT-Originaltext [4] „Verbesserung des Sprachverständnisses durch generatives Vortraining“ ) 4. GPT-2 und Zero-Sample-Prompt-Technologie#🎜🎜 # wir ein allgemeineres System aufbauen könnten, das viele Aufgaben bewältigen könnte und die Notwendigkeit eliminiert, Datensätze für jede Aufgabe manuell zu sammeln und zu kennzeichnen. Haben Sie im GPT-2-Originaltext von 2019 [6] mit einer so klaren Visionsaussage bereits den Geschmack einer Umstellung auf AGI gesehen? „Wir möchten zu allgemeineren Systemen übergehen, die viele Aufgaben ausführen können – schließlich ohne die Notwendigkeit, für jedes einzelne manuell einen Trainingsdatensatz zu erstellen und zu kennzeichnen.“ task angepasst werden , also Modellierung #🎜🎜 # werden alle in natürlicher Sprache als Symbolsequenzen ausgedrückt, läuft auf ein Sprachmodell hinaus # 🎜🎜# – Erzeugt unter Berücksichtigung des oben Gesagten rekursiv das nächste Symbol. Die Trainingsdaten verschiedener Aufgaben werden einheitlich in Form von Symbolsequenzen wie (in Französisch, Englischen Text, Französischen Text übersetzen)(Beantworten Sie die Frage , Dokument, Frage, Antwort) Unter ihnen wird Eingabeaufforderung genannt. Es gibt viele Methoden zur Aufforderung und es gibt viele verwandte Studien. In diesem Artikel werden sie nicht vorgestellt. Vor GPT-2 gab es Forschungen zu ähnlichen Ideen. GPT-2 brachte den Maßstab (unabhängig von der Größe des Trainingssatzes oder des Modells) auf ein neues Niveau. Es wurden Millionen von Webseiten gesammelt und große Datenmengen erstellt Set WebText (40 GB) wurde mit einer maximalen Parametergröße von 1,5 B trainiert und zeigte eine hervorragende Leistung bei mehreren Aufgaben unter Zero-Sample-Bedingungen ohne jegliche Parameter- oder Modellarchitekturänderung. Es ist erwähnenswert, dass der Ansatz von GPT-2 Multitasking-Lernen und Meta-Lernen vollständig verkörpert, was als intuitive Erklärung für die hervorragende Leistung von GPT-2 verwendet werden kann. (aus GPT-2-Originaltext [6] „Sprachmodelle sind unbeaufsichtigte Multitasking-Lernende“. GPT-2 trainierte eine Reihe von Transformer-LM mit Parametergrößen von 117 M, 345 M, 762 M und 1542 M 5. Die Abbildung zeigt die kontinuierliche Verbesserung der Leistung jeder Aufgabe [7] setzt die Vision und den technischen Weg von GPT-2 fort und hofft, die Mängel der aufgabenspezifischen Annotation und Feinabstimmung in jeder Aufgabe zu überwinden (es besteht immer noch Bedarf an aufgabenspezifischen Datensätzen und aufgabenspezifischen Feinabstimmungen). Tuning), in der Hoffnung, ein universelles System aufzubauen, das wie Menschen aussieht, weist der Artikel deutlich darauf hin, dass eine der Forschungsmotivationen darin besteht, Folgendes anzumerken: 「Menschen benötigen keine großen überwachten Datensätze, um die meisten Sprachaufgaben zu lernen – eine kurze Zusammenfassung Anweisung in natürlicher Sprache (z. B. „Bitte sagen Sie mir, ob dieser Satz etwas Fröhliches oder etwas Trauriges beschreibt“) oder höchstens eine kleine Anzahl von Demonstrationen (z. B. „Hier sind zwei Beispiele für mutiges Verhalten von Menschen; geben Sie bitte ein drittes Beispiel für Tapferkeit“) reicht oft aus, um einen Menschen in die Lage zu versetzen, eine neue Aufgabe zumindest mit einem angemessenen Maß an Kompetenz auszuführen um eine Vielzahl von Aufgaben wie Menschen auszuführen. GPT-3 wurde erneut auf ein neues Niveau skaliert Die Größe des Trainingssatzes beträgt 45 TB Text (vor der Bereinigung) und 570 GB (nach der Bereinigung). Die Größe von Transformer-LM ist im Vergleich zu GPT-2 gestiegen . 10 Mal und erreicht 175B (siehe Tabelle 2.1 unten). Der GPT-2-Artikel führte hauptsächlich Experimente zu Null-Schuss-Eingabeaufforderungssituationen durch, während GPT-3 Experimente zu Null-Schuss-, Einzel-Schuss- und Wenig-Schuss-Situationen durchführte, die zusammen als In-Context-Learning (Szenario-Lernen) bezeichnet werden. Die Anzahl der angegebenen Demonstrationen kann 0, 1 oder mehr sein, aber alle verfügen über Aufgabenbeschreibungen (Aufgabenbeschreibung), siehe Abbildung in Abbildung 2.1. Wie aus Abbildung 1.2 ersichtlich ist, steigt mit zunehmender Anzahl der Demonstrationsbeispiele die Leistung von Modellen unterschiedlicher Größe.

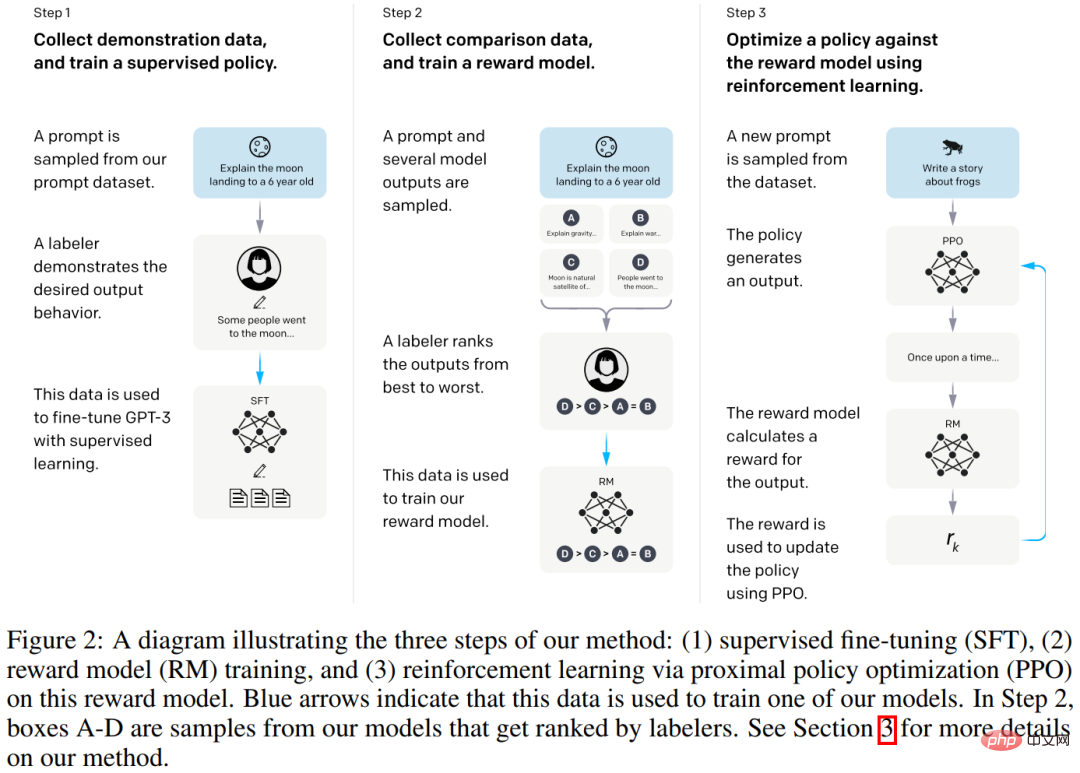

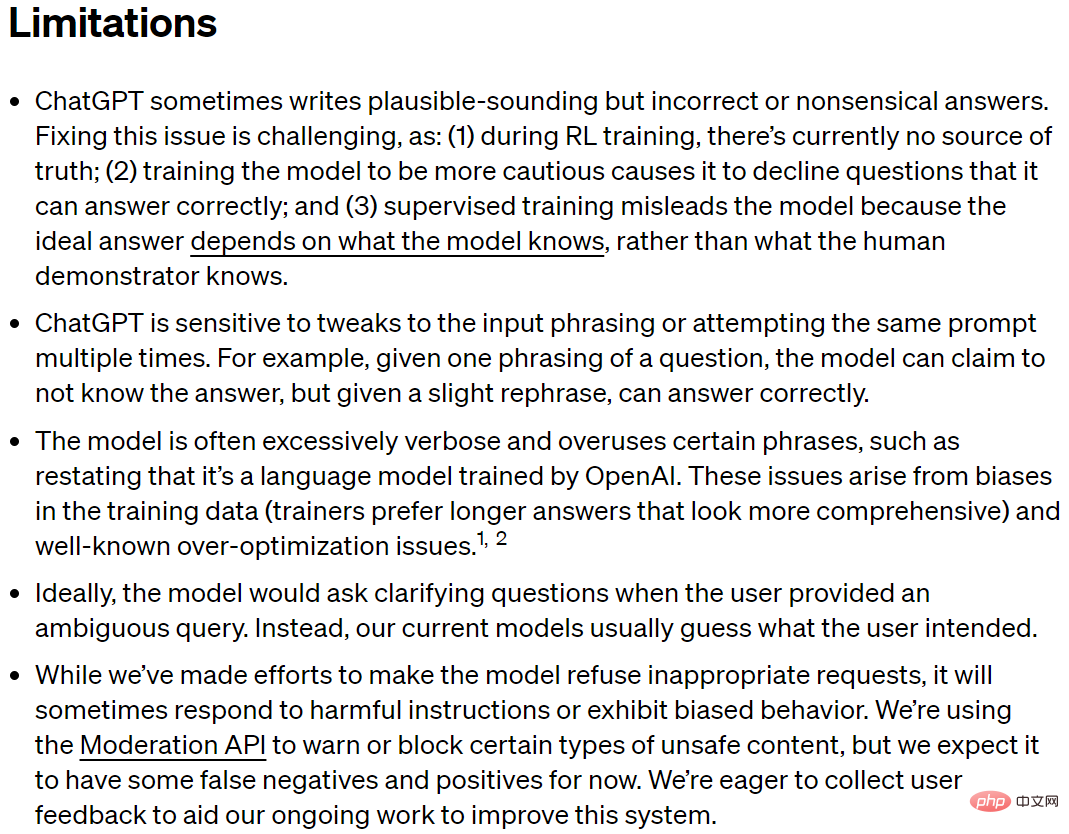

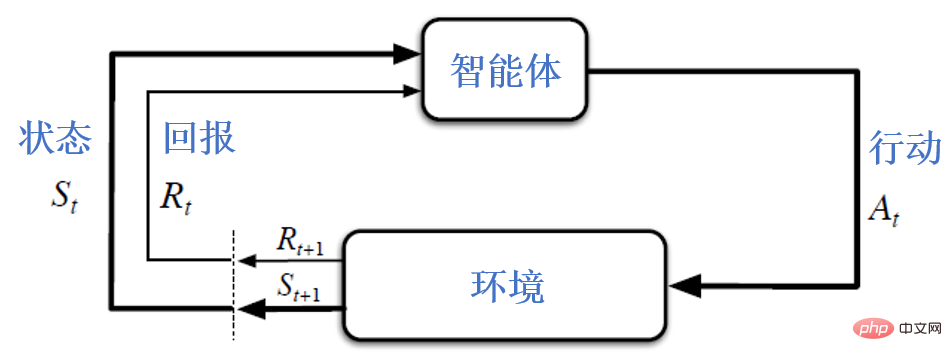

Die aktuelle Praxis des Large Language Model (LLM) zum Verständnis natürlicher Sprache besteht darin, das nächste Symbol rekursiv zu generieren. Ein Ausgangspunkt für die InstructGPT-Forschung ist die Überlegung, dass die Verbesserung der Sprachmodelle bei Mensch-Maschine-Gesprächen nicht unbedingt dazu führt, dass sie den Absichten der Benutzer besser folgen können. Große Sprachmodelle können auch unbefriedigendes Verhalten zeigen, z. B. Tatsachen fabrizieren, voreingenommenen und schädlichen Text generieren oder einfach nicht hilfreich für Benutzer sein. Das liegt daran, dass das Sprachmodellierungsziel, das von vielen neueren großen LMs verwendet wird, darin besteht, das nächste Token auf einer Webseite aus dem Internet vorherzusagen, was sich von dem Ziel unterscheidet, „den Anweisungen des Benutzers hilfreich und sicher zu folgen“. Daher sagen wir, dass das Ziel der Sprachmodellierung „fehlausgerichtet“ ist. Das Vermeiden dieser unerwarteten Verhaltensweisen ist besonders wichtig, wenn Sprachmodelle in Hunderten von Anwendungen bereitgestellt und verwendet werden. Im März 2022 demonstrierte die InstructGPT-Arbeit [8] eine Möglichkeit, Sprachmodelle durch Feinabstimmung auf der Grundlage menschlicher Rückmeldungen an die Benutzerabsichten für eine Reihe von Aufgaben anzupassen. Das resultierende Modell heißt InstructGPT. Konkret besteht der InstructGPT-Konstruktionsprozess, wie in Abbildung 2 unten dargestellt, aus drei Schritten: Schritt 1: Demonstrationsdaten sammeln (13.000 Datenelemente), überwachtes Lernen verwenden Feinabstimmung Schritt 2: Sammeln Sie Vergleichsdaten (33.000 Daten) und trainieren Sie ein Belohnungsmodell (Belohnungsmodell Schritt 3: Sammeln Sie 31.000 Trainingsdaten und optimieren Sie mithilfe von Reinforcement Learning die Strategie für das Belohnungsmodell, genannt „Reinforcement Learning from Human Feedback“ (Reinforcement Learning from Human Feedback, RLHF). Konkret kommt eine Policy-Optimierungsmethode namens PPO zum Einsatz [9]. Um Demonstrationsdaten und Vergleichsdaten zu sammeln, wurden 40 ausgelagerte Annotatoren verwendet. (aus dem ursprünglichen IntructGPT-Text [8] „Sprachmodelle trainieren, um Anweisungen mit menschlichem Feedback zu befolgen“) Im November 2022 veröffentlichte OpenAI das ChatGPT-Modell [10], das im Grunde genommen ist Das InstructGPT-Modell verwendet dieselbe dreistufige Trainingsmethode, es wird jedoch ein größerer Datenumfang für das Modelltraining und den Systemaufbau gesammelt. Zusammenfassung: Aus der Sprachmodellforschung, Transformer-Neuronale-Netzwerk-Architektur, GPT-Sprachmodell und Vortraining + Feinabstimmung, GPT-2 und Zero-Shot-Prompting, GPT-3 und Szenario-Lernen (im Kontext lernen). ), entwickelt zur InstructGPT-, ChatGPT- und RLHF-Technologie. Rückblickend scheint es ein relativ klarer technischer Weg zu sein, aber tatsächlich gibt es auch andere Arten von Sprachmodellen (z. B. energiebasierte Sprachmodelle [11]), andere Arten von neuronalen Netzwerkarchitektur (z. B. Zustandsraummodell [12]), andere Arten von Vortrainingsmethoden (z. B. basierend auf latenten Variablenmodellen [13]), andere Methoden des verstärkenden Lernens (z. B. basierend auf Benutzeremulatoren [14]) usw ., entwickeln sich ständig weiter, die Forschung an neuen Methoden hat nie aufgehört, sich gegenseitig zu inspirieren und zu fördern und einen endlosen Strom zu bilden, der zur allgemeinen künstlichen Intelligenz führt. Ein sehr wichtiger Punkt in den sechs Teilen von ChatGPT ist der „Skaleneffekt“, der allgemein als Ästhetik der Gewalt bekannt ist. Wenn die Route grundsätzlich korrekt ist, ist die Vergrößerung des Maßstabs eine gute Möglichkeit, die Leistung zu verbessern. Quantitative Änderungen führen zu qualitativen Änderungen, quantitative Änderungen führen jedoch möglicherweise nicht zu qualitativen Änderungen, wenn es Mängel in der Route gibt. Lassen Sie uns über die Mängel von ChatGPT sprechen. 02 Mängel von ChatGPT Einschränkungen. Im Gegenteil, es ist nicht strikt, über Mängel zu sprechen, und ist nicht förderlich für ein umfassendes Verständnis einer Technologie. Es kann die Öffentlichkeit irreführen, den Eliza-Effekt fördern und sogar zu falschen Urteilen führen.

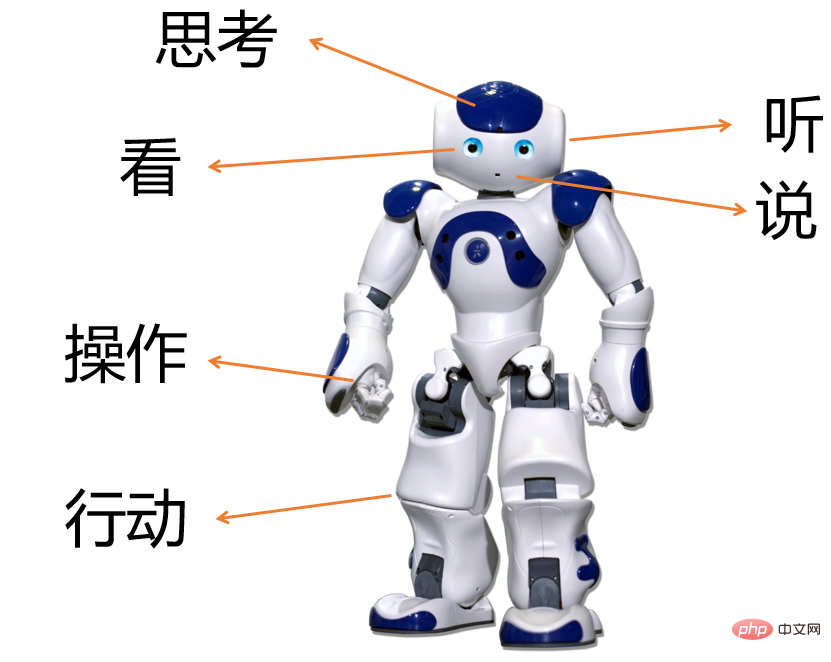

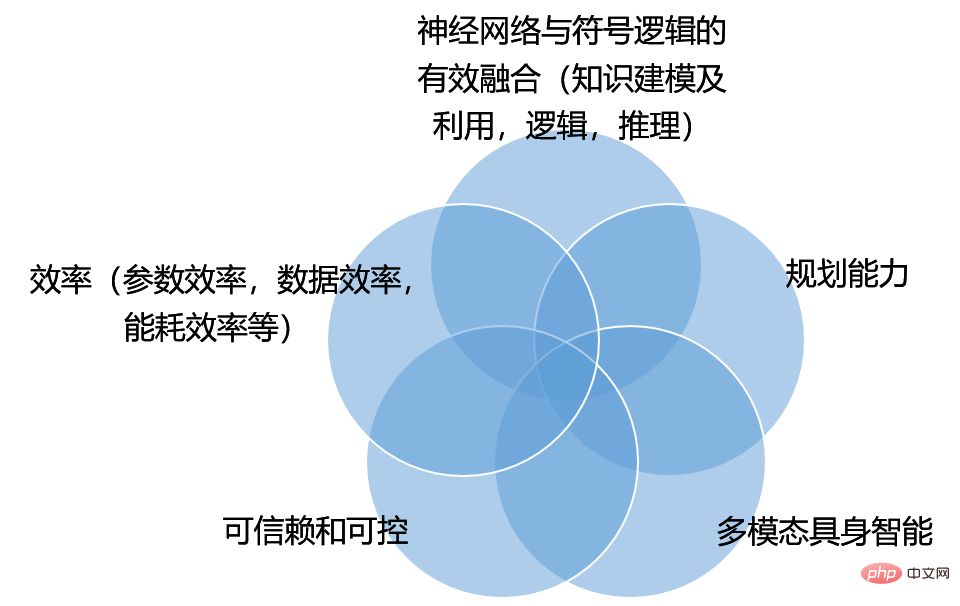

ChatGPT-Mängel (Screenshot aus ChatGPT-Originaltext [10]) L1. ChatGPT schreibt manchmal Antworten, die vernünftig erscheinen, aber falsch oder lächerlich L2. ChatGPT reagiert empfindlich auf Anpassungen des Eingabewortlauts oder auf das mehrmalige Ausprobieren derselben Eingabeaufforderung . L3. Die Generation von ChatGPT, ist oft zu ausführlich und verwendet bestimmte Ausdrücke zu häufig, , wie zum Beispiel die Wiederholung, dass es sich um ein von OpenAI trainiertes Sprachmodell handelt. L4 Wenn ein Benutzer eine mehrdeutige Anfrage stellt, sollte das Modell im Idealfall klärende Fragen stellen. Stattdessen erraten aktuelle Modelle häufig die Absicht des Benutzers. L5 Obwohl ChatGPT hart daran gearbeitet hat, dass das Model unangemessene Anfragen ablehnt, kann es dennoch manchmal auf schädliche Anweisungen reagieren oder voreingenommenes Verhalten zeigen #🎜🎜 # . Abbildung 4: ChatGPT-Beispiel über Kuheier und Eier #🎜🎜 # 03 Herausforderung in Richtung AGI Wenn wir über AGI diskutieren, müssen wir uns von der Beschränkung lösen, uns nur auf die Verarbeitung natürlicher Sprache zu konzentrieren, und die Forschung und Technologie im Bereich der künstlichen Intelligenz aus einer breiteren Perspektive betrachten. In Anlehnung an die klassische Arbeit zur künstlichen Intelligenz [15] bezieht sich künstliche Intelligenz auf die Forschung und das Design intelligenter Agenten. INTELLIGENT Und führen Sie Maßnahmen durch, um die Erfolgschancen zu maximieren: Maximieren Sie den erwarteten Nutzen (Utility) oder maximieren Sie die erwartete Rendite (Return), wie in der Abbildung unten dargestellt. Aufmerksame Leser werden feststellen, dass die folgende Abbildung häufig auch als Rahmendiagramm für verstärkendes Lernen verwendet wird. Tatsächlich gibt es eine ähnliche Aussage in [15]: „Reinforcement Learning könnte als die gesamte KI umfassend betrachtet werden“ (Reinforcement Learning kann als die gesamte künstliche Intelligenz betrachtet werden). Lassen Sie uns unter Berücksichtigung dieser Konzepte die Mängel von ChatGPT verstehen. Abbildung 6: Die Interaktion zwischen dem Agenten und der Umgebung, oft als Rahmendiagramm verwendet für verstärkendes Lernen [16] 1. ChatGPT fabriziert (gibt ernsthaft falsche Informationen) in Bezug auf die Wissensmodellierung und -nutzung Es gibt offensichtliche Mängel. Dies entspricht im Wesentlichen dem zuvor eingeführten L1, was aus dem vorherigen Beispiel deutlich hervorgeht. Was wir Wissen nennen, umfasst gesundes Menschenverstandswissen, Fachwissen und Echtzeitinformationen. Aus der Sicht des gesunden Menschenverstandes zeigte ChatGPT beispielsweise zunächst, dass es nicht wusste, dass Kühe Säugetiere sind und keine Eier legen können. Den Echtzeitinformationen nach zu urteilen, handelt es sich bei ChatGPT im Wesentlichen um ein groß angelegtes autoregressives Sprachmodell, das auf der Transformer-Architektur basiert. Das erlernte Wissen beschränkt sich auf seine Trainingsdaten und seine Frist endet im Jahr 2021. Leser können ChatGPT selbst ausprobieren und die diesbezüglichen Mängel entdecken. Die oben genannten Mängel spiegeln auf einer tieferen Ebene den langjährigen Konnektionismus(Konnektionismus) und # in der Geschichte der künstlichen Intelligenz wider 🎜🎜#Symbolismus Der Konnektionismus glaubt, dass Wissen in den Gewichten neuronaler Netze vergraben ist, und dass das Training eines neuronalen Netzes zur Anpassung seiner Gewichte es ihm ermöglicht, Wissen zu erlernen. Die Symbolik befürwortet, dass „Wissen“ durch symbolische Systeme wie relationale Datenbanken, Wissensgraphen, mathematische Physik und anderes Fachwissen sowie mathematische Logik organisiert wird. Die beiden Denktrends befruchten sich auch gegenseitig, wie zum Beispiel generatives Dialogsystem basierend auf neuronalen Netzen, verbessert durch den Abruf aus der Wissensdatenbank [17]; Denken, das die Argumentationsfähigkeiten großer Sprache fördert Modelle (LLM) Chain (CoT, Chain of Thought) Methode [18]. 2. ChatGPT weist offensichtliche Mängel bei der mehrrundigen Dialoginteraktion auf und es mangelt an Planungsfähigkeiten. P(Ausgabe | Eingabe) für die Vorhersage modelliert und keine Planung durchgeführt. , die die bedingte Wahrscheinlichkeit des Auftretens von Sprachsymbolen maximieren P(Ausgabe | Eingabe). InstructGPT ist der Ansicht, dass das System den Absichten des Benutzers folgen sollte, und verwendet die RLHF-Technologie (Reinforcement Learning from Human Feedback), um dem System eine Ausgabe zu ermöglichen, die an menschlichen Fragen ausgerichtet ist, was die Probleme, die durch überwachtes Lernen verursacht werden, ohne GPT-3-Fehlausrichtung zu planen, teilweise lindert Ausgabe. Die weitere Verbesserung der Planungsmöglichkeiten zur Maximierung des erwarteten Nutzens Was ist also der Nutzen eines Mensch-Computer-Interaktionssystems? Das InstructGPT-Papier [8] hat diesen Punkt in drei Dimensionen diskutiert: hilfreich, ehrlich und harmlos. „Wir möchten, dass Sprachmodelle hilfreich sind (sie sollen Benutzern helfen, ihre Aufgaben zu lösen), ehrlich (sie sollten keine Informationen verfälschen oder Benutzer irreführen) und harmlos sind (sie sollten weder Menschen noch der Umwelt physischen, psychischen oder sozialen Schaden zufügen). ) ). „Die spezifischen Implementierungsmethoden müssen jedoch weiter untersucht werden, anstatt bei der RLHF-Technologie stehen zu bleiben.“ 3. Das ChatGPT-Verhalten ist unkontrollierbar. Menschen haben sokratische Weisheit, das heißt: „Sie wissen, dass sie es nicht wissen.“ Das ist genau das, was dem aktuellen tiefen neuronalen Netzwerksystem fehlt. Sie wissen nicht, dass sie falsch liegen. Die meisten heutigen neuronalen Netzwerksysteme sind zu selbstsicher und melden Fehler nicht an den Menschen. Sie scheinen immer noch überraschend hoch zu sein, wenn sie Fehler machen, was es schwierig macht, ihnen zu vertrauen und sie zu kontrollieren. „Vertrauenswürdig und kontrollierbar“ wird eine große Herausforderung für AGI sein. 4. Die Effizienz von ChatGPT ist unzureichend. ChatGPT hat diesen Punkt in seiner Mängelrüge nicht berücksichtigt. Effizienz umfasst Parametereffizienz, Dateneffizienz, Energieverbrauchseffizienz usw.. ChatGPT hat durch die Verwendung extrem großer Datenmengen, das Training extrem großer Modelle und die kontinuierliche Vergrößerung seines Umfangs eine herausragende Leistung erzielt. Stellt ChatGPT jedoch im gleichen Maßstab (gleiche Anzahl an Modellparametern, gleiche Menge oder Kosten der Datenkennzeichnung, gleiche Rechenleistung, gleicher Energieverbrauch) die fortschrittlichste Technologie dar? Die Antwort lautet oft nein. Jüngste Untersuchungen haben beispielsweise ergeben [19], dass das LLaMA-Modell mit 13B-Parametern das 175B-GPT-3-Modell in mehreren Benchmark-Tests übertraf, sodass das 13B-LLaMA-Modell eine bessere Parametereffizienz aufweist. Unsere eigene aktuelle Arbeit zeigt auch, dass ein gut gestaltetes Dialogmodell zum Abrufen von Wissen nur 100 Millionen verwendet und die Leistung die eines großen 1B-Modells deutlich übertrifft. Die Effizienz des Energieverbrauchs ist leicht zu verstehen. Schauen wir uns die Dateneffizienz an. Der aktuelle Aufbau intelligenter Systeme steckt im Paradigma des überwachten Lernens fest und basiert auf einer großen Anzahl manueller Anmerkungen, was zu einer geringen Dateneffizienz führt. Basierend auf groß angelegten Sprachmodellen, die auf Autoregression basieren, wurde festgestellt, dass sie zunächst auf einer großen Textmenge (ohne Kennzeichnung) trainiert werden können und dann Feinabstimmungs- oder Eingabeaufforderungstechnologien verwenden, was die Mängel einer geringen Dateneffizienz teilweise lindert der aktuellen Deep-Learning-Technologie, erfordert aber dennoch aufgabenbezogene Anmerkungen. Je größer das Modell, desto höher sind die Kennzeichnungsanforderungen. Wie man gekennzeichnete und nicht gekennzeichnete Daten noch effizienter und gemeinsam nutzen kann ist eine Herausforderung, um Dateneffizienz zu erreichen. 5. Multimodale verkörperte Intelligenz ist ein wichtiger Inhalt bei der Erforschung von AGI. ChatGPT beschränkt sich auf die Texteingabe und -ausgabe, und die vielen Fehler, die es macht, veranschaulichen auch den gravierenden Mangel an Semantik, Wissen und Kausalschlussfolgerungen. Die Bedeutung von Wörtern scheint eher in ihrem statistischen gemeinsamen Vorkommen als in ihrer realen Grundlage zu liegen. Selbst wenn zukünftige Sprachmodelle immer größer werden, sind sie in Bezug auf einige grundlegende physikalische Aspekte des gesunden Menschenverstands immer noch unzureichend. Intelligenz ist weit mehr als nur Sprachfähigkeit. Das Grundelement der biologischen Intelligenz liegt in der Fähigkeit von Tieren zur sensorisch-motorischen Interaktion[20]. Intelligente Maschinen der Zukunft haben möglicherweise nicht unbedingt eine menschliche Form, aber die multimodale Interaktion zwischen der Maschine und der Umgebung durch den Körper beim Zuhören, Sprechen, Lesen, Schreiben, Denken, Manipulieren von Objekten, Handeln usw. wird dies erheblich fördern Die Entwicklung maschineller Intelligenz wird auch dabei helfen, die Grenzen einer einzelnen Textmodalität zu überwinden und Menschen besser zu helfen. Zusammenfassung: Aus linguistischer Sicht umfasst Sprachwissen die Struktur und Eigenschaften von Wörtern – Morphologie und Wortschatz (Lexikon), wie Wörter Phrasen und Sätze bilden – Syntax, die Bedeutung von Morphemen, Wörtern, Phrasen, Sätze und Diskurs – Semantik [21]. ChatGPT hat durch ein sehr großes Modell beträchtliche Sprachkenntnisse (insbesondere Kenntnisse unterhalb der semantischen Ebene) erlernt, verfügt über ein gewisses Sprachverständnis und kann fließende Sätze generieren, es gibt jedoch auch offensichtliche Mängel: Angesichts dieser Mängel haben wir mehrere Herausforderungen geklärt, mit denen ChatGPT und die zukünftige Entwicklung hin zu allgemeiner künstlicher Intelligenz (AGI) konfrontiert sind, wie in Abbildung 8 dargestellt, und außerdem auf mehrere wichtige Forschungsinhalte hingewiesen. Es ist hervorzuheben, dass die Forschungsbereiche der einzelnen Bereiche nicht isoliert sind, sondern sich überschneiden. Bei der Untersuchung von Vertrauenswürdigkeit und Kontrollierbarkeit wird beispielsweise gehofft, dass die Systemausgabe den sozialen Normen entspricht und wie diese soziale Norm im Nutzen des Systems widergespiegelt werden kann, damit die Ausgabe der Systemplanung den sozialen Normen entsprechen kann. Daher gibt es Überschneidungen zwischen der Forschung zur Systemsteuerbarkeit und der Forschung zur Verbesserung der Systemplanungsfähigkeiten. Ein weiteres Beispiel: Wie lässt sich Wissen in systematische Planung und Entscheidungsfindung integrieren? Abbildung 8: Herausforderungen für AGI ChatGPT ist ein wichtiges Ereignis in der Forschung im Bereich der künstlichen Intelligenz. Es ist sehr wichtig, ein genaues Verständnis seiner Fortschritte, Mängel und zukünftigen Herausforderungen in Bezug auf AGI zu haben. Wir glauben, dass wir durch die Suche nach Wahrheit, Pragmatismus und ständige Innovation die Entwicklung der künstlichen Intelligenz auf ein neues Niveau bringen können. Wir heißen jeden willkommen, uns zu diskutieren und zu korrigieren, vielen Dank!

ein solches Modell

ein solches Modell  organisiert. Zum Beispiel:

organisiert. Zum Beispiel:  Aufgabe

Aufgabe

Wir werden die Mängel in den folgenden fünf Punkten zusammenfassen

. Diese fünf Punkte stellen im Grunde auch die Herausforderungen dar, vor denen ChatGPT in Zukunft in Richtung allgemeiner künstlicher Intelligenz (AGI) steht. Es handelt sich um wichtige wissenschaftliche Fragen und Schlüsseltechnologien, die in Richtung AGI dringend gelöst werden müssen. Es ist erwähnenswert, dass die Perspektive dieses Artikels nicht darin besteht, Mängel und Herausforderungen aus der Perspektive der Aufgaben zu analysieren, sondern vielmehr aus der Perspektive gemeinsamer Probleme verschiedener Aufgaben. Wenn Aufgaben Zeilen und Probleme Spalten sind, dann ist unsere Perspektive die Analyse nach Spalten. Zeile für Zeile kann auch eine sehr gute Analyse und Beurteilung liefern.

Abbildung 7

04 Fazit

Das obige ist der detaillierte Inhalt vonEin exklusives Interview mit Professor Ou Zhijian von der Tsinghua-Universität, das eine ausführliche Analyse der Aura von ChatGPT und zukünftiger Herausforderungen bietet!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

ChatGPT-Registrierung

ChatGPT-Registrierung

Inländische kostenlose ChatGPT-Enzyklopädie

Inländische kostenlose ChatGPT-Enzyklopädie

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

So installieren Sie ChatGPT auf einem Mobiltelefon

So installieren Sie ChatGPT auf einem Mobiltelefon

Kann Chatgpt in China verwendet werden?

Kann Chatgpt in China verwendet werden?

Pycharm-Methode zum Suchen von Dateien

Pycharm-Methode zum Suchen von Dateien

Wie man mit Laptop-Verzögerungen und langsamer Reaktion umgeht

Wie man mit Laptop-Verzögerungen und langsamer Reaktion umgeht

Was ist die C-Programmiersoftware?

Was ist die C-Programmiersoftware?