Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

OpenAI enthüllt ChatGPT-Upgrade-Plan: Alle gefundenen Fehler werden behoben

OpenAI enthüllt ChatGPT-Upgrade-Plan: Alle gefundenen Fehler werden behoben

OpenAI enthüllt ChatGPT-Upgrade-Plan: Alle gefundenen Fehler werden behoben

Die Mission von OpenAI besteht darin, sicherzustellen, dass künstliche allgemeine Intelligenz (AGI) der gesamten Menschheit zugute kommt. Daher denken wir viel über das Verhalten der KI-Systeme nach, die wir bei der Implementierung von AGI erstellen, und über die Art und Weise, wie dieses Verhalten bestimmt wird.

Seit wir ChatGPT eingeführt haben, haben Benutzer Inhalte geteilt, die ihrer Meinung nach politisch voreingenommen oder anderweitig anstößig sind. In vielen Fällen glauben wir, dass die geäußerten Bedenken berechtigt sind, und identifizieren echte Einschränkungen unseres Systems, die wir beheben möchten. Aber gleichzeitig haben wir auch einige Missverständnisse darüber gesehen, wie unsere Systeme und Richtlinien zusammenarbeiten, um die Ausgabe von ChatGPT zu gestalten.

Die Hauptpunkte des Blogs sind wie folgt zusammengefasst:

- Wie das Verhalten von ChatGPT wird gebildet;# 🎜🎜#

- Wie wir planen, das Standardverhalten von ChatGPT zu verbessern;

- Wir wollen um mehr Systemanpassungen zu ermöglichen;# 🎜🎜# Wir werden hart daran arbeiten, der Öffentlichkeit mehr Meinungen zu unseren Entscheidungen zu geben.

- Unsere oberste Priorität

Zum jetzigen Zeitpunkt ist der Prozess unvollständig. Manchmal erfüllt der Feinabstimmungsprozess nicht sowohl unsere Absicht (ein sicheres, nützliches Werkzeug zu produzieren) als auch die Absicht des Benutzers (eine nützliche Ausgabe als Reaktion auf eine bestimmte Eingabe zu erhalten). Da KI-Systeme immer leistungsfähiger werden, wird die Verbesserung der Art und Weise, wie wir KI-Systeme an menschlichen Werten ausrichten, für unser Unternehmen oberste Priorität.

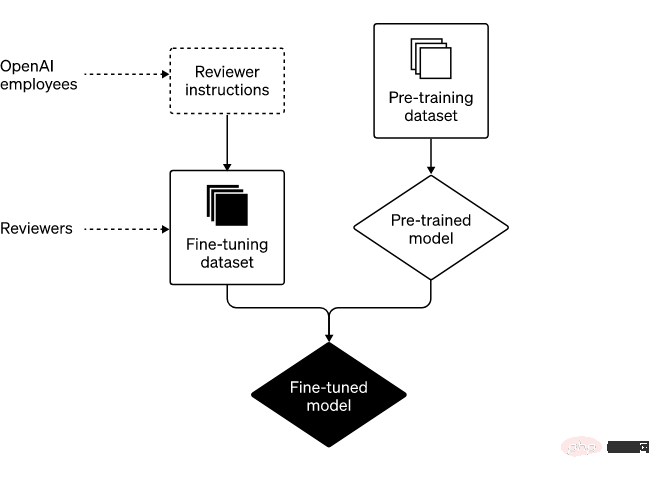

Zwei Hauptschritte: Vorschulung und Feinabstimmung

Die beiden Hauptschritte zum Aufbau von ChatGPT sind wie folgt:# 🎜🎜#

Die Rolle der Prüfer und die Strategie von OpenAI bei der Systementwicklung

In einigen Fällen können wir unseren Prüfern Hinweise zu bestimmten Ausgabearten geben (z. B. „Anfragen wegen illegaler Inhalte nicht abschließen“). In anderen Fällen sind die Ratschläge, die wir den Gutachtern geben, auf höherer Ebene (z. B. „Vermeiden Sie es, bei kontroversen Themen Partei zu ergreifen“). Wichtig ist, dass unsere Arbeit mit Gutachtern keine einmalige Angelegenheit ist, sondern eine dauerhafte Beziehung. Während dieser Beziehung haben wir viel von ihrem Fachwissen gelernt.

Ein großer Teil des Feinabstimmungsprozesses besteht darin, eine starke Feedbackschleife mit unseren Prüfern aufrechtzuerhalten, die wöchentliche Treffen umfasst, um eventuelle Fragen zu beantworten oder unsere Leitlinien weiter zu klären. Durch diesen iterativen Feedbackprozess trainieren wir unsere Modelle, um sie mit der Zeit immer besser zu machen.

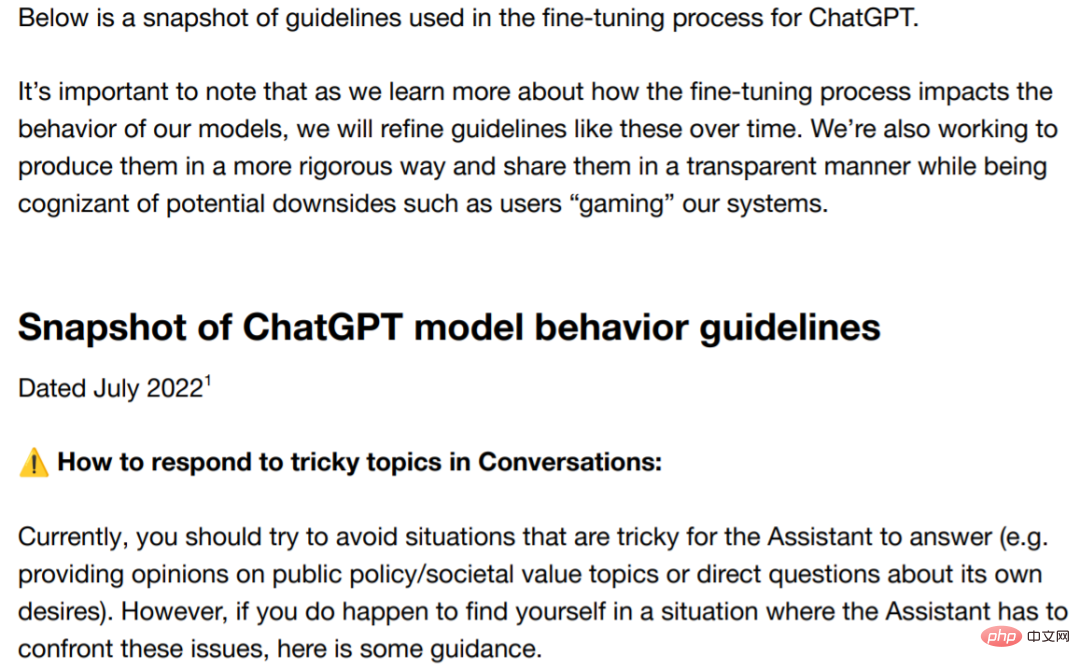

Bekämpfung von Verzerrungen

Bei KI-Systemen gibt es das Problem der Verzerrung schon seit langem, und viele Forscher haben Bedenken darüber geäußert. Wir sind fest entschlossen, dieses Problem anzugehen und unsere Absichten und Fortschritte öffentlich zu machen. Um die Fortschritte vor Ort zum Ausdruck zu bringen, geben wir hier einige Hinweise zu Themen im Zusammenhang mit Politik und Kontroversen. In den Leitlinien heißt es eindeutig, dass Gutachter keine politische Gruppe bevorzugen sollten. Dennoch kann es zu Voreingenommenheit kommen.

Adresse der Richtlinien: https://cdn.openai.com/snapshot-of-chatgpt-model-behavior-guidelines.pdf

Obwohl es immer Unterschiede geben wird, hoffen wir, dass es so ist Dieser Blog wird Ihnen zusammen mit einigen Anleitungen ein tieferes Verständnis dafür vermitteln, wie wir über Voreingenommenheit denken. Wir sind der festen Überzeugung, dass Technologieunternehmen verantwortungsbewusst Richtlinien entwickeln müssen, die einer Überprüfung standhalten.

Wir arbeiten ständig daran, die Klarheit dieser Richtlinien zu verbessern, und werden den Prüfern auf der Grundlage dessen, was wir bisher aus der ChatGPT-Veröffentlichung gelernt haben, Informationen über potenzielle Fallstricke und Herausforderungen im Zusammenhang mit Voreingenommenheit sowie kontroverse Daten bereitstellen und Eine klarere Beschreibung des Themas. Darüber hinaus arbeiten wir im Rahmen einer laufenden Transparenzinitiative daran, aggregierte Statistiken über Prüfer auf eine Weise weiterzugeben, die nicht gegen Datenschutzregeln und -normen verstößt, da dies eine weitere Quelle potenzieller Verzerrungen bei der Systemausgabe darstellt.

Aufbauend auf Fortschritten wie Regelbelohnungen und Constitutional AI (ursprüngliche Methode der künstlichen Intelligenz) untersuchen wir derzeit, wie wir den Feinabstimmungsprozess leichter verständlich und kontrollierbar machen können.

Zukünftige Richtungen: Systembausteine

Um unsere Mission zu erreichen, setzen wir uns dafür ein, dass ein breiteres Spektrum von Menschen KI und AGI nutzen und davon profitieren kann. Wir glauben, dass zum Erreichen dieser Ziele mindestens drei Bausteine erforderlich sind

1. Standardverhalten verbessern: Wir hoffen, dass das KI-System sofort einsetzbar ist, damit möglichst viele Benutzer es finden dass unser KI-System tatsächlich nützlich ist und dass wir von der Technologie ihre Werte verstehen und respektieren.

Zu diesem Zweck haben wir in Forschung und Technik investiert, um die subtilen Vorurteile zu reduzieren, die ChatGPT bei der Reaktion auf verschiedene Eingaben hat. In einigen Fällen verweigert ChatGPT die Ausgabe von Inhalten, die es ausgeben sollte, und in einigen Fällen macht es das Gegenteil und gibt Inhalte aus, die es nicht ausgeben sollte. Wir glauben, dass ChatGPT in beiden Bereichen Verbesserungspotenzial hat.

Darüber hinaus gibt es Raum für Verbesserungen in anderen Aspekten unseres KI-Systems, wie zum Beispiel, dass das System häufig „Dinge erfindet“. Für dieses Problem ist das Feedback der Benutzer äußerst wertvoll, um ChatGPT zu verbessern.

2. Definieren Sie den KI-Wert im Großen und Ganzen: Wir glauben, dass KI ein Werkzeug sein sollte, das für den Einzelnen nützlich ist, sodass jeder Benutzer es mit einigen Einschränkungen anpassen kann. Auf dieser Grundlage entwickeln wir ein Upgrade für ChatGPT, um Benutzern eine einfache Anpassung des Verhaltens zu ermöglichen.

Das bedeutet auch, dass Ergebnisse, mit denen einige Menschen überhaupt nicht einverstanden sind, für andere sichtbar sind. Dieses Gleichgewicht zu finden, ist eine große Herausforderung, denn eine extreme Anpassung kann zu einem böswilligen Einsatz unserer Technologie führen und die Leistung der KI blind steigern.

Daher gibt es immer einige Einschränkungen im Systemverhalten. Die Herausforderung besteht darin, diese Grenzen zu definieren. Wenn wir versuchen, all diese Entscheidungen selbst zu treffen oder wenn wir versuchen, ein einziges, monolithisches KI-System zu entwickeln, werden wir unser Versprechen, eine übermäßige Machtkonzentration zu vermeiden, nicht einhalten.

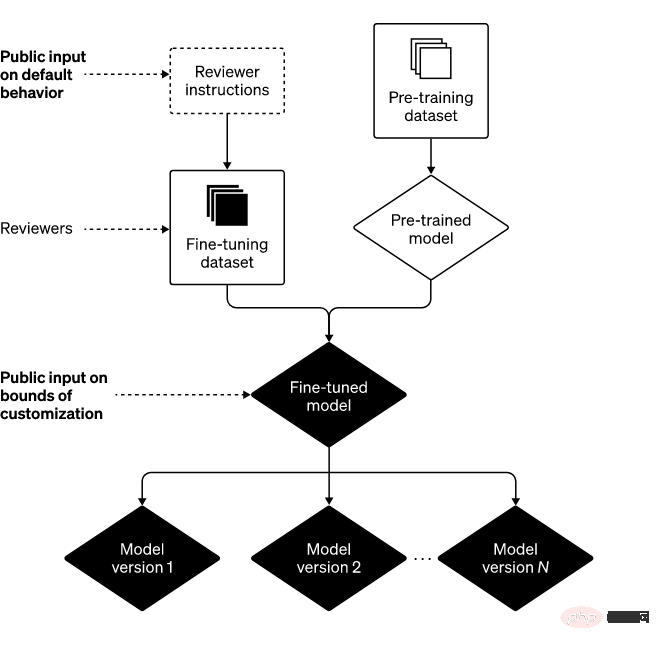

3. Öffentliche Eingaben (Standardeinstellungen und harte Grenzen): Eine Möglichkeit, eine übermäßige Machtkonzentration zu vermeiden, besteht darin, Personen, die Systeme wie ChatGPT verwenden oder von ihnen betroffen sind, zu ermöglichen, ihrerseits Einfluss auf die Systemregeln zu nehmen.

Wir glauben, dass Vorgaben und harte Grenzen zentralisiert werden sollten, und obwohl dies schwierig umzusetzen ist, ist es unser Ziel, so viele Perspektiven wie möglich einzubeziehen. Als Ausgangspunkt suchen wir externen Input in unsere Technologie in Form von „Red Teaming“. Wir haben vor kurzem auch damit begonnen, öffentliche Meinungen zur KI-Bildung einzuholen (ein besonders wichtiger Kontext, in dem wir uns engagieren).

Fazit

Durch die Kombination der drei oben genannten Bausteine können wir das folgende Framework erstellen

Manchmal machen wir Fehler, aber wenn wir Fehler machen, lernen wir und iterieren an Modellen und Systemen. Darüber hinaus möchten wir den ChatGPT-Benutzern und anderen dafür danken, dass sie uns aufmerksam und wachsam gehalten haben, und wir freuen uns, in den kommenden Monaten mehr über unsere Arbeit in diesen drei Bereichen zu berichten.

Das obige ist der detaillierte Inhalt vonOpenAI enthüllt ChatGPT-Upgrade-Plan: Alle gefundenen Fehler werden behoben. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1384

1384

52

52

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek:

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Docker verwendet Linux -Kernel -Funktionen, um eine effiziente und isolierte Anwendungsumgebung zu bieten. Sein Arbeitsprinzip lautet wie folgt: 1. Der Spiegel wird als schreibgeschützte Vorlage verwendet, die alles enthält, was Sie für die Ausführung der Anwendung benötigen. 2. Das Union File System (UnionFS) stapelt mehrere Dateisysteme, speichert nur die Unterschiede, speichert Platz und beschleunigt. 3. Der Daemon verwaltet die Spiegel und Container, und der Kunde verwendet sie für die Interaktion. 4. Namespaces und CGroups implementieren Container -Isolation und Ressourcenbeschränkungen; 5. Mehrere Netzwerkmodi unterstützen die Containerverbindung. Nur wenn Sie diese Kernkonzepte verstehen, können Sie Docker besser nutzen.

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

Die Installation von MySQL auf CentOS umfasst die folgenden Schritte: Hinzufügen der entsprechenden MySQL Yum -Quelle. Führen Sie den Befehl mySQL-server aus, um den MySQL-Server zu installieren. Verwenden Sie den Befehl mySQL_SECURE_INSTALLATION, um Sicherheitseinstellungen vorzunehmen, z. B. das Festlegen des Stammbenutzerkennworts. Passen Sie die MySQL -Konfigurationsdatei nach Bedarf an. Tune MySQL -Parameter und optimieren Sie Datenbanken für die Leistung.

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

Eine vollständige Anleitung zum Anzeigen von GitLab -Protokollen unter CentOS -System In diesem Artikel wird in diesem Artikel verschiedene GitLab -Protokolle im CentOS -System angezeigt, einschließlich Hauptprotokolle, Ausnahmebodi und anderen zugehörigen Protokollen. Bitte beachten Sie, dass der Log -Dateipfad je nach GitLab -Version und Installationsmethode variieren kann. Wenn der folgende Pfad nicht vorhanden ist, überprüfen Sie bitte das GitLab -Installationsverzeichnis und die Konfigurationsdateien. 1. Zeigen Sie das Hauptprotokoll an. Verwenden Sie den folgenden Befehl, um die Hauptprotokolldatei der GitLabRails-Anwendung anzuzeigen: Befehl: Sudocat/var/log/gitlab/gitlab-rails/production.log Dieser Befehl zeigt das Produkt an

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Pytorch Distributed Training on CentOS -System erfordert die folgenden Schritte: Pytorch -Installation: Die Prämisse ist, dass Python und PIP im CentOS -System installiert sind. Nehmen Sie abhängig von Ihrer CUDA -Version den entsprechenden Installationsbefehl von der offiziellen Pytorch -Website ab. Für CPU-Schulungen können Sie den folgenden Befehl verwenden: PipinstallTorChTorChVisionTorChaudio Wenn Sie GPU-Unterstützung benötigen, stellen Sie sicher, dass die entsprechende Version von CUDA und CUDNN installiert ist und die entsprechende Pytorch-Version für die Installation verwenden. Konfiguration der verteilten Umgebung: Verteiltes Training erfordert in der Regel mehrere Maschinen oder mehrere Maschinen-Mehrfach-GPUs. Ort