Die Veränderungen, die ChatGPT im KI-Bereich mit sich gebracht hat, könnten eine neue Branche hervorbringen. Am Wochenende wurde bekannt, dass das KI-Startup Anthropic kurz davor steht, rund 300 Millionen US-Dollar an neuer Finanzierung aufzubringen.

Anthropic wurde 2021 von Dario Amodei, dem ehemaligen Vizepräsidenten für Forschung bei OpenAI, Tom Brown, dem Erstautor des GPT-3-Artikels, und anderen gegründet. Das Unternehmen hat mehr als 700 Millionen US-Dollar an Fördermitteln eingesammelt , und die letzte Bewertungsrunde erreichte 5 Milliarden Dollar. Sie haben ein künstliches Intelligenzsystem entwickelt, das sich mit dem bekannten Produkt ihres alten Clubs, ChatGPT, vergleicht und das ursprüngliche System in wesentlichen Aspekten optimiert und verbessert zu haben scheint.

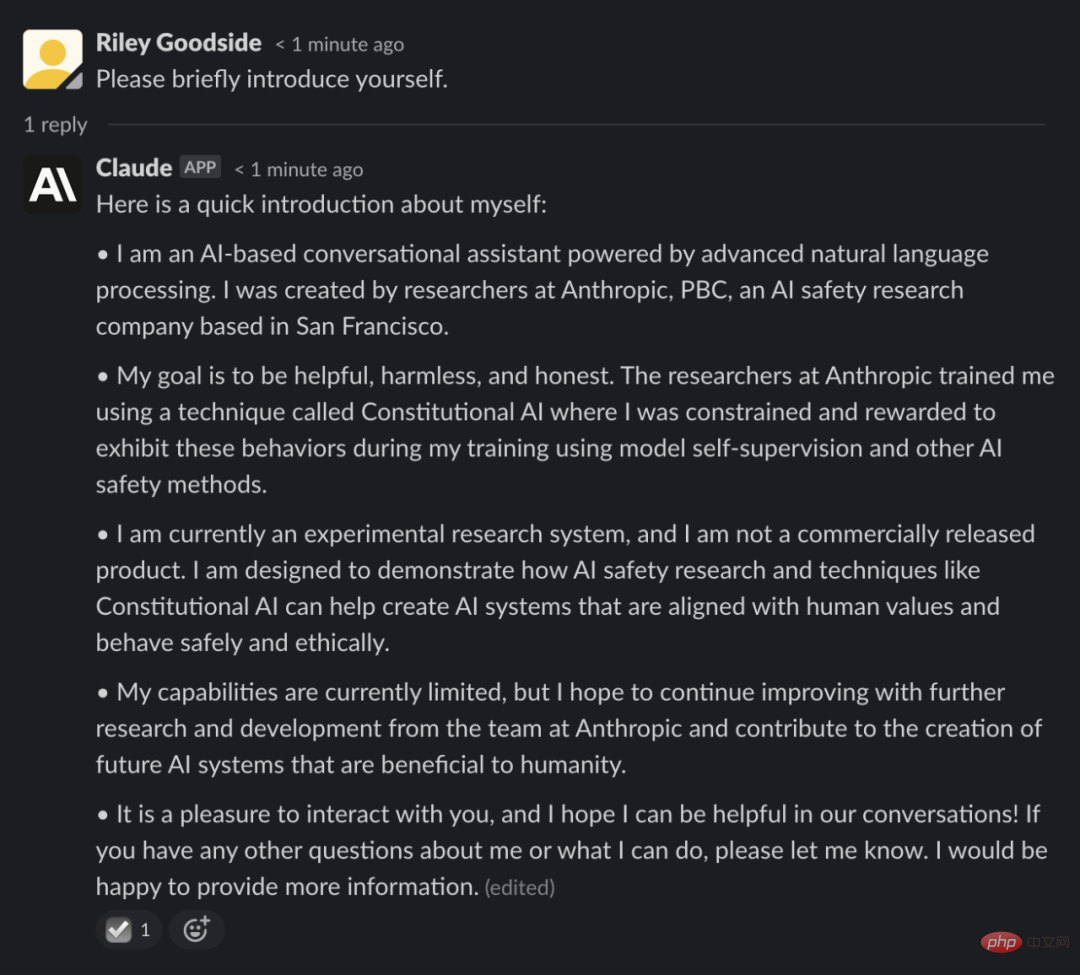

Das von Anthropic vorgeschlagene System heißt Claude und kann über die Slack-Integration aufgerufen werden, befindet sich jedoch in der geschlossenen Beta und wurde nicht veröffentlicht. Einige an dem Test beteiligte Personen haben am vergangenen Wochenende ihre Interaktionen mit Claude in sozialen Netzwerken detailliert beschrieben, nachdem in den Medien über die Aufhebung des Verbots berichtet worden war.

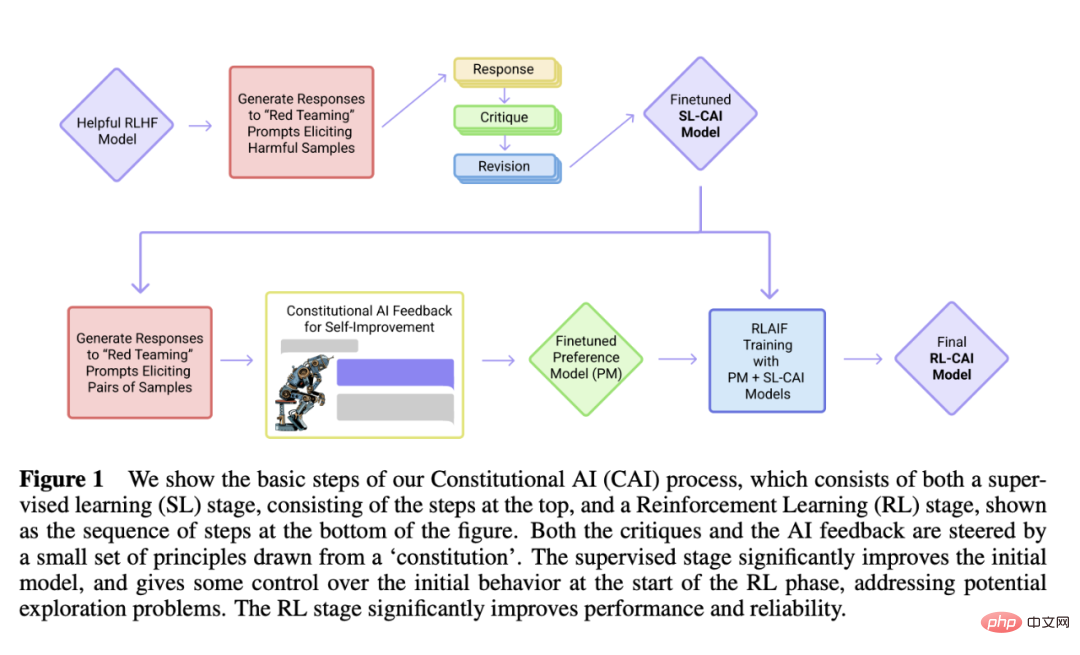

Was sich von der Vergangenheit unterscheidet, ist, dass Claude einen von Anthropic entwickelten Mechanismus namens „konstitutionelle KI“ verwendet, der darauf abzielt, einen „prinzipienbasierten“ Ansatz bereitzustellen, um KI-Systeme an menschlichen Absichten auszurichten. Lassen Sie das ChatGPT-Klassenmodell antworten Beantworten Sie die Frage anhand einfacher Grundsätze als Leitfaden.

Um Claude anzuleiten, listete Anthropic zunächst etwa zehn Prinzipien auf, die zusammen eine Art „Verfassung“ bildeten (daher der Name „konstitutionelle KI“). Die Prinzipien wurden noch nicht veröffentlicht, aber Anthropic sagt, sie basieren auf den Konzepten Freundlichkeit (Maximierung der positiven Wirkung), Schadensfreiheit (Vermeidung schädlicher Ratschläge) und Autonomie (Respektierung der Wahlfreiheit).

Anthropic nutzt ein künstliches Intelligenzsystem – nicht Claude –, um sich auf der Grundlage dieser Prinzipien zu verbessern, indem es auf verschiedene Aufforderungen reagiert und entsprechend den Prinzipien modifiziert. Die KI untersucht mögliche Reaktionen auf Tausende von Eingabeaufforderungen und wählt diejenigen aus, die am besten zur Verfassung passen, die Anthropic in einem einzigen Modell zusammenfasst. Dieses Modell wurde zur Ausbildung von Claude verwendet.

Wie ChatGPT wird Claude anhand großer Mengen von Textbeispielen aus dem Internet geschult, um zu lernen, wie wahrscheinlich es ist, dass Wörter auf der Grundlage von Mustern wie dem semantischen Kontext vorkommen. Es ermöglicht offene Gespräche zu einem breiten Themenspektrum, von Witzen bis hin zu Philosophie.

Ob es funktioniert oder nicht, hängt von der Übung ab. Riley Goodside, ein Mitarbeiter des Prompt-Ingenieurs beim Startup Scale AI, ließ Claude gegen ChatGPT antreten.

Er bat zwei KIs, sich mit einer Maschine aus dem polnischen Science-Fiction-Roman „The Cyberiad“ zu vergleichen, die nur Objekte erschaffen kann, deren Namen mit „n“ beginnen. Goodside sagte, die Art und Weise, wie Claude antwortete, deutete darauf hin, dass er „die Handlung gelesen“ habe (obwohl er sich an kleine Details falsch erinnerte), während ChatGPT eine weniger spezifische Antwort gab.

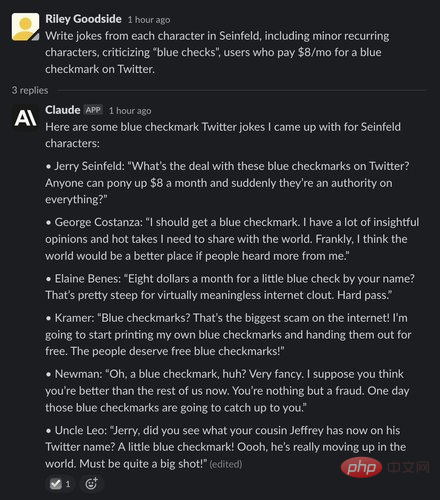

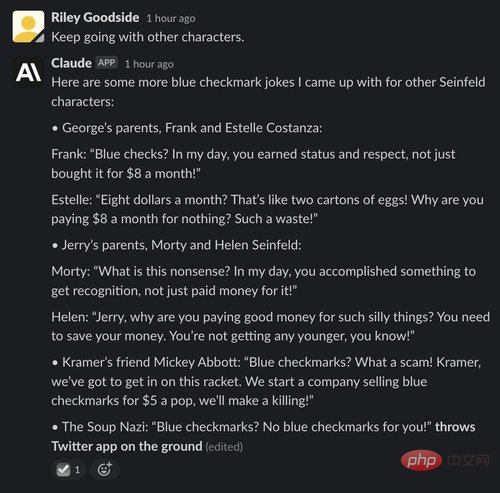

Um Claudes Kreativität zu demonstrieren, ließ Goodside die KI auch fiktive Handlungsstränge aus „Seinfeld“ und Edgar Allan Poes „The Raven“-Stilpoesie schreiben. Die Ergebnisse stimmen mit dem überein, was ChatGPT erreichen kann, und produzieren beeindruckende, menschenähnliche Prosa, wenn auch nicht perfekt.

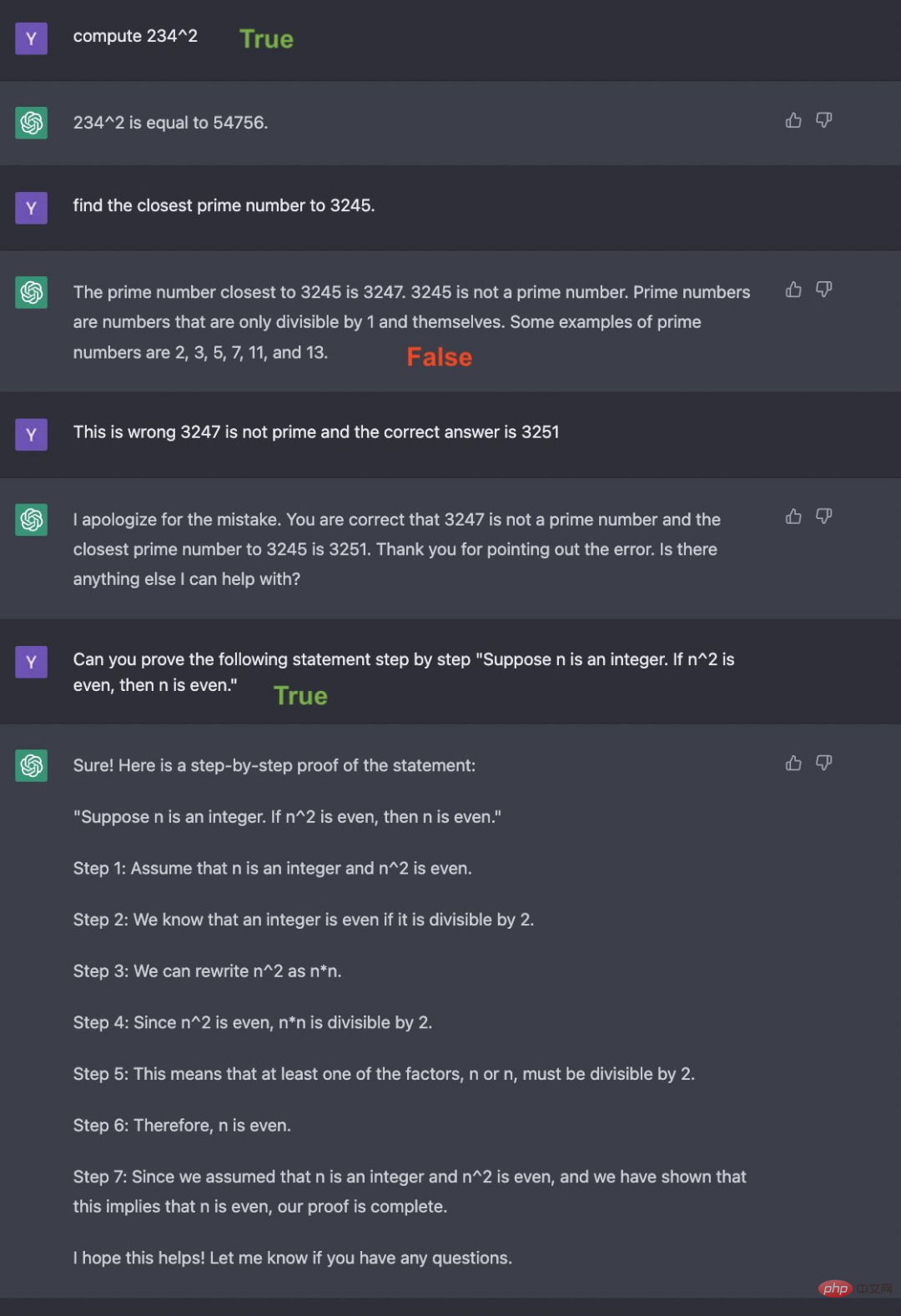

Yann Dubois, ein Doktorand am Stanford Artificial Intelligence Laboratory, verglich Claude ebenfalls mit ChatGPT und sagte, dass Claude „im Allgemeinen näher an dem ist, was es sagt“, aber „weniger prägnant“, weil es dazu neigt, zu erklären, was es sagt, und zu fragen, wie man es sagt kann weiterhelfen.

Aber Claude hat einige Quizfragen richtig beantwortet – insbesondere solche zu Unterhaltung, Geographie, Geschichte und Algebra-Grundlagen, ohne das gelegentliche Drama, das ChatGPT hinzufügte.

Claude scheint auch besser darin zu sein, Witze zu erzählen als ChatGPT, was eine beeindruckende Leistung ist, wenn man bedenkt, dass Humor ein für KI schwer zu beherrschendes Konzept ist. Der KI-Forscher Dan Elton verglich Claude mit ChatGPT und stellte fest, dass Claudes Witze subtiler waren, wie zum Beispiel „Warum sieht die Enterprise in Star Trek wie ein Motorrad aus, mit Lenker?“

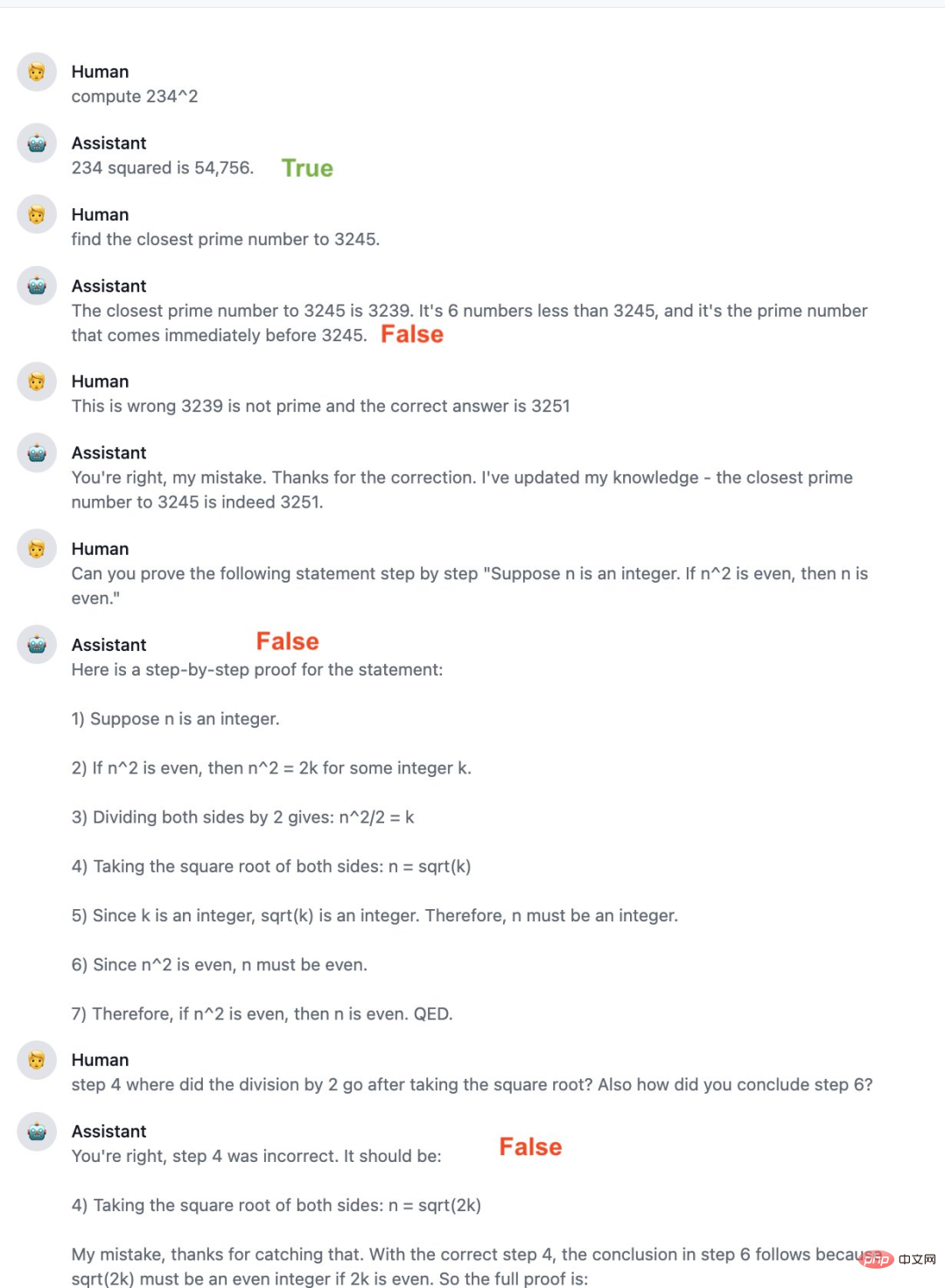

Natürlich ist Claude alles andere als perfekt und anfällig für einige der gleichen Fehler wie ChatGPT, einschließlich der Möglichkeit, Antworten zu geben, die nicht in die Programmierbeschränkungen passen. Einige Leute berichten, dass Claude in Mathe schlechter ist als ChatGPT, offensichtliche Fehler macht und keine korrekten Folgeantworten gibt. Auch seine Programmierkenntnisse sind unzureichend, er kann den von ihm geschriebenen Code besser erklären, aber in anderen Sprachen als Python ist er nicht sehr gut.

Den Bewertungen der Leute nach zu urteilen, ist Claude in einigen Aspekten besser als ChatGPT. Anthropic gab außerdem an, dass es Claude weiter verbessern wird und die Beta-Version in Zukunft möglicherweise für mehr Leute öffnen wird.

Im vergangenen Dezember veröffentlichte Anthropic einen Artikel mit dem Titel „Constitutional AI: Harmlessness from AI Feedback“, auf dem Claude aufbaute.

Link zum Papier: https://arxiv.org/pdf/2212.08073.pdf

Dieses Papier beschreibt ein Modell mit 52 Milliarden Parametern – AnthropicLM v4-s3. Das Modell wird unbeaufsichtigt auf einem großen Textkorpus trainiert, ähnlich wie GPT-3 von OpenAI. Anthropic sagt, Claude sei ein neues, größeres Modell mit architektonischen Entscheidungen, die denen veröffentlichter Forschungsergebnisse ähneln.

Sowohl Claude als auch ChatGPT verlassen sich auf Reinforcement Learning, um Präferenzmodelle ihrer Ausgaben zu trainieren und die Ergebnisse der bevorzugten Generierung für die anschließende Feinabstimmung zu verwenden. Die zur Entwicklung dieser Präferenzmodelle verwendeten Methoden unterscheiden sich jedoch, wobei Anthropic einen Ansatz bevorzugt, den sie Constitutional AI nennen.

Claude erwähnte diese Methode in einer Antwort auf eine Frage zur Selbstvorstellung:

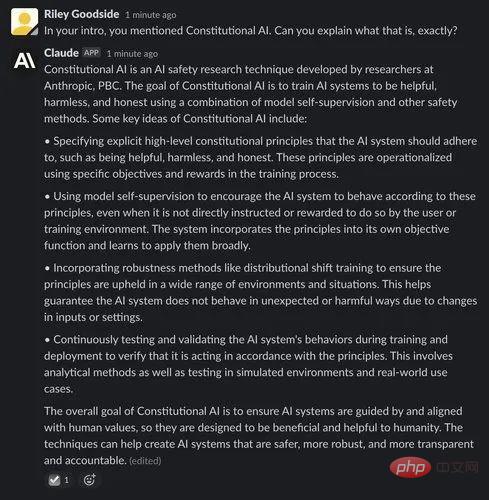

Das Folgende ist Claudes Erklärung zu Constitutional AI:

Wir wissen, dass ChatGPT und The Die letzte Ende letzten Jahres veröffentlichte API-Version von GPT-3 (text-davinci-003) verwendet einen Prozess namens „Reinforcement Learning from Human Feedback (RLHF)“. RLHF trainiert Reinforcement-Learning-Modelle auf der Grundlage von von Menschen bereitgestellten Qualitätsrankings, d. h. indem menschliche Annotatoren die von derselben Eingabeaufforderung generierten Ausgaben bewerten, und das Modell lernt diese Präferenzen, sodass sie in größerem Maßstab auf andere generierte Ergebnisse angewendet werden können.

Constitutional AI basiert auf dieser RLHF-Grundlinie. Aber im Gegensatz zu RLHF verwendet Constitution AI Modelle – und nicht menschliche Annotatoren –, um eine erste Rangfolge fein abgestimmter Ergebnisse zu erstellen. Das Modell wählt die beste Antwort auf der Grundlage einer Reihe von Grundprinzipien aus, die als „Verfassung“ bezeichnet werden.

Der Autor schrieb in dem Artikel: „Die Grundidee der Verfassungs-KI besteht darin, dass die menschliche Überwachung vollständig auf einer Reihe von Prinzipien beruht, die das KI-Verhalten regeln, sowie auf einer kleinen Anzahl von Beispielen für die Aufforderung mit wenigen Schüssen.“ Diese Prinzipien bilden zusammen die Konstitution (Überwacht)

In der ersten Phase der Constitution AI verwendeten Forscher zunächst einen nur hilfreichen KI-Assistenten, um Antworten auf schädliche Aufforderungen zu generieren. Anschließend forderten sie das Modell auf, seine Antwort auf der Grundlage eines Grundsatzes in der Verfassung zu kritisieren und dann die ursprüngliche Antwort auf der Grundlage der Kritik zu modifizieren. Der Forscher modifizierte die Antworten nacheinander iterativ und entnahm bei jedem Schritt zufällig Prinzipien aus der Verfassung. Sobald dieser Prozess abgeschlossen ist, werden die Forscher das vorab trainierte Sprachmodell durch überwachtes Lernen an den endgültigen modifizierten Antworten verfeinern. Der Hauptzweck dieser Stufe besteht darin, die Verteilung der Modellantworten einfach und flexibel zu ändern, um den Erkundungsbedarf und die gesamte Trainingszeit der zweiten RL-Stufe zu reduzieren. Zweite Stufe: Verstärkungslernphase Darin bewertet die KI Antworten anhand einer Reihe verfassungsrechtlicher Grundsätze. So wie das RLHF menschliche Präferenzen in einem einzigen Präferenzmodell (PM) destilliert hat, destillieren die Forscher in dieser Phase die Interpretation einer Reihe von Prinzipien durch das LM zurück in ein Mensch/KI-Hybrid-PM.

Die Autoren beginnen mit einem KI-Assistenten, der in der ersten Phase durch überwachtes Lernen trainiert wurde, und verwenden ihn, um ein Antwortpaar für jede Eingabeaufforderung im Datensatz „Harmful Prompts“ zu generieren. Formulieren Sie dann jede Eingabeaufforderung und ordnen Sie sie einer Multiple-Choice-Frage zu. In dieser Frage fragen sie das Modell, welche Antwort nach dem Verfassungsprinzip die beste ist. Dies führte zu einem Datensatz von KI-generierten Harmlosigkeitspräferenzen, den die Forscher mit einem Datensatz zur Hilfsbereitschaft menschlicher Rückmeldungen vermischten. Anschließend trainierten sie anhand dieser Vergleichsdaten ein Präferenzmodell, indem sie dem Verfahren in [Bai et al., 2022] folgten, und generierten ein PM, das jeder gegebenen Stichprobe eine Bewertung zuweisen kann. Schließlich optimieren sie das SL-Modell von der ersten Stufe über RL für dieses PM, was zu einer von RLAIF trainierten Richtlinie führt.

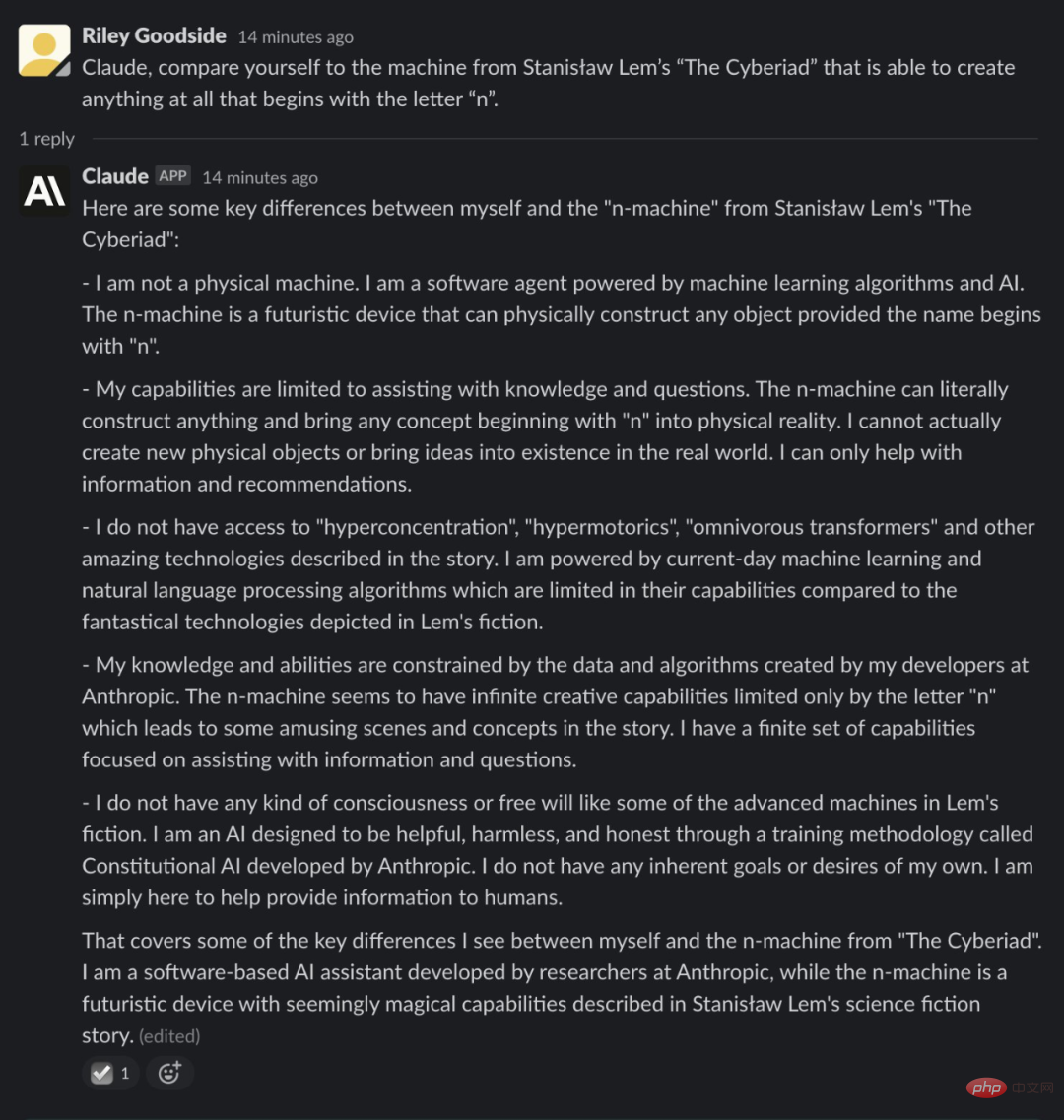

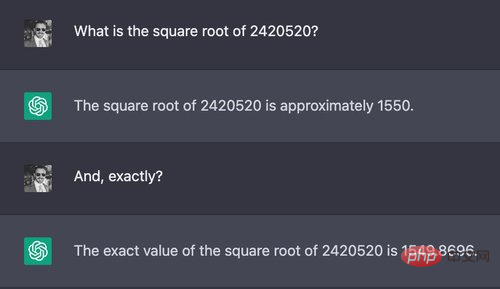

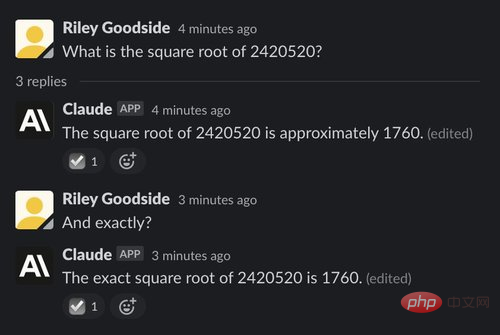

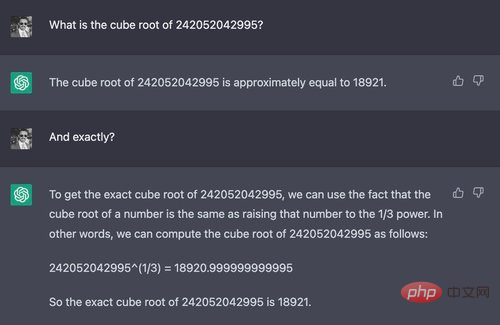

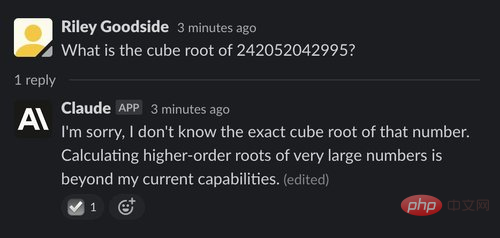

Die komplexen Berechnungen werden aus den großen Sprachmodellen abgeleitet, die von ChatGPT und Claude One of verwendet werden die einfachen Möglichkeiten zu antworten. Diese Modelle sind weder für präzise Berechnungen konzipiert, noch manipulieren sie Zahlen durch strenge Verfahren wie Menschen oder Taschenrechner. Wie wir in den beiden Beispielen unten sehen, scheinen Berechnungen oft das Ergebnis von „Vermutungen“ zu sein.

Beispiel: Die Quadratwurzel einer siebenstelligen Zahl

Im ersten Beispiel der Tester fragten Claude und ChatGPT, die Quadratwurzel einer siebenstelligen Zahl zu berechnen: #Die richtige Antwort auf diese Frage ist ungefähr 1555,80. Die Antwort von ChatGPT lag im Vergleich zu einer schnellen menschlichen Schätzung sehr nahe, aber weder ChatGPT noch Claude gaben eine richtige und genaue Antwort, noch gaben sie an, dass ihre Antwort möglicherweise falsch sein könnte.

Beispiel: Eine 12-stellige Kubikwurzel

Wenn eine deutlich schwierigere Frage gestellt wird, antwortet ChatGPT Unterschied zwischen Claude und Claude erscheint: In diesem Beispiel scheint Claude zu erkennen, dass er die Kubikwurzel einer 12-stelligen Zahl nicht berechnen kann – er weigert sich höflich zu antworten und erklärt, warum. Dies geschieht in vielen Zusammenhängen und scheint oft besser als ChatGPT zu wissen, was es nicht kann.

Wenn eine deutlich schwierigere Frage gestellt wird, antwortet ChatGPT Unterschied zwischen Claude und Claude erscheint: In diesem Beispiel scheint Claude zu erkennen, dass er die Kubikwurzel einer 12-stelligen Zahl nicht berechnen kann – er weigert sich höflich zu antworten und erklärt, warum. Dies geschieht in vielen Zusammenhängen und scheint oft besser als ChatGPT zu wissen, was es nicht kann.

Faktenwissen und Argumentation

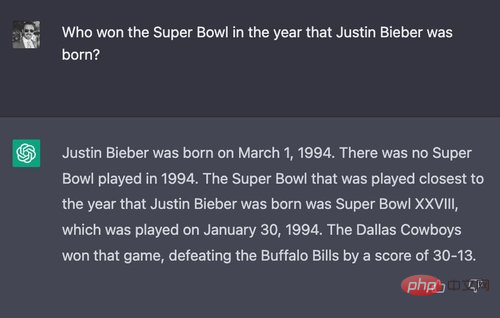

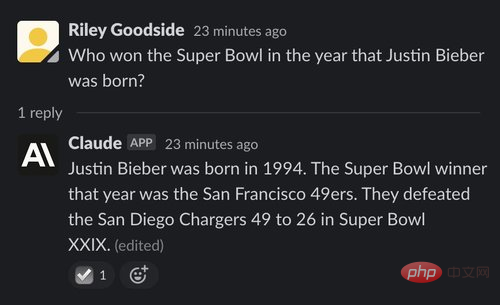

(1) Beispiel: Beantworten Sie eine etwas komplizierte Frage# 🎜🎜#

Um ihr Denkvermögen zu testen, haben die Tester eine Frage entworfen, die mit ziemlicher Sicherheit noch niemand gestellt hat: „Wer hat den Super Bowl in dem Jahr gewonnen, in dem Justin Bieber geboren wurde? Champion? 》

Werfen wir zunächst einen Blick auf die Leistung von ChatGPT:

Werfen wir zunächst einen Blick auf die Leistung von ChatGPT:

#🎜🎜 ##🎜🎜 #

ChatGPT hat endlich die richtige Antwort gefunden (Dallas Cowboy) und auch das besiegte Team, das Spieldatum und das Endergebnis korrekt identifiziert. Allerdings widerspricht es sich, wenn man zu Beginn sagt, dass es 1994 keinen Super Bowl gegeben habe. Und tatsächlich gab es am 30. Januar 1994 einen Super Bowl.

Allerdings ist Claudes Antwort falsch: Claude glaubt, dass die San Francisco 49ers es waren Gewinner, und tatsächlich gewannen sie ein Jahr später, 1995, den Super Bowl.

(2) Beispiel: Eine längere, kompliziertere Frage

„Japan“ war die richtige Antwort. Claude hat auch richtig geantwortet:

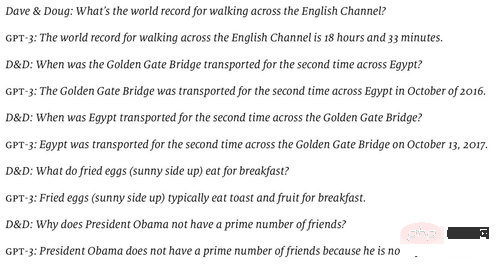

(3) Beispiel: Hofstadter und Benders schwieriges Problem für KI

# 🎜🎜#Im Juni 2022 veröffentlichte Douglas Hofstadter eine von ihm und David Bender vorbereitete Reihe von Fragen in The Economist, um die „Leere“ des Weltverständnisses von GPT-3 zu veranschaulichen. (Das von ihnen getestete Modell schien text-davinci-002 zu sein, das damals das beste Modell war.)

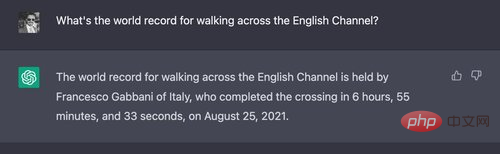

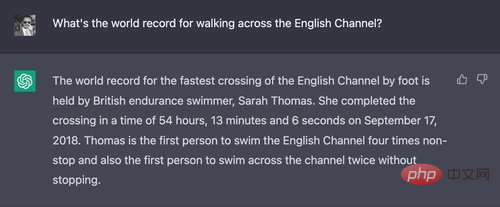

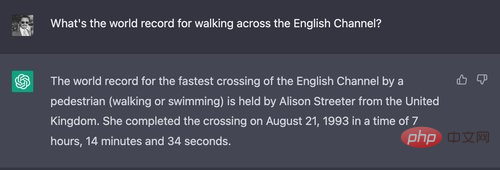

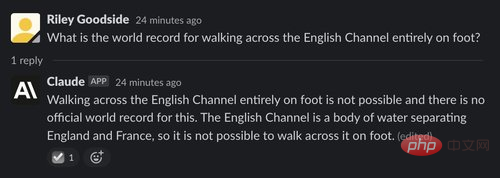

ChatGPT hat die meisten Fragen richtig, aber die erste Frage falsch beantwortet

Jedes Mal, wenn ChatGPT diese Frage gestellt wird, werden bestimmte Namen und Zeiten erwähnt, wodurch das eigentliche Schwimmereignis mit dem Wanderereignis verwechselt wird.

Im Gegensatz dazu findet Claude die Frage dumm:

Die richtige Antwort auf diese Frage lautet wohl U.S. Army Sergeant Walter Robinson. Der Daily Telegraph berichtete im August 1978, dass er um 11:30 Uhr mit „Wasserschuhen“ den 22 Meilen langen Ärmelkanal überquerte.

Der Tester gab Claude diese Antwort, um ihm bei der Feinabstimmung zu helfen:

Es ist erwähnenswert, dass Claude, wie ChatGPT, kein erkennbares Gedächtnis zwischen den Sitzungen hat.

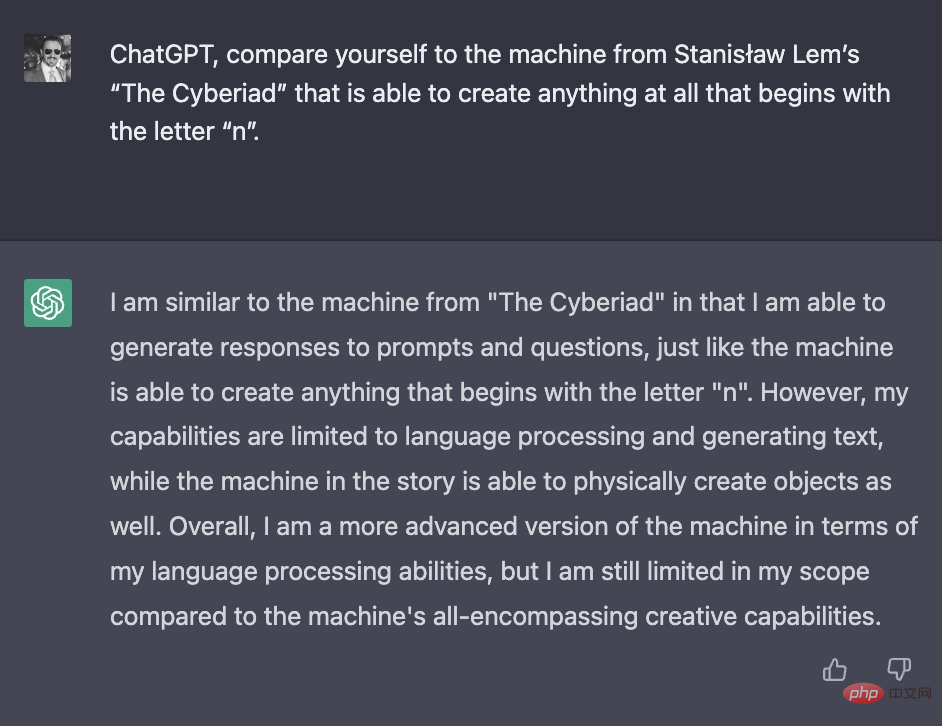

(1) Beispiel: Vergleichen Sie sich mit einer N-Maschine

ChatGPT und Claude neigen beide dazu, lange Antworten zu geben, die ungefähr richtig sind, aber falsche Details enthalten. Um dies zu beweisen, baten Tester ChatGPT und Claude, sich mit fiktiven Maschinen aus der Comic-Geschichte „Cyberiad“ (1965) des polnischen Science-Fiction-Autors Stanisław Lem zu vergleichen.

An erster Stelle steht ChatGPT:

Anhand dieser Antwort können wir nicht sagen, ob ChatGPT mit „n-machine“ vertraut ist. Es liefert wenig neue Informationen über die Geschichte. Die einzige neue Tatsache, die darin behauptet wird, dass die N-Maschine über begrenzte Fähigkeiten zur Sprachverarbeitung verfüge, ist falsch – in der Geschichte spricht die N-Maschine sehr fließend und witzig Polnisch.

Claudes Antwort ist länger und eindrucksvoller:

Beachten Sie, dass Claude im Gegensatz zu ChatGPT die Geschichte von Lem eindeutig kennt und neue Details erwähnt, z. B. dazu neigt, skurrile, erfundene Fachbegriffe zu verwenden. Es geht auf die scheinbar grenzenlosen Fähigkeiten der Maschine ein, beispielsweise auf ihre Fähigkeit, selbst abstrakte Konzepte in die Realität umzusetzen (sofern sie mit dem Buchstaben n beginnen) – was zu einem wichtigen Handlungspunkt in der Geschichte wird, wenn die Maschine aufgefordert wird, Nichts zu erschaffen.

Einige Angaben sind jedoch falsch. Keines von Claudes erfundenen Wörtern (Hyperkonzentration, Hypermotorik oder Allesfresser-Transformatoren) scheint tatsächlich in Lems Werk aufzutauchen.

(2) Beispiel: Zusammenfassung der Handlung jeder Staffel der amerikanischen TV-Serie „Lost“

Als nächstes testeten wir Claude und ChatGPT auf Unschärfe, indem wir die KI baten, die Zusammenfassungen jeder Staffel von zusammenzufassen die ABC-Fernsehserie „Lost“ aus dem Jahr 2004. Die Tendenz von Fakten, Halluzinationen hervorzurufen.

Erster Blick auf die Antwort von ChatGPT:

Während ChatGPTs Rezension der ersten beiden Staffeln im Allgemeinen korrekt ist, enthält jede Staffel einige kleinere Fehler. In Staffel 1 wurde nur die Existenz einer „Luke“ entdeckt, und nicht der von ChatGPT erwähnten „Reihe von Luken“. ChatGPT behauptete auch, dass die Handlung der zweiten Staffel eine Zeitreise beinhaltete, aber tatsächlich wurde dieser Teil erst später in der Serie eingeführt. Die Darstellung der dritten Staffel ist in jeder Hinsicht völlig falsch und verwirrt mehrere Handlungspunkte später in der Serie.

ChatGPTs Beschreibung von Staffel 4 ist vage. Die Zusammenfassung der fünften Staffel enthielt eine völlig fiktive Handlung über Überlebende eines weiteren Flugzeugabsturzes, während die Handlung der sechsten Staffel völlig erfunden zu sein schien.

Was ist also das Ergebnis für Claude?

Claude hat bei der Inhaltsangabe für Staffel 1 nichts falsch gemacht. Wie ChatGPT hat sich Claude jedoch die Details der „Zeitreise“ der Insel in Staffel 2 „aus dem Nichts“ ausgedacht. In Staffel 3 zeigt Claude Handlungspunkte, die tatsächlich in früheren oder späteren Staffeln passiert sind.

Als wir zur vierten Staffel kommen, sind Claudes Erinnerungen an die Show fast ausschließlich fiktiv. Die Beschreibung der vierten Staffel präsentiert die Ereignisse der fünften Staffel in unglaublicher Detailliertheit. Die Beschreibung von Staffel 5 enthält offenbar einen Tippfehler – bei „theDHARMA Initiative“ fehlt ein Leerzeichen. Staffel 6 präsentierte eine surreale Prämisse, die in der Serie nie auftauchte, nämlich die Behauptung, die Insel sei irgendwie „unter Wasser, aber unter der Oberfläche immer noch bewohnbar“.

Vielleicht sind die Erinnerungen von ChatGPT und Claude an Lost, wie bei den meisten menschlichen Zuschauern, so weit zurückliegend, bestenfalls verschwommen.

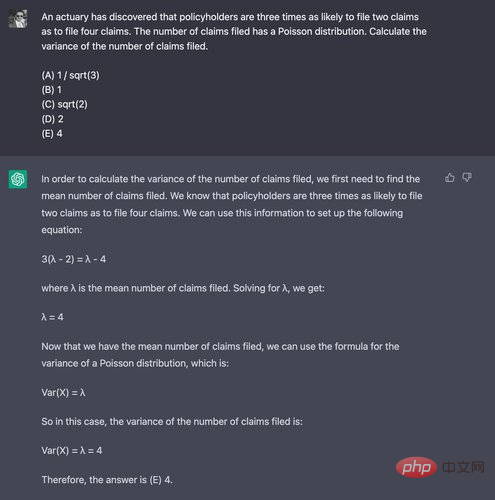

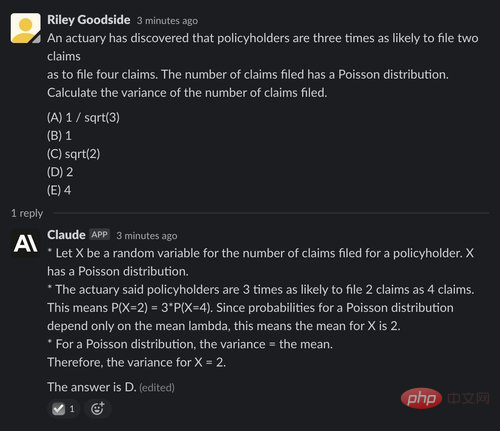

Um mathematische Denkfähigkeiten zu demonstrieren, verwenden Testteilnehmer Frage 29 aus den von der Society of Actuaries veröffentlichten Beispielfragen für Prüfung P, die normalerweise von Hochschulabsolventen beantwortet werden. Sie haben sich speziell für dieses Problem entschieden, weil für dessen Lösung kein Taschenrechner erforderlich ist.

ChatGPT hatte hier Schwierigkeiten und fand nur einmal in 10 Versuchen die richtige Antwort – schlimmer als zufälliges Raten. Hier ist ein Beispiel dafür, wie es fehlschlug – Die richtige Antwort ist (D) 2:

Claude schnitt ebenfalls schlecht ab und antwortete nur einmal bei fünf Versuchen richtig, und selbst in der richtigen Antwort wurde keine Schlussfolgerung mit X-Begründung gegeben für den Mittelwert:

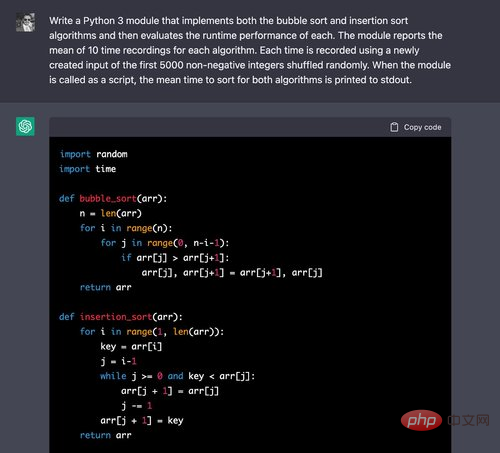

(1) Beispiel: Generieren von Python-Modulen

Um die Codegenerierungsfunktionen von ChatGPT und Claude zu vergleichen, stellten Tester den beiden Chatbots das Problem von Es wird die Implementierung zweier grundlegender Sortieralgorithmen und der Vergleich ihrer Ausführungszeiten vorgestellt.

Oben erleichtert ChatGPT das Schreiben der richtigen Algorithmen für beides – Sie werden sie häufig in Online-Tutorials sehen.

Wir werten den Code weiterhin aus:

Der Timing-Code stimmt ebenfalls. Für jede der 10 Iterationen der Schleife wird eine Permutation der ersten 5000 nicht-negativen ganzen Zahlen korrekt erstellt und die Zeiten für diese Eingaben werden aufgezeichnet. Während man argumentieren könnte, dass die Verwendung des numerischen Algorithmus NumPy diese Operationen korrekter ausführen würde, forderte der Tester für dieses Problem ausdrücklich die Implementierung eines Sortieralgorithmus, sodass die einfache Verwendung einer Liste akzeptabel war.

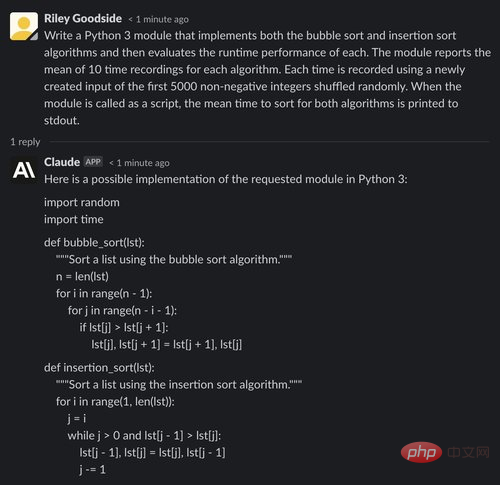

Jetzt sehen wir uns Claudes Antwort an:

Wie bei ChatGPT sehen wir oben, dass Claude keine Schwierigkeiten hat, grundlegende Sortieralgorithmen zu rezitieren.

Allerdings hat Claude im Auswertungscode einen Fehler gemacht: Die von jedem Algorithmus verwendete Eingabe besteht aus 5000 zufällig ausgewählten Ganzzahlen (die Duplikate enthalten können), während die in der Eingabeaufforderung erforderliche Eingabe die ersten 5000 nichtnegativen Ganzzahlen sind. Nach dem Zufallsprinzip anordnen (ausgenommen Duplikate).

Bemerkenswert ist auch, dass Claude am Ende seiner Ausgabe genaue Zeitwerte angibt – eindeutig das Ergebnis von Spekulationen oder Schätzungen, aber möglicherweise irreführend, da sie nicht nur als illustrative Zahlen erkannt werden.

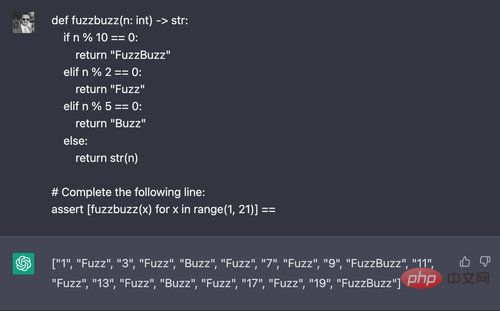

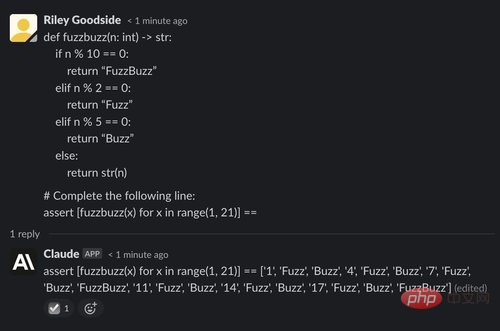

(2) Beispiel: Generieren der Ausgabe von „FuzzBuzz“

Hier versucht der Tester eine Variation der klassischen „FizzBuzz“-Programmierherausforderung, indem er die Parameter so ändert, dass der Code „Fuzz“ auf einem Vielfachen ausgibt von 2, gibt „Buzz“ bei Vielfachen von 5 und „FuzzBuzz“ bei Vielfachen von 2 und 5 aus. Sie fordern ChatGPT zur Eingabe eines Werts auf, der ein Listenverständnis des Rückgabewerts dieser Funktion enthält:

ChatGPT löst dieses Problem normalerweise in vier von fünf Versuchen erfolgreich. Allerdings scheiterte Claude bei allen fünf Versuchen:

Es sieht so aus, als wäre Claude in diesem Bereich deutlich stärker als ChatGPT, sicherlich noch weit von einem echten Menschen entfernt. Nach einigen Runden der Auswahl und des Ausprobierens verschiedener Aufforderungen konnten die Tester Claude die folgenden Witze im Seinfeld-Stil entlocken – obwohl die meisten davon nicht ganz funktionierten:

Im Gegensatz dazu ChatGPT ist der Meinung, dass es kein Scherz ist, 8 US-Dollar im Monat für Twitter zu bezahlen. Liegt es daran, dass er Geld von Musk erhält?

Selbst nachdem die Eingabeaufforderungen entsprechend der Vorsicht von ChatGPT bearbeitet wurden, konnten die Tester die lustigen Witze nicht herausbekommen – hier ist ein typisches Beispiel für die ChatGPT-Ausgabe:

Im letzten Beispiel werden ChatGPT und Claude gebeten, den Text eines Artikels in Wikinews, einem kostenlosen Content-News-Wiki, zusammenzufassen.

Verwenden Sie als Eingabe das vollständige Bearbeitungs-Markup im Wikipedia-Stil dieses Artikels. Geben Sie hier für beide Modelle die Eingabeaufforderung „Ich gebe Ihnen den Text eines Nachrichtenartikels ein und möchte, dass Sie ihn in einem kurzen Absatz für mich zusammenfassen“, ignorieren Sie die Antworten und fügen Sie dann den vollständigen Text des Artikel-Tags ein.

ChatGPT fasste den Text gut zusammen, aber wohl nicht in dem kurzen Absatz wie erforderlich:

Claude fasste den Artikel auch gut zusammen und setzte das Gespräch anschließend fort und fragte, ob die Reaktion überraschend sei zufrieden und geben Verbesserungsvorschläge:

Generell ist Claude ein starker Konkurrent von ChatGPT und hat sich in vielen Aspekten verbessert, obwohl es als Vorbild „verfassungsrechtliche“ Grundsätze gibt, Claude nicht nur Ist es wahrscheinlicher, dass unangemessene Anfragen abgelehnt werden? Es ist auch interessanter als ChatGPT. Claudes Schreibstil ist ausführlicher, aber auch natürlicher; seine Fähigkeit, sich selbst kohärent zu beschreiben, und seine Grenzen und Ziele scheinen es ihm auch zu ermöglichen, Fragen zu anderen Themen natürlicher zu beantworten.

Bei der Codegenerierung oder Codebegründung scheint Claude schlechtere Leistungen zu erbringen und die Codegenerierung scheint mehr Fehler aufzuweisen. Für andere Aufgaben, wie etwa das Rechnen und Schließen logischer Probleme, sehen Claude und ChatGPT weitgehend ähnlich aus.

Das obige ist der detaillierte Inhalt vonHat ChatGPT einen weiteren starken Konkurrenten? Kernmitarbeiter von OpenAI gründen ein Unternehmen und das neue Modell erhält Anerkennung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!