Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

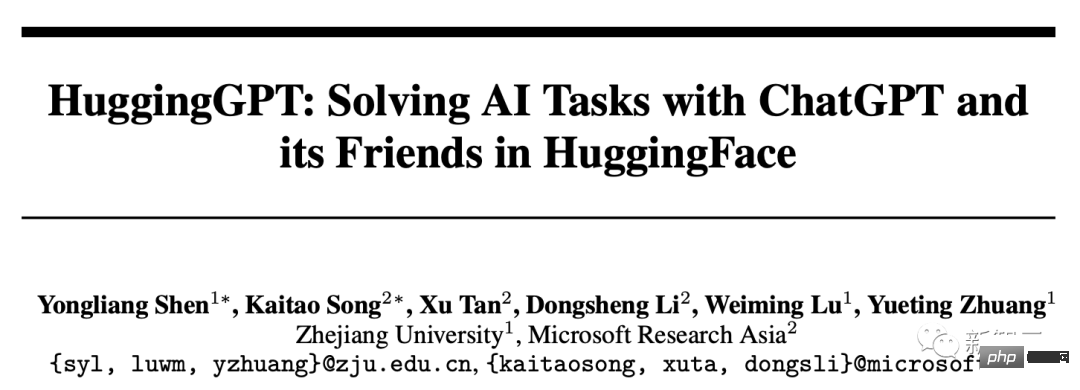

ChatGPT kann Modelle selbst auswählen! Das heiße neue Papier des Microsoft Asia Research Institute und der Zhejiang University, das HuggingGPT-Projekt, ist Open Source

ChatGPT kann Modelle selbst auswählen! Das heiße neue Papier des Microsoft Asia Research Institute und der Zhejiang University, das HuggingGPT-Projekt, ist Open Source

ChatGPT kann Modelle selbst auswählen! Das heiße neue Papier des Microsoft Asia Research Institute und der Zhejiang University, das HuggingGPT-Projekt, ist Open Source

ChatGPT Der KI-Wahn explodierte und „brannte“ auch den Finanzkreis nieder.

Kürzlich haben Forscher bei Bloomberg auch ein GPT im Finanzbereich entwickelt – Bloomberg GPT, mit 50 Milliarden Parametern.

Das Aufkommen von GPT-4 hat vielen Menschen einen Vorgeschmack auf die leistungsstarken Fähigkeiten großer Sprachmodelle gegeben.

Allerdings ist OpenAI nicht geöffnet. Viele Leute in der Branche haben damit begonnen, GPT zu klonen, und viele ChatGPT-Ersatzmodelle basieren auf Open-Source-Modellen, insbesondere dem Meta-Open-Source-LLMa-Modell.

Zum Beispiel hat sich Stanford’s Alpaca, UC Berkeley mit CMU, Stanford und anderen Vicuna, Dolly vom Startup Databricks usw. zusammengetan. .

Eine umfangreiche ChatGPT-ähnliche Sprache, die für verschiedene Aufgaben und Anwendungen entwickelt wurde Models konkurrieren im gesamten Bereich.

Dann stellt sich die Frage, wie Forscher ein geeignetes Modell oder sogar mehrere Modelle auswählen, um eine komplexe Aufgabe zu lösen ?

Kürzlich hat das Forschungsteam von Microsoft Research Asia und der Zhejiang-Universität HuggingGPT veröffentlicht, ein großes Modellkollaborationssystem.

Papieradresse: https://arxiv.org/pdf/2303.17580 .pdf

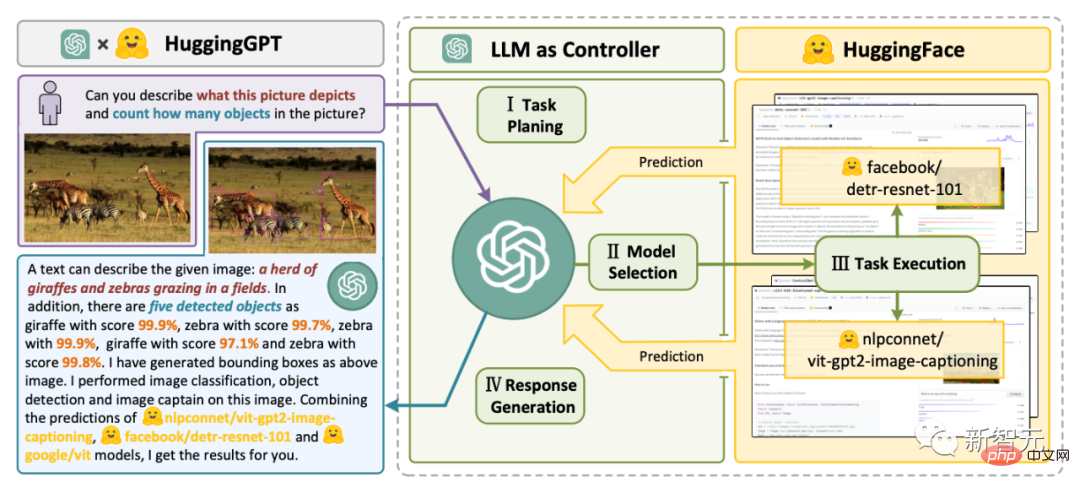

HuggingGPT nutzt ChatGPT als Controller, um verschiedene KI-Modelle in der HuggingFace-Community zu verbinden, um multimodale komplexe Aufgaben zu erledigen.

Das bedeutet, dass Sie durch HuggingGPT über multimodale Fähigkeiten verfügen können, Wenshengtu, Vincent Video und Sprache stehen Ihnen jederzeit zur Verfügung.

HuggingGPT Bridging

Forscher wiesen darauf hin, dass zur Lösung der aktuellen Probleme großer Sprachmodelle (LLMs) , es kann sein, dass der erste Schritt in Richtung AGI auch ein entscheidender Schritt ist.

Da die aktuelle Technologie großer Sprachmodelle noch einige Mängel aufweist, gibt es auf dem Weg zum Aufbau von AGI-Systemen einige dringende Herausforderungen.

- Aktuelle LLMs sind aufgrund der Eingabe- und Ausgabeformen der Textgenerierung nicht in der Lage, komplexe Informationen (z. B. Sehen und Sprechen) zu verarbeiten. 🎜🎜 #

- In tatsächlichen Anwendungsszenarien bestehen einige komplexe Aufgaben normalerweise aus mehreren Unteraufgaben und erfordern daher die Planung und Zusammenarbeit mehrerer Modelle, was auch darüber hinausgeht Sprachmodelle Der Funktionsumfang;

- Bei einigen anspruchsvollen Aufgaben leisten LLMs hervorragende Ergebnisse bei Null- oder wenigen Stichprobeneinstellungen , aber sie sind immer noch schwächer als einige Experten (wie fein abgestimmte Modelle).

Um komplexe KI-Aufgaben zu bewältigen, sollten LLMs in der Lage sein, sich mit externen Modellen zu koordinieren, um deren Fähigkeiten zu nutzen. Der entscheidende Punkt ist daher die Auswahl der geeigneten Middleware zur Überbrückung von LLMs und KI-Modellen.

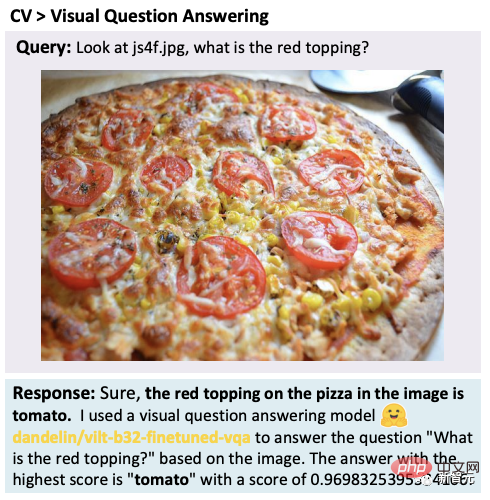

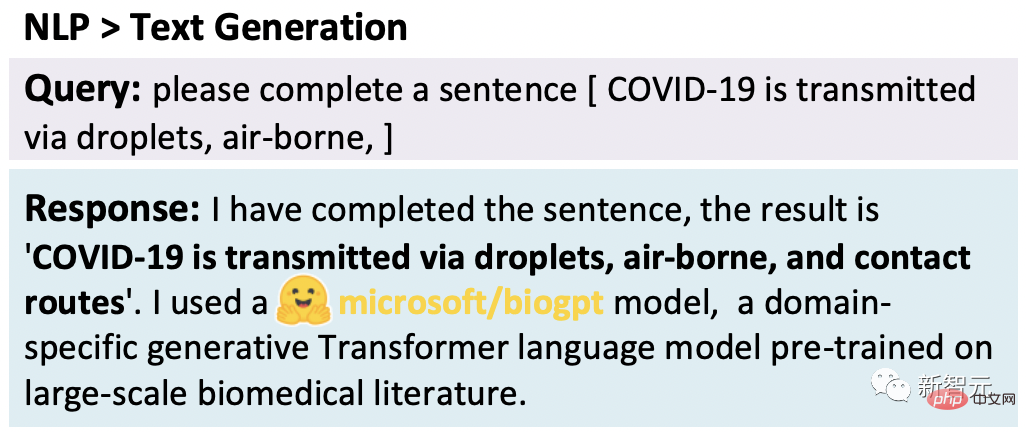

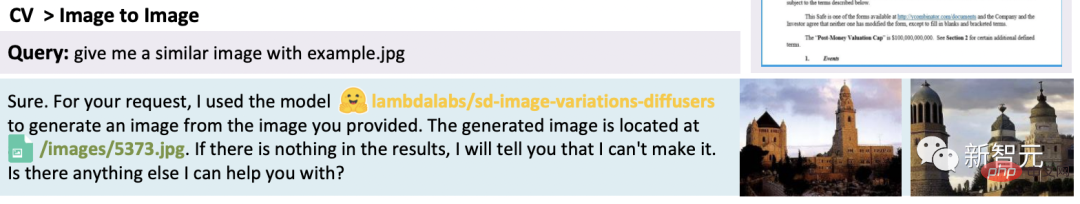

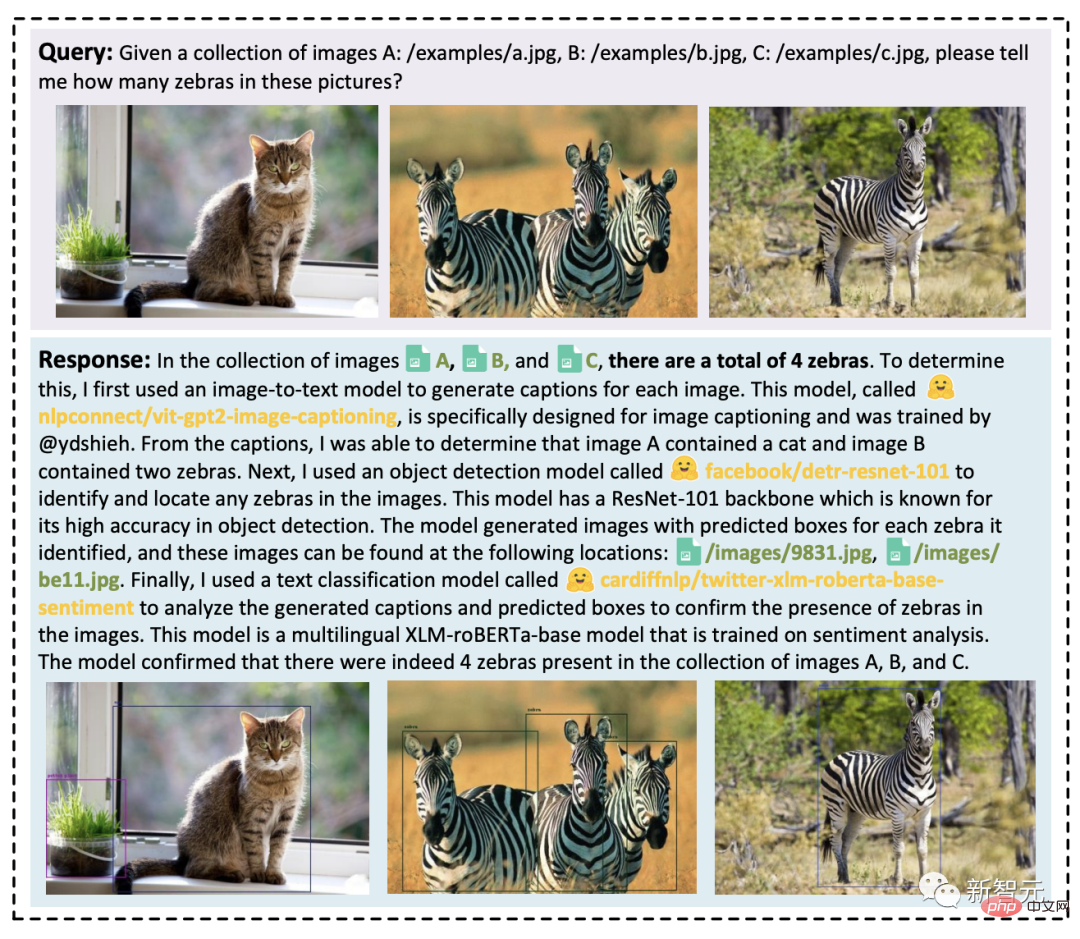

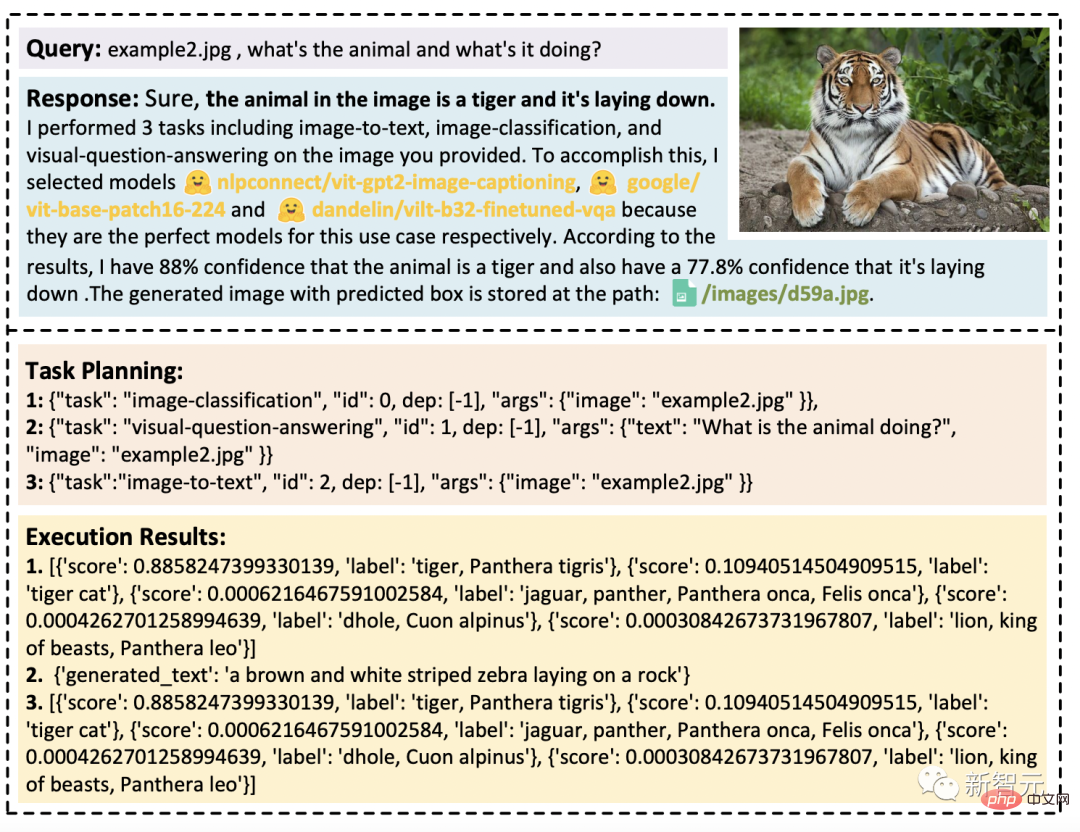

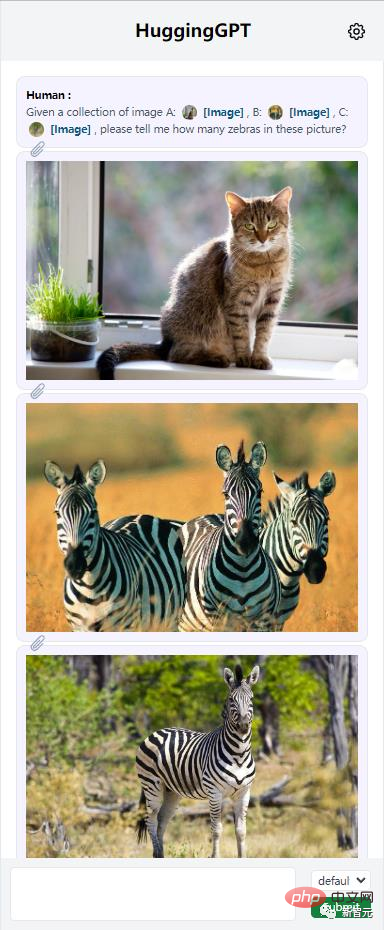

Forscher fanden heraus, dass jedes KI-Modell durch Zusammenfassung seiner Modellfunktion zusammengefasst werden kann wird als sprachliche Form dargestellt. Damit wird ein Konzept eingeführt: „Sprache ist LLMs, nämlich ChatGPT, eine gemeinsame Schnittstelle zum Verbinden von Modellen der künstlichen Intelligenz.“ Durch die Integration von KI-Modellbeschreibungen in Eingabeaufforderungen kann ChatGPT als das Gehirn für die Verwaltung von KI-Modellen betrachtet werden. Daher ermöglicht diese Methode ChatGPT, externe Modelle aufzurufen, um praktische Aufgaben zu lösen. Einfach ausgedrückt ist HuggingGPT ein Kollaborationssystem, kein großes Modell. Seine Funktion besteht darin, ChatGPT und HuggingFace zu verbinden, um Eingaben in verschiedenen Modalitäten zu verarbeiten und viele komplexe Aufgaben der künstlichen Intelligenz zu lösen. Daher verfügt jedes KI-Modell in der HuggingFace-Community über eine entsprechende Modellbeschreibung in der HuggingGPT-Bibliothek und ist integriert. Gehen Sie zur Eingabeaufforderung zu Stellen Sie eine Verbindung zu ChatGPT her. HuggingGPT verwendet dann ChatGPT als Gehirn, um die Antwort auf die Frage zu ermitteln. Bisher hat HuggingGPT Hunderte von Modellen auf HuggingFace rund um ChatGPT integriert, die Textklassifizierung, Zielerkennung und 24 Aufgaben einschließlich semantischer Segmentierung abdecken , Bilderzeugung, Frage und Antwort, Text-to-Speech, Text-to-Video usw. Experimentelle Ergebnisse belegen, dass HuggingGPT in der Lage ist, multimodale Informationen und komplexe Aufgaben der künstlichen Intelligenz zu bewältigen. Vier-Schritte-Workflow HuggingGPT Der gesamte Workflow kann in die folgenden vier Phasen unterteilt werden: - Aufgabenplanung : ChatGPT analysiert Benutzeranfragen, unterteilt sie in mehrere Aufgaben und plant Aufgabensequenzen und Abhängigkeiten basierend auf seinem Wissen : LLM weist die analysierte Aufgabe basierend auf der Modellbeschreibung in HuggingFace dem Expertenmodell zu Endpunkt: Führen Sie die zugewiesenen Aufgaben aus und zeichnen Sie die Ausführungsinformationen und Inferenzergebnisse in LLM auf Ergebnisse und gibt die Zusammenfassung an den Benutzer zurück -3.5-turbo und text-davinci- 003 Varianten dieser beiden GPT-Modelle dienen als Large Language Models (LLMs), die über die OpenAI-API öffentlich zugänglich sind. Um die Ausgabe von LLM stabiler zu machen, setzen wir die Dekodierungstemperatur auf 0. Um gleichzeitig die Ausgabe von LLM an das erwartete Format anzupassen, setzen wir logit_bias auf 0,1 die Formatbeschränkung. Die Forscher geben in der folgenden Tabelle detaillierte Tipps für die Phasen Missionsplanung, Modellauswahl und Reaktionsgenerierung, wobei { {variabel }} gibt an, dass der Feldwert mit dem entsprechenden Text gefüllt werden muss, bevor die Eingabeaufforderung in das LLM eingegeben wird. Die Forscher testeten HuggingGPT an einer Vielzahl multimodaler Aufgaben. Durch die Zusammenarbeit von ChatGP und Expertenmodellen kann HuggingGPT Aufgaben in mehreren Modi wie Sprache, Bild, Audio und Video lösen, einschließlich Erkennungs-, Generierungs-, Klassifizierungs- und Fragebeantwortungsformen Aufgaben. Obwohl diese Aufgaben einfach erscheinen mögen, ist die Beherrschung der Grundfunktionen von HuggingGPT eine Voraussetzung für die Lösung komplexer Aufgaben. Zum Beispiel visuelle Frage-und-Antwort-Aufgabe: # 🎜🎜##🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜##text generation:#🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜## #🎜🎜. #

demonstrierte die Fähigkeit von HuggingGPT, mehrere komplexe Aufgaben zu bewältigen. Bei der Bearbeitung mehrerer Anfragen können mehrere implizite Aufgaben oder Bedürfnisse und andere Informationen enthalten sein. Verlassen Sie sich in diesem Fall auf ein Expertenmodell zu lösen reicht nicht aus. Und HuggingGPT kann die Zusammenarbeit mehrerer Modelle durch Aufgabenplanung organisieren. Eine Benutzeranfrage kann explizit mehrere Aufgaben enthalten: #🎜🎜 ## 🎜🎜# Die folgende Abbildung zeigt die Fähigkeit von HuggingGPT, komplexe Aufgaben in Dialogszenarien mit mehreren Runden zu bewältigen. Benutzer unterteilen eine komplexe Anfrage in mehrere Schritte und erreichen das endgültige Ziel durch mehrere Anfragerunden. Es wurde festgestellt, dass HuggingGPT den Situationsstatus von Benutzeranfragen durch Dialogsituationsmanagement in der Aufgabenplanungsphase verfolgen und die von Benutzern genannten angeforderten Ressourcen und Aufgabenplanungen gut lösen kann. #🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#「Jarvis」 Open Source#🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#Derzeit Dieses Projekt wurde als Open Source auf GitHub bereitgestellt, der Code wurde jedoch noch nicht vollständig veröffentlicht. Interessanterweise nannten die Forscher dieses Projekt „Iron Man“ Jarvis in „ ", die unbesiegbare KI ist da. JARVIS: Ein System, das LLMs und ML-Communities verbindet Übrigens erfordert HuggingGPT die Verwendung der OpenAI API. JARVIS / HuggingGPT fungiert wie der zuvor von Meta vorgeschlagene Toolformer als Konnektor. Sogar inklusive ChatGPT-Plugins. Ein Internetnutzer sagte: „Ich vermute stark, dass die erste künstliche allgemeine Intelligenz (AGI) früher als erwartet erscheinen wird. Sie wird auf künstlicher „Klebstoff“-Intelligenz basieren, die eine Reihe enger künstlicher Intelligenz und praktischer Intelligenz intelligent kombinieren kann Werkzeuge werden zusammengeklebt. Ich erhielt Zugriff auf das Add-on, das mich über Nacht von einem Mathe-Neuling zu einem Mathe-Genie verwandelte. Das ist natürlich nur ein kleiner Schritt, aber er ist ein Zeichen für zukünftige Entwicklungstrends. Ich gehe davon aus, dass wir im nächsten Jahr oder so einen KI-Assistenten sehen werden, der mit Dutzenden großer Sprachmodelle (LLMs) und ähnlichen Tools verbunden ist und dem Endbenutzer lediglich Anweisungen geben muss an ihre Assistenten, um Aufgaben für sie zu erledigen. Dieser Science-Fiction-Moment kommt. Einige Internetnutzer sagten, dass dies die zukünftige Forschungsmethode sei. GPT Bei vielen Tools wissen Sie, wie man sie verwendet.  文生图:

文生图: Hugg ingGPT kann integrieren mehrere Eingabeinhalte, um einfache Schlussfolgerungen zu ziehen. Es kann festgestellt werden, dass HuggingGPT auch bei mehreren Aufgabenressourcen die Hauptaufgabe in mehrere Grundaufgaben zerlegen und schließlich die Inferenzergebnisse mehrerer Modelle integrieren kann, um die richtige Antwort zu erhalten.

Hugg ingGPT kann integrieren mehrere Eingabeinhalte, um einfache Schlussfolgerungen zu ziehen. Es kann festgestellt werden, dass HuggingGPT auch bei mehreren Aufgabenressourcen die Hauptaufgabe in mehrere Grundaufgaben zerlegen und schließlich die Inferenzergebnisse mehrerer Modelle integrieren kann, um die richtige Antwort zu erhalten.  Darüber hinaus bewerteten die Forscher die Wirksamkeit von HuggingGPT durch Tests in komplexen Aufgabensituationen .

Darüber hinaus bewerteten die Forscher die Wirksamkeit von HuggingGPT durch Tests in komplexen Aufgabensituationen .

Netizen: Die Zukunft der Forschung

Das obige ist der detaillierte Inhalt vonChatGPT kann Modelle selbst auswählen! Das heiße neue Papier des Microsoft Asia Research Institute und der Zhejiang University, das HuggingGPT-Projekt, ist Open Source. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1371

1371

52

52

Das intelligente Fahrsystem Qiankun ADS3.0 von Huawei wird im August auf den Markt kommen und erstmals auf dem Xiangjie S9 eingeführt

Jul 30, 2024 pm 02:17 PM

Das intelligente Fahrsystem Qiankun ADS3.0 von Huawei wird im August auf den Markt kommen und erstmals auf dem Xiangjie S9 eingeführt

Jul 30, 2024 pm 02:17 PM

Am 29. Juli nahm Yu Chengdong, Huawei-Geschäftsführer, Vorsitzender von Terminal BG und Vorsitzender von Smart Car Solutions BU, an der Übergabezeremonie des 400.000sten Neuwagens von AITO Wenjie teil, hielt eine Rede und kündigte an, dass die Modelle der Wenjie-Serie dies tun werden Dieses Jahr auf den Markt kommen Im August wurde die Huawei Qiankun ADS 3.0-Version auf den Markt gebracht und es ist geplant, die Upgrades sukzessive von August bis September voranzutreiben. Das Xiangjie S9, das am 6. August auf den Markt kommt, wird erstmals mit dem intelligenten Fahrsystem ADS3.0 von Huawei ausgestattet sein. Mit Hilfe von Lidar wird Huawei Qiankun ADS3.0 seine intelligenten Fahrfähigkeiten erheblich verbessern, über integrierte End-to-End-Funktionen verfügen und eine neue End-to-End-Architektur von GOD (allgemeine Hinderniserkennung)/PDP (prädiktiv) einführen Entscheidungsfindung und Kontrolle), Bereitstellung der NCA-Funktion für intelligentes Fahren von Parkplatz zu Parkplatz und Aktualisierung von CAS3.0

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren