Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wie definiere ich das Testphasentraining richtig? Sequentielle Inferenz und domänenadaptive Clustering-Methoden

Wie definiere ich das Testphasentraining richtig? Sequentielle Inferenz und domänenadaptive Clustering-Methoden

Wie definiere ich das Testphasentraining richtig? Sequentielle Inferenz und domänenadaptive Clustering-Methoden

Die Domänenanpassung ist eine wichtige Methode zur Lösung des Transferlernens. Aktuelle Domänenanpassungsmethoden basieren für das synchrone Training auf Originaldomänen- und Zieldomänendaten. Wenn die Quelldomänendaten nicht verfügbar sind und die Zieldomänendaten nicht vollständig sichtbar sind, wird das Testzeittraining zu einer neuen Domänenanpassungsmethode. In der aktuellen Forschung zum Testzeittraining (Test-Time Training, TTT) werden häufig selbstüberwachtes Lernen, kontrastives Lernen, Selbsttraining und andere Methoden eingesetzt. Die Definition von TTT in realen Umgebungen wird jedoch häufig ignoriert, was zu einer mangelnden Vergleichbarkeit zwischen verschiedenen Methoden führt.

Kürzlich haben die South China University of Technology, das A*STAR-Team und das Pengcheng-Labor gemeinsam ein systematisches Klassifizierungskriterium für TTT-Probleme vorgeschlagen, indem unterschieden wird, ob die Methode über sequentielle Inferenzfähigkeiten (Sequential Inference) verfügt und ob das Quelldomänen-Trainingsziel ist muss geändert werden, bietet eine detaillierte Klassifizierung der aktuellen Methoden. Gleichzeitig wird eine Methode vorgeschlagen, die auf der verankerten Clusterung von Zieldomänendaten basiert und die höchste Klassifizierungsgenauigkeit unter verschiedenen TTT-Klassifizierungen erreicht. Dieser Artikel zeigt die richtige Richtung für die nachfolgende Forschung zu TTT auf und vermeidet Verwirrung in experimentellen Umgebungen sind nicht vergleichbar. Die Forschungsarbeit wurde für NeurIPS 2022 angenommen.

- Papier: https://arxiv.org/abs/2206.02721

- Code: https://github.com/Gorilla-Lab-SCUT/TTAC

1. Einleitung Der Erfolg von Deep Learning beruht hauptsächlich auf der großen Menge an annotierten Daten und der Annahme, dass der Trainingssatz und der Testsatz unabhängig und identisch verteilt sind. Wenn es notwendig ist, auf synthetischen Daten zu trainieren und dann auf realen Daten zu testen, können die oben genannten Annahmen im Allgemeinen nicht erfüllt werden, was auch als Domänenverschiebung bezeichnet wird. Um dieses Problem zu lindern, wurde Domain Adaptation (DA) geboren. Bestehende DA-Jobs erfordern während des Trainings entweder Zugriff auf Daten aus den Quell- und Zieldomänen oder trainieren auf mehreren Domänen gleichzeitig. Ersteres erfordert, dass das Modell während des Anpassungstrainings immer Zugriff auf die Daten der Quelldomäne hat, während letzteres teurere Berechnungen erfordert. Um die Abhängigkeit von Quelldomänendaten zu verringern, kann aufgrund von Datenschutzproblemen oder Speicheraufwand nicht auf Quelldomänendaten zugegriffen werden. Die quellenfreie Domänenanpassung (Source-Free Domain Adaptation, SFDA) ohne Quelldomänendaten löst das Domänenanpassungsproblem unzugänglicher Quelldomänendaten. Der Autor stellte fest, dass SFDA über mehrere Runden hinweg auf den gesamten Zieldatensatz trainiert werden muss, um Konvergenz zu erreichen. SFDA kann solche Probleme nicht lösen, wenn es um Streaming-Daten und die Notwendigkeit geht, zeitnahe Inferenzvorhersagen zu treffen. Diese realistischere Einstellung, die eine rechtzeitige Anpassung an das Streaming von Daten und die Erstellung von Inferenzvorhersagen erfordert, wird Test-Time Training (TTT) oder Test-Time Adaptation (TTA) genannt.

Der Autor bemerkte, dass in der Community Verwirrung über die Definition von TTT herrscht, was zu unfairen Vergleichen führt. Das Papier klassifiziert bestehende TTT-Methoden basierend auf zwei Schlüsselfaktoren:

Für Daten, die in einem Streaming-Verfahren angezeigt werden und zeitnahe Vorhersagen zu den aktuell angezeigten Daten treffen müssen, wird es als Ein-Runden-Anpassungsprotokoll (One-Pass) bezeichnet Anpassung); für andere Protokolle, die die oben genannten Einstellungen nicht erfüllen, sogenannte Multi-Pass-Anpassung, muss das Modell möglicherweise für mehrere Runden des gesamten Testsatzes aktualisiert werden, bevor von Anfang bis Ende Inferenzvorhersagen getroffen werden können.

- Ändern Sie die Trainingsverlustgleichung der Quelldomäne je nach Bedarf, z. B. durch die Einführung zusätzlicher selbstüberwachter Zweige, um eine effektivere TTT zu erreichen.

- Das Ziel dieses Artikels ist es, das realistischste und anspruchsvollste TTT-Protokoll zu lösen, nämlich die Anpassung in einer Runde, ohne die Trainingsverlustgleichung zu ändern. Diese Einstellung ähnelt der von TENT [1] vorgeschlagenen TTA, ist jedoch nicht auf die Verwendung einfacher Informationen aus der Quelldomäne beschränkt, z. B. Feature-Statistiken. Angesichts des Ziels von TTT, sich zur Testzeit effizient anzupassen, ist diese Annahme recheneffizient und verbessert die Leistung von TTT erheblich. Die Autoren nannten dieses neue TTT-Protokoll Sequential Test Time Training (sTTT).

Zusätzlich zur oben genannten Klassifizierung verschiedener TTT-Methoden schlägt das Papier auch zwei Technologien vor, um sTTT effektiver und genauer zu machen:

- Das Papier schlägt die Test-Time Anchored Clustering (TTAC)-Methode vor.

- Um die Auswirkungen fehlerhafter Pseudo-Labels auf Cluster-Updates zu reduzieren, filtert das Papier Pseudo-Labels basierend auf der Vorhersagestabilität und dem Vertrauen des Netzwerks in die Stichprobe.

2. Methodeneinführung

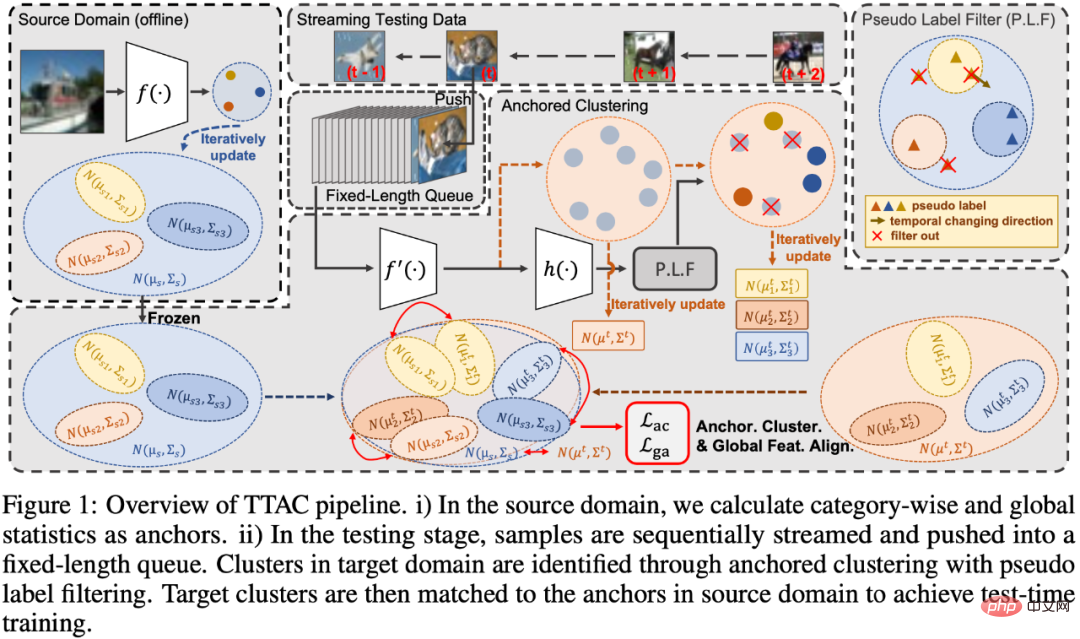

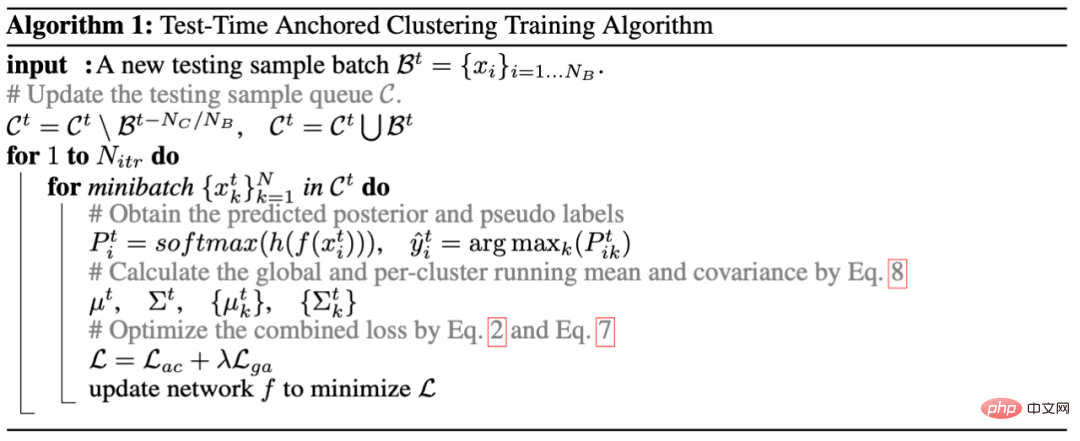

Das Papier ist in vier Teile unterteilt, um die vorgeschlagene Methode zu erläutern. Diese sind 1) Einführung des verankerten Clustering-Moduls des Testzeittrainings (TTT), wie im Teil „Ankered Clustering“ gezeigt Abbildung 1; 2) Stellen Sie einige Strategien zum Filtern von Pseudo-Labels vor, wie z. B. den Pseudo-Label-Filter-Teil in Abbildung 1. 3) Anders als bei der Verwendung des L2-Abstands zur Messung des Abstands zwischen zwei Verteilungen in TTT++ [2] verwendet der Autor die KL-Divergenz Messen Sie den Abstand zwischen zwei Verteilungen. 4) Führen Sie eine effektive iterative Methode zur Aktualisierung der Merkmalsstatistiken im Testzeittrainingsprozess ein. Schließlich gibt der fünfte Abschnitt den Prozesscode des gesamten Algorithmus an.

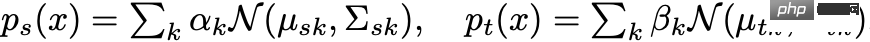

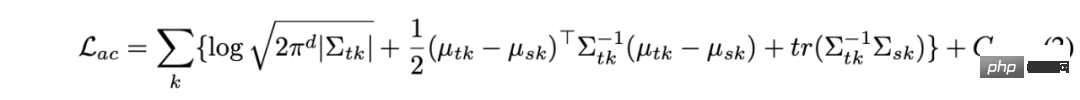

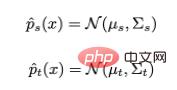

Teil 1 Beim verankerten Clustering verwendet der Autor zunächst eine Mischung aus Gaußschen Funktionen, um die Merkmale der Zieldomäne zu modellieren, wobei jede Gaußsche Komponente einen entdeckten Cluster darstellt. Die Autoren verwenden dann die Verteilung jeder Kategorie in der Quelldomäne als Ankerpunkte für die Verteilung in der Zieldomäne für den Abgleich. Auf diese Weise können Testdatenmerkmale gleichzeitig Cluster bilden, und die Cluster werden Quelldomänenkategorien zugeordnet, wodurch eine Generalisierung auf die Zieldomäne erreicht wird. Zusammenfassend werden die Merkmale der Quelldomäne und der Zieldomäne entsprechend den Kategorieinformationen modelliert:

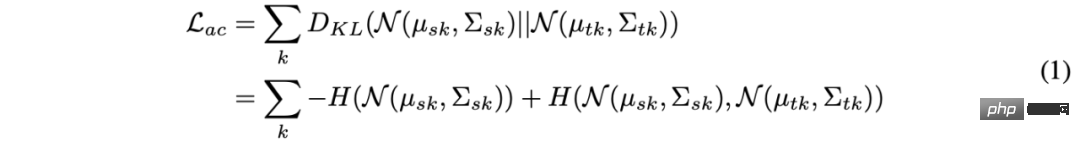

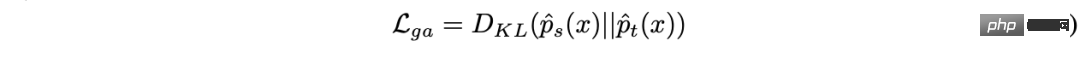

Dann wird der Abstand zwischen zwei gemischten Gaußschen Verteilungen durch KL-Divergenz gemessen und durch Reduzieren der KL-Divergenz-Anpassung erreicht von zwei Domänenmerkmalen. Es gibt jedoch keine geschlossene Lösung zur direkten Lösung der KL-Divergenz auf zwei gemischten Gaußschen Verteilungen, was die Verwendung effektiver Methoden zur Gradientenoptimierung unmöglich macht. In diesem Artikel weist der Autor die gleiche Anzahl von Clustern in den Quell- und Zieldomänen zu, und jeder Zieldomänencluster wird einem Quelldomänencluster zugewiesen, sodass die KL-Divergenzlösung des gesamten gemischten Gaußschen in jedes Paar umgewandelt werden kann Summe von KL-Divergenzen zwischen Gauß-Funktionen. Die Formel lautet wie folgt:

Die geschlossene Lösung der obigen Formel lautet:

In Formel 2 können die Parameter des Quelldomänenclusters offline erfasst werden, und zwar nur in geringem Umfang Bei Statistiken handelt es sich um verwendete Daten, sodass keine Datenschutzprobleme entstehen und nur ein geringer Rechen- und Speicheraufwand entsteht. Für Variablen in der Zieldomäne ist die Verwendung von Pseudo-Labels erforderlich. Zu diesem Zweck hat der Autor eine effektive und einfache Pseudo-Label-Filterstrategie entwickelt.

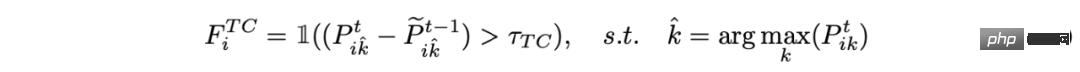

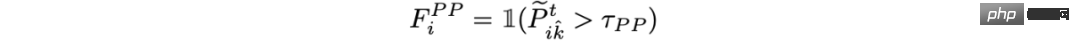

Der zweite Teil der Pseudo-Label-Filterstrategie ist hauptsächlich in zwei Teile unterteilt:

1) Filterung für konsistente Vorhersage in Zeitreihen:

2) Filterung basierend auf der Posterior-Wahrscheinlichkeit:

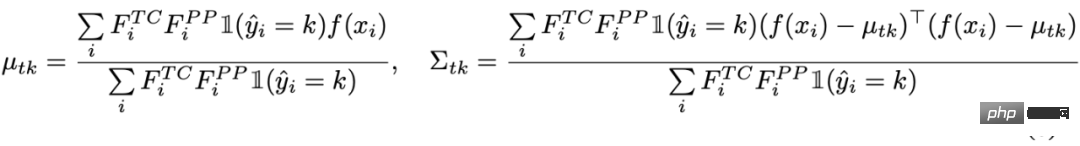

Verwenden Sie abschließend die gefilterten Stichproben, um die Statistiken des Zieldomänenclusters zu ermitteln:

Teil 3: Beim verankerten Clustering nehmen einige gefilterte Stichproben nicht an der Schätzung der Zieldomäne teil. Der Autor führt auch eine globale Merkmalsausrichtung für alle Testproben durch, ähnlich dem Ansatz für Cluster beim verankerten Clustering. Hier werden alle Proben als Gesamtcluster betrachtet, der in der Quelldomäne bzw. der Zieldomäne definiert ist ## 🎜🎜#

Dann richten Sie die globale Merkmalsverteilung erneut auf das Ziel aus, die KL-Divergenz zu minimieren:

Dann richten Sie die globale Merkmalsverteilung erneut auf das Ziel aus, die KL-Divergenz zu minimieren:

#🎜 🎜#

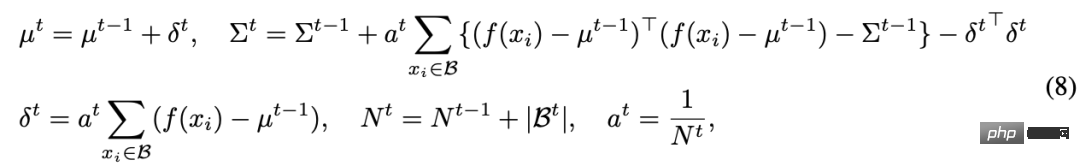

Teil 4 und die oben genannten drei Teile stellen alle einige Domänenausrichtungsmethoden vor, aber im TTT-Prozess ist es nicht einfach, die Verteilung einer Zieldomäne abzuschätzen, da wir sie nicht beobachten können es. Daten für die gesamte Zieldomäne. In einer hochmodernen Arbeit verwendet TTT++ [2] eine Feature-Warteschlange, um vergangene Teilproben zu speichern und eine lokale Verteilung zu berechnen, um die Gesamtverteilung abzuschätzen. Dies führt jedoch nicht nur zu einem Speicheraufwand, sondern führt auch zu einem Kompromiss zwischen Genauigkeit und Speicher. In diesem Artikel schlägt der Autor eine iterative Aktualisierung der Statistiken vor, um den Speicheraufwand zu verringern. Die spezifische iterative Aktualisierungsformel lautet wie folgt:

Im Allgemeinen ist der gesamte Algorithmus wie in Algorithmus 1 unten dargestellt : # 🎜🎜#

3. Experimentelle Ergebnisse

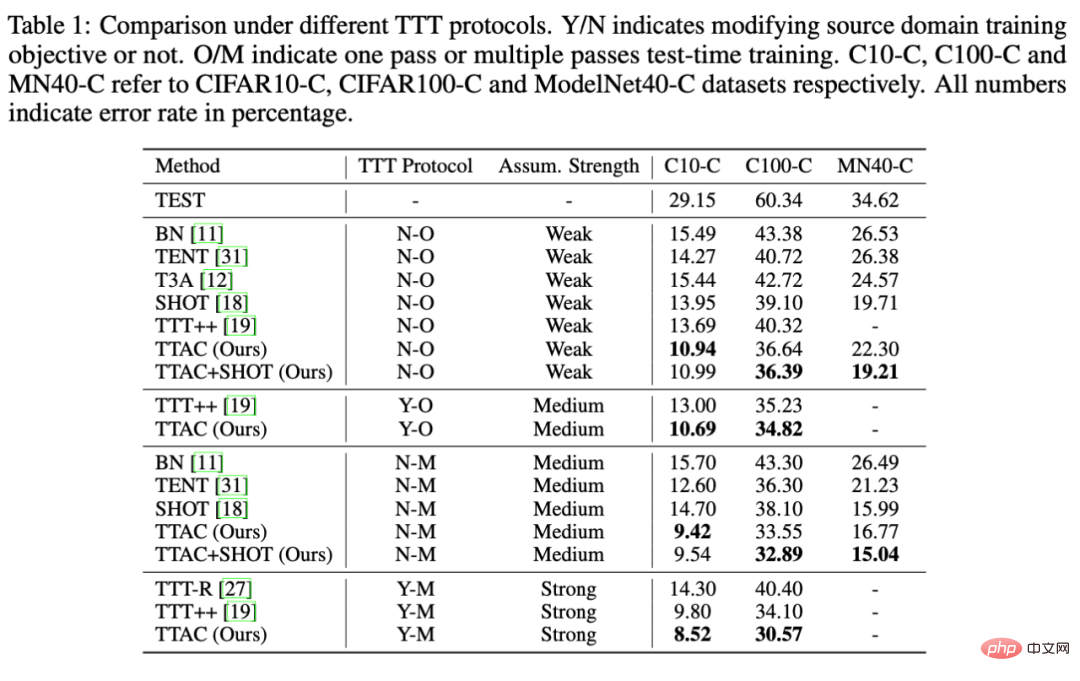

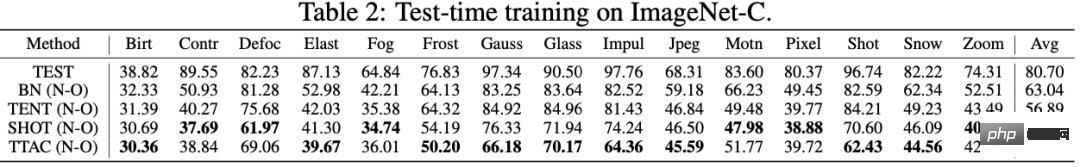

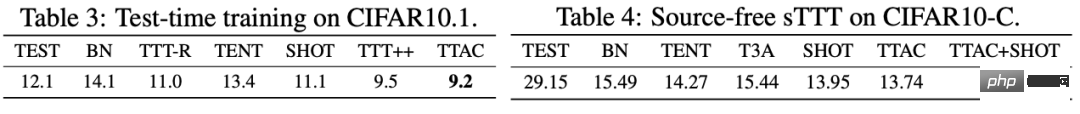

Wie in der Einleitung erwähnt, der Autor von In diesem Artikel wird großer Wert auf einen fairen Vergleich verschiedener Methoden unter verschiedenen TTT-Strategien gelegt. Der Autor klassifiziert alle TTT-Methoden gemäß den folgenden zwei Schlüsselfaktoren: 1) ob ein One-Pass-Anpassungsprotokoll (One-Pass-Anpassung) und 2) die Trainingsverlustgleichung der Quelldomäne modifiziert wird, jeweils als Y/N aufgezeichnet, um anzuzeigen Die Quelldomänen-Trainingsgleichung muss geändert werden oder nicht. O/M steht für eine Einzelrundenanpassung oder Mehrrundenanpassung. Darüber hinaus führte der Autor ausreichende Vergleichsexperimente und einige weitere Analysen an 6 Benchmark-Datensätzen durch.

# 🎜 🎜#

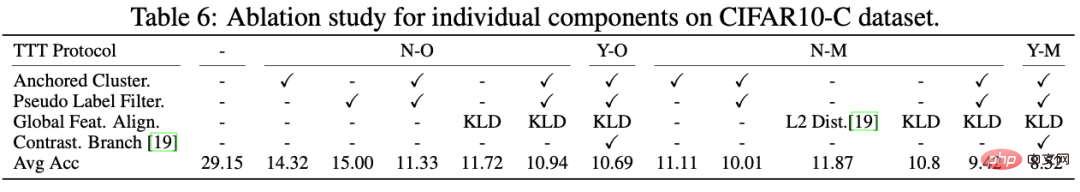

Darüber hinaus führte der Autor strenge Ablationsexperimente unter mehreren TTT-Protokollen gleichzeitig durch und erkannte klar die Rolle jeder Komponente, wie in Tabelle 6 gezeigt. Erstens ist aus dem Vergleich zwischen L2 Dist und KLD ersichtlich, dass die Verwendung der KL-Divergenz zur Messung der beiden Verteilungen einen besseren Effekt hat. Zweitens zeigt sich, dass bei alleiniger Verwendung von Anchored Clustering oder Pseudo-Label-Überwachung die Die Verbesserung beträgt nur 14 %, aber in Kombination mit Anchored Cluster und Pseudo Label Filter können Sie eine deutliche Leistungsverbesserung von 29,15 % -> 11,33 % feststellen. Dies zeigt auch die Notwendigkeit und effektive Kombination der einzelnen Komponenten.

Abschließend analysiert der Autor TTAC am Ende des Textes vollständig aus fünf Dimensionen, einschließlich der kumulativen Leistung unter sTTT (NO), der TSNE-Visualisierung von TTAC-Funktionen, der quelldomänenunabhängigen TTT-Analyse und der Analyse von Testbeispielen Warteschlangen und Aktualisierungsrunden, Rechenaufwand gemessen in Vollzeit. Weitere interessante Beweise und Analysen finden Sie im Anhang des Artikels.

IV. Zusammenfassung

Dieser Artikel stellt nur kurz die Beitragspunkte dieser Arbeit von TTAC vor: Klassifizierungsvergleich bestehender TTT-Methoden, vorgeschlagene Methoden und Experimente unter jeder TTT-Protokollklassifizierung. Eine ausführlichere Diskussion und Analyse finden Sie im Papier und im Anhang. Wir hoffen, dass diese Arbeit einen fairen Maßstab für TTT-Methoden liefern kann und dass zukünftige Studien innerhalb ihrer jeweiligen Protokolle verglichen werden sollten.

Das obige ist der detaillierte Inhalt vonWie definiere ich das Testphasentraining richtig? Sequentielle Inferenz und domänenadaptive Clustering-Methoden. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil