Es wird erwartet, dass die DPU-Entwicklung auf die Überholspur kommt. DPU (Data Processing Unit) gilt nach CPU und GPU als „dritter Hauptchip“. Dank der allmählichen Reife von Smart-Network-Card-Lösungen, dem stetigen Wachstum der weltweiten Lieferungen von Allzweckservern, der Implementierung der intelligenten Fahrfahrzeugtechnologie L3 und höher und der steigenden Nachfrage im Bereich der industriellen Steuerung sind die globalen und inländischen DPU-Industrien gewachsen eine schnelle Entwicklung erwartet.

Der globale DPU-Markt boomt weiterhin und der inländische DPU-Markt holt immer schneller auf. Laut dem „China DPU Industry Development White Paper“ von CCID Consulting wird die globale Marktgröße der DPU-Industrie im Jahr 2020 3,05 Milliarden US-Dollar erreichen, und es wird erwartet, dass dies auch der Fall sein wird bis 2025 24,53 Milliarden US-Dollar übersteigen. Die durchschnittliche Wachstumsrate erreichte 51,73 %.

Die Marktgröße der chinesischen DPU-Industrie erreichte im Jahr 2020 390 Millionen Yuan. Es wird erwartet, dass die Marktgröße der chinesischen DPU-Industrie bis 2025 56,59 Milliarden Yuan überschreiten wird, mit einer durchschnittlichen Wachstumsrate von 170,6 %.

DPU-Industriekettenanalyse:

DPU-Midstream-Link (DPU-Chiphersteller): Übersee-Giganten liegen vorübergehend an der Spitze, und inländische Hersteller sind bereit zu gehen. Nach Angaben des Toubao Research Institute erreichten die Anteile der drei internationalen Giganten NVIDIA, Broadcom und Intel im inländischen DPU-Markt im Jahr 2020 jeweils 55 %, 36 % und 9 %. Unter den inländischen Herstellern haben Huawei, Alibaba, Baidu und Tencent in den letzten Jahren auch selbst entwickelte und ausgelagerte DPUs für ihre eigenen Server durchgeführt. Die Hauptfunktionen sind Daten, Speicherung und Sicherheit.

DPU-Upstream-Links: EDA, IP usw. sind wichtige Grundlagen für Forschung und Entwicklung. Der heimische EDA-Markt wird seit langem von den drei internationalen Giganten dominiert und dürfte in Zukunft einen Durchbruch erleben. Angebot und Nachfrage arbeiten zusammen, um die IP-Kernbranche zu fördern, und die zukünftige Nachfrage wird neue Kanäle eröffnen. Die Lokalisierung von Halbleitern schreitet weiter voran, und inländische IP-Anbieter werden die Hochebene des Knappheitswerts einnehmen, darunter Cambrian, VeriSilicon usw.

DPU-Downstream-Anwendungen: mehrere Blüten, glänzende Zukunftsaussichten. Der Kernmarkt für DPUs dreht sich um Rechenzentren mit Servern als Hardwareträgern, und nachgelagerte Szenarien umfassen Cloud Computing, Hochleistungsrechnen, Netzwerksicherheit, Edge Computing und andere Bereiche. Aus der Sicht unseres Landes entstehen ständig verschiedene Szenarien für den Bedarf an Rechenleistung wie Hochtechnologie und neue Technologien, digitale Transformation und Terminalverbrauch, wobei der Effekt der Stärkung der Rechenleistung im Vordergrund steht.

ChatGPT und andere KI-Technologie-Entwicklungstrends, die Nachfrage nach Rechenleistung wird hervorgehoben, DPU wird voraussichtlich eine goldene Entwicklungsperiode einläuten, die globale und inländische Marktgröße der DPU-Industrie zeigt einen Trend, der von Jahr zu Jahr zunimmt Es wird erwartet, dass Kernunternehmen vom Branchenentwicklungstrend profitieren werden.

DPU (Datenverarbeitungschip Data Process Unit) wird in Betracht gezogen Der „dritte Hauptchip“ nach CPU und GPU. DPU (Data Processing Unit) ist ein neu entwickelter Spezialprozessor. In der 2020 von NVIDIA veröffentlichten DPU-Produktstrategie wird er nach CPU und GPU als „dritter Hauptchip“ im Rechenzentrum positioniert. Mit der kontinuierlichen Verbesserung der Herstellungsprozesse in der Chipindustrie und der Entwicklung digitaler Technologien wie KI setzt die Chipindustrie ihre Innovationen fort. Als neuer Chiptyp ist das Aufkommen der DPU ein Meilenstein im heterogenen Computing.

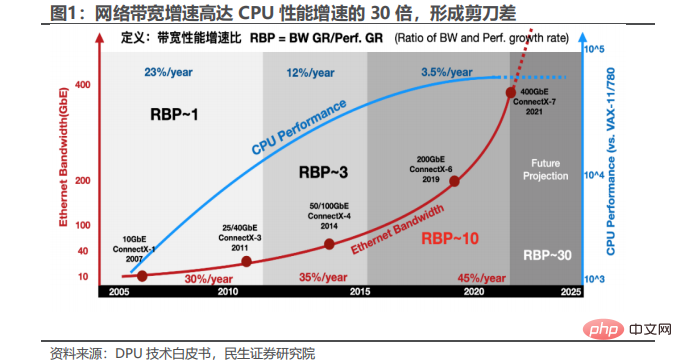

1. Es besteht eine Scherenlücke zwischen der Verbesserung der Rechenleistung und dem Datenwachstum, und die Nachfrage nach DPU wird hervorgehoben

DPU ist eine dedizierte Datenverarbeitungseinheit, deren Kern die Datenverarbeitung ist. Sie ist eine Auslagerungsplattform für Netzwerk, Sicherheit und Speicherung herkömmlicher Computerressourcen. Herkömmliche Rechenzentren nutzen die CPU als Hauptdatenverarbeitungseinheit, und der Betrieb der riesigen Infrastruktur belegt in der Regel einen erheblichen Teil der CPU-Kerne, was große Herausforderungen an die Datenverarbeitungsaufgaben stellt.

DPU ist tatsächlich schon seit langer Zeit in der Branche tätig, angefangen bei der frühen Auslagerung der Netzwerkprotokollverarbeitung bis hin zur anschließenden Auslagerung von Netzwerk, Speicher und Virtualisierung.

Laut Riesenraddaten hat Amazons AWS bereits 2013 das Nitro-Produkt entwickelt, das den gesamten Rechenzentrumsaufwand abdeckt (Bereitstellung von Remote-Ressourcen für virtuelle Maschinen, Ver- und Entschlüsselung, Fehlerverfolgung, Sicherheitsrichtlinien und mehr). (Dienstprogramme) Stellen Sie es zur Ausführung auf einen dedizierten Beschleuniger. Die Nitro-Architektur verwendet einen leichten Hypervisor und angepasste Hardware, um die Rechen- (hauptsächlich CPU und Speicher) und E/A-Subsysteme (hauptsächlich Netzwerk und Speicher) der virtuellen Maschine zu trennen und sie über den PCIe-Bus zu verbinden, wodurch 30 % der CPU-Ressourcen eingespart werden.

In den Jahren 2016-2017 schlug Alibaba Cloud die X-Dragon-Systemarchitektur vor, deren Kern die MOC-Karte ist und die über eine relativ umfangreiche externe Schnittstelle verfügt, einschließlich Rechenressourcen, Speicherressourcen und Netzwerkressourcen. X-Dragon SOC, der Kern der MOC-Karte, unterstützt einheitlich die Virtualisierung von Netzwerk, I/O, Speicher und Peripheriegeräten und bietet einen einheitlichen Ressourcenpool für virtuelle Maschinen, Bare-Metal- und Container-Clouds.

Nach Angaben von NetEase und Xinxixi brachte Fungible, ein amerikanisches Startup-Unternehmen, 2019 das Produkt F1DPU auf den Markt und schlug damit erstmals das Konzept der DPU vor. Im Oktober 2020 benannte NVIDIA die Smart NIC basierend auf der Mellanox-Lösung DPU und definierte damit das Konzept der DPU neu. Im Jahr 2020 positionierte Nvidia die DPU-Produktstrategie als „dritten Hauptchip“ im Rechenzentrum nach CPU und GPU und löste damit einen Hype in der Branche aus.

2. Mit dem Ziel, Kosten zu senken und die Effizienz zu steigern, geht DPU direkt an den Schwachstellen der Branche an.

Das Kernproblem, das DPU lösen möchte, ist die „Kostenreduzierung und „Effizienzverbesserung“ der Infrastruktur, also „CPU-Verarbeitung“. Lasten, die ineffizient sind und nicht von der GPU verarbeitet werden können, werden auf die dedizierte DPU verlagert, wodurch die Effizienz des gesamten Computersystems verbessert und die Gesamtbetriebskosten (TCO) gesenkt werden. des Gesamtsystems.

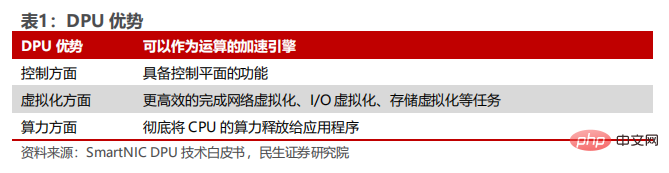

Übermäßige CPU-Ressourcenauslastung ist ein Problem in der Branche, und intelligente Netzwerkkarten (Smart NIC) sind die Vorgänger von DPU. Im Bereich der Kommunikation hat mit dem Aufkommen der Ära von 5G, der Integration von Cloud-Netzwerken und der Einführung von Technologien wie virtuellem Switching die Komplexität der serverbasierten Netzwerkdatenebene dramatisch zugenommen. Eine enorme Datenübertragungsarbeit wird von der CPU getragen, was zu einem starken Anstieg der Netzwerkschnittstellenbandbreite und einer übermäßigen CPU-Ressourcenbelastung führt, was sich stark auf die Fähigkeit der CPU auswirkt, Rechenleistung in Anwendungen freizugeben, um die Verarbeitungsleistung der Host-CPU zu verbessern. Smart NIC (intelligente Netzwerkkarte) überträgt einige Netzwerkfunktionen der CPU (z. B. IP-Fragmentierung, TCP-Segmentierung usw.) zur Beschleunigung des Betriebs auf die Netzwerkkartenhardware. Sie kann als Vorgänger der DPU angesehen werden . Der Vorteil der neuen DPU-Generation besteht darin, dass sie nicht nur als Beschleunigungsmotor für die Datenverarbeitung dienen kann, sondern auch die Funktion einer Steuerebene hat, die Aufgaben wie Netzwerkvirtualisierung, E/A-Virtualisierung und Speicherung effizienter erledigen kann Virtualisierung, und nutzen Sie die Rechenleistung der CPU vollständig für die Anwendung.

In Bezug auf Funktionen hat DPU Basisdienste, Netzwerkdatenbeschleunigung, Zero-Trust-Schutz, Computing und Speicherung integriert Trennung usw. Funktion. Es kann viele Probleme effektiv lösen, wie z. B. die Unfähigkeit, die aktuelle CPU-Rechenleistung vollständig auf Anwendungen anzuwenden, langsame Datenverarbeitungsgeschwindigkeit, durch Kredite verursachte Datenlecks und schlechte Kompatibilität von Speicherlösungen. Konkret:

1. DPU realisiert die operative Trennung von Geschäft und Infrastruktur. DPU überträgt Infrastrukturaufgaben von der CPU auf die DPU und setzt so CPU-Ressourcen frei, sodass mehr Server-CPU-Kerne zum Ausführen von Anwendungen und zum Abschließen von Geschäftsberechnungen verwendet werden können, wodurch die Effizienz von Servern und Rechenzentren verbessert wird.

2.DPU lädt Netzwerkdaten aus, um die Leistung zu verbessern. DPU ist für Cloud-native Umgebungen optimiert und bietet softwaredefinierte und hardwarebeschleunigte Netzwerk-, Speicher-, Sicherheits- und Verwaltungsdienste auf Rechenzentrumsebene. Laut Programmer Inn-Daten nutzt die Container-Cloud-Plattform als Service (PaaS) 0penShift von Red Hat DPU, um die Ressourcennutzung im Rechenzentrum zu optimieren und netzwerkbezogene Datenverarbeitung (wie VxLan und IPSec usw.) auf DPU auszulagern, um die Ausführung zu beschleunigen. Unter 25-Gbit/s-Netzwerkbedingungen setzt Open Shift DPU zur Beschleunigung ein und kann eine Leistung von 25 Gbit/s mit nur 1/3 der CPU-Auslastung erreichen. Unter 100-Gbit/s-Netzwerkbedingungen erreicht das Szenario jedoch 25 Gbit/s Bei einer Netzwerkleitungsgeschwindigkeit von weniger als 100 Gbit/s kann die DPU einen zehnfachen Leistungsvorteil bringen.

3.DPU kann einen Zero-Trust-Sicherheitsschutz bieten. Zero Trust ist ein sicherheitszentriertes Modell, das auf der Idee basiert, dass Unternehmen keinen Standard für alles innerhalb oder außerhalb von Trust-Optionen gewähren sollten. Zero Trust kann Datenlecks reduzieren und unbefugten Zugriff verhindern und ist daher für die Datensicherheit von großem Wert.

Methode: DPU bietet Zero-Trust-Schutz für Unternehmen, indem die Steuerungsebene vom Host zur DPU dezentralisiert wird, wodurch eine vollständige Isolierung des Host-Geschäfts und der Steuerungsebene erreicht wird und Daten nicht eindringen können. Gewährleistung der Sicherheit.

Das Aufkommen von DPU entspricht der Ausstattung jedes Servers mit einem „Computer vor dem Computer“, um unabhängige, sichere Infrastrukturdienste und sichere Isolierung von der Serveranwendungsdomäne bereitzustellen. Wenn ein Host kompromittiert wird, verhindert die DPU-Isolationsschicht zwischen dem Sicherheitskontrollagenten und dem kompromittierten Host, dass sich der Angriff im gesamten Rechenzentrum ausbreitet. Auf diese Weise löst DPU die Situation, in der Unternehmen nicht bereit sind, Sicherheitsagenten direkt auf der Computerplattform bereitzustellen. Durch die Bereitstellung von Sicherheitsagenten auf DPUs, die vollständig von Anwendungsdomänen isoliert sind, erhalten Unternehmen Einblick in die Anwendungs-Workloads und können konsistente Sicherheitsrichtlinien in ihrer gesamten Infrastruktur durchsetzen.

4. Die technische Lösung BlueField SNAP führt Rechenressourcen am Dateneingang des Serversystems ein und implementiert unabhängig Speicherlösungen, die den Anwendungsanforderungen auf der DPU entsprechen, und hilft so Speicherherstellern bei der Datenerfassung Center: Erweiterte Speicherprotokolle zu geringen bis mittleren Kosten flexibel bereitstellen und aktualisieren, ohne dass Änderungen am vorhandenen Software-Stack erforderlich sind. Speicherhersteller können Open-System-Direct-Attached-Storage (DAS), vertikale Erweiterung (Scale-up), horizontale Erweiterung (Scale-out), hyperkonvergente Architektur (Hyperconverged) und andere von ihren eigenen Teams entwickelte Speicherlösungen für verschiedene Branchenanwendungen verwenden kann ohne Overhead auf bestehende Geschäftsverarbeitungsplattformen und Rechenzentrumsinfrastrukturen in verschiedenen Anwendungsbereichen erweitert werden, und alle komplexen und notwendigen Funktionen wie Sicherheitsverschlüsselung, Datenkomprimierung und Lastausgleich werden vollständig transparent von der DPU ausgelagert. Die innovativen Algorithmen und Implementierungen der Speicherbranche können unabhängig vom Serverbetriebssystem in der DPU-Architektur eingesetzt werden. Die DPU-Technologie hilft Speicherherstellern dabei, eine echte „Rechen- und Speichertrennung“ zu erreichen, die technischen Vorteile ihrer eigenen Produkte voll auszuschöpfen und Kanäle zu öffnen, um Anwendungsanforderungen möglichst effizient zu erfüllen.

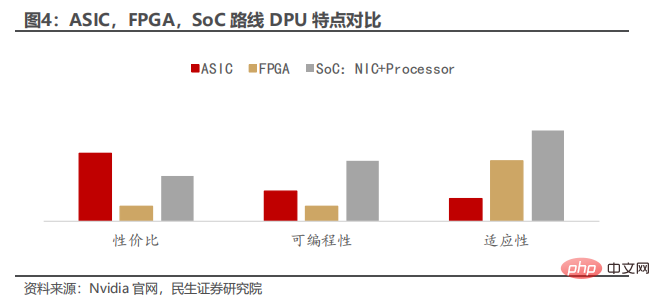

3. FPGA- und Hybridarchitektur-Routen sind die gängigen Typen wie ASIC- und FPGA-basierte Smart-Netzwerkkarten. Mit der Weiterentwicklung der Technologie verschmelzen FPGAs, ASICs und SoCs miteinander und die Grenzen zwischen ihnen verschwimmen zunehmend. Mit der Entwicklung von FPGAs integrieren beispielsweise viele FPGAs einen ASIC im herkömmlichen Sinne. Aus Sicht der Hardware-Programmierbarkeit ist SoC das Gegenteil von FPGA und kann hier als ASIC betrachtet werden bezieht sich hauptsächlich auf Hardware, die nicht programmierbar ist, und nicht nur auf einen bestimmten Funktionschip.

NIC steht für Network Interface Card. Im Wesentlichen handelt es sich bei einer NIC um eine PCIe-Karte, die an einen Server oder eine Speicherbox angeschlossen wird, um eine Verbindung zu einem Ethernet-Netzwerk herzustellen. DPU-basierte Smart-NICs gehen über die einfache Konnektivität hinaus und implementieren im Fall einer Basis-NIC die Verarbeitung des Netzwerkverkehrs, die die CPU auf der NIC durchführen muss.

DPU-basierte Smart NICs können ASIC-, FPGA- und SoC-basiert sein. Es gibt verschiedene Kompromisse zwischen diesen verschiedenen Routen hinsichtlich Kosten, einfacher Programmierung und Flexibilität. 1) ASICs sind kostengünstig und bieten möglicherweise das beste Preis-Leistungs-Verhältnis, verfügen jedoch über eine begrenzte Flexibilität. ASIC-basierte NICs wie der NVIDIA ConnectX-5 können über relativ einfache programmierbare Datenpfade verfügen. Letztendlich ist die Funktionalität aufgrund der im ASIC definierten Fähigkeiten eingeschränkt, was möglicherweise die Unterstützung bestimmter Workloads verhindert. 2) Im Gegensatz dazu sind FPGA-NICs (wie NVIDIA Innova-2 Flex) hochgradig programmierbar. Bei genügend Zeit und Aufwand kann nahezu jede Funktion im Rahmen der verfügbaren Gates relativ effizient unterstützt werden. Allerdings sind FPGAs bekanntermaßen schwierig und teuer zu programmieren. 3) Für komplexere Anwendungsfälle bieten SOCs wie die Mellanox BlueField DPU – Programmable Smart NIC die scheinbar beste DPU-basierte Smart NIC-Implementierung.

4. Der Kernwert von DPU liegt in der Auslagerung, Freigabe und Erweiterung der Rechenleistung Heterogene Rechenleistung fördert mehr DPU. Das Feld entwickelt sich rasant die Rechenleistung der CPU für einige Anwendungen. Ein Teil des Wertes der DPU spiegelt sich in den Kosteneinsparungen dieses Teils der Rechenleistung wider – den Kosten der DPU selbst. Je mehr Rechenleistung die DPU einspart oder je niedriger die Kosten der DPU sind, desto höher ist der Wert, den sie bringt. Gleichzeitig wird aufgrund der Spezialisierung der DPU die Geschäftsleistung verbessert, nachdem die DPU einige Kontrollfunktionen im Zusammenhang mit Netzwerk, Speicher, Sicherheit und Verwaltung ausgelagert hat. Daher liegt ein weiterer Teil des Werts der DPU in der Es kann Zeit für das Unternehmen und die Benutzererfahrung sparen.

4. Der Kernwert von DPU liegt in der Auslagerung, Freigabe und Erweiterung der Rechenleistung Heterogene Rechenleistung fördert mehr DPU. Das Feld entwickelt sich rasant die Rechenleistung der CPU für einige Anwendungen. Ein Teil des Wertes der DPU spiegelt sich in den Kosteneinsparungen dieses Teils der Rechenleistung wider – den Kosten der DPU selbst. Je mehr Rechenleistung die DPU einspart oder je niedriger die Kosten der DPU sind, desto höher ist der Wert, den sie bringt. Gleichzeitig wird aufgrund der Spezialisierung der DPU die Geschäftsleistung verbessert, nachdem die DPU einige Kontrollfunktionen im Zusammenhang mit Netzwerk, Speicher, Sicherheit und Verwaltung ausgelagert hat. Daher liegt ein weiterer Teil des Werts der DPU in der Es kann Zeit für das Unternehmen und die Benutzererfahrung sparen.

2. Laut Daten der China Academy of Information and Communications Technology, Rechenleistungsfreigabe: Die Rechenleistungsfreigabe erfordert keinen mehrfachen CPU-Eingriff, um auf Speicher und Peripheriegeräte zuzugreifen, unnötige Datenübertragungen, Kopiervorgänge und Kontextwechsel zu vermeiden und die Daten direkt zu vervollständigen Die Verarbeitung erfolgt auf der Netzwerkkarten-Hardware und wird an die Anwendung übermittelt, die die Daten letztendlich verbraucht. Die traditionelle CPU-zentrierte Computerarchitektur muss während der Datenverarbeitung mehrmals Daten zwischen dem Kernel und der Anwendung kopieren und darauf zugreifen, was zu enormen Leistungsverlusten führt. Die datenzentrierte DPU-Architektur kann das Problem einer übermäßigen CPU-Beteiligung an der Datenverarbeitung effektiv lösen. Die CPU muss nicht am Datenverarbeitungsprozess teilnehmen, und die Daten werden direkt an die Anwendung, die zugehörige GPU oder das Speichergerät gesendet, was möglich ist Vermeiden Sie effektiv Leistungsengpässe und Ausnahmen, die durch übermäßige CPU-Auslastung verursacht werden.

DPU-Architektur und -Technologie ermöglichen es Geschäftsanwendungen und Betriebssystemkernen, die auf Servern laufen, mithilfe einfacher lokaler Speicherzugriffs-APIs einen effizienten und transparenten Zugriff auf verteilte, hyperkonvergente oder softwaredefinierte Speichersysteme zu erreichen. Speicherhersteller können Direct-Attached Storage (DAS), vertikale Erweiterung (Scale-up), horizontale Erweiterung (Scale-out), hyperkonvergente Architektur (Hyperconverged) und andere Speicherlösungen, die für verschiedene Branchenanwendungen entwickelt wurden, kostenlos im bestehenden Geschäft fördern Verarbeitungsplattformen und Rechenzentrumsinfrastruktur in verschiedenen Anwendungsbereichen werden alle komplexen und notwendigen Funktionen wie Sicherheitsverschlüsselung, Datenkomprimierung und Lastausgleich vollständig transparent von der DPU ausgelagert. Die innovativen Algorithmen und Implementierungen der Speicherbranche können unabhängig vom Serverbetriebssystem in einer DPU-Architektur eingesetzt werden.

DPU-Technologie hilft Speicherherstellern, eine echte „Trennung von Computer und Speicher“ zu erreichen, die technischen Vorteile ihrer eigenen Produkte voll auszuschöpfen und den effizientesten Weg zur Erfüllung der Anwendungsanforderungen zu eröffnen.

3. Erweiterung der Rechenleistung: Durch die Erweiterung der Rechenleistung werden Engpässe bei der knotenübergreifenden Netzwerkkommunikation beseitigt, indem Überlastungen wirksam vermieden, der Anteil der zeitaufwändigen Kommunikation im Aufgabenzyklus verteilter Anwendungen erheblich reduziert und der gesamte Rechencluster im großen Maßstab verbessert wird Cluster-Rechenleistung. Um die Rechenleistung zu verbessern, entwickelt sich die Branche auf mehreren Wegen weiter. Für Allzweck-CPUs ist es schwierig, die Rechenleistung weiterhin deutlich zu steigern, indem sie die Single-Core- und Single-Thread-Leistung verbessern und On-Chip-Multi-Cores erweitern. Nachdem der Prozess der Single-Core-Chips auf 3 nm aufgerüstet wurde, verlangsamte sich die Entwicklung durch die Überlagerung mehrerer Kerne, um die Rechenleistung zu erhöhen. Mit zunehmender Anzahl der Kerne wird auch der Stromverbrauch pro Rechenleistungseinheit deutlich ansteigen 256 Kerne, die Gesamtrechenleistung kann nicht linear verbessert werden. Die Prozessentwicklung von Recheneinheiten hat sich dem Grundniveau angenähert. Um den Bedarf an großer Rechenleistung zu decken, sind die Erweiterung des Umfangs von Rechenclustern, die Erhöhung der Netzwerkbandbreite und die Reduzierung der Netzwerklatenz durch verteilte Systeme zu den wichtigsten Mitteln zur Verbesserung der Rechenleistung geworden von Rechenzentrumsclustern.

5. DPU treibt die Verbindung heterogener Rechenleistung voran, und der Anwendungsmarkt deckt viele Bereiche der High-Tech-Industrie ab.

Unter der Verbindung heterogener Rechenleistung versteht man die Datenverbindung zwischen GPU, FPGA, ASIC oder anderen Beschleunigerkarten und der CPU. Die Chip-Verbindungstechnologie zwischen der CPU und der Beschleunigerkarte sowie zwischen der Beschleunigerkarte wird zunehmend übernommen. Obwohl PCIe ein weit verbreitetes standardisiertes Design aufweist, führt die begrenzte Bandbreite zu Engpässen. Verbindungstechnologien der nächsten Generation wie CXL und Gen-Z haben eine schnelle Entwicklung erreicht. Als Sandbox für die Integration verschiedener Hochgeschwindigkeits-Verbindungsprotokolle ist DPU am besten geeignet, durch die Einführung und Erweiterung ein flexibler Hochgeschwindigkeits-Verbindungsträger zu werden. speicherzentriert“ Das Verbindungsprotokoll bietet die Möglichkeit, die Latenztechnologie im Submikrosekundenbereich über ein einzelnes Gehäuse hinaus zu erweitern und so Möglichkeiten für Innovationen in der Computerarchitektur der nächsten Generation zu schaffen.

Mit der Vertiefung der Informationskonstruktion und -anwendung wächst der Markt weiter und die Nachfrage nach DPU-Industrieanwendungen in den Bereichen Telekommunikation, Internet, intelligentes Fahren, KI-Server und anderen Branchen wächst weiter.

1) Im Bereich der Telekommunikation sind die drei großen Betreiber aktiv im Einsatz, fördern die Produktverifizierung und sind bereit, mit Herstellern in der Industriekette zusammenzuarbeiten, um die Entwicklung der DPU-Branche voranzutreiben.

2) Im Internetbereich hat DPU angesichts der Entwicklungsanforderungen von Cloud Computing, Cloud Native und anderen Geschäftsszenarien als Schwerpunkt der Rechenzentrumsentwicklung große Aufmerksamkeit von großen Cloud-Anbietern erhalten. Führende Hersteller haben Ressourcen in Eigenforschung oder strategische Zusammenarbeit investiert, um Kosten zu senken und die Effizienz zu steigern und so den Nutzen zu maximieren.

3) Im Bereich des intelligenten Fahrens beschleunigen in- und ausländische Chiphersteller den Einsatz des intelligenten Fahrens, verbessern kontinuierlich die Forschungs- und Entwicklungseffizienz und legen den Grundstein für die Marktentwicklung von DPU.

4) In Bezug auf KI-Server und andere Bereiche entwickeln sich Chinas KI-Server, Finanzen, Terminalregierungsunternehmen und andere Bereiche unter dem Einfluss von Richtlinien wie der digitalen Wirtschaft und „Eastern Digital and Western Counting“ weiterhin rasant und die Nachfrage steigt Da die Rechenleistung weiter zunimmt, kann die DPU den aktuellen Geschäftsentwicklungsanforderungen nicht mehr gerecht werden, die Effizienz des gesamten Systems verbessern und technische Unterstützung für die Entwicklung von KI-Servern, Finanzen und anderen Bereichen bieten und den zukünftigen Entwicklungsprozess der DPU-Branche umfassend fördern.

Das obige ist der detaillierte Inhalt vonWelche Funken entstehen bei der Rechenleistungseffizienz, wenn DPU mit ChatGPT kollidiert?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Was tun, wenn die CPU-Temperatur zu hoch ist?

Was tun, wenn die CPU-Temperatur zu hoch ist?

Ein Speicher, der Informationen direkt mit der CPU austauschen kann, ist ein

Ein Speicher, der Informationen direkt mit der CPU austauschen kann, ist ein

Die Hauptkomponenten, aus denen die CPU besteht

Die Hauptkomponenten, aus denen die CPU besteht

ChatGPT-Registrierung

ChatGPT-Registrierung

Was sind die Konfigurationsparameter des Videoservers?

Was sind die Konfigurationsparameter des Videoservers?

Inländische kostenlose ChatGPT-Enzyklopädie

Inländische kostenlose ChatGPT-Enzyklopädie

So beheben Sie einen CPU-Lüfterfehler

So beheben Sie einen CPU-Lüfterfehler

Was tun, wenn die CPU-Auslastung zu hoch ist?

Was tun, wenn die CPU-Auslastung zu hoch ist?