Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

GPT-4-Chef: Keine Panik, ich habe einen Plan, die Zukunft von AGI ist wirklich rosig!

GPT-4-Chef: Keine Panik, ich habe einen Plan, die Zukunft von AGI ist wirklich rosig!

GPT-4-Chef: Keine Panik, ich habe einen Plan, die Zukunft von AGI ist wirklich rosig!

Der Chatbot von OpenAI schockierte die Welt.

Aber wenn die Leute erkennen, dass diese Technologie auch eine Möglichkeit ist, Desinformation zu verbreiten und Menschen zu gefährlichen Dingen zu überreden, werfen einige Kritiker Ultraman rücksichtsloses Verhalten vor.

Viele Branchenführer, Forscher im Bereich der künstlichen Intelligenz und Akademiker betrachten ChatGPT als einen grundlegenden technologischen Wandel, der ebenso bedeutsam ist wie die Geburt des Webbrowsers oder des iPhone. Über die Zukunft der Technologie sind sich jedoch nur wenige einig.

Manche Leute glauben, dass dadurch eine Utopie entstehen wird, in der jeder die Zeit und das Geld hat, die er braucht. Andere glauben, dass es die Menschheit zerstören könnte. Andere verbringen einen Großteil ihrer Zeit damit, zu argumentieren, dass die Technologie niemals so leistungsfähig sein wird, wie alle behaupten, und bestehen darauf, dass weder das Nirvana noch das Ende der Welt noch in weiter Ferne liegen.

In der vergangenen Woche haben mehr als tausend Experten für künstliche Intelligenz und Technologieführer OpenAI und andere Unternehmen aufgefordert, ihre Arbeit an Systemen wie ChatGPT einzustellen, mit der Begründung, dass diese „tiefgreifende Konsequenzen für die Gesellschaft und die Menschheit haben“. „Risiko“.

Als CEO von OpenAI verkörpert Altman auf irgendeine Weise jede dieser scheinbar widersprüchlichen Ansichten, während er hofft, diese seltsame, leistungsstarke und fehlerhafte Technologie in die Zukunft zu bringen und gleichzeitig unzählige Möglichkeiten abzuwägen.

Das bedeutet, dass er ständig von allen Seiten kritisiert wird. Aber Greg Brockman, Präsident von OpenAI, hält das für angemessen: „Wenn man Menschen in beiden Extremen gleichermaßen Unbehagen bereitet, dann macht man etwas richtig.“

Manhattan-Projektleiter Robert Oppenheimer glaubt, dass die Atombombe unvermeidlich ist Produkt des wissenschaftlichen Fortschritts, und Ultraman und Oppenheimer haben denselben Geburtstag. Als er über die Technologie von OpenAI sprach, zitierte ihn Altman auch mit den Worten: „Technologie entsteht, weil sie möglich ist, und sie wird Dinge bewirken, die nicht einmal er sich vorstellen kann.“ Wir können Wege finden, den Schaden, den es verursachen kann, zu mildern.

Diese Einstellung spiegelt Ultramans eigenen Entwicklungsweg wider. Er kletterte ziemlich stetig auf dem Weg zu Erfolg und Reichtum, angetrieben von effektiven persönlichen Fähigkeiten. Es macht Sinn, dass er glaubt, dass gute Dinge passieren werden.

Allerdings sagte er auch, dass es für den Fall, dass er sich irrt, einen Ausweg gibt: In seinem Vertrag mit Investoren wie Microsoft behält sich der Vorstand von OpenAI das Recht vor, die Technologie jederzeit abzuschalten.

Selbstzieher

Ultraman ist ein Mensch, der in einem Widerspruch lebt. Er ist Vegetarier, züchtet aber Kühe.

Wenn er über die von seinem Unternehmen entwickelte Technologie spricht, glaubt er, dass Technologie „einige unserer dringendsten Probleme lösen, den Lebensstandard wirklich verbessern und den menschlichen Willen und die Kreativität besser nutzen wird“. , er ist sich nicht ganz sicher, welche Probleme es lösen wird. Gleichzeitig befürchtet er, dass die Technologie ernsthaften Schaden anrichten könnte, wenn sie in die Hände autoritärer Regierungen gerät.

Kelly Sims, Partnerin bei der Risikokapitalgesellschaft Thrive Capital, die mit Altman als Vorstandsberaterin bei OpenAI zusammenarbeitete, sagte, er habe das Gefühl, ständig mit sich selbst zu streiten: „In Gesprächen stand er selbst auf beiden Seiten der Debatte .“

Die Frage ist, ob die beiden Seiten von Ultraman letztendlich kompatibel sind: Ist es sinnvoll, der Zeit voraus zu sein, wenn es in einer Katastrophe enden könnte? Ultraman ist natürlich gespannt, wie das passieren kann.

Als Präsident des Silicon Valley Startup Accelerator und Seed-Investors Y Combinator von 2014 bis 2019 beriet er einen stetigen Strom neuer Unternehmen und investierte klugerweise in mehrere, die heute bekannte Namen sind, darunter Airbnb, Reddit und Stripe.

Er ist stolz darauf, erkennen zu können, ob eine Technologie ein exponentielles Wachstum erzielen kann.

Ich interessiere mich nicht für Geld

Viele Menschen im Silicon Valley haben ihr persönliches Vermögen in verschiedenen öffentlichen und privaten Unternehmen angelegt, und Altman ist wie sie. Und sein Reichtum ist nicht erstaunlich.

Er hat keine Anteile an OpenAI. Das einzige Geld, das er mit dem Unternehmen verdient, ist ein Jahresgehalt von etwa 65.000 US-Dollar und ein kleiner Teil der alten Investition von Y Combinator in das Unternehmen.

Paul Graham, der Gründer von Y Combinator, ist sein Partner und Mentor. Er erklärte Altmans Beweggründe so:

„Warum sollte er einen Job machen, der ihn nicht reicher macht? Viele Leute werden das tun, sobald sie genug Geld haben, und die andere Antwort ist, dass er Macht mag , eine private Vorbereitungsschule, die nach dem amerikanischen Naturforscher und Philosophen benannt ist, ist voller Homophobie.

Zu Beginn des 21. Jahrhunderts begann der 17-jährige Schüler Altman, die Kultur der Schule zu verändern, indem er die Lehrer einen nach dem anderen davon überzeugte, „Safe Space“-Schilder an den Klassentüren anzubringen, als Zeichen der Unterstützung für schwule Schüler ihn.Georgeann Kepchar, die den fortgeschrittenen Informatikkurs der Schule unterrichtet, betrachtet Altman als einen ihrer begabtesten Informatikstudenten: „Er verfügt über Kreativität und Vision, und gepaart mit Ehrgeiz und Charakterstärke kann er andere davon überzeugen, mit ihm zusammenzuarbeiten.“ Altman erzählte mir auch, dass er nach seinem ersten Studienjahr erfolgreich einen besonders homophoben Lehrer gebeten hatte, im Labor für künstliche Intelligenz und Robotik zu arbeiten Flaggschiff-Labor für künstliche Intelligenz bei Google. Aber er sagte, dass er während seines kurzen Aufenthalts in Stanford durch das nächtliche Pokerspielen mehr gelernt habe als durch andere College-Aktivitäten, und dass Poker ihm beigebracht habe, wie man Menschen sieht und Risiken einschätzt.

„Wie man im Laufe der Zeit Muster bei Menschen erkennt, wie man Entscheidungen mit sehr unvollständigen Informationen trifft, wie man entscheidet, wann es sich lohnt, mehr Informationen zu erhalten, das ist ein großartiges Spiel

Graham, wer hat Er hat ein Jahrzehnt lang mit Altman zusammengearbeitet und sieht in dem gebürtigen St. Louis die gleiche Überzeugungskraft: „Er hat eine angeborene Fähigkeit, Menschen davon zu überzeugen, Dinge zu tun. Wenn es nicht angeboren ist, dann hatte er diese Fähigkeit zumindest, bevor er 20 Jahre alt war. Wann.“ Ich habe Sam zum ersten Mal getroffen, er war 19 Jahre alt, und ich dachte: „So muss Bill Gates sein.“

Sein Nachfolger, der die Menschen im Silicon Valley schockierte, weil es hier nicht darum geht, Programmierer, Ingenieure oder künstliche Intelligenz einzustellen. Der Forscher ist derjenige, der die Agenda festlegt, das Team aufbaut und den Deal abschließt.

Als Präsident von YC hätte Altman die Expansion des Unternehmens fast aufgegeben, einen neuen Investmentfonds und ein neues Forschungslabor gegründet und die Zahl der Unternehmen, die das Unternehmen jedes Jahr Beratungsdienstleistungen erbringt, erhöht.

Er begann auch an mehreren Projekten außerhalb von Investmentfirmen zu arbeiten, darunter OpenAI, eine gemeinnützige Organisation, die er 2015 mit einer Gruppe von Leuten, darunter Musk, gründete. YC machte sich zunehmend Sorgen, dass Ultraman sich erschöpfen würde, und beschloss, seine Aufmerksamkeit wieder auf ein Projekt zu richten, das, wie er sagte, einen echten Einfluss auf die Welt haben würde: künstliche Intelligenz.

Im Jahr 2019, gerade als die Forschung zu OpenAI in Fahrt kam, nutzte Herr Altman die Gelegenheit, trat als Präsident von Y Combinator zurück und konzentrierte sich auf ein Unternehmen mit weniger als 100 Mitarbeitern und wusste nicht einmal wie Lohn zahlen.

Innerhalb eines Jahres verwandelte er OpenAI in eine gemeinnützige Organisation mit einem gewinnorientierten Arm. Auf diese Weise könnte er sich um Gelder für den Bau einer Maschine bemühen, die alles kann, was das menschliche Gehirn kann. Er traf Microsoft-CEO Satya Nadella bei einem jährlichen Treffen von Technologieführern, das oft als „Milliardärs-Sommercamp“ bezeichnet wird, und verhandelte den Deal später persönlich mit Nadella und Kevin Scott, Chief Technology Officer von Microsoft. Herr Brockman, Präsident von OpenAI, sagte, dass Altmans Talent darin liegt, die Bedürfnisse der Menschen zu verstehen: „Er versucht wirklich herauszufinden, was für eine Person am wichtigsten ist, und dann einen Weg zu finden, es ihnen zu geben.“ ein Algorithmus, den er immer wieder verwendet. Die Vereinbarung stellt OpenAI und Microsoft in den Mittelpunkt einer Bewegung, die alles neu gestalten wird, von Suchmaschinen über E-Mail-Apps bis hin zu Online-Lehrern. Und die Geschwindigkeit, mit der dies geschieht, hat selbst diejenigen überrascht, die diese Technologie seit Jahrzehnten verfolgen. Inmitten dieser Begeisterung bleibt Ultraman so ruhig wie eh und je. Microsoft-CTO Scott glaubt, dass Ultraman irgendwann so großartig werden wird wie Steve Jobs, Bill Gates und Mark Zuckerberg. „Diese Menschen haben einen unauslöschlichen Eindruck im Gefüge der Technologiebranche und vielleicht auch im Gefüge der Welt hinterlassen. Ich denke, Sam wird einer dieser Menschen sein.“ Yudkowsky und seine Arbeit spielten eine Schlüsselrolle bei der Entwicklung von OpenAI und DeepMind. Er hat auch dazu beigetragen, eine riesige Online-Community von Rationalisten und effektiven Altruisten hervorzubringen, die glauben, dass künstliche Intelligenz ein existenzielles Risiko darstellt und befürchten, dass sie eines Tages die Welt zerstören wird. Forscher aus vielen Top-Laboren für künstliche Intelligenz, darunter OpenAI, gehören zu dieser sehr einflussreichen Gruppe. Sie sehen darin keine Heuchelei: Viele von ihnen glauben, dass sie die Gefahren besser verstehen als andere, weil sie in der besten Position sind, diese Technologie zu entwickeln. Altman glaubt, dass effektive Altruisten eine wichtige Rolle beim Aufstieg der künstlichen Intelligenz gespielt haben und die Industrie auf die Gefahren aufmerksam machen können. Er meint auch, dass sie die Gefahren übertreiben. Während OpenAI ChatGPT entwickelte, entwickelten viele andere Unternehmen, darunter Google und Meta, ähnliche Technologien. Aber es waren Ultraman und OpenAI, die sich entschieden haben, diese Technologie mit der Welt zu teilen. Viele in diesem Bereich haben die Entscheidung kritisiert und argumentiert, dass sie einen Wettlauf um die Veröffentlichung von Technologien auslöst, die schief gehen, erfunden werden und schnell zur schnellen Verbreitung von Desinformation genutzt werden können. Am Freitag verbot die italienische Regierung vorübergehend die Nutzung von ChatGPT im Land und begründete dies mit Bedenken hinsichtlich der Privatsphäre und der Gefährdung von Minderjährigen durch gefährliche Inhalte. Ultraman glaubt, dass es sicherer wäre, diese Technologie nach und nach zu teilen, anstatt diese Technologie vollständig hinter verschlossenen Türen zu entwickeln und zu testen, bevor sie vollständig veröffentlicht wird, damit jeder die Risiken und den Umgang mit ihnen besser verstehen kann. Es werde ein „sehr langsamer Start“ sein, sagte er. Er sagte, er könne sich keine Welt vorstellen, in der die menschliche Intelligenz nutzlos sei. Wenn er sich geirrt hatte, dachte er, er könne menschliche Fehler wiedergutmachen. Er baute OpenAI zu einem, wie er es nennt, gewinnorientierten Unternehmen um. Dadurch konnte er sich eine Finanzierung in Milliardenhöhe sichern, indem er Investoren wie Microsoft Gewinne versprach. Diese Gewinne sind jedoch begrenzt und alle zusätzlichen Einnahmen fließen zurück in die 2015 gegründete gemeinnützige Organisation OpenAI. Seine großartige Idee ist, dass OpenAI durch die Schaffung von AGI den größten Teil des weltweiten Reichtums an sich reißen und diesen Reichtum dann an die Menschen weiterverteilen wird. Allerdings ist er sich nicht sicher, wie er das Vermögen umverteilen soll. Er glaubt, dass Geld in dieser neuen Welt möglicherweise andere Bedeutungen hat, aber „Ich denke, AGI kann helfen, dieses Problem zu lösen.“

Der lange Weg dorthin Einen Traum verwirklichen

Das obige ist der detaillierte Inhalt vonGPT-4-Chef: Keine Panik, ich habe einen Plan, die Zukunft von AGI ist wirklich rosig!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Vier empfohlene KI-gestützte Programmiertools

Apr 22, 2024 pm 05:34 PM

Vier empfohlene KI-gestützte Programmiertools

Apr 22, 2024 pm 05:34 PM

Dieses KI-gestützte Programmiertool hat in dieser Phase der schnellen KI-Entwicklung eine große Anzahl nützlicher KI-gestützter Programmiertools zu Tage gefördert. KI-gestützte Programmiertools können die Entwicklungseffizienz verbessern, die Codequalität verbessern und Fehlerraten reduzieren. Sie sind wichtige Helfer im modernen Softwareentwicklungsprozess. Heute wird Dayao Ihnen 4 KI-gestützte Programmiertools vorstellen (und alle unterstützen die C#-Sprache). https://github.com/YSGStudyHards/DotNetGuide1.GitHubCopilotGitHubCopilot ist ein KI-Codierungsassistent, der Ihnen hilft, Code schneller und mit weniger Aufwand zu schreiben, sodass Sie sich mehr auf Problemlösung und Zusammenarbeit konzentrieren können. Git

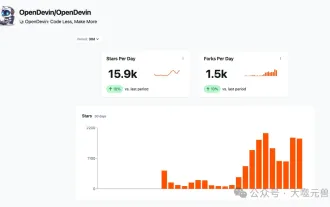

Welcher KI-Programmierer ist der beste? Entdecken Sie das Potenzial von Devin, Tongyi Lingma und SWE-Agent

Apr 07, 2024 am 09:10 AM

Welcher KI-Programmierer ist der beste? Entdecken Sie das Potenzial von Devin, Tongyi Lingma und SWE-Agent

Apr 07, 2024 am 09:10 AM

Am 3. März 2022, weniger als einen Monat nach der Geburt von Devin, dem weltweit ersten KI-Programmierer, entwickelte das NLP-Team der Princeton University einen Open-Source-KI-Programmierer-SWE-Agenten. Es nutzt das GPT-4-Modell, um Probleme in GitHub-Repositorys automatisch zu lösen. Die Leistung des SWE-Agenten auf dem SWE-Bench-Testsatz ist ähnlich wie die von Devin, er benötigt durchschnittlich 93 Sekunden und löst 12,29 % der Probleme. Durch die Interaktion mit einem dedizierten Terminal kann der SWE-Agent Dateiinhalte öffnen und durchsuchen, die automatische Syntaxprüfung verwenden, bestimmte Zeilen bearbeiten sowie Tests schreiben und ausführen. (Hinweis: Der obige Inhalt stellt eine geringfügige Anpassung des Originalinhalts dar, die Schlüsselinformationen im Originaltext bleiben jedoch erhalten und überschreiten nicht die angegebene Wortbeschränkung.) SWE-A

Wie sollte das Design der Sicherheitsarchitektur des Java-Frameworks mit den Geschäftsanforderungen in Einklang gebracht werden?

Jun 04, 2024 pm 02:53 PM

Wie sollte das Design der Sicherheitsarchitektur des Java-Frameworks mit den Geschäftsanforderungen in Einklang gebracht werden?

Jun 04, 2024 pm 02:53 PM

Das Java-Framework-Design ermöglicht Sicherheit, indem es Sicherheitsanforderungen mit Geschäftsanforderungen in Einklang bringt: Identifizierung wichtiger Geschäftsanforderungen und Priorisierung relevanter Sicherheitsanforderungen. Entwickeln Sie flexible Sicherheitsstrategien, reagieren Sie schichtweise auf Bedrohungen und nehmen Sie regelmäßige Anpassungen vor. Berücksichtigen Sie architektonische Flexibilität, unterstützen Sie die Geschäftsentwicklung und abstrakte Sicherheitsfunktionen. Priorisieren Sie Effizienz und Verfügbarkeit, optimieren Sie Sicherheitsmaßnahmen und erhöhen Sie die Sichtbarkeit.

Sicherheitskonfiguration und Härtung des Struts 2-Frameworks

May 31, 2024 pm 10:53 PM

Sicherheitskonfiguration und Härtung des Struts 2-Frameworks

May 31, 2024 pm 10:53 PM

Um Ihre Struts2-Anwendung zu schützen, können Sie die folgenden Sicherheitskonfigurationen verwenden: Nicht verwendete Funktionen deaktivieren. Inhaltstypprüfung aktivieren. Eingaben validieren. Sicherheitstokens aktivieren. CSRF-Angriffe verhindern. Verwenden Sie RBAC, um den rollenbasierten Zugriff einzuschränken

Wie vereinfachen neue Features von PHP-Funktionen den Entwicklungsprozess?

May 04, 2024 pm 09:45 PM

Wie vereinfachen neue Features von PHP-Funktionen den Entwicklungsprozess?

May 04, 2024 pm 09:45 PM

Die neuen Funktionen von PHP-Funktionen vereinfachen den Entwicklungsprozess erheblich, darunter: Pfeilfunktion: Bietet eine prägnante anonyme Funktionssyntax, um Coderedundanz zu reduzieren. Deklaration von Eigenschaftstypen: Geben Sie Typen für Klasseneigenschaften an, verbessern Sie die Lesbarkeit und Zuverlässigkeit des Codes und führen Sie zur Laufzeit automatisch eine Typprüfung durch. Nulloperator: Prüft und verarbeitet präzise Nullwerte und kann zur Verarbeitung optionaler Parameter verwendet werden.

PHP-Mikroframework: Sicherheitsdiskussion von Slim und Phalcon

Jun 04, 2024 am 09:28 AM

PHP-Mikroframework: Sicherheitsdiskussion von Slim und Phalcon

Jun 04, 2024 am 09:28 AM

Im Sicherheitsvergleich zwischen Slim und Phalcon im PHP-Mikroframework verfügt Phalcon über integrierte Sicherheitsfunktionen wie CSRF- und XSS-Schutz, Formularvalidierung usw., während Slim keine sofort einsatzbereiten Sicherheitsfunktionen aufweist und eine manuelle Implementierung erfordert Sicherheitsmaßnahmen. Für sicherheitskritische Anwendungen bietet Phalcon einen umfassenderen Schutz und ist die bessere Wahl.

Implementierung von Algorithmen für maschinelles Lernen in C++: Sicherheitsüberlegungen und Best Practices

Jun 01, 2024 am 09:26 AM

Implementierung von Algorithmen für maschinelles Lernen in C++: Sicherheitsüberlegungen und Best Practices

Jun 01, 2024 am 09:26 AM

Bei der Implementierung von Algorithmen für maschinelles Lernen in C++ sind Sicherheitsaspekte von entscheidender Bedeutung, einschließlich Datenschutz, Modellmanipulation und Eingabevalidierung. Zu den Best Practices gehören die Einführung sicherer Bibliotheken, die Minimierung von Berechtigungen, die Verwendung von Sandboxing und die kontinuierliche Überwachung. Der praktische Fall demonstriert die Verwendung der Botan-Bibliothek zum Ver- und Entschlüsseln des CNN-Modells, um sicheres Training und Vorhersage zu gewährleisten.

Welche Wallet ist sicherer für SHIB-Coins? (Muss für Neulinge gelesen werden)

Jun 05, 2024 pm 01:30 PM

Welche Wallet ist sicherer für SHIB-Coins? (Muss für Neulinge gelesen werden)

Jun 05, 2024 pm 01:30 PM

SHIB-Coin ist für Anleger kein Unbekannter mehr. Es handelt sich um einen konzeptionellen Token vom gleichen Typ wie Dogecoin. Mit der Entwicklung des Marktes ist SHIB auf Platz 12 gestiegen. Es ist ersichtlich, dass der SHIB-Markt heiß ist und unzählige Investitionen anzieht . Investoren beteiligen sich an der Investition. In der Vergangenheit kam es auf dem Markt häufig zu Transaktionen und Sicherheitsvorfällen bei Wallets. Viele Anleger waren besorgt über das Speicherproblem von SHIB. Sie fragen sich, welches Wallet derzeit sicherer für die Aufbewahrung von SHIB-Coins ist. Laut Marktdatenanalyse handelt es sich bei den relativ sicheren Wallets hauptsächlich um OKXWeb3Wallet-, imToken- und MetaMask-Wallets, die relativ sicher sein werden. Als Nächstes wird der Herausgeber ausführlich auf sie eingehen. Welche Wallet ist sicherer für SHIB-Coins? Derzeit werden SHIB-Münzen auf OKXWe platziert