Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Interpretation der autonomen Fahralgorithmen und -modelle von Tesla

Interpretation der autonomen Fahralgorithmen und -modelle von Tesla

Interpretation der autonomen Fahralgorithmen und -modelle von Tesla

Tesla ist ein typisches KI-Unternehmen. Es hat im vergangenen Jahr 75.000 neuronale Netze trainiert, was bedeutet, dass alle 8 Minuten ein neues Modell produziert wird. Insgesamt werden 281 Modelle in Tesla-Autos verwendet. Als nächstes werden wir den Algorithmus und den Modellfortschritt von Tesla FSD in verschiedenen Aspekten interpretieren.

01 Perception Occupancy Network

Eine der Schlüsseltechnologien von Tesla im Bereich Wahrnehmung in diesem Jahr ist das Occupancy Network. Studierende, die Robotik studieren, werden mit dem Belegungsraster auf jeden Fall vertraut sein. Es gibt an, ob jedes 3D-Voxel (Voxel) im Raum besetzt ist. Es kann eine binäre Darstellung von 0/1 oder eine zwischen [0, 1] sein.

Warum ist die Belegung wichtig für die Wahrnehmung des autonomen Fahrens? Denn während der Fahrt können wir zusätzlich zu häufigen Hindernissen wie Fahrzeugen und Fußgängern deren Position und Größe durch 3D-Objekterkennung abschätzen. Es gibt auch weitere Hindernisse mit langem Heck, die ebenfalls einen wichtigen Einfluss auf das Fahren haben. Zum Beispiel: 1. Verformbare Hindernisse, wie z. B. zweiteilige Anhänger, sind nicht für die Darstellung durch 3D-Begrenzungsrahmen geeignet. 2. Bei Hindernissen mit besonderer Form, wie z. B. umgekippte Fahrzeuge, ist die 3D-Lageschätzung ungültig Kategorien Hindernisse wie Steine und Müll auf der Straße können nicht klassifiziert werden. Daher hoffen wir, einen besseren Ausdruck zur Beschreibung dieser Long-Tail-Hindernisse zu finden und die Besetzung jeder Position im 3D-Raum, sogar die Semantik und Bewegung (Fluss), vollständig abzuschätzen.

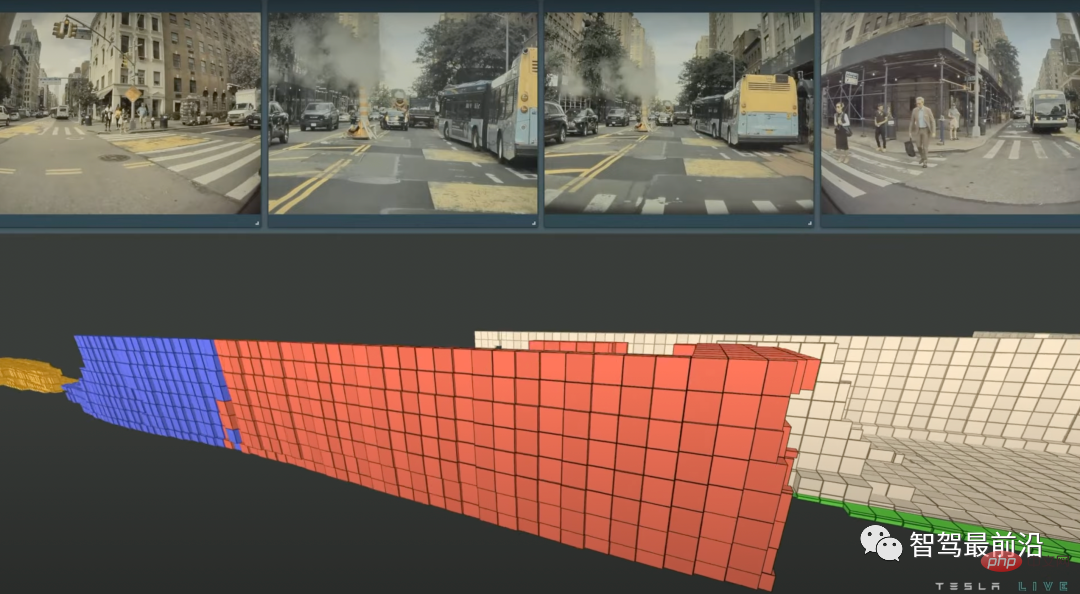

Tesla verwendet das konkrete Beispiel im Bild unten, um die Leistungsfähigkeit des Occupancy Network zu demonstrieren. Im Gegensatz zu 3D-Boxen werden bei der Darstellung der Besetzung nicht zu viele geometrische Annahmen über das Objekt getroffen, sodass Objekte jeder Form und jeder Form der Objektbewegung modelliert werden können. Die Abbildung zeigt eine Szene, in der ein Bus mit zwei Abschnitten in Bewegung gesetzt wird, während Rot für stationäre Voxel steht begann sich zu bewegen. Der Abschnitt ruht noch.

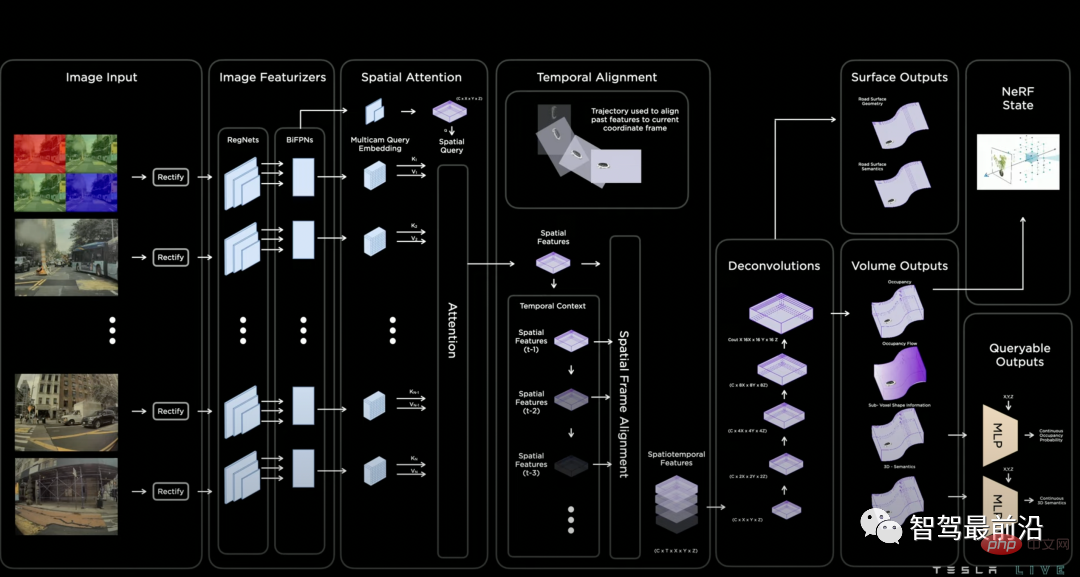

Die Belegungsschätzung der beiden gestarteten Busse stellt die sich bewegenden Voxel und die rote die stationären Voxel dar. Die Modellstruktur des Belegungsnetzwerks ist in der folgenden Abbildung dargestellt. Erstens verwendet das Modell RegNet und BiFPN, um Funktionen von mehreren Kameras zu erhalten. Diese Struktur stimmt mit der Netzwerkstruktur überein, die beim letztjährigen KI-Tag geteilt wurde, was darauf hinweist, dass sich am Grundgerüst nicht viel geändert hat. Das Modell führt dann eine aufmerksamkeitsbasierte Multikamera-Fusion von 2D-Bildmerkmalen durch räumliche Abfrage mit 3D-Raumposition durch. Wie kann die Verbindung zwischen räumlicher 3D-Abfrage und 2D-Feature-Map realisiert werden? Die spezifische Fusionsmethode ist in der Abbildung nicht detailliert beschrieben, es gibt jedoch viele öffentliche Veröffentlichungen als Referenz. Ich denke, die wahrscheinlichste Lösung ist eine von zwei Lösungen. Die erste heißt 3D-zu-2D-Abfrage und projiziert die räumliche 3D-Abfrage auf der Grundlage der internen und externen Parameter jeder Kamera, um deren Merkmale zu extrahieren die entsprechende Position. Diese Methode wurde in DETR3D vorgeschlagen, und BEVFormer und PolarFormer haben diese Idee ebenfalls übernommen. Die zweite besteht darin, die Positionseinbettung zu verwenden, um eine implizite Zuordnung durchzuführen, dh jeder Position der 2D-Feature-Map eine angemessene Positionseinbettung hinzuzufügen, z. B. interne und externe Parameter der Kamera, Pixelkoordinaten usw., und das Modell dann die Entsprechung lernen zu lassen zwischen 2D- und 3D-Features. Als nächstes wird das Modell einer Zeitreihenfusion unterzogen. Die Implementierungsmethode besteht darin, den 3D-Merkmalsraum basierend auf den bekannten Positions- und Lageänderungen des eigenen Fahrzeugs zu verbinden.

Occupancy-Netzwerkstruktur

Nach der Feature-Fusion dekodiert ein auf Dekonvolution basierender Decoder die Belegung, Semantik und den Fluss jeder 3D-Raumposition. Auf der Pressekonferenz wurde betont, dass die Ausgabeauflösung durch den Speicher begrenzt sei, da die Ausgabe dieses Netzwerks dicht sei. Ich glaube, dass dies auch allen Studenten, die Bildsegmentierung durchführen, große Kopfschmerzen bereitet. Darüber hinaus handelt es sich hier um eine 3D-Segmentierung, aber beim autonomen Fahren werden sehr hohe Anforderungen an die Auflösung gestellt (~10 cm). Daher wird am Ende des Modells, inspiriert von der neuronalen impliziten Darstellung, ein zusätzlicher implizit abfragbarer MLP-Decoder entworfen. Durch Eingabe eines beliebigen Koordinatenwerts (x, y, z) können die Informationen der räumlichen Position, also der Besetzung, dekodiert werden , Semantik, Fluss. Diese Methode durchbricht die Beschränkung der Modellauflösung, was meiner Meinung nach ein Highlight des Designs ist.

02 Planung Interaktive Planung

Planung ist ein weiteres wichtiges Modul des autonomen Fahrens, bei dem Tesla diesmal hauptsächlich die Modellierung der Interaktion an komplexen Kreuzungen in den Vordergrund stellt. Warum ist Interaktionsmodellierung so wichtig? Da das zukünftige Verhalten anderer Fahrzeuge und Fußgänger ein gewisses Maß an Unsicherheit aufweist, muss ein intelligentes Planungsmodul mehrere Interaktionen zwischen eigenen Fahrzeugen und anderen Fahrzeugen online vorhersagen, die mit jeder Interaktion verbundenen Risiken bewerten und schließlich entscheiden, welche Strategie angewendet wird verfolgen.

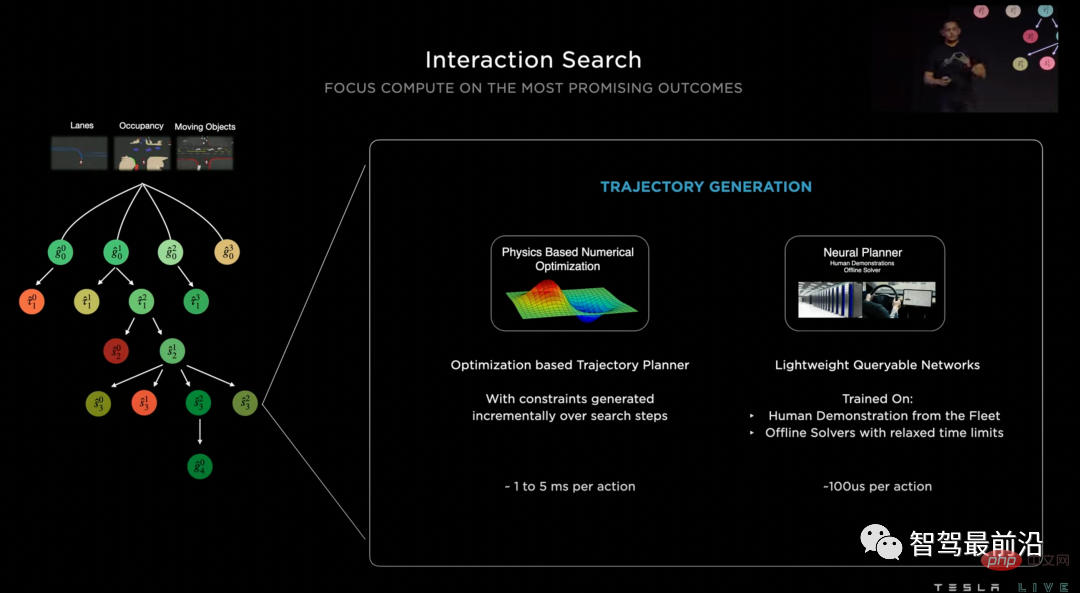

Tesla nennt das von ihnen verwendete Planungsmodell Interaction Search, das hauptsächlich aus drei Hauptschritten besteht: Baumsuche, Trajektorienplanung im neuronalen Netzwerk und Trajektorienbewertung.

1. Die Baumsuche ist ein häufig verwendeter Algorithmus für die Trajektorienplanung. Sie kann verschiedene interaktive Situationen effektiv erkennen und optimale Lösungen finden. Die größte Schwierigkeit bei der Verwendung von Suchmethoden zur Lösung von Trajektorienplanungsproblemen besteht jedoch zu groß. Beispielsweise kann es an einer komplexen Kreuzung 20 mit einem selbst verbundene Fahrzeuge geben, die zu mehr als 100 Interaktionsmethoden kombiniert werden können, und jede Interaktionsmethode kann Dutzende räumlich-zeitlicher Trajektorien als Kandidaten haben. Daher verwendete Tesla nicht die Flugbahnsuchmethode, sondern ein neuronales Netzwerk, um die Zielpositionen (Ziele) zu bewerten, die nach einer gewissen Zeit erreicht werden könnten, und um eine kleine Anzahl besserer Ziele zu erhalten.

2. Nachdem wir das Ziel bestimmt haben, müssen wir eine Flugbahn bestimmen, um das Ziel zu erreichen. Herkömmliche Planungsmethoden verwenden häufig die Optimierung, um das Optimierungsproblem zu lösen. Wenn in den vorherigen Schritten viele Kandidatenziele angegeben wurden, ist dies nicht möglich das Problem im Hinblick auf den Zeitaufwand lösen. Daher schlug Tesla vor, ein weiteres neuronales Netzwerk für die Flugbahnplanung zu verwenden, um eine hochparallele Planung für mehrere mögliche Ziele zu erreichen. Es gibt zwei Quellen für Trajektorienbezeichnungen zum Trainieren dieses neuronalen Netzwerks: Die erste ist die Trajektorie des echten menschlichen Fahrens, aber wir wissen, dass die Trajektorie des menschlichen Fahrens möglicherweise nur eine von vielen besseren Lösungen ist, daher ist die zweite Quelle die Offline-Optimierung Vom Algorithmus erzeugte Trajektorienlösungen.

3. Nachdem wir eine Reihe realisierbarer Trajektorien erhalten haben, müssen wir eine optimale Lösung auswählen. Die hier gewählte Lösung besteht darin, die erhaltene Flugbahn zu bewerten. Die Bewertungslösung kombiniert künstlich formulierte Risikoindikatoren, Komfortindikatoren und einen Scorer für ein neuronales Netzwerk.

Durch die Entkopplung der oben genannten drei Schritte hat Tesla ein effizientes Trajektorienplanungsmodul implementiert, das die Interaktion berücksichtigt. Es gibt nicht viele Artikel, auf die ich mich bei der Trajektorienplanung basierend auf neuronalen Netzen beziehen kann. Ich habe einen Artikel veröffentlicht, der sich auf diese Methode bezieht. Außerdem wird das Problem der Trajektorienvorhersage in die oben genannten drei Schritte zerlegt: Ziel Scoring, Flugbahnplanung, Flugbahnbewertung. Interessierte Leser können sich über die Details informieren. Darüber hinaus hat unsere Forschungsgruppe Fragen im Zusammenhang mit Verhaltensinteraktion und -planung untersucht, und jeder ist herzlich eingeladen, sich unsere neueste Arbeit InterSim[6] anzuschauen.

Struktur des Interaktionssuchplanungsmodells

03 Vektorkarte Lanes Network

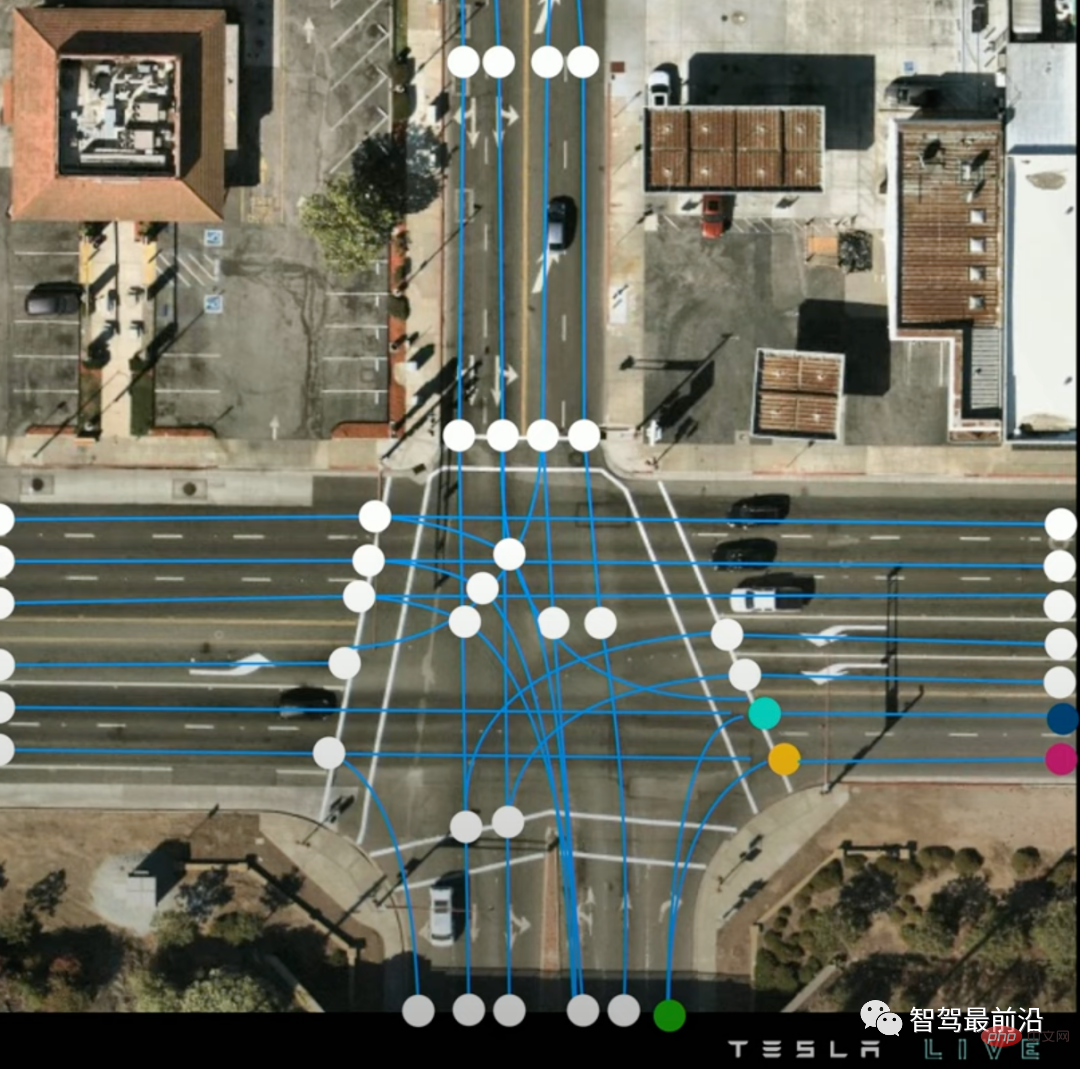

Ich persönlich denke, dass ein weiteres großes technisches Highlight dieses KI-Tages das Online-Vektorkarten-Konstruktionsmodell Lanes Network ist. Studenten, die letztes Jahr auf den AI Day geachtet haben, erinnern sich vielleicht daran, dass Tesla eine vollständige Online-Segmentierung und Erkennung von Karten im BEV-Bereich durchgeführt hat. Warum wollen wir also immer noch Lanes Network aufbauen? Da die segmentierten Fahrspuren auf Pixelebene für die Trajektorienplanung nicht ausreichen, müssen wir auch die Topologie der Fahrspurlinien ermitteln, um zu wissen, dass unser Auto von einer Fahrspur auf eine andere wechseln kann.

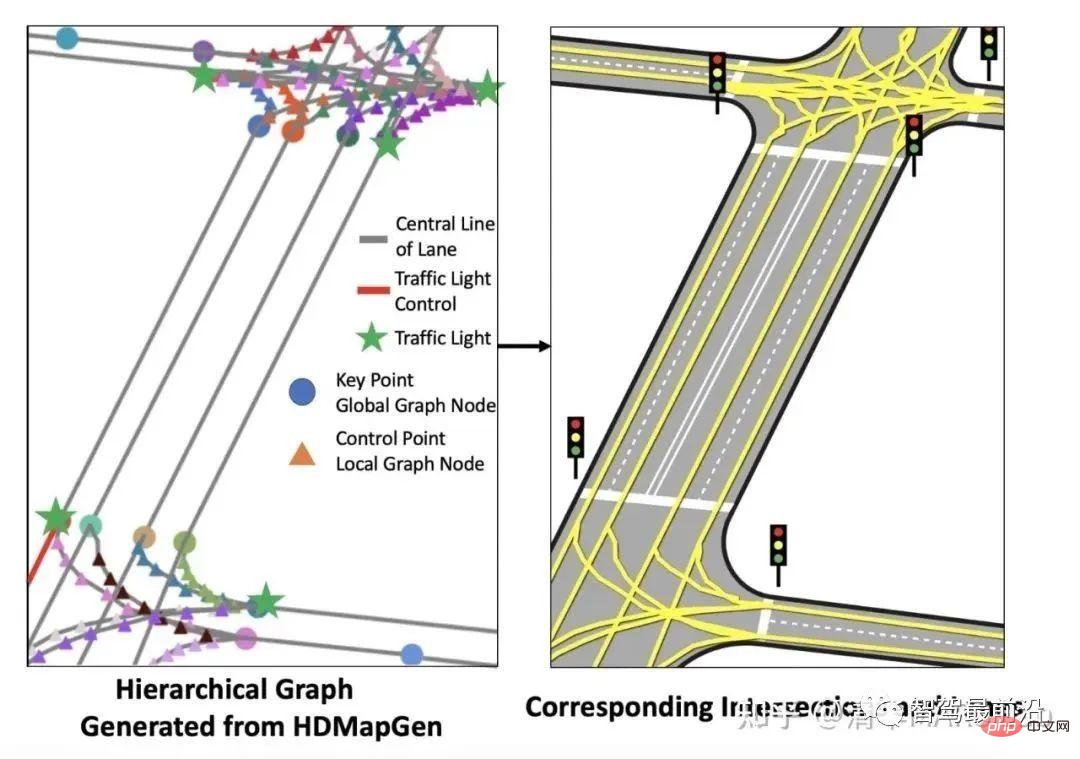

Werfen wir zunächst einen Blick darauf, was eine Vektorkarte ist. Wie im Bild gezeigt, besteht die Vektorkarte von Tesla aus einer Reihe blauer Spurmittellinien und einigen Schlüsselpunkten (Verbindungspunkt, Gabelungspunkt usw.). zusammenführen), und ihre Verbindungsbeziehung wird in Form eines Diagramms ausgedrückt.

Vektorkarte, die Punkte sind die Schlüsselpunkte der Fahrspurlinie und das Blau ist die Mittellinie der Fahrspur

Lanes Network ist ein Decoder, der in Bezug auf die Modellstruktur auf dem Rückgrat des Wahrnehmungsnetzwerks basiert. Im Vergleich zur Dekodierung der Belegung und Semantik jedes Voxels ist es schwieriger, eine Reihe dünner, verbundener Spurlinien zu dekodieren, da die Anzahl der Ausgänge nicht festgelegt ist und zwischen den Ausgangsgrößen logische Beziehungen bestehen.

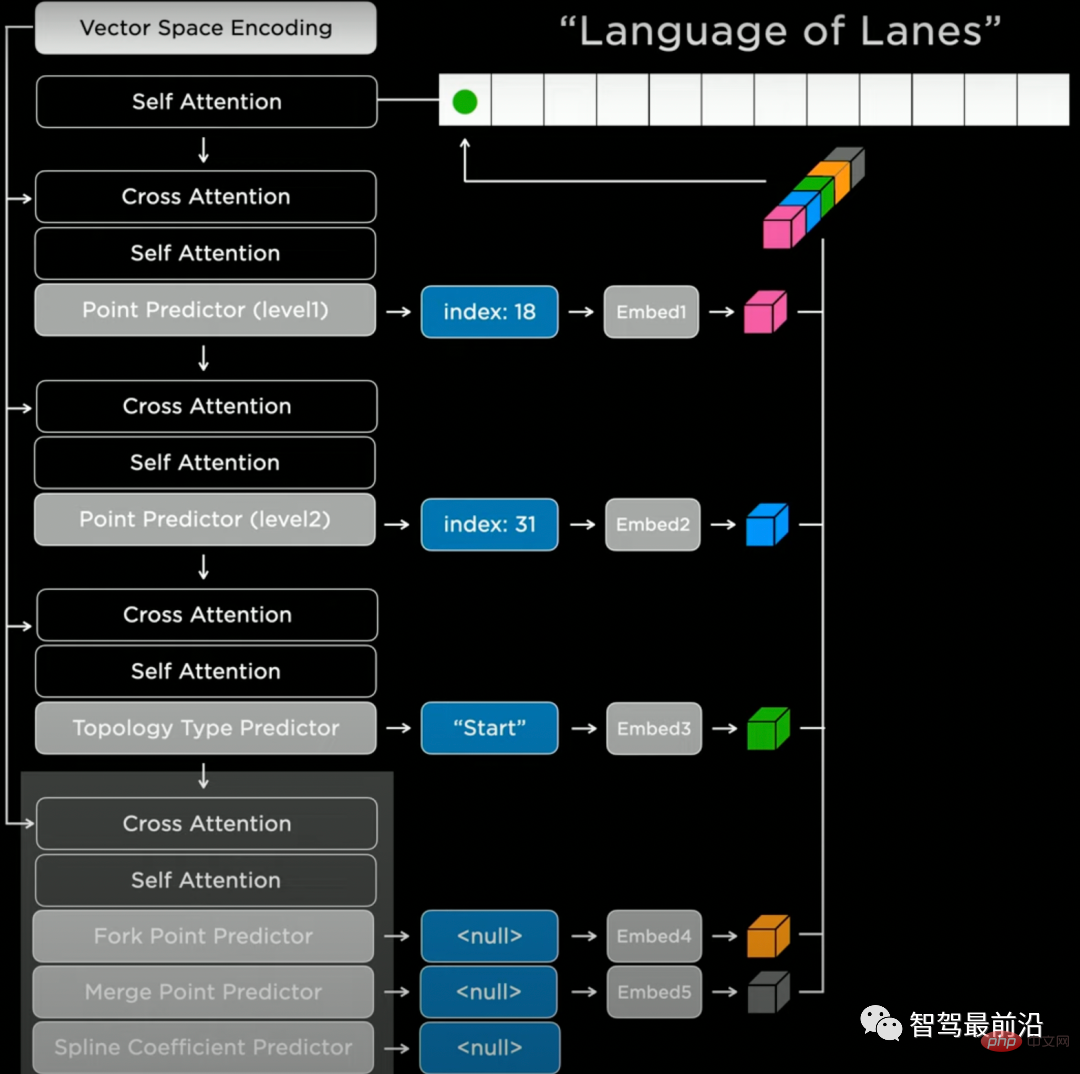

Tesla greift im Natural-Language-Modell auf den Transformer-Decoder zurück und gibt die Ergebnisse autoregressiv sequentiell aus. Im Hinblick auf die spezifische Implementierung müssen wir zunächst eine Generierungsreihenfolge auswählen (z. B. von links nach rechts, von oben nach unten) und den Raum diskretisieren (Tokenisierung). Dann können wir Lanes Network verwenden, um eine Reihe diskreter Token vorherzusagen. Wie in der Abbildung gezeigt, sagt das Netzwerk zunächst die grobe Position (Index: 18) und die genaue Position (Index: 31) eines Knotens voraus und sagt dann die Semantik des Knotens voraus („Start“, der Ausgangspunkt des Knotens). Fahrspurlinie) und schließlich die Verbindungseigenschaften vorhersagen, wie z. B. Gabelungs-/Zusammenführungs-/Krümmungsparameter usw. Das Netzwerk generiert alle Fahrspurlinienknoten auf diese autoregressive Weise.

Lanes-Netzwerk-Netzwerkstruktur

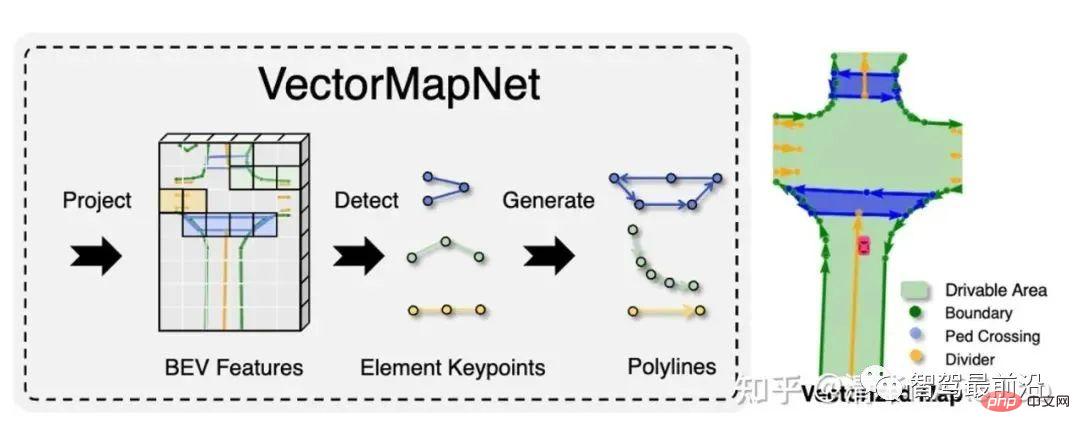

Wir sollten beachten, dass die autoregressive Sequenzgenerierung kein Patent des Sprachtransformatormodells ist. Unsere Forschungsgruppe hat in den letzten Jahren auch zwei verwandte Artikel zur Generierung von Vektorkarten veröffentlicht, HDMapGen[7] und VectorMapNet[8]. HDMapGen verwendet das Graph Neural Network with Attention (GAT), um die Schlüsselpunkte der Vektorkarte autoregressiv zu generieren, was der Lösung von Tesla ähnelt. VectorMapNet verwendet Detection Transformer (DETR), um dieses Problem zu lösen und eine festgelegte Vorhersagelösung zu verwenden, um Vektorkarten schneller zu generieren. Ergebnisse der HDMapGen-Vektorkartengenerierung

Automatische Etikettierung war letztes Jahr auch Teslas KI-Technologie, die Day hat erklärt, dass sich die diesjährige automatische Annotation auf die automatische Annotation von Lanes Network konzentriert. Tesla-Fahrzeuge können täglich 500.000 Fahrten (Fahrten) zurücklegen, und die sinnvolle Nutzung dieser Fahrdaten kann dazu beitragen, die Spurlinien besser vorherzusagen.

Die automatische Spurmarkierung von Tesla besteht aus drei Schritten:

1 Verwenden Sie die Technologie der visuellen Trägheits-Odometrie (visuelle Trägheits-Odometrie), um hochpräzise Flugbahnen für alle Fahrten abzuschätzen.

2. Die Kartenrekonstruktion mehrerer Fahrzeuge und mehrerer Fahrten ist der wichtigste Schritt in diesem Plan. Die grundlegende Motivation für diesen Schritt besteht darin, dass verschiedene Fahrzeuge denselben Ort aus unterschiedlichen räumlichen Winkeln und zu unterschiedlichen Zeiten beobachten können, sodass die Aggregation dieser Informationen zu einer besseren Kartenrekonstruktion führen kann. Zu den technischen Punkten dieses Schritts gehören der geometrische Abgleich zwischen Karten und die gemeinsame Optimierung der Ergebnisse. 3. Automatische Fahrspurmarkierung für neue Fahrten. Wenn wir über hochpräzise Offline-Kartenrekonstruktionsergebnisse verfügen und eine neue Fahrt stattfindet, können wir einen einfachen geometrischen Abgleich durchführen, um den pseudowahren Wert (Pseudolabel) der neuen Fahrtspurlinie zu erhalten. Diese Methode zum Erhalten pseudowahrer Werte ist manchmal sogar besser als die manuelle Annotation (nachts, an regnerischen und nebligen Tagen).

Automatische Beschriftung des Lanes Network

05 Simulation

Die Simulation visueller Bilder ist in den letzten Jahren eine beliebte Richtung in der Computer Vision. Beim autonomen Fahren besteht der Hauptzweck der visuellen Simulation darin, gezielt einige seltene Szenen zu generieren und so das Glück in echten Fahrversuchen zu vermeiden. Tesla hatte zum Beispiel schon immer Kopfschmerzen, wenn ein großer Lastwagen mitten auf der Straße lag. Aber die visuelle Simulation ist kein einfaches Problem. Für eine komplexe Kreuzung (Market Street in San Francisco) benötigt der Designer zwei Wochen, um die Lösung mithilfe traditioneller Modellierung und Darstellung zu erreichen. Die KI-basierte Lösung von Tesla dauert jetzt nur noch 5 Minuten.

Visuelle Simulation rekonstruierter Kreuzung

Konkret besteht die Voraussetzung für die visuelle Simulation darin, automatisch beschriftete Straßeninformationen aus der realen Welt und eine umfangreiche Grafikmaterialbibliothek vorzubereiten. Fahren Sie dann nacheinander mit den folgenden Schritten fort:

1. Fahrbahnerzeugung: Füllen Sie die Straßenoberfläche entsprechend dem Bordstein, einschließlich Straßenneigung, Material und anderen detaillierten Informationen.

2. Fahrspurliniengenerierung: Zeichnen Sie Fahrspurlinieninformationen auf der Straßenoberfläche.

3. Pflanzen- und Gebäudegenerierung: Erzeugen und rendern Sie zufällig Pflanzen und Häuser auf und neben Straßen. Der Zweck der Generierung von Pflanzen und Gebäuden besteht nicht nur in der visuellen Schönheit, sondern auch in der Simulation des Okklusionseffekts, der durch diese Objekte in der realen Welt verursacht wird.

4. Generieren Sie andere Straßenelemente: wie Ampeln, Straßenschilder und Importfahrspuren und Verbindungsbeziehungen.

5. Fügen Sie dynamische Elemente wie Fahrzeuge und Fußgänger hinzu.

06 Infrastruktur-Infrastruktur

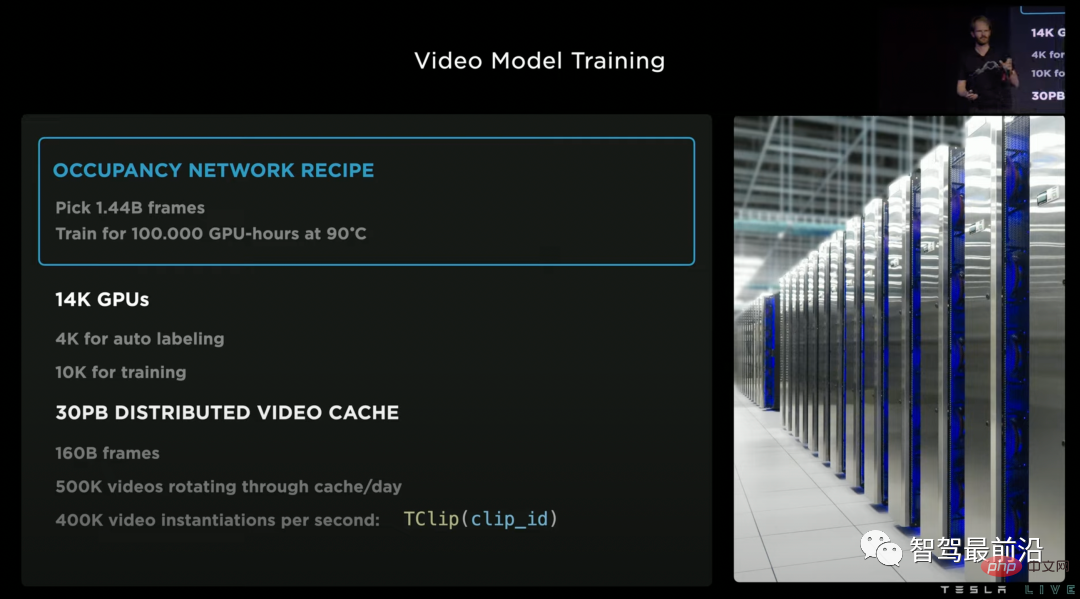

Lassen Sie uns abschließend kurz über die Grundlage von Teslas Reihe von Softwaretechnologien sprechen, bei der es sich um eine leistungsstarke Infrastruktur handelt. Das Supercomputing-Zentrum von Tesla verfügt über 14.000 GPUs und insgesamt 30 PB Datencache, und jeden Tag fließen 500.000 neue Videos in diese Supercomputer. Um diese Daten effizienter zu verarbeiten, hat Tesla speziell eine beschleunigte Videodekodierungsbibliothek sowie ein Dateiformat .smol entwickelt, das das Lesen und Schreiben von Zwischenfunktionen beschleunigt. Darüber hinaus hat Tesla auch ein eigenes Chip-Dojo für das Supercomputing-Zentrum entwickelt, das wir hier nicht näher erläutern.

Supercomputing-Zentrum für Videomodelltraining

07 Zusammenfassung

Mit der Veröffentlichung von Tesla AI Day-Inhalten in den letzten zwei Jahren haben wir Tesla langsam klar in Bezug auf die Technologielandschaft gesehen In Richtung autonomes (unterstütztes) Fahren haben wir auch gesehen, dass Tesla selbst ständig an sich selbst iteriert, beispielsweise von der 2D-Wahrnehmung, der BEV-Wahrnehmung bis hin zum Occupancy Network. Autonomes Fahren ist eine lange Reise von Tausenden von Kilometern. Was unterstützt die Entwicklung der Tesla-Technologie? Ich denke, es gibt drei Punkte: vollständige Szenenverständnisfähigkeiten durch visuelle Algorithmen, Modelliterationsgeschwindigkeit unterstützt durch leistungsstarke Rechenleistung und Generalisierung durch umfangreiche Daten. Sind das nicht die drei Säulen des Deep-Learning-Zeitalters?

Das obige ist der detaillierte Inhalt vonInterpretation der autonomen Fahralgorithmen und -modelle von Tesla. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich während des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt hätte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randfälle bei autonomen Fahrzeugen, also mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschränken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gelöst, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschränkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen gehören eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der „Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randfälle in autonomen Fahrzeugen (AVs). Randfälle sind mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

CLIP-BEVFormer: Überwacht explizit die BEVFormer-Struktur, um die Leistung der Long-Tail-Erkennung zu verbessern

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: Überwacht explizit die BEVFormer-Struktur, um die Leistung der Long-Tail-Erkennung zu verbessern

Mar 26, 2024 pm 12:41 PM

Oben geschrieben und das persönliche Verständnis des Autors: Derzeit spielt das Wahrnehmungsmodul im gesamten autonomen Fahrsystem eine entscheidende Rolle Das Steuermodul im autonomen Fahrsystem trifft zeitnahe und korrekte Urteile und Verhaltensentscheidungen. Derzeit sind Autos mit autonomen Fahrfunktionen in der Regel mit einer Vielzahl von Dateninformationssensoren ausgestattet, darunter Rundumsichtkamerasensoren, Lidar-Sensoren und Millimeterwellenradarsensoren, um Informationen in verschiedenen Modalitäten zu sammeln und so genaue Wahrnehmungsaufgaben zu erfüllen. Der auf reinem Sehen basierende BEV-Wahrnehmungsalgorithmus wird von der Industrie aufgrund seiner geringen Hardwarekosten und einfachen Bereitstellung bevorzugt, und seine Ausgabeergebnisse können problemlos auf verschiedene nachgelagerte Aufgaben angewendet werden.

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Zu den häufigsten Herausforderungen, mit denen Algorithmen für maschinelles Lernen in C++ konfrontiert sind, gehören Speicherverwaltung, Multithreading, Leistungsoptimierung und Wartbarkeit. Zu den Lösungen gehören die Verwendung intelligenter Zeiger, moderner Threading-Bibliotheken, SIMD-Anweisungen und Bibliotheken von Drittanbietern sowie die Einhaltung von Codierungsstilrichtlinien und die Verwendung von Automatisierungstools. Praktische Fälle zeigen, wie man die Eigen-Bibliothek nutzt, um lineare Regressionsalgorithmen zu implementieren, den Speicher effektiv zu verwalten und leistungsstarke Matrixoperationen zu nutzen.

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

Vorab geschrieben und Ausgangspunkt Das End-to-End-Paradigma verwendet ein einheitliches Framework, um Multitasking in autonomen Fahrsystemen zu erreichen. Trotz der Einfachheit und Klarheit dieses Paradigmas bleibt die Leistung von End-to-End-Methoden für das autonome Fahren bei Teilaufgaben immer noch weit hinter Methoden für einzelne Aufgaben zurück. Gleichzeitig erschweren die in früheren End-to-End-Methoden weit verbreiteten Funktionen der dichten Vogelperspektive (BEV) die Skalierung auf mehr Modalitäten oder Aufgaben. Hier wird ein Sparse-Search-zentriertes End-to-End-Paradigma für autonomes Fahren (SparseAD) vorgeschlagen, bei dem die Sparse-Suche das gesamte Fahrszenario, einschließlich Raum, Zeit und Aufgaben, ohne dichte BEV-Darstellung vollständig abbildet. Insbesondere ist eine einheitliche, spärliche Architektur für die Aufgabenerkennung einschließlich Erkennung, Verfolgung und Online-Zuordnung konzipiert. Zudem schwer

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Im vergangenen Monat hatte ich aus bekannten Gründen einen sehr intensiven Austausch mit verschiedenen Lehrern und Mitschülern der Branche. Ein unvermeidliches Thema im Austausch ist natürlich End-to-End und der beliebte Tesla FSDV12. Ich möchte diese Gelegenheit nutzen, einige meiner aktuellen Gedanken und Meinungen als Referenz und Diskussion darzulegen. Wie definiert man ein durchgängiges autonomes Fahrsystem und welche Probleme sollten voraussichtlich durchgängig gelöst werden? Gemäß der traditionellsten Definition bezieht sich ein End-to-End-System auf ein System, das Rohinformationen von Sensoren eingibt und für die Aufgabe relevante Variablen direkt ausgibt. Bei der Bilderkennung kann CNN beispielsweise als End-to-End bezeichnet werden, verglichen mit der herkömmlichen Methode zum Extrahieren von Merkmalen + Klassifizieren. Bei autonomen Fahraufgaben werden Eingabedaten verschiedener Sensoren (Kamera/LiDAR) benötigt

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Entdecken Sie die zugrunde liegenden Prinzipien und die Algorithmusauswahl der C++-Sortierfunktion

Apr 02, 2024 pm 05:36 PM

Entdecken Sie die zugrunde liegenden Prinzipien und die Algorithmusauswahl der C++-Sortierfunktion

Apr 02, 2024 pm 05:36 PM

Die unterste Ebene der C++-Sortierfunktion verwendet die Zusammenführungssortierung, ihre Komplexität beträgt O(nlogn) und bietet verschiedene Auswahlmöglichkeiten für Sortieralgorithmen, einschließlich schneller Sortierung, Heap-Sortierung und stabiler Sortierung.