Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Nature veröffentlichte einen Artikel: Die Geschwindigkeit grundlegender wissenschaftlicher Innovationen hat sich verlangsamt und ist in die „inkrementelle Ära' eingetreten.

Nature veröffentlichte einen Artikel: Die Geschwindigkeit grundlegender wissenschaftlicher Innovationen hat sich verlangsamt und ist in die „inkrementelle Ära' eingetreten.

Nature veröffentlichte einen Artikel: Die Geschwindigkeit grundlegender wissenschaftlicher Innovationen hat sich verlangsamt und ist in die „inkrementelle Ära' eingetreten.

In den letzten Jahrzehnten ist die Zahl der weltweit veröffentlichten wissenschaftlichen und technologischen Forschungsarbeiten dramatisch gestiegen. Basierend auf einer Analyse der Arbeiten und der bisherigen Literatur stellten Wissenschaftler jedoch fest, dass die „Disruptivität“ dieser Arbeiten stark abnahm.

Daten aus Millionen von Manuskripten zeigen, dass die seit dem 21. Jahrhundert abgeschlossenen Forschungsarbeiten im Vergleich zur Mitte des 20. Jahrhunderts das Gebiet der Wissenschaft eher „schrittweise“ voranbringen, als eine neue Richtung einzuschlagen und zu ermöglichen. Die vorherige Aufgabe war vollständig veraltet. Eine Analyse der Patente von 1976 bis 2010 zeigt den gleichen Trend.

Der Bericht wurde am 4. Januar in der Zeitschrift Nature veröffentlicht. Russell Funk, Soziologe an der University of Minnesota und Mitautor des Analyseberichts, sagte: „Diese Daten zeigen, dass sich etwas ändert und die Intensität der disruptiven Entdeckungen zuvor nicht mehr vorhanden ist.“ Zitate veranschaulichen Was?

Obwohl im letzten Jahrhundert eine beispiellose Erweiterung des wissenschaftlichen und technologischen Wissens zu verzeichnen war, bestehen Bedenken, dass die Innovationstätigkeit nachlässt. Papiere, Patente und sogar Förderanträge werden weniger neu als frühere Arbeiten und es ist weniger wahrscheinlich, dass sie verschiedene Wissensbereiche miteinander verbinden. Darüber hinaus wächst die Kluft zwischen dem Jahr, in dem ein Nobelpreis entdeckt wird, und dem Jahr, in dem er verliehen wird, was darauf hindeutet, dass einige Beiträge nicht mehr so wichtig sind wie früher.

Diese Verlangsamung der Innovation erfordert eine gründliche analytische Erklärung. Die Autoren des Berichts argumentierten, dass, wenn eine Studie äußerst störend sei, nachfolgende Studien weniger wahrscheinlich Verweise auf diese Studie zitieren würden und stattdessen die Studie selbst zitieren würden.

Daher analysierten die Forscher 25 Millionen Artikel (1945–2010) im Web of Science (WoS) und 3,9 Millionen Patente (1976–2010) in der Patent View-Datenbank des US-amerikanischen Patent- und Markenamts (USPTO). die Entstehung von Innovationslücken verstehen. Die WoS-Daten umfassen 390 Millionen Zitate, 25 Millionen Papiertitel und 13 Millionen Abstracts. Die Daten zur Patentansicht umfassen 35 Millionen Zitate, 3,9 Millionen Patenttitel und 3,9 Millionen Abstracts. Anschließend verwendeten sie dieselbe Analysemethode für vier weitere Datensätze (JSTOR, American Physical Society Corpus, Microsoft Academic Graph und PubMed), die 20 Millionen Artikel enthielten.

Anhand der Zitierdaten dieser 45 Millionen Papiermanuskripte und 3,9 Millionen Patente berechneten die Forscher einen Index zur Messung von Störungen, den sogenannten „CD-Index“, mit Werten, die von - 1 bis 1, also von From, verteilt sind vom am wenigsten störenden Job zum störendsten Job.

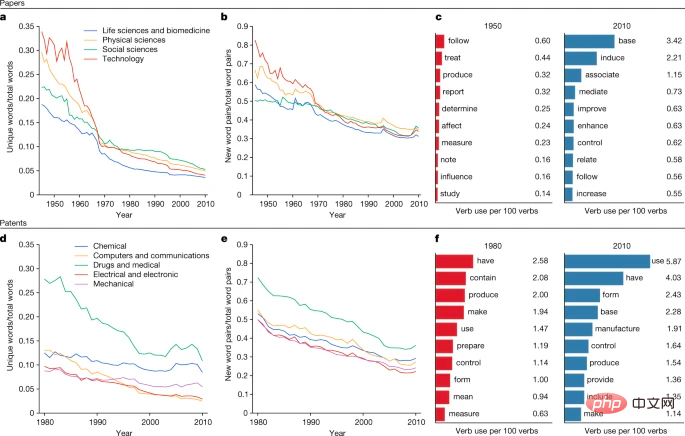

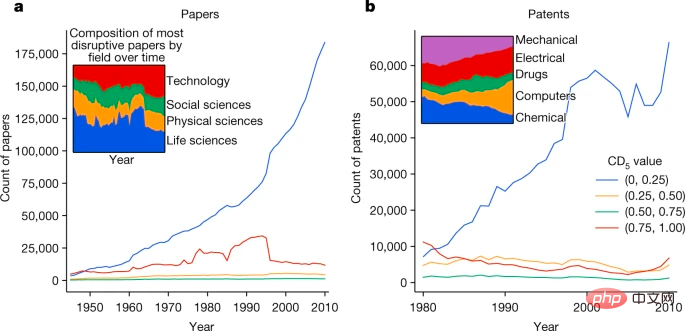

Der durchschnittliche CD-Index von Forschungsmanuskripten sank von 1945 bis 2010 um mehr als 90 %, und der durchschnittliche CD-Index von Patenten sank von 1980 bis 2010 um mehr als 78 %. Die Störung nimmt in allen untersuchten Forschungsbereichen und Patentarten ab, auch wenn mögliche Unterschiede bei Faktoren wie Zitierkonventionen berücksichtigt werden.

Veränderungen in den Sprachgewohnheiten

Die Autoren analysierten auch die am häufigsten verwendeten Verben in den Manuskripten und stellten fest, dass in Studien in den 1950er Jahren eher Wörter verwendet wurden, die Schöpfung oder Entdeckung bedeuten, wie zum Beispiel „produzieren“ oder „bestimmen“. Studien aus den 2010er Jahren bezogen sich eher auf schrittweise Fortschritte und verwendeten Begriffe wie „Verbesserung“ oder „Verbesserung“.

„Es ist großartig, dass dieses Phänomen so detailliert dokumentiert werden kann“, sagte Dashun Wang, ein computergestützter Sozialwissenschaftler an der Northwestern University in Evanston, Illinois. „Sie haben es auf 100 verschiedene Arten betrachtet. Ich denke, das ist so.“ Insgesamt sehr überzeugend.“ Der Niedergang der disruptiven Wissenschaft und Technologie lässt sich an den Veränderungen in der Sprache von Dokumenten und Patenten erkennen.

Yian Yin, ein computergestützter Sozialwissenschaftler ebenfalls an der Northwestern University, sagte, andere Untersuchungen zeigten, dass sich die wissenschaftliche Innovation in den letzten Jahrzehnten ebenfalls verlangsamt habe. Aber die Studie biete „einen neuen Ausgangspunkt für die Untersuchung, wie sich die Wissenschaft auf datengesteuerte Weise verändert“, fügte er hinzu.

Dashun Wang sagte, dass Disruption an sich nicht unbedingt eine gute Sache sei und dass inkrementelle Wissenschaft gleichzeitig nicht unbedingt eine schlechte Sache sei. Er erwähnte auch eine Situation: Beispielsweise ist die erste direkte Beobachtung von Gravitationswellen sowohl eine revolutionäre Errungenschaft als auch ein Produkt der inkrementellen Wissenschaft. John Walsh, Experte für Technologiepolitik am Georgia Institute of Technology in Atlanta, sagt, das ideale Szenario sei eine gesunde Mischung aus inkrementeller und disruptiver Forschung: „In einer Welt, in der uns die Validität von Forschungsergebnissen am Herzen liegt, mehr Replikation und …“ Fortpflanzung ist wahrscheinlich eine gute Sache.“ Was genau hat den disruptiven Rückgang verursacht? John Walsh sagt, es sei wichtig, die Gründe für diese dramatische Veränderung zu verstehen, und ein Teil der Gründe könnte auf Veränderungen im wissenschaftlichen Betrieb zurückzuführen sein. Beispielsweise gibt es heute viel mehr Forscher als in den 1940er Jahren, wodurch ein wettbewerbsintensiveres Umfeld entsteht, das die Herausforderungen bei der Veröffentlichung von Forschungsergebnissen und der Anmeldung von Patenten erhöht. Dies wiederum verändert die Anreize für Forscher, ihrer Arbeit nachzugehen. Beispielsweise sind große Forschungsteams immer häufiger anzutreffen, und Dashun Wang und Kollegen fanden heraus, dass große Teams eher inkrementelle als disruptive Wissenschaft hervorbringen. John Walsh sagt, es sei nicht einfach, eine Erklärung für diesen Abwärtstrend zu finden. Während der Gesamtanteil der disruptiven Forschung zwischen 1945 und 2010 deutlich zurückging, blieb die Zahl der äußerst disruptiven Forschung im Wesentlichen gleich. Daten zeigen, dass das Aufkommen hochgradig disruptiver Forschung nicht im Widerspruch zur Verlangsamung der Innovation steht. Gleichzeitig ist auch die Geschwindigkeit des Rückgangs rätselhaft. Der CD-Index sank von 1945 bis 1970 stark und dann von Ende der 1990er Jahre bis 2010 noch deutlicher. „Welche Erklärung Sie auch immer für den Rückgang der Störungen haben, Sie müssen ihr Plateau in den 2000er Jahren erklären“, sagte er Was bremst Innovationen?

Das obige ist der detaillierte Inhalt vonNature veröffentlichte einen Artikel: Die Geschwindigkeit grundlegender wissenschaftlicher Innovationen hat sich verlangsamt und ist in die „inkrementelle Ära' eingetreten.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Neue „KI-Wissenschaftler' kombinieren Theorie und Daten, um wissenschaftliche Gleichungen zu entdecken

May 18, 2023 am 10:49 AM

Neue „KI-Wissenschaftler' kombinieren Theorie und Daten, um wissenschaftliche Gleichungen zu entdecken

May 18, 2023 am 10:49 AM

Wissenschaftler wollen aussagekräftige Formeln finden, die experimentelle Daten genau beschreiben. Mathematische Modelle natürlicher Phänomene können manuell auf der Grundlage von Domänenwissen erstellt werden, oder sie können mithilfe von Algorithmen für maschinelles Lernen automatisch aus großen Datensätzen erstellt werden. Die akademische Gemeinschaft hat das Problem der Zusammenführung relevanter Vorkenntnisse und relevanter Funktionsmodelle untersucht und ist der Ansicht, dass die Suche nach einem Modell, das mit Vorkenntnissen über allgemeine logische Axiome konsistent ist, ein ungelöstes Problem darstellt. Forscher des IBM-Forschungsteams und des Samsung-KI-Teams haben eine Methode „AI-Descartes“ entwickelt, die logisches Denken mit symbolischer Regression kombiniert, um eine prinzipielle Ableitung von Naturphänomenmodellen aus axiomatischem Wissen und experimentellen Daten durchzuführen. Die Studie basiert auf der „Kombination von Daten und Theorie für

Welchen Computer sollten Absolventen der Geoinformatik wählen?

Jan 13, 2024 am 08:00 AM

Welchen Computer sollten Absolventen der Geoinformatik wählen?

Jan 13, 2024 am 08:00 AM

Empfohlene Computer für Studierende mit Schwerpunkt Geoinformationswissenschaft 1. Empfehlung 2. Studierende mit Schwerpunkt Geoinformationswissenschaft müssen große Mengen geografischer Daten verarbeiten und komplexe Geoinformationsanalysen durchführen und benötigen daher einen Computer mit hoher Leistung. Ein Computer mit hoher Konfiguration kann eine schnellere Verarbeitungsgeschwindigkeit und mehr Speicherplatz bieten und professionelle Anforderungen besser erfüllen. 3. Es wird empfohlen, einen Computer zu wählen, der mit einem Hochleistungsprozessor und einem Speicher mit großer Kapazität ausgestattet ist, der die Effizienz der Datenverarbeitung und -analyse verbessern kann. Darüber hinaus können geografische Daten und Ergebnisse besser angezeigt werden, wenn Sie sich für einen Computer mit größerem Speicherplatz und einem hochauflösenden Display entscheiden. Da Studierende im Hauptfach Geoinformatik möglicherweise Software für geografische Informationssysteme (GIS) entwickeln und programmieren müssen, sollten Sie sich außerdem für einen Computer mit besserer Grafikverarbeitungsunterstützung entscheiden.

„Vater des maschinellen Lernens' Mitchell schreibt: Wie KI die wissenschaftliche Entwicklung beschleunigt und wie die Vereinigten Staaten Chancen nutzen

Jul 29, 2024 pm 08:23 PM

„Vater des maschinellen Lernens' Mitchell schreibt: Wie KI die wissenschaftliche Entwicklung beschleunigt und wie die Vereinigten Staaten Chancen nutzen

Jul 29, 2024 pm 08:23 PM

Herausgeber |. ScienceAI Kürzlich hat Tom M. Mitchell, Professor an der Carnegie Mellon University und bekannt als „Vater des maschinellen Lernens“, ein neues Whitepaper zu KI für die Wissenschaft geschrieben, das sich mit der Frage „Wie beschleunigt künstliche Intelligenz die wissenschaftliche Entwicklung?“ befasst Helft die US-Regierung, dieses Ziel zu erreichen? ScienceAI hat den vollständigen Text des Original-Whitepapers zusammengestellt, ohne seine ursprüngliche Bedeutung zu ändern. Der Inhalt ist wie folgt. Der Bereich der künstlichen Intelligenz hat in jüngster Zeit erhebliche Fortschritte gemacht, einschließlich groß angelegter Sprachmodelle wie GPT, Claude und Gemini, was die Möglichkeit erhöht, dass sich die sehr positiven Auswirkungen der künstlichen Intelligenz möglicherweise erheblich beschleunigen

96 chinesische Wissenschaftler wurden zu den 1.000 besten Informatikern der Welt gewählt, und Zhang Lei war der erste auf dem chinesischen Festland

Apr 21, 2023 pm 06:58 PM

96 chinesische Wissenschaftler wurden zu den 1.000 besten Informatikern der Welt gewählt, und Zhang Lei war der erste auf dem chinesischen Festland

Apr 21, 2023 pm 06:58 PM

Kürzlich veröffentlichte Research (Guide2Research) das Ranking der 1.000 weltweit besten Informatiker im Jahr 2023. 583 amerikanische Wissenschaftler dominieren die Liste. Auf der Liste stehen 96 chinesische Wissenschaftler, wobei Zhang Lei unter den festlandchinesischen Wissenschaftlern an erster Stelle steht. Unter den 20 besten Wissenschaftlern der Welt gibt es viele große Namen der KI, wie etwa die Turing-Preisträger Bengio und Hinton. Netizens wiesen darauf hin, dass unter den 100 besten Informatikern in den Vereinigten Staaten nur sieben Frauen seien. Das Research-Ranking der besten Wissenschaftler der Informatik wurde auf die 9. Auflage aktualisiert. Dieses Ranking bewertete verschiedene akademische Indikatoren von mehr als 14.400 Wissenschaftlern weltweit und wählte die 1.000 besten Wissenschaftler aus. Ranking basierend auf der Einbeziehung von O

Die zehn wichtigsten jährlichen wissenschaftlichen Forschungsankündigungen von Science: Das Webb-Teleskop wurde ausgewählt, begleitet von AIGC!

Apr 11, 2023 pm 03:37 PM

Die zehn wichtigsten jährlichen wissenschaftlichen Forschungsankündigungen von Science: Das Webb-Teleskop wurde ausgewählt, begleitet von AIGC!

Apr 11, 2023 pm 03:37 PM

Endlich werden die größten Auszeichnungen des Science Magazine 2022 bekannt gegeben! Am 16. Dezember veröffentlichte die offizielle Website der Wissenschaft die „Top Ten der wissenschaftlichen Durchbrüche im Jahr 2022“, unter denen das Webb-Teleskop die Krone gewann und auf dem Cover der neuesten Ausgabe veröffentlicht wurde. Der Grund für die Auszeichnung des Science-Magazins ist: Aufgrund seiner technischen Meisterleistungen beim Bau und Start und seiner enormen Aussichten für die Erforschung des Universums wurde das James Webb-Teleskop vom Science Magazine zum wissenschaftlichen Durchbruch des Jahres 2022 gekürt. Darüber hinaus wurden auch wichtige Errungenschaften der wissenschaftlichen Gemeinschaft im vergangenen Jahr ausgewählt, darunter AIGC, der erfolgreiche Einschlag der NASA auf einen Asteroiden und die Schaffung von mehrjährigem Reis durch die Universität Yunnan. Lassen Sie uns diese Blockbuster-Studien des vergangenen Jahres Revue passieren lassen. Durchbruch des Jahres – Webb Telescope 12. Juli, NA

Was sind die Vor- und Nachteile der Implementierung künstlicher Intelligenz im Gesundheitswesen?

Apr 12, 2023 pm 10:34 PM

Was sind die Vor- und Nachteile der Implementierung künstlicher Intelligenz im Gesundheitswesen?

Apr 12, 2023 pm 10:34 PM

Künstliche Intelligenz im Gesundheitswesen deckt ein breites Spektrum an Hilfsmitteln für Gesundheitssysteme und Arbeitnehmer ab, aber welche spezifischen Vor- und Nachteile hat die Einführung von KI? Vom Transport bis zur Leistungserbringung hat künstliche Intelligenz (KI) im Laufe der Jahre wissenschaftliche und technologische Entwicklungen bewiesen. insbesondere mit der Implementierung von KI im Gesundheitswesen. Dabei bleibt es jedoch noch nicht. Einer der größten Fortschritte war das Gesundheitswesen, was bei der breiten Öffentlichkeit und bei Medizinern gemischte Reaktionen hervorrief. Künstliche Intelligenz im Gesundheitswesen umfasst ein breites Spektrum an Unterstützung durch Algorithmen und mühsame Aufgaben, die zum Job eines Gesundheitspersonals gehören. Dazu gehört die Rationalisierung zeitaufwändiger Aufgaben, die Rationalisierung komplexer Verfahren und sogar die klinische Entscheidungsfindung in Echtzeit. Aber wie bei allen Aspekten des menschlichen Fortschritts gilt es, das Gesamtbild zu sehen

Müssen Sie nach Sprachmodellen fragen, wenn Sie mit Ihrem Freund ausgehen? Natur: Ideen vorschlagen und Notizen zusammenfassen, GPT-3 ist zu einem zeitgenössischen „wissenschaftlichen Forscher' geworden.

Apr 14, 2023 pm 05:19 PM

Müssen Sie nach Sprachmodellen fragen, wenn Sie mit Ihrem Freund ausgehen? Natur: Ideen vorschlagen und Notizen zusammenfassen, GPT-3 ist zu einem zeitgenössischen „wissenschaftlichen Forscher' geworden.

Apr 14, 2023 pm 05:19 PM

Lassen Sie einen Affen nach dem Zufallsprinzip Tasten auf einer Schreibmaschine drücken, und wenn Sie genügend Zeit haben, kann er die gesamten Werke von Shakespeare abtippen. Was wäre, wenn es ein Affe wäre, der Grammatik und Semantik versteht? Die Antwort ist, dass sogar wissenschaftliche Forschung für Sie erledigt werden kann! Die Entwicklungsdynamik von Sprachmodellen ist sehr schnell. Vor einigen Jahren konnte die Eingabemethode nur das nächste Wort automatisch vervollständigen. Heute kann es Forschern bereits bei der Analyse und beim Schreiben wissenschaftlicher Arbeiten sowie beim Generieren von Code helfen. Das Training großer Sprachmodelle (LLM) erfordert im Allgemeinen umfangreiche Textdaten zur Unterstützung. Im Jahr 2020 veröffentlichte OpenAI das GPT-3-Modell mit 175 Milliarden Parametern. Es kann fast alles, was das generative Modell auch heute noch kann wird immer noch von vielen Sprachmodellen verwendet.

Nobelpreis für Physik 2023 bekannt gegeben, drei Wissenschaftler gewinnen für Attosekunden-Lichtimpulse

Oct 03, 2023 pm 09:21 PM

Nobelpreis für Physik 2023 bekannt gegeben, drei Wissenschaftler gewinnen für Attosekunden-Lichtimpulse

Oct 03, 2023 pm 09:21 PM

Laut Nachrichten dieser Website vom 3. Oktober wurde bekannt gegeben, dass der Nobelpreis für Physik 2023 an Pierre Agostini, Ferenc Kraus und Anne Lhuillier in Anerkennung ihrer Forschungen zu Elektronen in Materie verliehen wird of Dynamics erklärte offiziell, dass „ihr Beitrag es den Menschen ermöglicht, extrem kurze Prozesse zu untersuchen, die vorher nicht verfolgt werden konnten“, und der Preis in Höhe von 11 Millionen schwedischen Kronen (Anmerkung von dieser Website: etwa 7,3 Millionen Yuan). Der Preis wird zu gleichen Teilen unter den Mitgliedern aufgeteilt drei Gewinner. Die Königlich-Schwedische Akademie der Wissenschaften sagte, die drei Physiker hätten „eine Methode zur Erzeugung extrem kurzer Lichtimpulse demonstriert, mit denen der schnelle Prozess der Elektronenbewegung oder Energieänderung gemessen werden kann“, was „die Erforschung der elektronischen Welt im Inneren von Atomen und Molekülen durch den Menschen ermöglicht“. „Neue Wege“. Da reicht die Zeitspanne, in der Menschen die Welt beobachten