Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die Effizienz übertrifft DALL·E 2 und Imagen, Googles neues Modell erreicht neue SOTA und kann auch PS in einem Satz verarbeiten

Die Effizienz übertrifft DALL·E 2 und Imagen, Googles neues Modell erreicht neue SOTA und kann auch PS in einem Satz verarbeiten

Die Effizienz übertrifft DALL·E 2 und Imagen, Googles neues Modell erreicht neue SOTA und kann auch PS in einem Satz verarbeiten

Zu Beginn des neuen Jahres hat Google AI wieder damit begonnen, an Modellen zur Text-Bild-Generierung zu arbeiten.

Dieses Mal erreichte ihr neues Modell Muse ein neues SOTA (derzeit bestes Niveau) im CC3M-Datensatz.

Und seine Effizienz ist weitaus höher als die des beliebten DALL·E 2 und Imagen (beides Diffusionsmodelle) und Parti (ein autoregressives Modell).

——Die Generierungszeit eines einzelnen Bildes mit einer Auflösung von 512 x 512 wird auf nur 1,3 Sekunden komprimiert.

In Bezug auf die Bildbearbeitung können Sie das Originalbild mit nur einem Textbefehl bearbeiten.

(Sieht so aus, als müssten Sie sich keine Gedanken mehr über das Erlernen von PS~ machen)

Wenn Sie einen präziseren Effekt wünschen, können Sie auch die Maskenposition auswählen und einen bestimmten Bereich bearbeiten. Ersetzen Sie beispielsweise die Gebäude im Hintergrund durch Heißluftballons.

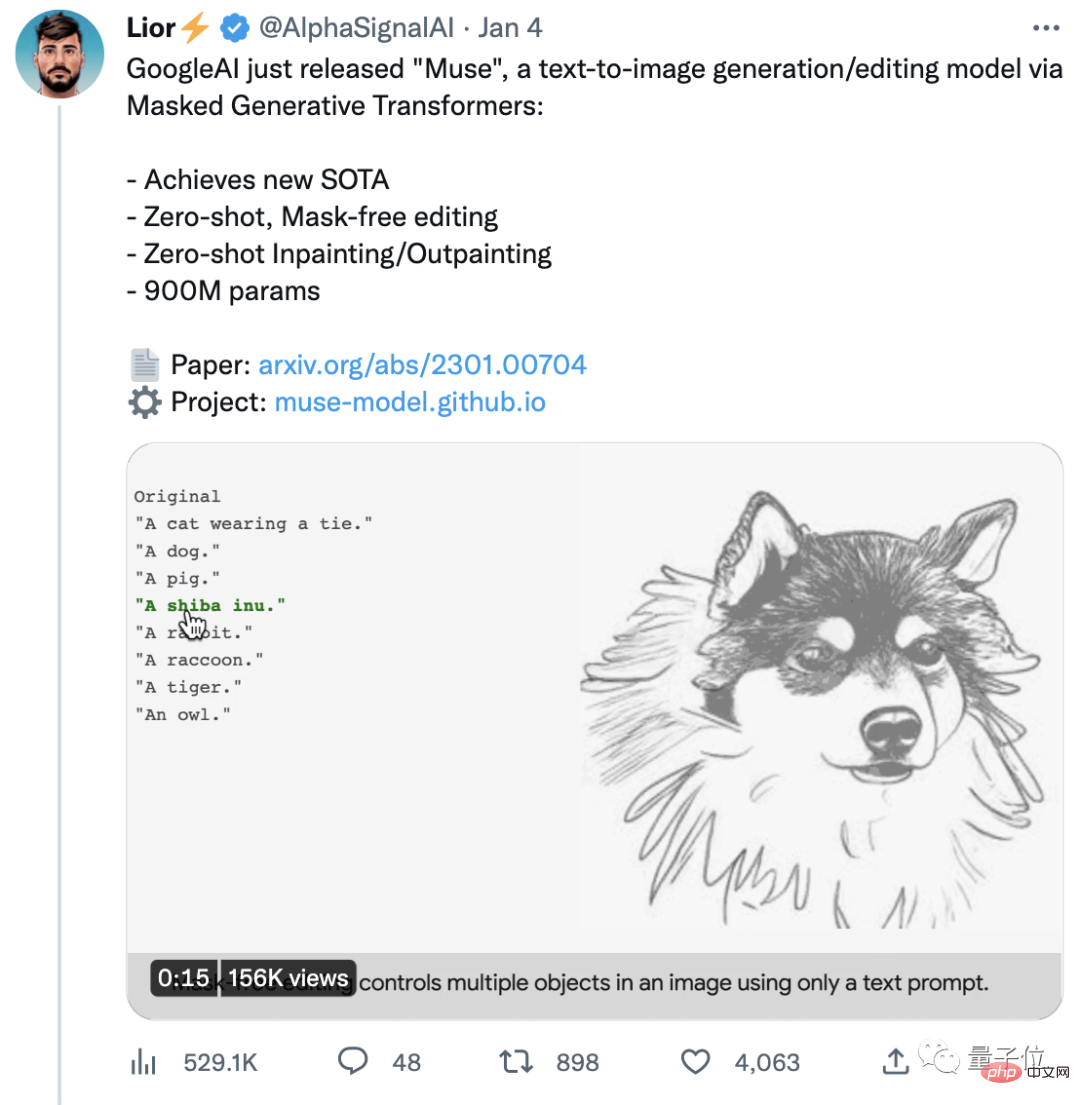

Muse erregte nach der offiziellen Ankündigung schnell große Aufmerksamkeit. Der Originalbeitrag hat bereits über 4.000 Likes erhalten.

Beim Anblick eines weiteren Meisterwerks von Google haben einige sogar begonnen, vorherzusagen:

Der Wettbewerb unter KI-Entwicklern ist jetzt sehr hart und es scheint, dass 2023 ein sehr aufregendes Jahr wird.

Effizienter als DALL·E 2 und Imagen

Zurück zum Muse, das gerade von Google veröffentlicht wurde.

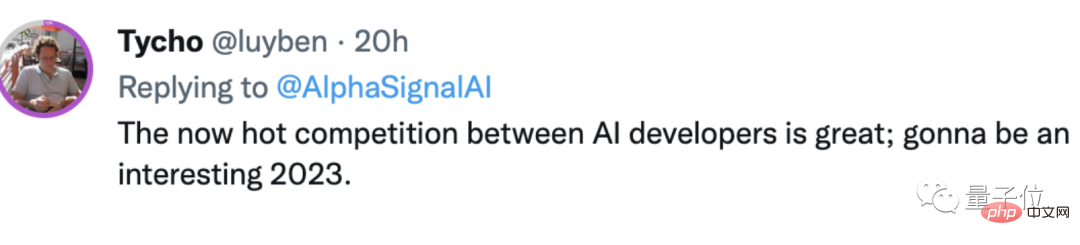

Was zunächst die Qualität der erzeugten Bilder betrifft, weisen die meisten Werke von Muse klare Bilder und natürliche Effekte auf.

Schauen wir uns weitere Beispiele an, um ein Gefühl dafür zu bekommen~

Zum Beispiel bedient ein Faultierbaby mit Wollmütze einen Computer; ein anderes Beispiel ist ein Schaf in einem Weinglas:

Verschiedene Themen die normalerweise nicht mit acht Polen getroffen werden können. Sie koexistieren harmonisch in einem Bild und es gibt kein Gefühl von Dissonanz.

Wenn Sie der Meinung sind, dass dies nur die Grundfunktionen von AIGC sind, können Sie sich auch die Bearbeitungsfunktion von Muse ansehen.

Zum Beispiel Outfitwechsel mit einem Klick (Sie können auch das Geschlecht ändern):

Dies erfordert keine Maskierung und kann in einem Satz erfolgen.

Und wenn Sie eine Maske verwenden, können Sie 6 weitere Vorgänge ausführen, einschließlich des Wechselns des Hintergrunds mit einem Klick vom ursprünglichen Ort nach New York, Paris und dann nach San Francisco.

Sie können auch vom Meer nach London zum Blumenmeer fahren oder sogar zu den Saturnringen im Weltraum fliegen, um einen aufregenden Skateboard-Delfinsprung zu machen.

(Guter Kerl, man kann nicht nur ganz einfach in der Wolke reisen, sondern auch mit einem Klick in den Himmel fliegen...)

Der Effekt ist wirklich hervorragend. Welcher technische Support steckt also hinter Muse? Warum ist die Effizienz höher als bei DALL·E 2 und Imagen?

Ein wichtiger Grund ist, dass DALL·E 2 und Imagen während des Trainingsprozesses das gesamte gelernte Wissen in den Modellparametern speichern müssen.

Sie müssen also immer größere Modelle und immer mehr Trainingsdaten benötigen, um sich mehr Wissen anzueignen – und so „Better and Bigger“ miteinander zu verbinden.

Der Preis besteht darin, dass die Anzahl der Parameter enorm ist und auch die Effizienz beeinträchtigt wird.

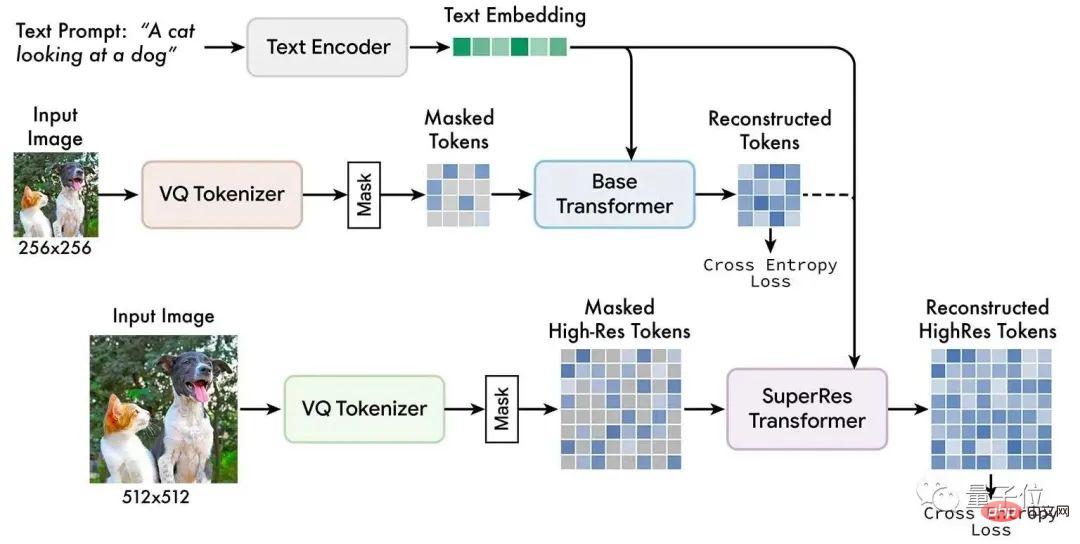

Nach Angaben des Google AI-Teams heißt die Hauptmethode, die sie verwenden: Maskierte Bildmodellierung.

Dies ist eine neue selbstüberwachte Vortrainingsmethode. Ihre Grundidee ist einfach:

Ein Teil des Eingabebildes wird zufällig ausgeblendet und dann durch Textaufgaben vor dem Training rekonstruiert.

Muse-Modelle werden auf diskret beschrifteten räumlichen Masken trainiert und mit Text kombiniert, der aus vorab trainierten großen Sprachmodellen extrahiert wurde, um zufällig maskierte Bildbeschriftungen vorherzusagen.

Von oben nach unten: vorab trainierter Textencoder, Basismodell, Superauflösungsmodell

Das Google-Team hat herausgefunden, dass die Verwendung vorab trainierter großer Sprachmodelle das Sprachverständnis der KI detaillierter und gründlicher machen kann.

In Bezug auf die Ausgabe können die erzeugten Bilder eine hohe Wiedergabetreue aufweisen, da die KI die räumliche Beziehung, die Haltung und andere Elemente von Objekten gut versteht.

Im Vergleich zu Pixelraumdiffusionsmodellen wie DALL·E 2 und Imagen verwendet Muse diskrete Token und hat weniger Sampling-Iterationen.

Darüber hinaus verwendet Muse im Vergleich zu autoregressiven Modellen wie Parti die parallele Dekodierung, was effizienter ist.

SOTA-Score bei FID

Wie bereits erwähnt, hat Muse nicht nur die Effizienz verbessert, sondern ist auch sehr gut bei der Erzeugung von Bildqualität.

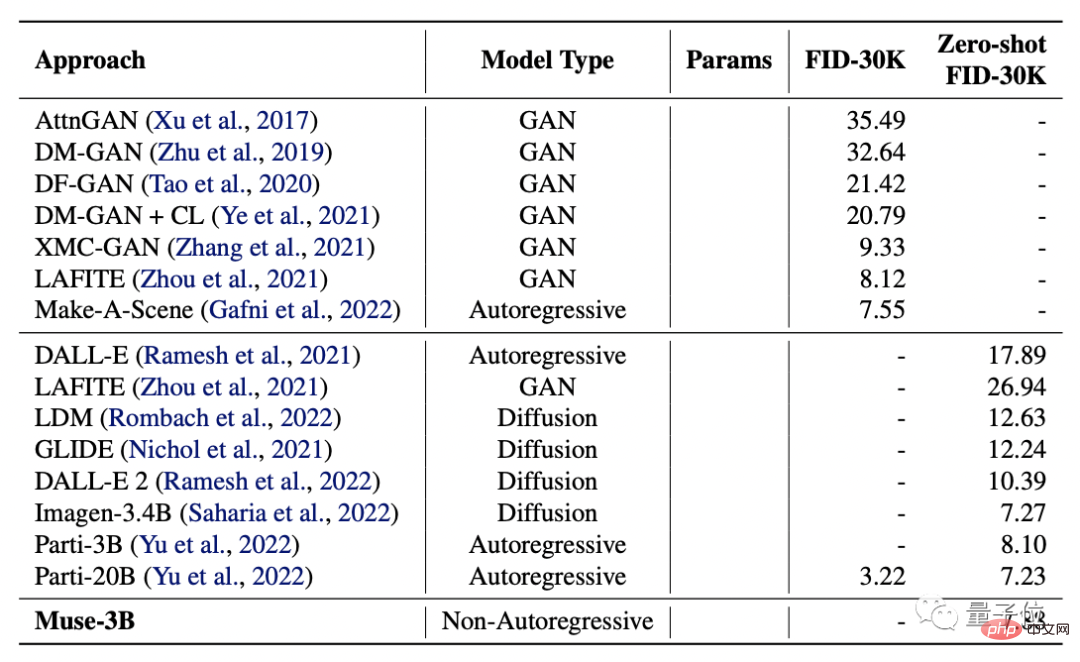

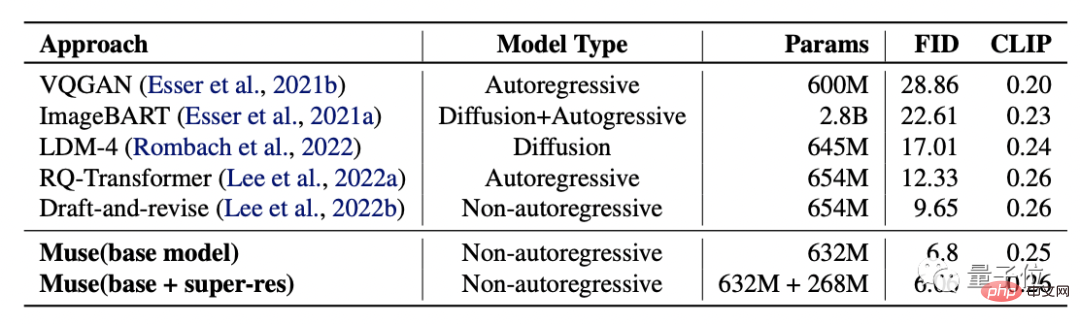

Die Forscher verglichen es mit DALL·E, LAFITE, LDM, GLIDE, DALL·E 2 sowie Googles eigenem Imagen und Parti und testeten deren FID- und CLIP-Scores.

(Der FID-Score wird verwendet, um die Qualität des generierten Bildes zu bewerten. Je niedriger der Score, desto höher die Qualität; der CLIP-Score stellt den Grad der Übereinstimmung zwischen Text und Bild dar. Je höher der Score, desto besser.)

Die Ergebnisse zeigen, dass das Muse-3B-Modell in COCO verifiziert wurde. Der zentralisierte Zero-Shot FID-30K erzielte einen Wert von 7,88 und lag damit an zweiter Stelle hinter den Modellen Imagen-3.4B und Parti-20B mit größeren Parametern.

Noch besser: Das Muse-900M-Modell erreichte einen neuen SOTA im CC3M-Datensatz mit einem FID-Score von 6,06, was auch bedeutet, dass der Übereinstimmungsgrad mit Text am höchsten ist.

Gleichzeitig liegt der CLIP-Score dieses Modells bei 0,26, was im gleichen Zeitraum ebenfalls den höchsten Wert erreicht hat.

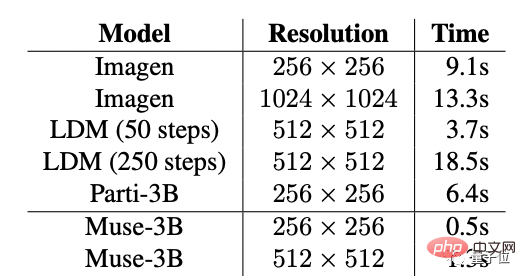

Um die Bildwiedergabeeffizienz von Muse weiter zu bestätigen, verglichen die Forscher außerdem die Einzelbilderzeugungszeit von Muse und anderen Modellen:

Muse erreichte die höchste Auflösung bei 256 x 256 und 512 x 512. Schnelle Geschwindigkeit: 0,5 s und 1,3 s.

Forschungsteam

Muses Forschungsteam kommt von Google und die beiden Co-Autoren sind Huiwen Chang und Han Zhang.

Huiwen Chang, jetzt leitende Forscherin bei Google.

Sie hat als Studentin an der Tsinghua University studiert und an der Princeton University promoviert. Sie hat Praktikumserfahrung bei Adobe, Facebook usw. gesammelt.

Han Zhang erhielt seinen Bachelor-Abschluss von der China Agricultural University, seinen Master-Abschluss von der Beijing University of Posts and Telecommunications und seinen Ph.D. in Informatik von der Rutgers University.

Seine Forschungsrichtungen sind Computer Vision, Deep Learning und medizinische Bildanalyse.

Es ist jedoch erwähnenswert, dass Muse noch nicht offiziell veröffentlicht wurde.

Einige Internetnutzer scherzten, dass Muse aufgrund des „Harnverhaltens“ von Google möglicherweise noch lange von der offiziellen Veröffentlichung entfernt sei, obwohl es sehr wohlriechend sein sollte – schließlich haben sie seit 18 Jahren keine KI mehr veröffentlicht.

Apropos, was haltet Ihr von der Wirkung von Muse?

Freust du dich auf die offizielle Veröffentlichung?

Portal:https://www.php.cn/link/854f1fb6f65734d9e49f708d6cd84ad6

Referenzlink: https://twitter.com / AlphaSignalAI/status/1610404589966180360

Das obige ist der detaillierte Inhalt vonDie Effizienz übertrifft DALL·E 2 und Imagen, Googles neues Modell erreicht neue SOTA und kann auch PS in einem Satz verarbeiten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

Das Neueste von der Universität Oxford! Mickey: 2D-Bildabgleich in 3D SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Das Neueste von der Universität Oxford! Mickey: 2D-Bildabgleich in 3D SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Projektlink vorne geschrieben: https://nianticlabs.github.io/mickey/ Anhand zweier Bilder kann die Kameraposition zwischen ihnen geschätzt werden, indem die Korrespondenz zwischen den Bildern hergestellt wird. Normalerweise handelt es sich bei diesen Entsprechungen um 2D-zu-2D-Entsprechungen, und unsere geschätzten Posen sind maßstabsunabhängig. Einige Anwendungen, wie z. B. Instant Augmented Reality jederzeit und überall, erfordern eine Posenschätzung von Skalenmetriken und sind daher auf externe Tiefenschätzer angewiesen, um die Skalierung wiederherzustellen. In diesem Artikel wird MicKey vorgeschlagen, ein Keypoint-Matching-Prozess, mit dem metrische Korrespondenzen im 3D-Kameraraum vorhergesagt werden können. Durch das Erlernen des 3D-Koordinatenabgleichs zwischen Bildern können wir auf metrische Relativwerte schließen

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins