Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Vernichte AdamW umfassend! Der neue Optimierer von Google verfügt über einen kleinen Speicher und eine hohe Effizienz. Netizens: Das Training von GPT 2 ist wirklich schnell

Vernichte AdamW umfassend! Der neue Optimierer von Google verfügt über einen kleinen Speicher und eine hohe Effizienz. Netizens: Das Training von GPT 2 ist wirklich schnell

Vernichte AdamW umfassend! Der neue Optimierer von Google verfügt über einen kleinen Speicher und eine hohe Effizienz. Netizens: Das Training von GPT 2 ist wirklich schnell

Der Optimierer ist ein Optimierungsalgorithmus und spielt eine Schlüsselrolle beim Training neuronaler Netze. In den letzten Jahren haben Forscher eine große Anzahl manueller Optimierer eingeführt, von denen die meisten adaptive Optimierer sind. Adam- und Adafactor-Optimierer nehmen immer noch den Mainstream beim Training neuronaler Netze ein, insbesondere in den Bereichen Sprache, Vision und Multimodalität.

Neben der manuellen Einführung von Optimierern besteht eine weitere Richtung darin, dass das Programm Optimierungsalgorithmen automatisch erkennt. Jemand hat bereits L2O (Learning to Optimize) vorgeschlagen, das Optimierer durch das Training neuronaler Netze entdeckt. Allerdings werden diese Black-Box-Optimierer normalerweise auf eine begrenzte Anzahl kleiner Aufgaben trainiert und haben Schwierigkeiten bei der Verallgemeinerung auf große Modelle.

Andere haben andere Ansätze ausprobiert, indem sie Verstärkungslernen oder Monte-Carlo-Stichproben angewendet haben, um neue Optimierer zu entdecken. Um die Suche zu vereinfachen, schränken diese Methoden jedoch meist den Suchraum ein und schränken damit die Möglichkeit ein, andere Optimierer zu entdecken. Daher haben aktuelle Methoden noch nicht das SOTA-Niveau erreicht.

In den letzten Jahren ist AutoML-Zero erwähnenswert, das versucht, bei der Bewertung von Aufgaben jede Komponente der Machine-Learning-Pipeline zu durchsuchen, was für die Entdeckung von Optimierern sehr nützlich ist.

In diesem Artikel Forscher von Google und der UCLA schlugen eine Methode zur Entdeckung von Optimierungsalgorithmen für das Training tiefer neuronaler Netze durch Programmsuche vor und entdeckten dann Lion (EvoL ved S ign Momentum) Optimierer. Das Erreichen dieses Ziels steht vor zwei Herausforderungen: Erstens müssen qualitativ hochwertige Algorithmen im unendlich spärlichen Programmraum gefunden werden, und zweitens müssen Algorithmen ausgewählt werden, die sich von kleinen Aufgaben auf größere SOTA-Aufgaben verallgemeinern lassen. Um diesen Herausforderungen zu begegnen, setzt die Forschung eine Reihe von Techniken ein, darunter evolutionäre Suche mit Heißstarts und Neustarts, abstrakte Ausführung, Trichterauswahl und Programmvereinfachung.

- Papieradresse: https://arxiv.org/pdf/2302.06675.pdf

- Projektadresse: https://github.com/google/automl/tree/master/lion

Im Vergleich zu AdamW und verschiedenen adaptiven Optimierern (die sowohl das erste als auch das zweite Moment speichern müssen) benötigt Lion nur Impuls und verwendet symbolische Operationen zur Berechnung von Aktualisierungen und wird zusätzlich die Speichernutzung halbieren. Dies ist nützlich, wenn Sie große Modelle oder große Chargen trainieren. Beispielsweise benötigt AdamW mindestens 16 TPU V4, um ViT-B/16 mit der Bildgröße 224 und der Stapelgröße 4096 zu trainieren, während Lion nur 8 benötigt. Ein weiterer praktischer Vorteil besteht darin, dass Lion aufgrund seiner Einfachheit in Experimenten schnellere Laufzeiten (Schritte/Sek.) aufweist, typischerweise 2–15 % schneller als AdamW und Adafactor, je nach Aufgabe, Codebasis und Hardware.

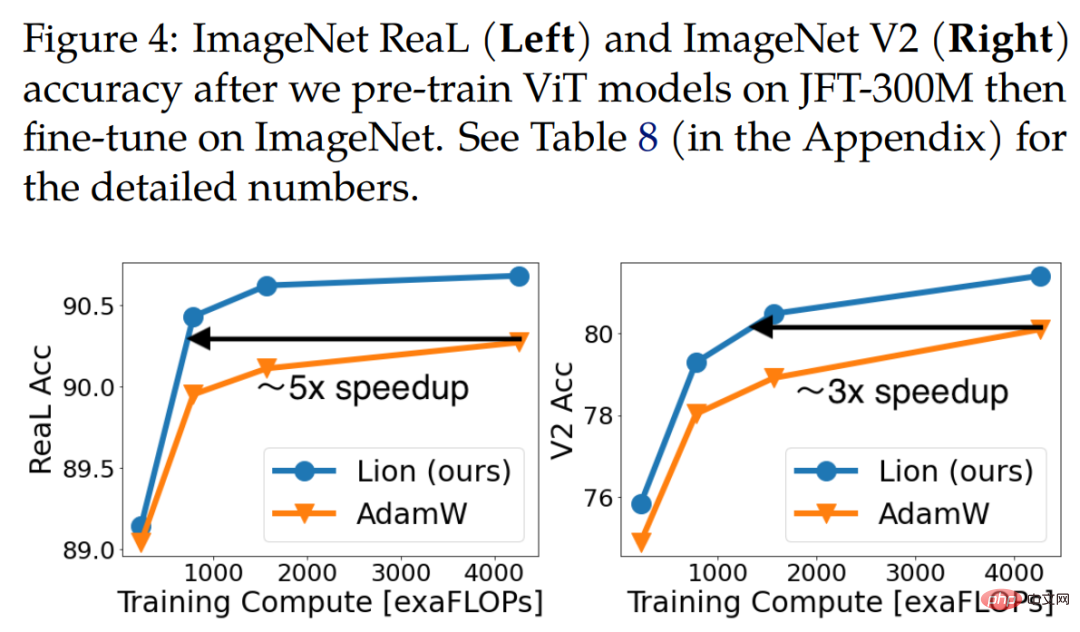

Xiangning Chen, der erste Autor des Papiers, sagte: Unsere Suche nach symbolischen Programmen hat einen effektiven Optimierer gefunden, der nur die Dynamik verfolgt – Lion. Im Vergleich zu Adam wurde eine Genauigkeit von 88,3 % bei der Nullabtastung und 91,1 % bei der Feinabstimmung von ImageNet sowie eine bis zu 5-fache (im Vergleich zu ViT), 2,3-fache (im Vergleich zum Diffusionsmodell) und 2-fache (im Vergleich zu LM) Trainingseffizienz erreicht.

Lion hat bei einer Reihe von Modellen (Transformer, MLP, ResNet, U-Net und Hybrid) und Aufgaben (Bildklassifizierung, visuell-linguistisches kontrastives Lernen, Diffusion, Sprachmodellierung und Feinabstimmung) herausragende Leistungen gezeigt ) Leistung. Es ist erwähnenswert, dass diese Studie durch das Ersetzen von Adafactor durch Lion in BASIC eine Zero-Shot-Genauigkeit von 88,3 % und eine Feinabstimmungsgenauigkeit von 91,1 % auf ImageNet erreichte (Pham et al., 2021) und damit die vorherigen SOTA-Ergebnisse um 2 % bzw. 0,1 übertraf . %.

Darüber hinaus reduziert Lion die Berechnung vor dem Training auf JFT um das bis zu Fünffache, verbessert die Trainingseffizienz von Diffusionsmodellen um das 2,3-fache, erzielt bessere FID-Werte und bietet Verbesserungen bei der Sprachmodellierung. Ähnliche oder bessere Leistung, was Einsparungen ermöglicht bis zum 2-fachen Rechenaufwand.

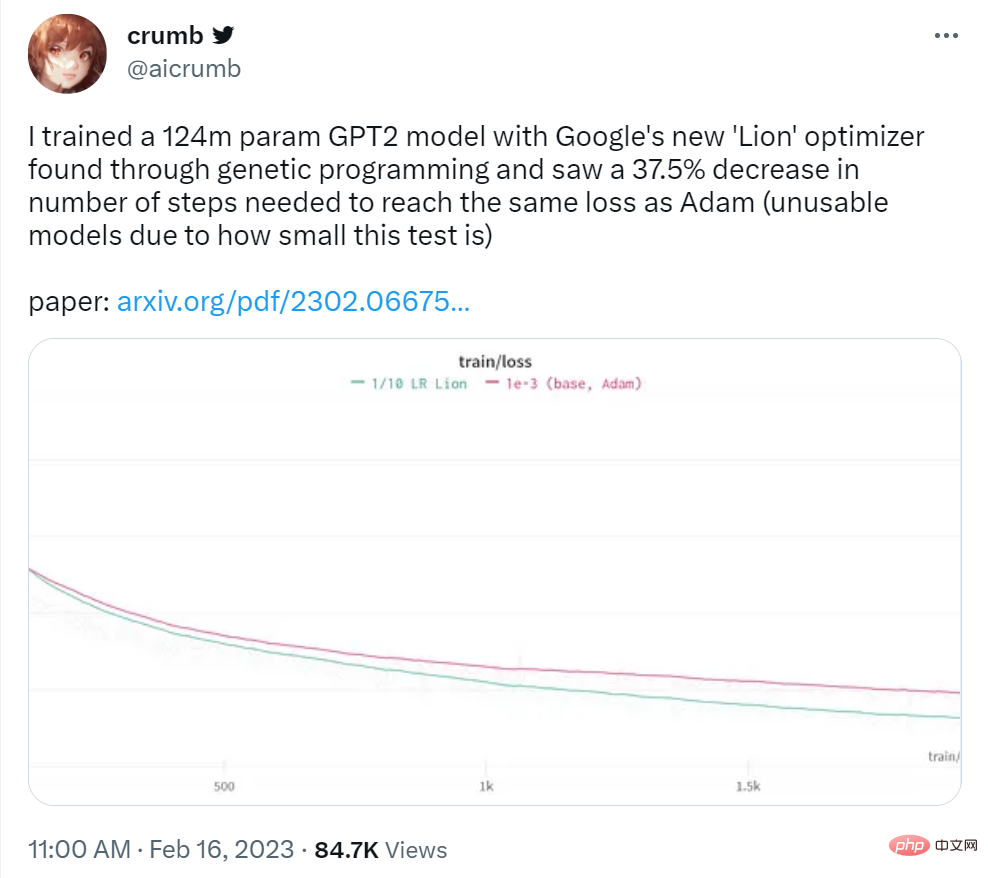

Der Twitter-Benutzer Crumb sagte: Er nutzte den Lion-Optimierer von Google, um ein GPT2-Modell mit 124 Millionen Parametern zu trainieren, und stellte fest, dass die Anzahl der Schritte, die erforderlich waren, um den gleichen Verlust wie bei Adam zu erzielen, um 37,5 % reduziert wurde.

Bildquelle: https://twitter.com/aicrumb/status/1626053855329898496

Symbolerkennung von Algorithmen

Dieser Artikel verwendet Symbole in Form von Programmen die folgenden Vorteile: (1) Es steht im Einklang mit der Tatsache, dass Algorithmen als Programme ausgeführt werden müssen. (2) Im Vergleich zu parametrischen Modellen wie neuronalen Netzen sind symbolische Darstellungen wie Programme einfacher zu analysieren, zu verstehen und auf neue Aufgaben zu übertragen ; (3) Programmlänge kann verwendet werden. Die Schätzung der Komplexität verschiedener Programme erleichtert die Auswahl einfacherer, oft vielseitigerer Programme. Diese Arbeit konzentriert sich auf Optimierer für das Training tiefer neuronaler Netze, der Ansatz ist jedoch allgemein auf andere Aufgaben anwendbar .

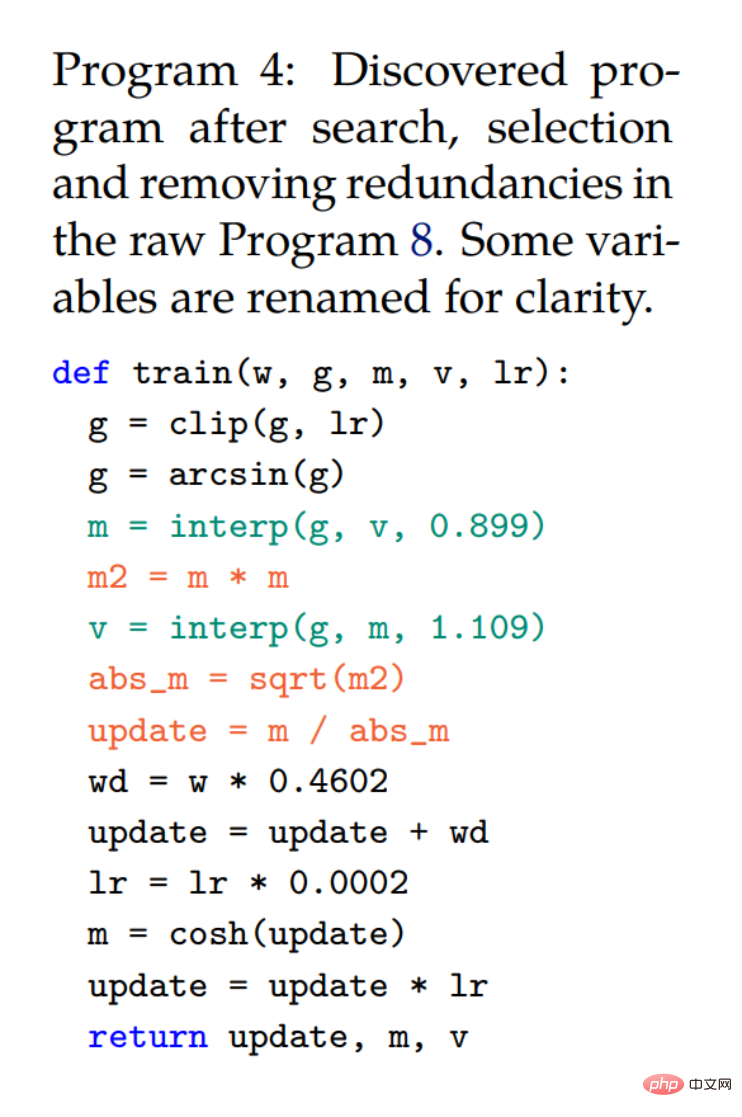

In der Abbildung unten verwendet der vereinfachte Codeausschnitt von Programm 2 dieselbe Signatur wie AdamW, um sicherzustellen, dass der entdeckte Algorithmus einen kleineren oder gleichen Speicherbedarf hat, wie in Programm 3 dargestellt.

Diese Forschung wendet die folgenden Techniken an, um die Herausforderungen zu lösen, die durch unendliche und spärliche Suchräume entstehen. Die erste besteht darin, die Regularisierung anzuwenden, da sie bei vielen AutoML-Suchaufgaben einfach, skalierbar und erfolgreich ist; die zweite besteht darin, die Redundanz im Programmbereich zu vereinfachen, und schließlich reduziert diese Studie die Modellgröße und die Anzahl der Trainingsbeispiele und Schritte von der Zielaufgabe entfernt, um die Kosten zu senken.

Links: Gezeigt sind die Mittelwerte und Standardfehler von fünf Experimenten zur evolutionären Suche. Rechts: Sowohl der Prozentsatz redundanter Anweisungen als auch die Cache-Trefferquote steigen mit fortschreitender Suche.

Ableitung und Analyse von Lion

Forscher sagten, dass der Optimierer Lion Einfachheit, hohe Speichereffizienz und leistungsstarke Leistung bei Suche und Metavalidierung aufweist.

Ableitung

Der Such- und Trichterauswahlprozess führte zu Programm 4, das durch automatisches Entfernen überflüssiger Anweisungen aus dem ursprünglichen Programm 8 (Anhang) erhalten wurde. Der Forscher vereinfachte weiter und erhielt den endgültigen Algorithmus (Lion) in Programm 1. Im Rahmen des Vereinfachungsprozesses wurden mehrere unnötige Elemente aus Programm 4 entfernt. wobei die Cosh-Funktion entfernt wird, da m in der nächsten Iteration neu zugewiesen wird (Zeile 3). Auch Aussagen mit Arcsin und Clip wurden entfernt, da die Forscher ohne diese keinen Qualitätsverlust feststellen konnten. Die drei roten Aussagen werden in eine symbolische Funktion umgewandelt.

Obwohl m und v in Programm 4 zusammen verwendet werden, ändert v nur die Art und Weise, wie der Impuls aktualisiert wird (zwei Interpolationsfunktionen mit Konstanten ∼0,9 und ∼1,1 entsprechen einer Funktion mit ∼0,99) und muss nicht verwendet werden separat verfolgen. Beachten Sie, dass eine Bias-Korrektur nicht mehr erforderlich ist, da sie die Richtung nicht ändert.

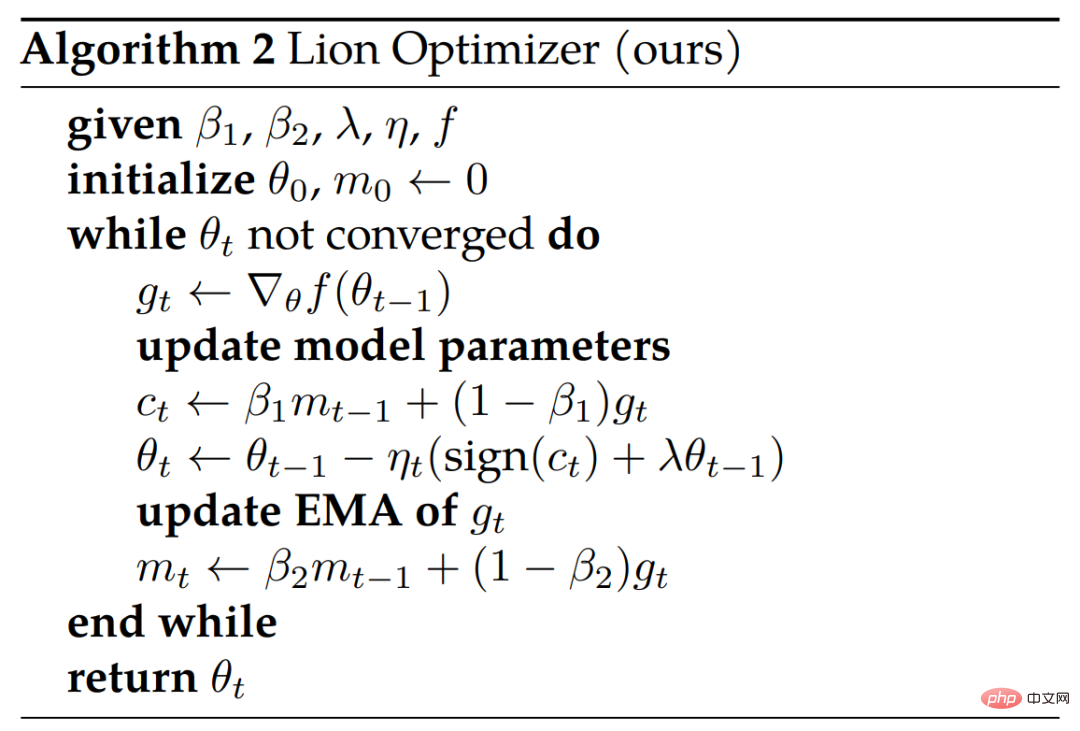

Algorithmus 2 unten zeigt den Pseudocode.

Analyse

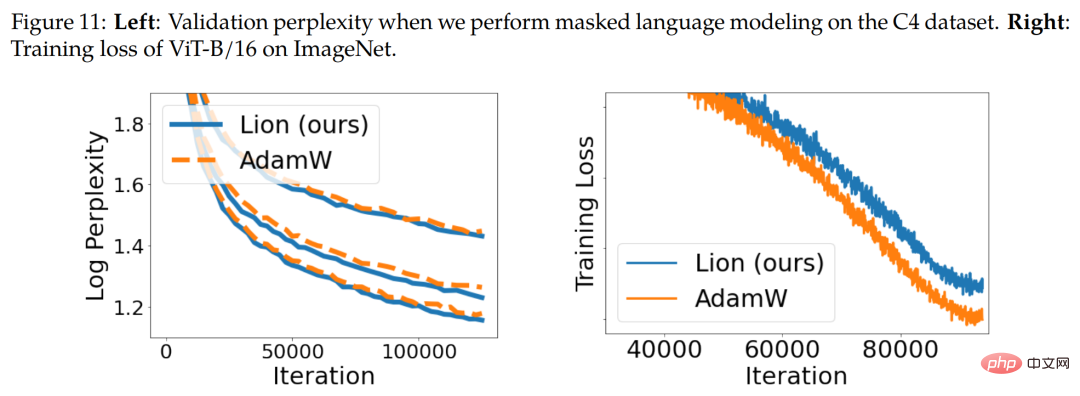

Symbolaktualisierung und Regularisierung. Der Lion-Algorithmus erzeugt durch symbolische Operationen Aktualisierungen mit einheitlicher Größe in allen Dimensionen, was sich grundsätzlich von verschiedenen adaptiven Optimierern unterscheidet. Intuitiv fügen symbolische Operationen den Aktualisierungen Rauschen hinzu, wirken als eine Form der Regularisierung und unterstützen die Generalisierung. Abbildung 11 unten (rechts) zeigt ein Beweisstück.

Momentum-Tracking. Der standardmäßige EMA-Faktor für die Verfolgung des Momentums in Lion beträgt 0,99 (β_2) im Vergleich zu den 0,9, die üblicherweise in AdamW und Momentum SGD verwendet werden. Diese Auswahl an EMA-Faktoren und Interpolation ermöglicht es Lion, ein Gleichgewicht zwischen der Speicherung des zehnfachen Verlaufs des Impulsgradienten und der stärkeren Gewichtung des aktuellen Gradienten in Aktualisierungen zu finden.

Hyperparameter- und Chargengrößenauswahl. Im Vergleich zu AdamW und Adafactor ist Lion einfacher und verfügt über weniger Hyperparameter, da es keine ϵ- und Faktorisierungsparameter erfordert. Lion erfordert eine geringere Lernrate und damit einen größeren entkoppelten Gewichtsabfall, um eine ähnliche effektive Gewichtsabfallstärke (lr * λ) zu erreichen.

Speicher- und Laufzeitvorteile. Lion speichert nur Dynamik und hat einen geringeren Speicherbedarf als beliebte adaptive Optimierer wie AdamW, was beim Training großer Modelle und/oder beim Arbeiten mit großen Batchgrößen nützlich ist. Beispielsweise benötigt AdamW mindestens 16 TPU-V4-Chips, um ViT-B/16 mit einer Bildauflösung von 224 und einer Stapelgröße von 4.096 zu trainieren, während Lion nur 8 benötigt (beide mit bfloat16-Momentum).

Lion-Bewertungsergebnisse

Im experimentellen Teil bewerteten die Forscher Lion anhand verschiedener Benchmarks und verglichen es hauptsächlich mit dem beliebten AdamW (oder Adafactor, wenn der Speicher zum Engpass wird).

Bildklassifizierung

Forscher führen Experimente zu verschiedenen Datensätzen und Architekturen zu Bildklassifizierungsaufgaben durch. Zusätzlich zum Training von Grund auf auf ImageNet haben sie auch zwei größere ausgereifte Datensätze, ImageNet-21K und JFT, vorab trainiert. Die Bildgröße ist standardmäßig auf 224 eingestellt.

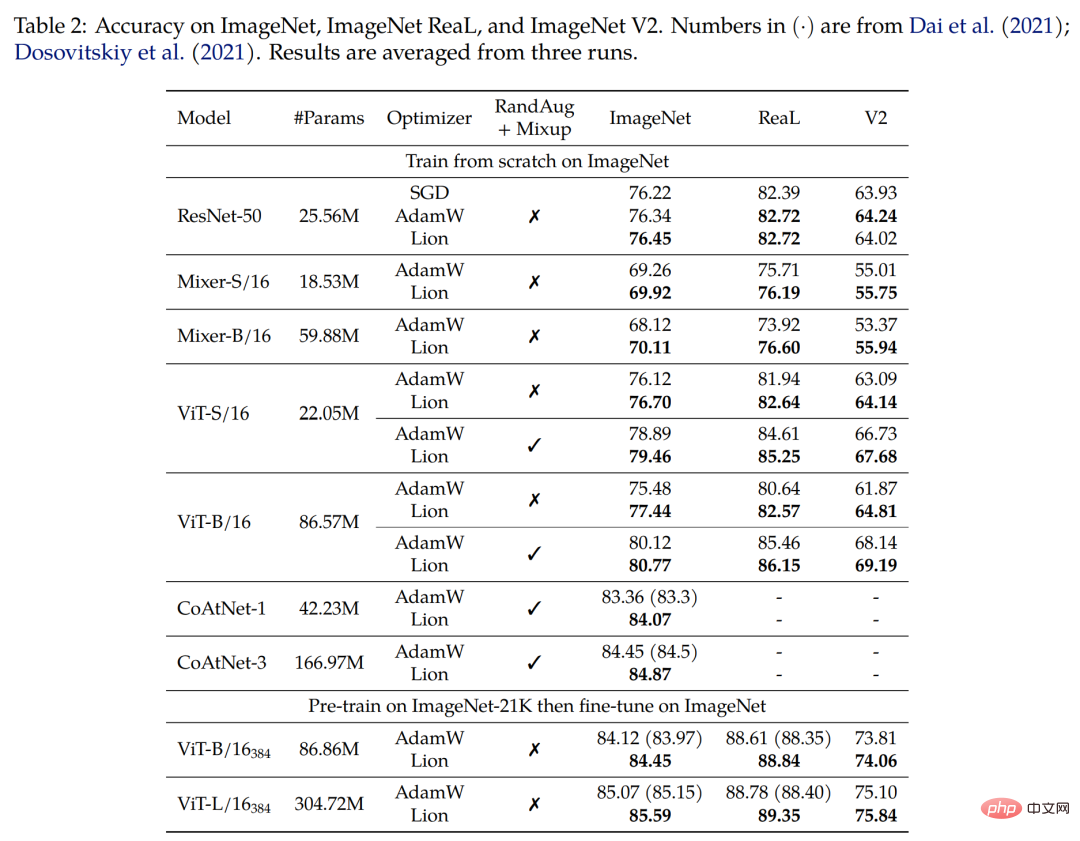

Erster Zug von Grund auf auf ImageNet. Die Forscher trainierten ResNet-50 für 90 Epochen mit einer Stapelgröße von 1.024 und die anderen Modelle für 300 Epochen mit einer Stapelgröße von 4.096. Wie in Tabelle 2 unten gezeigt, übertrifft Lion AdamW auf verschiedenen Architekturen deutlich.

Zweitens trainieren Sie vorab auf ImageNet-21K. Die Forscher trainierten ViT-B/16 und ViT-L/16 auf ImageNet-21K für 90 Epochen mit einer Stapelgröße von 4.096. Tabelle 2 unten zeigt, dass Lion AdamW immer noch übertrifft, selbst wenn der Trainingssatz um das Zehnfache vergrößert wird.

Endlich Vortraining auf JFT. Um die Grenzen zu erweitern, führen Forscher zahlreiche Experimente zu JFT durch. Abbildung 4 unten zeigt die Genauigkeit von drei ViT-Modellen (ViT-B/16, ViT-L/16 und ViT-H/14) unter verschiedenen Budgets vor dem Training auf JFT-300M. Lion ermöglicht es ViT-L/16, die Leistung von AdamWs ViT-H/14 zu erreichen, das auf ImageNet und ImageNet V2 trainiert wurde, jedoch zu dreimal geringeren Kosten vor dem Training.

Tabelle 3 unten zeigt die Ergebnisse der Feinabstimmung mit höherer Auflösung und Polyak-Mittelwertbildung. Der von den Forschern verwendete ViT-L/16 entspricht den Ergebnissen des zuvor von AdamW trainierten ViT-H/14, verfügt jedoch über 2x weniger Parameter. Nach der Erweiterung des Pre-Training-Datensatzes auf JFT-3B übertrifft das von Lion trainierte ViT-g/14 frühere ViT-G/14-Ergebnisse mit 1,8-mal weniger Parametern.

Kontrastives Lernen visueller Sprache

Dieser Abschnitt konzentriert sich auf das kontrastive Training visueller Sprache im CLIP-Stil. Anstatt alle Parameter von Grund auf zu lernen, initialisierten die Forscher den Bildencoder mithilfe eines leistungsstarken vorab trainierten Modells.

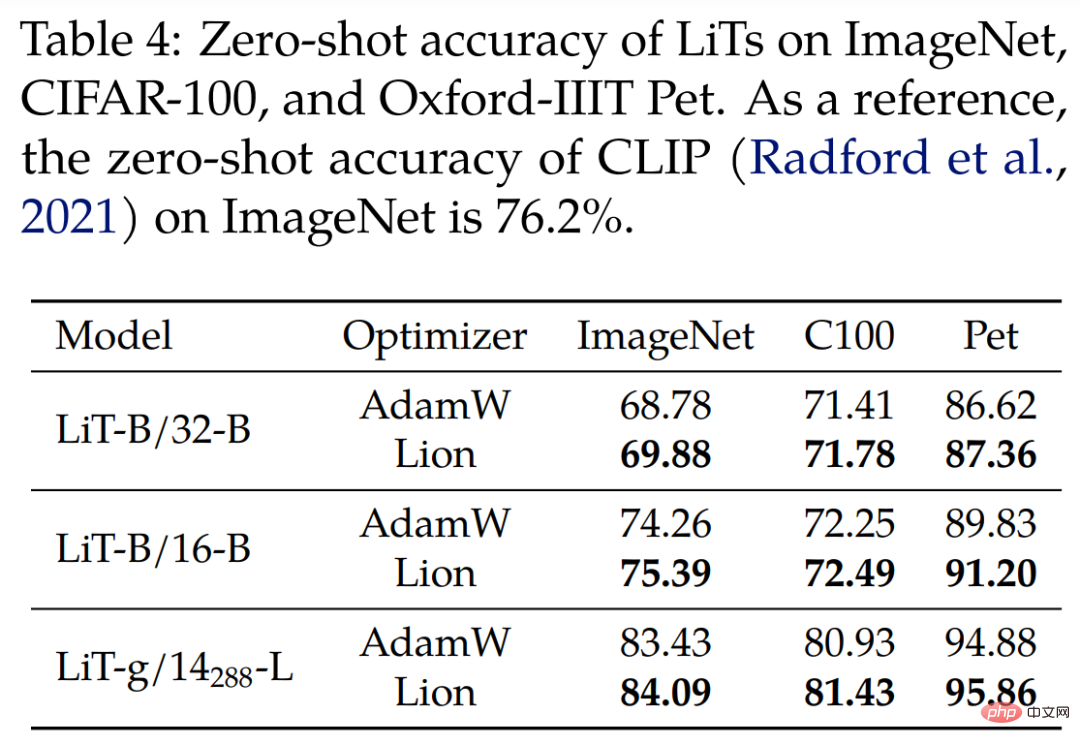

Für Locked Image Text Tuning (LiT) verglichen die Forscher Lion und AdamW auf LiT, indem sie Textencoder vergleichend mit demselben eingefrorenen, vorab trainierten ViT trainierten. Tabelle 4 unten zeigt die Ergebnisse der Zero-Shot-Bildklassifizierung in drei Modellmaßstäben, wobei Lion eine kontinuierliche Verbesserung gegenüber AdamW zeigt.

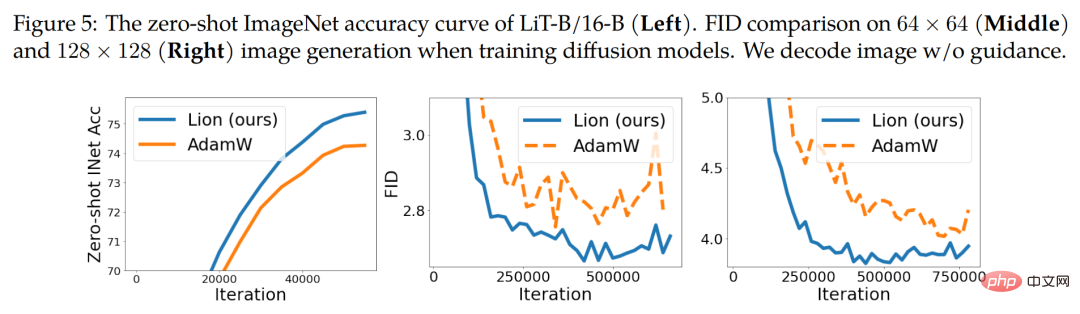

Abbildung 5 unten (links) zeigt eine beispielhafte Zero-Shot-Lernkurve für LiT-B/16-B mit ähnlichen Ergebnissen für die anderen beiden Datensätze.

Diffusionsmodell

In letzter Zeit haben Diffusionsmodelle große Erfolge bei der Bilderzeugung erzielt. Angesichts seines enormen Potenzials haben wir Lion auf bedingungslose Bildsynthese und multimodale Text-zu-Bild-Generierung getestet.

Für die Bildsynthese auf ImageNet verwendeten die Forscher die verbesserte U-Net-Architektur, die in der Arbeit „Diffusion models beat gans on image synthesize“ aus dem Jahr 2021 eingeführt wurde, um 64×64, 128×128 und 256×256 auf ImageNet-Bilderzeugung durchzuführen . Wie in Abbildung 5 oben (Mitte und rechts) dargestellt, kann Lion eine bessere Qualität und eine schnellere Konvergenz der FID-Scores erzielen.

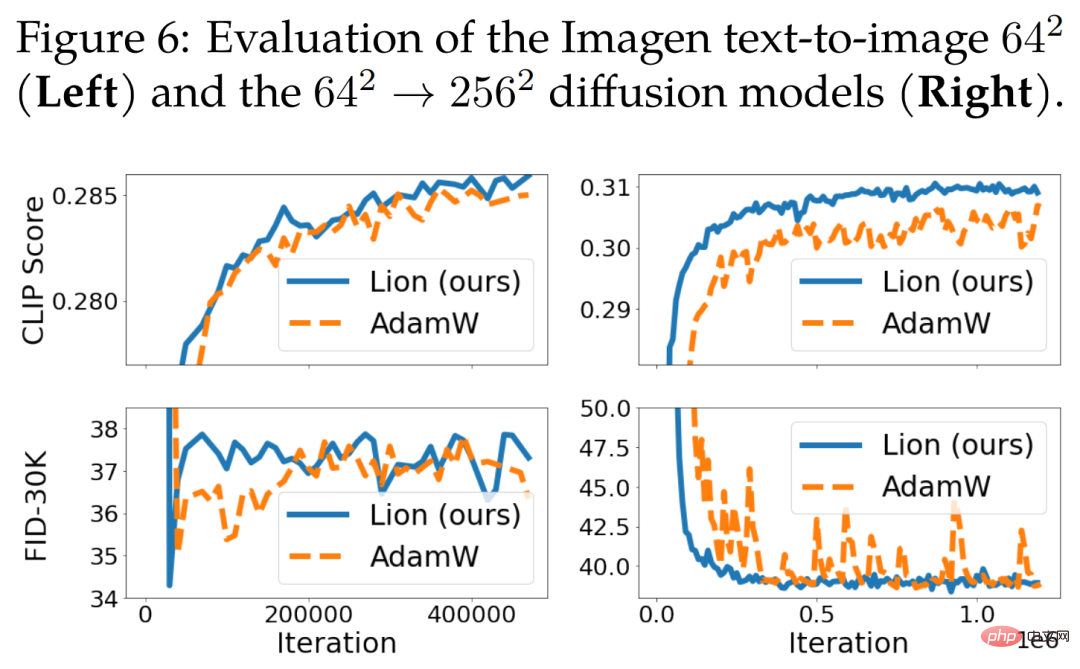

Für die Text-zu-Bild-Generierung zeigt Abbildung 6 unten die Lernkurve. Obwohl es keine signifikante Verbesserung gegenüber dem 64 × 64-Basismodell gibt, übertrifft Lion AdamW beim textbedingten Superauflösungsmodell. Lion erreicht im Vergleich zu AdamW höhere CLIP-Werte und weist kleinere verrauschte FID-Metriken auf.

Sprachmodellierung und Feinabstimmung

Dieser Abschnitt konzentriert sich auf Sprachmodellierung und Feinabstimmung. Bei reinen Sprachaufgaben fanden Forscher heraus, dass die Anpassung von β_1 und β_2 die Qualität von AdamW und Lion verbessern kann.

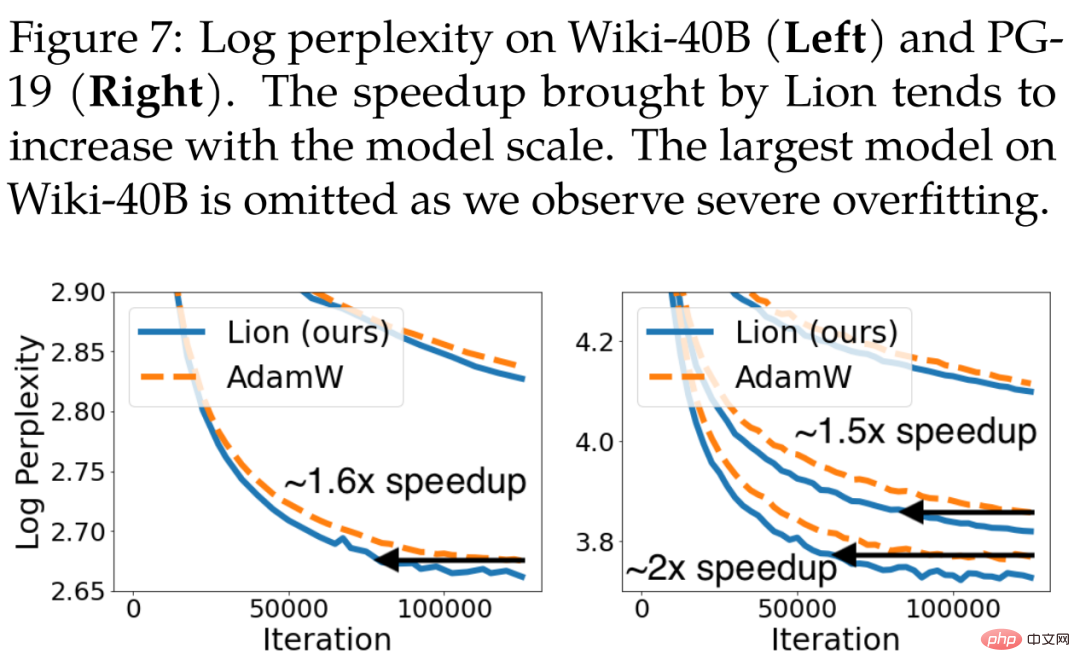

Für die autoregressive Sprachmodellierung zeigt Abbildung 7 unten die Verwirrung auf Token-Ebene von Wiki-40B und die Verwirrung auf Wortebene von PG-19. Lion erreicht durchweg eine geringere Verifizierungsproblematik als AdamW. Beim Training mittelgroßer Modelle auf Wiki-40B bzw. PG-19 werden Geschwindigkeitssteigerungen von 1,6x bzw. 1,5x erreicht. PG-19 erreicht außerdem eine 2-fache Geschwindigkeitssteigerung, wenn das Modell auf eine große Größe vergrößert wird.

Für die maskierte Sprachmodellierung führten die Forscher auch ein BERT-Training für den C4-Datensatz durch, wobei Lion in Bezug auf die Verifizierungsperplexität etwas besser abschnitt als AdamW. Die entsprechende Lernkurve ist in Abbildung 11 unten (links) dargestellt.

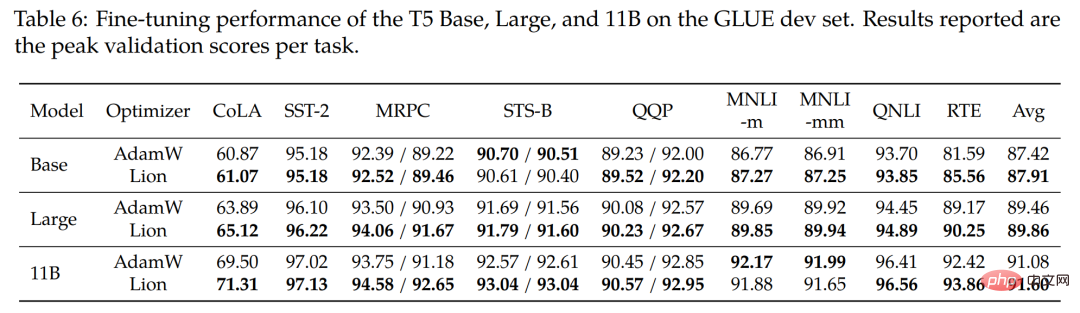

Zur Feinabstimmung haben die Forscher die Modelle Base (220M), Large (770M) und das größte 11B T5-Modell auf dem GLUE-Benchmark optimiert. Tabelle 6 unten zeigt die Ergebnisse des GLUE-Entwicklersatzes, wobei Lion im Durchschnitt AdamW in allen drei Modellgrößen schlägt.

Vergleich mit anderen beliebten Optimierern

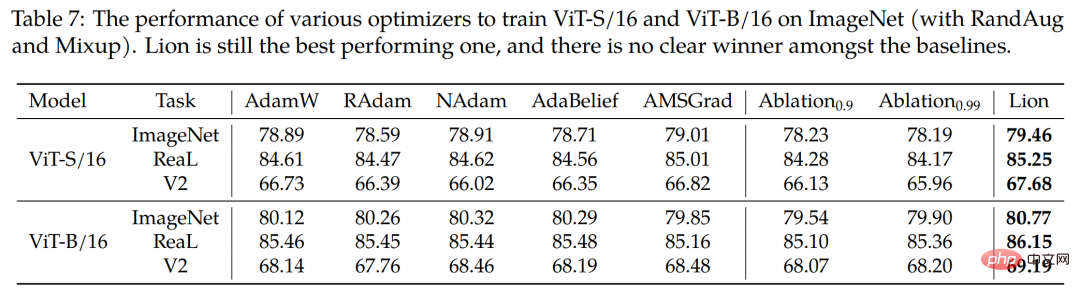

Die Studie verwendet außerdem vier beliebte Optimierer RAdam, NAdam, AdaBelief und AMSGrad, um ViT-S/16 auf ImageNet und ViT-B/ zu trainieren. 16 (mit RandAug und Mixup). Wie in Tabelle 7 unten gezeigt, bleibt Lion der Spitzenreiter.

Weitere technische Details finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonVernichte AdamW umfassend! Der neue Optimierer von Google verfügt über einen kleinen Speicher und eine hohe Effizienz. Netizens: Das Training von GPT 2 ist wirklich schnell. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil