Zwei Gerüchte und aktuelle Vorhersagen für GPT-4!

Autor |. Yun Zhao

Am 9. März brachte Andreas Braun, CTO von Microsoft Deutschland, auf der KI-Auftaktkonferenz eine lang erwartete Neuigkeit: „Wir werden nächste Woche GPT-4 starten, wenn wir Multimodal starten.“ Modi, die völlig unterschiedliche Möglichkeiten bieten – wie Videos Dinge, die bisher nur von Menschen gelesen und verstanden werden konnten. Gleichzeitig hat sich die Technologie dahingehend weiterentwickelt, dass sie „für alle Sprachen verfügbar“ ist: Sie können Fragen auf Deutsch stellen und auf Italienisch antworten. Mit Multimodalität wird Microsoft (-OpenAI) „Modelle umfassend machen“.

Es scheint grundsätzlich sicher zu sein, dass GPT-4 ein großes multimodales Modell sein wird. Wenn Sie jedoch die wahre Identität von GPT-4 im Voraus wissen möchten, ist es nicht unmöglich, sie zu finden.

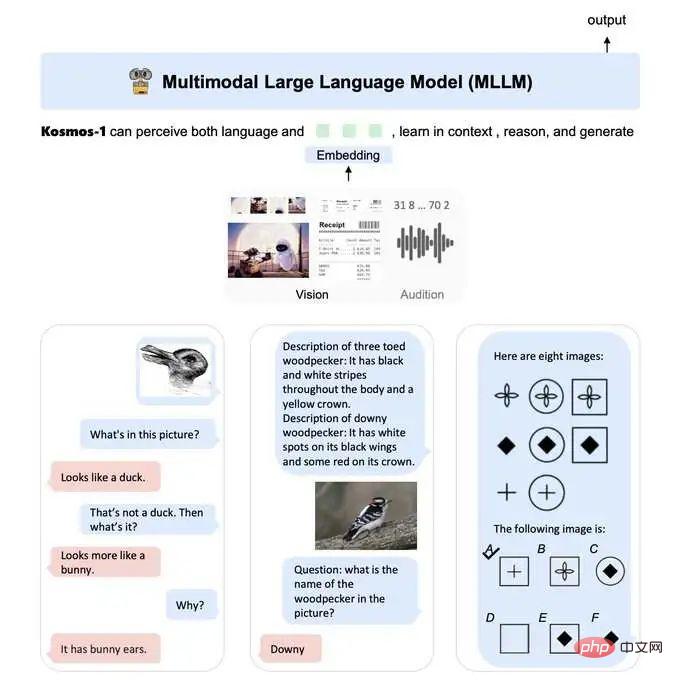

KOSMOS-1 ist ein multimodales großes Sprachmodell (MLLM), das in der Lage ist, multimodale Eingaben wahrzunehmen, Anweisungen zu befolgen und Kontextlernaufgaben durchzuführen, bei denen es sich auch um multimodale Aufgaben handeln kann. In dieser Arbeit richten wir unsere Vision an großen Sprachmodellen (LLMs) aus und treiben so die Entwicklung von LLMs zu MLLMs voran.

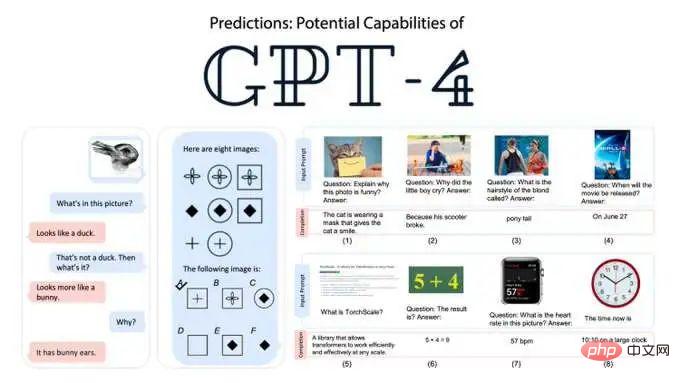

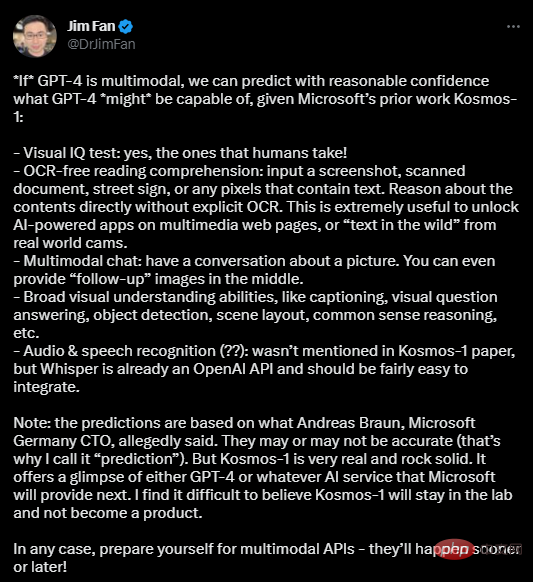

Der Stanford Ph.D. und der NVIDIA-KI-Wissenschaftler Jim Fan haben auf dieser Grundlage 5 konkrete Vorhersagen getroffen:

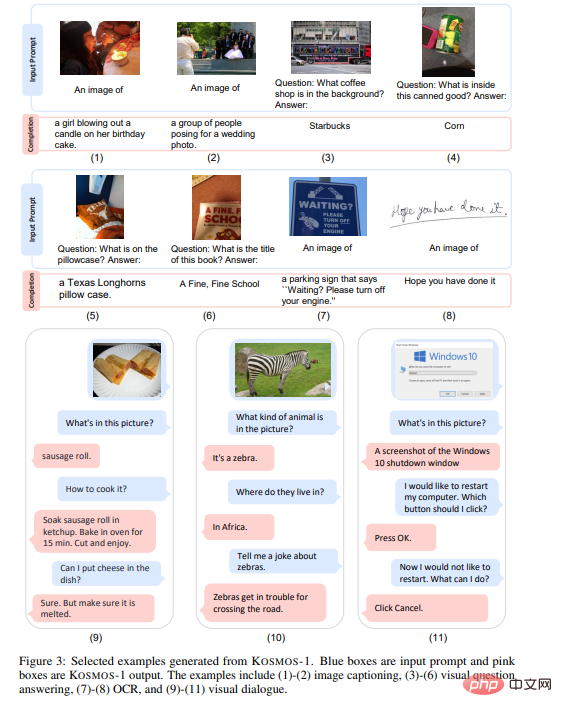

(1) Visueller IQ-Test: Ja, ein Test für Menschen! (2) Kein OCR-Leseverständnis: Eingabe-Screenshots, gescannte Dokumente, Straßenschilder oder Pixel mit Text. Argumentieren Sie direkt über Inhalte ohne explizite OCR. Dies ist nützlich, um KI-gesteuerte Anwendungen auf Multimedia-Webseiten oder „Text in freier Wildbahn“ von realen Kameras freizuschalten. (3) Multimodaler Chat: Unterhalten Sie sich über Bilder. Sie können sogar nach der Hälfte der Bearbeitung ein „Folgebild“ bereitstellen. (4) Umfangreiche visuelle Verständnisfunktionen wie Untertitel, visuelle Fragen und Antworten, Objekterkennung, Szenenlayout, logisches Denken usw. (5) Audio- und Spracherkennung: Im Kosmos-1-Papier nicht erwähnt, aber Whisper ist bereits eine OpenAI-API und sollte einfach zu integrieren sein. Jim glaubt, dass es aufgrund der jüngsten Ankündigung von Andreas einige Abweichungen bei den Vorhersagen geben könnte. Aber Kosmos-1 hat dies bereits getan. Es gibt Grund zu der Annahme, dass es Funktionen für GPT-4 oder jeden KI-Dienst bereitstellt, den Microsoft als nächstes anbieten wird. „Es ist kaum zu glauben, dass Kosmos-1 im Labor bleibt und kein Produkt wird.“

Beispiele für multimodale Großmodellanwendungen: Bilderfassung, Bildfrage und -antwort, OCR, visueller Dialog

Jim rät Praktikern: „Bitte seien Sie auf multimodale APIs vorbereitet – sie werden früher oder später kommen Wird erscheinen! „

Zweitens gibt es nicht genügend Daten. Obwohl der multimodale GPT-4 im Begriff ist, leistungsstarke Seh-, Hör-, Leseverständnis- und Denkfähigkeiten zu demonstrieren, ist dies nur die Spitze des Eisbergs von AGI. Am Beispiel humanoider Roboter ist es schwierig, die Steuerungsdaten zu vereinheitlichen der Roboter und „Diese Steuerdaten hängen mit der Roboterhardware zusammen und variieren stark.“ Daher können Trainingsdaten verschiedener realer Roboter nicht einfach kombiniert werden, was sich qualitativ von Daten wie Text, Video, Bild, Audio usw. unterscheidet.

3. Zwei Gerüchte über GPT-4

1. Gefälscht!

GPT-4 ist ein neues Sprachmodell, das von OpenAI entwickelt wird und Text erzeugen kann, der der menschlichen Sprache ähnelt. Es wird die von ChatGPT verwendete Technologie weiterentwickeln, die auf GPT-3.5 basiert.

Bereits im August 2021 spekulierten Branchenexperten, dass GPT-4 100 Billionen Parameter haben würde, aber einige Leute sagten damals: Der Aufbau einer KI mit mehr Parametern garantiert nicht unbedingt eine bessere Leistung und kann sich auf die Reaktionsfähigkeit auswirken.

Aber Altman, der Vater von ChatGPT, widerlegte schnell die Gerüchte: Die nächste Version von ChatGPT wird weder AGI sein noch 100 Billionen Parameter haben. Diese Gerüchte sind unwahr.

2.Verwendet der Bing-Chat GPT-4?

Microsoft hat gesagt, dass das neue Bing oder Bing Chat leistungsfähiger ist als ChatGPT. Da der Chat von OpenAI GPT-3.5 verwendet, spekulieren einige, dass der Bing-Chat möglicherweise GPT-4 verwendet. Dies wurde nicht bestätigt.

Offensichtlich wurde Bing Chat aktualisiert, um Zugriff auf aktuelle Informationen über das Internet zu ermöglichen, was eine enorme Verbesserung gegenüber ChatGPT darstellt, das bisher nur von Trainingsdaten profitieren konnte, die vor 2021 eingegangen sind.

Neben dem Internetzugang sind die für den Bing-Chat verwendeten KI-Modelle viel schneller, was sehr wichtig ist, wenn sie aus dem Labor genommen und der Suchmaschine hinzugefügt werden.

Aber es scheint unwahrscheinlich, dass dies mit dem GPT-4-Modell von OpenAI gleichwertig ist. Wenn GPT-4 bereits öffentlich verfügbar ist, besteht keine Notwendigkeit mehr, es geheim zu halten.

4. GPT-4: Eine Evolution, keine Revolution

Es besteht kein Zweifel, dass das kommende GPT-4 die Leute definitiv beeindrucken wird, aber OpenAI-CEO Sam Altman wurde von StrictlyVC interviewt: „Die Leute ‚betteln‘ darum.“ „Wir sind enttäuscht, und sie werden enttäuscht sein“, sagte Altman. Altman twitterte zuvor auch über das Potenzial von AGI, der Weltwirtschaft großen Schaden zuzufügen, und sagte, dass ein paar kleine Änderungen schnell umgesetzt würden. , ist besser als alarmierende Fortschritte, die wenig Chancen bieten damit sich die Welt an Veränderungen anpassen kann.

Zufälligerweise hat der Weltklasse-Meister der künstlichen Intelligenz, Ben Goertzel, auch viel kaltes Wasser auf GPT-3/GPT-4 gegossen:

Natürlich sollten die Leute jetzt bemerken, dass in diese „Wissensumordnungs“-Systeme investiert wird (z. B. Der Betrag an Geld und Arbeitskraft, der in ChatGPT investiert wird, ist weitaus größer als der Betrag, der in alternative KI-Ansätze investiert wird, die die Komplexität fundierter, selbstkorrigierender Kognition stärker berücksichtigen.

Die umfassende Skepsis gegenüber mehrschichtigen neuronalen Netzen und der Einführung von Expertensystemen in den späten 1970er und frühen 1990er Jahren schien naiv, archaisch und dumm, ähnlich wie heute.

? Sie sind weder cool noch nützlich – es handelt sich lediglich um eine trendige neue, schmale KI-Technologie, die nicht so stark mit AGI verbunden ist, wie es scheint oder wie einige Kommentatoren behaupten. Kurz gesagt: GPT-4 wird eine Weiterentwicklung sein, keine Revolution. 5. Am Ende geschrieben Natürlich wird ChatGPT 4 wahrscheinlich nicht der Name des nächsten Produkts von OpenAI sein, aber es wird sehr wahrscheinlich etwas kreative Fantasie mit sich bringen Modell, das die Verbesserung von GPT-4 vorantreibt. KI-Praktiker und -Manager müssen sich auf den aktuellen Arbeitsfortschritt von GPT-4 und ChatGPT konzentrieren und darauf, wann OpenAI möglicherweise das nächste große Upgrade veröffentlicht. Abschließend möchte ich allen sagen, dass es keine Rolle spielt, ob die Veröffentlichung von GPT-4 nächste Woche mit den Vorhersagen dieses Artikels übereinstimmt, einschließlich des großen inländischen Modells „Wen Xinyiyan“, auf das wir uns freuen . Entscheidend ist, ob Entwickler oder ihre Unternehmen bereit sind, multimodale APIs für große Modelle zu nutzen. Welch ein Glück, dass all dies hoffentlich noch vor 2024 geschehen wird! Referenzlink: https://arxiv.org/abs/2302.14045https://www.heise.de/news/GPT-4-is-coming-next-week-and-it- will-be-multimodal-says-Microsoft-Germany-7540972.htmlhttps://t.co/JbtQvjoJ3WDas obige ist der detaillierte Inhalt vonZwei Gerüchte und aktuelle Vorhersagen für GPT-4!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Nach 750.000 Runden Einzelkampf zwischen großen Modellen gewann GPT-4 die Meisterschaft und Llama 3 belegte den fünften Platz

Apr 23, 2024 pm 03:28 PM

Nach 750.000 Runden Einzelkampf zwischen großen Modellen gewann GPT-4 die Meisterschaft und Llama 3 belegte den fünften Platz

Apr 23, 2024 pm 03:28 PM

Zu Llama3 wurden neue Testergebnisse veröffentlicht – die große Modellbewertungs-Community LMSYS veröffentlichte eine große Modell-Rangliste, die Llama3 auf dem fünften Platz belegte und mit GPT-4 den ersten Platz in der englischen Kategorie belegte. Das Bild unterscheidet sich von anderen Benchmarks. Diese Liste basiert auf Einzelkämpfen zwischen Modellen, und die Bewerter aus dem gesamten Netzwerk machen ihre eigenen Vorschläge und Bewertungen. Am Ende belegte Llama3 den fünften Platz auf der Liste, gefolgt von drei verschiedenen Versionen von GPT-4 und Claude3 Super Cup Opus. In der englischen Einzelliste überholte Llama3 Claude und punktgleich mit GPT-4. Über dieses Ergebnis war Metas Chefwissenschaftler LeCun sehr erfreut und leitete den Tweet weiter

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren