Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Es gibt wirklich ResNet im Gehirn! Das weltweit erste „Drosophila Brain Connectome' wird veröffentlicht: Es dauerte mehr als zehn Jahre, 3.000 Neuronen und mehr als 500.000 Synapsen zu rekonstruieren!

Es gibt wirklich ResNet im Gehirn! Das weltweit erste „Drosophila Brain Connectome' wird veröffentlicht: Es dauerte mehr als zehn Jahre, 3.000 Neuronen und mehr als 500.000 Synapsen zu rekonstruieren!

Es gibt wirklich ResNet im Gehirn! Das weltweit erste „Drosophila Brain Connectome' wird veröffentlicht: Es dauerte mehr als zehn Jahre, 3.000 Neuronen und mehr als 500.000 Synapsen zu rekonstruieren!

Obwohl sich das moderne Deep Learning längst von der Nachahmung „biologischer neuronaler Netze“ gelöst hat, ist das Verständnis der Funktionsweise biologischer Gehirne immer noch sehr hilfreich für die zukünftige Entwicklung neuronaler Netzmodelle.

Die Art und Weise, wie Gehirnschaltkreise strukturiert sind, beeinflusst die Rechenfähigkeiten des Gehirns, aber bisher wurde keine spezifische Struktur des Gehirns beobachtet, außer bei einigen sehr einfachen Organismen.

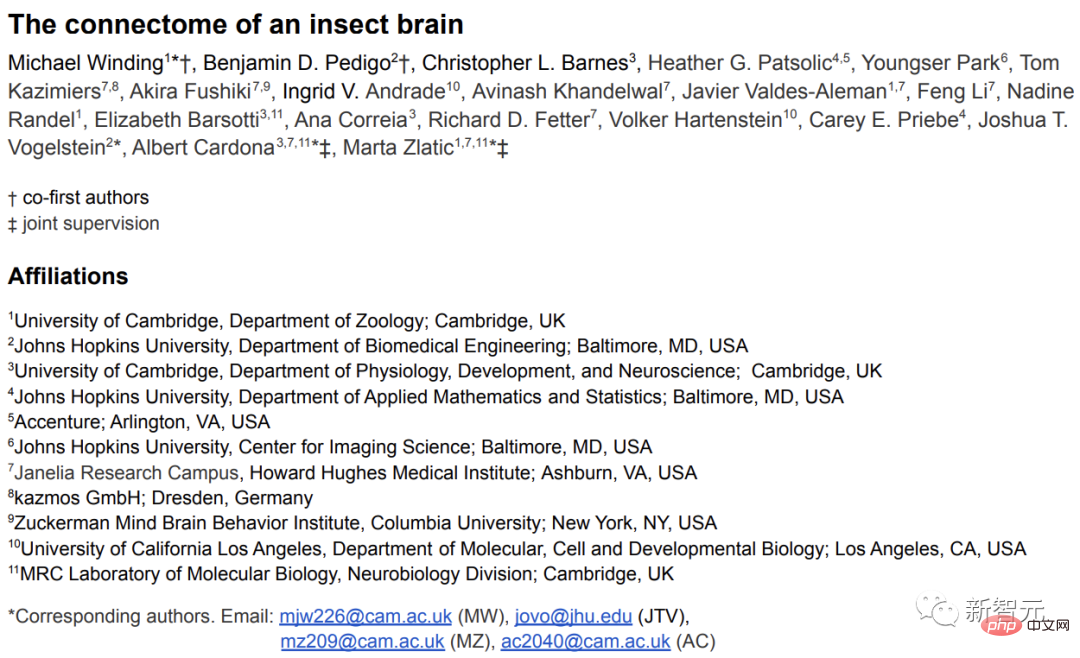

Im November letzten Jahres haben Forscher von vielen Top-Institutionen wie der University of Cambridge, der Johns Hopkins University und dem Janelia Research Park zum ersten Mal einen Artikel auf Biorxiv hochgeladen , das Hirnkonnektom von „Drosophila-Larven“ wurde vollständig rekonstruiert.

Am 10. März wurden die relevanten Ergebnisse in der Zeitschrift „ Wissenschaft“ überlegen.

Einer der Autoren der Arbeit, außerordentlicher Professor Joshua Vogelstein von der Johns Hopkins University, sagte, dass Fruchtfliegen in vielerlei Hinsicht näher am menschlichen Gehirn sind als andere Organismen Lernen und einige Bereiche entsprechen der Navigation; und das Gehirn von Drosophila-Larven und Menschen ist ebenfalls in eine linke und eine rechte Seite unterteilt.

Bei der Analyse des Fruchtfliegengehirns können wir auch einige Ergebnisse in modernen neuronalen Netzen finden, wie z. B. wiederkehrende neuronale Netze, Verknüpfungspfade zwischen mehrschichtigen Netzen (Restnetz ResNet) usw., die das inspirieren könnten Verständnis für maschinelles Lernen.

Gute Nachrichten:

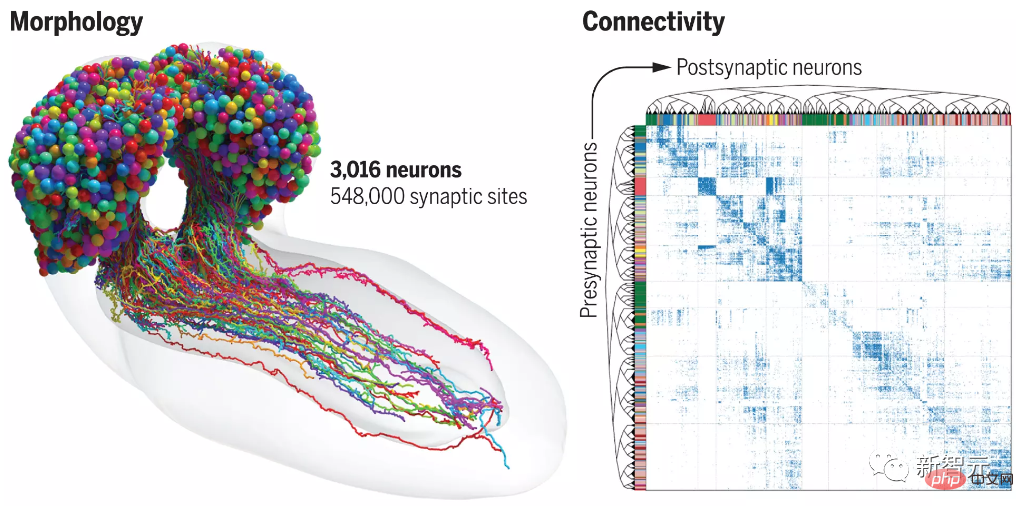

Das rekonstruierte Gehirnkonnektom von Drosophila-Larven umfasst 3016 NeuronenSchlechte Nachrichten:

Der Mensch hat 86 Milliarden Neuronen.Vollständige Rekonstruktion des Gehirns der Drosophila-Larve

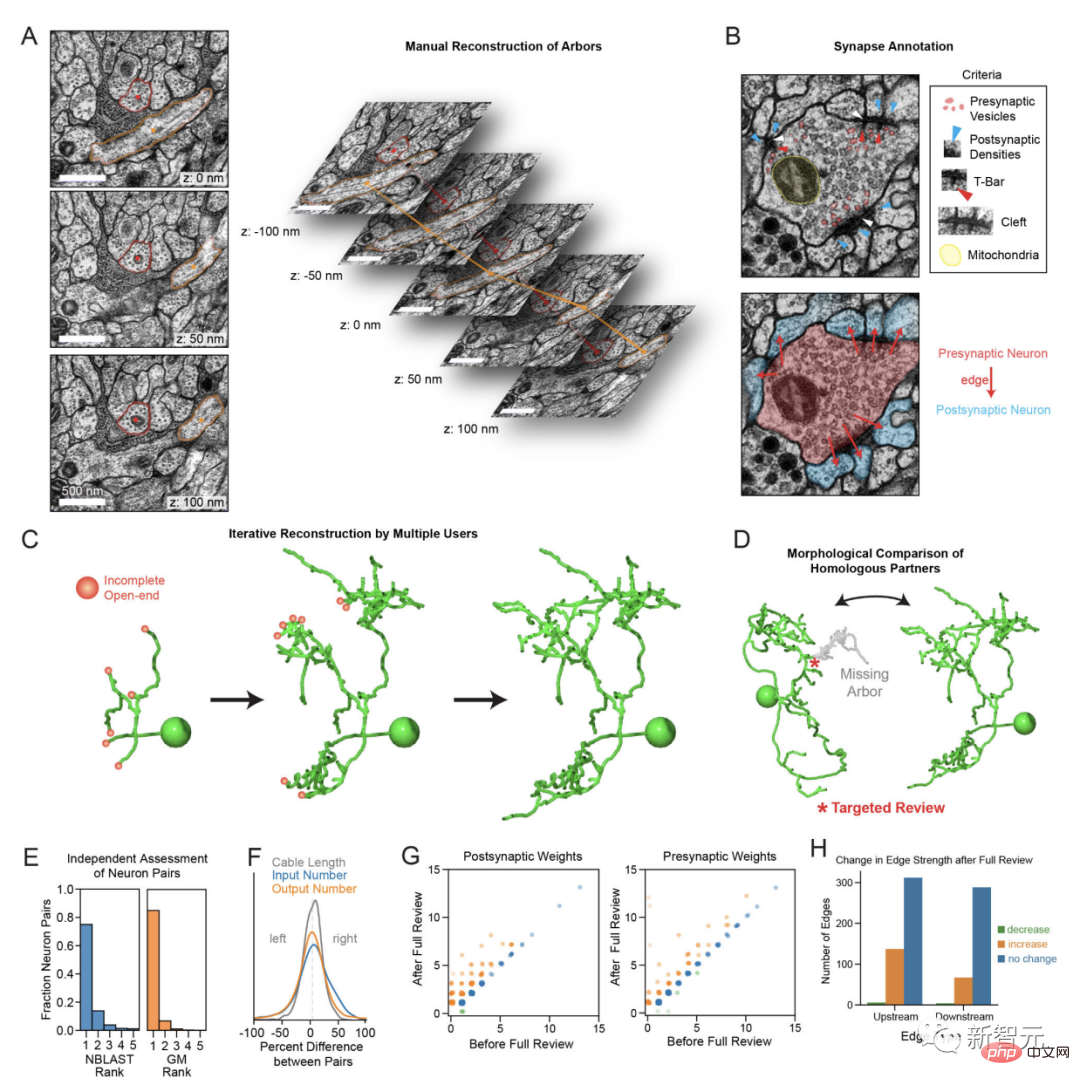

Das Gehirn besteht hauptsächlich aus „Neuronenzellen“. Benachbarte Neuronen können an der Verbindung zwischen synaptischen Zellen Signale aneinander senden, und eines der Neuronen setzt „Neurotransmitter“ frei. Ein anderes Neuron ist für die Aufnahme dieser Chemikalie verantwortlich. Die vollständige Karte der Neuronen und Synapsen im Gehirn wird als Konnektom bezeichnet. Die Untersuchung des Konnektoms ist entscheidend für das Verständnis, wie das Gehirn Verhalten erzeugt.Der Hauptprozess zur Rekonstruktion des Konnektoms besteht darin, das Gehirn in ultradünne (20 Mikrometer) Scheiben zu schneiden und dann den Elektronenfluss eines Elektronenmikroskops zu verwenden, um die Scheiben beispielsweise in Salzgröße zu schneiden Das Gehirn der Drosophila-Larve besteht aus Tausenden Teilen. Wenn etwas schief geht, muss man von vorne beginnen.

Bei einigen einfachen Organismen ist es relativ einfach, ein vollständiges Konnektom zu erstellen. Das erste vollständige Konnektom wurde in den 1980er Jahren bei Caenorhabditis elegans gezeichnet abgeschlossen, wenn es soweit ist.

Aber bisher haben Forscher vollständige synaptische Konnektome nur für drei Organismen kartiert, von denen jeder nur ein paar hundert Gehirnneuronen hat.

Aber bisher haben Forscher vollständige synaptische Konnektome nur für drei Organismen kartiert, von denen jeder nur ein paar hundert Gehirnneuronen hat.

Im Jahr 2020 veröffentlichten Forscher von Google und Janelia Research Park ein 3D-Modell des Drosophila-Gehirnkonnektoms, das 25.000 Drosophila-Neuronen enthält, die verschiedene Zelltypen und mehrere Gehirnregionen umfassen, aber das Modell ist kein vollständiges Gehirn, und selbst dann Es enthält nur ein Viertel der 100.000 Neuronen einer erwachsenen Fruchtfliege.

Es gibt auch einige Forschungsgruppen, die das Konnektom von Tieren mit größeren Gehirnen wie Insekten, Fischen, Säugetieren usw. untersuchen. Aufgrund der großen Anzahl von Neuronen besteht die Hauptforschungsmethode jedoch darin, das Gehirn zu unterteilen und zu untersuchen Dies führt dazu, dass Gehirnregionen, die räumlich miteinander verbunden sind, nicht mehr rekonstruiert werden können.

Das vollständig rekonstruierte Konnektom gehört zu den Larven von Drosophila melanogaster, einschließlich Lernen, Wertberechnung und Verhaltensselektion, und weist die gleichen Eigenschaften auf wie erwachsene Fruchtfliegen und größere Insekten Gehirnstruktur.

Leistungsstarke genetische Werkzeuge können verwendet werden, um einzelne Neuronentypen in nachvollziehbaren Modellsystemen im Hinblick auf die Funktion spezifischer neuronaler und Schaltkreismotive, die durch das Konnektom aufgedeckt werden, selektiv zu manipulieren oder aufzuzeichnen. Wirkhypothesen können leicht aufgestellt werden getestet.

Das Forscherteam schnitt das Gehirn einer „6 Stunden alten“ Drosophila melanogaster-Larve in 4841 Teile, scannte es mit einem hochauflösenden Elektronenmikroskop, digitalisierte das Bild und setzte es dann wieder zu einem dreidimensionalen Bild zusammen; Nach einer Computeranalyse mit Hilfe von enthält die endgültig generierte Karte 3016 Neuronen und 548.000 Synapsen.

Das verbleibende Netzwerk ist im Inneren verborgen

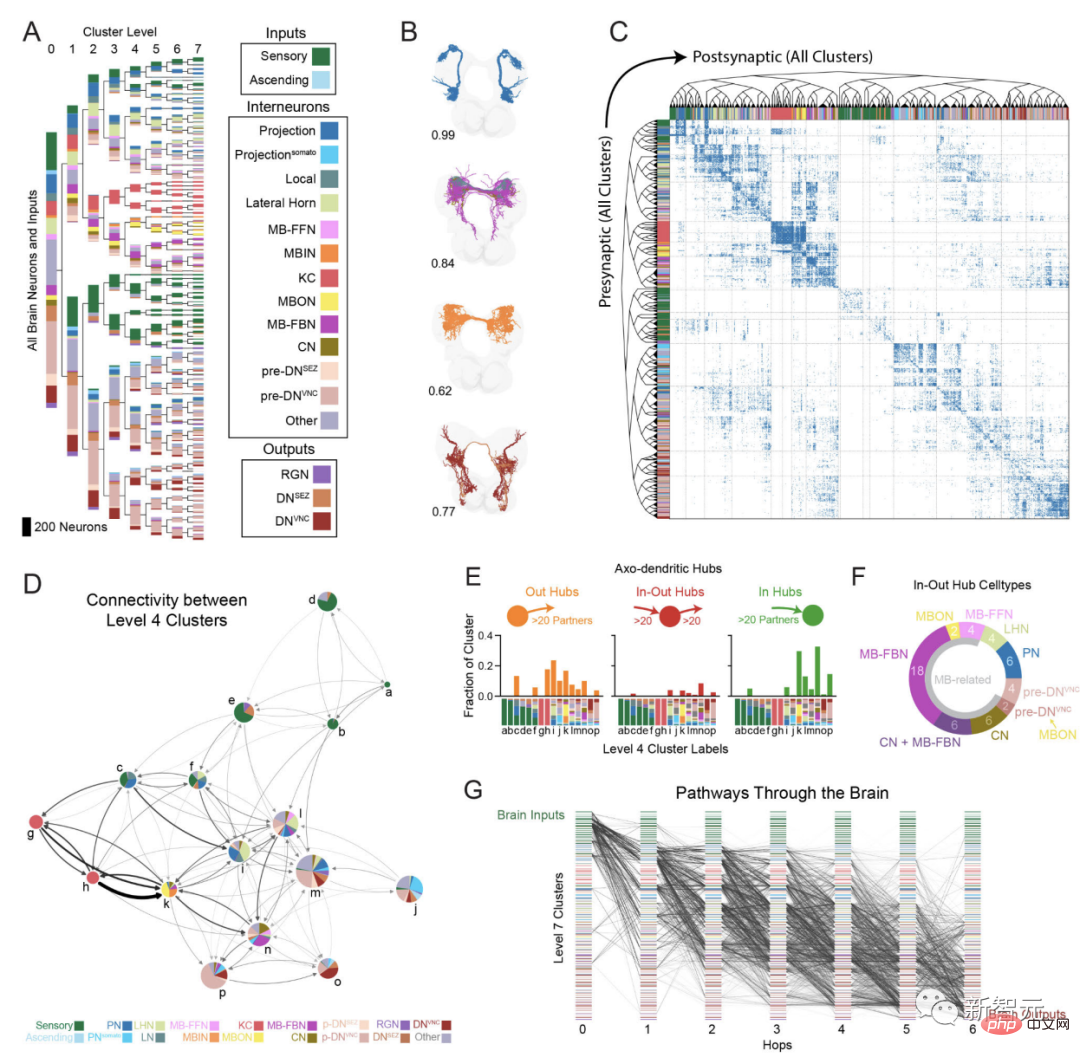

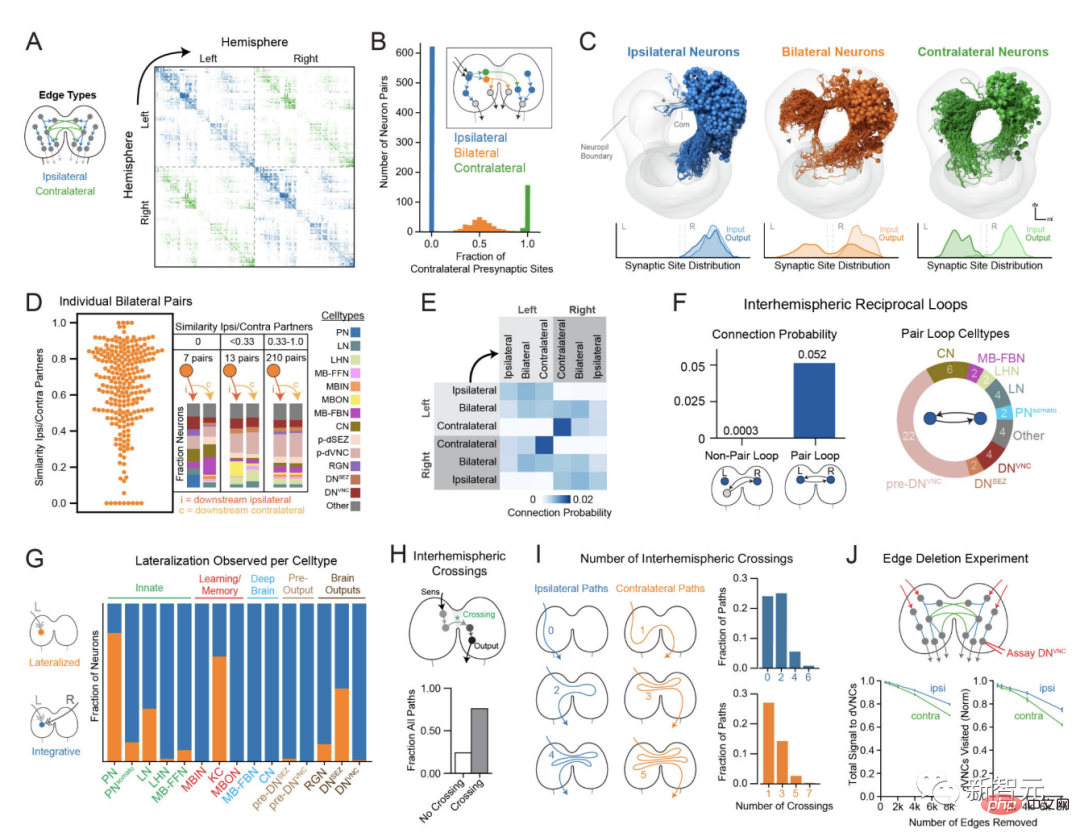

Die Forscher führten eine detaillierte Analyse der Schaltkreisstruktur des Gehirns durch, einschließlich Verbindungen und Neuronentypen, Netzwerkknotenpunkten und neuronalen Schaltplänen.

Die meisten (73 %) der Input- und Output-Hubs (In-Out-Hubs) des Gehirns sind „postsynaptische Zentren für Lernzentren“ oder „präsynaptische Zentren für dopaminerge Neuronen, die das Lernen vorantreiben“; Die Technologie gruppiert Neuronen basierend auf der synaptischen Konnektivität hierarchisch in 93 Typen, die aufgrund anderer Merkmale wie Morphologie und Funktion intern konsistent sind.

Die Forscher entwickelten außerdem einen Algorithmus zur Verfolgung der Signalausbreitung in den multisynaptischen Pfaden des Gehirns und analysierten Feedforward- (von der Empfindung zur Ausgabe) und Feedback-Pfade, multisensorische Integration (multisensorische Integration) und interhemisphärenübergreifende Interaktionen.

Im Gehirn findet sich eine umfassende multisensorische Integration sowie mehrere miteinander verbundene Bahnen in unterschiedlichen Tiefen, von sensorischen Neuronen bis hin zu Ausgabeneuronen, die ein verteiltes Verarbeitungsnetzwerk bilden.

Das Gehirn hat eine stark rekurrierende Struktur und 41 % der Neuronen empfangen rekurrierende Eingaben über große Entfernungen. Die Verteilung der Schleifen ist jedoch nicht gleichmäßig und die Schleifenrate ist in Bereichen, in denen es um Lernen und Handlungsauswahl geht, besonders hoch.

Dopaminerge Neuronen, die das Lernen vorantreiben, gehören zu den häufigsten Neuronen im Gehirn.

Es gibt viele kontralaterale Neuronen, die auf die beiden Hemisphären des Gehirns projizieren. Sie sind Drehkreuze und Synapsen untereinander und fördern die Verbindung zwischen den beiden Hemisphären des Gehirns. Der Artikel analysiert auch die Interaktion zwischen Gehirn und Nerven.

Forscher fanden heraus, dass absteigende Neuronen auf eine kleine Gruppe prämotorischer Elemente abzielen, die eine wichtige Rolle beim Umschalten des Bewegungszustands spielen.

Schlussfolgerung

Das vollständige Gehirnkonnektom von Drosophila-Larven wird noch lange Zeit die Grundlage für andere theoretische und experimentelle Studien zur Gehirnfunktion bilden, und die in dieser Studie generierten Methoden und Rechenwerkzeuge werden die zukünftige Analyse davon erleichtern connectome .

Obwohl die Details der Gehirnorganisation im Tierreich variieren, sind viele neuronale Schaltkreisstrukturen erhalten.

Da in Zukunft die Gehirnkonnektome weiterer Organismen kartiert werden, werden Vergleiche zwischen verschiedenen Konnektomen gemeinsame und potenziell optimale Schaltkreisstrukturen sowie die Eigenheiten von Verhaltensunterschieden zwischen Organismen offenbaren.

Einige der Strukturmerkmale, die im Gehirn von Drosophila-Larven beobachtet wurden, darunter mehrschichtige Verknüpfungen und markante verschachtelte Schleifen, können in hochmodernen künstlichen neuronalen Netzen gefunden werden und ergänzen möglicherweise aktuelle Netze Neben der Tiefe und der Generalisierung von Verarbeitungsaufgaben können diese Funktionen auch die Rechenleistung des Gehirns erhöhen und die physiologischen Einschränkungen der Anzahl der Neuronen überwinden.

Zukünftige Analysen der Ähnlichkeiten und Unterschiede zwischen dem Gehirn und künstlichen neuronalen Netzen könnten zum Verständnis der Rechenprinzipien des Gehirns beitragen und neue Architekturen für maschinelles Lernen inspirieren.

Ähnliche Kommentare

Gashpal Yekai, Professor für Neurowissenschaften an der University of Exeter, Großbritannien, sagte, dass alle Neuronen im Gehirn rekonstruiert und alle neuronalen Verbindungen analysiert wurden. Er nannte die Arbeit „sehr wichtig“.

Catherine Dulac von der Harvard University in den Vereinigten Staaten glaubt, dass diese Daten die „tiefe Logik“ dieser neuronalen Verbindungen offenbaren.

Scott Emmons vom Albert Einstein College of Medicine in New York glaubt jedoch, dass die bloße Kartierung von Synapsen kein vollständiges Bild liefert.

Emmons hat 2019 das Konnektom des männlichen und weiblichen C. elegans kartiert. Neuronen können auch über langsam freigesetzte Chemikalien wie Hormone und andere Verbindungen zwischen Zellen, sogenannte Gap Junctions, miteinander kommunizieren.

All dies muss berücksichtigt werden, aber im neu gezeichneten Konnektom sind nur Synapsen enthalten.

Das obige ist der detaillierte Inhalt vonEs gibt wirklich ResNet im Gehirn! Das weltweit erste „Drosophila Brain Connectome' wird veröffentlicht: Es dauerte mehr als zehn Jahre, 3.000 Neuronen und mehr als 500.000 Synapsen zu rekonstruieren!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

YOLO ist unsterblich! YOLOv9 wird veröffentlicht: Leistung und Geschwindigkeit SOTA~

Feb 26, 2024 am 11:31 AM

YOLO ist unsterblich! YOLOv9 wird veröffentlicht: Leistung und Geschwindigkeit SOTA~

Feb 26, 2024 am 11:31 AM

Heutige Deep-Learning-Methoden konzentrieren sich darauf, die am besten geeignete Zielfunktion zu entwerfen, damit die Vorhersageergebnisse des Modells der tatsächlichen Situation am nächsten kommen. Gleichzeitig muss eine geeignete Architektur entworfen werden, um ausreichend Informationen für die Vorhersage zu erhalten. Bestehende Methoden ignorieren die Tatsache, dass bei der schichtweisen Merkmalsextraktion und räumlichen Transformation der Eingabedaten eine große Menge an Informationen verloren geht. Dieser Artikel befasst sich mit wichtigen Themen bei der Datenübertragung über tiefe Netzwerke, nämlich Informationsengpässen und umkehrbaren Funktionen. Darauf aufbauend wird das Konzept der programmierbaren Gradienteninformation (PGI) vorgeschlagen, um die verschiedenen Änderungen zu bewältigen, die tiefe Netzwerke zur Erreichung mehrerer Ziele erfordern. PGI kann vollständige Eingabeinformationen für die Zielaufgabe zur Berechnung der Zielfunktion bereitstellen und so zuverlässige Gradienteninformationen zur Aktualisierung der Netzwerkgewichte erhalten. Darüber hinaus wird ein neues, leichtgewichtiges Netzwerk-Framework entworfen

Ein tiefer Einblick in Modelle, Daten und Frameworks: eine ausführliche 54-seitige Übersicht über effiziente große Sprachmodelle

Jan 14, 2024 pm 07:48 PM

Ein tiefer Einblick in Modelle, Daten und Frameworks: eine ausführliche 54-seitige Übersicht über effiziente große Sprachmodelle

Jan 14, 2024 pm 07:48 PM

Large-Scale Language Models (LLMs) haben überzeugende Fähigkeiten bei vielen wichtigen Aufgaben bewiesen, darunter das Verständnis natürlicher Sprache, die Sprachgenerierung und das komplexe Denken, und hatten tiefgreifende Auswirkungen auf die Gesellschaft. Diese herausragenden Fähigkeiten erfordern jedoch erhebliche Schulungsressourcen (im linken Bild dargestellt) und lange Inferenzzeiten (im rechten Bild dargestellt). Daher müssen Forscher wirksame technische Mittel entwickeln, um ihre Effizienzprobleme zu lösen. Darüber hinaus wurden, wie auf der rechten Seite der Abbildung zu sehen ist, einige effiziente LLMs (LanguageModels) wie Mistral-7B erfolgreich beim Entwurf und Einsatz von LLMs eingesetzt. Diese effizienten LLMs können den Inferenzspeicher erheblich reduzieren und gleichzeitig eine ähnliche Genauigkeit wie LLaMA1-33B beibehalten

„Der Eigentümer von Bilibili UP hat erfolgreich das weltweit erste Redstone-basierte neuronale Netzwerk geschaffen, das in den sozialen Medien für Aufsehen sorgte und von Yann LeCun gelobt wurde.'

May 07, 2023 pm 10:58 PM

„Der Eigentümer von Bilibili UP hat erfolgreich das weltweit erste Redstone-basierte neuronale Netzwerk geschaffen, das in den sozialen Medien für Aufsehen sorgte und von Yann LeCun gelobt wurde.'

May 07, 2023 pm 10:58 PM

In Minecraft ist Redstone ein sehr wichtiger Gegenstand. Es ist ein einzigartiges Material im Spiel. Schalter, Redstone-Fackeln und Redstone-Blöcke können Drähten oder Objekten stromähnliche Energie verleihen. Mithilfe von Redstone-Schaltkreisen können Sie Strukturen aufbauen, mit denen Sie andere Maschinen steuern oder aktivieren können. Sie können selbst so gestaltet sein, dass sie auf die manuelle Aktivierung durch Spieler reagieren, oder sie können wiederholt Signale ausgeben oder auf Änderungen reagieren, die von Nicht-Spielern verursacht werden, beispielsweise auf Bewegungen von Kreaturen und Gegenstände. Fallen, Pflanzenwachstum, Tag und Nacht und mehr. Daher kann Redstone in meiner Welt extrem viele Arten von Maschinen steuern, von einfachen Maschinen wie automatischen Türen, Lichtschaltern und Blitzstromversorgungen bis hin zu riesigen Aufzügen, automatischen Farmen, kleinen Spielplattformen und sogar in Spielcomputern gebauten Maschinen . Kürzlich, B-Station UP main @

Nvidias GPU der nächsten Generation zerschmettert H100 und wird enthüllt! Das erste 3-nm-Multichip-Moduldesign, vorgestellt im Jahr 2024

Sep 30, 2023 pm 12:49 PM

Nvidias GPU der nächsten Generation zerschmettert H100 und wird enthüllt! Das erste 3-nm-Multichip-Moduldesign, vorgestellt im Jahr 2024

Sep 30, 2023 pm 12:49 PM

3-nm-Prozess, Leistung übertrifft H100! Kürzlich brachten die ausländischen Medien DigiTimes die Nachricht, dass Nvidia die GPU der nächsten Generation, die B100, mit dem Codenamen „Blackwell“ entwickelt, angeblich als Produkt für Anwendungen im Bereich der künstlichen Intelligenz (KI) und des Hochleistungsrechnens (HPC). Der B100 wird den 3-nm-Prozess von TSMC sowie ein komplexeres Multi-Chip-Modul (MCM)-Design nutzen und im vierten Quartal 2024 erscheinen. Nvidia, das mehr als 80 % des GPU-Marktes für künstliche Intelligenz monopolisiert, kann mit dem B100 zuschlagen, solange das Eisen heiß ist, und in dieser Welle des KI-Einsatzes weitere Herausforderer wie AMD und Intel angreifen. Nach Schätzungen von NVIDIA wird erwartet, dass der Produktionswert dieses Bereichs bis 2027 ungefähr erreicht

Multipfad, Multidomäne, alles inklusive! Google AI veröffentlicht das allgemeine Modell MDL für Multi-Domain-Lernen

May 28, 2023 pm 02:12 PM

Multipfad, Multidomäne, alles inklusive! Google AI veröffentlicht das allgemeine Modell MDL für Multi-Domain-Lernen

May 28, 2023 pm 02:12 PM

Deep-Learning-Modelle für Sehaufgaben (z. B. Bildklassifizierung) werden normalerweise durchgängig mit Daten aus einem einzelnen visuellen Bereich (z. B. natürlichen Bildern oder computergenerierten Bildern) trainiert. Im Allgemeinen muss eine Anwendung, die Vision-Aufgaben für mehrere Domänen ausführt, mehrere Modelle für jede einzelne Domäne erstellen und diese unabhängig voneinander trainieren. Während der Inferenz verarbeitet jedes Modell eine bestimmte Domäne. Auch wenn sie auf unterschiedliche Bereiche ausgerichtet sind, sind einige Merkmale der frühen Schichten zwischen diesen Modellen ähnlich, sodass das gemeinsame Training dieser Modelle effizienter ist. Dies reduziert die Latenz und den Stromverbrauch und reduziert die Speicherkosten für die Speicherung jedes Modellparameters. Dieser Ansatz wird als Multi-Domain-Learning (MDL) bezeichnet. Darüber hinaus können MDL-Modelle auch Single-Modelle übertreffen

1,3 ms dauert 1,3 ms! Tsinghuas neueste Open-Source-Architektur für mobile neuronale Netzwerke RepViT

Mar 11, 2024 pm 12:07 PM

1,3 ms dauert 1,3 ms! Tsinghuas neueste Open-Source-Architektur für mobile neuronale Netzwerke RepViT

Mar 11, 2024 pm 12:07 PM

Papieradresse: https://arxiv.org/abs/2307.09283 Codeadresse: https://github.com/THU-MIG/RepViTRepViT funktioniert gut in der mobilen ViT-Architektur und zeigt erhebliche Vorteile. Als nächstes untersuchen wir die Beiträge dieser Studie. In dem Artikel wird erwähnt, dass Lightweight-ViTs bei visuellen Aufgaben im Allgemeinen eine bessere Leistung erbringen als Lightweight-CNNs, hauptsächlich aufgrund ihres Multi-Head-Selbstaufmerksamkeitsmoduls (MSHA), das es dem Modell ermöglicht, globale Darstellungen zu lernen. Allerdings wurden die architektonischen Unterschiede zwischen Lightweight-ViTs und Lightweight-CNNs noch nicht vollständig untersucht. In dieser Studie integrierten die Autoren leichte ViTs in die effektiven

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! 7 Microsoft-Forscher arbeiteten intensiv zusammen, 5 Hauptthemen, 119 Seiten Dokument

Sep 25, 2023 pm 04:49 PM

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! 7 Microsoft-Forscher arbeiteten intensiv zusammen, 5 Hauptthemen, 119 Seiten Dokument

Sep 25, 2023 pm 04:49 PM

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! Es wurde von sieben chinesischen Forschern bei Microsoft verfasst und umfasst 119 Seiten. Es geht von zwei Arten multimodaler Forschungsrichtungen für große Modelle aus, die abgeschlossen wurden und immer noch an der Spitze stehen, und fasst fünf spezifische Forschungsthemen umfassend zusammen: visuelles Verständnis und visuelle Generierung Der vom einheitlichen visuellen Modell LLM unterstützte multimodale Großmodell-Multimodalagent konzentriert sich auf ein Phänomen: Das multimodale Grundmodell hat sich von spezialisiert zu universell entwickelt. Ps. Aus diesem Grund hat der Autor am Anfang des Artikels direkt ein Bild von Doraemon gezeichnet. Wer sollte diese Rezension (Bericht) lesen? Mit den ursprünglichen Worten von Microsoft: Solange Sie daran interessiert sind, das Grundwissen und die neuesten Fortschritte multimodaler Grundmodelle zu erlernen, egal ob Sie ein professioneller Forscher oder ein Student sind, ist dieser Inhalt sehr gut für Sie geeignet.

Wussten Sie, dass es bei Programmierern in ein paar Jahren einen Niedergang geben wird?

Nov 08, 2023 am 11:17 AM

Wussten Sie, dass es bei Programmierern in ein paar Jahren einen Niedergang geben wird?

Nov 08, 2023 am 11:17 AM

Die Zeitschrift „ComputerWorld“ schrieb einmal in einem Artikel, dass „die Programmierung bis 1960 verschwinden wird“, weil IBM eine neue Sprache FORTRAN entwickelt hat, die es Ingenieuren ermöglicht, die benötigten mathematischen Formeln zu schreiben und sie dann dem Computer zu übermitteln, damit das Programmieren endet. Ein paar Jahre später hörten wir ein neues Sprichwort: Jeder Unternehmer kann Geschäftsbegriffe verwenden, um seine Probleme zu beschreiben und dem Computer zu sagen, was er tun soll. Mit dieser Programmiersprache namens COBOL brauchen Unternehmen keine Programmierer mehr. Später soll IBM eine neue Programmiersprache namens RPG entwickelt haben, mit der Mitarbeiter Formulare ausfüllen und Berichte erstellen können, sodass die meisten Programmieranforderungen des Unternehmens damit erfüllt werden können.