Praktische Übung zum Entscheidungsbaum für maschinelles Lernen

Übersetzer |. Zhu Xianzhong

Rezensent |. Sun Shujuan

Entscheidungsfindung im maschinellen Lernen Baum

Moderne Algorithmen für maschinelles Lernen verändern unser tägliches Leben. Große Sprachmodelle wie BERT unterstützen beispielsweise die Google-Suche und GPT-3 unterstützt viele Hochsprachenanwendungen.

Andererseits ist die Erstellung komplexer Algorithmen für maschinelles Lernen heute viel einfacher als je zuvor. Unabhängig davon, wie komplex ein Algorithmus für maschinelles Lernen auch sein mag, fallen sie alle in eine der folgenden Lernkategorien: Unüberwachtes Lernen

- Tatsächlich Entscheidung Tree ist einer der ältesten überwachten Algorithmen für maschinelles Lernen und kann eine Vielzahl realer Probleme lösen. Untersuchungen zeigen, dass die früheste Erfindung des Entscheidungsbaumalgorithmus auf das Jahr 1963 zurückgeht.

- Lassen Sie uns als Nächstes in die Details dieses Algorithmus eintauchen und sehen, warum dieser Algorithmustyp auch heute noch so beliebt ist.

- Was ist ein Entscheidungsbaum? Der Entscheidungsbaumalgorithmus ist ein beliebter überwachter Algorithmus für maschinelles Lernen, da er eine relativ einfache Möglichkeit bietet, mit komplexen Datensätzen umzugehen. Entscheidungsbäume haben ihren Namen aufgrund ihrer Ähnlichkeit mit der Struktur eines Baumes; eine Baumstruktur besteht aus mehreren Komponenten wie Wurzeln, Zweigen und Blättern in Form von Knoten und Kanten. Sie werden für die Entscheidungsanalyse verwendet, ähnlich wie ein Wenn-Sonst-basiertes Entscheidungsflussdiagramm, in dem Entscheidungen zu den gewünschten Vorhersagen führen. Entscheidungsbäume können diese If-Else-Entscheidungsregeln lernen, um den Datensatz aufzuteilen und schließlich ein baumartiges Datenmodell zu generieren.

- Entscheidungsbäume wurden bei der Vorhersage diskreter Ergebnisse für Klassifizierungsprobleme und der Vorhersage kontinuierlicher numerischer Ergebnisse für Regressionsprobleme angewendet. Im Laufe der Jahre haben Wissenschaftler viele verschiedene Algorithmen wie CART, C4.5 und Ensemble-Algorithmen wie Random Forests und Gradient Boosted Trees entwickelt.

Analyse der verschiedenen Komponenten des Entscheidungsbaums

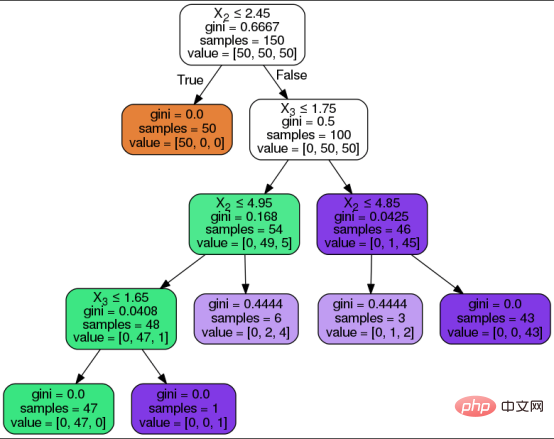

Das Ziel der Entscheidung Der Baumalgorithmus ist die Vorhersage der Ergebnisse des Eingabedatensatzes. Der Baumdatensatz ist in drei Formen unterteilt: Attribute, Attributwerte und vorherzusagende Typen. Wie bei jedem überwachten Lernalgorithmus ist der Datensatz in zwei Typen unterteilt: Trainingssatz und Testsatz. Unter anderem definiert der Trainingssatz die Entscheidungsregeln, die der Algorithmus lernt und auf den Testsatz anwendet.Bevor wir die Schritte des Entscheidungsbaumalgorithmus zusammenfassen, wollen wir zunächst die Komponenten des Entscheidungsbaums verstehen:

Wurzelknoten: Es ist der Startknoten oben im Entscheidungsbaum und enthält alle Attributwerte. Der Wurzelknoten wird basierend auf den vom Algorithmus gelernten Entscheidungsregeln in Entscheidungsknoten unterteilt.

Entscheidungsknoten/Interner Knoten: Der interne Knoten ist der Entscheidungsknoten zwischen dem Wurzelknoten und dem Blattknoten, entsprechend der Entscheidungsregel und ihrem Antwortpfad. Knoten stellen Fragen dar und Zweige zeigen Pfade zu relevanten Antworten auf der Grundlage dieser Fragen.

Blattknoten: Blattknoten ist der Endknoten, der die Zielvorhersage darstellt. Diese Knoten werden nicht weiter aufgeteilt.

- Das Folgende ist eine visuelle Darstellung eines Entscheidungsbaums und seiner oben genannten Komponenten. Der Entscheidungsbaumalgorithmus durchläuft die folgenden Schritte, um die gewünschte Vorhersage zu erzielen: # 🎜🎜#

- Der Algorithmus beginnt am Wurzelknoten mit allen Attributwerten.

- Der Wurzelknoten ist basierend auf den Entscheidungsregeln, die der Algorithmus aus dem Trainingssatz gelernt hat, in Entscheidungsknoten unterteilt.

- Leiten Sie interne Entscheidungsknoten basierend auf der Frage und ihrem Antwortpfad durch Zweige/Kanten.

Fahren Sie mit den vorherigen Schritten fort, bis Sie einen Blattknoten erreichen oder alle Attribute verwendet werden.

- Um das beste Attribut auf jedem Knoten auszuwählen, basiert die Aufteilung auf einer der folgenden beiden Attributauswahlmetriken: # 🎜🎜#

- GINI-KOEFFIZIENT (Gini-Index) misst die Gini-Verunreinigung (Gini-Verunreinigung), um die Wahrscheinlichkeit anzuzeigen, dass ein Algorithmus eine zufällige Klassenbezeichnung falsch klassifiziert.

- InformationsgewinnMisst die Verbesserung der Entropie nach der Segmentierung, um die Vorhersage von Klassen zu vermeiden 50/50 geteilt. Entropie ist ein mathematisches Maß für die Verunreinigung in einer bestimmten Datenprobe. Chaoszustand im Entscheidungsbaum liegt nahe bei 50/50 durch 🎜#divide#🎜 🎜# bedeutet. Blumenklassifizierungsfall mit EntscheidungsbaumalgorithmusNachdem wir die oben genannten Grundkenntnisse verstanden haben, beginnen wir mit der Implementierung. Ein Anwendungsfall. In diesem Artikel implementieren wir mithilfe der Scikit Learning-Bibliothek ein Entscheidungsbaumklassifizierungsmodell in Python.

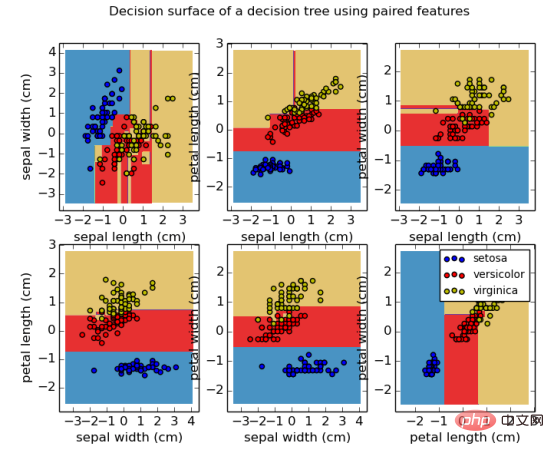

Der Datensatz für dieses Tutorial ist ein Irisblütendatensatz. Dieser Datensatz ist bereits in die Scikit-Open-Source-Bibliothek integriert, sodass Entwickler ihn nicht extern laden müssen. Dieser Datensatz umfasst insgesamt vier Irisattribute und entsprechende Attributwerte, die in das Modell eingegeben werden, um eine von drei Arten von Irisblüten vorherzusagen.

Attribute/Merkmale im Datensatz: Kelchblattlänge, Kelchblattbreite, Blütenblattlänge, Blütenblattbreite.Vorhergesagte Tags/Blumentypen im Datensatz: Setosis, Versicolor, Virginica.

- Als nächstes wird eine schrittweise Codebeschreibung des Entscheidungsbaumklassifikators basierend auf der Python-Sprache gegeben.

- Bibliothek importieren

Importieren Sie zunächst die Bibliotheken, die zum Implementieren des Entscheidungsbaums erforderlich sind, über den folgenden Codeabschnitt.

Laden des Iris-Datensatzesimport pandas as pd import numpy as np from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from sklearn.tree import DecisionTreeClassifier

Nach dem Login kopierenDer folgende Code zeigt die Verwendung der Funktion „load_iris“ zum Laden des in der Variablen „data_set“ gespeicherten sklearn.datasets Iris-Datensatz in der Bibliothek. Die nächsten beiden Codezeilen drucken den Iristyp und die charakteristischen Informationen.

data_set = load_iris() print('Iris plant classes to predict: ', data_set.target_names) print('Four features of iris plant: ', data_set.feature_names)Nach dem Login kopierenAttribute und Tags trennen

Die folgenden Codezeilen implementieren die Blume Separate Attribut- und Typinformationen und speichern sie in entsprechenden Variablen. Unter diesen ist die Funktion „Shape[0]“ dafür verantwortlich, die Anzahl der in der Variablen X_att gespeicherten Attribute zu bestimmen. Die Gesamtzahl der Attributwerte im Datensatz beträgt 150.

#提取花的特性和类型信息 X_att = data_set.data y_label = data_set.target print('数据集中总的样本数:', X_att.shape[0])Nach dem Login kopierenTatsächlich können wir auch eine visuelle Tabelle erstellen, um einen Teil der Attributwerte im Datensatz anzuzeigen, indem wir den Wert in der Variablen X_att hinzufügen zum DataFrame in der Panda-Bibliothek Nur in der Funktion.

Datensatz aufteilendata_view=pd.DataFrame({ 'sepal length':X_att[:,0], 'sepal width':X_att[:,1], 'petal length':X_att[:,2], 'petal width':X_att[:,3], 'species':y_label }) data_view.head()Nach dem Login kopierenDer folgende Code zeigt die Verwendung der Funktion train_test_split, um den Datensatz in zwei Teile aufzuteilen: einen Trainingssatz und ein Testset. Unter anderem wird der Parameter random_state in dieser Funktion verwendet, um einen zufälligen Startwert für die Funktion bereitzustellen, um bei jeder Ausführung die gleichen Ergebnisse für den angegebenen Datensatz bereitzustellen. test_size gibt die Größe des Testsatzes an macht nach der Aufteilung 25 % aus. Trainingsdaten machen 75 % aus.

Wenden Sie die Entscheidungsbaumklassifizierungsfunktion an. DecisionTreeClassifier-Funktion ##数据集拆分为训练集和测试集两部分 X_att_train, X_att_test, y_label_train, y_label_test = train_test_split(X_att, y_label, random_state = 42, test_size = 0.25)

Nach dem Login kopieren

Klassifizierungsmodellum 一

Entscheidungsbaum zu realisieren,

#🎜🎜 # KategorieDie Standardeinstellung ist „Entropie“ Weg . Der Standard ermöglicht , die Attributauswahlmetrik auf (Informationsgewinn) festzulegen. Der Code ordnet dann das Modell unserem Trainingssatz aus Attributen und Beschriftungen zu.

#应用决策树分类器 clf_dt = DecisionTreeClassifier(criterion = 'entropy') clf_dt.fit(X_att_train, y_label_train)

Nach dem Login kopieren计算模型精度

下面的代码负责计算并打印决策树分类模型在训练集和测试集上的准确性。为了计算准确度分数,我们使用了predict函数。测试结果是:训练集和测试集的准确率分别为100%和94.7%。

print('Training data accuracy: ', accuracy_score(y_true=y_label_train, y_pred=clf_dt.predict(X_att_train))) print('Test data accuracy: ', accuracy_score(y_true=y_label_test, y_pred=clf_dt.predict(X_att_test)))Nach dem Login kopieren真实世界中的决策树应用程序

当今社会,机器学习决策树在许多行业的决策过程中都得到广泛应用。其中,决策树的最常见应用首先是在金融和营销部门,例如可用于如下一些子领域:

- 贷款批准

- 支出管理

- 客户流失预测

- 新产品的可行性分析,等等。

如何改进决策树?

作为本文决策树主题讨论的总结,我们有充分的理由安全地假设:决策树的可解释性仍然很受欢迎。决策树之所以容易理解,是因为它们可以被人类以可视化方式展现并便于解释。因此,它们是解决机器学习问题的直观方法,同时也能够确保结果是可解释的。机器学习中的可解释性是我们过去讨论过的一个小话题,它也与即将到来的人工智能伦理主题存在密切联系。

与任何其他机器学习算法一样,决策树自然也可以加以改进,以避免过度拟合和出现过于偏向于优势预测类别。剪枝和ensembling技术是克服决策树算法缺点方案最常采用的方法。决策树尽管存在这些缺点,但仍然是决策分析算法的基础,并将在机器学习领域始终保持重要位置。

译者介绍

朱先忠,51CTO社区编辑,51CTO专家博客、讲师,潍坊一所高校计算机教师,自由编程界老兵一枚。

原文标题:An Introduction to Decision Trees for Machine Learning,作者:Stylianos Kampakis

Das obige ist der detaillierte Inhalt vonPraktische Übung zum Entscheidungsbaum für maschinelles Lernen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

15 empfohlene kostenlose Open-Source-Bildanmerkungstools

Mar 28, 2024 pm 01:21 PM

15 empfohlene kostenlose Open-Source-Bildanmerkungstools

Mar 28, 2024 pm 01:21 PM

Bei der Bildanmerkung handelt es sich um das Verknüpfen von Beschriftungen oder beschreibenden Informationen mit Bildern, um dem Bildinhalt eine tiefere Bedeutung und Erklärung zu verleihen. Dieser Prozess ist entscheidend für maschinelles Lernen, das dabei hilft, Sehmodelle zu trainieren, um einzelne Elemente in Bildern genauer zu identifizieren. Durch das Hinzufügen von Anmerkungen zu Bildern kann der Computer die Semantik und den Kontext hinter den Bildern verstehen und so den Bildinhalt besser verstehen und analysieren. Die Bildanmerkung hat ein breites Anwendungsspektrum und deckt viele Bereiche ab, z. B. Computer Vision, Verarbeitung natürlicher Sprache und Diagramm-Vision-Modelle. Sie verfügt über ein breites Anwendungsspektrum, z. B. zur Unterstützung von Fahrzeugen bei der Identifizierung von Hindernissen auf der Straße und bei der Erkennung und Diagnose von Krankheiten durch medizinische Bilderkennung. In diesem Artikel werden hauptsächlich einige bessere Open-Source- und kostenlose Bildanmerkungstools empfohlen. 1.Makesens

In diesem Artikel erfahren Sie mehr über SHAP: Modellerklärung für maschinelles Lernen

Jun 01, 2024 am 10:58 AM

In diesem Artikel erfahren Sie mehr über SHAP: Modellerklärung für maschinelles Lernen

Jun 01, 2024 am 10:58 AM

In den Bereichen maschinelles Lernen und Datenwissenschaft stand die Interpretierbarkeit von Modellen schon immer im Fokus von Forschern und Praktikern. Mit der weit verbreiteten Anwendung komplexer Modelle wie Deep Learning und Ensemble-Methoden ist das Verständnis des Entscheidungsprozesses des Modells besonders wichtig geworden. Explainable AI|XAI trägt dazu bei, Vertrauen in maschinelle Lernmodelle aufzubauen, indem es die Transparenz des Modells erhöht. Eine Verbesserung der Modelltransparenz kann durch Methoden wie den weit verbreiteten Einsatz mehrerer komplexer Modelle sowie der Entscheidungsprozesse zur Erläuterung der Modelle erreicht werden. Zu diesen Methoden gehören die Analyse der Merkmalsbedeutung, die Schätzung des Modellvorhersageintervalls, lokale Interpretierbarkeitsalgorithmen usw. Die Merkmalswichtigkeitsanalyse kann den Entscheidungsprozess des Modells erklären, indem sie den Grad des Einflusses des Modells auf die Eingabemerkmale bewertet. Schätzung des Modellvorhersageintervalls

Transparent! Eine ausführliche Analyse der Prinzipien der wichtigsten Modelle des maschinellen Lernens!

Apr 12, 2024 pm 05:55 PM

Transparent! Eine ausführliche Analyse der Prinzipien der wichtigsten Modelle des maschinellen Lernens!

Apr 12, 2024 pm 05:55 PM

Laienhaft ausgedrückt ist ein Modell für maschinelles Lernen eine mathematische Funktion, die Eingabedaten einer vorhergesagten Ausgabe zuordnet. Genauer gesagt ist ein Modell für maschinelles Lernen eine mathematische Funktion, die Modellparameter anpasst, indem sie aus Trainingsdaten lernt, um den Fehler zwischen der vorhergesagten Ausgabe und der wahren Bezeichnung zu minimieren. Beim maschinellen Lernen gibt es viele Modelle, z. B. logistische Regressionsmodelle, Entscheidungsbaummodelle, Support-Vektor-Maschinenmodelle usw. Jedes Modell verfügt über seine anwendbaren Datentypen und Problemtypen. Gleichzeitig gibt es viele Gemeinsamkeiten zwischen verschiedenen Modellen oder es gibt einen verborgenen Weg für die Modellentwicklung. Am Beispiel des konnektionistischen Perzeptrons können wir es durch Erhöhen der Anzahl verborgener Schichten des Perzeptrons in ein tiefes neuronales Netzwerk umwandeln. Wenn dem Perzeptron eine Kernelfunktion hinzugefügt wird, kann es in eine SVM umgewandelt werden. Dieses hier

Identifizieren Sie Über- und Unteranpassung anhand von Lernkurven

Apr 29, 2024 pm 06:50 PM

Identifizieren Sie Über- und Unteranpassung anhand von Lernkurven

Apr 29, 2024 pm 06:50 PM

In diesem Artikel wird vorgestellt, wie Überanpassung und Unteranpassung in Modellen für maschinelles Lernen mithilfe von Lernkurven effektiv identifiziert werden können. Unteranpassung und Überanpassung 1. Überanpassung Wenn ein Modell mit den Daten übertrainiert ist, sodass es daraus Rauschen lernt, spricht man von einer Überanpassung des Modells. Ein überangepasstes Modell lernt jedes Beispiel so perfekt, dass es ein unsichtbares/neues Beispiel falsch klassifiziert. Für ein überangepasstes Modell erhalten wir einen perfekten/nahezu perfekten Trainingssatzwert und einen schrecklichen Validierungssatz-/Testwert. Leicht geändert: „Ursache der Überanpassung: Verwenden Sie ein komplexes Modell, um ein einfaches Problem zu lösen und Rauschen aus den Daten zu extrahieren. Weil ein kleiner Datensatz als Trainingssatz möglicherweise nicht die korrekte Darstellung aller Daten darstellt. 2. Unteranpassung Heru.“

Die Entwicklung der künstlichen Intelligenz in der Weltraumforschung und der Siedlungstechnik

Apr 29, 2024 pm 03:25 PM

Die Entwicklung der künstlichen Intelligenz in der Weltraumforschung und der Siedlungstechnik

Apr 29, 2024 pm 03:25 PM

In den 1950er Jahren wurde die künstliche Intelligenz (KI) geboren. Damals entdeckten Forscher, dass Maschinen menschenähnliche Aufgaben wie das Denken ausführen können. Später, in den 1960er Jahren, finanzierte das US-Verteidigungsministerium künstliche Intelligenz und richtete Labore für die weitere Entwicklung ein. Forscher finden Anwendungen für künstliche Intelligenz in vielen Bereichen, etwa bei der Erforschung des Weltraums und beim Überleben in extremen Umgebungen. Unter Weltraumforschung versteht man die Erforschung des Universums, das das gesamte Universum außerhalb der Erde umfasst. Der Weltraum wird als extreme Umgebung eingestuft, da sich seine Bedingungen von denen auf der Erde unterscheiden. Um im Weltraum zu überleben, müssen viele Faktoren berücksichtigt und Vorkehrungen getroffen werden. Wissenschaftler und Forscher glauben, dass die Erforschung des Weltraums und das Verständnis des aktuellen Zustands aller Dinge dazu beitragen können, die Funktionsweise des Universums zu verstehen und sich auf mögliche Umweltkrisen vorzubereiten

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Zu den häufigsten Herausforderungen, mit denen Algorithmen für maschinelles Lernen in C++ konfrontiert sind, gehören Speicherverwaltung, Multithreading, Leistungsoptimierung und Wartbarkeit. Zu den Lösungen gehören die Verwendung intelligenter Zeiger, moderner Threading-Bibliotheken, SIMD-Anweisungen und Bibliotheken von Drittanbietern sowie die Einhaltung von Codierungsstilrichtlinien und die Verwendung von Automatisierungstools. Praktische Fälle zeigen, wie man die Eigen-Bibliothek nutzt, um lineare Regressionsalgorithmen zu implementieren, den Speicher effektiv zu verwalten und leistungsstarke Matrixoperationen zu nutzen.

Erklärbare KI: Erklären komplexer KI/ML-Modelle

Jun 03, 2024 pm 10:08 PM

Erklärbare KI: Erklären komplexer KI/ML-Modelle

Jun 03, 2024 pm 10:08 PM

Übersetzer |. Rezensiert von Li Rui |. Chonglou Modelle für künstliche Intelligenz (KI) und maschinelles Lernen (ML) werden heutzutage immer komplexer, und die von diesen Modellen erzeugten Ergebnisse sind eine Blackbox, die den Stakeholdern nicht erklärt werden kann. Explainable AI (XAI) zielt darauf ab, dieses Problem zu lösen, indem es Stakeholdern ermöglicht, die Funktionsweise dieser Modelle zu verstehen, sicherzustellen, dass sie verstehen, wie diese Modelle tatsächlich Entscheidungen treffen, und Transparenz in KI-Systemen, Vertrauen und Verantwortlichkeit zur Lösung dieses Problems gewährleistet. In diesem Artikel werden verschiedene Techniken der erklärbaren künstlichen Intelligenz (XAI) untersucht, um ihre zugrunde liegenden Prinzipien zu veranschaulichen. Mehrere Gründe, warum erklärbare KI von entscheidender Bedeutung ist. Vertrauen und Transparenz: Damit KI-Systeme allgemein akzeptiert und vertrauenswürdig sind, müssen Benutzer verstehen, wie Entscheidungen getroffen werden

Ausblick auf zukünftige Trends der Golang-Technologie im maschinellen Lernen

May 08, 2024 am 10:15 AM

Ausblick auf zukünftige Trends der Golang-Technologie im maschinellen Lernen

May 08, 2024 am 10:15 AM

Das Anwendungspotenzial der Go-Sprache im Bereich des maschinellen Lernens ist enorm. Ihre Vorteile sind: Parallelität: Sie unterstützt die parallele Programmierung und eignet sich für rechenintensive Operationen bei maschinellen Lernaufgaben. Effizienz: Der Garbage Collector und die Sprachfunktionen sorgen dafür, dass der Code auch bei der Verarbeitung großer Datenmengen effizient ist. Benutzerfreundlichkeit: Die Syntax ist prägnant und erleichtert das Erlernen und Schreiben von Anwendungen für maschinelles Lernen.