Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wie sehen Hunde die Welt? Humanforscher wollten die visuelle Wahrnehmung im Gehirn von Hunden entschlüsseln

Wie sehen Hunde die Welt? Humanforscher wollten die visuelle Wahrnehmung im Gehirn von Hunden entschlüsseln

Wie sehen Hunde die Welt? Humanforscher wollten die visuelle Wahrnehmung im Gehirn von Hunden entschlüsseln

Hunde und Menschen haben sich in den letzten 15.000 Jahren gemeinsam entwickelt. Heutzutage leben Hunde oft als Haustiere in menschlicher Umgebung. Manchmal schauen sich Hunde wie Menschen zu Hause Videos an und scheinen es zu verstehen.

Wie sieht also die Welt in den Augen von Hunden aus?

Kürzlich hat eine Studie der Emory University visuelle Bilder aus den Gehirnen von Hunden entschlüsselt und damit zum ersten Mal enthüllt, wie das Gehirn des Hundes rekonstruiert, was es sieht. Die Forschung wurde im Journal of Visual Experiments veröffentlicht.

Papieradresse: https://www.jove.com/t/64442/through-dog-s-eyes-fmri-decoding-naturalistic-videos-from-dog

Die Forscher zeichneten zwei fMRT auf neuronale Daten von wachen, ungezügelten Hunden, während sie dreimal insgesamt 90 Minuten lang 30-minütige Videos ansahen. Anschließend nutzten sie Algorithmen des maschinellen Lernens, um Muster in den neuronalen Daten zu analysieren.

Gregory Berns, Professor für Psychologie an der Emory University und Co-Autor der Arbeit, sagte: „Wir können die Gehirnaktivität des Hundes überwachen, während er das Video ansieht, und bis zu einem gewissen Grad rekonstruieren, was er sieht. Wir können das tun.“ Das ist ziemlich bemerkenswert.“

Berns und Kollegen leisteten Pionierarbeit bei der Verwendung der fMRT-Scantechnologie bei Hunden und brachten den Hunden bei, während der Messung der neuronalen Aktivität völlig still und ungezügelt zu bleiben. Vor zehn Jahren veröffentlichte das Team das erste fMRT-Gehirnbild eines vollständig wachen, ungezügelten Hundes und öffnete damit die Tür zu dem, was Berns „The Dog Project“ nennt.

Berns mit Callie, der ersten Hündin, deren Gehirnaktivität im völlig wachen und ungezügelten Zustand gescannt wurde.

Im Laufe der Jahre hat das Labor von Berns mehrere Studien darüber veröffentlicht, wie das Gehirn von Hunden Sehvermögen, Sprache, Gerüche und Belohnungen (z. B. Lob oder Futter) verarbeitet.

Gleichzeitig schreitet die Technologie des maschinellen Lernens weiter voran und ermöglicht es Wissenschaftlern, einige Aktivitätsmuster des menschlichen Gehirns zu entschlüsseln. Berns begann sich dann zu fragen, ob eine ähnliche Technologie auf Hundegehirne angewendet werden könnte.

Diese neue Forschung basiert auf maschinellem Lernen und fMRT-Technologie. fMRT ist ein Neuroimaging-Verfahren, das Magnetresonanztomographie nutzt, um durch neuronale Aktivität verursachte Veränderungen der Hämodynamik zu messen. Diese Technologie ist nicht-invasiv und spielt eine wichtige Rolle auf dem Gebiet der Lokalisierung von Gehirnfunktionen. Außer beim Menschen wurde die Technologie bisher nur bei einer Handvoll anderer Arten eingesetzt, darunter auch bei einigen Primaten.

Einführung in die Forschung

Bei dem Experiment wurden zwei Hunde eingesetzt. Es beweist, dass maschinelles Lernen, fMRT und andere Technologien allgemein für die Analyse von Hunden eingesetzt werden können. Die Forscher hoffen auch, dass diese Studie für andere hilfreich sein wird, um tiefer zu gehen. Erfahren Sie mehr darüber, wie verschiedene Tiere denken.

Der experimentelle Ablauf ist ungefähr wie folgt:

Experimentelle Teilnehmer: Bhubo, 4 Jahre alt; Daisy, 11 Jahre alt. Beide Hunde hatten zuvor an mehreren fMRT-Trainingssitzungen teilgenommen (Bhubo: 8 Sitzungen, Daisy: 11 Sitzungen), bei denen einige auf einen Bildschirm projizierte visuelle Reize betrachteten. Die beiden Hunde wurden aufgrund ihrer Fähigkeit ausgewählt, längere Zeit im Scanner zu bleiben, ohne sich zu bewegen, ohne von ihren Besitzern gesehen zu werden.

Videoaufnahmen: Nehmen Sie Videos aus der Perspektive des Hundes auf, um alltägliche Szenen im Leben eines Hundes festzuhalten. Zu diesen Szenarien gehören Gehen, Füttern, Spielen, Interaktion mit Menschen, Interaktionen von Hund zu Hund usw. Das Video wurde in 256 einzigartige Szenen geschnitten, von denen jede ein Ereignis darstellt, beispielsweise einen Hund, der mit einem Menschen kuschelt, einen Hund rennt oder einen Spaziergang. Jeder Szene wird basierend auf ihrem Inhalt eine eindeutige Nummer und Bezeichnung zugewiesen. Die Szenen wurden dann in fünf größere Zusammenstellungsvideos mit einer Länge von jeweils etwa 6 Minuten geschnitten.

Experimentelles Design: Die Teilnehmer wurden zunächst mit einem 3T-MRT gescannt, während sie sich ein Zusammenstellungsvideo ansahen, das auf einen Bildschirm hinter dem MRT-Loch projiziert wurde. Bei Hunden wird der Kopf nach vorherigem Training in speziell angefertigte Kinnstützen gelegt, um eine stabile Kopfposition zu erreichen, wie im Bild unten dargestellt. Das Experiment wurde dreimal angeschaut, jede Betrachtung dauerte 30 Minuten. Das Video hat eine Gesamtdauer von 90 Minuten.

Während des Experiments wurde gleichzeitig fMRT verwendet, um den Hund zu scannen, und dann wurden die Daten analysiert. Das Experiment verwendete den Ivis-Algorithmus für maschinelles Lernen, eine nichtlineare Methode, die auf dem Siamese Neural Network (SNN) basiert hat den hochdimensionalen Erfolg biologischer Daten analysiert. Darüber hinaus wurden im Experiment auch maschinelle Lernalgorithmen wie Scikit-Learn und RFC verwendet.

Daisy wurde gescannt. Ihre Ohren wurden abgeklebt, um Ohrstöpsel an Ort und Stelle zu halten und Lärm zu vermeiden.

Diese Studie verglich die Funktionsweise des Gehirns von Menschen und Hunden. Ergebnisse von zwei menschlichen Probanden zeigten, dass ein Modell, das mithilfe neuronaler Netze entwickelt wurde, Gehirndaten mit einer Genauigkeit von 99 % auf objektbasierte und aktionsbasierte Klassifikatoren abbildete. Bei der Dekodierung von Hundegehirnmustern war das gleiche Modell nicht anwendbar Aktionsklassifizierung, Genauigkeit erreicht 75 % – 88 %. Dies verdeutlicht erhebliche Unterschiede in der Funktionsweise des Gehirns von Menschen und Hunden, wie unten in den experimentellen Ergebnissen für Menschen (A) und Hunde (B) gezeigt. Diesbezüglich kam Berns zu dem Schluss: „Wir Menschen sind sehr besorgt darüber, was wir sehen, aber Hunden scheint es weniger darum zu gehen, wen oder was sie sehen, als vielmehr um das Handlungsverhalten.“ Originaltext der Arbeit, um mehr über die Forschungsdetails zu erfahren.

Das obige ist der detaillierte Inhalt vonWie sehen Hunde die Welt? Humanforscher wollten die visuelle Wahrnehmung im Gehirn von Hunden entschlüsseln. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Heute diskutieren wir darüber, wie Deep-Learning-Technologie die Leistung von visionbasiertem SLAM (Simultaneous Localization and Mapping) in komplexen Umgebungen verbessern kann. Durch die Kombination von Methoden zur Tiefenmerkmalsextraktion und Tiefenanpassung stellen wir hier ein vielseitiges hybrides visuelles SLAM-System vor, das die Anpassung in anspruchsvollen Szenarien wie schlechten Lichtverhältnissen, dynamischer Beleuchtung, schwach strukturierten Bereichen und starkem Jitter verbessern soll. Unser System unterstützt mehrere Modi, einschließlich erweiterter Monokular-, Stereo-, Monokular-Trägheits- und Stereo-Trägheitskonfigurationen. Darüber hinaus wird analysiert, wie visuelles SLAM mit Deep-Learning-Methoden kombiniert werden kann, um andere Forschungen zu inspirieren. Durch umfangreiche Experimente mit öffentlichen Datensätzen und selbst abgetasteten Daten demonstrieren wir die Überlegenheit von SL-SLAM in Bezug auf Positionierungsgenauigkeit und Tracking-Robustheit.

Was ist NeRF? Ist die NeRF-basierte 3D-Rekonstruktion voxelbasiert?

Oct 16, 2023 am 11:33 AM

Was ist NeRF? Ist die NeRF-basierte 3D-Rekonstruktion voxelbasiert?

Oct 16, 2023 am 11:33 AM

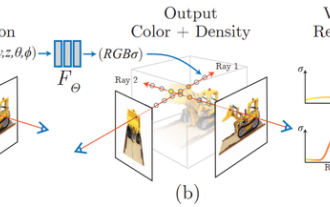

1 Einleitung Neural Radiation Fields (NeRF) sind ein relativ neues Paradigma im Bereich Deep Learning und Computer Vision. Diese Technologie wurde im ECCV2020-Papier „NeRF: Representing Scenes as Neural Radiation Fields for View Synthesis“ (das mit dem Best Paper Award ausgezeichnet wurde) vorgestellt und erfreut sich seitdem mit bisher fast 800 Zitaten äußerster Beliebtheit [1]. Der Ansatz markiert einen grundlegenden Wandel in der traditionellen Art und Weise, wie maschinelles Lernen 3D-Daten verarbeitet. Darstellung neuronaler Strahlungsfelder und differenzierbarer Rendering-Prozess: Zusammengesetzte Bilder durch Abtasten von 5D-Koordinaten (Position und Blickrichtung) entlang der Kamerastrahlen, Eingabe dieser Positionen in ein MLP, um mithilfe volumetrischer Rendering-Techniken Bilder zu erzeugen; ; Die Rendering-Funktion ist differenzierbar und kann daher übergeben werden

Die erste rein visuelle statische Rekonstruktion des autonomen Fahrens

Jun 02, 2024 pm 03:24 PM

Die erste rein visuelle statische Rekonstruktion des autonomen Fahrens

Jun 02, 2024 pm 03:24 PM

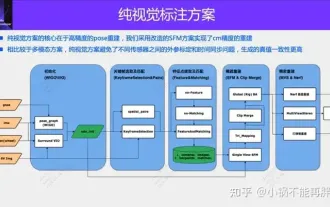

Eine rein visuelle Annotationslösung nutzt hauptsächlich die visuelle Darstellung sowie einige Daten von GPS, IMU und Radgeschwindigkeitssensoren für die dynamische Annotation. Für Massenproduktionsszenarien muss es sich natürlich nicht nur um visuelle Aspekte handeln. Einige in Massenproduktion hergestellte Fahrzeuge verfügen über Sensoren wie Festkörperradar (AT128). Wenn wir aus Sicht der Massenproduktion einen geschlossenen Datenkreislauf erstellen und alle diese Sensoren verwenden, können wir das Problem der Kennzeichnung dynamischer Objekte effektiv lösen. Aber in unserem Plan gibt es kein Festkörperradar. Aus diesem Grund stellen wir diese gängigste Etikettierungslösung für die Massenproduktion vor. Der Kern einer rein visuellen Annotationslösung liegt in der hochpräzisen Posenrekonstruktion. Wir verwenden das Posenrekonstruktionsschema von Structure from Motion (SFM), um die Genauigkeit der Rekonstruktion sicherzustellen. Aber pass

Werfen Sie einen Blick auf die Vergangenheit und Gegenwart von Occ und autonomem Fahren! Die erste Rezension fasst die drei Hauptthemen Funktionserweiterung/Massenproduktionsbereitstellung/effiziente Annotation umfassend zusammen.

May 08, 2024 am 11:40 AM

Werfen Sie einen Blick auf die Vergangenheit und Gegenwart von Occ und autonomem Fahren! Die erste Rezension fasst die drei Hauptthemen Funktionserweiterung/Massenproduktionsbereitstellung/effiziente Annotation umfassend zusammen.

May 08, 2024 am 11:40 AM

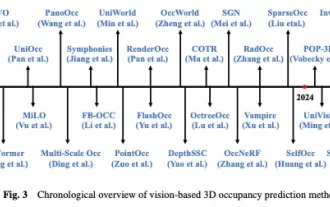

Oben geschrieben und persönliches Verständnis des Autors In den letzten Jahren hat autonomes Fahren aufgrund seines Potenzials, die Belastung des Fahrers zu verringern und die Fahrsicherheit zu verbessern, zunehmende Aufmerksamkeit erhalten. Die visionsbasierte dreidimensionale Belegungsvorhersage ist eine neue Wahrnehmungsaufgabe, die sich für eine kostengünstige und umfassende Untersuchung der Sicherheit autonomen Fahrens eignet. Obwohl viele Studien die Überlegenheit von 3D-Belegungsvorhersagetools im Vergleich zu objektzentrierten Wahrnehmungsaufgaben gezeigt haben, gibt es immer noch Rezensionen, die diesem sich schnell entwickelnden Bereich gewidmet sind. In diesem Artikel wird zunächst der Hintergrund der visionsbasierten 3D-Belegungsvorhersage vorgestellt und die bei dieser Aufgabe auftretenden Herausforderungen erörtert. Als nächstes diskutieren wir umfassend den aktuellen Status und die Entwicklungstrends aktueller 3D-Belegungsvorhersagemethoden unter drei Gesichtspunkten: Funktionsverbesserung, Bereitstellungsfreundlichkeit und Kennzeichnungseffizienz. zu guter Letzt

Base64-Kodierung und -Dekodierung mit Python

Sep 02, 2023 pm 01:49 PM

Base64-Kodierung und -Dekodierung mit Python

Sep 02, 2023 pm 01:49 PM

Nehmen wir an, Sie haben eine binäre Bilddatei, die Sie über das Netzwerk übertragen möchten. Sie sind überrascht, dass die andere Partei die Datei nicht korrekt erhalten hat – sie enthält nur seltsame Zeichen! Nun, es sieht so aus, als ob Sie versuchen, die Datei im Rohbit- und Byteformat zu senden, während die von Ihnen verwendeten Medien für das Streamen von Text ausgelegt sind. Welche Lösungen gibt es, um solche Probleme zu vermeiden? Die Antwort ist Base64-Kodierung. In diesem Artikel zeige ich Ihnen, wie Sie Binärbilder mit Python kodieren und dekodieren. Das Programm wird als eigenständiges lokales Programm beschrieben, Sie können das Konzept jedoch auf andere Anwendungen anwenden, z. B. auf das Senden codierter Bilder von einem mobilen Gerät an einen Server und viele andere Anwendungen. Was ist Base64? Bevor wir uns mit diesem Artikel befassen, definieren wir Base6

Die Registrierung von Punktwolken ist für die 3D-Vision unumgänglich! Verstehen Sie alle gängigen Lösungen und Herausforderungen in einem Artikel

Apr 02, 2024 am 11:31 AM

Die Registrierung von Punktwolken ist für die 3D-Vision unumgänglich! Verstehen Sie alle gängigen Lösungen und Herausforderungen in einem Artikel

Apr 02, 2024 am 11:31 AM

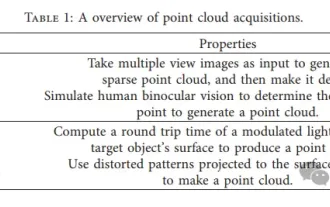

Es wird erwartet, dass die Punktwolke als Sammlung von Punkten eine Veränderung bei der Erfassung und Generierung dreidimensionaler (3D) Oberflächeninformationen von Objekten durch 3D-Rekonstruktion, industrielle Inspektion und Roboterbetrieb bewirken wird. Der anspruchsvollste, aber wesentlichste Prozess ist die Punktwolkenregistrierung, d. h. das Erhalten einer räumlichen Transformation, die zwei in zwei verschiedenen Koordinaten erhaltene Punktwolken ausrichtet und abgleicht. In dieser Rezension werden ein Überblick und die Grundprinzipien der Punktwolkenregistrierung vorgestellt, verschiedene Methoden systematisch klassifiziert und verglichen und die technischen Probleme bei der Punktwolkenregistrierung gelöst. Dabei wird versucht, akademischen Forschern außerhalb des Fachgebiets und Ingenieuren Orientierung zu geben und Diskussionen über eine einheitliche Vision zu erleichtern zur Punktwolkenregistrierung. Die allgemeine Methode zur Punktwolkenerfassung ist in aktive und passive Methoden unterteilt. Die vom Sensor aktiv erfasste Punktwolke ist die aktive Methode, und die Punktwolke wird später rekonstruiert.

Wie implementiert man die Kodierung und Dekodierung chinesischer Zeichen in der C-Sprachprogrammierung?

Feb 19, 2024 pm 02:15 PM

Wie implementiert man die Kodierung und Dekodierung chinesischer Zeichen in der C-Sprachprogrammierung?

Feb 19, 2024 pm 02:15 PM

In der modernen Computerprogrammierung ist die Sprache C eine der am häufigsten verwendeten Programmiersprachen. Obwohl die C-Sprache selbst die chinesische Kodierung und Dekodierung nicht direkt unterstützt, können wir einige Technologien und Bibliotheken verwenden, um diese Funktion zu erreichen. In diesem Artikel wird erläutert, wie die chinesische Kodierung und Dekodierung in C-Sprachprogrammiersoftware implementiert wird. Um die chinesische Kodierung und Dekodierung zu implementieren, müssen wir zunächst die Grundkonzepte der chinesischen Kodierung verstehen. Derzeit ist das am häufigsten verwendete chinesische Codierungsschema die Unicode-Codierung. Die Unicode-Kodierung weist jedem Zeichen einen eindeutigen numerischen Wert zu, sodass bei der Berechnung

Sie können spielen, indem Sie einfach Ihren Mund bewegen! Benutze KI, um Charaktere zu wechseln und Feinde anzugreifen: „Ayaka, benutze Kamiri-ryu Frost Destruction.'

May 13, 2023 pm 07:52 PM

Sie können spielen, indem Sie einfach Ihren Mund bewegen! Benutze KI, um Charaktere zu wechseln und Feinde anzugreifen: „Ayaka, benutze Kamiri-ryu Frost Destruction.'

May 13, 2023 pm 07:52 PM

Wenn es um heimische Spiele geht, die in den letzten zwei Jahren auf der ganzen Welt populär geworden sind, hat Genshin Impact definitiv die Nase vorn. Laut der im Mai veröffentlichten Umsatzumfrage für Mobilspiele im ersten Quartal dieses Jahres belegte „Genshin Impact“ mit einem absoluten Vorsprung von 567 Millionen US-Dollar den ersten Platz In nur 18 Jahren war das Unternehmen online. Der Gesamtumsatz allein mit der mobilen Plattform überstieg 3 Milliarden US-Dollar (ca. 13 Milliarden RM). Nun ist die letzte Inselversion 2.8 vor der Eröffnung von Xumi längst überfällig. Nach einer langen Entwurfszeit gibt es endlich neue Handlungsstränge und Gebiete zum Spielen. Aber ich weiß nicht, wie viele „Leberkaiser“ es gibt. Jetzt, wo die Insel vollständig erkundet ist, beginnt wieder Gras zu wachsen. Es gibt insgesamt 182 Schatztruhen + 1 Mora-Box (nicht im Lieferumfang enthalten). Es besteht kein Grund zur Sorge, dass es im Genshin Impact-Bereich nie an Arbeit mangelt. Nein, während des hohen Grases