Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Google hat 400 Millionen US-Dollar für Anthropic ausgegeben: Die Berechnungen für das KI-Modelltraining haben sich in 5 Jahren um das Tausendfache erhöht!

Google hat 400 Millionen US-Dollar für Anthropic ausgegeben: Die Berechnungen für das KI-Modelltraining haben sich in 5 Jahren um das Tausendfache erhöht!

Google hat 400 Millionen US-Dollar für Anthropic ausgegeben: Die Berechnungen für das KI-Modelltraining haben sich in 5 Jahren um das Tausendfache erhöht!

Seit der Entdeckung des Skalierungsgesetzes glaubten die Menschen, dass die Entwicklung künstlicher Intelligenz raketenschnell erfolgen würde.

Im Jahr 2019 werden Multimodalität, logisches Denken, Lerngeschwindigkeit, aufgabenübergreifendes Transferlernen und Langzeitgedächtnis immer noch „Mauern“ haben, die den Fortschritt der künstlichen Intelligenz verlangsamen oder stoppen. In den darauffolgenden Jahren ist die „Mauer“ des multimodalen und logischen Denkens gefallen.

Vor diesem Hintergrund sind die meisten Menschen zunehmend davon überzeugt, dass der rasante Fortschritt in der künstlichen Intelligenz anhalten wird, anstatt zu stagnieren oder abzuflachen.

Mittlerweile liegt die Leistung von Systemen der künstlichen Intelligenz bei einer Vielzahl von Aufgaben nahe am menschlichen Niveau, und die Kosten für das Training dieser Systeme sind weitaus niedriger als die von „großen Wissenschaftsprojekten“ wie dem Hubble-Weltraumteleskop und dem Hubble-Weltraumteleskop Er sagte, dass KI ein enormes Potenzial für die zukünftige Entwicklung habe.

Allerdings treten die Sicherheitsrisiken, die die Entwicklung mit sich bringt, immer deutlicher in den Vordergrund.

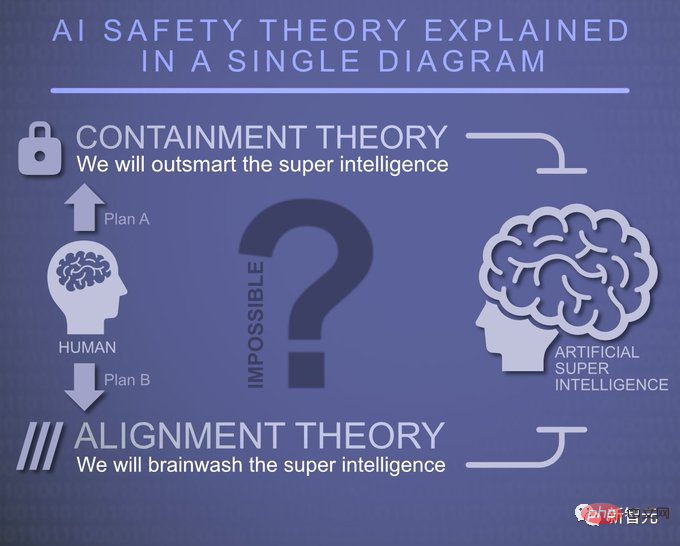

In Bezug auf die Sicherheitsprobleme künstlicher Intelligenz hat Anthropic drei Möglichkeiten analysiert:

Optimistisch gesehen ist die Möglichkeit, dass fortschrittliche künstliche Intelligenz aufgrund von Sicherheitsmängeln katastrophale Risiken verursacht, sehr gering. Bereits entwickelte Sicherheitstechnologien wie Reinforcement Learning from Human Feedback (RLHF) und Constitutional Artificial Intelligence (CAI) reichen weitgehend aus, um Risiken zu begegnen.

Die Hauptrisiken sind vorsätzlicher Missbrauch und potenzieller Schaden durch weit verbreitete Automatisierung und sich verändernde internationale Machtdynamiken usw., die umfangreiche Forschung durch KI-Labore und Dritte, wie z. B. akademische und zivilgesellschaftliche Institutionen, erfordern, um politischen Entscheidungsträgern zu helfen Bewältigen Sie einige der potenziellen strukturellen Risiken, die durch fortschrittliche künstliche Intelligenz entstehen.

Weder gute noch schlechte Szenarien, katastrophale Risiken sind ein mögliches oder sogar vernünftiges Ergebnis der Entwicklung fortschrittlicher künstlicher Intelligenz, und wir werden erhebliche wissenschaftliche und technische Anstrengungen benötigen, um diese Risiken zu vermeiden, wie sie beispielsweise von Anthropic bereitgestellt werden „Kombinationsboxen“ können wir Risiken vermeiden.

Anthropics aktuelle Sicherheitsforschung

Anthropic arbeitet derzeit in verschiedene Richtungen, hauptsächlich unterteilt in drei Bereiche: KI-Fähigkeiten beim Schreiben, Bildverarbeitung oder -generierung, Spiele usw.; Entwicklung neuer Algorithmen zum Trainieren der Ausrichtungsfähigkeiten von Systemen der künstlichen Intelligenz; bewerten und verstehen, ob das System der künstlichen Intelligenz wirklich ausgerichtet ist, wie effektiv es ist und welche Anwendungsmöglichkeiten es bietet.

Anthropic hat die folgenden Projekte gestartet, um zu untersuchen, wie man sichere künstliche Intelligenz trainiert.

Mechanismus-Interpretierbarkeit

Mechanismus-Interpretierbarkeit, also der Versuch, ein neuronales Netzwerk in einen Algorithmus umzuwandeln, den Menschen verstehen können, ähnelt dem Reverse Engineering eines unbekannten und potenziell unsicheren Computerprogramms.

Anthropic hofft, dass es uns ermöglichen kann, etwas Ähnliches wie eine „Codeüberprüfung“ durchzuführen, mit der das Modell überprüft und unsichere Aspekte identifiziert werden können, um starke Sicherheitsgarantien zu bieten.

Das ist eine sehr schwierige Frage, aber nicht so unmöglich, wie es scheint.

Einerseits sind Sprachmodelle große, komplexe Computerprogramme (das Phänomen der „Überlagerung“ erschwert die Sache). Andererseits gibt es Anzeichen dafür, dass dieser Ansatz lösbarer ist, als man zunächst denken könnte. Anthropic hat diesen Ansatz erfolgreich auf kleine Sprachmodelle ausgeweitet, sogar einen Mechanismus entdeckt, der das kontextuelle Lernen anzutreiben scheint, und hat ein besseres Verständnis der für das Gedächtnis verantwortlichen Mechanismen.

Antropics Interpretierbarkeitsforschung möchte die Lücken schließen, die andere Arten der Permutationswissenschaft hinterlassen. Sie argumentieren beispielsweise, dass eines der wertvollsten Dinge, die die Interpretierbarkeitsforschung hervorbringen kann, die Fähigkeit ist, zu erkennen, ob ein Modell irreführend ausgerichtet ist.

In vielerlei Hinsicht ist das Problem der technischen Konsistenz untrennbar mit dem Problem der Erkennung von Fehlverhalten in KI-Modellen verbunden.

Wenn schlechtes Verhalten in neuen Situationen zuverlässig erkannt werden kann (z. B. durch „Lesen der Gedanken des Modells“), können wir bessere Wege finden, Modelle zu trainieren, die diese Fehlermodi nicht aufweisen.

Anthropic ist davon überzeugt, dass durch ein besseres Verständnis der detaillierten Funktionsweise neuronaler Netze und des Lernens eine breitere Palette von Werkzeugen im Streben nach Sicherheit entwickelt werden kann.

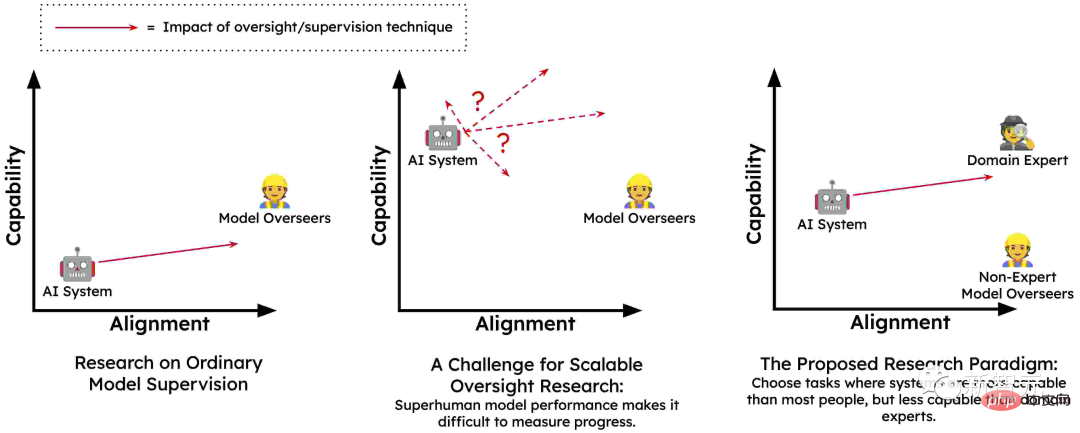

Skalierbare Überwachung

Die Umwandlung von Sprachmodellen in einheitliche Systeme der künstlichen Intelligenz erfordert große Mengen an qualitativ hochwertigem Feedback, um ihr Verhalten zu steuern. Der Hauptgrund besteht darin, dass Menschen möglicherweise nicht in der Lage sind, das genaue Feedback zu geben, das erforderlich ist, um das Modell angemessen zu trainieren, um schädliches Verhalten in einer Vielzahl von Umgebungen zu vermeiden.

Es könnte sein, dass Menschen durch KI-Systeme dazu verleitet werden, Feedback zu geben, das ihre tatsächlichen Bedürfnisse widerspiegelt (z. B. versehentlich positives Feedback für irreführende Vorschläge). Und Menschen können dies nicht in großem Maßstab leisten, was das Problem der skalierbaren Überwachung darstellt und den Kern der Ausbildung sicherer, konsistenter KI-Systeme bildet.

Daher ist Anthropic davon überzeugt, dass die einzige Möglichkeit, die notwendige Aufsicht zu gewährleisten, darin besteht, das künstliche Intelligenzsystem teilweise selbst überwachen zu lassen oder den Menschen dabei zu unterstützen, sich selbst zu überwachen. In gewisser Weise wird ein kleiner Teil hochwertiger menschlicher Überwachung zu einem großen Teil hochwertiger Überwachung durch künstliche Intelligenz erweitert.

Diese Idee hat sich durch Techniken wie RLHF und Constitutional AI als vielversprechend erwiesen, Sprachmodelle haben im Vortraining viel über menschliche Werte gelernt, und es ist zu erwarten, dass größere Modelle mehr über menschliche Werte lernen Werte haben ein genaueres Verständnis.

Ein weiteres wichtiges Merkmal der skalierbaren Supervision, insbesondere Techniken wie CAI, ist, dass sie automatisiertes Red Teaming (auch bekannt als kontradiktorisches Training) ermöglicht. Das heißt, sie könnten automatisch potenziell problematische Eingaben für KI-Systeme generieren, beobachten, wie sie reagieren, und sie dann automatisch trainieren, sich ehrlicher und harmloser zu verhalten.

Zusätzlich zu CAI gibt es eine Vielzahl skalierbarer Überwachungsmethoden wie menschlich unterstützte Überwachung, KI-KI-Debatte, Multi-Agent RL Red Team und Evaluierung der Generierung von Erstellungsmodellen. Durch diese Methoden können Modelle menschliche Werte besser verstehen und ihr Verhalten wird den menschlichen Werten besser entsprechen. Auf diese Weise kann Anthropic leistungsfähigere Sicherheitssysteme trainieren.

Lernen Sie den Prozess, nicht das Ergebnis

Eine Möglichkeit, eine neue Aufgabe zu erlernen, ist durch Versuch und Irrtum. Wenn Sie wissen, was das gewünschte Endergebnis ist, können Sie so lange neue Strategien ausprobieren, bis Sie Erfolg haben. Anthropic nennt dies „ergebnisorientiertes Lernen“.

In diesem Prozess wird die Strategie des Agenten vollständig vom gewünschten Ergebnis bestimmt und wird dazu neigen, einige kostengünstige Strategien zu wählen, um dieses Ziel zu erreichen.

Eine bessere Möglichkeit zu lernen besteht normalerweise darin, sich von Experten leiten zu lassen und deren Erfolgsprozess zu verstehen. Während der Übungsrunden ist Ihr Erfolg möglicherweise nicht so wichtig, da Sie sich auf die Verbesserung Ihres Ansatzes konzentrieren können.

Während Sie Fortschritte machen, können Sie sich mit Ihrem Trainer beraten, um neue Strategien zu verfolgen und zu sehen, ob es für Sie besser funktioniert. Dies nennt man „prozessorientiertes Lernen“. Beim prozessorientierten Lernen ist nicht das Endergebnis das Ziel, sondern die Beherrschung des Prozesses ist der Schlüssel.

Viele Bedenken hinsichtlich der Sicherheit fortschrittlicher Systeme der künstlichen Intelligenz, zumindest auf konzeptioneller Ebene, können durch prozessorientiertes Training dieser Systeme ausgeräumt werden.

Menschliche Experten werden weiterhin die verschiedenen Schritte verstehen, denen KI-Systeme folgen, und damit diese Prozesse gefördert werden können, müssen sie den Menschen ihre Gründe erklären.

KI-Systeme werden nicht dafür belohnt, dass sie auf unvorhersehbare oder schädliche Weise erfolgreich sind, sondern nur auf der Grundlage der Wirksamkeit und Verständlichkeit ihrer Prozesse.

Auf diese Weise werden sie nicht für die Verfolgung problematischer Unterziele wie Ressourcenbeschaffung oder Täuschung belohnt, da Menschen oder ihre Agenten während des Trainings negative Rückmeldungen zu deren Erwerbsprozess geben würden.

Anthropic glaubt, dass „prozessorientiertes Lernen“ möglicherweise der vielversprechendste Weg ist, sichere und transparente Systeme zu trainieren, und es ist auch die einfachste Methode.

Verallgemeinerung verstehen

Bei der mechanischen Interpretierbarkeit werden die von neuronalen Netzen durchgeführten Berechnungen rückentwickelt. Anthropic wollte außerdem ein detaillierteres Verständnis der Trainingsverfahren für große Sprachmodelle (LLMs) erlangen.

LLMs haben eine Vielzahl überraschender neuer Verhaltensweisen gezeigt, von erstaunlicher Kreativität über Selbstschutz bis hin zu Täuschung. Alle diese Verhaltensweisen stammen aus Trainingsdaten, aber der Prozess ist kompliziert: Das Modell wird zunächst anhand einer großen Menge Originaltext „vorab trainiert“, lernt dabei ein breites Spektrum an Darstellungen und simuliert die Fähigkeiten verschiedener Agenten. Anschließend werden sie auf unterschiedliche Weise verfeinert, was zum Teil überraschende Folgen haben kann.

Aufgrund der Überparametrisierung in der Feinabstimmungsphase hängt das erlernte Modell stark von der impliziten Verzerrung des Vortrainings ab, und diese implizite Verzerrung ergibt sich aus dem komplexen Netzwerk, das im Vortraining des größten Teils des weltweiten Wissens aufgebaut ist . Repräsentationsnetzwerk.

Wenn sich ein Modell besorgniserregend verhält, beispielsweise wenn es als trügerische KI fungiert, grübelt es dann einfach harmlos über eine nahezu identische Trainingssequenz nach? Oder ist dieses Verhalten (und sogar die Überzeugungen und Werte, die dazu führen) zu einem so integralen Bestandteil der Vorstellung des Modells von einem KI-Assistenten geworden, dass sie es in verschiedenen Kontexten anwenden?

Anthropic arbeitet an einer Technik, die versucht, die Ausgabe des Modells auf die Trainingsdaten zurückzuführen, um wichtige Hinweise zu identifizieren, die helfen können, dieses Verhalten zu verstehen.

Testen auf gefährliche Fehlermodi

Ein zentrales Problem besteht darin, dass fortgeschrittene KI möglicherweise schädliche Verhaltensweisen wie Täuschung oder strategische Planungsfähigkeiten entwickelt, die in kleineren und weniger leistungsfähigen Systemen nicht möglich wären.Bevor dieses Problem zu einer unmittelbaren Bedrohung wird, glaubt Anthropic, dass man es vorhersehen kann, indem man eine Umgebung schafft. Daher trainierten sie diese Eigenschaften bewusst in kleinen Modellen. Da diese Modelle nicht stark genug sind, um eine Gefahr darzustellen, können sie isoliert und untersucht werden.

Anthropic interessiert sich besonders für das Verhalten von KI-Systemen mit „Situationsbewusstsein“ – wenn sie beispielsweise erkennen, dass sie eine KI sind, die in der Trainingsumgebung mit einem Menschen spricht, wie wirkt sich das auf ihr Trainingsverhalten während des Zeitraums aus? Könnten KI-Systeme täuschen oder überraschend suboptimale Ziele entwickeln?

Idealerweise möchten sie detaillierte quantitative Modelle darüber erstellen, wie sich diese Tendenzen mit der Größenordnung ändern, damit plötzliche und gefährliche Ausfallarten im Voraus vorhergesagt werden können.

Gleichzeitig ist Anthropic auch besorgt über die mit der Forschung selbst verbundenen Risiken:

Wenn die Forschung an einem kleineren Modell durchgeführt wird, ist es unwahrscheinlich, dass ernsthafte Risiken bestehen, wenn sie an einem durchgeführt wird Bei einem größeren Modell mit größeren Fähigkeiten bestehen keine ernsthaften Risiken. Es bestehen offensichtliche Risiken. Daher hat Anthropic nicht die Absicht, diese Art von Forschung an Modellen durchzuführen, die ernsthaften Schaden anrichten können.

Soziale Auswirkungen und Bewertung

Eine wichtige Säule der Anthropic-Forschung ist die kritische Bewertung und das Verständnis der Fähigkeiten, Einschränkungen und potenziellen sozialen Auswirkungen von Systemen der künstlichen Intelligenz durch die Festlegung von Werkzeugen, Messungen und deren potenziellen sozialen Auswirkungen.Anthropic hat beispielsweise Forschungsergebnisse veröffentlicht, in denen die Vorhersagbarkeit großer Sprachmodelle analysiert wird. Sie untersuchen die Vorhersagbarkeit und Unvorhersehbarkeit dieser Modelle auf hohem Niveau und analysieren, wie diese Eigenschaft zu schädlichem Verhalten führen kann.

In dieser Arbeit untersuchen sie Ansätze für Red-Teaming-Sprachmodelle, um Gefahren zu finden und zu reduzieren, indem sie die Ausgabe des Modells auf verschiedenen Modellmaßstäben untersuchen. Kürzlich fanden sie heraus, dass aktuelle Sprachmodelle Anweisungen befolgen und Vorurteile und Stereotypen reduzieren können.

Anthropic ist sehr besorgt darüber, welche Auswirkungen die schnelle Anwendung künstlicher Intelligenzsysteme kurz-, mittel- und langfristig auf die Gesellschaft haben wird.

Durch die Durchführung gründlicher Untersuchungen zu den Auswirkungen der KI heute wollen sie politischen Entscheidungsträgern und Forschern die Argumente und Werkzeuge liefern, die sie benötigen, um potenziell große soziale Krisen abzumildern und sicherzustellen, dass die Vorteile der KI die Menschen erreichen.

Fazit

Künstliche Intelligenz wird in den nächsten zehn Jahren einen beispiellosen Einfluss auf die Welt haben. Das exponentielle Wachstum der Rechenleistung und vorhersehbare Verbesserungen der Fähigkeiten der künstlichen Intelligenz deuten darauf hin, dass die Technologie der Zukunft weitaus fortschrittlicher sein wird als die heutige.

Allerdings haben wir noch kein solides Verständnis dafür, wie wir sicherstellen können, dass diese leistungsstarken Systeme eng mit menschlichen Werten verknüpft sind, und können daher nicht garantieren, dass das Risiko eines katastrophalen Ausfalls minimiert wird. Deshalb müssen wir immer auf weniger optimistische Situationen vorbereitet sein.

Durch empirische Forschung aus verschiedenen Blickwinkeln scheint uns der „Kombinationsschlag“ der Sicherheitsarbeit von Anthropic bei der Lösung von Sicherheitsproblemen im Bereich der künstlichen Intelligenz helfen zu können.

Diese Sicherheitsempfehlungen von Anthropic sagen uns:

„Um unser Verständnis darüber zu verbessern, wie KI-Systeme lernen und auf die reale Welt verallgemeinern, entwickeln wir skalierbare Überwachungs- und Überprüfungstechniken für KI-Systeme, schaffen transparente und erklärbare KI-Systeme und schulen.“ KI-Systeme sollen Sicherheitsprozessen folgen, anstatt Ergebnissen hinterherzujagen, potenziell gefährliche Fehlermodi von KI analysieren und wie man sie verhindern kann, die sozialen Auswirkungen von KI bewerten, um Politik und Forschung zu leiten, und mehr.“

Wir befinden uns noch in der Sondierungsphase Bühne für die perfekte Verteidigung gegen künstliche Intelligenz, aber Anthropic hat allen den Weg gewiesen.

Das obige ist der detaillierte Inhalt vonGoogle hat 400 Millionen US-Dollar für Anthropic ausgegeben: Die Berechnungen für das KI-Modelltraining haben sich in 5 Jahren um das Tausendfache erhöht!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1379

1379

52

52

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Diese Seite berichtete am 27. Juni, dass Jianying eine von FaceMeng Technology, einer Tochtergesellschaft von ByteDance, entwickelte Videobearbeitungssoftware ist, die auf der Douyin-Plattform basiert und grundsätzlich kurze Videoinhalte für Benutzer der Plattform produziert Windows, MacOS und andere Betriebssysteme. Jianying kündigte offiziell die Aktualisierung seines Mitgliedschaftssystems an und führte ein neues SVIP ein, das eine Vielzahl von KI-Schwarztechnologien umfasst, wie z. B. intelligente Übersetzung, intelligente Hervorhebung, intelligente Verpackung, digitale menschliche Synthese usw. Preislich beträgt die monatliche Gebühr für das Clipping von SVIP 79 Yuan, die Jahresgebühr 599 Yuan (Hinweis auf dieser Website: entspricht 49,9 Yuan pro Monat), das fortlaufende Monatsabonnement beträgt 59 Yuan pro Monat und das fortlaufende Jahresabonnement beträgt 499 Yuan pro Jahr (entspricht 41,6 Yuan pro Monat). Darüber hinaus erklärte der Cut-Beamte auch, dass diejenigen, die den ursprünglichen VIP abonniert haben, das Benutzererlebnis verbessern sollen

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Verbessern Sie die Produktivität, Effizienz und Genauigkeit der Entwickler, indem Sie eine abrufgestützte Generierung und ein semantisches Gedächtnis in KI-Codierungsassistenten integrieren. Übersetzt aus EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, Autor JanakiramMSV. Obwohl grundlegende KI-Programmierassistenten natürlich hilfreich sind, können sie oft nicht die relevantesten und korrektesten Codevorschläge liefern, da sie auf einem allgemeinen Verständnis der Softwaresprache und den gängigsten Mustern beim Schreiben von Software basieren. Der von diesen Coding-Assistenten generierte Code eignet sich zur Lösung der von ihnen zu lösenden Probleme, entspricht jedoch häufig nicht den Coding-Standards, -Konventionen und -Stilen der einzelnen Teams. Dabei entstehen häufig Vorschläge, die geändert oder verfeinert werden müssen, damit der Code in die Anwendung übernommen wird

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Large Language Models (LLMs) werden auf riesigen Textdatenbanken trainiert und erwerben dort große Mengen an realem Wissen. Dieses Wissen wird in ihre Parameter eingebettet und kann dann bei Bedarf genutzt werden. Das Wissen über diese Modelle wird am Ende der Ausbildung „verdinglicht“. Am Ende des Vortrainings hört das Modell tatsächlich auf zu lernen. Richten Sie das Modell aus oder verfeinern Sie es, um zu erfahren, wie Sie dieses Wissen nutzen und natürlicher auf Benutzerfragen reagieren können. Aber manchmal reicht Modellwissen nicht aus, und obwohl das Modell über RAG auf externe Inhalte zugreifen kann, wird es als vorteilhaft angesehen, das Modell durch Feinabstimmung an neue Domänen anzupassen. Diese Feinabstimmung erfolgt mithilfe von Eingaben menschlicher Annotatoren oder anderer LLM-Kreationen, wobei das Modell auf zusätzliches Wissen aus der realen Welt trifft und dieses integriert

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Um mehr über AIGC zu erfahren, besuchen Sie bitte: 51CTOAI.x Community https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou unterscheidet sich von der traditionellen Fragendatenbank, die überall im Internet zu sehen ist erfordert einen Blick über den Tellerrand hinaus. Large Language Models (LLMs) gewinnen in den Bereichen Datenwissenschaft, generative künstliche Intelligenz (GenAI) und künstliche Intelligenz zunehmend an Bedeutung. Diese komplexen Algorithmen verbessern die menschlichen Fähigkeiten, treiben Effizienz und Innovation in vielen Branchen voran und werden zum Schlüssel für Unternehmen, um wettbewerbsfähig zu bleiben. LLM hat ein breites Anwendungsspektrum und kann in Bereichen wie der Verarbeitung natürlicher Sprache, der Textgenerierung, der Spracherkennung und Empfehlungssystemen eingesetzt werden. Durch das Lernen aus großen Datenmengen ist LLM in der Lage, Text zu generieren

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Maschinelles Lernen ist ein wichtiger Zweig der künstlichen Intelligenz, der Computern die Möglichkeit gibt, aus Daten zu lernen und ihre Fähigkeiten zu verbessern, ohne explizit programmiert zu werden. Maschinelles Lernen hat ein breites Anwendungsspektrum in verschiedenen Bereichen, von der Bilderkennung und der Verarbeitung natürlicher Sprache bis hin zu Empfehlungssystemen und Betrugserkennung, und es verändert unsere Lebensweise. Im Bereich des maschinellen Lernens gibt es viele verschiedene Methoden und Theorien, von denen die fünf einflussreichsten Methoden als „Fünf Schulen des maschinellen Lernens“ bezeichnet werden. Die fünf Hauptschulen sind die symbolische Schule, die konnektionistische Schule, die evolutionäre Schule, die Bayes'sche Schule und die Analogieschule. 1. Der Symbolismus, auch Symbolismus genannt, betont die Verwendung von Symbolen zum logischen Denken und zum Ausdruck von Wissen. Diese Denkrichtung glaubt, dass Lernen ein Prozess der umgekehrten Schlussfolgerung durch das Vorhandene ist

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

KI-Startups wechselten gemeinsam ihre Jobs zu OpenAI, und das Sicherheitsteam formierte sich neu, nachdem Ilya gegangen war!

Jun 08, 2024 pm 01:00 PM

KI-Startups wechselten gemeinsam ihre Jobs zu OpenAI, und das Sicherheitsteam formierte sich neu, nachdem Ilya gegangen war!

Jun 08, 2024 pm 01:00 PM

Letzte Woche wurde OpenAI inmitten der Welle interner Kündigungen und externer Kritik von internen und externen Problemen geplagt: - Der Verstoß gegen die Schwester der Witwe löste weltweit hitzige Diskussionen aus - Mitarbeiter, die „Overlord-Klauseln“ unterzeichneten, wurden einer nach dem anderen entlarvt – Internetnutzer listeten Ultramans „ Sieben Todsünden“ – Gerüchtebekämpfung: Laut durchgesickerten Informationen und Dokumenten, die Vox erhalten hat, war sich die leitende Führung von OpenAI, darunter Altman, dieser Eigenkapitalrückgewinnungsbestimmungen wohl bewusst und hat ihnen zugestimmt. Darüber hinaus steht OpenAI vor einem ernsten und dringenden Problem – der KI-Sicherheit. Die jüngsten Abgänge von fünf sicherheitsrelevanten Mitarbeitern, darunter zwei der prominentesten Mitarbeiter, und die Auflösung des „Super Alignment“-Teams haben die Sicherheitsprobleme von OpenAI erneut ins Rampenlicht gerückt. Das Fortune-Magazin berichtete, dass OpenA