Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Turing-Preisträger Jack Dongarra: Wie die Integration von Hochleistungsrechnen und KI das wissenschaftliche Rechnen untergraben wird

Turing-Preisträger Jack Dongarra: Wie die Integration von Hochleistungsrechnen und KI das wissenschaftliche Rechnen untergraben wird

Turing-Preisträger Jack Dongarra: Wie die Integration von Hochleistungsrechnen und KI das wissenschaftliche Rechnen untergraben wird

In den letzten drei Jahrzehnten hat das Hochleistungsrechnen (HPC) rasante Fortschritte gemacht und spielt eine wichtige Rolle im wissenschaftlichen Rechnen und anderen Bereichen. Derzeit entwickeln sich Cloud Computing und Mobile Computing allmählich zu Mainstream-Computing-Paradigmen. Gleichzeitig hat der disruptive Einfluss von KI-Methoden wie Deep Learning neue Herausforderungen und Chancen für die Integration von HPC und KI mit sich gebracht. Auf der 10. National Social Media Processing Conference (SMP 2022) stellte Turing-Award-Gewinner Jack Dongarra die wichtigsten Anwendungen und Entwicklungen des Hochleistungsrechnens der letzten Jahre vor.

Jack Dongarra, Experte für Hochleistungsrechnen, Gewinner des Turing Award 2021, Direktor des Innovative Computing Laboratory an der University of Tennessee, USA. Seine bahnbrechenden Beiträge zu numerischen Algorithmen und Bibliotheken ermöglichen es Hochleistungscomputersoftware, seit mehr als vier Jahrzehnten mit den exponentiellen Verbesserungen der Hardware Schritt zu halten. Zu seinen zahlreichen akademischen Erfolgen zählen der SIAM/ACM Computational Science and Engineering Award 2019, für den er ausgezeichnet wurde, und der IEEE Computing Pioneer Award 2020 für Führungsqualitäten bei leistungsstarker mathematischer Software. Er ist Fellow von AAAS, ACM, IEEE und SIAM, Foreign Fellow der Royal Society und Mitglied der National Academy of Engineering.

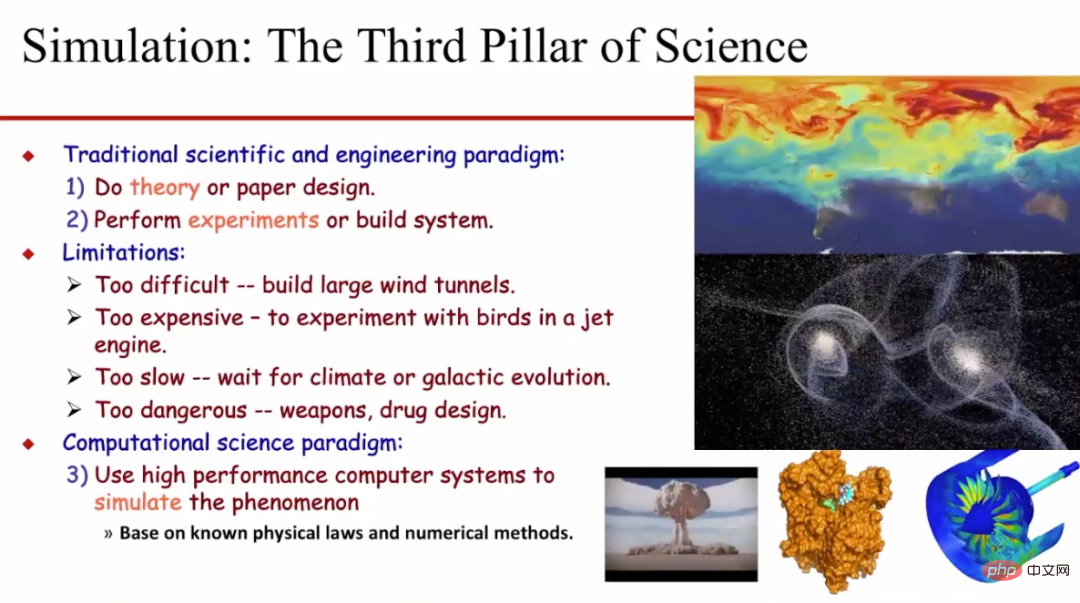

1 Hochleistungsrechnen wird häufig im „dritten Pol“ der Wissenschaft eingesetzt auch bekannt als Wissenschaft Der „dritte Pol“ der Forschung.

Historisch gesehen haben die wissenschaftliche Forschung und die technische Forschung in der Regel ein Paradigma übernommen, das auf Theorie und Experiment basiert. Diese beiden Methoden weisen jedoch viele inhärente Einschränkungen auf. Beispielsweise ist es normalerweise sehr schwierig, große Windkanäle zu bauen, die Kosten für das Testen von Flugzeugtriebwerken und Vogelkollisionen sind sehr hoch und das Warten auf die Beobachtung des Klimawandels wird sehr zeitaufwändig sein -Aufwändige und langsame Experimente mit Drogen und Waffen werden sehr gefährlich sein und so weiter. Darüber hinaus können wir bestimmte Probleme manchmal nicht experimentell untersuchen, beispielsweise die Bewegung von Galaxien untersuchen und neue Medikamente entwickeln. Daher nutzen Forscher nach und nach wissenschaftliche Rechenmethoden, um Simulationen durchzuführen und solche Probleme zu untersuchen. Diese Methode basiert in der Regel auf bekannten physikalischen Gesetzen und digitalen Berechnungsmethoden und simuliert die entsprechenden physikalischen Phänomene durch leistungsstarke Computersysteme.

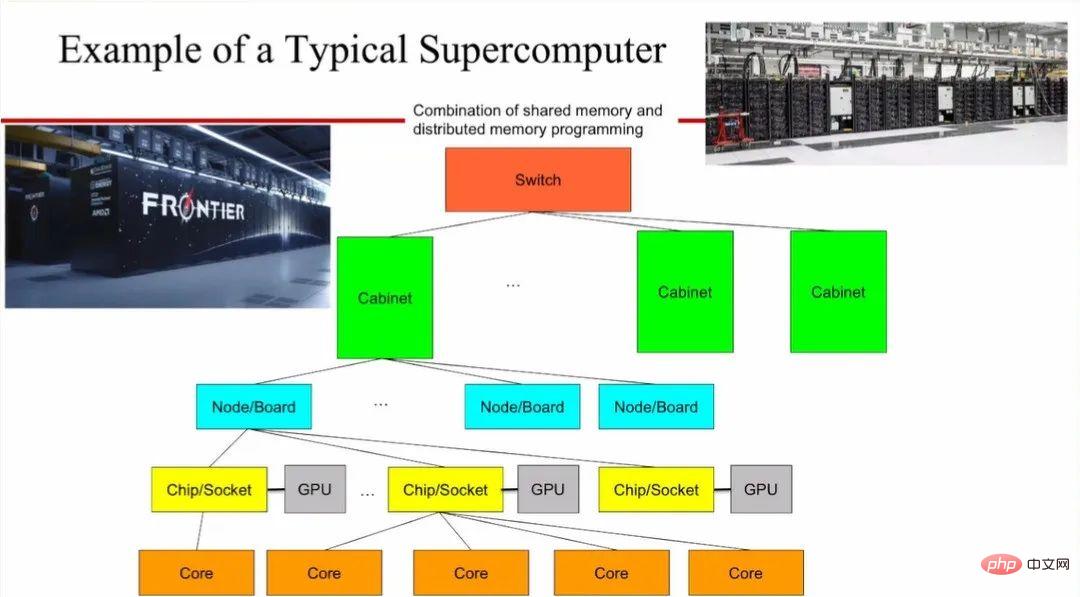

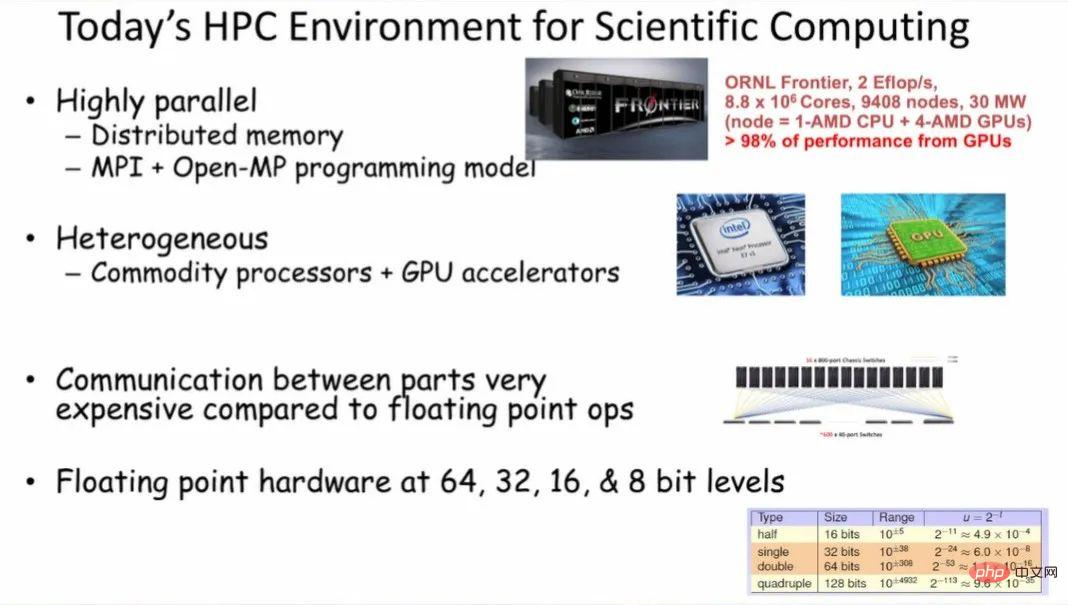

Solche Supercomputer weisen eine sehr hohe Parallelität auf und verwenden normalerweise verteilten Speicher und das Programmierparadigma „MPI+Open-MP“. Das Verschieben von Daten zwischen verschiedenen Teilen des HPC-Systems ist im Vergleich zu Gleitkommaberechnungen für die Daten sehr kostspielig. Bestehende Supercomputer unterstützen Gleitkommaberechnungen mit unterschiedlichen Genauigkeiten, einschließlich 64-, 32-, 16- und 8-Bit-Breiten.

Derzeit können die schnellsten Supercomputer Rechenleistung auf Exaflop/s-Niveau (1018) bereitstellen. Das ist ein sehr großer Wert. Wenn jeder eine Multiplikations- und Additionsrechnung in einer Sekunde durchführt, dann wird jeder auf der Welt vier Jahre brauchen, um die Berechnung durchzuführen, die ein Supercomputer in einer Sekunde durchführen kann. Gleichzeitig verursacht die Aufrechterhaltung des Betriebs eines solchen Supercomputers jedes Jahr Stromrechnungen in zweistelliger Millionenhöhe.

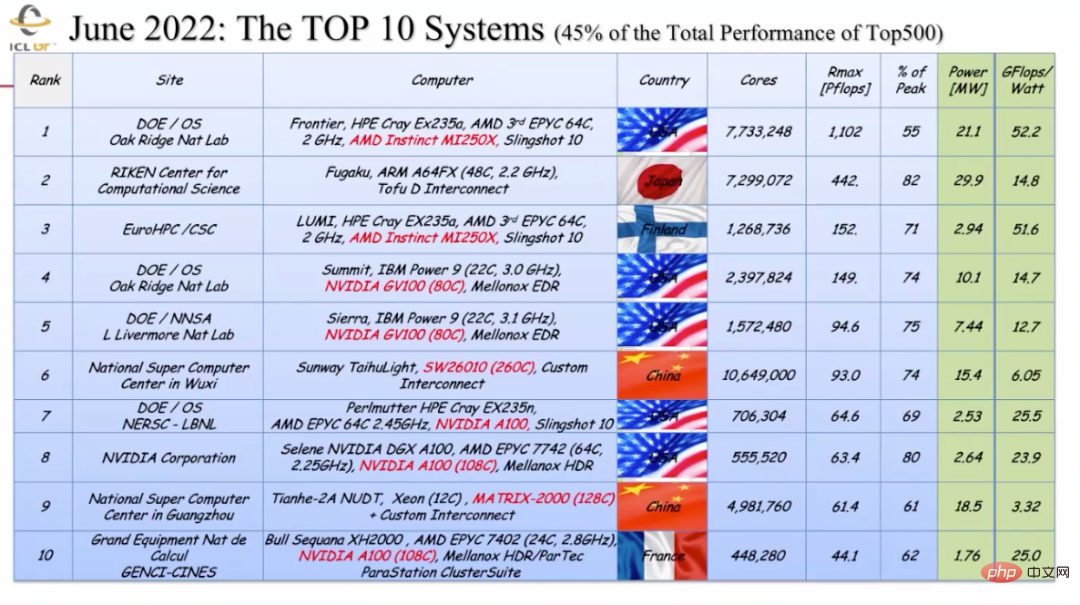

Anhand der Leistungsänderungen der TOP500-Supercomputer der Welt in den letzten dreißig Jahren können wir feststellen, dass die Leistung von Supercomputern nahezu eine exponentielle Wachstumsrate beibehalten hat. Interessanterweise ist die Leistung des heute verwendeten MacBook leistungsstärker als die des weltweit fortschrittlichsten Supercomputers von 1993, der im Los Alamos National Laboratory hergestellt wurde und hauptsächlich für die Entwicklung von Atomwaffen verwendet wurde. Daten vom Juni dieses Jahres zeigen, dass unter den zehn besten Supercomputern der Welt fünf aus den USA, zwei aus China (mit Standorten in Wuxi und Guangzhou) und die restlichen drei aus Finnland, Japan und Frankreich stammen.

3 „Harmonisches und doch unterschiedliches“ HPC und ML/KI

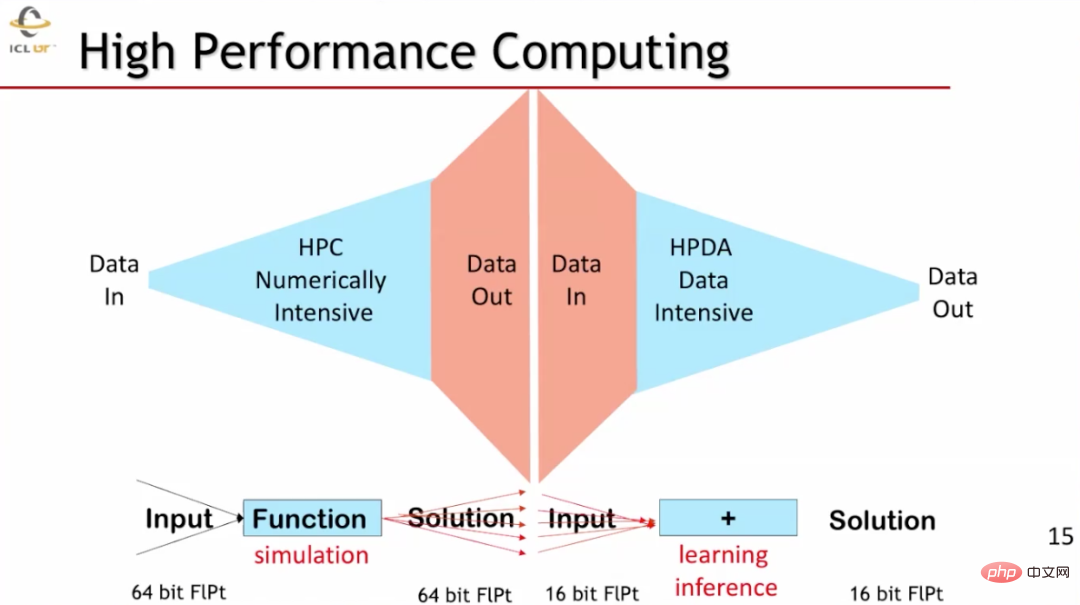

HPC und ML-Computing haben ähnliche, aber unterschiedliche Eigenschaften. HPC ist digital berechnungsintensiv. Es gibt normalerweise nur sehr begrenzte Daten ein und gibt nach einer sehr großen Anzahl digitaler Berechnungen eine große Datenmenge aus. Die Hochleistungsdatenverarbeitung (HPDA) im ML-Bereich erfordert normalerweise die Eingabe großer Datenmengen, gibt jedoch relativ kleine Datenmengen aus. Auch die von den beiden verwendete Datengenauigkeit ist sehr unterschiedlich. In Hochleistungsrechnerszenarien wie wissenschaftlichen Simulationen werden normalerweise 64-Bit-Gleitkommadaten verwendet, während in Szenarien des maschinellen Lernens 16-Bit-Gleitkommadaten verwendet werden.

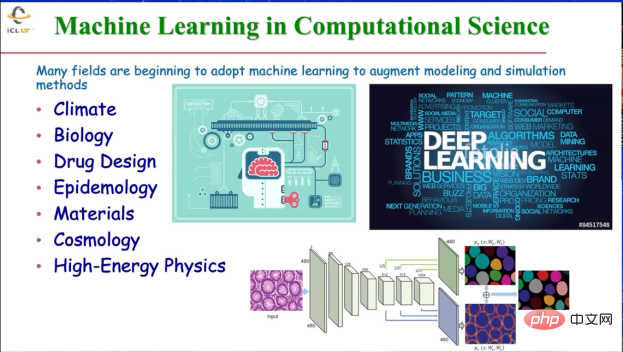

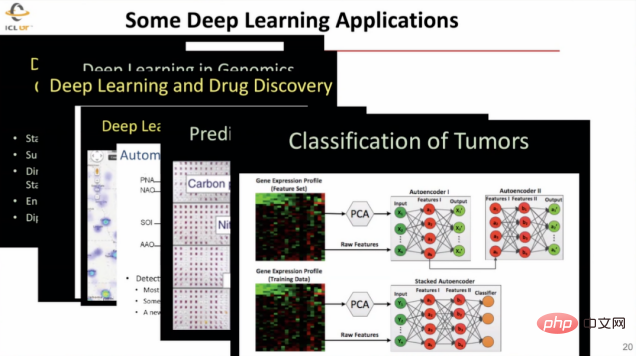

KI spielt in vielen verschiedenen Aspekten der wissenschaftlichen Forschung eine sehr wichtige Rolle: KI kann wissenschaftliche Entdeckungen in verschiedenen Bereichen unterstützen, die Leistung der Computerarchitektur verbessern und am Rande verwalten und verwalten Verarbeiten Sie große Datenmengen. Daher werden im Bereich des wissenschaftlichen Rechnens Technologien wie maschinelles Lernen auf viele Disziplinen wie Klimatologie, Biologie, Pharmazie, Epidemiologie, Materialwissenschaften, Kosmologie und sogar Hochenergiephysik angewendet, um verbesserte Modelle und fortschrittlichere Simulationsmethoden bereitzustellen. Beispielsweise wird Deep Learning eingesetzt, um die Medikamentenentwicklung zu unterstützen, Epidemien vorherzusagen und Tumore anhand medizinischer Bildgebung zu klassifizieren usw.

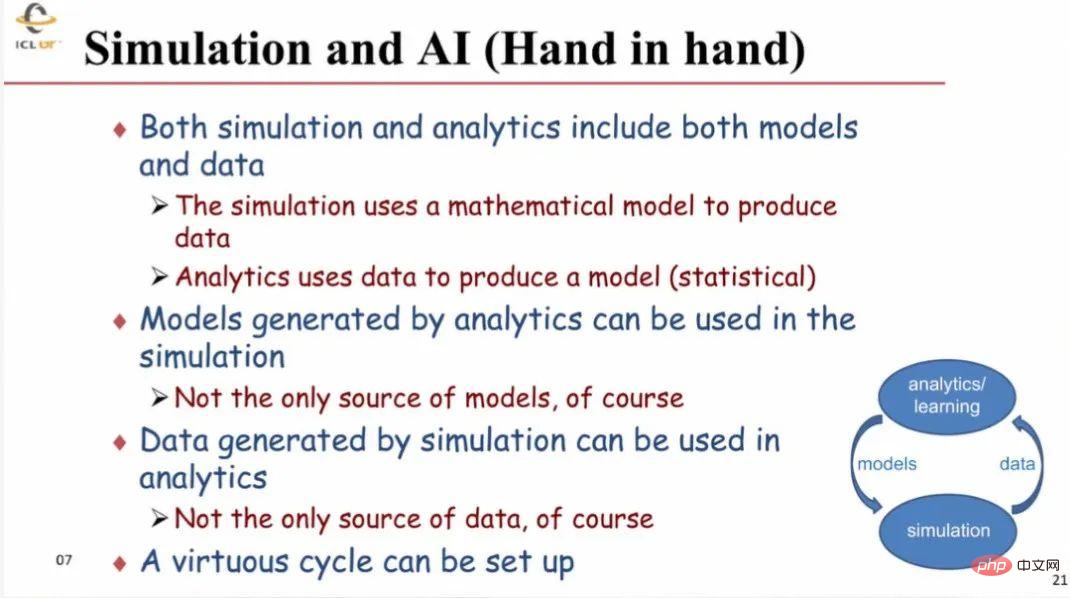

Wissenschaftliche Forschungssimulation und KI-Computing lassen sich sehr effektiv kombinieren, da beide Modelle und Daten erfordern. Typischerweise werden bei der Simulation (mathematische) Modelle zur Generierung von Daten verwendet, und bei der (KI-)Analytik werden Daten zur Generierung von Modellen verwendet. Mit analytischen Methoden gewonnene Modelle können in Simulationen zusammen mit anderen Modellen verwendet werden; durch Simulationen generierte Daten können zusammen mit Daten aus anderen Quellen in der Analyse verwendet werden. Dies bildet einen positiven Kreislauf der gegenseitigen Förderung.

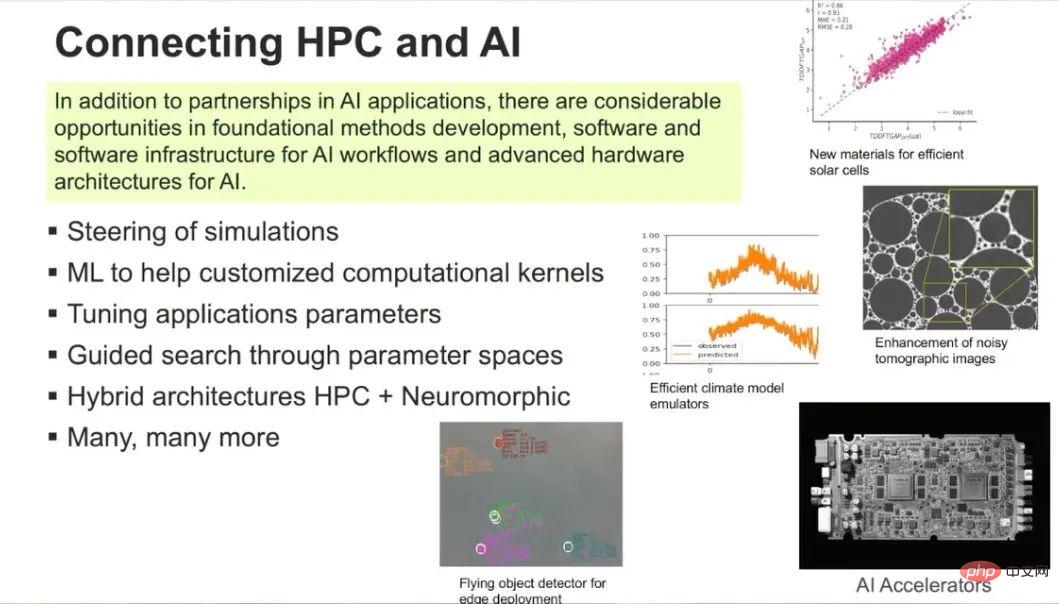

HPC und KI ergänzen sich nicht nur in spezifischen Anwendungsfeldern, sondern haben auch zahlreiche Verbindungen in den Bereichen grundlegende Entwicklungsmethoden, Software und Software-Infrastruktur sowie KI-Hardwarearchitektur. Gleichzeitig sind die beiden stärker miteinander verbunden. Beispielsweise kann KI zur Steuerung von Simulationen, zur schnelleren Anpassung von Parametern von Simulationsanwendungen, zur Bereitstellung benutzerdefinierter Computerkernfunktionen und zur Kombination von Inhalten aus traditionellem HPC und neuromorphem Computing verwendet werden. AI&ML hat einen disruptiven Einfluss, wie oft gesagt wird: „AL&ML wird Wissenschaftler nicht ersetzen, aber Wissenschaftler, die AI&ML-Tools nutzen, werden diejenigen ersetzen, die diese Tools nicht nutzen.“

4 Der Blick in die Zukunft: HPC-Systeme werden individueller

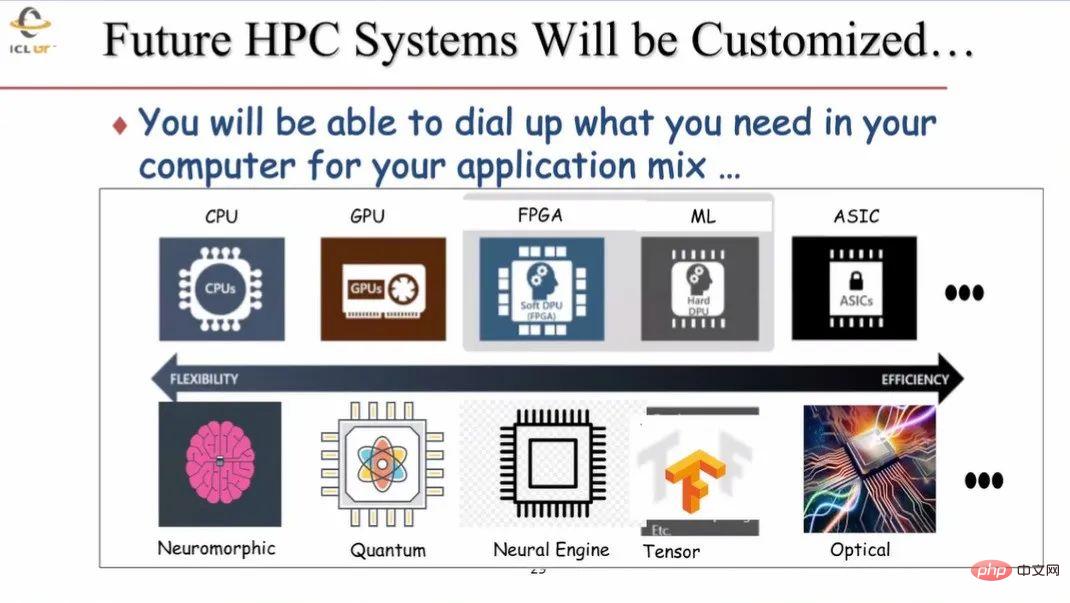

Zukünftige HPC-Systeme werden anpassbar sein. Derzeit verfügt HPC hauptsächlich über zwei Arten von Prozessoren: CPU und GPU. In Zukunft werden weitere verschiedene Einheiten verwendet, wie z. B. FPGA, ML-Beschleuniger, ASIC-Chip usw. Zu HPC-Rechnersystemen werden immer mehr Prozessoren hinzugefügt, die unterschiedliche Strukturen und Paradigmen verwenden, beispielsweise neuromorphe Verarbeitung, Quanteninformatik und optisches Rechnen, die möglicherweise eine immer wichtigere Rolle spielen. Beim Aufbau neuer HPC-Systeme können die entsprechenden Module und Funktionen je nach Bedarf genutzt werden.

5 Zusammenfassung

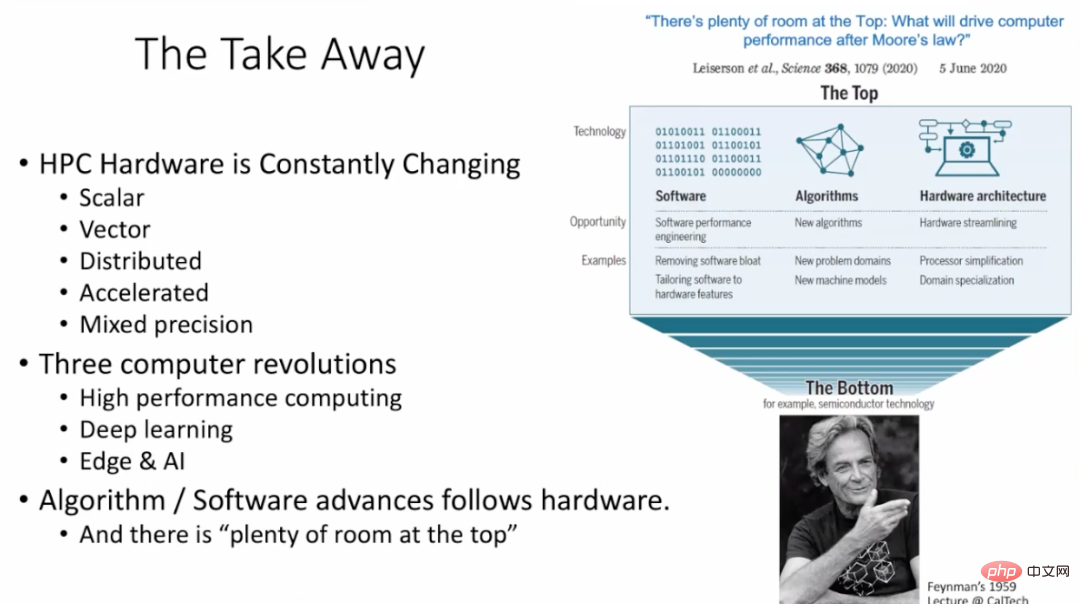

HPC-Hardware entwickelt sich ständig weiter, einschließlich Skalar-Rechenmaschinen, Vektor-Rechenmaschinen und verteilt Systeme, Beschleuniger, Rechenmaschinen mit gemischter Präzision und mehr. Im Computerbereich finden derzeit drei große Veränderungen statt: Hochleistungsrechnen, Deep Learning sowie Edge Computing und künstliche Intelligenz. Algorithmen und Software sollten sich mit der Hardware weiterentwickeln. Wie in der Arbeit von Leiserson et al. dargelegt, gibt es nach dem Mooreschen Gesetz noch viel Spielraum, um die ultimative Leistung von HPC-Systemen durch Algorithmen, Software und Hardwarearchitektur zu verbessern.

6 Q&A

#🎜 🎜#Frage 1: Derzeit widmen Industrie und Wissenschaft dem Training großer neuronaler Netzwerkmodelle mehr Aufmerksamkeit. Beispielsweise verfügt GPT3 über mehr als 170 Milliarden Parameter, was normalerweise Hunderte von Hochleistungs-GPUs erfordert um 1 bis 3 Modelle zu trainieren. Werden in Zukunft Hochleistungscomputer eingesetzt, um entsprechende Schulungen in wenigen Tagen oder Stunden zu absolvieren?

Antwort 1: Die GPU bietet Computern leistungsstarke numerische Berechnungsfunktionen. Beispielsweise stammen 98 % der Rechenleistung in Supercomputern von GPUs. Und das Verschieben von Daten zwischen CPU und GPU ist sehr zeitaufwändig. Um kostspielige Datenbewegungen zu reduzieren, können GPU und CPU mithilfe von Chipdesignmethoden wie Chiplets oder praktischeren Implementierungspfaden näher aneinander gebracht werden. Darüber hinaus wird die Methode der direkten Annäherung der Daten und der entsprechenden Verarbeitungseinheiten auch sehr hilfreich sein, um das Problem der hohen Datentransportkosten zu lösen.

Frage 2: Wir haben ein Phänomen beobachtet, dass sich viele aktuelle Machine-Learning-Algorithmen zusammen mit der Hardware weiterentwickeln und sich gegenseitig beeinflussen können. Beispielsweise haben Nvidia und andere Unternehmen speziell eine dedizierte Architektur für das Transformer-Modell entwickelt, das derzeit die beste Leistung im ML-Bereich aufweist, wodurch der Transformer einfacher zu verwenden ist. Haben Sie ein solches Phänomen beobachtet und wie würden Sie es dazu kommentieren?

Antwort 2: Dies ist ein sehr gutes Beispiel dafür, wie sich Hardware-Design und andere Aspekte gegenseitig verstärken. Derzeit achten viele Hardwareforscher genau auf Veränderungen in der Branche und beurteilen Trends. Das gemeinsame Entwerfen von Anwendungen mit Hardware kann die Leistung erheblich verbessern und mehr Hardware verkaufen. Ich stimme dieser Aussage zu, dass sich Algorithmen und Hardware gemeinsam weiterentwickeln.

Frage 3: Sie haben darauf hingewiesen, dass die Zukunft des Hochleistungsrechnens ein heterogener Hybrid sein wird. Die Integration dieser Teile stellt ein sehr schwieriges Problem dar und kann sogar zu Leistungseinbußen führen. Wenn wir nur die GPU verwenden, kann dies zu einer besseren Leistung führen. Was denken Sie?

Antwort 3: Derzeit sind CPU und GPU in Hochleistungscomputern sehr lose miteinander gekoppelt, und Daten müssen von der CPU zur übertragen werden die GPU berechnen. Auch in Zukunft wird sich der Trend zur Kopplung über unterschiedliche Hardware fortsetzen. Beispielsweise kann die Verwendung spezieller Hardware für ML-Berechnungen die GPU weiter verbessern. Durch das Laden von ML-bezogenen Algorithmen auf den entsprechenden Beschleuniger werden die Details des Algorithmus auf dem Beschleuniger ausgeführt und die Berechnungsergebnisse an den entsprechenden Prozessor übertragen. Zukünftig können auch steckbare Quantenbeschleuniger implementiert werden, um entsprechende Quantenalgorithmen usw. auszuführen.

Frage 4: HPC ist sehr teuer, insbesondere für Forscher und kleine und mittlere Unternehmen. Gibt es Methoden wie Cloud Computing, die HPC für Lehrende, Studierende und forschende kleine und mittlere Unternehmen erschwinglich machen können?

Antwort 4: In den Vereinigten Staaten erfordert die Verwendung von HPC die Einreichung eines entsprechenden Antrags bei der zuständigen Abteilung, in dem das untersuchte Problem und der Berechnungsaufwand beschrieben werden erforderlich. Im Falle einer Genehmigung besteht kein Grund zur Sorge über die Kosten der HPC-Nutzung. In den USA wurde eine Studie darüber durchgeführt, ob alle HPC-Systeme auf cloudbasierte Systeme umgestellt werden sollten. Die Ergebnisse zeigen, dass cloudbasierte Lösungen 2-3 Mal teurer sind als die direkte Nutzung von HPC-Systemen. Es ist wichtig, die wirtschaftliche Annahme dahinter zu beachten: HPC wird von genügend Menschen genutzt, und die zu lösenden Probleme erfordern manchmal die Nutzung des gesamten HPC-Systems. In diesem Fall ist ein dedizierter HPC besser als der Kauf von Cloud-Diensten. Dies ist die aktuelle Situation, die in den Vereinigten Staaten und Europa beobachtet wird.

Das obige ist der detaillierte Inhalt vonTuring-Preisträger Jack Dongarra: Wie die Integration von Hochleistungsrechnen und KI das wissenschaftliche Rechnen untergraben wird. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

SQllimit -Klausel: Steuern Sie die Anzahl der Zeilen in Abfrageergebnissen. Die Grenzklausel in SQL wird verwendet, um die Anzahl der von der Abfrage zurückgegebenen Zeilen zu begrenzen. Dies ist sehr nützlich, wenn große Datensätze, paginierte Anzeigen und Testdaten verarbeitet werden und die Abfrageeffizienz effektiv verbessern können. Grundlegende Syntax der Syntax: SelectColumn1, Spalte2, ... Fromtable_Namelimitnumber_of_rows; number_of_rows: Geben Sie die Anzahl der zurückgegebenen Zeilen an. Syntax mit Offset: SelectColumn1, Spalte2, ... Fromtable_NamelimitOffset, Number_of_rows; Offset: Skip überspringen

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Die MySQL-Datenbankleistung Optimierungshandbuch In ressourcenintensiven Anwendungen spielt die MySQL-Datenbank eine entscheidende Rolle und ist für die Verwaltung massiver Transaktionen verantwortlich. Mit der Erweiterung der Anwendung werden jedoch die Datenbankleistung Engpässe häufig zu einer Einschränkung. In diesem Artikel werden eine Reihe effektiver Strategien zur Leistungsoptimierung von MySQL -Leistung untersucht, um sicherzustellen, dass Ihre Anwendung unter hohen Lasten effizient und reaktionsschnell bleibt. Wir werden tatsächliche Fälle kombinieren, um eingehende Schlüsseltechnologien wie Indexierung, Abfrageoptimierung, Datenbankdesign und Caching zu erklären. 1. Das Design der Datenbankarchitektur und die optimierte Datenbankarchitektur sind der Eckpfeiler der MySQL -Leistungsoptimierung. Hier sind einige Kernprinzipien: Die Auswahl des richtigen Datentyps und die Auswahl des kleinsten Datentyps, der den Anforderungen entspricht, kann nicht nur Speicherplatz speichern, sondern auch die Datenverarbeitungsgeschwindigkeit verbessern.

Überwachen Sie MySQL und Mariadb -Tröpfchen mit Prometheus Mysql Exporteur

Apr 08, 2025 pm 02:42 PM

Überwachen Sie MySQL und Mariadb -Tröpfchen mit Prometheus Mysql Exporteur

Apr 08, 2025 pm 02:42 PM

Eine effektive Überwachung von MySQL- und MariADB -Datenbanken ist entscheidend für die Aufrechterhaltung einer optimalen Leistung, die Identifizierung potenzieller Engpässe und die Gewährleistung der Zuverlässigkeit des Gesamtsystems. Prometheus MySQL Exporteur ist ein leistungsstarkes Tool, das detaillierte Einblicke in Datenbankmetriken bietet, die für die proaktive Verwaltung und Fehlerbehebung von entscheidender Bedeutung sind.

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der MySQL -Primärschlüssel kann nicht leer sein, da der Primärschlüssel ein Schlüsselattribut ist, das jede Zeile in der Datenbank eindeutig identifiziert. Wenn der Primärschlüssel leer sein kann, kann der Datensatz nicht eindeutig identifiziert werden, was zu Datenverwirrung führt. Wenn Sie selbstsinkrementelle Ganzzahlsspalten oder UUIDs als Primärschlüssel verwenden, sollten Sie Faktoren wie Effizienz und Raumbelegung berücksichtigen und eine geeignete Lösung auswählen.

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Es ist unmöglich, das MongoDB -Passwort direkt über Navicat anzuzeigen, da es als Hash -Werte gespeichert ist. So rufen Sie verlorene Passwörter ab: 1. Passwörter zurücksetzen; 2. Überprüfen Sie die Konfigurationsdateien (können Hash -Werte enthalten). 3. Überprüfen Sie Codes (May Hardcode -Passwörter).

Beherrschen Sie die Reihenfolge nach Klausel in SQL: Daten effektiv sortieren

Apr 08, 2025 pm 07:03 PM

Beherrschen Sie die Reihenfolge nach Klausel in SQL: Daten effektiv sortieren

Apr 08, 2025 pm 07:03 PM

Detaillierte Erläuterung der SQLORDSBY -Klausel: Die effiziente Sortierung der Datenreihenfolge -Klausel ist eine Schlüsselanweisung in SQL, die zur Sortierung von Abfrageergebnissen verwendet wird. Es kann in einzelnen Spalten oder mehreren Spalten in den Aufstieg (ASC) oder absteigender Reihenfolge (Desc) angeordnet werden, wodurch die Datenlesbarkeit und die Effizienz der Datenverwaltung erheblich verbessert werden. OrderBy syntax SelectColumn1, Spalte2, ... fromTable_NameOrDByColumn_Name [ASC | Desc]; Column_Name: Sortieren nach Spalte. ASC: Ascending Order Sort (Standard). Desc: Sortieren Sie in absteigender Reihenfolge. OrderBy Hauptmerkmale: Multi-Sortier-Sortierung: Unterstützt mehrere Spaltensortierungen, und die Reihenfolge der Spalten bestimmt die Priorität der Sortierung. seit