Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Timing-Analyse Pentagon-Krieger! Die Tsinghua-Universität schlägt TimesNet vor: führend in der Vorhersage, Füllung, Klassifizierung und Erkennung

Timing-Analyse Pentagon-Krieger! Die Tsinghua-Universität schlägt TimesNet vor: führend in der Vorhersage, Füllung, Klassifizierung und Erkennung

Timing-Analyse Pentagon-Krieger! Die Tsinghua-Universität schlägt TimesNet vor: führend in der Vorhersage, Füllung, Klassifizierung und Erkennung

Das Erreichen der Aufgabenuniversalität ist ein Kernthema bei der Erforschung grundlegender Deep-Learning-Modelle und auch eines der Hauptanliegen in der jüngsten Richtung großer Modelle.

Allerdings gibt es im Zeitreihenbereich verschiedene Arten von Analyseaufgaben, die eine feinkörnige Modellierung und semantische Informationen auf hoher Ebene erfordern Klassifizierungsaufgaben. So erstellen Sie ein einheitliches, tiefes Grundmodell, um verschiedene Timing-Analyseaufgaben effizient durchzuführen.Es gab bisher keinen etablierten Plan.

Zu diesem Zweck führte ein Team der School of Software der Tsinghua-Universität Untersuchungen zum grundlegenden Problem der Modellierung von Zeitänderungen durch und schlug TimesNet vor, ein grundlegendes aufgabenübergreifendes Timing Das Papier wurde vom ICLR 2023 angenommen.

Autorenliste: Wu Haixu*, Hu Tenge* , Liu雍*, Zhou Hang, Wang Jianmin, Long Mingsheng

Link: https://openreview.net/pdf?id =ju_Uqw384Oq#🎜 🎜#

Code: https://github.com/thuml/TimesNet#🎜🎜 ##🎜🎜 #

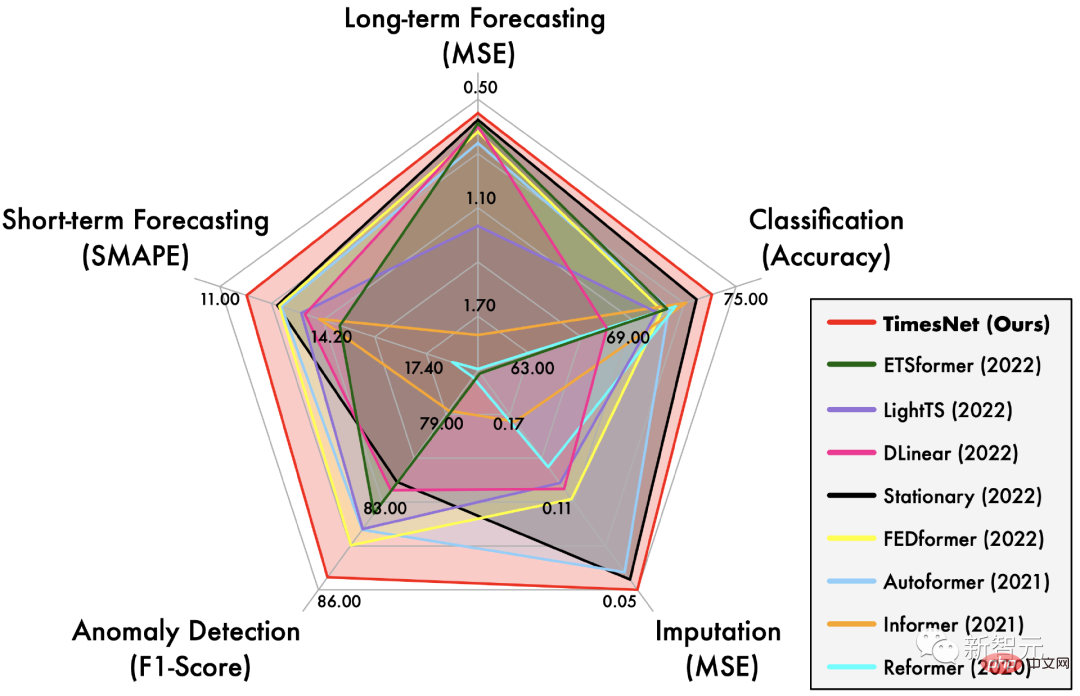

Zeitreihenalgorithmus-Bibliothek: https://github.com/thuml/Time-Series-Library# 🎜🎜#TimesNet at It hat eine umfassende Führungsrolle bei den fünf Hauptaufgaben der langfristigen und kurzfristigen Vorhersage, dem Auffüllen fehlender Werte, der Erkennung von Anomalien und der Klassifizierung übernommen.

1 Problemanalyse

Daher Die Modellierung von Timing-Änderungen ist ein gemeinsames Kernthema für alle Arten von Timing-Analyseaufgaben.

In den letzten Jahren wurden verschiedene Tiefenmodelle häufig in Timing-Analyseaufgaben eingesetzt, wie z. B. rekurrente neuronale Netze (RNN) und zeitliche Faltungsnetze (TCN). ) und Transformatornetzwerk (Transformer).

Die ersten beiden Arten von Methoden konzentrieren sich jedoch hauptsächlich auf die Erfassung von Änderungen zwischen nahegelegenen Momenten und verfügen über unzureichende Modellierungsmöglichkeiten für langfristige Abhängigkeiten.

Obwohl Transformer einen natürlichen Vorteil bei der Modellierung langfristiger Abhängigkeiten hat, ist es aufgrund der äußerst komplexen zeitlichen Änderungen in der realen Welt nur auf die Aufmerksamkeit zwischen diskreten Zeitpunkten angewiesen (Achtung) Es ist schwierig, zuverlässige Timing-Abhängigkeiten zu ermitteln.

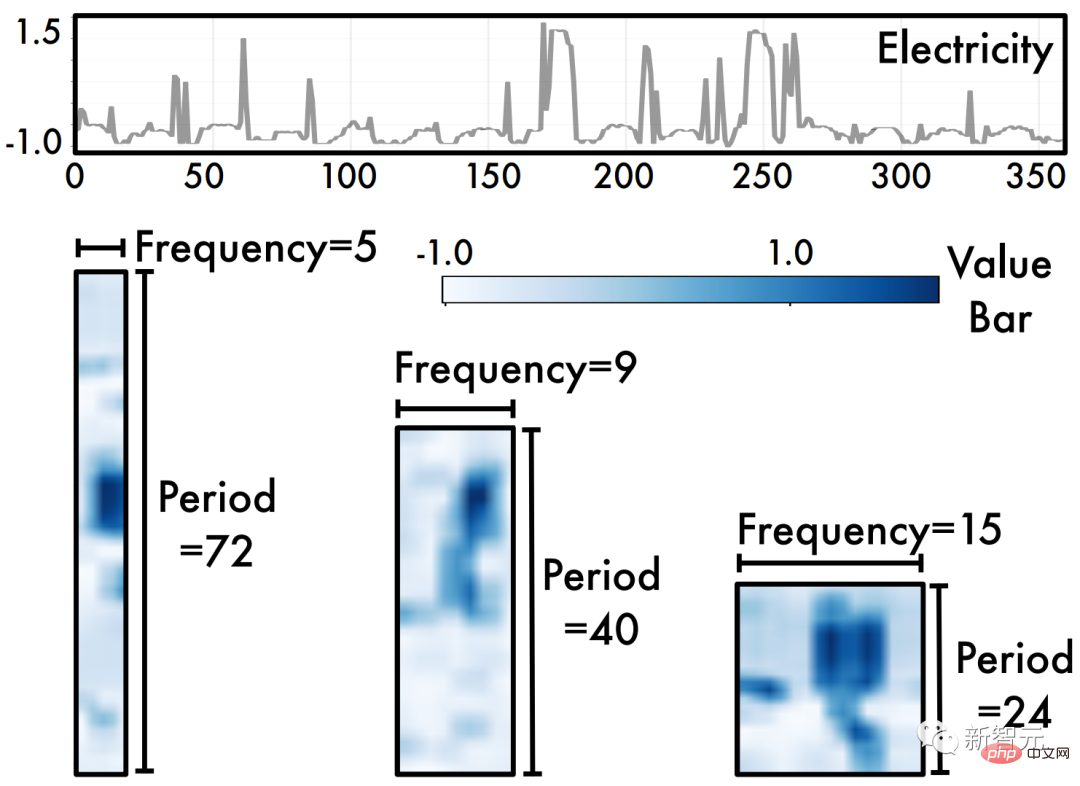

Zu diesem Zweck analysiert dieser Artikel Timing-Änderungen aus einer neuen Multiperiodizitätsperspektive, wie in der folgenden Abbildung dargestellt. Wir beobachten, dass:

Zeitreihen sind von Natur aus

- mehrperiodisch #🎜🎜 #. Zeitreihendaten in der realen Welt sind oft die Überlagerung verschiedener periodischer Prozesse, beispielsweise ändern sich Verkehrsdaten kurzfristig , während sich langfristig wöchentlich ändert. Diese Daten verschiedener Zeiträume überlappen und stören sich gegenseitig, was die Zeitreihenanalyse vor große Herausforderungen stellt.

Zeitreihendarstellung

- Zwei zeitliche Änderungen innerhalb des Zyklus und zwischen den Zyklen

- # 🎜 🎜#. Insbesondere für den Prozess eines bestimmten Zyklus bezieht sich die Änderung zu jedem Zeitpunkt nicht nur auf den angrenzenden Moment, sondern auch auf ähnliche Prozesse im angrenzenden Zyklus Sehr relevant. Dabei entsprechen Veränderungen innerhalb eines Zyklus kurzfristigen Prozessen, während Veränderungen zwischen einem Zyklus langfristige Trends in aufeinanderfolgenden Zyklen widerspiegeln können. Hinweis: Wenn die Zeitreihe keine offensichtliche Periodizität aufweist, entspricht dies einer Situation, in der die Periode unendlich lang ist. 2 Design-Ideen

Basierend auf den beiden oben genannten Beobachtungen haben wir die Struktur von TimesNet wie folgt entworfen: #🎜 🎜 #Die

- Multiperiodizität von Zeitreihen inspirierte natürlich eine modulare Designidee, das heißt, ein Modul erfasst die Zeitreihenänderungen, die von einem bestimmten Zeitraum dominiert werden. Diese modulare Designidee kann komplexe Zeitänderungen entkoppeln, was für die spätere Modellierung von Vorteil ist. Für die

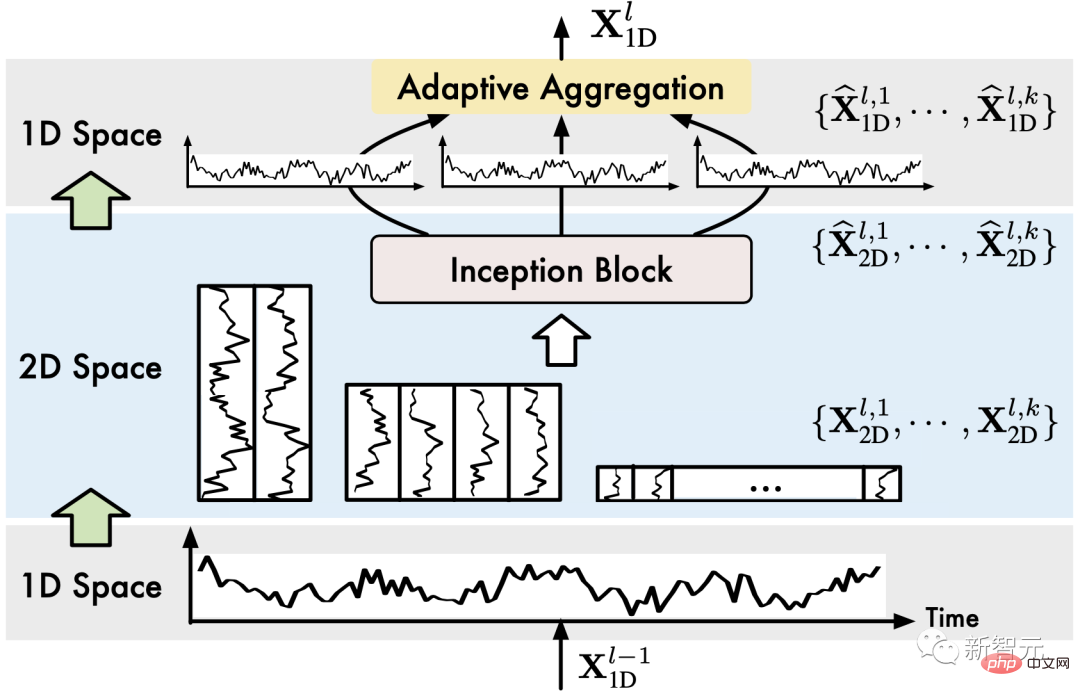

- Änderungen innerhalb und zwischen Zyklen von Zeitreihen schlägt dieser Artikel auf innovative Weise vor, eindimensionale Zeitreihendaten zur Analyse auf einen zweidimensionalen Raum zu erweitern. Wie in der Abbildung oben gezeigt, können durch Falten einer eindimensionalen Zeitreihe basierend auf mehreren Zyklen mehrere zweidimensionale Tensoren (2D-Tensoren) erhalten werden. Die Spalten und Zeilen jedes zweidimensionalen Tensors spiegeln die Zeitreihe innerhalb des Zyklus wider und zwischen den Zyklen Änderungen, das heißt, wir erhalten Zeitliche 2D-Variationen.

Daher können wir nach dem Falten der Zeitreihendaten direkt das erweiterte

Visual Backbone Networkverwenden, um eine Merkmalsextraktion der Zeitreihendaten durchzuführen, wie z. B. Swin Transformer, ResNeXt, ConvNeXt usw. Dieses Design ermöglicht es auch, Timing-Analyseaufgaben direkt vom boomenden Computer-Vision-Bereich zu profitieren. 3 TimesNet

Basierend auf den oben genannten Ideen haben wir das TimesNet-Modell vorgeschlagen, das komplexe Zeitreihenänderungen durch eine modulare Struktur in verschiedene Zyklen zerlegt und eine zyklusinterne und einheitliche Modellierung der Variation von Woche zu Woche realisiert

.In diesem Abschnitt stellen wir zunächst die Methode zur Erweiterung von Zeitreihendaten auf den zweidimensionalen Raum vor und stellen dann die Gesamtarchitektur des Modells vor. 3.1 Timing-Änderungen: 1D->2D

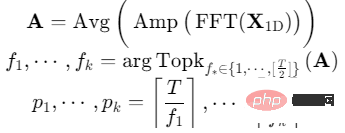

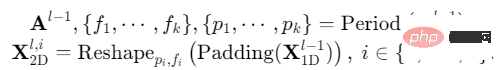

Für eine eindimensionale Zeitreihe mit einer Zeitlänge von und einer Kanaldimension von können die Periodeninformationen direkt durch die schnelle Fourier-Transformation (FFT) der Zeitdimension extrahiert werden, das heißt:

wobei, die Intensität jeder Frequenzkomponente in darstellt, wobei die Frequenz mit der größten Intensität der signifikantesten Periodenlänge entspricht.

(2) Sequenzfaltung 1D->2D

Für ausgewählte Zeiträume wird die ursprüngliche eindimensionale Zeitreihe entsprechend gefaltet:

Unter anderem macht das Auffüllen von 0 am Ende der Sequenz die Sequenzlänge teilbar.

Durch die obigen Operationen erhalten wir einen Satz zweidimensionaler Tensoren, die zweidimensionalen Zeitreihenänderungen mit einer Periode von entsprechen. 3.2 Modelldesign

Die Gesamtarchitektur von TimesNet ist in der Abbildung dargestellt:

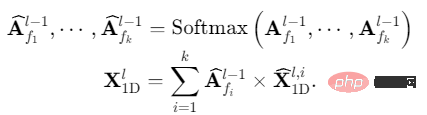

Insgesamt besteht TimesNet aus gestapelten TimesBlocks. Die Eingabesequenz durchläuft zunächst die Einbettungsschicht, um tiefe Merkmale zu erhalten. Für den TimesBlock der dritten Schicht lautet seine Eingabe und seine Ausgabe:

Konkret enthält jeder TimesBlock, wie in der folgenden Abbildung dargestellt, die folgenden Unterprozesse:

(1) Faltende Zeitreihe (1D->2D) : TimesBlock Zuerst extrahieren die eingegebenen eindimensionalen Zeitreihenfunktionen den Zyklus und konvertieren ihn dann in zweidimensionale Zeitreihenänderungen, was im vorherigen Abschnitt behandelt wurde:

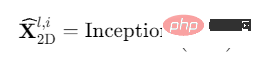

(2) Zweidimensional extrahieren Zeitreihenänderungsdarstellung (2D-Darstellung) : Wie zuvor analysiert, weisen die konvertierten zweidimensionalen Zeitreihenänderungen eine 2D-Lokalität auf, sodass die 2D-Faltung direkt zum Extrahieren von Merkmalen verwendet werden kann. Hier haben wir uns für das klassische Inception-Modell entschieden, nämlich:

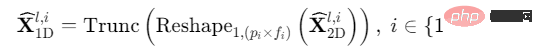

Da wir 1D-Zeitmerkmale in 2D-Raum konvertiert haben, ist es erwähnenswert, dass wir auch viele hochmoderne Modelle im Computerbereich nutzen können Vision, zum Beispiel ResNeXt, ConvNeXt, Attention-based Swin Transformer usw. Dadurch kann die Zeitreihenanalyse Hand in Hand mit dem visuellen Backbone-Netzwerk arbeiten. ⋅ Entfernen Sie die 0, die durch die Padding(⋅)-Operation in Schritt (1) hinzugefügt wurde.

(4) Adaptive Fusion (1D-Aggregation): Um mehrperiodige Informationen zu fusionieren, führen wir eine gewichtete Summierung der extrahierten zweidimensionalen Zeitreihendarstellungen durch und das ausgewählte Summationsgewicht wird in Schritt ( 1) Die entsprechende Frequenzintensität:

Durch die Konvertierung von 1D-Zeitreihen in ein 2D-Raumdesign realisiert TimesNet die Zeitreihenänderungskonstruktion „mehrerer Perioden, um zweidimensionale Zeitreihenänderungen separat zu extrahieren und dann Führen Sie den Formprozess „Adaptive Fusion“ durch.

4 Experimente

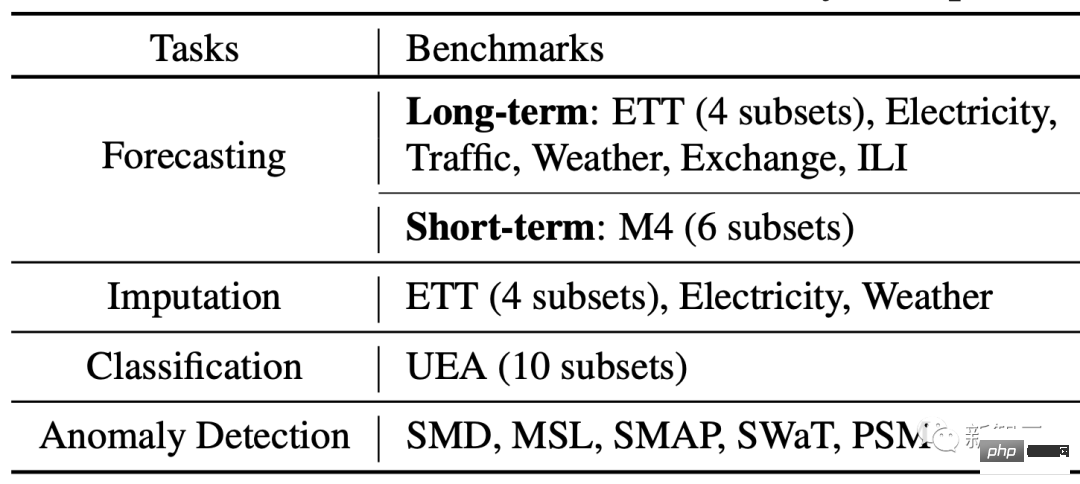

Wir führten Experimente zu fünf Hauptaufgaben durch: Langzeitvorhersage, Kurzzeitvorhersage, Füllen fehlender Werte, Anomalieerkennung und Klassifizierung, wobei wir 36 Datensätze und 81 verschiedene experimentelle Einstellungen abdeckten.

Gleichzeitig wurden 19 verschiedene Tiefenmethoden verglichen, darunter die neuesten Modelle auf Basis von RNN, CNN, MLP und Transformer, wie N-BEATS (2019), Autoformer (2021), LSSL (2022), N-Hits (2022), FEDformer (2022), Dlinear (2023) usw.

4.1 Gesamtergebnisse

Wie im ersten Radardiagramm gezeigt, hat TimesNet bei allen fünf Aufgaben SOTA erreicht.

(1) Langfristige Vorhersage: Bei dieser hochkarätigen Aufgabe übertrifft TimesNet die neuesten Transformer- und MLP-basierten Modelle.

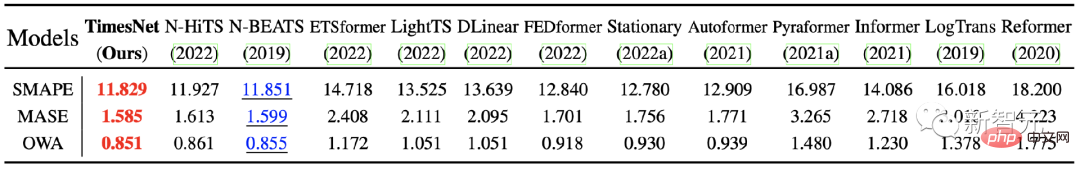

(2) Kurzfristige Vorhersage: Der in diesem Experiment verwendete M4-Datensatz enthält 6 Unterdatensätze mit unterschiedlichen Abtastfrequenzen mit insgesamt mehr als 100.000 Daten. TimesNet erzielte in dieser komplexen Datenverteilungssituation immer noch optimale Ergebnisse und bestätigte die Modellierungsfähigkeiten des Modells für zeitliche Änderungen.

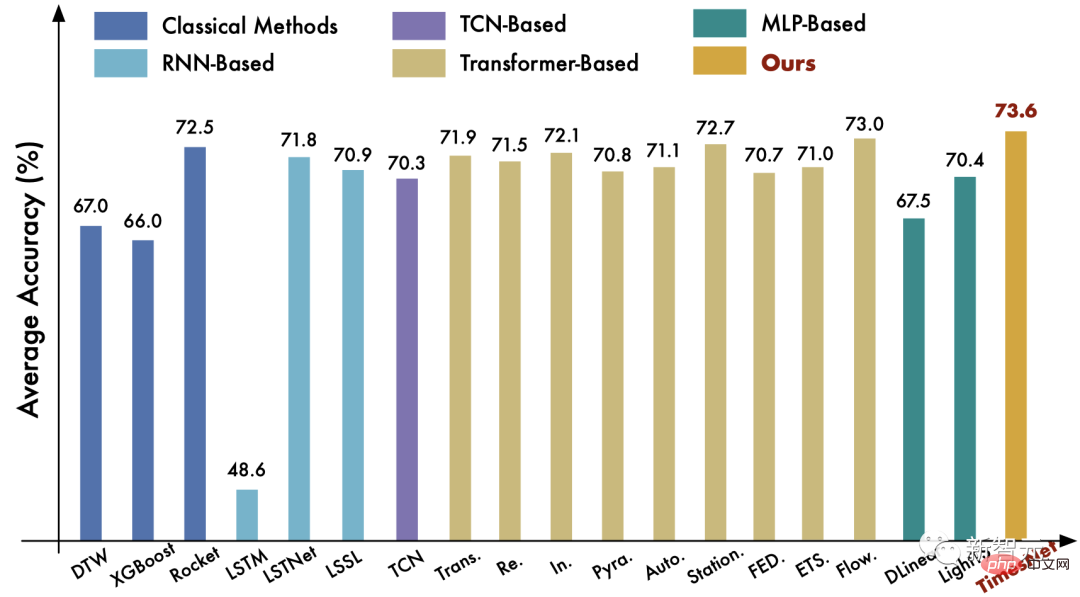

(3) Klassifizierungsaufgabe : Bei dieser Aufgabe hat TimesNet den klassischen Rocket-Algorithmus und das hochmoderne Deep-Learning-Modell Flowformer übertroffen.

Weitere Aufgabenvergleiche finden Sie im Papier.

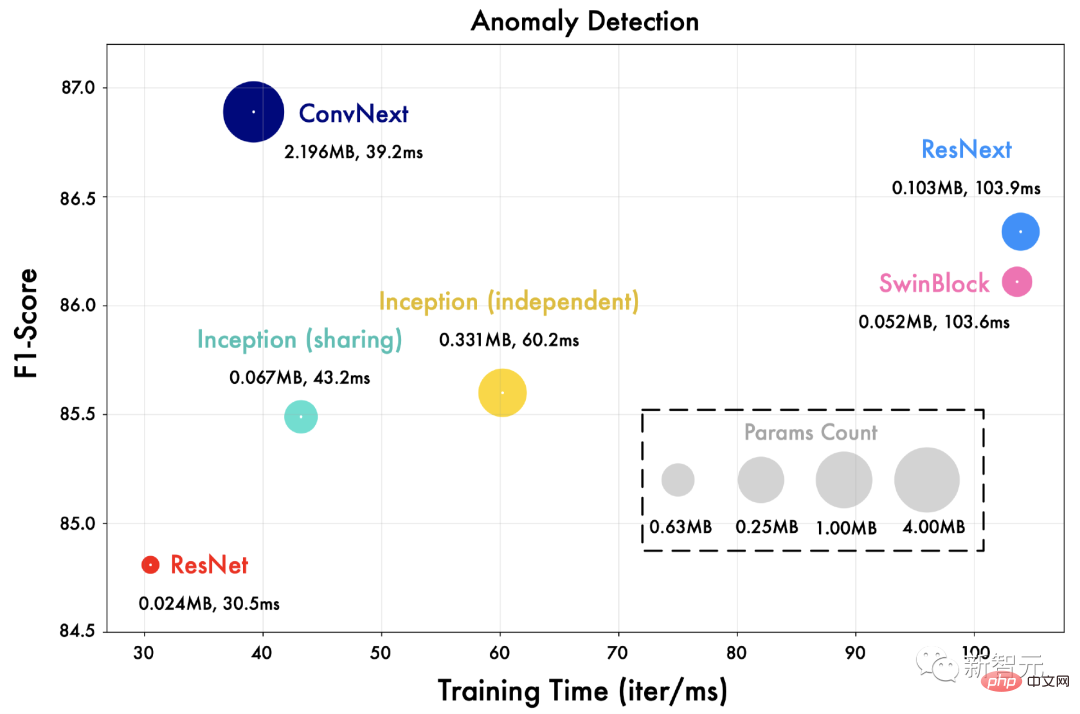

4.2 Verallgemeinerung des visuellen Backbone-Netzwerks

Wir ersetzen das Inception-Netzwerk in TimesNet durch verschiedene visuelle Backbone-Netzwerke wie ResNet, ConvNext, Swin Transformer usw.

Wie in der Abbildung unten gezeigt, kann ein fortschrittlicheres visuelles Backbone-Netzwerk bessere Ergebnisse bringen. Dies bedeutet auch, dass die Zeitreihenanalyse im Rahmen von TimesNet direkt von Fortschritten im Bereich der visuellen Backbone-Netzwerke profitieren kann.

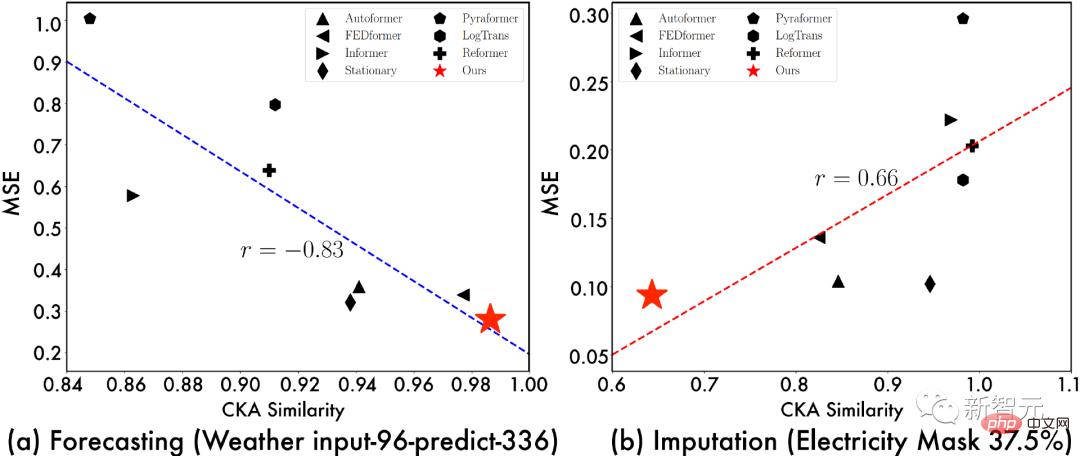

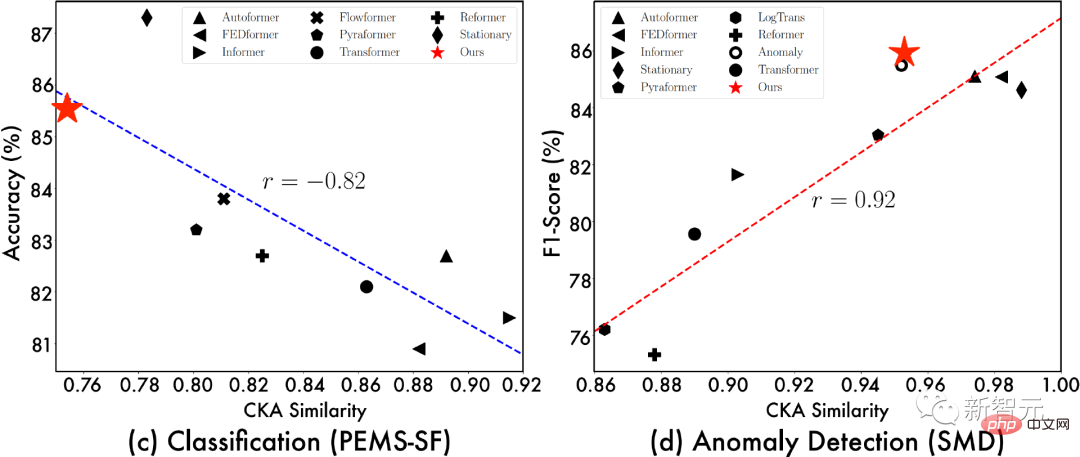

4.3 Darstellungsanalyse

Um die Quelle des TimesNet-Effekts weiter zu untersuchen, zeigen wir die Beziehung zwischen „CKA-Ähnlichkeit zwischen der unteren Schicht des Modells und der Darstellung der oberen Schicht“ und „Modelleffekt“. Je geringer die CKA-Ähnlichkeit ist, desto größer ist der Darstellungsunterschied zwischen der unteren und der oberen Schicht des Modells, dh die Darstellung ist hierarchischer.

Aus der obigen Visualisierung können wir Folgendes beobachten:

- Bei Vorhersage- und Anomalieerkennungsaufgaben neigen Modelle mit besserer Leistung dazu, eine Darstellungsähnlichkeit von unten nach oben zu haben Je höher , es zeigt an, dass die Aufgabe Darstellungen auf niedrigerer Ebene erfordert;

- Je besser das Modell ist, desto geringer ist die Darstellungsähnlichkeit zwischen der unteren und der oberen Ebene , was darauf hinweist, dass diese Aufgabe hierarchisch ist Darstellung, d. h. bessere globale Funktionen zur Merkmalsextraktion.

Dank der Faltungsoperation im 2D-Raum kann TimesNet geeignete Darstellungen für verschiedene Aufgaben lernen. Beispielsweise lernt es bei Vorhersage- und Anomalieerkennungsaufgaben Darstellungen auf niedriger Ebene bei Klassifizierungs- und Füllaufgaben lernt hierarchische abstrakte Merkmale. Dies beweist weiter die Aufgabenverallgemeinerung von TimesNet als Grundmodell.

Gleichzeitig liefert die obige Darstellungsanalyse auch Entwurfsideen für tiefe Modelle für bestimmte Aufgaben. Beispielsweise müssen wir uns bei Vorhersageaufgaben auf die Extraktion zugrunde liegender feinkörniger Merkmale konzentrieren und bei Füllaufgaben. Wir müssen das Lernen globaler Darstellungen weiter berücksichtigen.

5 Zusammenfassung

Inspiriert von der mehrperiodischen Natur von Zeitreihen schlägt dieser Artikel ein Grundmodell für die Zeitreihenanalyse vor, das universell für Aufgaben geeignet ist – TimesNet. Dieses Modell faltet eindimensionale Zeitreihen auf innovative Weise in einen zweidimensionalen Raum und verwendet die 2D-Faltung, um Zeitreihenmerkmale zu erhalten. Durch diese Innovation können Timing-Analyseaufgaben direkt vom boomenden visuellen Backbone-Netzwerk profitieren, was für die nachfolgende Forschung sehr inspirierend ist.

Gleichzeitig hat TimesNet eine umfassende Führungsrolle bei den fünf gängigen Zeitreihenanalyseaufgaben Langzeit- und Kurzzeitvorhersage, Füllen fehlender Werte, Anomalieerkennung und Klassifizierung übernommen und verfügt über einen hervorragenden Anwendungswert.

Das obige ist der detaillierte Inhalt vonTiming-Analyse Pentagon-Krieger! Die Tsinghua-Universität schlägt TimesNet vor: führend in der Vorhersage, Füllung, Klassifizierung und Erkennung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins