Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wer kann eine chinesische Version von ChatGPT erstellen? Wie geht das?

Wer kann eine chinesische Version von ChatGPT erstellen? Wie geht das?

Wer kann eine chinesische Version von ChatGPT erstellen? Wie geht das?

Im Dezember 2022 wurde ChatGPT geboren. OpenAI hat das Paradigma der wissenschaftlichen Forschung und technischen Anwendungen mit einem Ergebnis auf Atombombenniveau verändert. In China hat ChatGPT große Aufmerksamkeit und tiefgreifende Diskussionen erhalten. Im vergangenen Monat habe ich große Universitäten, Forschungsinstitute, große Fabriken, Start-up-Unternehmen und Risikokapitalgeber von Peking über Shanghai und Hangzhou bis Shenzhen besucht und mit allen führenden Akteuren gesprochen. Das Game of Scale hat in China bereits begonnen. Wie können die Akteure im Zentrum des Sturms angesichts der großen Kluft zwischen heimischer Technologie und Ökologie und der weltweiten Spitzenreiterschaft dies erreichen? Wer kann das machen?

Qin hat seinen Hirsch verloren und die ganze Welt hat ihn vertrieben. ———— „Historische Aufzeichnungen · Biografien des Marquis von Huaiyin“

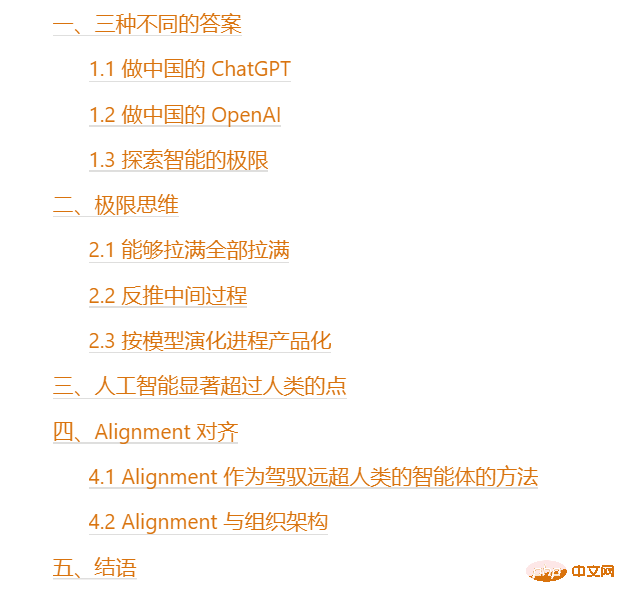

Inhaltsverzeichnis

1. Drei verschiedene Antworten

Jedes Mal, wenn ich mit einem Startup-Unternehmen in Kontakt komme, frage ich das gleiche Frage: „Wo ist ChatGPT? Was möchten Sie tun?“ Ich habe wahrscheinlich drei verschiedene Antworten erhalten. Die erste Antwort ist klar: Chinas ChatGPT aufbauen.

1.1 Machen Sie Chinas ChatGPT

Weil es da ist, möchte ich es reproduzieren und lokalisieren. Das ist sehr klassisches produktorientiertes chinesisches Internet-Denken. Diese Denkweise war in den letzten zwei Jahrzehnten auch im chinesischen Internet ein gängiges Geschäftsmodell: Zuerst macht das Silicon Valley etwas, und dann kopieren wir es.

Aber das Problem hierbei ist, dass ChatGPT erstens nicht wie eine Software für Taxirufe ist und die Schwierigkeit der Reproduktion völlig anders ist. Aus menschlicher Sicht ist die Entwicklung von GPT das Ergebnis kontinuierlicher Forschung der weltweit führenden Wissenschaftler und Ingenieure seit 2015. Der Chefwissenschaftler von OpenAI, Ilya Sutskever[1], glaubt fest daran, dass AGI erreicht werden kann. Als Schüler des Turing-Preisträgers Geoffery Hinton beschäftigt er sich seit 2007 mit Deep Learning. Er hat 370.000 Zitate und die Artikel, die er in den letzten zehn Jahren veröffentlicht hat, treffen genau alle Schlüsselaspekte des Deep Learning. Selbst mit einem so starken Team dauerte es vier Jahre, von GPT 2 auf GPT 3.5 umzusteigen. Man kann sich die Schwierigkeit der Wissenschaft und Technik vorstellen.

Gleichzeitig ist die erste Generation von ChatGPT eine von OpenAI erstellte Demo, die auf dem Grundmodell von GPT 3.5 basiert. Nachdem zwei Wochen lang den Dialog verfeinert hat , wurde er verworfen . Die eigentliche Stärke liegt hier nicht im Produkt ChatGPT, sondern im zugrunde liegenden GPT 3.5 Basismodell. Dieses Modell befindet sich noch in der Entwicklung. Die GPT 3.5-Serie wurde im Jahr 2022 mit drei Hauptversionen aktualisiert Monate nach ihrer Veröffentlichung weist jede kleine Version in einer einzelnen Dimension offensichtliche Verbesserungen auf. Alle OpenAI-Modelle entwickeln sich ständig weiter und werden mit der Zeit immer leistungsfähiger. Das heißt, wenn man sich nur auf das aktuelle Produkt ChatGPT konzentriert,

kommt dem Versuch gleich, ein Schwert zu finden. Als ChatGPT auf den Markt kam, verursachte es einen Rückschlag für die Dimensionsreduzierung bestehender Sprachassistenten; selbst wenn man ein oder zwei Jahre damit verbrachte, etwas Ähnliches zu schaffen, war die Entwicklung des Basismodells zu dieser Zeit die Grundlage von OpenAI Modelle werden auch weiterhin stärker, wenn sie weiterhin ein stärkeres Produkt mit einem neuen, stärkeren Basismodell produzieren und verfeinern, werden sie dann erneut von der Dimensionsreduzierung betroffen sein? Der Ansatz, ein Boot zu schnitzen und ein Schwert zu suchen, wird nicht funktionieren.

1.2 Werden Sie Chinas OpenAI

Die zweite Antwort ist, Chinas OpenAI zu werden. Der Spieler, der diese Antwort gab, ist aus dem klassischen chinesischen Internet-Produktdenken herausgesprungen. Sie sahen nicht nur ein einzelnes Produkt, sondern auch die starke treibende Kraft für die kontinuierliche Weiterentwicklung des Grundmodells hinter diesem Produkt, das aus der Dichte an Spitzentalenten und der fortschrittlichen Organisationsstruktur resultiert.

Wenn Sie dies tun möchten, müssen Sie also nicht nur das Produkt sehen, sondern auch das Talentteam und die Organisationsstruktur dahinter , Personen>> Karte >> Geld . Aber das Problem dabei ist, dass unterschiedliche Böden Innovationen unterschiedlich stark fördern. Als OpenAI im Jahr 2015 gegründet wurde, glaubten seine Investoren an AGI, auch wenn zu diesem Zeitpunkt noch kein Gewinn zu verzeichnen war. Nachdem GPT entwickelt wurde, haben auch inländische Investoren an AGI geglaubt, aber ihre Überzeugungen können unterschiedlich sein: Glauben Sie, dass AGI Geld verdienen kann, oder glauben Sie, dass AGI die menschliche Entwicklung fördern kann? Auch wenn OpenAI hier geboren wird und morgen erscheinen wird, kann der mit Microsoft erzielte Deal mit inländischen Cloud-Computing-Herstellern erreicht werden? Das Training und die Inferenz großer Modelle erfordern enorme Kosten und erfordern eine Cloud-Computing-Engine als Unterstützung. Microsoft kann seine ganze Kraft darauf verwenden, dass das gesamte Azure OpenAI unterstützt. [4] Organisationsstruktur ist sehr wichtig. Nur Spitzentalente und fortschrittliche Organisationsstrukturen können die kontinuierliche Iteration und Weiterentwicklung der Intelligenz fördern. 1.3 Erkunden Sie die Grenzen der Intelligenz Die dritte Antwort lautet: Erforschen Sie die Grenzen der Intelligenz . Das ist die beste Antwort, die ich je gehört habe. Es geht weit über das klassische Internet-Produktdenken hinaus, bei dem auf Schritt und Tritt nach einem Schwert gesucht wird. Es erkennt auch die Bedeutung der Organisationsstruktur und der Dichte an Spitzentalenten. Noch wichtiger ist, dass es die Zukunft sieht, Modellentwicklung und Produktiteration sieht und denkt darüber, wie man die tiefgreifendsten und tiefgreifendsten Dinge integriert. Das erfordert extremes Denken beim Nachdenken über große Modelle. Wenn man sich das aktuelle ChatGPT/GPT-3.5 ansieht, ist es offensichtlich, dass es noch viele Punkte gibt, die deutlich verbessert werden können, darunter: 2.1 kann alles füllen Das Eingabefeld des Modells kann weiter verlängert werden, die Größe des Modells kann weiter zunehmen, die Daten des Modells können weiter zunehmen, multimodale Daten kann fusioniert werden, und der Spezialisierungsgrad des Modells kann weiter zunehmen, und alle diese Dimensionen können weiter nach oben gezogen werden. Das Modell hat seine Grenzen noch nicht erreicht. Limit ist ein Prozess. Wie werden sich die Fähigkeiten des Modells während dieses Prozesses entwickeln?

2.2 Den Zwischenprozess umkehren Nachdem Sie klar über den Grenzprozess nachgedacht haben, können Sie den Zwischenprozess vom Grenzzustand aus umkehren. Wenn wir beispielsweise das Eingabefeld vergrößern möchten: Auf diese Weise können wir ableiten, welche Technologien für die Skalierung in den verschiedenen Phasen benötigt werden. Die obige Analyse gilt nicht nur für die Länge des Eingabefelds, sondern auch für den Skalierungsprozess anderer Faktoren. Auf diese Weise können wir eine klare technische Roadmap für jede Zwischenstufevon der aktuellen Technologie bis zur Skalierungsgrenze erhalten. 2.3 Produktisierung gemäß dem Modellentwicklungsprozess Modelle entwickeln sich ständig weiter, aber die Produktisierung muss nicht warten, bis das endgültige Modell fertiggestellt ist – immer dann, wenn eine große Version des Modells iteriert wird, kann dies geschehen produziert werden. Nehmen Sie als Beispiel den Produktisierungsprozess von OpenAI: Das ist in zu sehen Mit jeder wichtigen Version in der Zwischenphase werden die Fähigkeiten des Modells verbessert und es wird die Möglichkeit einer Produktisierung geben. Noch wichtiger ist, dass Sie sich während der Produktisierungsphase an den Markt anpassen können, indem Sie den Modellentwicklungsprozess verfolgen und ihn in die Produktion umsetzen. Lernen Sie die Organisationsstruktur von OpenAI kennen, um die Modellentwicklung selbst zu fördern. Die Produktisierung kann jedoch auf den Merkmalen des lokalen Marktes basieren. Dieser Ansatz ermöglicht es uns möglicherweise, aus den fortgeschrittenen Erfahrungen von OpenAI zu lernen und gleichzeitig das Problem der Akklimatisierung zu vermeiden. Bisher haben wir die Notwendigkeit diskutiert, das Modell aus der Perspektive der Modellentwicklung zu analysieren und extremes Denken zu verwenden, um die Entwicklung des Modells zu diskutieren. Zu den Punkten, die in dieser Phase sofort verbessert werden können, gehören die Länge des Eingabefelds, größere Modelle und Daten, multimodale Daten und der Spezialisierungsgrad des Modells. Lassen Sie uns nun einen längeren Blickwinkel werfen und darüber nachdenken, wie das Modell in einem größeren Zeit- und Raumbereich noch weiter an seine Grenzen gebracht werden kann. Wir besprechen: Dieses Problem möchte die Alignment-Technologie wirklich lösen. 4. Ausrichtung 4.1 Ausrichtung als Methode zur Steuerung intelligenter Agenten weit über den Menschen hinaus Eine offensichtliche Frage ist: Kann die KI, nachdem sie den Menschen übertrifft, durch menschliches Feedback noch stärker/eingeschränkter gemacht werden? Ist es zu diesem Zeitpunkt außer Kontrolle? Auch wenn das Modell den Menschen weit überlegen ist, können wir es dennoch kontrollieren. Ein Beispiel hierfür ist die Beziehung zwischen : Goldmedaillen-Athleten sind bereits die stärksten Menschen in ihrer Richtung. , aber das bedeutet nicht, dass der Trainer ihn nicht trainieren kann. Im Gegenteil: Auch wenn der Trainer nicht so gut ist wie der Sportler, kann er den Sportler durch verschiedene Feedback-Mechanismen dennoch stärker und disziplinierter machen. In ähnlicher Weise kann die Beziehung zwischen Menschen und starker künstlicher Intelligenz zur Beziehung zwischen Sportlern und Trainern in der mittleren und späteren Phase der KI-Entwicklung werden. Zu diesem Zeitpunkt besteht die Fähigkeit, die Menschen benötigen, nicht darin, ein Ziel zu erreichen, sondern darin, sich ein gutes Ziel zu setzen und dann zu messen, ob die Maschine das Ziel gut genug erreicht hat, und Verbesserungsvorschläge zu machen. Die Forschung in dieser Richtung ist noch sehr vorläufig. Der Name dieser neuen Disziplin heißt Scalable Oversight4.2 Ausrichtung und Organisationsstruktur Die Hirse wird abgetrennt, die Reiskeimlinge wachsen. Das Tempo ist langsam und zaghaft und die Mitte bebt. Die Hirse wird abgetrennt, die Ähren werden abgetrennt. Wenn man mit großen Schritten vorwärts geht, ist die Mitte wie ein Rausch. ———— „Das Buch der Lieder·Mili“

Methode, da das Hinzufügen von Videospeicher zu diesem Zeitpunkt nicht in der Lage sein sollte, den quadratischen Anstieg des Aufmerksamkeitsberechnungsvolumens mit der Länge des Eingabefelds zu unterstützen.

3. Der Punkt, an dem künstliche Intelligenz den Menschen deutlich übertrifft

Wie kann man eine starke künstliche Intelligenz kontrollieren, die die des Menschen bei weitem übertrifft?

Das obige ist der detaillierte Inhalt vonWer kann eine chinesische Version von ChatGPT erstellen? Wie geht das?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

Was sind die Methoden zur Abstimmung der Leistung von Zookeeper auf CentOS

Apr 14, 2025 pm 03:18 PM

Was sind die Methoden zur Abstimmung der Leistung von Zookeeper auf CentOS

Apr 14, 2025 pm 03:18 PM

Die Zookeper -Leistungsstimmung auf CentOS kann von mehreren Aspekten beginnen, einschließlich Hardwarekonfiguration, Betriebssystemoptimierung, Konfigurationsparameteranpassung, Überwachung und Wartung usw. Hier finden Sie einige spezifische Tuning -Methoden: SSD wird für die Hardwarekonfiguration: Da die Daten von Zookeeper an Disk geschrieben werden, wird empfohlen, SSD zu verbessern, um die I/O -Leistung zu verbessern. Genug Memory: Zookeeper genügend Speicherressourcen zuweisen, um häufige Lesen und Schreiben von häufigen Festplatten zu vermeiden. Multi-Core-CPU: Verwenden Sie Multi-Core-CPU, um sicherzustellen, dass Zookeeper es parallel verarbeiten kann.

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek:

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Docker verwendet Linux -Kernel -Funktionen, um eine effiziente und isolierte Anwendungsumgebung zu bieten. Sein Arbeitsprinzip lautet wie folgt: 1. Der Spiegel wird als schreibgeschützte Vorlage verwendet, die alles enthält, was Sie für die Ausführung der Anwendung benötigen. 2. Das Union File System (UnionFS) stapelt mehrere Dateisysteme, speichert nur die Unterschiede, speichert Platz und beschleunigt. 3. Der Daemon verwaltet die Spiegel und Container, und der Kunde verwendet sie für die Interaktion. 4. Namespaces und CGroups implementieren Container -Isolation und Ressourcenbeschränkungen; 5. Mehrere Netzwerkmodi unterstützen die Containerverbindung. Nur wenn Sie diese Kernkonzepte verstehen, können Sie Docker besser nutzen.

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

Die Installation von MySQL auf CentOS umfasst die folgenden Schritte: Hinzufügen der entsprechenden MySQL Yum -Quelle. Führen Sie den Befehl mySQL-server aus, um den MySQL-Server zu installieren. Verwenden Sie den Befehl mySQL_SECURE_INSTALLATION, um Sicherheitseinstellungen vorzunehmen, z. B. das Festlegen des Stammbenutzerkennworts. Passen Sie die MySQL -Konfigurationsdatei nach Bedarf an. Tune MySQL -Parameter und optimieren Sie Datenbanken für die Leistung.

CentOS8 startet SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 startet SSH

Apr 14, 2025 pm 09:00 PM

Der Befehl zum Neustart des SSH -Dienstes lautet: SystemCTL Neustart SSHD. Detaillierte Schritte: 1. Zugriff auf das Terminal und eine Verbindung zum Server; 2. Geben Sie den Befehl ein: SystemCTL Neustart SSHD; 1. Überprüfen Sie den Dienststatus: SystemCTL -Status SSHD.