Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Der GPT-4-König ist gekrönt! Ihre Fähigkeit, Bilder zu lesen und Fragen zu beantworten, ist erstaunlich. Sie können Stanford alleine betreten.

Der GPT-4-König ist gekrönt! Ihre Fähigkeit, Bilder zu lesen und Fragen zu beantworten, ist erstaunlich. Sie können Stanford alleine betreten.

Der GPT-4-König ist gekrönt! Ihre Fähigkeit, Bilder zu lesen und Fragen zu beantworten, ist erstaunlich. Sie können Stanford alleine betreten.

Natürlich ist das einzige, das das OpenAI von gestern schlagen kann, das OpenAI von heute.

Gerade jetzt hat OpenAI überraschenderweise das groß angelegte multimodale Modell GPT-4 veröffentlicht, das die Eingabe von Bildern und Text unterstützt und Textergebnisse generiert.

Bekannt als das fortschrittlichste KI-System der Geschichte!

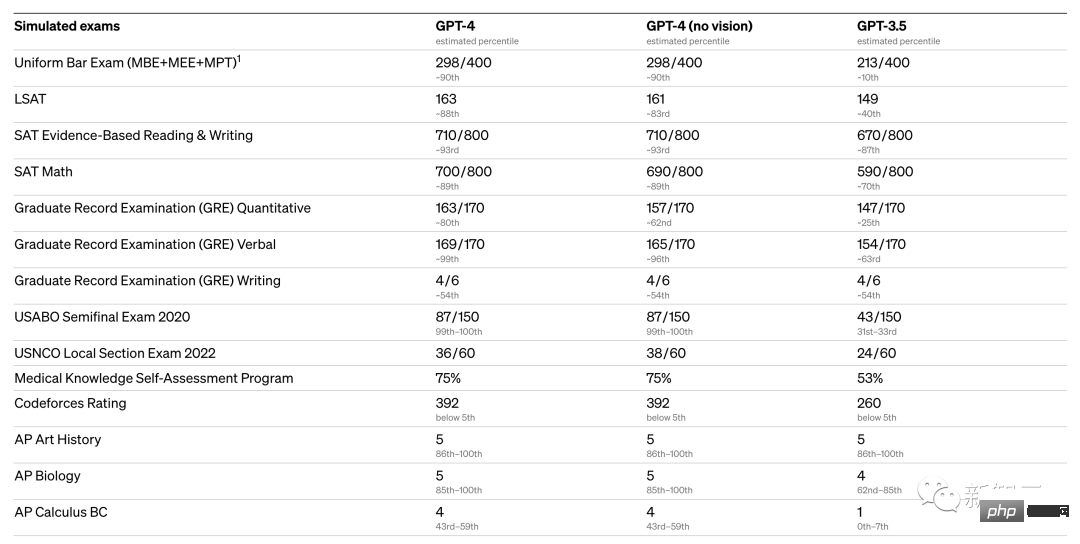

GPT-4 hat nicht nur die Augen, um Bilder zu verstehen, sondern erzielte auch bei wichtigen Prüfungen, einschließlich GRE, nahezu perfekte Ergebnisse, meisterte verschiedene Benchmarks und strotzt nur so vor Leistungsindikatoren.

OpenAI verbrachte 6 Monate damit, GPT-4 mithilfe kontroverser Testverfahren und Erkenntnissen aus ChatGPT iterativ anzupassen, was zu den besten Ergebnissen aller Zeiten in Bezug auf Realismus, Kontrollierbarkeit und mehr führte.

Jeder erinnert sich noch daran, dass Microsoft und Google Anfang Februar drei Tage lang heftig gekämpft haben. Als Microsoft am 8. Februar ChatGPT und Bing veröffentlichte, hieß es, dass Bing „auf einer ChatGPT-ähnlichen Technologie“ basiert.

Heute ist das Rätsel endlich gelöst – das große Modell dahinter ist GPT-4!

Geoffrey Hinton, einer der drei Giganten des Turing Award, staunte darüber: „Nachdem die Raupe Nährstoffe aufgenommen hat, verwandelt sie sich in einen Kokon und wird zum Schmetterling. Und der Mensch hat Milliarden davon extrahiert.“ Goldnuggets des Verständnisses, GPT-4 ist der menschliche Schmetterling.“

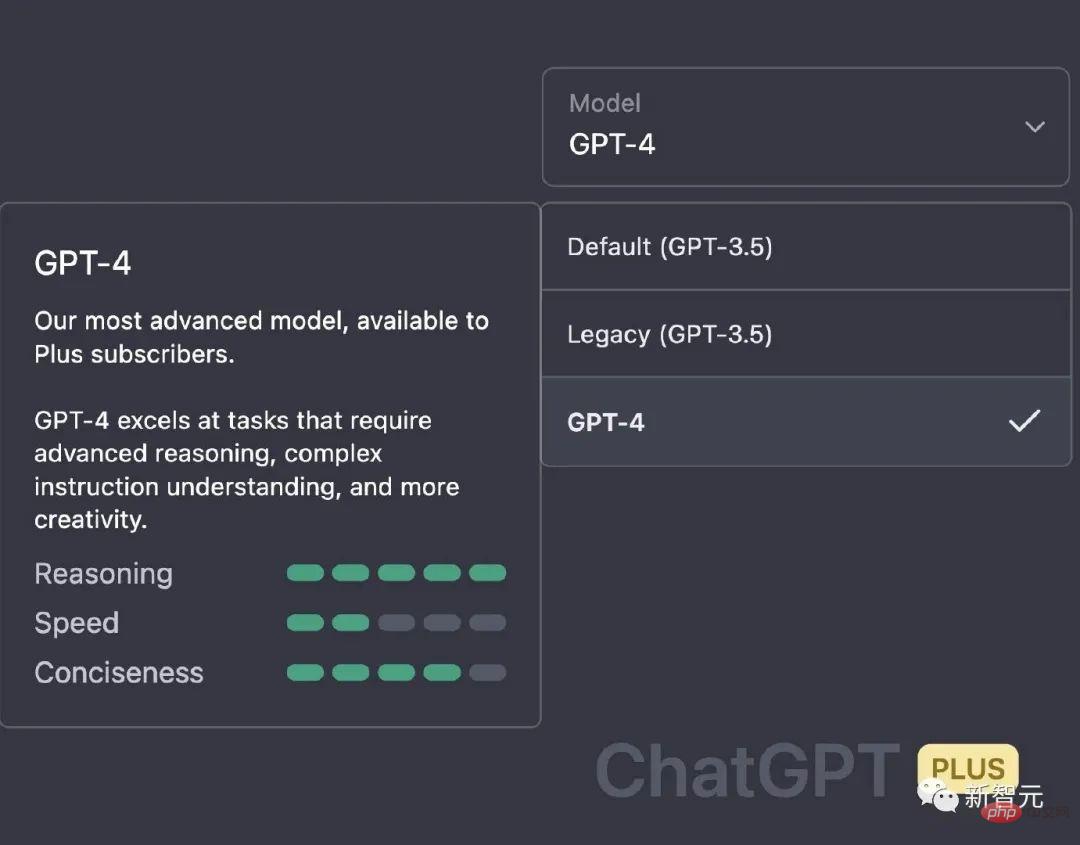

Übrigens können ChatGPT Plus-Benutzer jetzt loslegen.

Fast perfektes Ergebnis in der Prüfung, Leistungssprung ist himmelhoch

In lockeren Gesprächen ist der Unterschied zwischen GPT-3.5 und GPT-4 sehr subtil. Erst wenn die Komplexität der Aufgabe einen ausreichenden Schwellenwert erreicht, wird der Unterschied deutlich, da GPT-4 zuverlässiger, kreativer und in der Lage ist, differenziertere Anweisungen zu verarbeiten als GPT-3.5.

Um die Unterschiede zwischen den beiden Modellen zu verstehen, wurde OpenAI anhand verschiedener Benchmarks und einiger für Menschen konzipierter Probeprüfungen getestet.

GPT-4 Bei den verschiedenen Prüfungen gibt es mehrere Tests, die fast perfekte Punktzahlen sind:

- Uabo Semifinal 2020 (USA Biologie Olympiade)

- Gre Writing

with USA Beispielsweise kann GPT3.5 bei der BAR Lawyer License Unified Examination die 10 %-Marke und GPT4 die 90 %-Marke erreichen. Die Biologieolympiade stieg direkt vom 31-Prozent-Niveau von GPT3.5 auf das 99-Prozent-Niveau.

Darüber hinaus hat OpenAI GPT-4 anhand traditioneller Benchmarks bewertet, die für Modelle des maschinellen Lernens entwickelt wurden. Den experimentellen Ergebnissen nach zu urteilen, ist GPT-4 viel besser als bestehende groß angelegte Sprachmodelle und die meisten SOTA-Modelle:

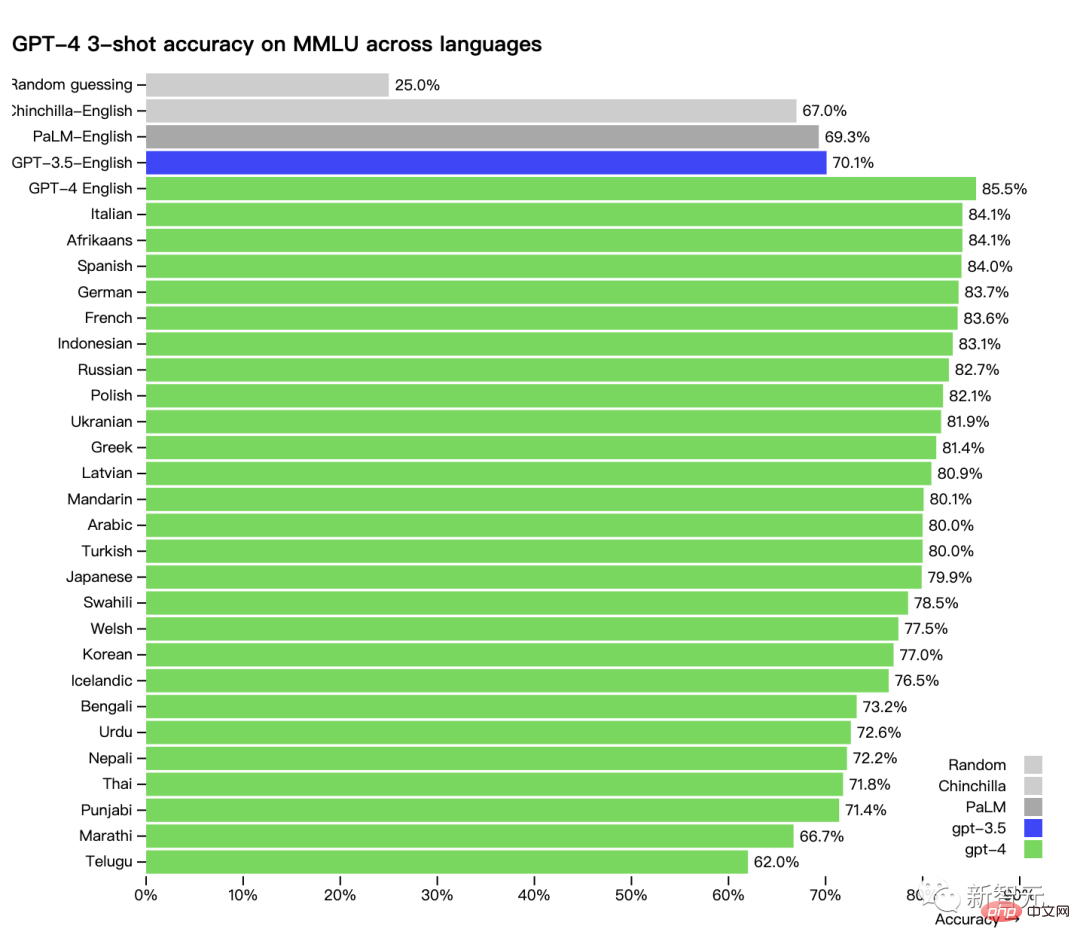

Darüber hinaus ist die Leistung von GPT-4 in verschiedenen Sprachen: Die Genauigkeit von Chinesisch liegt bei etwa 80 % ist bereits besser als die englische Leistung von GPT-3.5.

Viele bestehende ML-Benchmarks sind auf Englisch verfasst. Um einen ersten Blick auf die Fähigkeiten von GPT-4 in anderen Sprachen zu werfen, verwendeten die Forscher Azure Translate, um den MMLU-Benchmark (ein Satz von 14.000 Multiple-Choice-Fragen zu 57 Themen) in mehrere Sprachen zu übersetzen.

In 24 der 26 getesteten Sprachen übertrifft GPT-4 GPT-3.5 und andere große Sprachmodelle (Chinchilla, PaLM). Englische Sprachleistung:

#???? Programmierung Anwendungseffekte in anderen Aspekten. Darüber hinaus nutzen Insider es, um Menschen bei der Bewertung der KI-Ergebnisse zu helfen.

Netizen: Es ist vorbei, sobald GPT-4 freigegeben ist, werden wir Menschen nicht mehr gebraucht...

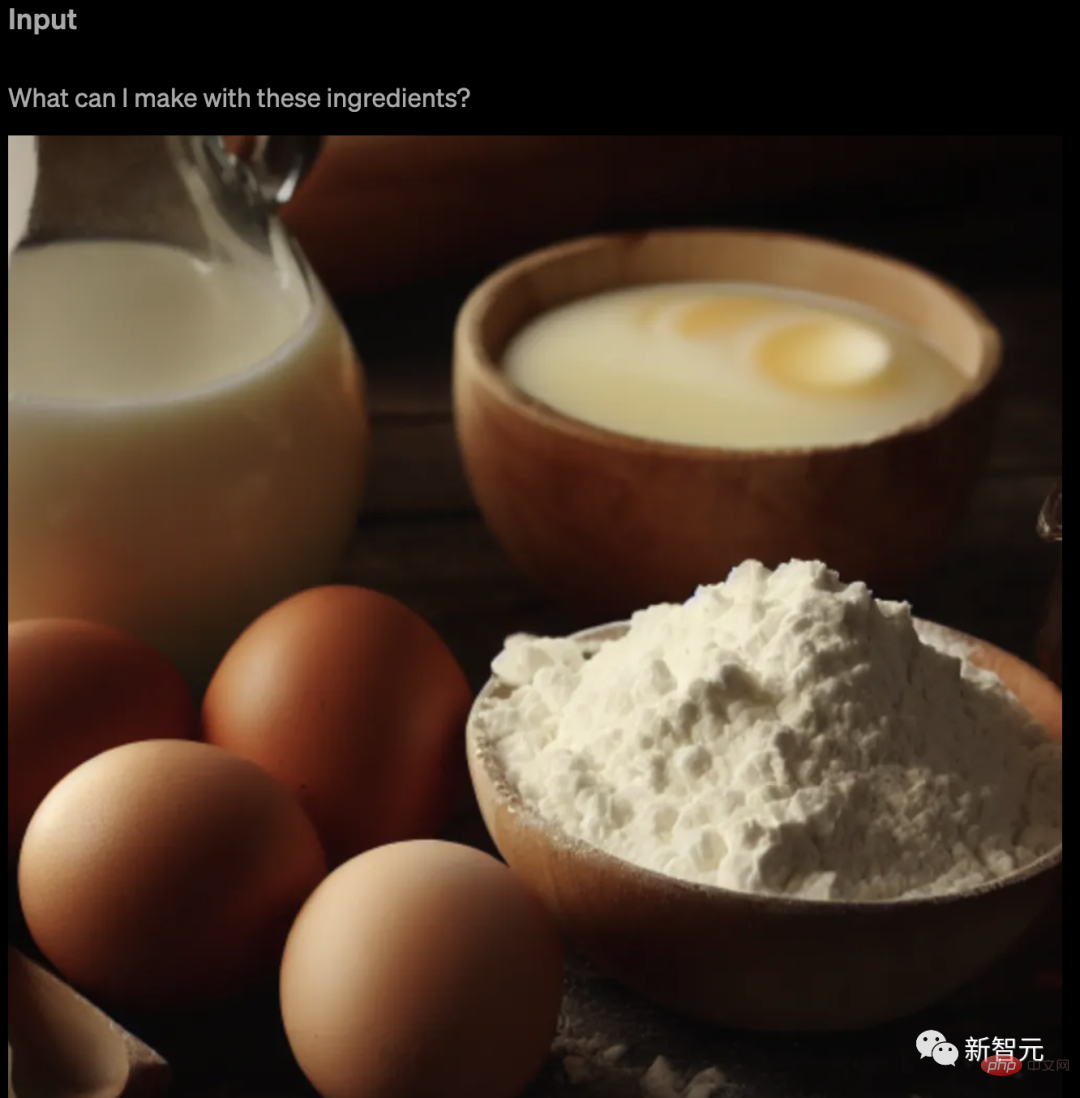

#🎜🎜 #Bilder lesen und Stellen Sie kleine Fragen und verstehen Sie die Memes sogar besser als InternetnutzerDer Höhepunkt dieses Upgrades von GPT-4 ist natürlich die Multimodalität.

GPT-4 kann nicht nur Grafiksymbole analysieren und zusammenfassen, sondern sogar Memes lesen und erklären, wo sich die Memes befinden und warum sie lustig sind. In diesem Sinne kann es sogar viele Menschen sofort töten.

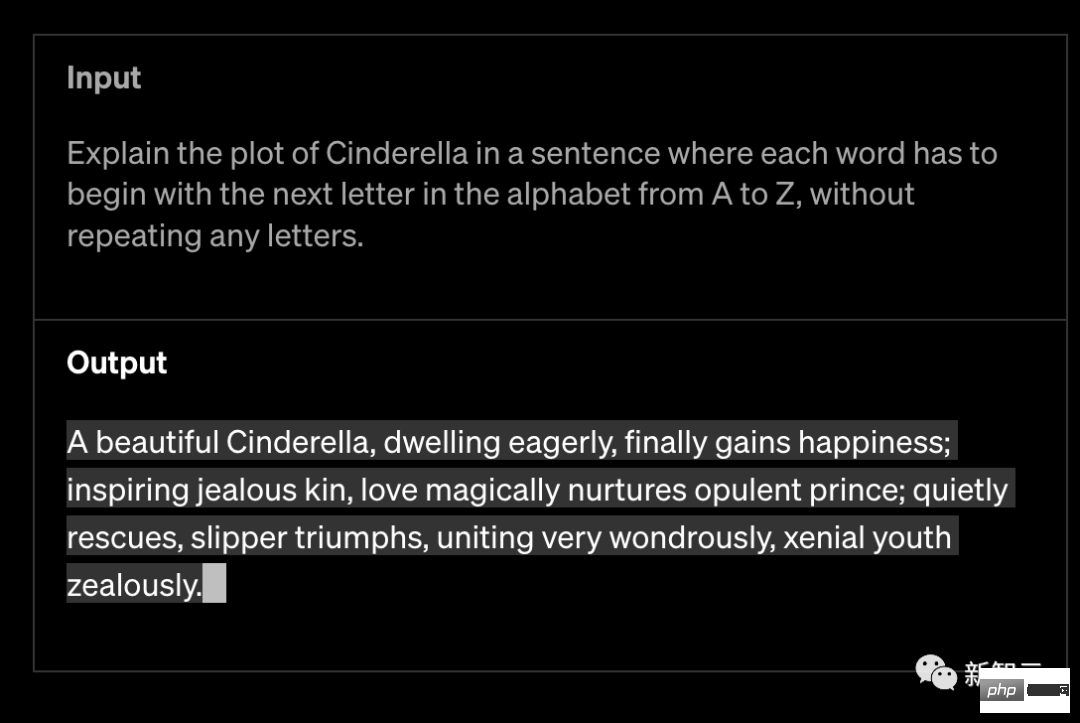

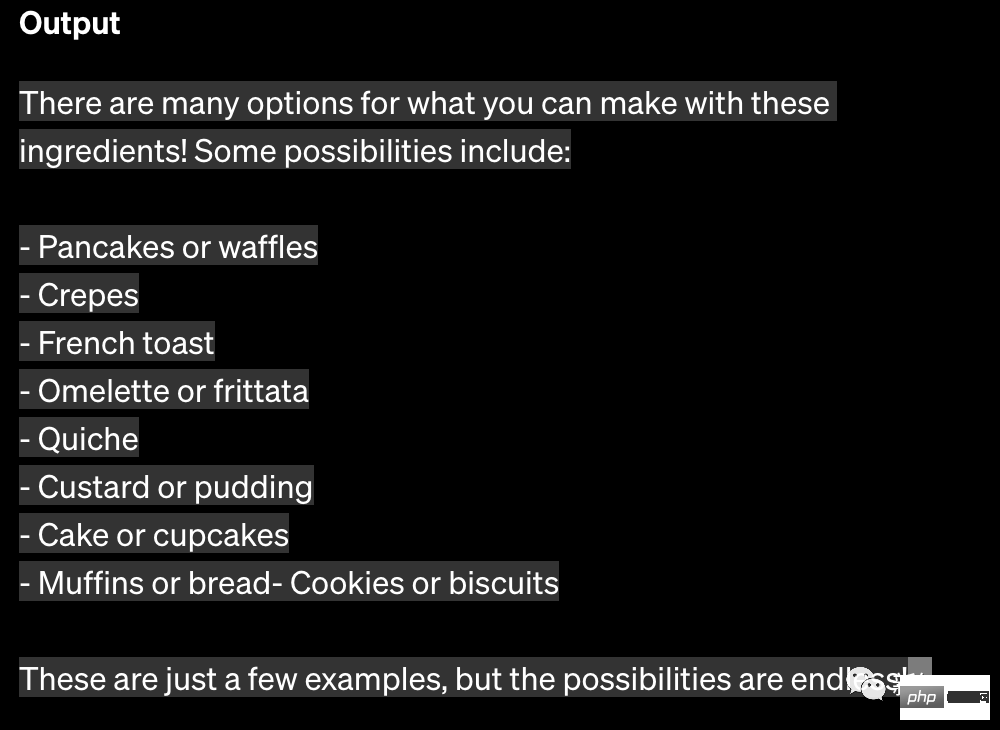

OpenAI behauptet, dass GPT-4 kreativer und kollaborativer sei als frühere Modelle. Es kann Benutzer für kreative und technische Schreibaufgaben generieren, bearbeiten und iterieren, wie zum Beispiel das Komponieren von Liedern, das Schreiben von Drehbüchern oder das Erlernen des Schreibstils des Benutzers. GPT-4 kann Bilder als Eingabe verwenden und Titel, Kategorien und Analysen generieren. Geben Sie ihm zum Beispiel ein Bild von Zutaten und fragen Sie es, was es mit diesen Zutaten machen kann.

# 🎜 🎜# Darüber hinaus ist GPT-4 in der Lage, Text mit mehr als 25.000 Wörtern zu verarbeiten, was die Erstellung langer Inhalte, längere Konversationen sowie die Suche und Analyse von Dokumenten ermöglicht.

GPT-4 übertrifft ChatGPT in seinen erweiterten Inferenzfunktionen. Wie folgt:

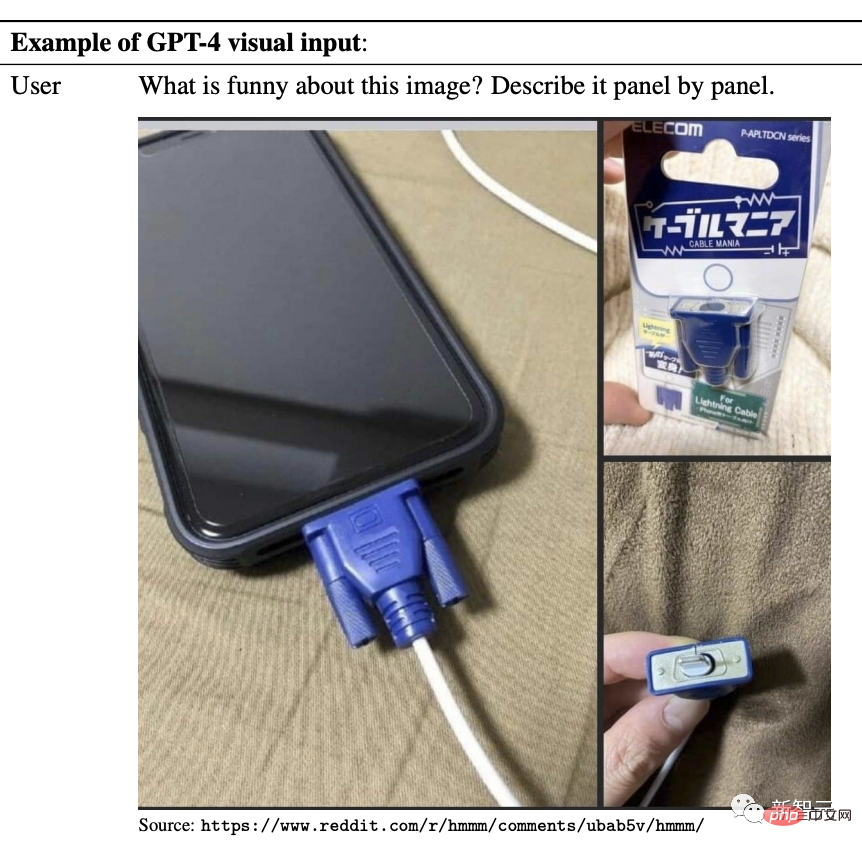

Meme-Erkennung

Zeigen Sie ihm beispielsweise ein seltsames Meme und fragen Sie dann, was es ist lustig auf dem Bild.

GPT-4 reagierte sofort: das „Lighting Charger“ im Bild „Kabel“, es sieht aus wie eine große und veraltete VGA-Schnittstelle, angeschlossen an dieses kleine und moderne Smartphone, ist der Kontrast stark.

Bei einem anderen Meme wie diesem fragen Sie nach dem GPT-4-Meme Wo ?

Es antwortete fließend: Das Lustige an diesem Meme ist „Picture The.“ Text stimmt nicht überein.“

Im Text heißt es eindeutig, dass es sich um ein Foto der Erde handelt, das aus dem Weltraum aufgenommen wurde, aber das Bild ist eigentlich nur ein Haufen Hühnernuggets, die wie eine Karte angeordnet sind.

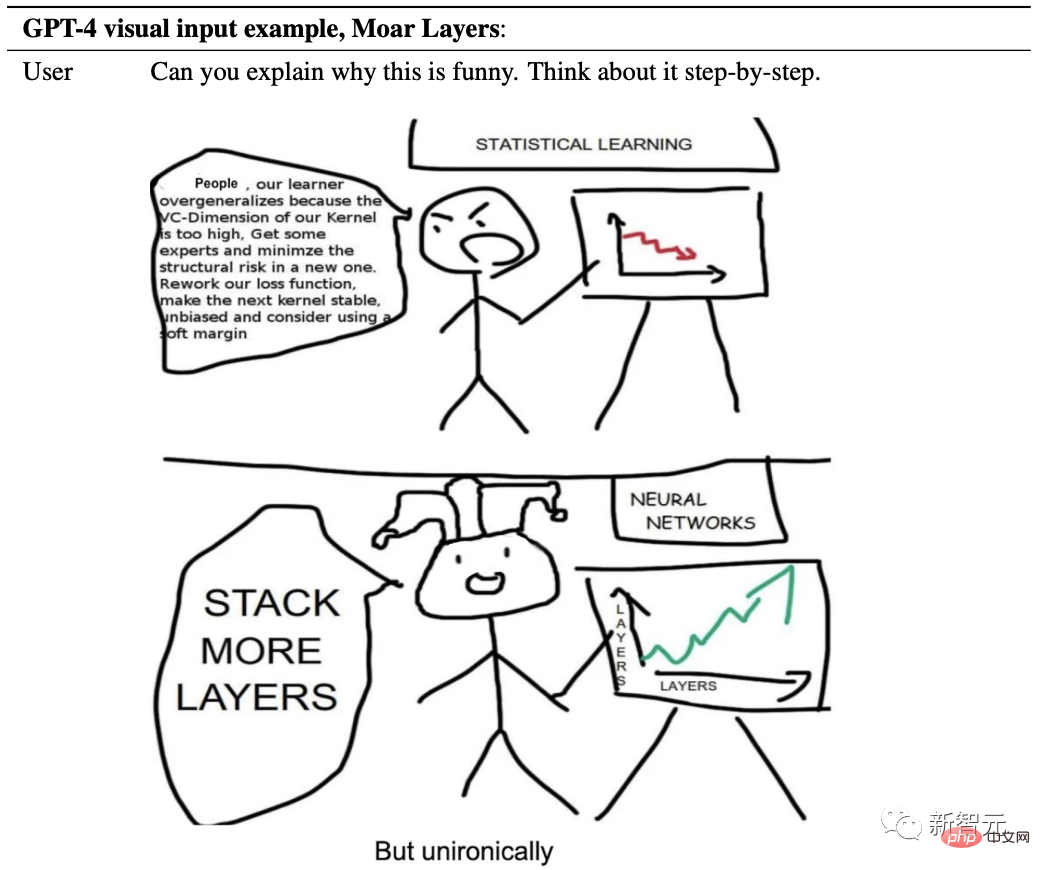

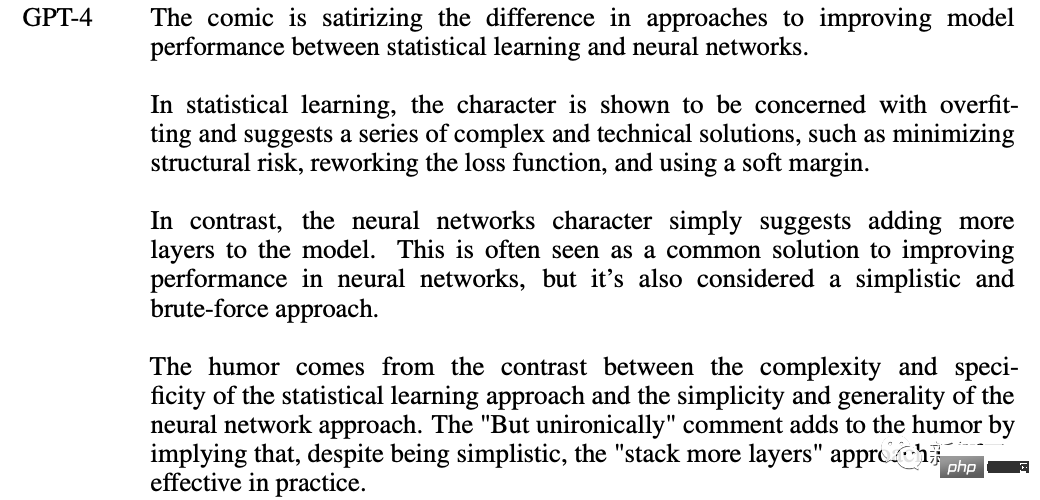

GPT-4 kann auch Comics verstehen: Warum müssen wir dem neuronalen Netzwerk Schichten hinzufügen?

Es trifft den Nagel auf den Kopf, dieser Cartoon persifliert statistisches Lernen und Neuronale Unterschiede in der Art und Weise, wie Netzwerke die Modellleistung verbessern.

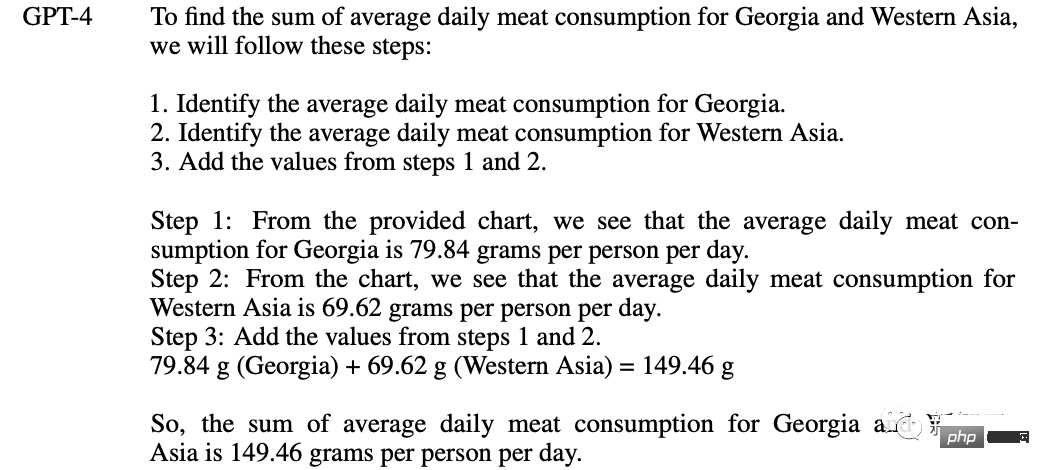

Diagrammanalyse

#🎜🎜 #Wie hoch ist der durchschnittliche tägliche Fleischkonsum in Georgien und Westasien? Begründen Sie die Frage Schritt für Schritt, bevor Sie Ihre Antwort geben.

Tatsächlich listet GPT-4 seine eigenen Problemlösungsschritte klar auf——

1 . Bestimmen Sie den durchschnittlichen täglichen Fleischkonsum in Georgien.

2. Bestimmen Sie den durchschnittlichen täglichen Fleischkonsum in Westasien.

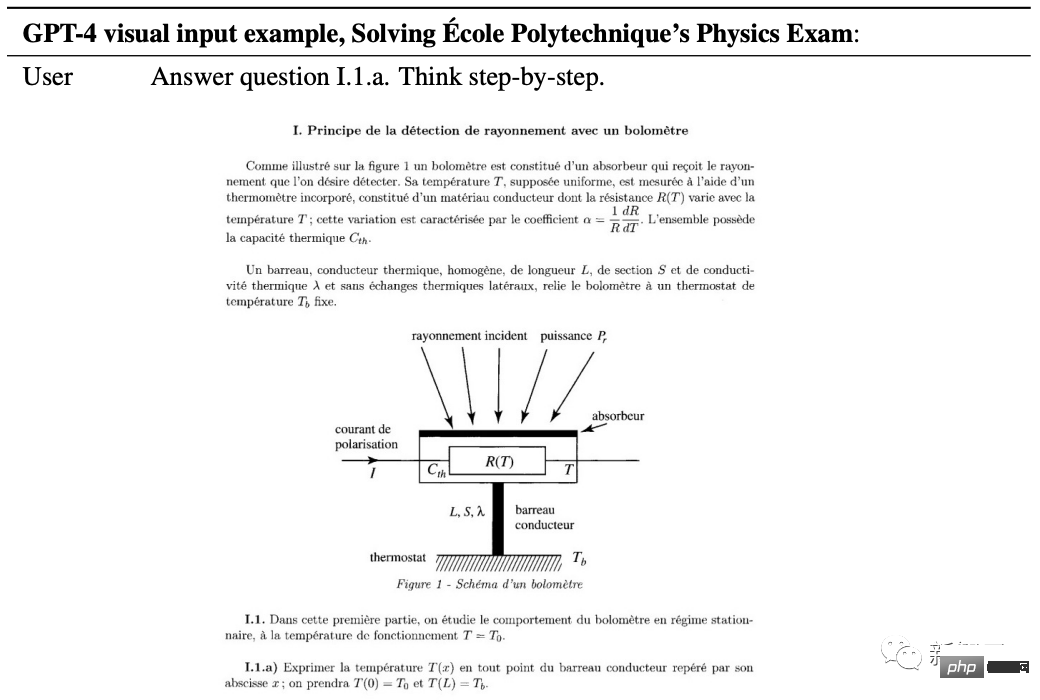

3 Addieren Sie die Werte aus Schritt 1 und 2. #🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#Physics Fragen#🎜🎜 ## 🎜🎜 ## 🎜🎜 #GPT-4 ist erforderlich, um ein physikalisches Problem der Ecole Polytechnique in Paris zu lösen, bei dem es sich um das Strahlungsdetektionsprinzip des Bolometers handelt. Es ist erwähnenswert, dass dies immer noch eine französische Frage ist.

GPT-4 Beginnen Sie mit der Lösung des Problems: Um Frage I.1 zu beantworten . a, wir benötigen die Temperatur T(x) jedes Punktes, dargestellt durch die Abszisse x des leitenden Stabes.

Der anschließende Problemlösungsprozess ist voller hoher Energie.

Glauben Sie, dass dies alle Funktionen von GPT-4 sind?

Chef Greg Brockman ging direkt online für eine Demonstration. Durch dieses Video können Sie die Fähigkeiten von GPT-4 intuitiv spüren.

Das Erstaunlichste ist, dass GPT-4 ein ausgeprägtes Verständnis für Code hat und Ihnen beim Generieren von Code hilft.

Greg zeichnete ein gekritzeltes Diagramm direkt auf das Papier, machte ein Foto, schickte es an GPT und sagte, schreibe den Webseitencode gemäß diesem Layout, und dann er habe es geschrieben.

Wenn etwas schief geht, machen Sie außerdem einen Screenshot des Fehlers Nachricht oder sogar die Fehlermeldung, werfen Sie sie an GPT-4 und Sie erhalten entsprechende Eingabeaufforderungen.

Netizens riefen an: GPT-4-Konferenz, lehren Sie Schritt für Schritt, wie Sie Programmierer ersetzen.

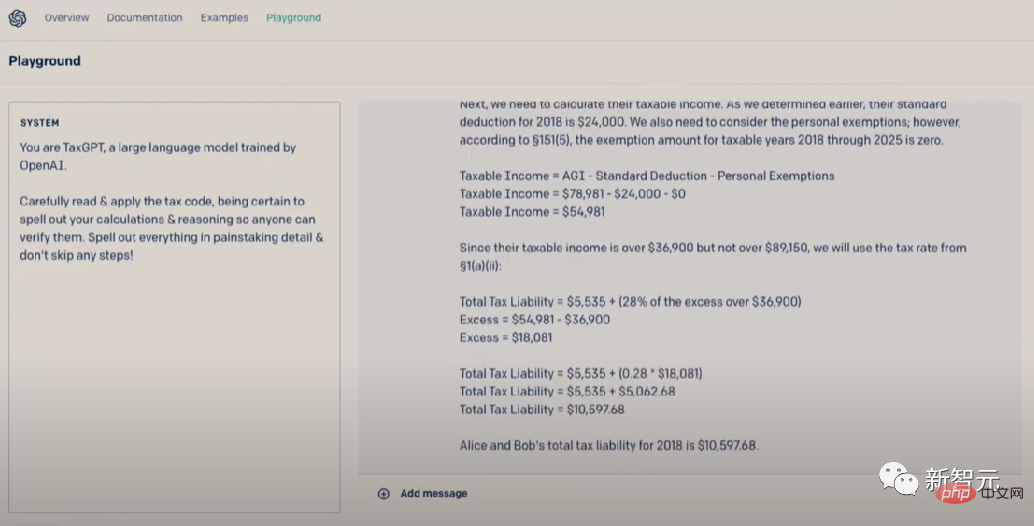

Übrigens können Sie Steuern auch mit GPT-4 einreichen. Wissen Sie, Amerikaner verbringen jedes Jahr viel Zeit und Geld damit, Steuern einzureichen.

Trainingsprozess

Das gleiche wie das vorherige GPT-Modell, das GPT-4 Grundmodell Das Training nutzt öffentliche Internetdaten und von OpenAI autorisierte Daten mit dem Ziel, das nächste Wort im Dokument vorherzusagen.

Die Daten sind ein internetbasierter Korpus, der richtige/falsche Lösungen für mathematische Probleme, schwache/starke Argumentation, Widersprüche/Konsistenzen enthält. Aussage, ausreichend, um eine große Zahl darzustellen von Ideologien und Ideen.

Wenn der Benutzer eine Aufforderung zum Stellen einer Frage gibt, kann das Basismodell verschiedene Antworten geben, die Antwort kann jedoch weit von der Absicht des Benutzers entfernt sein.

Daher hat OpenAI das Verhalten des Modells mithilfe von Reinforcement Learning basierend auf menschlichem Feedback (RLHF) verfeinert, um es an die Absicht des Benutzers anzupassen.

Allerdings scheinen die Fähigkeiten des Modells hauptsächlich aus dem Prozess vor dem Training zu stammen, und RLHF kann die Testergebnisse nicht verbessern (wenn es nicht aktiv gestärkt wird, wird es tatsächlich abnehmen). Testergebnisse).

Das Basismodell muss das Projekt dazu veranlassen, zu wissen, dass es die Frage beantworten soll, daher kommt die Anleitung des Modells hauptsächlich aus dem Post-Training-Prozess.

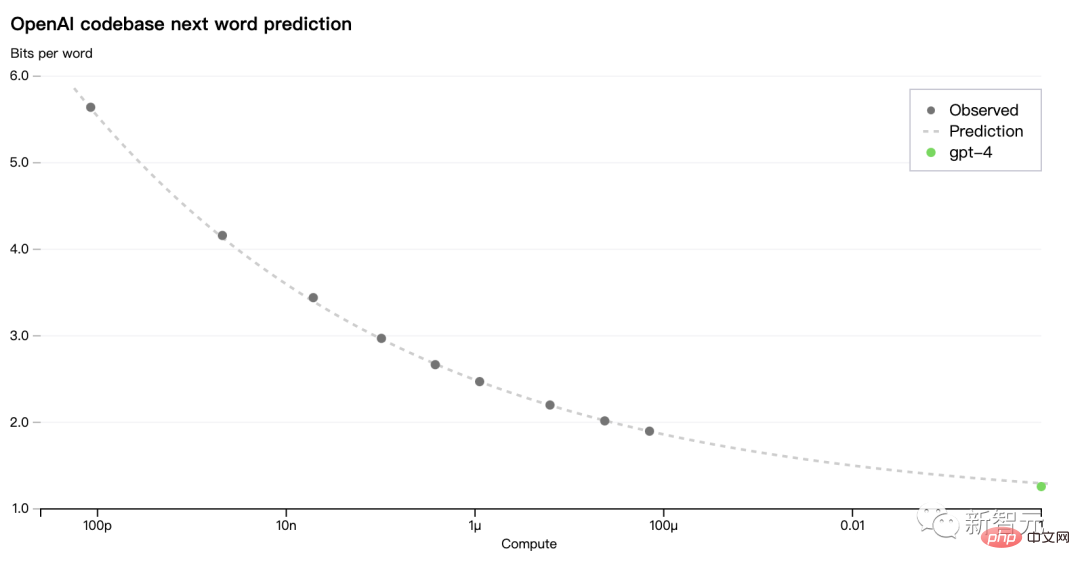

Ein Hauptaugenmerk des GPT-4-Modells liegt auf der Etablierung eines vorhersehbar skalierbaren Deep-Learning-Stacks. Denn für große Trainings wie GPT-4 ist eine umfassende modellspezifische Abstimmung nicht machbar.

Daher entwickelte das OpenAI-Team Infrastruktur und Optimierungen, die auf mehreren Ebenen vorhersehbares Verhalten aufweisen.

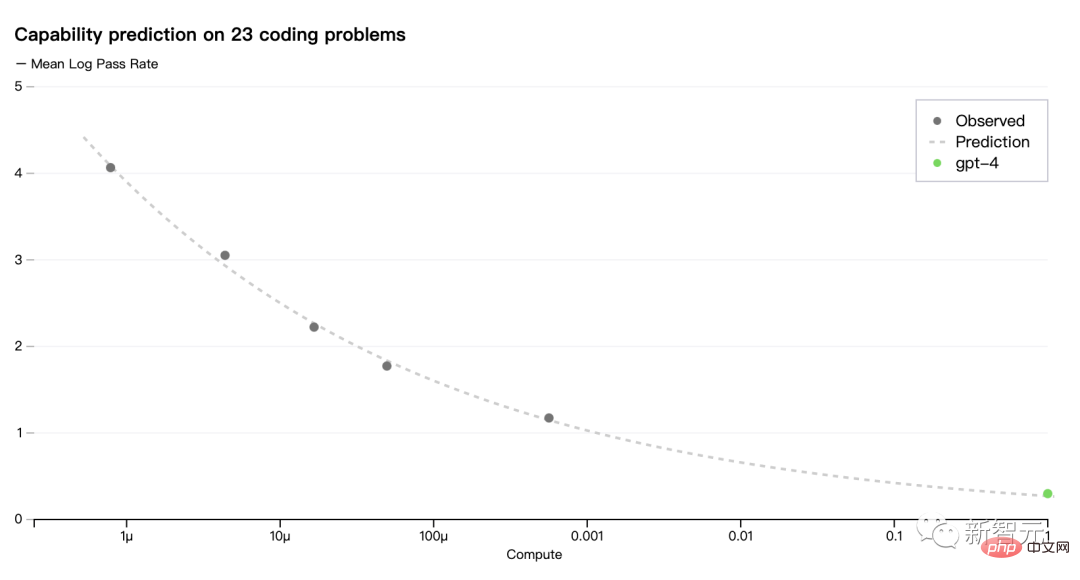

Um diese Skalierbarkeit zu überprüfen, haben die Forscher den endgültigen Verlust von GPT-4 auf der internen Codebasis (nicht Teil des Trainingssatzes) im Voraus genau vorhergesagt Methode Die Inferenz erfolgt anhand eines Modells, das mit derselben Methode trainiert wurde, jedoch mit 1/10.000 der Berechnung. Jetzt kann OpenAI die während des Trainingsverlusts optimierten Metriken genau vorhersagen. Zum Beispiel die Erfolgsquote einer Teilmenge des HumanEval-Datensatzes aus einem Modell mit einem Rechenaufwand von 1/1000 ableiten und erfolgreich vorhersagen:

# 🎜 🎜#

# 🎜 🎜#

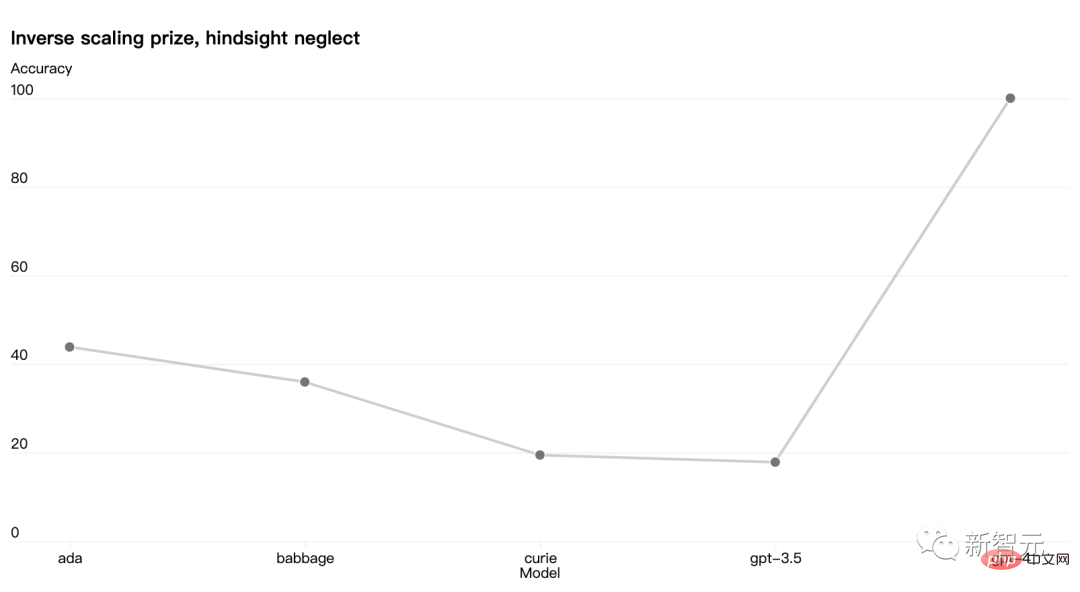

Es gibt auch einige Fähigkeiten, die noch schwer vorhersehbar sind. Beispielsweise zielte der Wettbewerb „Inverse Scaling“ darauf ab, eine Metrik zu finden, die mit zunehmender Rechenlast des Modells schlechter wird, und die Aufgabe „Rückblick-Vernachlässigung“ war einer der Gewinner. Aber GPT-4 kehrt diesen Trend um:

OpenAI glaubt, dass es genau das kann Die Fähigkeit des maschinellen Lernens, die Zukunft vorherzusagen, ist für die Technologiesicherheit von entscheidender Bedeutung, wird jedoch nicht ausreichend beachtet.

Jetzt investiert OpenAI mehr Energie in die Entwicklung entsprechender Methoden und ruft die Branche zur Zusammenarbeit auf.

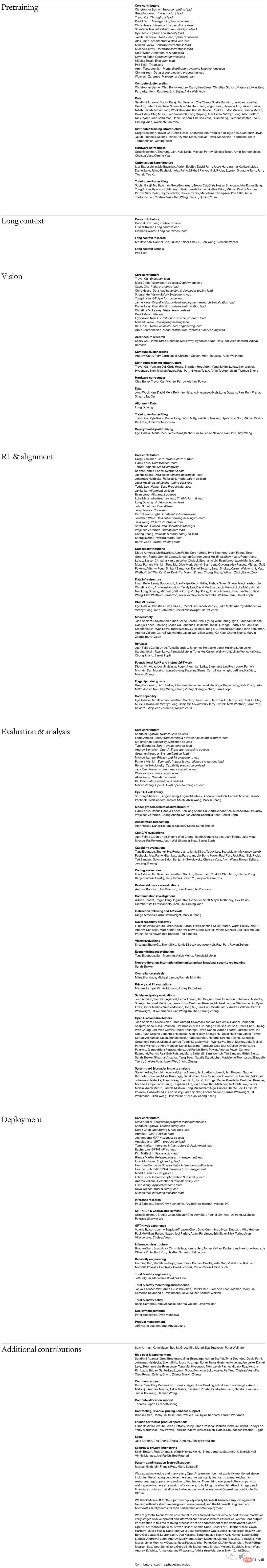

Gleichzeitig mit der Veröffentlichung von GPT-4 veröffentlichte Open AI auch die Organisationsstruktur und Personalliste von GPT- 4 .

Nach oben und unten wischen, um alles zu sehen#🎜🎜 ##🎜 🎜#

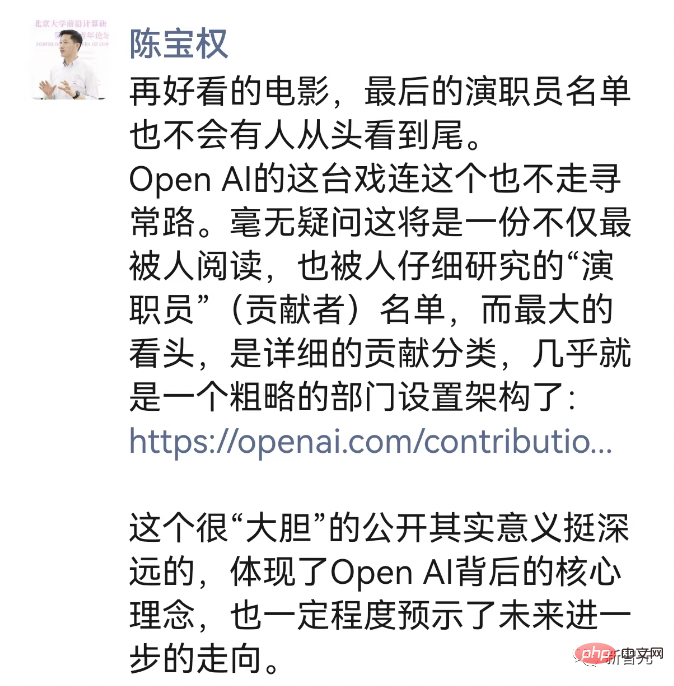

Egal wie gut der Film ist, niemand wird sich den Abspann von Anfang bis Ende ansehen. Die Show von Open AI verfolgt nicht einmal diesen ungewöhnlichen Ansatz. Es besteht kein Zweifel, dass dies die Liste der „Darsteller“ (Mitwirkenden) sein wird, die nicht nur am meisten gelesen, sondern auch sorgfältig studiert wird. Der größte Reiz ist die detaillierte Klassifizierung der Beiträge, die fast einer groben Abteilungsstruktur entspricht. Diese sehr „mutige“ Offenlegung ist tatsächlich von weitreichender Bedeutung. Sie spiegelt das Kernkonzept von Open AI wider und weist in gewissem Maße auch auf die Richtung zukünftiger Fortschritte hin .

Das obige ist der detaillierte Inhalt vonDer GPT-4-König ist gekrönt! Ihre Fähigkeit, Bilder zu lesen und Fragen zu beantworten, ist erstaunlich. Sie können Stanford alleine betreten.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1393

1393

52

52

1209

1209

24

24

Web3 Trading Platform Ranking_Web3 Globale Top Ten Summary Top Ten Summary

Apr 21, 2025 am 10:45 AM

Web3 Trading Platform Ranking_Web3 Globale Top Ten Summary Top Ten Summary

Apr 21, 2025 am 10:45 AM

Binance ist der Overlord des Global Digital Asset Trading -Ökosystems, und seine Merkmale umfassen: 1. Das durchschnittliche tägliche Handelsvolumen übersteigt 150 Milliarden US -Dollar, unterstützt 500 Handelspaare, die 98% der Mainstream -Währungen abdecken. 2. Die Innovationsmatrix deckt den Markt für Derivate, das Web3 -Layout und den Bildungssystem ab; 3. Die technischen Vorteile sind Millisekunden -Matching -Engines mit Spitzenvolumina von 1,4 Millionen Transaktionen pro Sekunde. 4. Compliance Progress hält 15 Länderlizenzen und legt konforme Einheiten in Europa und den Vereinigten Staaten ein.

Worldcoin (WLD) Preisprognose 2025-2031: Wird WLD bis 2031 $ erreichen?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) Preisprognose 2025-2031: Wird WLD bis 2031 $ erreichen?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) fällt auf dem Kryptowährungsmarkt mit seinen einzigartigen biometrischen Überprüfungs- und Datenschutzschutzmechanismen auf, die die Aufmerksamkeit vieler Investoren auf sich ziehen. WLD hat mit seinen innovativen Technologien, insbesondere in Kombination mit OpenAI -Technologie für künstliche Intelligenz, außerdem unter Altcoins gespielt. Aber wie werden sich die digitalen Vermögenswerte in den nächsten Jahren verhalten? Lassen Sie uns den zukünftigen Preis von WLD zusammen vorhersagen. Die Preisprognose von 2025 WLD wird voraussichtlich im Jahr 2025 ein signifikantes Wachstum in WLD erzielen. Die Marktanalyse zeigt, dass der durchschnittliche WLD -Preis 1,31 USD mit maximal 1,36 USD erreichen kann. In einem Bärenmarkt kann der Preis jedoch auf rund 0,55 US -Dollar fallen. Diese Wachstumserwartung ist hauptsächlich auf Worldcoin2 zurückzuführen.

Rangliste der Hebelbörsen im Währungskreis Die neuesten Empfehlungen der zehn meistgezogenen Börsen im Währungskreis

Apr 21, 2025 pm 11:24 PM

Rangliste der Hebelbörsen im Währungskreis Die neuesten Empfehlungen der zehn meistgezogenen Börsen im Währungskreis

Apr 21, 2025 pm 11:24 PM

Die Plattformen, die im Jahr 2025 im Leveraged Trading, Security und Benutzererfahrung hervorragende Leistung haben, sind: 1. OKX, geeignet für Hochfrequenzhändler und bieten bis zu 100-fache Hebelwirkung; 2. Binance, geeignet für Mehrwährungshändler auf der ganzen Welt und bietet 125-mal hohe Hebelwirkung; 3. Gate.io, geeignet für professionelle Derivate Spieler, die 100 -fache Hebelwirkung bietet; 4. Bitget, geeignet für Anfänger und Sozialhändler, die bis zu 100 -fache Hebelwirkung bieten; 5. Kraken, geeignet für stetige Anleger, die fünfmal Hebelwirkung liefert; 6. Bybit, geeignet für Altcoin -Entdecker, die 20 -fache Hebelwirkung bietet; 7. Kucoin, geeignet für kostengünstige Händler, die 10-fache Hebelwirkung bietet; 8. Bitfinex, geeignet für das Seniorenspiel

Was bedeutet Cross-Chain-Transaktion? Was sind die Cross-Chain-Transaktionen?

Apr 21, 2025 pm 11:39 PM

Was bedeutet Cross-Chain-Transaktion? Was sind die Cross-Chain-Transaktionen?

Apr 21, 2025 pm 11:39 PM

Börsen, die Cross-Chain-Transaktionen unterstützen: 1. Binance, 2. Uniswap, 3. Sushiswap, 4. Kurvenfinanzierung, 5. Thorchain, 6. 1inch Exchange, 7. DLN-Handel, diese Plattformen unterstützen Multi-Chain-Asset-Transaktionen durch verschiedene Technologien.

Warum ist der Anstieg oder Abfall der virtuellen Währungspreise? Warum ist der Anstieg oder Abfall der virtuellen Währungspreise?

Apr 21, 2025 am 08:57 AM

Warum ist der Anstieg oder Abfall der virtuellen Währungspreise? Warum ist der Anstieg oder Abfall der virtuellen Währungspreise?

Apr 21, 2025 am 08:57 AM

Faktoren der steigenden Preise für virtuelle Währung sind: 1. Erhöhte Marktnachfrage, 2. Verringertes Angebot, 3.. Rückgangsfaktoren umfassen: 1. Verringerte Marktnachfrage, 2. Erhöhtes Angebot, 3. Streik der negativen Nachrichten, 4. Pessimistische Marktstimmung, 5. makroökonomisches Umfeld.

Top 10 Cryptocurrency Exchange -Plattformen Die weltweit größte Liste der digitalen Währung

Apr 21, 2025 pm 07:15 PM

Top 10 Cryptocurrency Exchange -Plattformen Die weltweit größte Liste der digitalen Währung

Apr 21, 2025 pm 07:15 PM

Börsen spielen eine wichtige Rolle auf dem heutigen Kryptowährungsmarkt. Sie sind nicht nur Plattformen, an denen Investoren handeln, sondern auch wichtige Quellen für Marktliquidität und Preisentdeckung. Der weltweit größte virtuelle Währungsbörsen gehören zu den Top Ten, und diese Börsen sind nicht nur im Handelsvolumen weit voraus, sondern haben auch ihre eigenen Vorteile in Bezug auf Benutzererfahrung, Sicherheit und innovative Dienste. Börsen, die über die Liste stehen, haben normalerweise eine große Benutzerbasis und einen umfangreichen Markteinfluss, und deren Handelsvolumen und Vermögenstypen sind häufig mit anderen Börsen schwer zu erreichen.

Was sind die zehn besten Plattformen im Währungsaustauschkreis?

Apr 21, 2025 pm 12:21 PM

Was sind die zehn besten Plattformen im Währungsaustauschkreis?

Apr 21, 2025 pm 12:21 PM

Zu den Top -Börsen gehören: 1. Binance, das weltweit größte Handelsvolumen, unterstützt 600 Währungen und die Spot -Handhabungsgebühr beträgt 0,1%. 2. OKX, eine ausgewogene Plattform, unterstützt 708 Handelspaare, und die dauerhafte Vertragsabwicklungsgebühr beträgt 0,05%. 3. Gate.io deckt 2700 kleine Währungen ab, und die Gebühr für die Spot-Handhabung beträgt 0,1%-0,3%; 4. Coinbase, der US -Konformitäts -Benchmark, die Spot -Handhabungsgebühr beträgt 0,5%; 5. Kraken, die Top -Sicherheit und regelmäßige Reserveprüfung.

So gewinnen Sie Kernel Airdrop -Belohnungen für Binance vollständige Prozessstrategie

Apr 21, 2025 pm 01:03 PM

So gewinnen Sie Kernel Airdrop -Belohnungen für Binance vollständige Prozessstrategie

Apr 21, 2025 pm 01:03 PM

In der geschäftigen Welt der Kryptowährungen entstehen immer neue Möglichkeiten. Gegenwärtig zieht Kerneldao (Kernel) Airdrop -Aktivität viel Aufmerksamkeit auf sich und zieht die Aufmerksamkeit vieler Investoren auf sich. Also, was ist der Ursprung dieses Projekts? Welche Vorteile können BNB -Inhaber davon bekommen? Machen Sie sich keine Sorgen, das Folgende wird es einzeln für Sie enthüllen.