Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

In den nächsten zehn Jahren wird sich die KI-Spracherkennung in diese fünf Richtungen entwickeln

In den nächsten zehn Jahren wird sich die KI-Spracherkennung in diese fünf Richtungen entwickeln

In den nächsten zehn Jahren wird sich die KI-Spracherkennung in diese fünf Richtungen entwickeln

Autor |. Migüel Jetté

Zusammengestellt |. bluemin

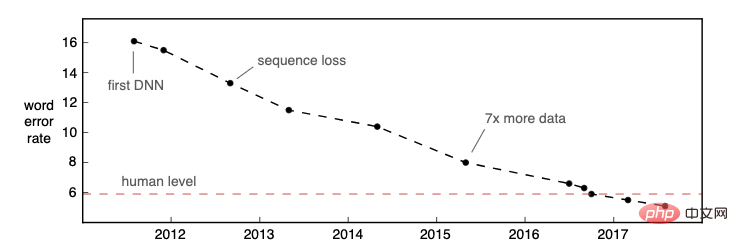

Herausgeber |. Die automatische Spracherkennung (Automatic Speech Recognition, ASR) hat in den letzten zwei Jahren wichtige Fortschritte gemacht: Mehrere ASR-Modelle auf Unternehmensebene, die vollständig auf neuronalen Netzen basieren, wurden erfolgreich eingeführt, z. B. Alexa, Rev, AssemblyAI, ASAPP usw. Im Jahr 2016 veröffentlichte Microsoft Research einen Artikel, in dem bekannt gegeben wurde, dass ihr Modell auf dem 25 Jahre alten Datensatz „Switchboard“ die Leistung eines Menschen erreicht hat (gemessen an der Wortfehlerrate). Die ASR-Genauigkeit verbessert sich weiter und erreicht bei immer mehr Datensätzen und Anwendungsfällen eine Leistung auf menschlichem Niveau.

Bildquelle: Awni Hannuns Blogbeitrag „Spracherkennung ist nicht gelöst“

Bildquelle: Awni Hannuns Blogbeitrag „Spracherkennung ist nicht gelöst“

Da sich die Erkennungsgenauigkeit der ASR-Technologie erheblich verbessert hat und die Anwendungsszenarien immer zahlreicher geworden sind, glauben wir: Jetzt ist es nicht so Der Höhepunkt der kommerziellen Nutzung von ASR ist noch nicht erreicht. Forschung und Marktanwendungen in diesem Bereich müssen noch erforscht werden. Wir gehen davon aus, dass sich KI-Sprachforschung und kommerzielle Systeme in den nächsten zehn Jahren auf die folgenden fünf Bereiche konzentrieren werden:

1. Mehrsprachiges ASR-Modell

„In den nächsten zehn Jahren werden wir echte ASR-Modelle einsetzen.“ in Produktionsumgebungen Mehrsprachige Modelle, die es Entwicklern ermöglichen, Anwendungen zu erstellen, die jeder in jeder Sprache verstehen kann, wodurch die Leistungsfähigkeit der Spracherkennung wirklich für die Welt freigesetzt wird.

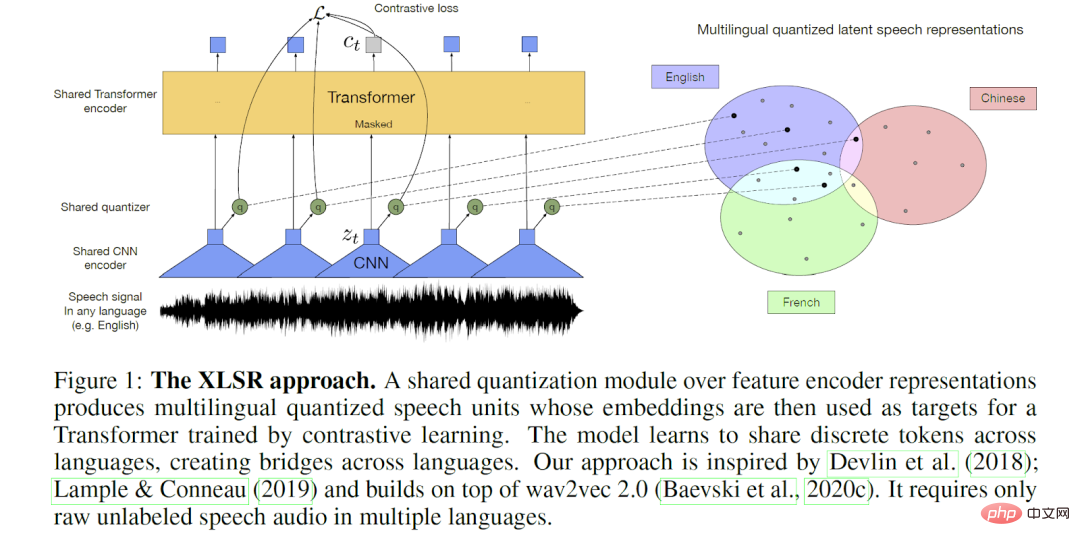

Quelle: Alexis Conneau et al Repräsentationslernen für die Spracherkennung“-Papier

Quelle: Alexis Conneau et al Repräsentationslernen für die Spracherkennung“-Papier

Heutige kommerzielle ASR-Modelle verwenden hauptsächlich englische Datensätze für das Training, sodass sie eine höhere Genauigkeit für die englische Eingabe aufweisen. Aufgrund der Datenverfügbarkeit und der Marktnachfrage besteht in Wissenschaft und Industrie langfristig ein größeres Interesse an Englisch. Obwohl die Erkennungsgenauigkeit beliebter kommerzieller Sprachen wie Französisch, Spanisch, Portugiesisch und Deutsch ebenfalls angemessen ist, gibt es eindeutig eine lange Reihe von Sprachen mit begrenzten Trainingsdaten und relativ geringer ASR-Ausgabequalität.

Darüber hinaus basieren die meisten Geschäftssysteme auf einer einzigen Sprache, was nicht auf die mehrsprachigen Szenarien angewendet werden kann, die in vielen Gesellschaften einzigartig sind. Mehrsprachigkeit kann die Form von aufeinanderfolgenden Sprachen annehmen, beispielsweise bei der Medienprogrammierung in zweisprachigen Ländern. Amazon hat bei der Bewältigung dieses Problems große Fortschritte gemacht, indem es kürzlich ein Produkt auf den Markt gebracht hat, das Spracherkennung (LID) und ASR integriert. Im Gegensatz dazu ist Translanguaging (auch Code-Switching genannt) ein Sprachsystem, das von einer Person verwendet wird, um Wörter und Grammatik aus zwei Sprachen in demselben Satz zu kombinieren. Dies ist ein Bereich, in dem die Wissenschaft weiterhin interessante Fortschritte macht.

So wie der Bereich der Verarbeitung natürlicher Sprache einen mehrsprachigen Ansatz verfolgt, werden wir im nächsten Jahrzehnt erleben, wie ASR diesem Beispiel folgt. Während wir lernen, neue End-to-End-Technologien zu nutzen, werden wir groß angelegte mehrsprachige Modelle trainieren, die das Lernen zwischen mehreren Sprachen übertragen können. Metas XLS-R ist ein gutes Beispiel: In einer Demo könnten Benutzer jede von 21 Sprachen sprechen, ohne eine Sprache anzugeben, und das Modell würde schließlich ins Englische übersetzen. Durch das Verständnis und die Anwendung von Ähnlichkeiten zwischen Sprachen werden diese intelligenteren ASR-Systeme eine qualitativ hochwertige ASR-Verfügbarkeit für ressourcenarme Sprach- und gemischtsprachige Anwendungsfälle bieten und kommerzielle Anwendungen ermöglichen.

2. Umfangreiche standardisierte Ausgabeobjekte

„Wir gehen davon aus, dass kommerzielle ASR-Systeme im nächsten Jahrzehnt umfangreichere Transkriptionsobjekte ausgeben werden, die mehr als nur einfache Wörter enthalten.“ von Standardisierungsgremien wie dem W3C, sodass alle APIs ähnlich aufgebaute Ausgaben zurückgeben Tradition, „reiche Transkription“ zu erforschen, aber die Bemühungen, sie in standardisierte und skalierbare Formate für die ASR-Ausgabe zu integrieren, sind noch relativ oberflächlich. Das Konzept der reichhaltigen Transkription umfasste zunächst Groß- und Kleinschreibung, Interpunktion und Tagebuchführung, wurde jedoch in gewissem Maße auf Sprecherrollen und eine Reihe nonverbaler Sprachereignisse ausgeweitet. Zu den erwarteten Innovationen gehören die Transkription überlappender Sprache verschiedener Sprecher, verschiedener Emotionen und anderer paralinguistischer Merkmale sowie einer Reihe nonverbaler und sogar nichtmenschlicher Sprachszenen und -ereignisse sowie die Transkription textbasierter oder sprachlicher Vielfalt. Tanaka et al. stellen ein Szenario dar, in dem ein Benutzer möglicherweise zwischen Transkriptionsoptionen unterschiedlicher Fülle wählen möchte und offensichtlich die Menge und Art der zusätzlichen Informationen, die wir vorhersagen, abhängig von der nachgelagerten Anwendung spezifizierbar ist.

Herkömmliche ASR-Systeme sind in der Lage, bei der Erkennung gesprochener Wörter ein Raster aus mehreren Hypothesen zu generieren, was sich bei der vom Menschen unterstützten Transkription, gesprochenen Dialogsystemen und dem Informationsabruf als sehr nützlich erwiesen hat. Durch die Einbeziehung der n-besten Informationen in ein umfangreiches Ausgabeformat werden mehr Benutzer dazu ermutigt, das ASR-System zu verwenden, wodurch die Benutzererfahrung verbessert wird. Während es derzeit keinen Standard für die Strukturierung und Speicherung der zusätzlichen Informationen gibt, die derzeit oder möglicherweise bei der Sprachdekodierung generiert werden, ist der Open Speech Transcription Standard (OVTS) von CallMiner ein solider Schritt in diese Richtung, der es Unternehmen erleichtert, mehrere ASR-Anbieter zu erkunden und auszuwählen.

Wir gehen davon aus, dass ASR-Systeme in Zukunft eine umfangreichere Ausgabe in Standardformaten erzeugen werden, was leistungsfähigere nachgelagerte Anwendungen ermöglicht. Beispielsweise könnte ein ASR-System den gesamten Satz möglicher Netze ausgeben und eine Anwendung könnte diese zusätzlichen Daten verwenden, um beim Bearbeiten des Transkripts eine intelligente automatisierte Transkription durchzuführen. Ebenso können ASR-Transkriptionen, die zusätzliche Metadaten wie erkannte regionale Dialekte, Akzente, Umgebungsgeräusche oder Stimmung enthalten, leistungsfähigere Suchanwendungen ermöglichen.

3. Groß angelegte ASR für alle

„In diesem Jahrzehnt wird groß angelegte ASR (d. h. privatisiert, erschwinglich, zuverlässig und schnell) Teil des täglichen Lebens aller sein in der Lage zu sein, nach Videos zu suchen, alle Medieninhalte zu indizieren, an denen wir teilnehmen, und jedes Video für hörgeschädigte Verbraucher auf der ganzen Welt zugänglich zu machen. ASR wird der Schlüssel dazu sein, jedes Audio und Video zugänglich und umsetzbar zu machen

Möglicherweise nutzen wir alle häufig Audio- und Videosoftware: Podcasts, Social-Media-Streaming, Online-Videos, Echtzeit-Gruppenchats, Zoom-Meetings usw. Dennoch werden nur sehr wenige relevante Inhalte tatsächlich transkribiert. Heutzutage ist die Inhaltstranskription zu einem der größten Märkte für ASR-APIs geworden und wird im nächsten Jahrzehnt exponentiell wachsen, insbesondere angesichts ihrer Genauigkeit und Erschwinglichkeit. Allerdings wird die ASR-Transkription derzeit nur für bestimmte Anwendungen (Videoübertragungen, bestimmte Konferenzen und Podcasts usw.) verwendet. Dies hat zur Folge, dass viele Menschen nicht auf diese Medieninhalte zugreifen können und nach einer Übertragung oder Veranstaltung Schwierigkeiten haben, relevante Informationen zu finden.

Möglicherweise nutzen wir alle häufig Audio- und Videosoftware: Podcasts, Social-Media-Streaming, Online-Videos, Echtzeit-Gruppenchats, Zoom-Meetings usw. Dennoch werden nur sehr wenige relevante Inhalte tatsächlich transkribiert. Heutzutage ist die Inhaltstranskription zu einem der größten Märkte für ASR-APIs geworden und wird im nächsten Jahrzehnt exponentiell wachsen, insbesondere angesichts ihrer Genauigkeit und Erschwinglichkeit. Allerdings wird die ASR-Transkription derzeit nur für bestimmte Anwendungen (Videoübertragungen, bestimmte Konferenzen und Podcasts usw.) verwendet. Dies hat zur Folge, dass viele Menschen nicht auf diese Medieninhalte zugreifen können und nach einer Übertragung oder Veranstaltung Schwierigkeiten haben, relevante Informationen zu finden.

In Zukunft wird sich diese Situation ändern. Wie Matt Thompson 2010 vorhersagte, wird ASR irgendwann billig und so weit verbreitet sein, dass wir das erleben werden, was er „Sprechbarkeit“ nannte. Wir gehen davon aus, dass in Zukunft fast alle Audio- und Videoinhalte transkribiert und in großem Umfang sofort zugänglich, speicherbar und durchsuchbar gemacht werden. Aber die Entwicklung von ASR wird hier nicht aufhören, wir hoffen auch, dass diese Inhalte umsetzbar sind. Wir hoffen, dass jedes konsumierte oder genutzte Audio- und Videomaterial zusätzlichen Kontext bietet, beispielsweise automatisch generierte Erkenntnisse aus einem Podcast oder einer Konferenz oder eine automatische Zusammenfassung wichtiger Momente im Video usw. Wir hoffen, dass NLP-Systeme die oben genannte Verarbeitung routinemäßig durchführen können.

In Zukunft wird der Mensch das ASR-Training mit intelligenten Mitteln effizient überwachen und eine immer wichtigere Rolle bei der Beschleunigung des maschinellen Lernens spielen. Human-in-the-Loop-Ansätze versetzen menschliche Prüfer in die maschinelle Lern-/Feedback-Schleife und ermöglichen so eine kontinuierliche Überprüfung und Anpassung der Modellergebnisse. Dadurch wird maschinelles Lernen schneller und effizienter, was zu einer qualitativ hochwertigeren Ausgabe führt. Anfang dieses Jahres haben wir darüber gesprochen, wie Verbesserungen an ASR es den menschlichen Transkriptoren von Rev (genannt „Revvers“) ermöglichen würden, ASR-Entwürfe nachzubearbeiten und sie dadurch produktiver zu machen. Die Transkription von Revver kann direkt in das verbesserte ASR-Modell eingegeben werden und bildet so einen positiven Kreislauf.

Ein Bereich, in dem menschliche Sprachexperten nach wie vor ein integraler Bestandteil von ASR sind, ist die inverse Textnormalisierung (ITN), bei der sie erkannte Zeichenfolgen (wie „fünf Dollar“) in ihre erwartete geschriebene Form (wie „$5“) umwandeln. Pusateri et al. schlugen einen hybriden Ansatz unter Verwendung „handgefertigter Grammatik und statistischer Modelle“ vor, und Zhang et al. fuhren in dieser Richtung fort, indem sie RNNs mit handgefertigten FSTs einschränkten.

5. Verantwortungsvolles ASR

„Wie alle Systeme der künstlichen Intelligenz werden sich zukünftige ASR-Systeme an strengere ethische Grundsätze der künstlichen Intelligenz halten, sodass das System alle gleich behandelt und ein höheres Maß an Erklärbarkeit für ihre Entscheidungen bietet.“ und respektieren Sie die Privatsphäre der Benutzer und ihrer Daten.“

Fairness: Ein faires ASR-System kann Sprache unabhängig vom Hintergrund, dem sozioökonomischen Status oder anderen Merkmalen des Sprechers erkennen. Es ist erwähnenswert, dass der Aufbau eines solchen Systems die Identifizierung und Reduzierung von Verzerrungen in unseren Modellen und Trainingsdaten erfordert. Glücklicherweise arbeiten Regierungen, NGOs und Unternehmen bereits daran, die Infrastruktur zu schaffen, um Voreingenommenheit zu erkennen und abzumildern.

Das obige ist der detaillierte Inhalt vonIn den nächsten zehn Jahren wird sich die KI-Spracherkennung in diese fünf Richtungen entwickeln. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

Beherrschen Sie die Koordinatensystemkonvertierung wirklich? Multisensorik-Themen, die für das autonome Fahren unverzichtbar sind

Oct 12, 2023 am 11:21 AM

Beherrschen Sie die Koordinatensystemkonvertierung wirklich? Multisensorik-Themen, die für das autonome Fahren unverzichtbar sind

Oct 12, 2023 am 11:21 AM

Der erste Pilot- und Schlüsselartikel stellt hauptsächlich mehrere häufig verwendete Koordinatensysteme in der autonomen Fahrtechnologie vor und erläutert, wie die Korrelation und Konvertierung zwischen ihnen abgeschlossen und schließlich ein einheitliches Umgebungsmodell erstellt werden kann. Der Schwerpunkt liegt hier auf dem Verständnis der Umrechnung vom Fahrzeug in den starren Kamerakörper (externe Parameter), der Kamera-in-Bild-Konvertierung (interne Parameter) und der Bild-in-Pixel-Einheitenkonvertierung. Die Konvertierung von 3D in 2D führt zu entsprechenden Verzerrungen, Verschiebungen usw. Wichtige Punkte: Das Fahrzeugkoordinatensystem und das Kamerakörperkoordinatensystem müssen neu geschrieben werden: Das Ebenenkoordinatensystem und das Pixelkoordinatensystem. Schwierigkeit: Sowohl die Entzerrung als auch die Verzerrungsaddition müssen auf der Bildebene kompensiert werden. 2. Einführung Insgesamt gibt es vier visuelle Systeme Koordinatensystem: Pixelebenenkoordinatensystem (u, v), Bildkoordinatensystem (x, y), Kamerakoordinatensystem () und Weltkoordinatensystem (). Es gibt eine Beziehung zwischen jedem Koordinatensystem,

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.

Was sind die fünf profitabelsten Bereiche der Self-Media? In welche Richtung wird Douyins Unterstützung im Jahr 2024 gehen?

Mar 22, 2024 am 10:11 AM

Was sind die fünf profitabelsten Bereiche der Self-Media? In welche Richtung wird Douyins Unterstützung im Jahr 2024 gehen?

Mar 22, 2024 am 10:11 AM

Mit der rasanten Entwicklung des Internets ist die Self-Media-Branche in den Fokus immer mehr Menschen gerückt. In dieser Branche haben einige Bereiche aufgrund ihrer breiten Marktaussichten und Rentabilität große Aufmerksamkeit erregt. In diesem Artikel werden Ihnen die fünf profitabelsten Bereiche der Selbstmedien vorgestellt und die Richtung der Unterstützung von Douyin im Jahr 2024 besprochen, damit Sie die Entwicklungschancen der Selbstmedien besser nutzen können. 1. Was sind die fünf profitabelsten Bereiche der Self-Media? Mit dem Aufkommen der Online-Bildung erfreut sich der Bereich der allgemeinen und beruflichen Bildung immer größerer Beliebtheit. Die Menschen sind bereit, in den Erwerb von Wissen und Fähigkeiten zu investieren, nicht nur in akademische Kurse, sondern auch in die Qualifizierung und berufliche Weiterentwicklung. Self-Media-Ersteller können Gewinne erzielen, indem sie hochwertige Bildungsinhalte erstellen, um Studenten dazu zu bewegen, für das Lernen zu zahlen. Dieser Trend zeigt, dass die Menschen an lebenslangem Lernen interessiert sind

Das erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation

Oct 23, 2023 am 11:13 AM

Das erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation

Oct 23, 2023 am 11:13 AM

Einige persönliche Gedanken des Autors Im Bereich des autonomen Fahrens sind mit der Entwicklung BEV-basierter Teilaufgaben/End-to-End-Lösungen hochwertige Multi-View-Trainingsdaten und der entsprechende Aufbau von Simulationsszenen immer wichtiger geworden. Als Reaktion auf die Schwachstellen aktueller Aufgaben kann „hohe Qualität“ in drei Aspekte zerlegt werden: Long-Tail-Szenarien in verschiedenen Dimensionen: z. B. Nahbereichsfahrzeuge in Hindernisdaten und präzise Kurswinkel beim Schneiden von Autos sowie Spurliniendaten . Szenen wie Kurven mit unterschiedlichen Krümmungen oder Rampen/Zusammenführungen/Zusammenführungen, die schwer zu erfassen sind. Diese basieren häufig auf der Sammlung großer Datenmengen und komplexen Data-Mining-Strategien, die kostspielig sind. Echter 3D-Wert – hochkonsistentes Bild: Die aktuelle BEV-Datenerfassung wird häufig durch Fehler bei der Sensorinstallation/-kalibrierung, hochpräzisen Karten und dem Rekonstruktionsalgorithmus selbst beeinträchtigt. das hat mich dazu geführt

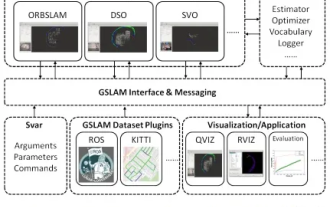

GSLAM |. Eine allgemeine SLAM-Architektur und ein Benchmark

Oct 20, 2023 am 11:37 AM

GSLAM |. Eine allgemeine SLAM-Architektur und ein Benchmark

Oct 20, 2023 am 11:37 AM

Plötzlich wurde ein 19 Jahre altes Papier namens GSLAM: A General SLAM Framework and Benchmark mit offenem Quellcode entdeckt: https://github.com/zdzhaoyong/GSLAM Gehen Sie direkt zum Volltext und spüren Sie die Qualität dieser Arbeit~1 Zusammenfassung der SLAM-Technologie hat in letzter Zeit viele Erfolge erzielt und die Aufmerksamkeit vieler High-Tech-Unternehmen auf sich gezogen. Es bleibt jedoch eine Frage, wie eine Schnittstelle zu bestehenden oder neuen Algorithmen hergestellt werden kann, um ein Benchmarking hinsichtlich Geschwindigkeit, Robustheit und Portabilität effizient durchzuführen. In diesem Artikel wird eine neue SLAM-Plattform namens GSLAM vorgeschlagen, die nicht nur Evaluierungsfunktionen bietet, sondern Forschern auch eine nützliche Möglichkeit bietet, schnell ihre eigenen SLAM-Systeme zu entwickeln.

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

Bitte beachten Sie, dass dieser kantige Mann die Stirn runzelt und über die Identität der „ungebetenen Gäste“ vor ihm nachdenkt. Es stellte sich heraus, dass sie sich in einer gefährlichen Situation befand, und als ihr dies klar wurde, begann sie schnell mit der mentalen Suche nach einer Strategie zur Lösung des Problems. Letztendlich entschloss sie sich, vom Unfallort zu fliehen, dann so schnell wie möglich Hilfe zu suchen und sofort Maßnahmen zu ergreifen. Gleichzeitig dachte die Person auf der Gegenseite das Gleiche wie sie... In „Minecraft“ gab es eine solche Szene, in der alle Charaktere von künstlicher Intelligenz gesteuert wurden. Jeder von ihnen hat eine einzigartige Identität. Das zuvor erwähnte Mädchen ist beispielsweise eine 17-jährige, aber kluge und mutige Kurierin. Sie haben die Fähigkeit, sich zu erinnern und zu denken und in dieser kleinen Stadt in Minecraft wie Menschen zu leben. Was sie antreibt, ist ein brandneues,