In den letzten Jahren gab es viele interessante Entwicklungen im Bereich der Robotik, wie zum Beispiel Roboterhunde, die tanzen und Fußball spielen können, zweibeinige Roboter, die Dinge bewegen#🎜 🎜 #. Typischerweise sind diese Roboter darauf angewiesen, Kontrollstrategien auf der Grundlage sensorischer Eingaben zu generieren. Obwohl dieser Ansatz die Herausforderungen der Entwicklung von Modulen zur Zustandsschätzung, der Modellierung von Objekteigenschaften und der Optimierung der Controller-Verstärkungen vermeidet, erfordert er erhebliches Fachwissen auf diesem Gebiet. Trotz großer Fortschritte erschweren Lernengpässe es Robotern, willkürliche Aufgaben auszuführen und allgemeine Ziele zu erreichen.

Um den Schlüssel zum Roboterlernen zu verstehen, lautet eine Kernfrage: Wie sammeln wir Trainingsdaten für Roboter? Ein Ansatz besteht darin, Daten über den Roboter durch eine selbstüberwachte Datenerfassungsstrategie zu sammeln. Obwohl dieser Ansatz relativ robust ist, erfordert er oft Tausende von Stunden Dateninteraktion mit der realen Welt, selbst für relativ einfache betriebliche Aufgaben. Die andere besteht darin, anhand simulierter Daten zu trainieren und diese dann auf reale Roboter zu übertragen (Sim2Real). Dadurch können Roboter komplexe Roboterverhalten um Größenordnungen schneller erlernen. Allerdings erfordert die Einrichtung einer simulierten Roboterumgebung und die Festlegung von Simulatorparametern häufig umfassende Fachkenntnisse.

Um Trainingsdaten zu sammeln, können Sie auch menschliche Lehrer bitten, Demonstrationen durchzuführen, und dann den Roboter trainieren, menschliche Demonstrationen schnell nachzuahmen . Dieser Nachahmungsansatz hat in letzter Zeit großes Potenzial bei einer Vielzahl anspruchsvoller betrieblicher Probleme gezeigt. Die meisten dieser Arbeiten weisen jedoch eine grundlegende Einschränkung auf: Es ist schwierig, qualitativ hochwertige Demonstrationsdaten für Roboter zu sammeln.

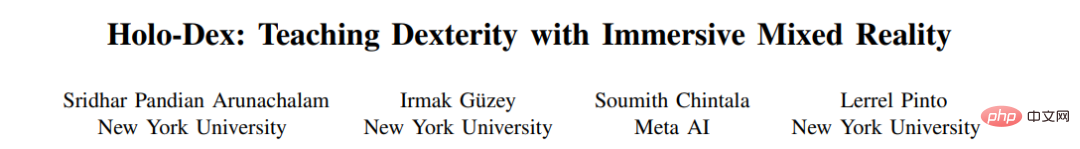

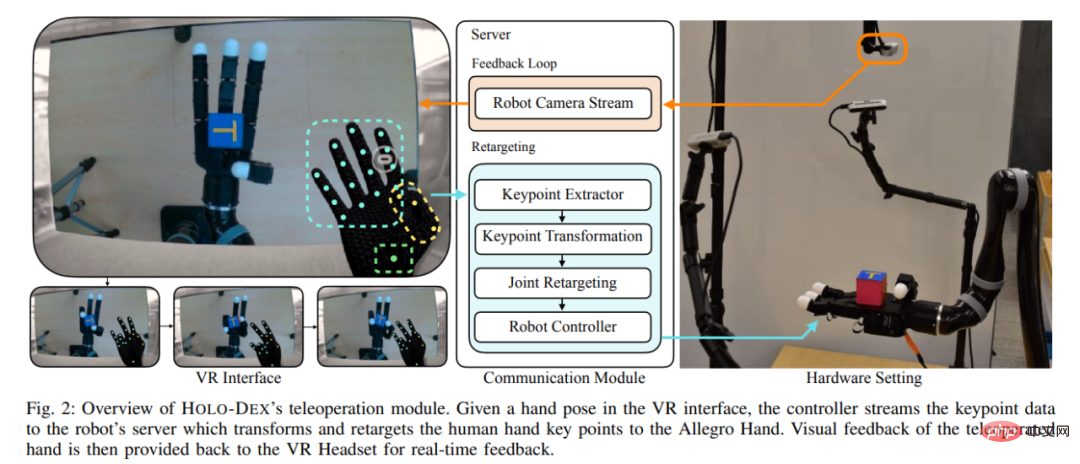

Auf der Grundlage der oben genannten Probleme schlugen Forscher der New York University und Meta AI HOLO-DEX vor, ein neues Framework zum Sammeln von Demonstrationsdaten und zum Training geschickter Roboter. Es verwendet ein VR-Headset (wie das Quest 2), um menschliche Lehrer in eine immersive virtuelle Welt zu versetzen. In dieser virtuellen Welt können Lehrer durch seine Augen sehen, was der Roboter „sieht“, und den Allegro-Manipulator über eingebaute Posendetektoren steuern.

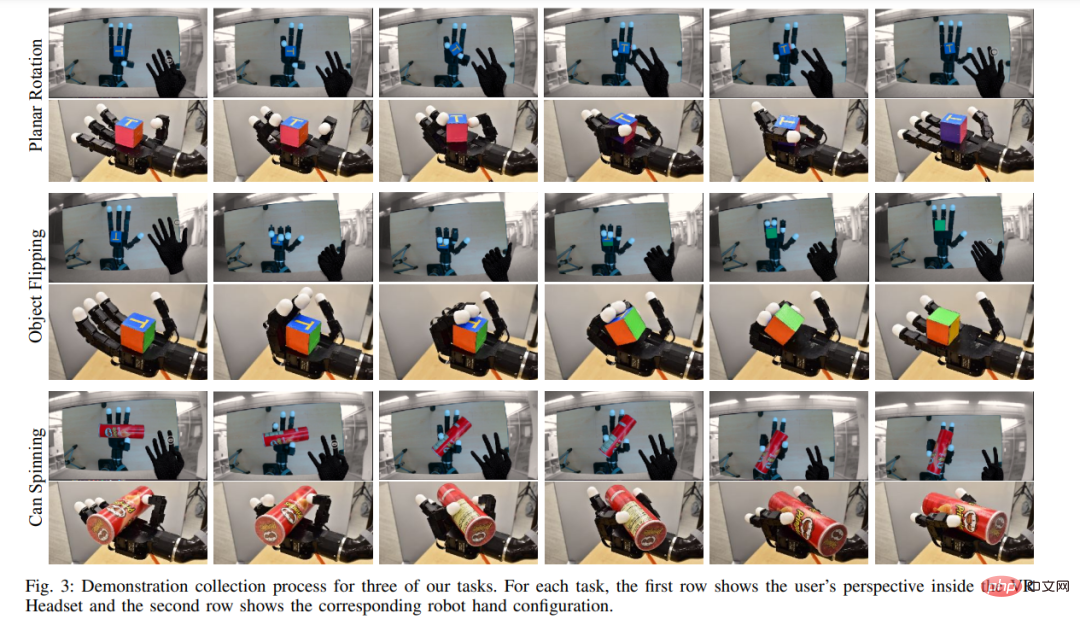

Es sieht aus, als würde ein Mensch dem Roboter beibringen, die Bewegungen „Schritt für Schritt“ auszuführen:

HOLODEX ermöglicht es Menschen, Robotern durch ein Beobachtungs-Feedback-System mit geringer Latenz nahtlos hochwertige Demonstrationsdaten bereitzustellen, was die folgenden drei Vorteile bietet: # 🎜🎜##🎜 🎜#

Im Vergleich zu selbstüberwachten Datenerfassungsmethoden basiert HOLODEX auf leistungsstarker Nachahmungslerntechnologie und kann ohne Belohnungsmechanismus schnell trainiert werden; #🎜🎜 #Im Vergleich zur Sim2Real-Methode können die erlernten Strategien direkt auf realen Robotern ausgeführt werden, da sie auf realen Daten trainiert werden; Mit HOLODEX werden die Anforderungen an Domänenkenntnisse erheblich reduziert und es ist lediglich die Bedienung von VR-Geräten durch Mitarbeiter erforderlich. Projektlink: https://holo-dex.github.io/

Code-Link: https://github.com/SridharPandian/Holo-Dex

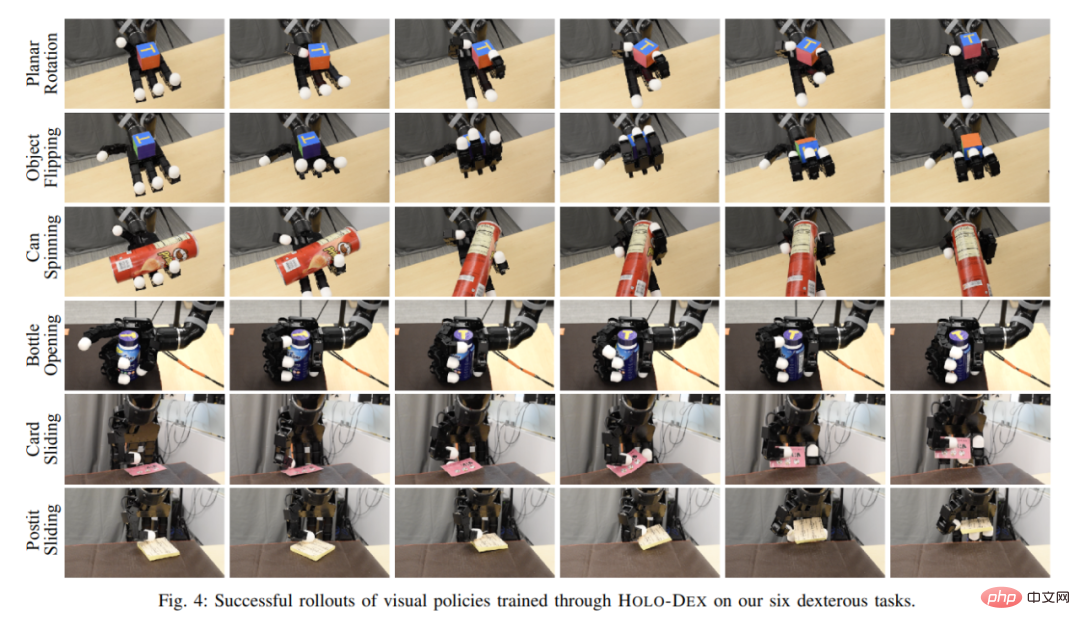

#🎜🎜 #Um die Leistung von HOLO-DEX zu bewerten, führte die Studie Experimente zu sechs Aufgaben durch, die Geschicklichkeit erfordern, darunter das Halten von Gegenständen, das Abschrauben von Flaschenverschlüssen mit einer Hand usw. Die Studie ergab, dass menschliche Lehrer, die HOLO-DEX verwenden, 1,8-mal schneller waren als frühere Arbeiten zur Einzelbild-Teleoperation (Teleoperation). Bei 4/6 Aufgaben liegt die Erfolgsquote der HOLO-DEX-Lernstrategie bei über 90 %. Darüber hinaus ergab die Studie, dass die durch HOLO-DEX erlernten geschickten Strategien auf neue, unsichtbare Zielobjekte übertragen werden können. Insgesamt umfassen die Beiträge dieser Studie:

Darüber hinaus sind die Mixed-Reality-API, Forschungssammlungsdemonstrationen und Schulungscode im Zusammenhang mit HOLO-DEX Open Source: https://holo-dex.github.io/

Wie in Abbildung 1 unten dargestellt, arbeitet HOLO-DEX in zwei Phasen. In der ersten Phase verwendet ein menschlicher Lehrer ein Virtual-Reality-Headset (VR), um dem Roboter eine Demonstration zu geben. Diese Phase umfasst das Erstellen einer virtuellen Welt für den Unterricht, das Schätzen der Handhaltung des Lehrers, das Verlagern der Handhaltung des Lehrers auf die Roboterhand und schließlich die Steuerung der Roboterhand. Nachdem in der ersten Phase einige Demonstrationen gesammelt wurden, lernt man in der zweiten Phase von HOLO-DEX visuelle Strategien zur Lösung der demonstrierten Aufgaben.

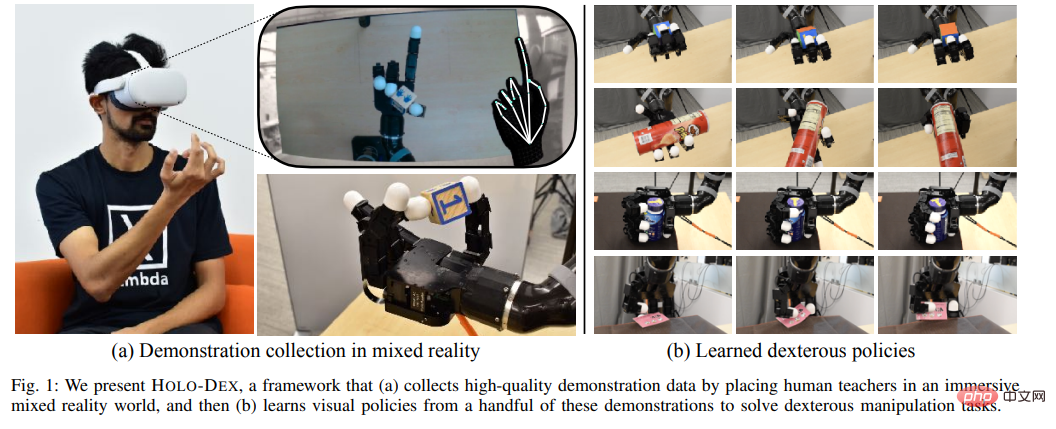

Die Studie versetzte menschliche Lehrer in eine virtuelle Welt, indem sie ein Meta Quest 2 VR-Headset mit einer Auflösung von 1832 × 1920 und einer Bildwiederholfrequenz von 72 Hz verwendeten. Die Basisversion des Headsets kostet 399 US-Dollar und ist mit 503 Gramm relativ leicht, was Präsentationen für Lehrer einfacher und komfortabler macht. Darüber hinaus ermöglicht die API-Schnittstelle von Quest 2 die Erstellung benutzerdefinierter Mixed-Reality-Welten, die Robotersysteme neben Diagnosepanels in VR visualisieren.

Im Vergleich zu früheren Arbeiten zur geschickten Teleoperation bietet die Verwendung von VR-Headsets drei Vorteile bei der Handhaltungsschätzung für menschliche Lehrer. Erstens: Da Quest 2 vier Monochromkameras verwendet, ist sein Gestenschätzer viel leistungsfähiger als der Einzelkameraschätzer. Zweitens sind die Kameras intern kalibriert und erfordern daher nicht die speziellen Kalibrierungsverfahren, die in früheren Multikamera-Teleoperations-Frameworks erforderlich waren. Drittens ist der Handposenschätzer in das Gerät integriert und kann Posen in Echtzeit mit 72 Hz übertragen. Frühere Untersuchungen haben gezeigt, dass eine große Herausforderung bei der geschickten Teleoperation darin besteht, Handgesten mit hoher Genauigkeit und Häufigkeit zu erfassen. HOLO-DEX vereinfacht dieses Problem erheblich, indem es ein VR-Headset in kommerzieller Qualität verwendet.

Als nächstes muss die aus VR extrahierte Handhaltung des Lehrers auf die Roboterhand umgestellt werden. Dabei werden zunächst die Winkel jedes Gelenks der Hand des Lehrers berechnet. Anschließend besteht eine direkte Neuausrichtungsmethode darin, den Gelenken des Roboters zu „befehlen“, sich in die entsprechenden Winkel zu bewegen. Diese Methode funktionierte bei allen Fingern in der Studie außer dem Daumen, aber die Form der Allegro-Roboterhand stimmt nicht genau mit der des Menschen überein, sodass die Methode nicht vollständig mit dem Daumen funktioniert.

Um dieses Problem zu lösen, ordnet diese Studie die räumlichen Koordinaten der Daumenspitze des Lehrers der Daumenspitze des Roboters zu und berechnet dann den Gelenkwinkel des Daumens mithilfe eines inversen Kinematiklösers. Es ist zu beachten, dass der Winkel des kleinen Fingers des Lehrers in der Studie ignoriert wurde, da der Allegro-Manipulator keinen kleinen Finger hat.

Der gesamte Haltungsumleitungsprozess erfordert keine Kalibrierung oder lehrerspezifische Anpassungen, um Demos zu sammeln. Die Studie ergab jedoch, dass die Daumenumleitung verbessert werden könnte, indem eine spezifische Zuordnung vom Daumen des Lehrers zum Daumen des Roboters gefunden würde. Der gesamte Prozess ist rechenintensiv und kann die gewünschte Roboterhandhaltung mit 60 Hz übertragen.

Allegro Hand führt eine asynchrone Steuerung über das ROS-Kommunikationsframework durch. Angesichts der durch das Neuausrichtungsprogramm berechneten Roboter-Handgelenkpositionen verwendet diese Studie einen PD-Controller, um das erforderliche Drehmoment bei 300 Hz auszugeben. Um den stationären Fehler zu reduzieren, verwendet diese Studie ein Schwerkraftkompensationsmodul zur Berechnung des Offset-Drehmoments. In Latenztests ergab die Studie, dass eine Latenz von unter 100 Millisekunden erreicht wurde, wenn sich das VR-Headset im selben lokalen Netzwerk wie die Roboterhand befand. Geringe Latenz und niedrige Fehlerraten sind für HOLO-DEX von entscheidender Bedeutung, da dies eine intuitive Telebedienung der Roboterhand durch einen menschlichen Lehrer ermöglicht.

Wenn menschliche Lehrer die Roboterhand steuern, können sie die Veränderungen des Roboters in Echtzeit (60 Hz) sehen. Dadurch kann der Lehrer Ausführungsfehler der Roboterhand korrigieren. Während des Lehrprozesses zeichnete die Studie Beobachtungsdaten von drei RGBD-Kameras und die Bewegungsinformationen des Roboters mit einer Frequenz von 5 Hz auf. Aufgrund des großen Datenvolumens und der damit verbundenen Bandbreite, die für die Aufzeichnung mehrerer Kameras erforderlich ist, musste die Aufnahmehäufigkeit in der Studie reduziert werden.

Nach dem Sammeln der Daten geht es in die zweite Phase, in der HOLO-DEX die visuelle Strategie anhand der Daten trainieren muss. Diese Studie verwendet den INN-Algorithmus (Nearest Neighbor Imitation) zum Lernen. In früheren Arbeiten wurde gezeigt, dass INN intelligente staatsbasierte Richtlinien für Allegro erstellt. HOLO-DEX geht noch einen Schritt weiter und zeigt, dass sich diese visuellen Strategien bei einer Vielzahl geschickter Manipulationsaufgaben auf neuartige Objekte übertragen lassen.

Um den Lernalgorithmus zum Erhalten niedrigdimensionaler Einbettungen auszuwählen, wurden in dieser Studie mehrere hochmoderne selbstüberwachte Lernalgorithmen ausprobiert und festgestellt, dass BYOL die besten Ergebnisse für den nächsten Nachbarn lieferte. Daher wurde BYOL als ausgewählt die grundlegende selbstüberwachte Lernmethode.

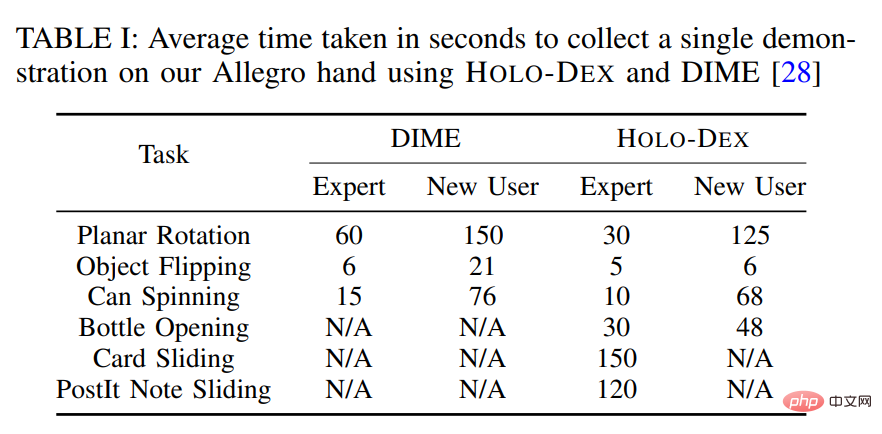

Tabelle 1 unten zeigt, dass HOLO-DEX erfolgreiche Demos 1,8-mal schneller sammelt als DIME. Bei 3/6 Aufgaben, die eine präzise 3D-Bewegung erfordern, ergab die Studie, dass die Einzelbild-Teleoperation nicht einmal ausreichte, um eine einzige Demonstration zu erfassen.

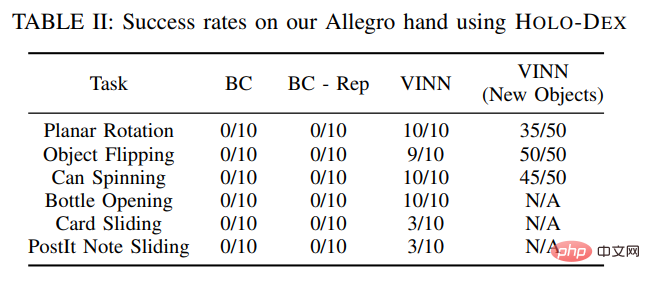

In dieser Studie wurde die Leistung verschiedener Nachahmungslernstrategien bei Geschicklichkeitsaufgaben untersucht. Die Erfolgsraten jeder Aufgabe unter verschiedenen Strategien sind in Tabelle 2 unten aufgeführt.

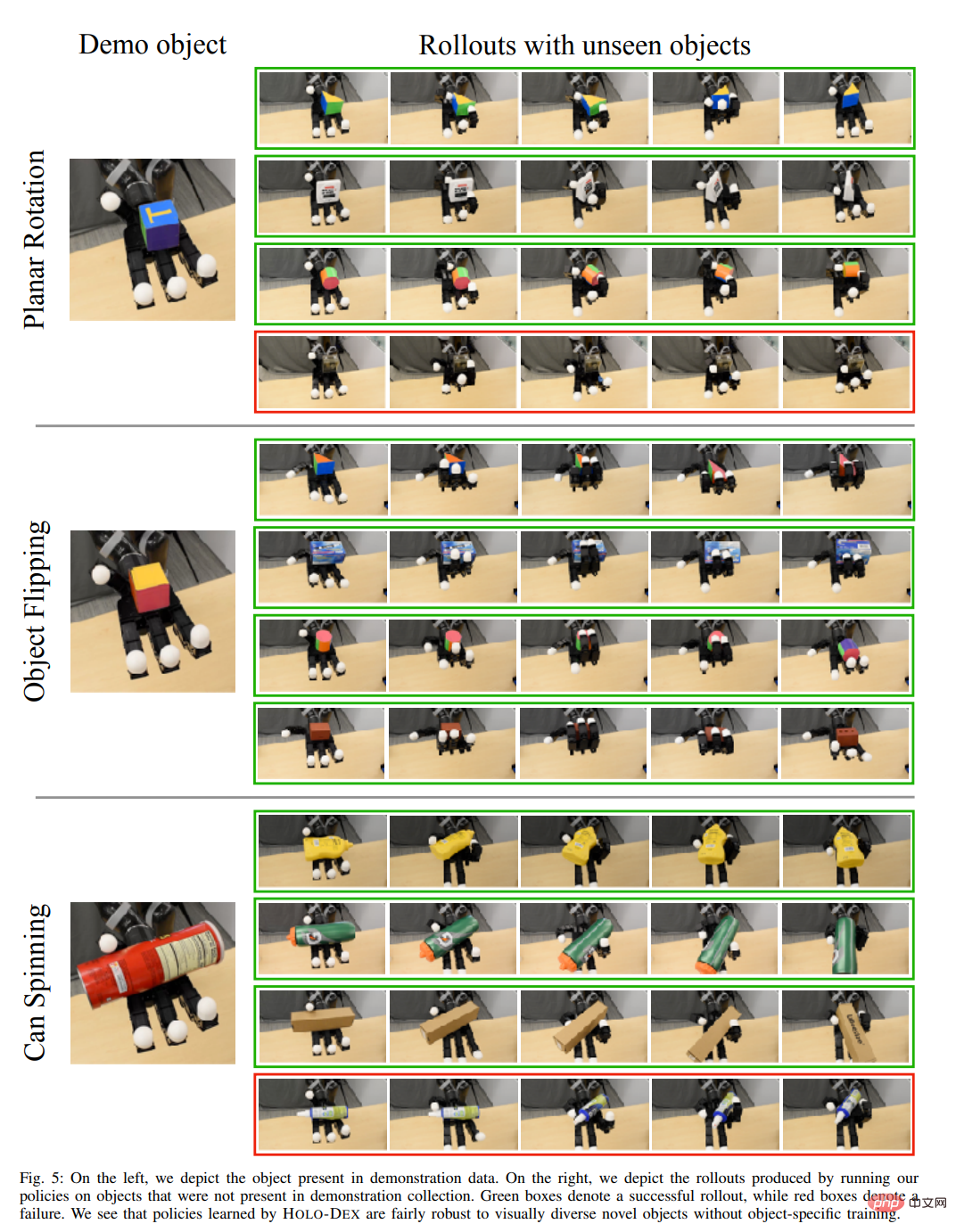

Da die in dieser Studie vorgeschlagenen Strategien visionsbasiert sind und keine explizite Schätzung des Objektzustands erfordern, sind sie mit unsichtbaren Objekten im Training kompatibel. In der Studie wurden die manuellen Manipulationsstrategien bewertet, die darauf trainiert wurden, Ebenendrehungen, Objektspiegelungen und Can-Spin-Aufgaben an Objekten unterschiedlicher visueller Erscheinung und Geometrie durchzuführen, wie in Abbildung 5 unten dargestellt.

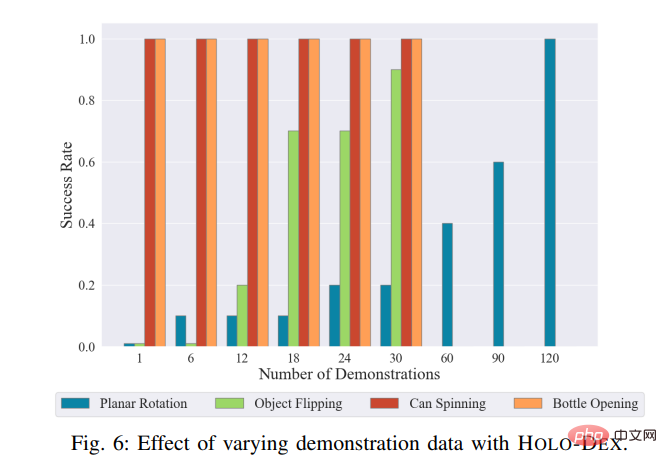

Darüber hinaus testete die Studie auch die Leistung von HOLO-DEX an Datensätzen unterschiedlicher Größe für verschiedene Aufgaben. Die Visualisierungsergebnisse sind in der folgenden Abbildung dargestellt.

Das obige ist der detaillierte Inhalt vonTragen Sie einen VR-Helm, um einem Roboter das Greifen beizubringen, und der Roboter lernt es sofort. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Vollständige Sammlung von SQL-Abfrageanweisungen

Vollständige Sammlung von SQL-Abfrageanweisungen

Lösung für Socket-Fehler 10054

Lösung für Socket-Fehler 10054

Was soll ich tun, wenn die chinesische Neustarteinstellung von vscode nicht wirksam wird?

Was soll ich tun, wenn die chinesische Neustarteinstellung von vscode nicht wirksam wird?

Ist C-Sprache dasselbe wie C++?

Ist C-Sprache dasselbe wie C++?

Was sind die 8 Datentypen von Redis?

Was sind die 8 Datentypen von Redis?

Was bedeutet GPRS-Netzwerk?

Was bedeutet GPRS-Netzwerk?

Verwendung der Update-Anweisung

Verwendung der Update-Anweisung

Linux-Befehl zum Umbenennen von Dateien

Linux-Befehl zum Umbenennen von Dateien

Proxy-Switchysharp

Proxy-Switchysharp