Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Ein Artikel, in dem die Testtechnologie des intelligenten Fahrwahrnehmungssystems ausführlich erläutert wird

Ein Artikel, in dem die Testtechnologie des intelligenten Fahrwahrnehmungssystems ausführlich erläutert wird

Ein Artikel, in dem die Testtechnologie des intelligenten Fahrwahrnehmungssystems ausführlich erläutert wird

Vorwort

Mit der Weiterentwicklung der künstlichen Intelligenz und ihrer Software- und Hardwaretechnologie hat sich das autonome Fahren in den letzten Jahren rasant weiterentwickelt. Autonome Fahrsysteme werden in Fahrerassistenzsystemen für zivile Fahrzeuge, autonomen Logistikrobotern, Drohnen und anderen Bereichen eingesetzt. Die Wahrnehmungskomponente ist das Herzstück des autonomen Fahrsystems, das es dem Fahrzeug ermöglicht, Informationen über die interne und externe Verkehrsumgebung zu analysieren und zu verstehen. Wie andere Softwaresysteme weisen auch Wahrnehmungssysteme für autonomes Fahren jedoch Softwarefehler auf. Darüber hinaus arbeitet das autonome Fahrsystem in sicherheitskritischen Szenarien und seine Softwarefehler können katastrophale Folgen haben. In den letzten Jahren kam es zu zahlreichen Todesfällen und Verletzten durch Defekte an autonomen Fahrsystemen. Die Testtechnologie für autonome Fahrsysteme hat in Wissenschaft und Industrie große Aufmerksamkeit erregt. Unternehmen und Forschungseinrichtungen haben eine Reihe von Technologien und Umgebungen vorgeschlagen, darunter virtuelle Simulationstests, reale Straßentests und kombinierte virtuelle und reale Tests. Aufgrund der Besonderheit der Eingabedatentypen und der Vielfalt der Betriebsumgebungen autonomer Fahrsysteme erfordert die Implementierung dieser Art von Testtechnologie jedoch übermäßige Ressourcen und birgt größere Risiken. Dieser Artikel analysiert kurz den aktuellen Forschungs- und Anwendungsstand von Testmethoden für autonome Fahrwahrnehmungssysteme.

1 Prüfung von Wahrnehmungssystemen für autonomes Fahren

Die Qualitätssicherung von Wahrnehmungssystemen für autonomes Fahren wird immer wichtiger. Das Wahrnehmungssystem muss Fahrzeugen helfen, Informationen über den Straßenzustand automatisch zu analysieren und zu verstehen. Seine Zusammensetzung ist sehr komplex und es ist notwendig, die Zuverlässigkeit und Sicherheit des zu testenden Systems in vielen Verkehrsszenarien vollständig zu testen. Aktuelle Wahrnehmungstests für autonomes Fahren werden hauptsächlich in drei Kategorien unterteilt. Unabhängig von der Art der Testmethode weist sie ein wichtiges Merkmal auf, das sich von herkömmlichen Tests unterscheidet, nämlich die starke Abhängigkeit von Testdaten.

Die erste Art von Tests basiert hauptsächlich auf Software-Engineering-Theorie und formalen Methoden usw. und verwendet den Modellstrukturmechanismus der Implementierung des Wahrnehmungssystems als Einstiegspunkt. Diese Testmethode basiert auf einem umfassenden Verständnis des Betriebsmechanismus und der Systemeigenschaften der autonomen Fahrwahrnehmung. Der Zweck dieses voreingenommenen Wahrnehmungssystemlogiktests besteht darin, die Designfehler des Wahrnehmungsmoduls in den frühen Phasen der Systementwicklung zu entdecken, um die Wirksamkeit des Modellalgorithmus in frühen Systemiterationen sicherzustellen. Basierend auf den Merkmalen des autonomen Fahralgorithmusmodells schlugen die Forscher eine Reihe von Testdatengenerierungen, Testverifizierungsindikatoren, Testbewertungsmethoden und Technologien vor.

Bei der zweiten Art der virtuellen Simulationsmethode zum Testen werden Computer verwendet, um das tatsächliche Verkehrssystem zu abstrahieren und Testaufgaben abzuschließen, einschließlich Systemtests in einer voreingestellten virtuellen Umgebung oder unabhängigen Tests von Wahrnehmungskomponenten. Die Wirkung virtueller Simulationstests hängt von der Realität der virtuellen Umgebung, der Testdatenqualität und der spezifischen Testausführungstechnologie ab. Es ist notwendig, die Wirksamkeit der Konstruktionsmethode der Simulationsumgebung, der Datenqualitätsbewertung und der Testverifizierungstechnologie vollständig zu berücksichtigen. Modelle zur Wahrnehmung der autonomen Fahrumgebung und zur Szenenanalyse stützen sich für das Training und die Testverifizierung auf umfangreiche effektive Verkehrsszenendaten. In- und ausländische Forscher haben zahlreiche Untersuchungen zu Verkehrsszenen und ihrer Technologie zur Datenstrukturgenerierung durchgeführt. Verwenden Sie Methoden wie Datenmutation, Simulations-Engine-Generierung und Spielmodell-Rendering, um virtuelle Testszenendaten zu erstellen, um qualitativ hochwertige Testdaten zu erhalten, und verwenden Sie verschiedene generierte Testdaten für autonome Fahrmodelle sowie zur Datenverstärkung und -verbesserung. Testszenarien und Datengenerierung sind Schlüsseltechnologien. Testfälle müssen umfangreich genug sein, um den Zustandsraum der Testprobe abzudecken. Testproben müssen unter extremen Verkehrsbedingungen generiert werden, um die Sicherheit des Entscheidungsausgabemodells des Systems unter diesen Grenzanwendungsfällen zu testen. Virtuelles Testen kombiniert häufig bestehende Testtheorien und -technologien, um effektive Methoden zur Bewertung und Überprüfung von Testeffekten zu entwickeln.

Die dritte Kategorie umfasst Straßentests von realen Fahrzeugen, die mit autonomen Fahrwahrnehmungssystemen ausgestattet sind, einschließlich voreingestellter Tests in geschlossenen Szenen und Tests des tatsächlichen Straßenzustands. Der Vorteil dieser Art von Tests besteht darin, dass durch Tests in einer realen Umgebung die Gültigkeit der Ergebnisse vollständig gewährleistet werden kann. Diese Art von Methode weist jedoch Schwierigkeiten auf, z. B. Testszenarien, die den unterschiedlichen Anforderungen nur schwer gerecht werden können, Schwierigkeiten beim Erhalten relevanter Verkehrsszenendatenproben, hohe Kosten für die manuelle Annotation realer Straßenerfassungsdaten, ungleichmäßige Annotationsqualität, übermäßige Anforderungen an die Testkilometer usw zu langer Datenerfassungszyklus usw. . Beim manuellen Fahren in gefährlichen Szenarien bestehen Sicherheitsrisiken, und es ist für Tester schwierig, diese Probleme in der realen Welt zu lösen. Gleichzeitig leiden Verkehrsszenendaten auch unter Problemen wie einer einzigen Datenquelle und unzureichender Datenvielfalt, die nicht ausreicht, um die Test- und Verifizierungsanforderungen von Forschern für autonomes Fahren in der Softwareentwicklung zu erfüllen. Dennoch sind Straßentests ein unverzichtbarer Bestandteil traditioneller Autotests und äußerst wichtig für die Wahrnehmungstests beim autonomen Fahren.

Aus Sicht der Testtypen hat das Testen von Wahrnehmungssystemen unterschiedliche Testinhalte für den Fahrzeugentwicklungslebenszyklus. Tests zum autonomen Fahren können in Model-in-the-Loop-Tests (MiL), Software-in-the-Loop-Tests (SiL), Hardware-in-the-Loop-Tests (HiL) und Vehicle-in-the-Loop unterteilt werden (ViL)-Tests usw. Dieser Artikel konzentriert sich auf die SiL- und HiL-bezogenen Teile des Tests des autonomen Fahrwahrnehmungssystems. HiL umfasst Wahrnehmungshardwaregeräte wie Kameras, Lidar und Wahrnehmungsmodule für die Mensch-Computer-Interaktion. SiL verwendet Softwaresimulation, um die von der realen Hardware generierten Daten zu ersetzen. Der Zweck beider Tests besteht darin, die Funktionalität, Leistung, Robustheit und Zuverlässigkeit des autonomen Fahrsystems zu überprüfen. Für bestimmte Testobjekte werden in jeder Entwicklungsphase des Wahrnehmungssystems unterschiedliche Testtypen mit unterschiedlichen Testtechnologien kombiniert, um die entsprechenden Verifizierungsanforderungen zu erfüllen. Aktuelle Informationen zur autonomen Fahrwahrnehmung stammen hauptsächlich aus der Analyse verschiedener Arten von Hauptdaten, einschließlich Bild- (Kamera), Punktwolken- (Lidar) und Fusionswahrnehmungssystemen. In diesem Artikel werden hauptsächlich die Wahrnehmungstests dieser drei Datentypen analysiert.

2 Bildsystemtest für autonomes Fahren

Bilder, die von mehreren Kameratypen gesammelt werden, sind einer der wichtigsten Eingabedatentypen für die Wahrnehmung des autonomen Fahrens. Bilddaten können bei fahrendem Fahrzeug Umgebungsinformationen für die Vorder-, Rundum-, Rück- und Seitenansicht bereitstellen und dem autonomen Fahrsystem dabei helfen, Funktionen wie Straßenmessung, Zielerkennung und -verfolgung sowie automatische Spurwechselanalyse zu erfüllen . Bilddaten liegen in verschiedenen Formaten vor, beispielsweise als RGB-Bilder, semantische Bilder, Tiefenbilder usw. Diese Bildformate haben ihre eigenen Eigenschaften. Beispielsweise verfügen RGB-Bilder über reichhaltigere Farbinformationen, Tiefenschärfebilder enthalten mehr Szenentiefeninformationen und semantische Bilder werden basierend auf der Pixelklassifizierung erhalten, was für Zielerkennungs- und Verfolgungsaufgaben vorteilhafter ist .

Bildbasierte Tests des autonomen Fahrwahrnehmungssystems basieren auf großformatigen, effektiven Verkehrsszenenbildern für das Training und die Testüberprüfung. Allerdings sind die Kosten für die manuelle Kennzeichnung realer Straßenerfassungsdaten hoch, der Datenerfassungszyklus ist zu lang, Gesetze und Vorschriften für manuelles Fahren an gefährlichen Orten sind unvollständig und die Qualität der Kennzeichnung ist uneinheitlich. Gleichzeitig werden Verkehrsszenendaten auch durch Faktoren wie eine einzige Datenquelle und unzureichende Datenvielfalt beeinflusst, die nicht ausreicht, um die Test- und Verifizierungsanforderungen der autonomen Fahrforschung zu erfüllen.

Inländische und ausländische Forscher haben umfangreiche Untersuchungen zur Konstruktions- und Generierungstechnologie von Verkehrsszenendaten durchgeführt und dabei Methoden wie Datenmutation, kontradiktorisches Generierungsnetzwerk, Simulations-Engine-Generierung und Spielmodell-Rendering verwendet, um virtuelle Testszenendaten zu erstellen. Dadurch erhalten Sie qualitativ hochwertige Testdaten und nutzen unterschiedliche generierte Testdaten für autonome Fahrmodelle und Datenerweiterung. Die Verwendung hartcodierter Bildtransformationen zur Generierung von Testbildern ist eine effektive Methode. Mithilfe verschiedener mathematischer Transformationen und Bildverarbeitungstechniken kann das Originalbild mutiert werden, um das potenzielle Fehlverhalten des autonomen Fahrsystems unter verschiedenen Umgebungsbedingungen zu testen.

Zhang et al. verwendeten eine kontradiktorische generative netzwerkbasierte Methode zur Bildstiltransformation, um Fahrzeugfahrszenen unter bestimmten Umgebungsbedingungen zu simulieren. Einige Studien führen autonome Fahrtests in virtuellen Umgebungen durch, wobei 3D-Modelle aus physischen Simulationsmodellen verwendet werden, um Verkehrsszenen zu konstruieren und diese in 2D-Bilder als Eingabe für das Wahrnehmungssystem umzuwandeln. Testbilder können auch durch Synthese erzeugt werden, indem modifizierbare Inhalte im Unterraum niedrigdimensionaler Bilder abgetastet werden und eine Bildsynthese durchgeführt wird. Im Vergleich zur direkten Mutation von Bildern ist die synthetische Szene umfangreicher und die Bildstörungsoperation ist freier. Fremont et al. verwendeten die feldspezifische Programmiersprache Scenic für das autonome Fahren, um Testszenarien vorab zu entwerfen, nutzten eine Game-Engine-Schnittstelle, um spezifische Verkehrsszenenbilder zu generieren, und nutzten die gerenderten Bilder auf dem Zielerkennungsmodell für Training und Verifizierung.

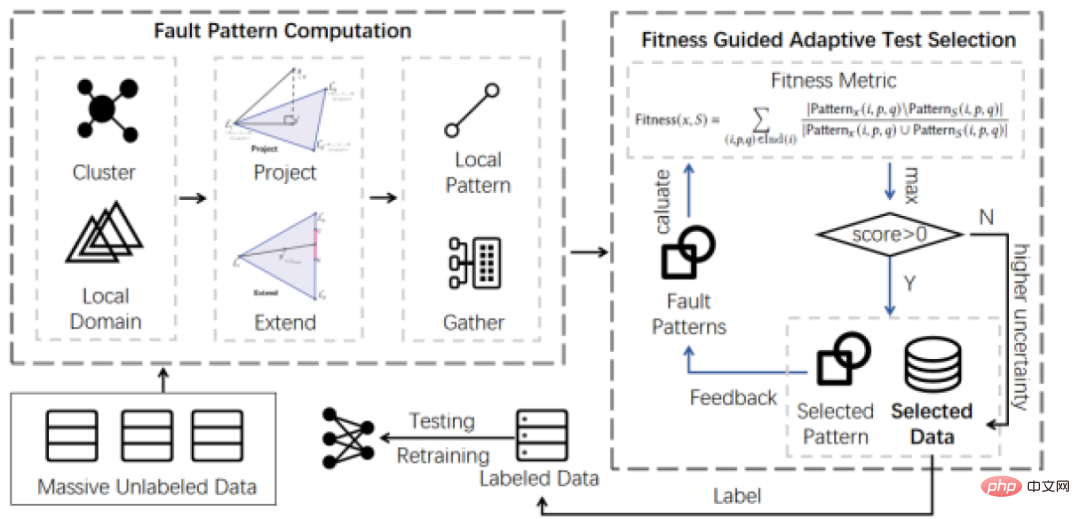

Pei et al. nutzten die Idee des Differentialtests, um inkonsistente Ergebnisse des autonomen Fahrlenkungsmodells zu finden. Sie schlugen auch vor, die Neuronenabdeckung zu verwenden, also den Anteil der Neuronen im neuronalen Netzwerk, der einen voreingestellten Wert überschreitet gegebene Aktivierungsschwelle, um die Leistung der Testprobe zu messen. Auf der Grundlage der neuronalen Abdeckung haben Forscher auch viele neue Testabdeckungskonzepte vorgeschlagen, wie z. B. Neuronengrenzenabdeckung, starke Neuronenabdeckung, hierarchische Neuronenabdeckung usw. Darüber hinaus ist die Verwendung heuristischer Suchtechnologie zum Auffinden von Zieltestfällen auch eine effektive Methode. Die Hauptschwierigkeit liegt in der Entwicklung von Testbewertungsindikatoren als Leitfaden für die Suche. Beim Testen von Bildsystemen für autonomes Fahren treten häufig Probleme auf, beispielsweise das Fehlen gekennzeichneter Daten für spezielle Fahrszenarien. Dieses Team schlug eine adaptive Testfallauswahlmethode für tiefe neuronale Netze (ATS) vor, die von der Idee des adaptiven Zufallstests im Bereich Softwaretests inspiriert ist, um die hohen Personalkosten für die Kennzeichnung von Testdaten für tiefe neuronale Netze in der autonomen Fahrwahrnehmung zu lösen System. Dieses Problem.

3 Lidar-Systemtest für autonomes Fahren

Lidar ist ein entscheidender Sensor für das autonome Fahrsystem. Es kann die Ausbreitungsentfernung zwischen dem Sensorsender und dem Zielobjekt messen und die reflektierte Energiegröße und Reflexion auf der Oberfläche analysieren des Zielobjekts Informationen wie Amplitude, Frequenz und Phase des Wellenspektrums. Die gesammelten Punktwolkendaten stellen den dreidimensionalen Maßstab und die Reflexionsintensitätsinformationen verschiedener Objekte in der Fahrszene genau dar, was den Mangel an Datenform und -genauigkeit der Kamera ausgleichen kann. Lidar spielt eine wichtige Rolle bei Aufgaben wie der automatischen Fahrzielerkennung und der Positionierungskartierung und kann nicht allein durch Single Vision ersetzt werden.

Als typisches komplexes intelligentes Softwaresystem verwendet das autonome Fahren die von Lidar erfassten Umgebungsinformationen als Eingabe und trifft über das Modell der künstlichen Intelligenz im Wahrnehmungsmodul Urteile. Nach der Systemplanung und -steuerung führt es verschiedene Fahraufgaben aus. Obwohl die hohe Komplexität des Modells der künstlichen Intelligenz dem autonomen Fahrsystem die Wahrnehmungsfähigkeit verleiht, basiert die bestehende traditionelle Testtechnologie auf der manuellen Erfassung und Kommentierung von Punktwolkendaten, was kostspielig und ineffizient ist. Andererseits sind Punktwolkendaten ungeordnet, es fehlen offensichtliche Farbinformationen, sie werden leicht durch Wetterfaktoren gestört und das Signal wird leicht gedämpft, wodurch die Vielfalt der Punktwolkendaten während des Testprozesses besonders wichtig ist.

Der Test autonomer Fahrsysteme auf Lidar-Basis befindet sich noch im Anfangsstadium. Sowohl tatsächliche Fahrtests als auch Simulationstests weisen Probleme wie hohe Kosten, geringe Testeffizienz und nicht garantierte Testangemessenheit auf. Angesichts der Probleme, mit denen autonome Fahrsysteme konfrontiert sind, wie z. B. veränderliche Testszenarien, große und komplexe Softwaresysteme und enorme Testkosten, ist die Möglichkeit, auf Domänenwissen basierende Technologie zur Testdatengenerierung vorschlagen zu können, für die Garantie autonomer Fahrsysteme von großer Bedeutung .

In Bezug auf die Generierung von Radarpunktwolkendaten modellierten Sallab et al. Radarpunktwolkendaten durch den Aufbau eines generativen gegnerischen Netzwerks mit Zykluskonsistenz und führten eine Merkmalsanalyse an den simulierten Daten durch, um neue Punktwolkendaten zu generieren. Yue et al. schlugen ein Framework zur Generierung von Punktwolkendaten für autonome Fahrszenen vor, das auf annotierten Objekten basiert, um neue Daten zu erhalten. Die Daten wurden neu trainiert Datenverarbeitungsmodul des autonomen Fahrsystems und erzielte bessere Genauigkeitsverbesserungen.

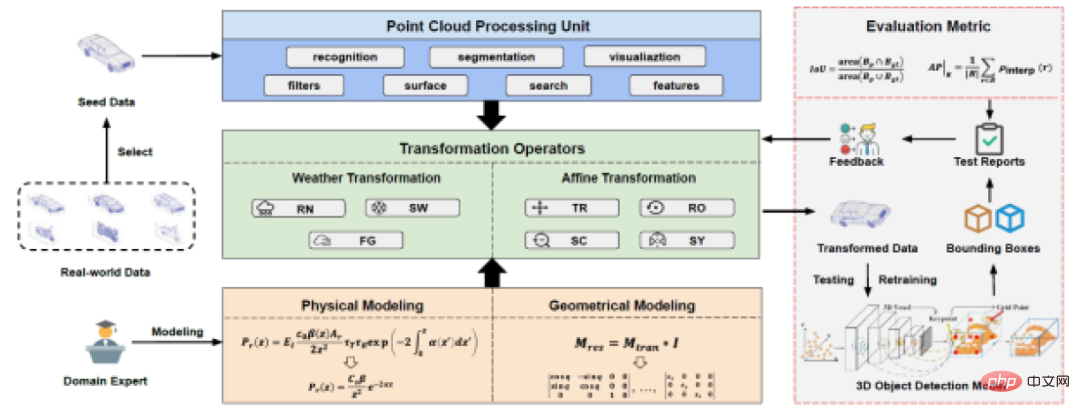

Dieses Team hat ein automatisiertes Lidar-Testtool LiRTest entworfen und implementiert, das hauptsächlich zum automatisierten Testen von Zielerkennungssystemen für selbstfahrende Autos verwendet wird und weiter umgeschult werden kann, um die Systemrobustheit zu verbessern. LiRTest entwirft zunächst physikalische und geometrische Modelle durch Domänenexperten und konstruiert dann Transformationsoperatoren auf der Grundlage der Modelle. Entwickler wählen Punktwolken-Seeds aus realen Daten aus, verwenden Punktwolken-Verarbeitungseinheiten, um sie zu identifizieren und zu verarbeiten, und implementieren auf Transformationsoperatoren basierende Mutationsalgorithmen, um Tests zu generieren, die die Robustheit von 3D-Zielerkennungsmodellen für autonomes Fahren bewerten. Schließlich erhält LiRTest den Testbericht und gibt Feedback zum Operator-Design, wodurch die Qualität iterativ verbessert wird.

Das autonome Fahrsystem ist ein typisches informationsphysikalisches Fusionssystem. Sein Betriebsstatus wird nicht nur durch Benutzereingabeinformationen und den internen Zustand des Softwaresystems bestimmt, sondern wird auch von der physischen Umgebung beeinflusst. Obwohl es derzeit nur wenige Forschungsarbeiten gibt, die sich mit dem Problem der Erzeugung von Punktwolkendaten befassen, die von verschiedenen Umweltfaktoren beeinflusst werden, ist es aufgrund der Eigenschaften von Punktwolkendaten schwierig, die Authentizität der generierten Daten mit den Fahrtestdaten gleichzusetzen Wie kann dies erreicht werden, ohne den zusätzlichen Ressourcenverbrauch erheblich zu erhöhen? In diesem Fall ist die automatische Generierung von Punktwolkendaten, die eine Vielzahl realer Umweltfaktoren beschreiben können, ein zentrales Problem, das gelöst werden muss.

In der gängigen Softwarearchitektur autonomer Fahrsoftware haben Modelle der künstlichen Intelligenz einen äußerst wichtigen Einfluss auf Fahrentscheidungen und Systemverhalten. Zu den Funktionen, die sie beeinflussen, gehören: Objekterkennung, Pfadplanung, Verhaltensvorhersage usw. Das am häufigsten verwendete Modell der künstlichen Intelligenz für die Verarbeitung von Punktwolkendaten ist das Zielerkennungsmodell, das mithilfe tiefer neuronaler Netze implementiert wird. Obwohl diese Technologie bei bestimmten Aufgaben eine hohe Genauigkeit erreichen kann, können Benutzer und Entwickler ihr Verhalten aufgrund der mangelnden Interpretierbarkeit ihrer Ergebnisse nicht analysieren und bestätigen, was die Entwicklung von Testtechnologien erschwert und die Bewertung der Testangemessenheit erheblich erschwert. Dies alles sind Herausforderungen, denen sich künftige Lidar-Modelltester stellen müssen.

4 Test des Fusionswahrnehmungssystems für autonomes Fahren

Autonome Fahrsysteme sind in der Regel mit einer Vielzahl von Sensoren zur Erfassung von Umgebungsinformationen sowie mit einer Vielzahl von Software und Algorithmen ausgestattet, um verschiedene autonome Fahraufgaben zu erfüllen. Unterschiedliche Sensoren haben unterschiedliche physikalische Eigenschaften und auch ihre Anwendungsszenarien sind unterschiedlich. Die Fusionssensortechnologie kann die schlechte Anpassungsfähigkeit eines einzelnen Sensors an die Umgebung ausgleichen und durch die Zusammenarbeit mehrerer Sensoren den normalen Betrieb des autonomen Fahrsystems unter verschiedenen Umgebungsbedingungen sicherstellen.

Aufgrund der unterschiedlichen Arten der Informationserfassung besteht eine starke Komplementarität zwischen verschiedenen Sensortypen. Die Installationskosten der Kamera sind gering und die erfassten Bilddaten verfügen über eine hohe Auflösung und umfangreiche visuelle Informationen wie Farbe und Textur. Allerdings reagiert die Kamera empfindlich auf die Umgebung und kann nachts, bei starkem Licht und anderen Lichtveränderungen unzuverlässig sein. LiDAR hingegen lässt sich nicht so leicht durch Lichtveränderungen beeinflussen und bietet eine präzise dreidimensionale Wahrnehmung bei Tag und Nacht. Allerdings ist Lidar teuer und den gesammelten Punktwolkendaten fehlen Farbinformationen, was es schwierig macht, Ziele ohne offensichtliche Formen zu identifizieren. Wie man die Vorteile der einzelnen modalen Daten nutzen und tiefere semantische Informationen gewinnen kann, ist zu einem wichtigen Thema in der Fusions-Sensing-Technologie geworden.

Forscher haben verschiedene Datenfusionsmethoden vorgeschlagen. Die auf Deep Learning basierende Fusionssensortechnologie von Lidar und Kameras hat sich aufgrund ihrer hohen Genauigkeit zu einer wichtigen Forschungsrichtung entwickelt. Feng et al. haben die Fusionsmethoden kurz in drei Typen zusammengefasst: Fusion im frühen Stadium, im mittleren Stadium und im späten Stadium. Bei der frühen Fusion werden nur Originaldaten oder vorverarbeitete Daten zusammengeführt; bei der mittleren Fusion werden die von jedem Zweig extrahierten Datenmerkmale zusammengeführt; bei der späten Fusion werden nur die endgültigen Ausgabeergebnisse jedes Zweigs zusammengeführt. Obwohl die auf Deep Learning basierende Fused-Sensing-Technologie in bestehenden Benchmark-Datensätzen großes Potenzial gezeigt hat, können solche intelligenten Modelle in realen Szenarien mit komplexen Umgebungen immer noch falsches und unerwartetes extremes Verhalten zeigen, was zu fatalen Verlusten führen kann. Um die Sicherheit autonomer Fahrsysteme zu gewährleisten, müssen solche fusionierten Wahrnehmungsmodelle gründlich getestet werden.

Derzeit befindet sich die Fused-Sensing-Testtechnologie noch im Anfangsstadium. Der Testeingabebereich ist riesig und die Kosten für die Datenerfassung sind das Hauptproblem. Die Technologie zur automatisierten Testdatengenerierung ist weit verbreitet. Wang et al. schlugen einen modalübergreifenden Datenverbesserungsalgorithmus vor, der virtuelle Objekte gemäß geometrischen Konsistenzregeln in Bilder und Punktwolken einfügt, um Testdatensätze zu generieren. Zhang et al. schlugen eine multimodale Datenverbesserungsmethode vor, die multimodale Transformationsflüsse nutzt, um die korrekte Zuordnung zwischen Punktwolken und Bildpixeln aufrechtzuerhalten, und schlugen darauf basierend außerdem eine multimodale Ausschneide- und Einfügen-Verbesserungsmethode vor.

Unter Berücksichtigung der Auswirkungen komplexer Umgebungen in realen Szenen auf Sensoren hat unser Team eine Datenverstärkungstechnologie für multimodale Fusionssensorsysteme entwickelt. Diese Methode verwendet Domänenexperten, um eine Reihe von Mutationsregeln mit realistischer Semantik für alle Modaldaten zu entwickeln, und generiert automatisch Testdaten, um verschiedene Faktoren zu simulieren, die Sensoren in realen Szenarien stören, und hilft Softwareentwicklern beim Testen und Testen innerhalb begrenzter Ressourcen Sensorsysteme. Die bei dieser Methode verwendeten Mutationsoperatoren umfassen drei Kategorien: Signalrauschoperatoren, Signalausrichtungsoperatoren und Signalverlustoperatoren, die verschiedene Arten von Interferenzen simulieren, die in realen Szenen auftreten. Der Lärmoperator bezieht sich auf das Vorhandensein von Rauschen in den gesammelten Daten aufgrund des Einflusses von Umgebungsfaktoren während des Sensordatenerfassungsprozesses. Beispielsweise werden für Bilddaten Operatoren wie „Spot“ und „Unschärfe“ verwendet, um die Situation zu simulieren, in der die Kamera auf starkes Licht und Verwacklungen trifft. Der Ausrichtungsoperator simuliert die Fehlausrichtung multimodaler Datenmodi, insbesondere einschließlich zeitlicher und räumlicher Fehlausrichtung. Bei ersterem wird ein Signal zufällig verzögert, um einen Übertragungsstau oder eine Übertragungsverzögerung zu simulieren. Für Letzteres werden geringfügige Anpassungen der Kalibrierungsparameter jedes Sensors vorgenommen, um geringfügige Änderungen der Sensorposition aufgrund von Fahrzeugjitter und anderen Problemen während der Fahrt zu simulieren. Der Signalverlustoperator simuliert einen Sensorausfall. Beobachten Sie insbesondere nach dem zufälligen Verwerfen eines Signals, ob der Fusionsalgorithmus rechtzeitig reagieren oder normal funktionieren kann.

Kurz gesagt, die Multisensor-Fusion-Wahrnehmungstechnologie ist ein unvermeidlicher Trend in der Entwicklung des autonomen Fahrens. Vollständige Tests sind eine notwendige Voraussetzung, um sicherzustellen, dass das System normal funktionieren kann In komplexen realen Umgebungen ist es immer noch ein dringendes Problem, das mit begrenzten Ressourcen angemessen getestet werden kann.

Fazit

Wahrnehmungstests für autonomes Fahren sind eng in den Softwareentwicklungsprozess für autonomes Fahren integriert, und verschiedene Arten von In-the-Loop-Tests werden nach und nach zu einem notwendigen Bestandteil der Qualitätssicherung für autonomes Fahren. Bei industriellen Anwendungen bleiben tatsächliche Antriebstests wichtig. Es gibt jedoch Probleme wie übermäßige Kosten, unzureichende Effizienz und hohe Sicherheitsrisiken, die den Test- und Verifizierungsanforderungen intelligenter Wahrnehmungssysteme für autonomes Fahren bei weitem nicht gerecht werden. Die rasante Entwicklung formaler Methoden und virtueller Simulationstests in mehreren Forschungszweigen bietet wirksame Möglichkeiten zur Verbesserung von Tests. Forscher erforschen Modelltestindikatoren und -technologien, die für intelligentes Fahren geeignet sind, um Methoden für virtuelle Simulationstests zu unterstützen. Dieses Team widmet sich der Erforschung der Generierungs-, Bewertungs- und Optimierungsmethoden für Wahrnehmungstestdaten für autonomes Fahren und konzentriert sich dabei auf die eingehende Forschung zu drei Aspekten auf der Grundlage von Bildern, Punktwolkendaten und Wahrnehmungsfusionstests, um ein qualitativ hochwertiges Wahrnehmungssystem für autonomes Fahren sicherzustellen .

Das obige ist der detaillierte Inhalt vonEin Artikel, in dem die Testtechnologie des intelligenten Fahrwahrnehmungssystems ausführlich erläutert wird. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich während des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt hätte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randfälle bei autonomen Fahrzeugen, also mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschränken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gelöst, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschränkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen gehören eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der „Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randfälle in autonomen Fahrzeugen (AVs). Randfälle sind mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

Was halten Sie von Furmark? - Wie wird Furmark als qualifiziert angesehen?

Mar 19, 2024 am 09:25 AM

Was halten Sie von Furmark? - Wie wird Furmark als qualifiziert angesehen?

Mar 19, 2024 am 09:25 AM

Was halten Sie von Furmark? 1. Stellen Sie den „Ausführungsmodus“ und den „Anzeigemodus“ in der Hauptoberfläche ein, passen Sie auch den „Testmodus“ an und klicken Sie auf die Schaltfläche „Start“. 2. Nach einer Weile sehen Sie die Testergebnisse, darunter verschiedene Parameter der Grafikkarte. Wie wird Furmark qualifiziert? 1. Verwenden Sie eine Furmark-Backmaschine und überprüfen Sie das Ergebnis etwa eine halbe Stunde lang. Die Temperatur liegt im Wesentlichen bei etwa 85 Grad, mit einem Spitzenwert von 87 Grad und einer Raumtemperatur von 19 Grad. Großes Gehäuse, 5 Gehäuselüfteranschlüsse, zwei vorne, zwei oben und einer hinten, aber nur ein Lüfter ist installiert. Sämtliches Zubehör ist nicht übertaktet. 2. Unter normalen Umständen sollte die normale Temperatur der Grafikkarte zwischen „30-85℃“ liegen. 3. Auch wenn die Umgebungstemperatur im Sommer zu hoch ist, beträgt die normale Temperatur „50-85℃“

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

Vorab geschrieben und Ausgangspunkt Das End-to-End-Paradigma verwendet ein einheitliches Framework, um Multitasking in autonomen Fahrsystemen zu erreichen. Trotz der Einfachheit und Klarheit dieses Paradigmas bleibt die Leistung von End-to-End-Methoden für das autonome Fahren bei Teilaufgaben immer noch weit hinter Methoden für einzelne Aufgaben zurück. Gleichzeitig erschweren die in früheren End-to-End-Methoden weit verbreiteten Funktionen der dichten Vogelperspektive (BEV) die Skalierung auf mehr Modalitäten oder Aufgaben. Hier wird ein Sparse-Search-zentriertes End-to-End-Paradigma für autonomes Fahren (SparseAD) vorgeschlagen, bei dem die Sparse-Suche das gesamte Fahrszenario, einschließlich Raum, Zeit und Aufgaben, ohne dichte BEV-Darstellung vollständig abbildet. Insbesondere ist eine einheitliche, spärliche Architektur für die Aufgabenerkennung einschließlich Erkennung, Verfolgung und Online-Zuordnung konzipiert. Zudem schwer

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Im vergangenen Monat hatte ich aus bekannten Gründen einen sehr intensiven Austausch mit verschiedenen Lehrern und Mitschülern der Branche. Ein unvermeidliches Thema im Austausch ist natürlich End-to-End und der beliebte Tesla FSDV12. Ich möchte diese Gelegenheit nutzen, einige meiner aktuellen Gedanken und Meinungen als Referenz und Diskussion darzulegen. Wie definiert man ein durchgängiges autonomes Fahrsystem und welche Probleme sollten voraussichtlich durchgängig gelöst werden? Gemäß der traditionellsten Definition bezieht sich ein End-to-End-System auf ein System, das Rohinformationen von Sensoren eingibt und für die Aufgabe relevante Variablen direkt ausgibt. Bei der Bilderkennung kann CNN beispielsweise als End-to-End bezeichnet werden, verglichen mit der herkömmlichen Methode zum Extrahieren von Merkmalen + Klassifizieren. Bei autonomen Fahraufgaben werden Eingabedaten verschiedener Sensoren (Kamera/LiDAR) benötigt

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.

Nehmen Sie an einem neuen Xianxia-Abenteuer teil! Der Vorab-Download von „Zhu Xian 2' „Wuwei Test' ist jetzt verfügbar

Apr 22, 2024 pm 12:50 PM

Nehmen Sie an einem neuen Xianxia-Abenteuer teil! Der Vorab-Download von „Zhu Xian 2' „Wuwei Test' ist jetzt verfügbar

Apr 22, 2024 pm 12:50 PM

Der „Inaction Test“ des neuen Fantasy-Märchen-MMORPG „Zhu Xian 2“ startet am 23. April. Was für eine neue Märchen-Abenteuergeschichte wird auf dem Kontinent Zhu Die Six Realm Immortal World, eine Vollzeitakademie zur Kultivierung von Unsterblichen, ein freies Leben zur Kultivierung von Unsterblichen und jede Menge Spaß in der Welt der Unsterblichen warten darauf, von den unsterblichen Freunden persönlich erkundet zu werden! Der Vorab-Download von „Wuwei Test“ ist jetzt möglich. Sie können sich zum Herunterladen auf die offizielle Website begeben. Der Aktivierungscode kann nach dem Vorab-Download und der Installation verwendet werden abgeschlossen. „Zhu Als Blaupause wird der Spielhintergrund festgelegt