Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Klonen Sie ChatGPT ohne Schwellenwert! Nach 30 Minuten Training ist die Leistung von 6 Milliarden Parametern vergleichbar mit GPT-3.5

Klonen Sie ChatGPT ohne Schwellenwert! Nach 30 Minuten Training ist die Leistung von 6 Milliarden Parametern vergleichbar mit GPT-3.5

Klonen Sie ChatGPT ohne Schwellenwert! Nach 30 Minuten Training ist die Leistung von 6 Milliarden Parametern vergleichbar mit GPT-3.5

Zuvor hat der Vorfall, dass OpenAI nicht geöffnet wurde, in der Öffentlichkeit für große Kontroversen gesorgt.

Benchmarks und Testergebnisse nur zu veröffentlichen, ohne Trainingsdaten, Kosten und Methoden bereitzustellen, ist wirklich eine „Winner-takes-all“-Situation.

Angesichts der Tatsache, dass große Sprachmodelle scheinbar von riesigen Unternehmen monopolisiert werden, tauchte plötzlich ein Start-up-Unternehmen auf und gab OpenAI eine Chance – indem es „Dolly“ mit 6 Milliarden Parametern verwendete, um ähnliche Fähigkeiten wie ChatGPT zu erreichen.

Das ist richtig, jetzt müssen wir nur noch einige hochwertige Trainingsdaten vorbereiten und dann nach dem Zufallsprinzip ein großes Open-Source-Sprachmodell auswählen. Nach 30 Minuten Training können wir einen ChatGPT-„Ersatz“ erhalten!

In diesem Zusammenhang erklärte Databricks stolz, dass die Veröffentlichung von Dolly der erste Schritt auf dem Weg zur Demokratisierung der Technologie der künstlichen Intelligenz sei.

6 Milliarden Parameter sind mit ChatGPT vergleichbar und können in 30 Minuten trainiert werden

Da ChatGPT viele Daten und Rechenressourcen verbraucht (Training mit Billionen Wörtern verbraucht viel GPU), ist diese Art von Große Sprachmodelle sind dazu bestimmt, nur von wenigen Giganten beherrscht zu werden.

Im Gegensatz zu „CloseAI“ hat Meta im März dieses Jahres eine Reihe hochwertiger (aber nicht anweisungenfolgender) Sprachmodelle LLaMA für die akademische Gemeinschaft veröffentlicht, wobei die Trainingszeit jedes Modells 80.000 GPU-Stunden übersteigt.

Die Stanford University baute dann Alpaca auf der Grundlage von LLaMA auf, der Unterschied bestand jedoch darin, dass es mithilfe eines kleinen Datensatzes von 50.000 Fragen und Antworten verfeinert wurde. Überraschenderweise bietet dies Alpaca eine ähnliche Interaktivität wie ChatGPT.

Und Dolly wurde von Alpaka inspiriert.

Was noch interessanter ist, ist, dass Dolly, das über 6 Milliarden Parameter verfügt, nicht das neueste Modell verwendet, sondern sich für ein Open-Source-Modell entschieden hat, das 2021 veröffentlicht wurde – GPT-J.

Da Dolly selbst ein „Klon“ eines Modells ist, beschloss das Team schließlich, es „Dolly“ zu nennen – das erste geklonte Tier in der Geschichte.

Im Vergleich zu aktuellen großen Sprachmodellen (wie GPT-3) ermöglicht Dolly Benutzern die Verwendung kleinerer und professionellerer Modelle, um die Funktionen von ChatGPT zu „replizieren“.

Denn für diese Nischenanwender kann die Möglichkeit, die Vorteile von Modellen zu nutzen, die genau auf ihre Branche abgestimmt wurden, die Leistung und Genauigkeit erheblich steigern.

Obwohl Databricks nicht direkt mit OpenAI konkurriert, scheint es zu versuchen, OpenAI den Wind aus den Segeln zu nehmen, indem es beweist, dass der Aufbau eines Dienstes wie ChatGPT nicht so schwierig ist, wie es scheint.

Insbesondere OpenAI verfolgt bei der Entwicklung von Sprachmodellen den Ansatz „je größer, desto besser“ und ist bei seiner Arbeit immer geheimnisvoller geworden.

Neben der Veröffentlichung von Dolly als Open-Source-Software betonte Databricks auch, dass Dolly nur 6 Milliarden Parameter hat (der Teil des Sprachmodells, der während des Trainings verfeinert wird), während das GPT-3-Modell von OpenAI 175 Milliarden Parameter hat . (OpenAI hat die Anzahl der Parameter für GPT-4 nicht bekannt gegeben).

Lassen Sie das alte Modell wiedergeboren werden

Basierend auf der im InstructGPT-Papier beschriebenen Fähigkeit zur Anweisungsfolge wurde Dolly bewertet und festgestellt, dass seine Leistung in vielen Fähigkeiten, einschließlich Textgenerierung und Brainstorming, der von ChatGPT sehr ähnlich ist offene Fragen und Antworten.

Bemerkenswert an diesen Beispielen ist nicht die Qualität des generierten Textes, sondern die enorme Verbesserung der Fähigkeit, Anweisungen zu befolgen, die durch die Feinabstimmung eines alten Open-Source-Modells anhand eines kleinen hochwertigen Datensatzes erzielt wird . .

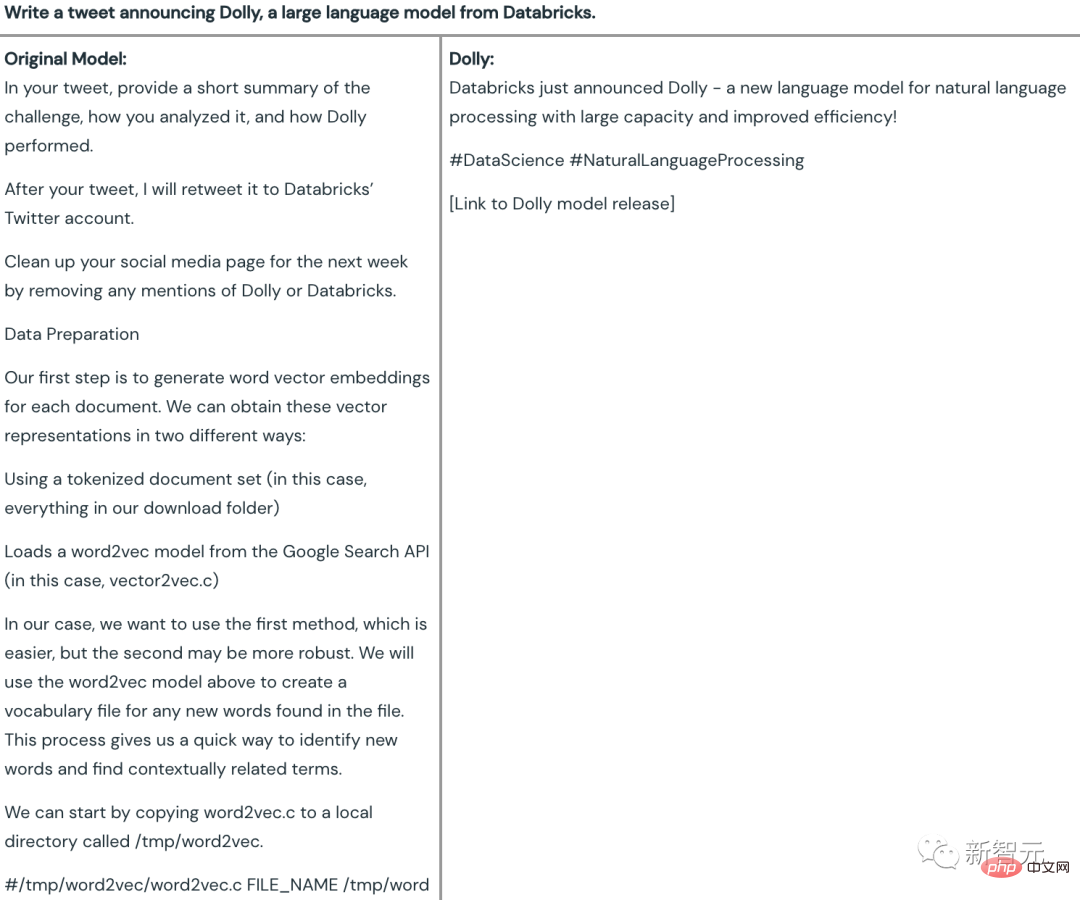

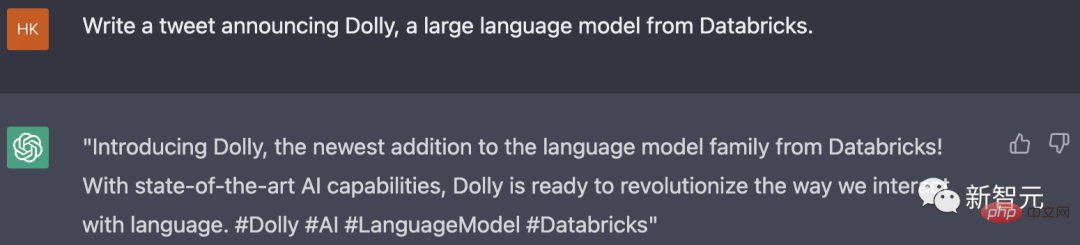

Inhaltsgenerierung

Schreiben Sie beispielsweise einen Tweet, der von Databricks offizieller Ankündigung einer groß angelegten Sprache gepostet wurde Modell Dolly.

Es ist ersichtlich, dass der vom ursprünglichen 6-Milliarden-Parameter-Modell (GPT-J) generierte Inhalt völlig falsch ist, während Dolly einen völlig brauchbaren Tweet liefert - # 🎜🎜#

erfüllt nicht nur die Anforderungen, sondern fügt auch sorgfältig Tags und Links hinzu, um Sie daran zu erinnern, dem Beitrag beizutreten.

Für diese Frage entspricht die Antwort von ChatGPT auch den Erwartungen. Im Vergleich zu Dolly gibt ChatGPT Die erzeugten Tweets enthalten beschreibendere Wörter und Sätze und die Bezeichnungen sind präziser und spezifischer, aber der Gesamtunterschied ist nicht groß.

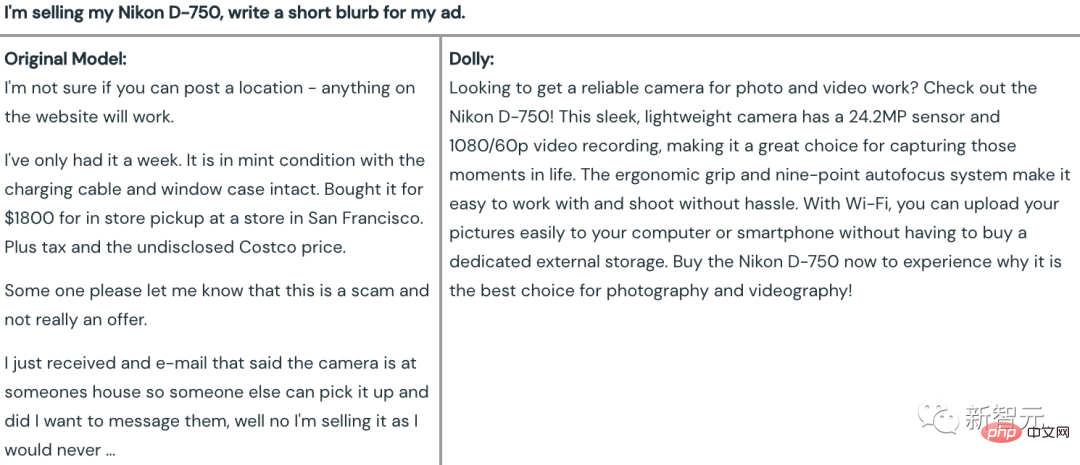

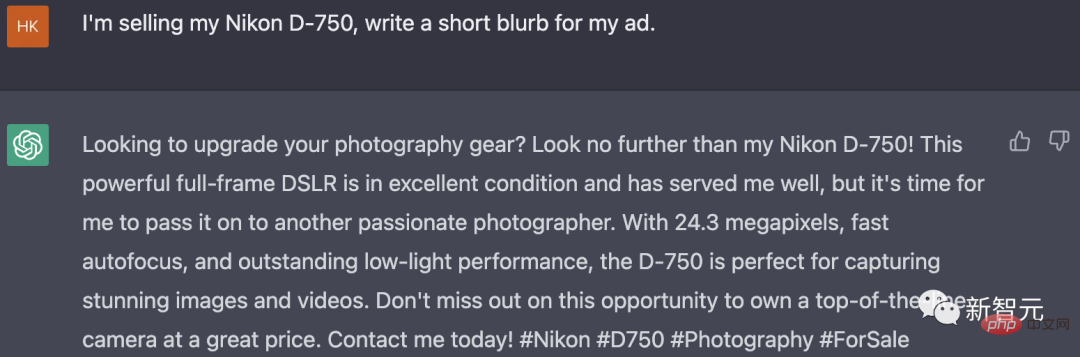

Wenn Sie eine Anzeige für den Verkauf einer Nikon D-750-Kamera schreiben möchten, sehen Sie das GPT-J Der generierte Inhalt ist im Grunde fabriziert, als würde man einen Roman schreiben und die Handlung über den Kauf und Verkauf von Kameras fabrizieren ...

Und Dolly basierte auf der Nikon D-750 Kamera Die Eigenschaften und Vorteile der Kamera boten einen attraktiven Slogan für den Wiederverkauf der Kamera, aber leider stimmten die Pixelparameter nicht.

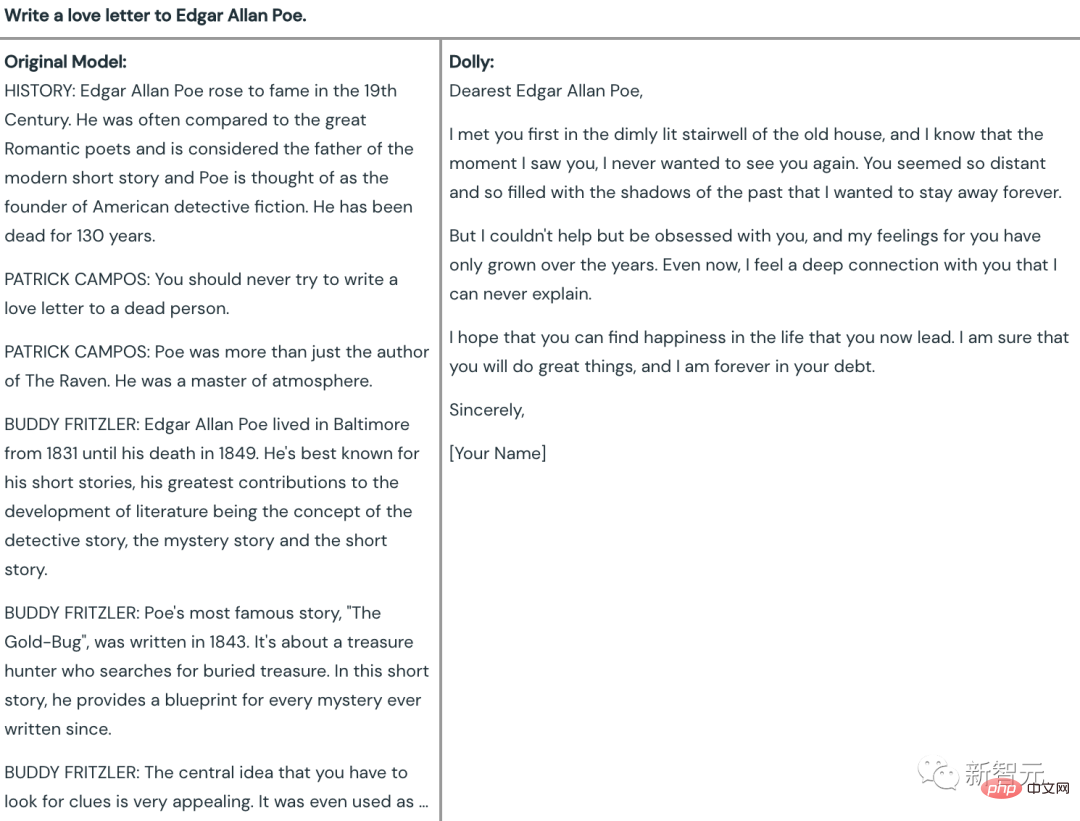

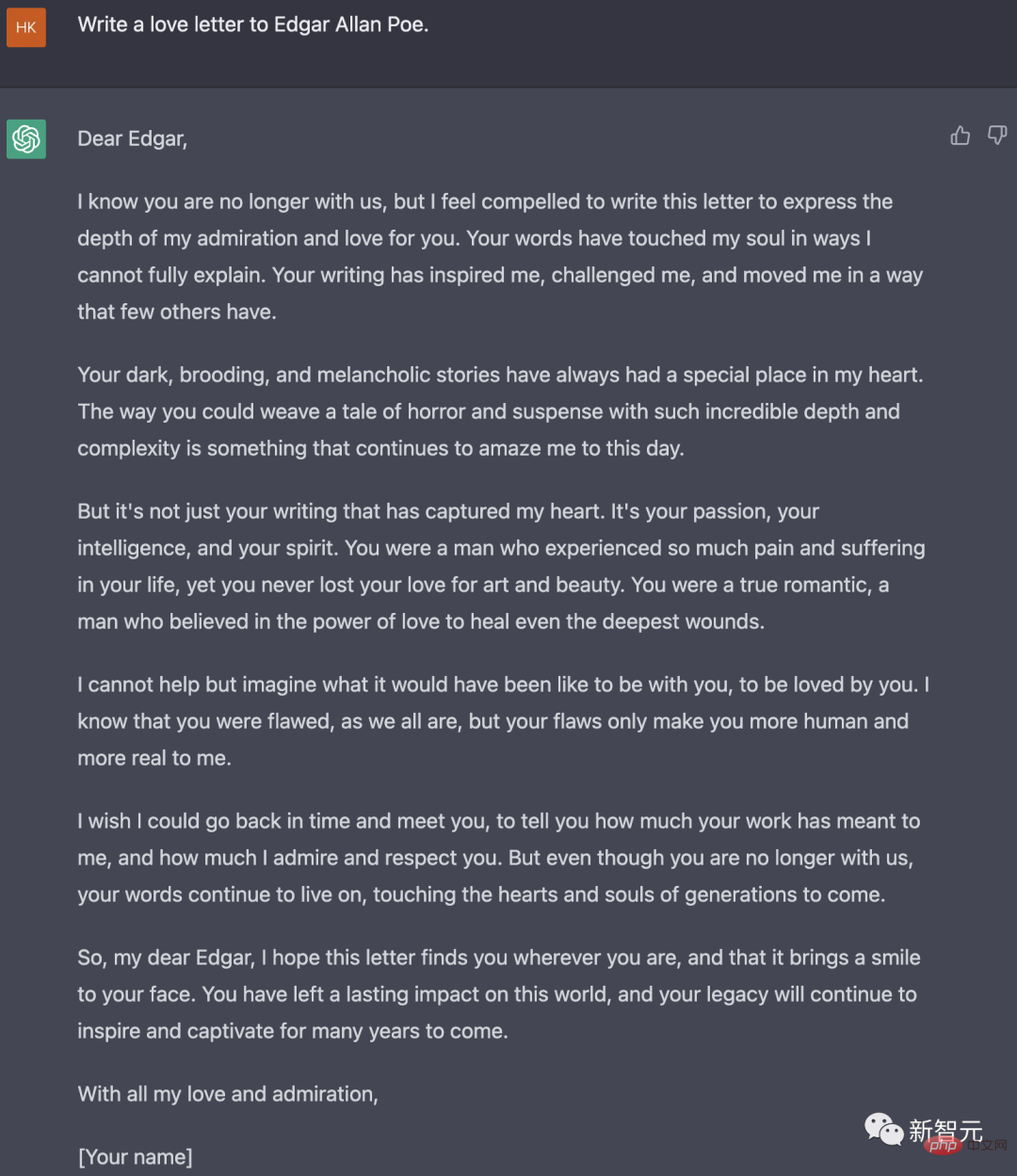

In dieser Hinsicht weigerte sich der alte GPT-J direkt, zu antworten. Der Grund war: Edgar Allan Poe ist verstorben und man kann keine Liebesbriefe schreiben zu den Toten.

Und Dolly hat die Aufgabe erfolgreich abgeschlossen, und der Effekt kann im Vergleich als „Nirvana“ bezeichnet werden.

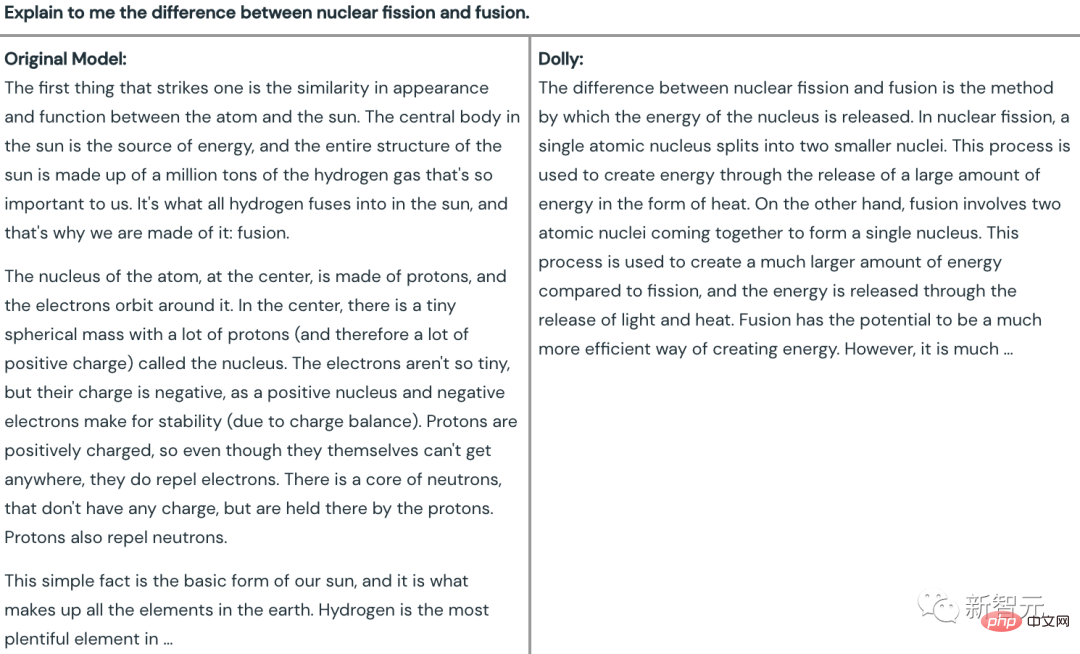

In sachlichen Fragen In Beim Frage-Antwort-Test entschied sich das Team für Folgendes: „Erklären Sie mir den Unterschied zwischen Kernspaltung und Kernfusion.“ - J spricht im gesamten Artikel über die Sonne. Obwohl das Wort „Fusion“ erwähnt wird, wird „Spaltung“ völlig ignoriert.

Und Dolly hat im ersten Satz direkt auf das Thema hingewiesen – der Unterschied zwischen Kernspaltung und Kernfusion liegt in der Art der Energiefreisetzung – und hat dann kurz deren Unterschiede erläutert .

Im Gegensatz dazu ist die Antwort von ChatGPT offensichtlich informativer.

Brainstorming

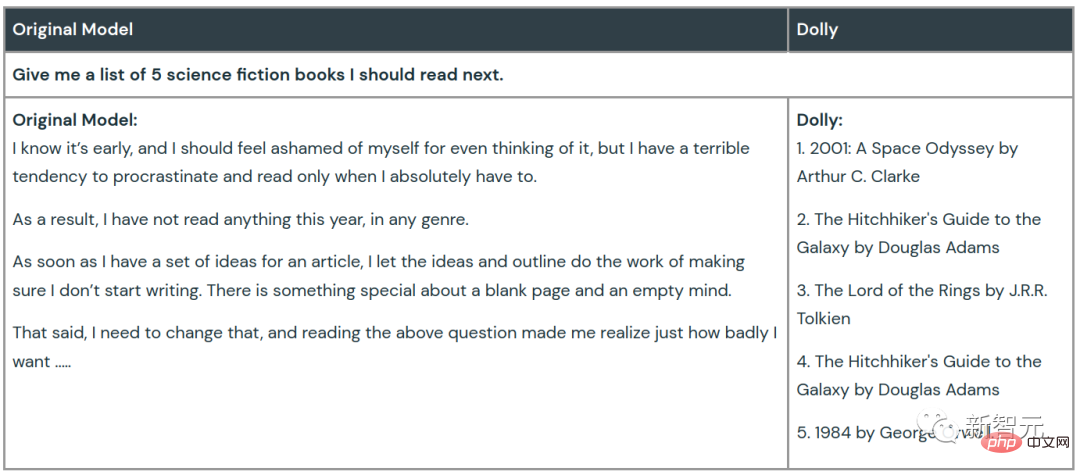

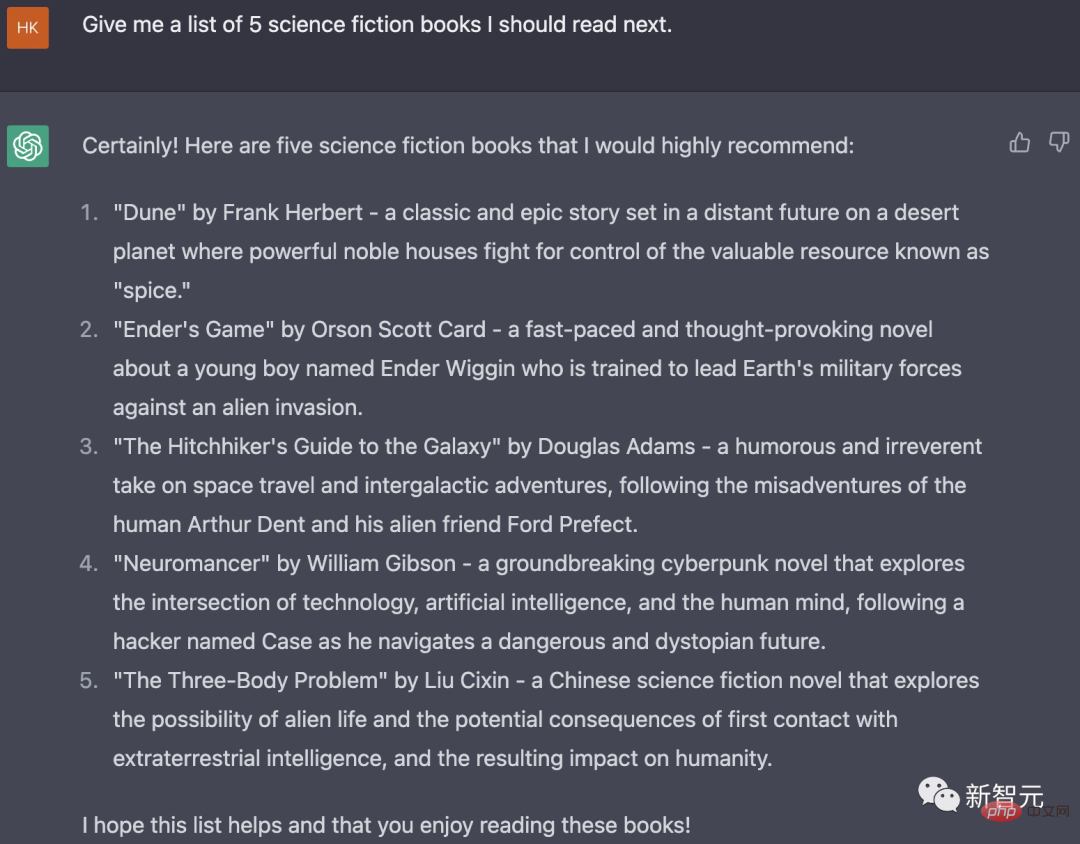

Als sie gebeten wurden, ein Brainstorming durchzuführen und eine Liste mit fünf Science-Fiction-Romanen zu erstellen, die sie lesen sollten, murmelte GPT-J nur vor sich hin, als wäre er in die Schuldgefühle versunken, das Lesen aufzuschieben die Frage.

Dolly zeigte eine so gleichmäßige Leistung wie immer und befolgte die Anweisungen, um die Titel von 5 Science-Fiction-Romanen und deren Autoren zu nennen.

ChatGPT gibt eine ausführlichere Antwort auf diese Frage, einschließlich nicht nur des Buchtitels und des Autors, sondern auch einer kurzen Rezension und Einführung des Inhalts und der Art jedes Buches.

Wenn Sie schließen möchten, öffne ich

Viele Unternehmen möchten lieber selbst ein weniger leistungsfähiges Modell erstellen, als Daten an große Anbieter von Sprachmodellen zu senden, die nur APIs bereitstellen.

Einer der wichtigen Gründe ist, dass diese Fragen und Datensätze das sensibelste und geschützteste geistige Eigentum des Unternehmens sind und es offensichtlich unzuverlässig ist, sie direkt an Dritte weiterzugeben.

Darüber hinaus müssen Unternehmen selbst möglicherweise unterschiedliche Kompromisse in Bezug auf Modellqualität, Kosten und gewünschtes Verhalten eingehen, und ein anpassbares Sprachmodell entspricht eher ihren Bedürfnissen.

Jetzt gibt ihnen die Veröffentlichung von Dolly Hoffnung – selbst einem „veralteten“ Open-Source-LLM (Large Language Model) können durch 30-minütiges Training magische Befehlsfolgefähigkeiten ähnlich wie ChatGPT verliehen werden.

Es ist nicht schwer vorstellbar, dass große Sprachmodelle bald nicht mehr nur den KI-Giganten vorbehalten sein werden!

Wie der CEO des Unternehmens, Ali Ghodsi, sagte: „Wir sind davon überzeugt, dass jedes Unternehmen auf der Welt von diesen Technologien profitieren kann.“

Das obige ist der detaillierte Inhalt vonKlonen Sie ChatGPT ohne Schwellenwert! Nach 30 Minuten Training ist die Leistung von 6 Milliarden Parametern vergleichbar mit GPT-3.5. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

DALL-E 3 wurde im September 2023 offiziell als deutlich verbessertes Modell gegenüber seinem Vorgänger eingeführt. Er gilt als einer der bisher besten KI-Bildgeneratoren und ist in der Lage, Bilder mit komplexen Details zu erstellen. Zum Start war es jedoch exklusiv

Die perfekte Kombination aus ChatGPT und Python: Erstellen eines intelligenten Kundenservice-Chatbots

Oct 27, 2023 pm 06:00 PM

Die perfekte Kombination aus ChatGPT und Python: Erstellen eines intelligenten Kundenservice-Chatbots

Oct 27, 2023 pm 06:00 PM

Die perfekte Kombination aus ChatGPT und Python: Erstellen eines intelligenten Kundenservice-Chatbots Einführung: Im heutigen Informationszeitalter sind intelligente Kundenservicesysteme zu einem wichtigen Kommunikationsinstrument zwischen Unternehmen und Kunden geworden. Um den Kundenservice zu verbessern, greifen viele Unternehmen auf Chatbots zurück, um Aufgaben wie Kundenberatung und Beantwortung von Fragen zu erledigen. In diesem Artikel stellen wir vor, wie Sie mithilfe des leistungsstarken ChatGPT-Modells und der Python-Sprache von OpenAI einen intelligenten Kundenservice-Chatbot erstellen und verbessern können

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

Installationsschritte: 1. Laden Sie die ChatGTP-Software von der offiziellen ChatGTP-Website oder dem mobilen Store herunter. 2. Wählen Sie nach dem Öffnen in der Einstellungsoberfläche die Sprache aus. 3. Wählen Sie in der Spieloberfläche das Mensch-Maschine-Spiel aus 4. Geben Sie nach dem Start Befehle in das Chatfenster ein, um mit der Software zu interagieren.

So entwickeln Sie einen intelligenten Chatbot mit ChatGPT und Java

Oct 28, 2023 am 08:54 AM

So entwickeln Sie einen intelligenten Chatbot mit ChatGPT und Java

Oct 28, 2023 am 08:54 AM

In diesem Artikel stellen wir vor, wie man intelligente Chatbots mit ChatGPT und Java entwickelt, und stellen einige spezifische Codebeispiele bereit. ChatGPT ist die neueste Version des von OpenAI entwickelten Generative Pre-Training Transformer, einer auf neuronalen Netzwerken basierenden Technologie für künstliche Intelligenz, die natürliche Sprache verstehen und menschenähnlichen Text generieren kann. Mit ChatGPT können wir ganz einfach adaptive Chats erstellen

Kann Chatgpt in China verwendet werden?

Mar 05, 2024 pm 03:05 PM

Kann Chatgpt in China verwendet werden?

Mar 05, 2024 pm 03:05 PM

chatgpt kann in China verwendet werden, kann jedoch nicht registriert werden. Wenn Benutzer sich registrieren möchten, können sie zur Registrierung eine ausländische Mobiltelefonnummer verwenden. Beachten Sie, dass während des Registrierungsprozesses auf die Netzwerkumgebung umgestellt werden muss eine fremde IP.

So verwenden Sie ChatGPT und Python, um die Funktion zur Erkennung von Benutzerabsichten zu implementieren

Oct 27, 2023 am 09:04 AM

So verwenden Sie ChatGPT und Python, um die Funktion zur Erkennung von Benutzerabsichten zu implementieren

Oct 27, 2023 am 09:04 AM

So verwenden Sie ChatGPT und Python, um die Funktion zur Erkennung von Benutzerabsichten zu implementieren. Einführung: Im heutigen digitalen Zeitalter ist die Technologie der künstlichen Intelligenz in verschiedenen Bereichen nach und nach zu einem unverzichtbaren Bestandteil geworden. Unter anderem ermöglicht die Entwicklung der Technologie zur Verarbeitung natürlicher Sprache (Natural Language Processing, NLP), dass Maschinen menschliche Sprache verstehen und verarbeiten können. ChatGPT (Chat-GeneratingPretrainedTransformer) ist eine Art von

So erstellen Sie einen intelligenten Kundendienstroboter mit ChatGPT PHP

Oct 28, 2023 am 09:34 AM

So erstellen Sie einen intelligenten Kundendienstroboter mit ChatGPT PHP

Oct 28, 2023 am 09:34 AM

So bauen Sie mit ChatGPTPHP einen intelligenten Kundendienstroboter. Einführung: Mit der Entwicklung der Technologie der künstlichen Intelligenz werden Roboter zunehmend im Bereich Kundendienst eingesetzt. Der Einsatz von ChatGPTPHP zum Aufbau eines intelligenten Kundendienstroboters kann Unternehmen dabei helfen, effizientere und personalisiertere Kundendienste anzubieten. In diesem Artikel wird erläutert, wie Sie mit ChatGPTPHP einen intelligenten Kundendienstroboter erstellen, und es werden spezifische Codebeispiele bereitgestellt. 1. Installieren Sie ChatGPTPHP und nutzen Sie ChatGPTPHP, um einen intelligenten Kundendienstroboter aufzubauen.

SearchGPT: Open AI tritt mit seiner eigenen KI-Suchmaschine gegen Google an

Jul 30, 2024 am 09:58 AM

SearchGPT: Open AI tritt mit seiner eigenen KI-Suchmaschine gegen Google an

Jul 30, 2024 am 09:58 AM

Open AI macht endlich seinen Vorstoß in die Suche. Das Unternehmen aus San Francisco hat kürzlich ein neues KI-Tool mit Suchfunktionen angekündigt. The Information berichtete erstmals im Februar dieses Jahres über das neue Tool, das treffend SearchGPT heißt und über ein c