Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Der Google AI-Sänger kommt! AudioLM kann Musik und Lieder komponieren, indem es einfach ein paar Sekunden lang zuhört.

Der Google AI-Sänger kommt! AudioLM kann Musik und Lieder komponieren, indem es einfach ein paar Sekunden lang zuhört.

Der Google AI-Sänger kommt! AudioLM kann Musik und Lieder komponieren, indem es einfach ein paar Sekunden lang zuhört.

Das Bildgenerierungsmodell ist aufgerollt! Generative Videomodelle aufgerollt!

Das nächste ist das Audio-Generierungsmodell.

Vor kurzem hat das Google-Forschungsteam ein KI-Modell für die Sprachgenerierung auf den Markt gebracht – AudioLM.

Mit nur wenigen Sekunden Audioansagen kann nicht nur hochwertige, kohärente Sprache, sondern auch Klaviermusik erzeugt werden. #🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#Papieradresse: https://www.php.cn/link/b6b3598b407b7f328e3129c74ca8ca94

🎜🎜#audiolm ist ein Langzeitsterme ist ein Langzeitmaterial konsistent Ein umfassendes, qualitativ hochwertiges Audio-Generierungs-Framework, das Eingabeaudio einer Zeichenfolge diskreter Token zuordnet und die Audio-Generierungsaufgabe in eine Sprachmodellierungsaufgabe umwandelt. Bestehende Audio-Tagger müssen einen Kompromiss zwischen der Qualität der Audioerzeugung und einer stabilen Langzeitstruktur eingehen.

Bestehende Audio-Tagger müssen einen Kompromiss zwischen der Qualität der Audioerzeugung und einer stabilen Langzeitstruktur eingehen.

Um diesen Widerspruch zu lösen, wendet Google eine „Hybrid-Tokenisierungs“-Lösung an, die eine diskretisierte Aktivierung vorab trainierter Maskensprachmodelle verwendet und diskrete Codes verwendet, die von neuronalen Audio-Codecs generiert werden, um eine hohe Leistung zu erzielen Synthese.

Das AudioLM-Modell kann lernen, natürliche und kohärente fortlaufende Wörter basierend auf kurzen Eingabeaufforderungen zu erzeugen, wenn es auf Sprache trainiert wird, ohne dass Aufzeichnung oder Anmerkung erforderlich sind. In diesem Fall Es wird eine grammatikalisch fließende und semantisch sinnvolle kontinuierliche Sprache erzeugt, während die Identität und Intonation des Sprechers erhalten bleibt. Neben Sprache kann AudioLM auch zusammenhängende Klaviermusik erzeugen, ohne dass für das Training überhaupt eine Notenschrift erforderlich ist. Vom Text zur Klaviermusik: zwei Hauptthemen

Vom Text zur Klaviermusik: zwei Hauptthemen

In den letzten Jahren haben Sprachmodelle, die auf umfangreichen Textkorpora trainiert wurden, ihre hervorragenden generativen Fähigkeiten unter Beweis gestellt und einen offenen Dialog, maschinelle Übersetzung, und selbst das Denken mit gesundem Menschenverstand kann auch andere Signale als Text modellieren, beispielsweise natürliche Bilder.

Die Idee von AudioLM besteht darin, diese Fortschritte in der Sprachmodellierung zu nutzen, um Audio ohne Training an annotierten Daten zu generieren.

Aber dazu müssen wir uns zwei Problemen stellen.

Erstens ist die Datenrate von Audio viel höher und die Einheitensequenz ist länger. Beispielsweise enthält ein Satz Dutzende von Zeichendarstellungen, aber nach der Konvertierung in eine Audiowellenform enthält er im Allgemeinen Hunderttausende Werte.

Darüber hinaus besteht eine Eins-zu-viele-Beziehung zwischen Text und Audio. Derselbe Satz kann von verschiedenen Sprechern mit unterschiedlichem Stil, unterschiedlichem emotionalem Inhalt und unterschiedlichem Kontext vorgetragen werden.

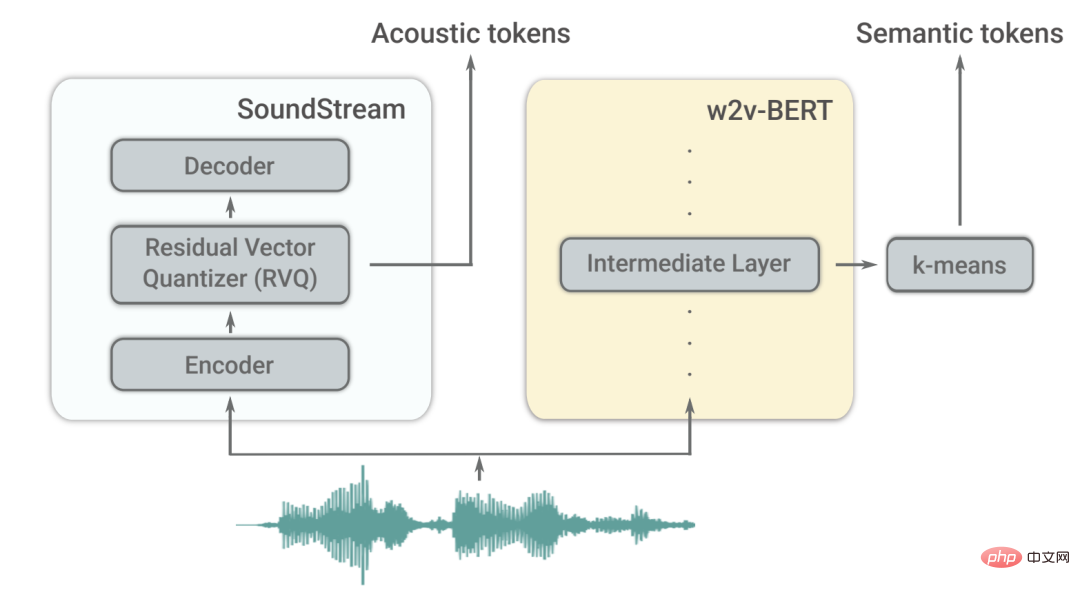

Um diese beiden Herausforderungen zu meistern, verwendet AudioLM zwei Arten von Audio-Tags.

Zuerst werden semantische Tags aus w2v-BERT extrahiert, einem selbstüberwachten Audiomodell.

Diese Tags können sowohl lokale Abhängigkeiten (wie Sprache in Sprache, lokale Melodie in Klaviermusik) als auch globale Langzeitstrukturen (wie Sprachsyntax und Semantik in Sprache) in Inhalt, Harmonie und Rhythmus erfassen Klaviermusik), während das Audiosignal stark heruntergesampelt wird, um lange Sequenzen zu modellieren.

Die Wiedergabetreue des aus diesen Tokens rekonstruierten Audios ist jedoch nicht hoch.

Um die Klangqualität zu verbessern, verwendet AudioLM zusätzlich zum semantischen Tagging auch akustische Tags, die vom neuronalen SoundStream-Codec generiert werden, um die Details der Audiowellenform (z. B. Lautsprechereigenschaften oder Aufnahmebedingungen) für hochqualitative Zwecke zu erfassen. Qualitätssynthese.

Wie trainiere ich?

AudioLM ist ein reines Audiomodell, das ohne symbolische Darstellung von Text oder Musik trainiert wird.

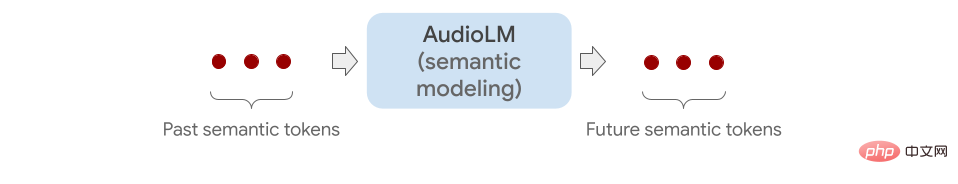

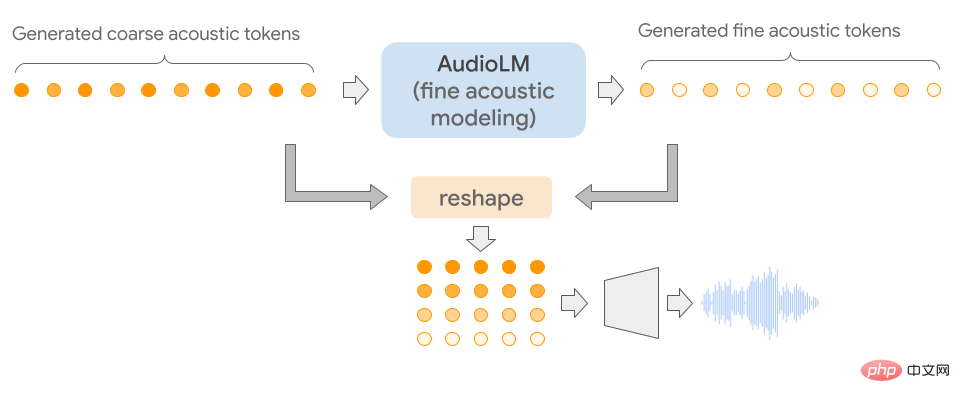

Es modelliert Audiosequenzen hierarchisch durch die Verkettung mehrerer Transformer-Modelle (eines für jede Stufe) vom semantischen Tagging bis zum feinen akustischen Tagging.

Jede Stufe wird darauf trainiert, das nächste Token basierend auf dem letzten Token vorherzusagen, genau wie das Training eines Sprachmodells.

In der ersten Stufe wird diese Aufgabe an semantischen Tags ausgeführt, um die übergeordnete Struktur der Audiosequenz zu modellieren.

In der zweiten Stufe wird die gesamte Sequenz semantischer Tags mit den vergangenen groben Tags verbunden und die beiden als Bedingungen der groben Stimme zugeführt Das Modell sagt dann zukünftige Token voraus. Dieser Schritt simuliert akustische Eigenschaften, wie zum Beispiel Lautsprechereigenschaften oder Klangfarbe in der Musik.

Nach Abschluss des Trainings kann AudioLM auf ein paar Sekunden Audio eingestellt werden, wodurch eine kontinuierliche Audiowiedergabe möglich ist.

Um die allgemeine Anwendbarkeit von AudioLM zu demonstrieren, testeten die Forscher es anhand von zwei Aufgaben in verschiedenen Audiobereichen.

Das erste ist die Sprachfortsetzung. Dieses Modell behält die vorgeschlagenen Sprechereigenschaften und Prosodie bei und gibt gleichzeitig neue Inhalte aus, die grammatikalisch korrekt und semantisch konsistent sind.

Das zweite ist die Piano-Fortsetzung. Dieses Modell erzeugt Klaviermusik, die in Bezug auf Melodie, Harmonie und Rhythmus mit der Eingabeaufforderung übereinstimmt.

Wie unten gezeigt, werden alle Töne, die Sie nach den grauen vertikalen Linien hören, von AudioLM erzeugt.

Um den Effekt zu überprüfen, baten die Forscher menschliche Bewerter, sich kurze Audioclips anzuhören, um festzustellen, ob es sich um Originalaufnahmen menschlicher Sprache oder um von AudioLM generierte Aufnahmen handelte.

Den gesammelten Bewertungen zufolge hat AudioLM eine Erfolgsquote von 51,2 %, was bedeutet, dass die von diesem KI-Modell erzeugte Sprache für normale Zuhörer nur schwer von echter Sprache zu unterscheiden ist.

Rupal Patel, der Informations- und Sprachwissenschaften an der Northeastern University studiert, sagte, dass frühere Arbeiten mit künstlicher Intelligenz zur Audioerzeugung diese Nuancen nur erfassen könnten, wenn sie in den Trainingsdaten explizit annotiert würden.

Im Gegensatz dazu lernt AudioLM diese Funktionen automatisch aus den Eingabedaten und erzielt auch Ergebnisse mit hoher Wiedergabetreue.

Mit dem Aufkommen multimodaler ML-Modelle wie GPT3 und Bloom (Textgenerierung), DALLE und Stable Diffusion (Bildgenerierung), RunwayML und Make-A-Video (Videogenerierung) verändern sich die Erstellung von Inhalten und die kreative Arbeit.

Die zukünftige Welt ist eine Welt, die durch künstliche Intelligenz generiert wird.

Referenzen:

https://www.php.cn/link/c11cb55c3d8dcc03a7ab7ab722703e0a

https://www.php.cn/link/b6b3598b407b7f328e3129c74 ca. 8ca94

https://www.php.cn/link/c5f7756d9f92a8954884ec415f79d120

https://www.php.cn/link/9b644ca9f37e3699ddf2055800130aa9

Das obige ist der detaillierte Inhalt vonDer Google AI-Sänger kommt! AudioLM kann Musik und Lieder komponieren, indem es einfach ein paar Sekunden lang zuhört.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

Um die Zeitüberschreitung für Vue Axios festzulegen, können wir eine Axios -Instanz erstellen und die Zeitleitungsoption angeben: in globalen Einstellungen: vue.Prototyp. $ Axios = axios.create ({Timeout: 5000}); In einer einzigen Anfrage: this. $ axios.get ('/api/user', {timeout: 10000}).

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der MySQL -Primärschlüssel kann nicht leer sein, da der Primärschlüssel ein Schlüsselattribut ist, das jede Zeile in der Datenbank eindeutig identifiziert. Wenn der Primärschlüssel leer sein kann, kann der Datensatz nicht eindeutig identifiziert werden, was zu Datenverwirrung führt. Wenn Sie selbstsinkrementelle Ganzzahlsspalten oder UUIDs als Primärschlüssel verwenden, sollten Sie Faktoren wie Effizienz und Raumbelegung berücksichtigen und eine geeignete Lösung auswählen.