Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Transformer imitiert das Gehirn, übertrifft 42 Modelle bei der Vorhersage der Bildgebung des Gehirns und kann auch die Übertragung zwischen den Sinnen und dem Gehirn simulieren

Transformer imitiert das Gehirn, übertrifft 42 Modelle bei der Vorhersage der Bildgebung des Gehirns und kann auch die Übertragung zwischen den Sinnen und dem Gehirn simulieren

Transformer imitiert das Gehirn, übertrifft 42 Modelle bei der Vorhersage der Bildgebung des Gehirns und kann auch die Übertragung zwischen den Sinnen und dem Gehirn simulieren

Viele KI-Anwendungsmodelle müssen jetzt eine Modellstruktur erwähnen:

Transformer.

Es verzichtet auf traditionelles CNN und RNN und besteht ausschließlich aus Aufmerksamkeitsmechanismen.

Transformer gibt verschiedenen KI-Anwendungsmodellen nicht nur die Möglichkeit, Artikel und Gedichte zu schreiben, sondern glänzt auch in multimodalen Aspekten.

Insbesondere nach der Veröffentlichung von ViT (Vision Transformer) wurde die Modellbarriere zwischen CV und NLP durchbrochen und nur ein Transformer-Modell kann multimodale Aufgaben bewältigen.

(Wer kann nach der Lektüre nicht sagen, wie leistungsfähig es ist?)

Obwohl Transformer ursprünglich für Sprachaufgaben entwickelt wurde, hat es auch großes Potenzial bei der Nachahmung des Gehirns.

Nein, ein wissenschaftlicher Autor hat einen Blog darüber geschrieben, wie Transformer das Gehirn modelliert.

Was hat er gesagt, als ich nach Kangkang kam?

Transformer: Machen Sie, was das Gehirn tut

Zuerst müssen wir seinen Evolutionsprozess klären.

Der Transformer-Mechanismus erschien erstmals vor 5 Jahren. Seine Leistungsfähigkeit ist größtenteils auf seinen Selbstaufmerksamkeitsmechanismus zurückzuführen.

Wie Transformer das Gehirn imitiert, lesen Sie weiter unten.

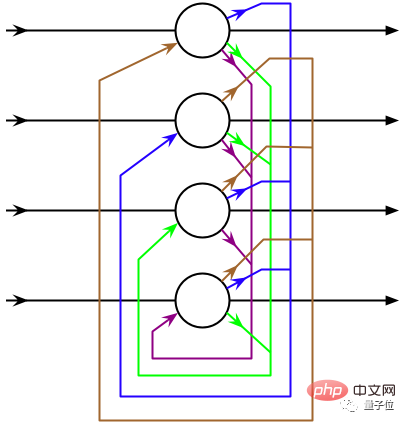

Im Jahr 2020 nutzte das Forschungsteam des österreichischen Informatikers Sepp Hochreiter Transformer, um das Hopfield Neural Network (ein Memory-Retrieval-Modell, HNN) neu zu organisieren.

Tatsächlich wurde das Hopfield-Neuronale Netzwerk vor 40 Jahren vorgeschlagen, und der Grund, warum sich das Forschungsteam nach Jahrzehnten für eine Neuorganisation dieses Modells entschieden hat, ist folgender:

Erstens folgt dieses Netzwerk einer universellen Regel: Neuronale Netzwerke, die aktiv sind Gleichzeitig werden die Elemente starke Verbindungen untereinander aufbauen.

Zweitens weist der Prozess des Abrufens von Erinnerungen durch das neuronale Hopfield-Netzwerk gewisse Ähnlichkeiten mit der Implementierung des Selbstaufmerksamkeitsmechanismus durch den Transformer auf.

Deshalb hat das Forschungsteam HNN neu organisiert, um bessere Verbindungen zwischen Neuronen herzustellen, sodass mehr Erinnerungen gespeichert und abgerufen werden können.

Der Reorganisationsprozess besteht, vereinfacht gesagt, darin, den Aufmerksamkeitsmechanismus des Transformers in HNN zu integrieren, sodass das ursprüngliche diskontinuierliche HNN zu einem kontinuierlichen Zustand wird.

△Quelle: Wikipedia

Das neu organisierte Hopfield-Netzwerk kann als Schicht in die Deep-Learning-Architektur integriert werden, um die Speicherung und den Zugriff auf ursprüngliche Eingabedaten, Zwischenergebnisse usw. zu ermöglichen.

Deshalb sagten sowohl Hopfield selbst als auch Dmitry Krotov vom MIT Watson Artificial Intelligence Laboratory:

Das transformatorbasierte neuronale Hopfield-Netzwerk ist biologisch vernünftig.

Obwohl dies bis zu einem gewissen Grad dem Funktionsprinzip des Gehirns ähnelt, ist es in einigen Aspekten nicht genau genug.

Also passten die Computerneurowissenschaftler Whittington und Behrens die Methode von Hochreiter an und nahmen einige Korrekturen am neu organisierten Hopfield-Netzwerk vor, wodurch die Leistung des Modells bei neurowissenschaftlichen Aufgaben (Replikation neuronaler Feuermuster im Gehirn) weiter verbessert wurde.

△Tim Behrens (links) James Whittington (rechts) Quelle: quantamagazine

Einfach ausgedrückt: Während der Kodierung-Dekodierung kodiert das Modell den Speicher nicht mehr als lineare Sequenz, sondern als Koordinaten auf hoher Ebene Dimensionsraum.

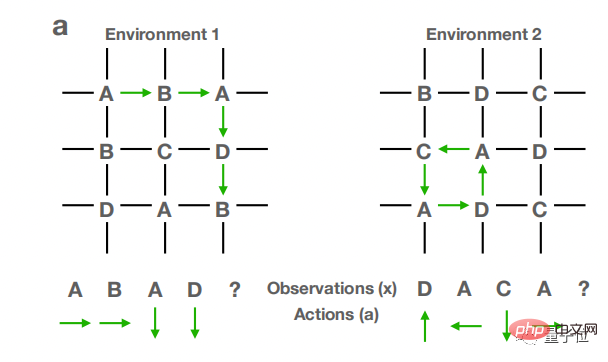

Konkret wird TEM (Tolman-Eichenbaum-Maschine) in das Modell eingeführt.

TEM ist ein assoziatives Gedächtnissystem, das die räumliche Navigationsfunktion des Hippocampus nachahmt.

Es ist in der Lage, räumliches und nichträumliches Strukturwissen zu verallgemeinern, die bei räumlichen und assoziativen Gedächtnisaufgaben beobachtete neuronale Leistung vorherzusagen und Neuzuordnungsphänomene im Hippocampus und im entorhinalen Kortex zu erklären.

Verschmelzung von TEM und Transformer, die so viele Funktionen haben, zum TEM-Transformer (TEM-t).

Lassen Sie dann das TEM-t-Modell in mehreren verschiedenen Weltraumumgebungen trainieren. Die Struktur der Umgebung ist in der folgenden Abbildung dargestellt.

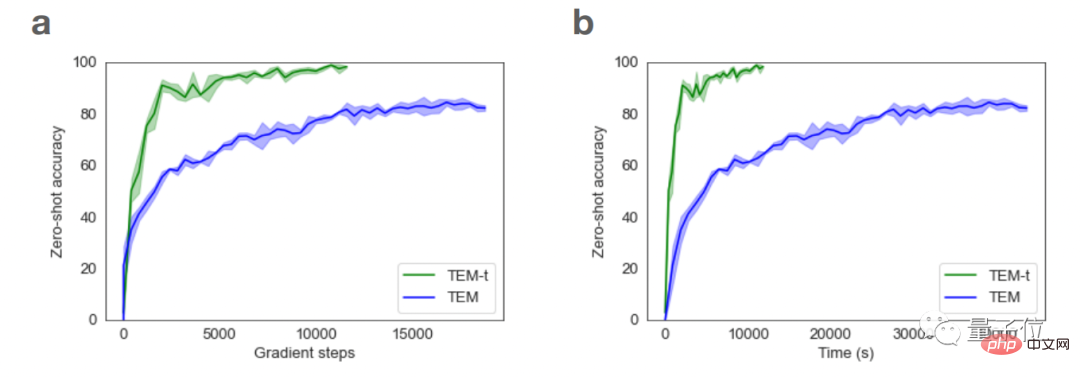

In TEM-t verfügt es immer noch über den Selbstaufmerksamkeitsmechanismus von Transformer. Auf diese Weise können die Lernergebnisse des Modells auf neue Umgebungen übertragen und zur Vorhersage neuer räumlicher Strukturen genutzt werden.

Untersuchungen zeigen außerdem, dass TEM-t im Vergleich zu TEM bei der Durchführung neurowissenschaftlicher Aufgaben effizienter ist und auch mehr Probleme mit weniger Lernproben bewältigen kann.

Transformer beschäftigt sich immer tiefer mit der Nachahmung von Gehirnmustern. Mit anderen Worten: Die Entwicklung von Transformer-Mustern fördert auch ständig unser Verständnis der Funktionsprinzipien von Gehirnfunktionen.

Darüber hinaus kann Transformer in mancher Hinsicht auch unser Verständnis anderer Funktionen des Gehirns verbessern.

Transformer hilft uns, das Gehirn zu verstehen

Zum Beispiel analysierte der Computerneurowissenschaftler Martin Schrimpf letztes Jahr 43 verschiedene Modelle neuronaler Netzwerke, um zu sehen, wie sie sich auf Messungen neuronaler Aktivität beim Menschen auswirken: funktionelle Magnetresonanztomographie (fMRT) und prädiktive Kraft des Elektrogramms im kortikalen Gehirn (EEG)-Berichte.

Unter anderem kann das Transformer-Modell fast alle in der Bildgebung festgestellten Veränderungen vorhersagen.

Rückblickend können wir vielleicht auch die Funktionsweise der entsprechenden Funktionen des Gehirns anhand des Transformer-Modells vorhersagen.

Darüber hinaus haben die Informatiker Yujin Tang und David Ha kürzlich ein Modell entworfen, das bewusst große Datenmengen auf zufällige und ungeordnete Weise durch das Transformer-Modell senden kann und so simuliert, wie der menschliche Körper sensorische Beobachtungen an das Gehirn übermittelt.

Dieser Transformer ist wie das menschliche Gehirn und kann erfolgreich mit einem gestörten Informationsfluss umgehen.

Obwohl das Transformer-Modell ständig verbessert wird, ist es nur ein kleiner Schritt in Richtung eines genauen Gehirnmodells und es sind eingehendere Untersuchungen erforderlich, um den Endpunkt zu erreichen.

Wenn Sie mehr darüber erfahren möchten, wie Transformer das menschliche Gehirn imitiert, können Sie auf den Link unten klicken~

Referenzlink:

[1]https://www.quantamagazine.org/how-ai-transformers- mimic-parts-of-the-brain-20220912/

[2]https://www.pnas.org/doi/10.1073/pnas.2105646118

[3]https://openreview.net/forum? id=B8DVo9B1YE0

Das obige ist der detaillierte Inhalt vonTransformer imitiert das Gehirn, übertrifft 42 Modelle bei der Vorhersage der Bildgebung des Gehirns und kann auch die Übertragung zwischen den Sinnen und dem Gehirn simulieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1384

1384

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Mar 18, 2024 am 09:20 AM

Mar 18, 2024 am 09:20 AM

Heute möchte ich eine aktuelle Forschungsarbeit der University of Connecticut vorstellen, die eine Methode zum Abgleichen von Zeitreihendaten mit großen NLP-Modellen (Natural Language Processing) im latenten Raum vorschlägt, um die Leistung von Zeitreihenprognosen zu verbessern. Der Schlüssel zu dieser Methode besteht darin, latente räumliche Hinweise (Eingabeaufforderungen) zu verwenden, um die Genauigkeit von Zeitreihenvorhersagen zu verbessern. Titel des Papiers: S2IP-LLM: SemanticSpaceInformedPromptLearningwithLLMforTimeSeriesForecasting Download-Adresse: https://arxiv.org/pdf/2403.05798v1.pdf 1. Hintergrundmodell für große Probleme

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren