Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Zum ersten Mal verlassen Sie sich nicht auf ein generatives Modell und lassen die KI Bilder in nur einem Satz bearbeiten!

Zum ersten Mal verlassen Sie sich nicht auf ein generatives Modell und lassen die KI Bilder in nur einem Satz bearbeiten!

Zum ersten Mal verlassen Sie sich nicht auf ein generatives Modell und lassen die KI Bilder in nur einem Satz bearbeiten!

2022 ist das Jahr, in dem AI Generated Content (AIGC) explodiert. Eine der beliebtesten Richtungen ist die Bearbeitung von Bildern durch Textbeschreibungen (Textaufforderungen). Bestehende Methoden basieren in der Regel auf generativen Modellen, die auf großen Datensätzen trainiert werden, was nicht nur zu hohen Datenerfassungs- und Trainingskosten führt, sondern auch zu größeren Modellgrößen. Diese Faktoren haben zu einer hohen Hemmschwelle für die tatsächliche Entwicklung und Anwendung von Technologie geführt und die Entwicklung und Kreativität von AIGC eingeschränkt.

Als Reaktion auf die oben genannten Probleme arbeitete das NetEase Interactive Entertainment AI Lab mit der Shanghai Jiao Tong University zusammen, um Forschungsarbeiten durchzuführen und innovativ eine Lösung auf Basis differenzierbarer Vektorrenderer vorzuschlagen— — CLIPVG ermöglicht erstmals eine textgesteuerte Bildbearbeitung, ohne auf ein generatives Modell angewiesen zu sein. Diese Lösung nutzt geschickt die Eigenschaften von Vektorelementen, um den Optimierungsprozess einzuschränken. Dadurch können nicht nur massive Datenanforderungen und ein hoher Trainingsaufwand vermieden werden, sondern auch das optimale Niveau hinsichtlich der Generierungseffekte erreicht werden. Das entsprechende Paper „CLIPVG: Text-Guided Image Manipulation Using Differentiable Vector Graphics“ wurde in AAAI 2023 aufgenommen.

- Papieradresse: https://arxiv.org/abs/2212.02122

- Offener Quellcode: https://github.com/NetEase-GameAI/clipvg# 🎜 🎜#

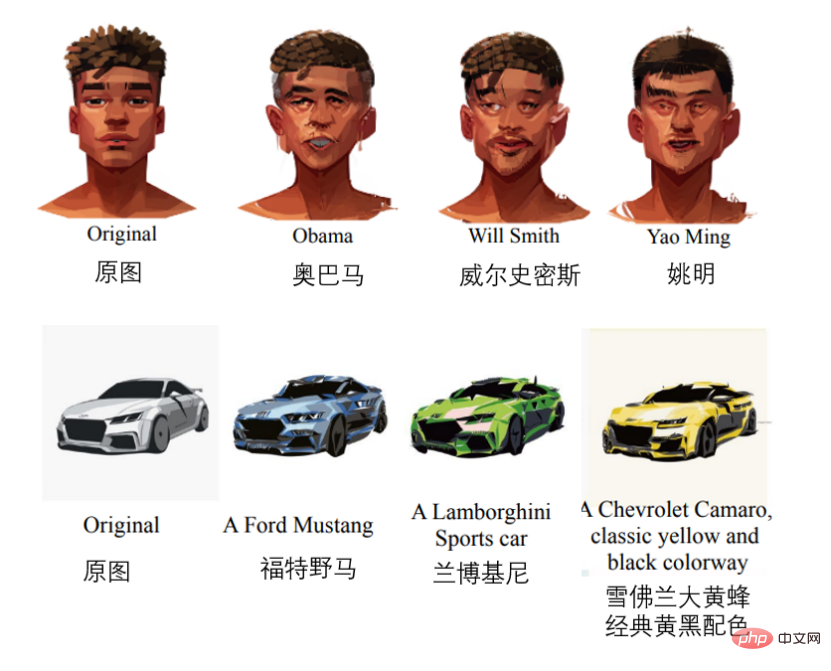

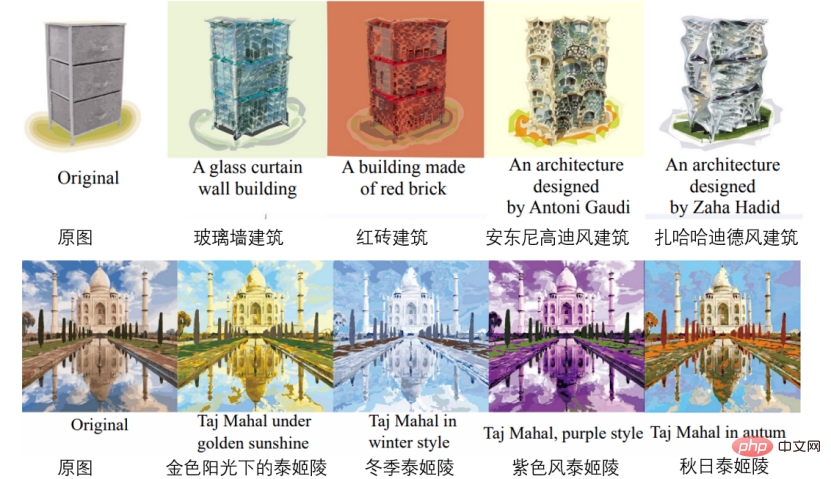

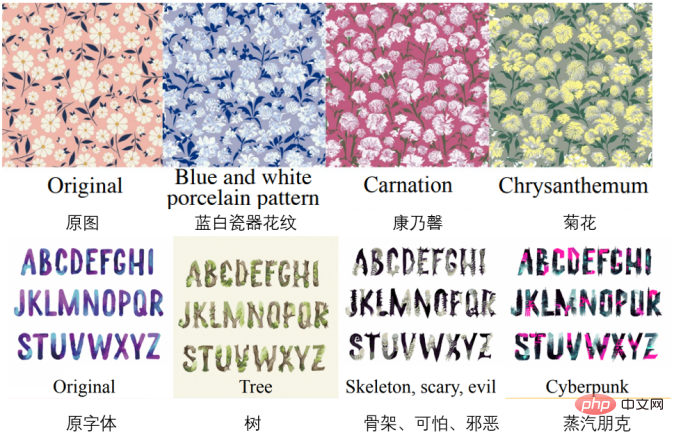

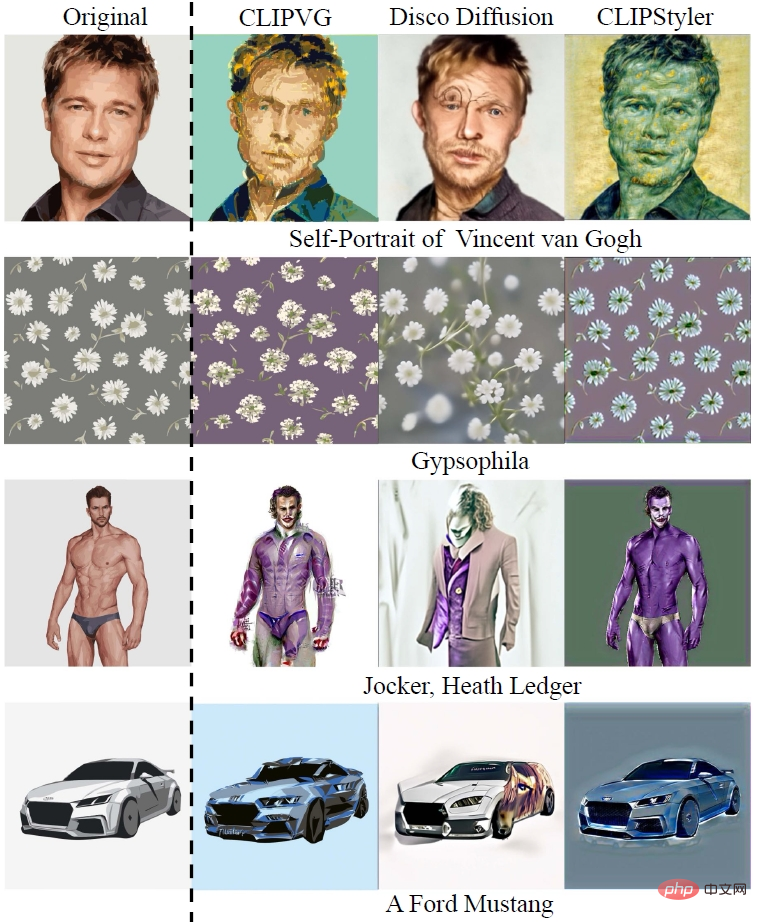

Einige der Effekte sind wie folgt (in der Reihenfolge Gesichtsbearbeitung, Änderung des Automodells, Gebäudegenerierung, Farbänderung, Musteränderung, Schriftartänderung).

Ideen und technischer Hintergrund

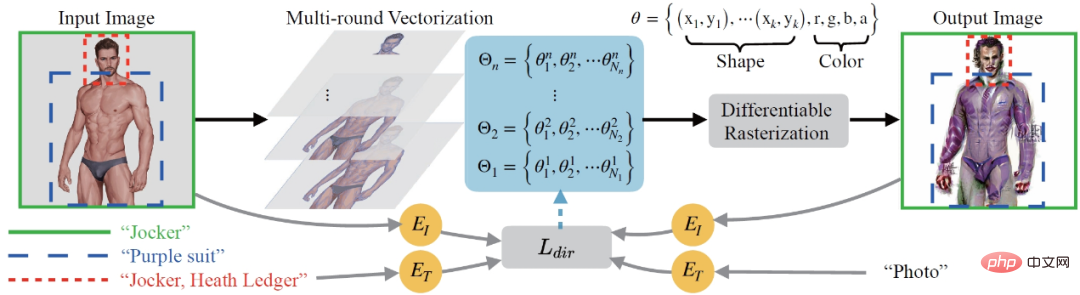

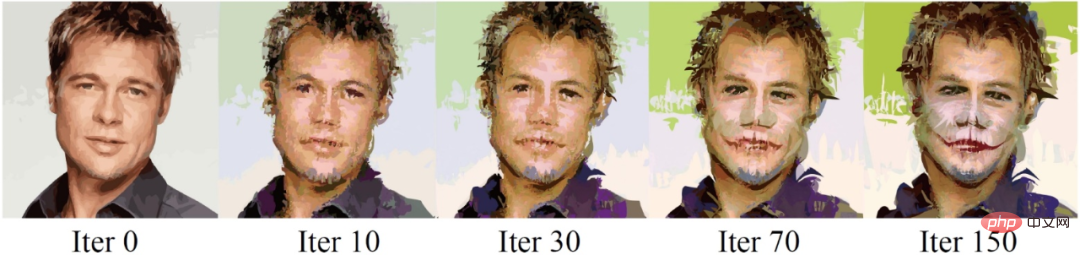

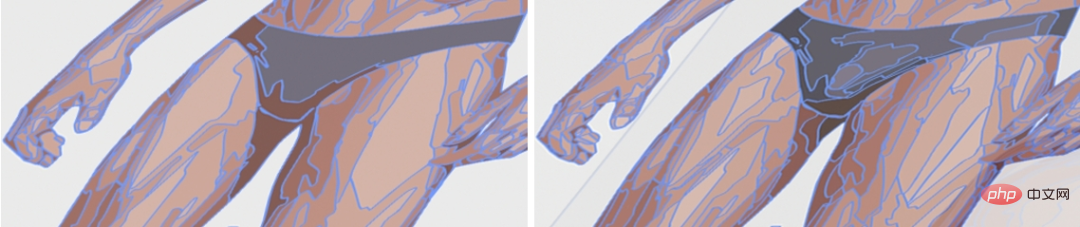

Aus Sicht des Gesamtprozesses schlug CLIPVG zunächst eine Multi-Runden-Vektorisierungsmethode vor, die Pixel robust konvertieren kann Bilder in Vektordomänen umwandeln und an spätere Bildbearbeitungsanforderungen anpassen. Anschließend wird ein ROI-CLIP-Verlust als Verlustfunktion definiert, um die Führung mit unterschiedlichem Text für jede Region of Interest (ROI) zu unterstützen. Der gesamte Optimierungsprozess verwendet einen differenzierbaren Vektorrenderer, um Gradientenberechnungen für Vektorparameter (wie Farbfelder, Kontrollpunkte usw.) durchzuführen.CLIPVG kombiniert Technologien aus zwei Bereichen, zum einen die textgeführte Bildbearbeitung im Pixelbereich und zum anderen die Generierung von Vektorbildern. Anschließend werden nacheinander die relevanten technischen Hintergründe vorgestellt.

Textgesteuerte Bildübersetzung

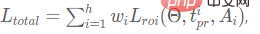

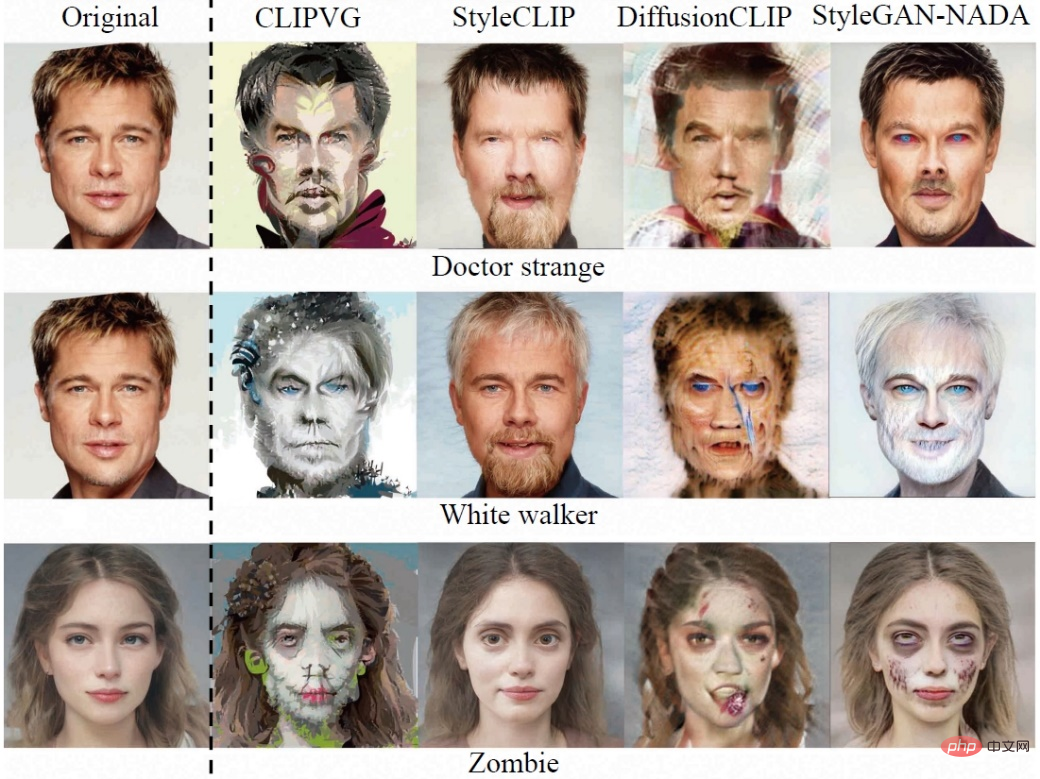

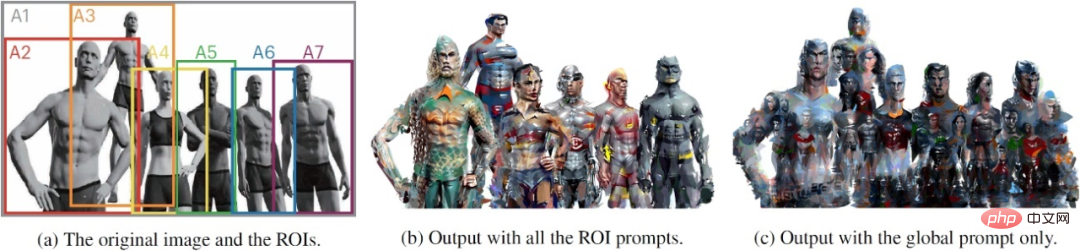

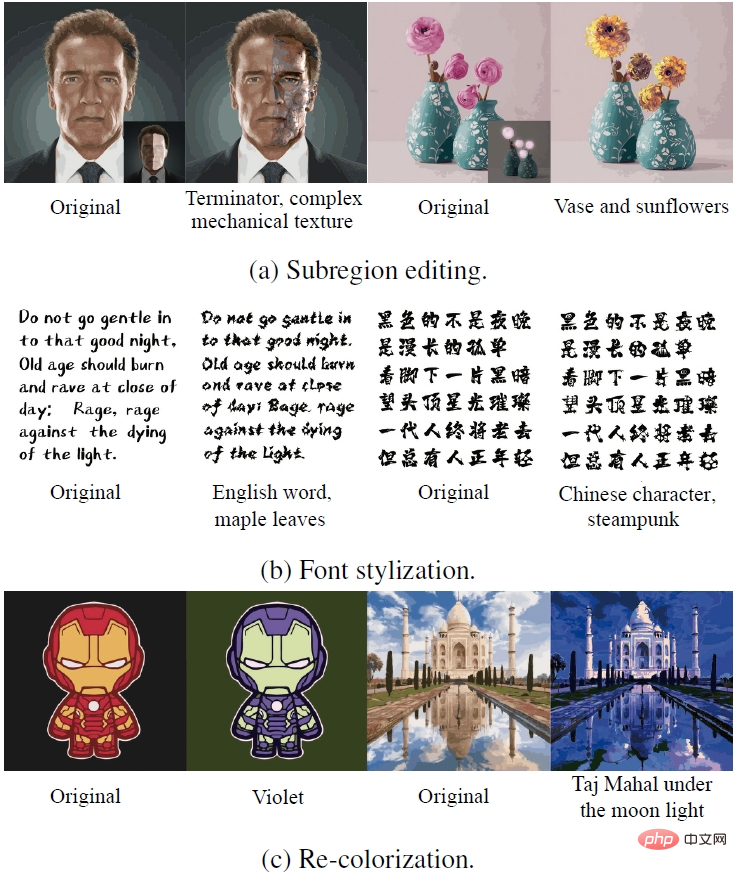

Überlassen Sie die Bearbeitung der KI in Bildern Beim „Verstehen“ von Textführung ist die typische Methode die Verwendung des CLIP-Modells (Contrastive Language-Image Pre-Training). Das CLIP-Modell kann Text und Bilder in vergleichbare latente Räume kodieren und modalübergreifende Ähnlichkeitsinformationen darüber liefern, „ob das Bild der Textbeschreibung entspricht“, wodurch eine semantische Verbindung zwischen Text und Bildern hergestellt wird. Tatsächlich ist es jedoch schwierig, die Bildbearbeitung nur mit dem CLIP-Modell effektiv zu steuern. Dies liegt daran, dass CLIP sich hauptsächlich auf die semantischen Informationen auf hoher Ebene des Bildes konzentriert und keine Einschränkungen für Details auf Pixelebene aufweist, was den Optimierungsprozess beeinträchtigt fallen leicht in ein lokales Optimum (lokales Minimum) oder kontradiktorische Lösungen.Eine gängige Methode besteht darin, CLIP mit einem Pixeldomänen-Generierungsmodell zu kombinieren, das auf GAN oder Diffusion basiert, wie z. B. StyleCLIP (Patashnik et al, 2021), StyleGAN-NADA (Gal et al, 2022). Disco Diffusion (Alembics 2022), DiffusionCLIP (Kim, Kwon und Ye 2022), DALL·E 2 (Ramesh et al, 2022) usw. Diese Schemata nutzen generative Modelle, um Bilddetails einzuschränken und gleichen so die Nachteile der alleinigen Verwendung von CLIP aus. Gleichzeitig sind diese generativen Modelle jedoch stark auf Trainingsdaten und Rechenressourcen angewiesen und begrenzen den effektiven Bereich der Bildbearbeitung durch die Bilder des Trainingssatzes. Durch die Fähigkeit zur Generierung von Modellen eingeschränkt, können Methoden wie StyleCLIP, StyleGAN-NADA und DiffusionCLIP ein einzelnes Modell nur auf ein bestimmtes Feld beschränken, z. B. Gesichtsbilder. Obwohl Methoden wie Disco Diffusion und DALL·E 2 jedes Bild bearbeiten können, erfordern sie enorme Daten- und Rechenressourcen, um ihre entsprechenden generativen Modelle zu trainieren. Es gibt derzeit nur sehr wenige Lösungen, die nicht auf generative Modelle setzen, wie zum Beispiel CLIPstyler (Kwon und Ye 2022). Während der Optimierung unterteilt CLIPstyler das zu bearbeitende Bild in zufällige Patches und verwendet die CLIP-Anleitung für jeden Patch, um die Einschränkungen für Bilddetails zu verstärken. Das Problem besteht darin, dass jeder Patch unabhängig die durch den Eingabetext definierte Semantik widerspiegelt. Daher kann diese Lösung nur eine Stilübertragung durchführen, aber keine umfassende semantische Bearbeitung des Bildes durchführen. Anders als die oben genannten Pixeldomänenmethoden nutzt die von NetEase Interactive Entertainment AI Lab vorgeschlagene CLIPVG-Lösung die Eigenschaften von Vektorgrafiken, um Bilddetails einzuschränken und das generative Modell zu ersetzen. CLIPVG kann jedes Eingabebild unterstützen und eine allgemeine Bildbearbeitung durchführen. Die Ausgabe ist eine Standard-Vektorgrafik im SVG-Format, die nicht durch die Auflösung begrenzt ist. Einige bestehende Arbeiten berücksichtigen die textgesteuerte Generierung von Vektorgrafiken, wie zum Beispiel CLIPdraw (Frans, Soros und Witkowski 2021) , StyleCLIPdraw (Schaldenbrand, Liu und Oh 2022) usw. Ein typischer Ansatz besteht darin, CLIP mit einem differenzierbaren Vektorrenderer zu kombinieren, von zufällig initialisierten Vektorgrafiken auszugehen und sich schrittweise der durch den Text dargestellten Semantik anzunähern. Der verwendete differenzierbare Vektorrenderer ist Diffvg (Li et al. 2020), der Vektorgrafiken durch differenzierbares Rendering in Pixelbilder rastern kann. CLIPVG verwendet Diffvg auch, um die Verbindung zwischen Vektorbildern und Pixelbildern herzustellen. Anders als bei bestehenden Methoden konzentriert sich CLIPVG auf die Bearbeitung vorhandener Bilder, anstatt sie direkt zu generieren. Da es sich bei den meisten vorhandenen Bildern um Pixelbilder handelt, müssen sie vektorisiert werden, bevor sie mit Vektorgrafikfunktionen bearbeitet werden können. Zu den bestehenden Vektorisierungsmethoden gehören Adobe Image Trace (AIT), LIVE (Ma et al. 2022) usw., diese Methoden berücksichtigen jedoch nicht den späteren Bearbeitungsbedarf. CLIPVG führt mehrere Runden von Methoden zur Vektorisierungsverbesserung ein, die auf vorhandenen Methoden basieren, um gezielt die Robustheit der Bildbearbeitung zu verbessern. Technische Umsetzung Der Gesamtprozess von CLIPVG ist unten dargestellt . Zunächst wird das Eingabepixelbild einer Mehrrunden-Vektorisierung (Mehrrunden-Vektorisierung) mit unterschiedlicher Genauigkeit unterzogen, wobei der in der i-ten Runde erhaltene Satz von Vektorelementen als Θi markiert wird. Die in jeder Runde erzielten Ergebnisse werden als Optimierungsobjekt überlagert und durch differenzierbares Vektorrendering (differenzierbare Rasterisierung) wieder in die Pixeldomäne umgewandelt. Der Ausgangszustand des Ausgabebildes ist die vektorisierte Rekonstruktion des Eingabebildes. Anschließend wird eine iterative Optimierung in der im Text beschriebenen Richtung durchgeführt. Der Optimierungsprozess berechnet den ROI-CLIP-Verlust ( Der gesamte iterative Optimierungsprozess ist im folgenden Beispiel zu sehen, in dem der Leittext „Jocker, Heath Ledger“ (Joker), Heath Ledger). Vektorisiert Eine Vektorgrafik kann als eine Sammlung von Vektorelementen definiert werden, wobei jedes Vektorelement durch eine Reihe von Parametern gesteuert wird. Die Parameter des Vektorelements hängen von seinem Typ ab. Am Beispiel der gefüllten Kurve sind seine Parameter , wobei der Kontrollpunktparameter und der Parameter für RGB-Farbe und Deckkraft ist . Bei der Optimierung von Vektorelementen gibt es einige natürliche Einschränkungen. Beispielsweise ist die Farbe innerhalb eines Elements immer konsistent und die topologische Beziehung zwischen seinen Kontrollpunkten ist ebenfalls festgelegt. Diese Funktionen gleichen den Mangel an detaillierten Einschränkungen bei CLIP aus und können die Robustheit des Optimierungsprozesses erheblich verbessern. Theoretisch kann CLIPVG mit jeder vorhandenen Methode vektorisiert werden. Untersuchungen haben jedoch ergeben, dass dies zu mehreren Problemen bei der anschließenden Bildbearbeitung führen kann. Erstens kann mit der üblichen Vektorisierungsmethode sichergestellt werden, dass die benachbarten Vektorelemente des Bildes im Ausgangszustand perfekt ausgerichtet sind. Allerdings bewegt sich jedes Element mit dem Optimierungsprozess, wodurch „Risse“ zwischen den Elementen entstehen. Zweitens ist das Eingabebild manchmal relativ einfach und erfordert nur eine kleine Anzahl von Vektorelementen zur Anpassung, während der Effekt der Textbeschreibung die Darstellung komplexerer Details erfordert, was dazu führt, dass bei der Bildbearbeitung die notwendigen Rohmaterialien (Vektorelemente) fehlen. Als Reaktion auf die oben genannten Probleme schlug CLIPVG eine Mehrrunden-Vektorisierungsstrategie vor. In jeder Runde werden vorhandene Methoden aufgerufen, um ein vektorisiertes Ergebnis zu erhalten, das der Reihe nach überlagert wird. Jede Runde verbessert die Genauigkeit im Vergleich zur vorherigen Runde, d. h. die Vektorisierung erfolgt mit kleineren Blöcken von Vektorelementen. Die folgende Abbildung spiegelt den Unterschied in den unterschiedlichen Genauigkeiten während der Vektorisierung wider. Der durch die i-te Vektorisierungsrunde erhaltene Satz von Vektorelementen kann als Verlustfunktion Ähnlich wie StyleGAN-NADA und CLIPstyler verwendet CLIPVG einen gerichteten CLIP-Verlust, um die Übereinstimmung zwischen dem generierten Bild und dem Beschreibungstext zu messen, der wie folgt definiert ist: wobei wobei Ai der i-te ROI-Bereich und Der Gesamtverlust ist die Summe der ROI-CLIP-Verluste aller Regionen, also Eine Region kann hier ein ROI oder ein vom ROI abgeschnittener Patch sein. CLIPVG optimiert den Vektorparametersatz Θ basierend auf der obigen Verlustfunktion. Bei der Optimierung können Sie auch nur auf eine Teilmenge von Θ abzielen, z. B. auf Formparameter, Farbparameter oder einige Vektorelemente, die einem bestimmten Bereich entsprechen. Im experimentellen Teil verifizierte CLIPVG zunächst die Wirksamkeit mehrerer Runden von Vektorisierungsstrategien und Vektordomänenoptimierung durch Ablationsexperimente, verglich sie dann mit bestehenden Basislinien und demonstrierte schließlich einzigartige Anwendungsszenarien. Ablationsexperiment Die Studie verglich zunächst die Wirkung einer Vektorisierungsstrategie mit mehreren Runden (Multi-Round) und nur einer Vektorisierungsrunde (One-Shot). Die erste Zeile in der Abbildung unten ist das erste Ergebnis nach der Vektorisierung und die zweite Zeile ist das bearbeitete Ergebnis. wobei Nc die Genauigkeit der Vektorisierung darstellt. Es ist ersichtlich, dass mehrere Vektorisierungsrunden nicht nur die Rekonstruktionsgenauigkeit des Anfangszustands verbessern, sondern auch die Risse zwischen bearbeiteten Vektorelementen wirksam beseitigen und die Detailleistung verbessern. Um die Eigenschaften der Vektordomänenoptimierung weiter zu untersuchen, vergleicht das Papier die Auswirkungen von CLIPVG (Vektordomänenmethode) und CLIPstyler (Pixeldomänenmethode) unter Verwendung verschiedener Patchgrößen zur Verbesserung. Die erste Zeile in der Abbildung unten zeigt die Wirkung von CLIPVG bei Verwendung verschiedener Patchgrößen und die zweite Zeile zeigt die Wirkung von CLIPstyler. Die Textbeschreibung lautet „Doctor Strange“. Die Auflösung des gesamten Bildes beträgt 512x512. Es ist ersichtlich, dass bei einer kleinen Patchgröße (128 x 128 oder 224 x 224) sowohl CLIPVG als auch CLIPstyler in kleinen lokalen Bereichen die repräsentativen roten und blauen Farben von „Doctor Strange“ anzeigen, sich die Semantik des gesamten Gesichts jedoch nicht wesentlich ändert . . Dies liegt daran, dass die CLIP-Anleitung zu diesem Zeitpunkt nicht auf das gesamte Bild angewendet wird. Wenn CLIPVG die Patchgröße auf 410 x 410 erhöht, können Sie offensichtliche Änderungen in der Charakteridentität erkennen, einschließlich Frisuren und Gesichtszügen, die entsprechend den Textbeschreibungen effektiv bearbeitet werden. Wenn die Patch-Verbesserung entfernt wird, werden der semantische Bearbeitungseffekt und die Detailklarheit verringert, was darauf hindeutet, dass die Patch-Verbesserung immer noch einen positiven Effekt hat. Im Gegensatz zu CLIPVG kann CLIPstyler die Identität des Charakters immer noch nicht ändern, wenn der Patch größer ist oder der Patch entfernt wird, sondern nur die Gesamtfarbe und einige lokale Texturen. Der Grund dafür ist, dass die Methode zur Vergrößerung der Patchgröße im Pixelbereich die zugrunde liegenden Einschränkungen verliert und in ein lokales Optimum fällt. Diese Vergleichsreihe zeigt, dass CLIPVG die Detailbeschränkungen in der Vektordomäne effektiv nutzen und eine semantische Bearbeitung auf hoher Ebene in Kombination mit dem größeren CLIP-Bereich (Patchgröße) erreichen kann, was mit Pixeldomänenmethoden schwer zu erreichen ist. Vergleichsexperiment Im Vergleichsexperiment verglich die Studie zunächst CLIPVG mit zwei Pixel-Domain-Methoden, die jedes Bild bearbeiten können, einschließlich Disco Diffusion und CLIPstyler, wie Sie im Bild unten als Beispiel sehen können Bei „Selbstporträt von Vincent van Gogh“ kann CLIPVG sowohl die Charakteridentität als auch den Malstil bearbeiten, während die Pixeldomänenmethode nur einen davon erreichen kann. Für „Gypsophila“ kann CLIPVG die Anzahl und Form der Blütenblätter genauer bearbeiten als die Basismethode. In den Beispielen „Jocker, Heath Ledger“ und „A Ford Mustang“ kann CLIPVG auch die Gesamtsemantik stark verändern. Relativ gesehen ist Disco Diffusion anfällig für lokale Fehler, während CLIPstyler im Allgemeinen nur die Textur und Farbe anpasst. (Von oben nach unten: Van-Gogh-Gemälde, Schleierkraut, Heath Ledger Joker, Ford Mustang) Die Forscher verglichen dann die Bilder in bestimmten Bereichen (um das menschliche Gesicht als zu nehmen). Ein Beispiel) Zu den Pixeldomänenmethoden gehören StyleCLIP, DiffusionCLIP und StyleGAN-NADA. Aufgrund des eingeschränkten Einsatzbereichs ist die Generierungsqualität dieser Basismethoden im Allgemeinen stabiler. In dieser Reihe von Vergleichen zeigt CLIPVG immer noch, dass die Wirkung den bestehenden Methoden nicht nachsteht, insbesondere ist der Grad der Konsistenz mit dem Zieltext oft höher. (Von oben nach unten: Doctor Strange, White Walkers, Zombies) Mit den Eigenschaften von Vektorgrafiken und Verlustfunktionen auf ROI-Ebene kann CLIPVG eine Reihe innovativer Gameplays unterstützen, die mit vorhandenen Methoden nur schwer zu erreichen sind. Beispielsweise wird der Bearbeitungseffekt des am Anfang dieses Artikels gezeigten Mehrpersonenbilds durch die Definition verschiedener Textbeschreibungen auf ROI-Ebene für verschiedene Charaktere erreicht. Die linke Seite des Bildes unten ist die Eingabe, die Mitte ist das Bearbeitungsergebnis der Textbeschreibung auf ROI-Ebene und die rechte Seite ist das Ergebnis des gesamten Bildes mit nur einer Gesamttextbeschreibung. Die den Bereichen A1 bis A7 entsprechenden Beschreibungen lauten 1. „Justice League Six“, 2. „Aquaman“, 3. „Superman“, 4. „Wonder Woman“, 5. „Cyborg“ (Cyborg), 6. „Flash“. , DC Superhero“ (The Flash, DC) und 7. „Batman“ (Batman). Es ist ersichtlich, dass die Beschreibung auf ROI-Ebene für jedes Zeichen separat bearbeitet werden kann, die Gesamtbeschreibung jedoch keine wirksamen individuellen Identitätsmerkmale generieren kann. Da die ROIs einander überlappen, ist es für bestehende Methoden schwierig, die Gesamtkoordination von CLIPVG zu erreichen, selbst wenn jedes Zeichen einzeln bearbeitet wird. CLIPVG kann durch die Optimierung einiger Vektorparameter auch eine Vielzahl spezieller Bearbeitungseffekte erzielen. Die erste Zeile im Bild unten zeigt den Effekt, wenn nur ein Teilbereich bearbeitet wird. Die zweite Zeile zeigt den Schriftgenerierungseffekt, der durch das Sperren der Farbparameter und die Optimierung nur der Formparameter entsteht. Die dritte Zeile ist das Gegenteil der zweiten Zeile und erreicht den Zweck der Neufärbung, indem nur die Farbparameter optimiert werden. (von oben nach unten: Teilbereichsbearbeitung, Schriftstilisierung, Bildfarbänderung) Vektorbildgenerierung

) basierend auf dem Flächenbereich und dem zugehörigen Text jedes ROI und optimiert jedes Vektorelement entsprechend dem Farbverlauf, einschließlich Farbparametern und Form Parameter.

) basierend auf dem Flächenbereich und dem zugehörigen Text jedes ROI und optimiert jedes Vektorelement entsprechend dem Farbverlauf, einschließlich Farbparametern und Form Parameter.

ausgedrückt werden, und der durch Überlagerung der Ergebnisse aller Runden erhaltene Satz von Vektorelementen wird als

ausgedrückt werden, und der durch Überlagerung der Ergebnisse aller Runden erhaltene Satz von Vektorelementen wird als  gekennzeichnet. Das ist das Gesamtoptimierungsobjekt von CLIPVG.

gekennzeichnet. Das ist das Gesamtoptimierungsobjekt von CLIPVG.

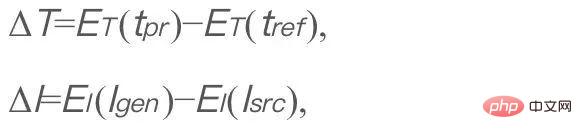

die Eingabetextbeschreibung darstellt.

die Eingabetextbeschreibung darstellt.  ist ein fester Referenztext, der in CLIPVG auf „Foto“ eingestellt ist, und

ist ein fester Referenztext, der in CLIPVG auf „Foto“ eingestellt ist, und  ist das generierte Bild (das zu optimierende Objekt).

ist das generierte Bild (das zu optimierende Objekt).  ist das Originalbild.

ist das Originalbild.  und

und  sind die Text- bzw. Bildcodecs von CLIP. ΔT und ΔI stellen die latenten Raumrichtungen von Text bzw. Bild dar. Der Zweck der Optimierung dieser Verlustfunktion besteht darin, die semantische Änderungsrichtung des Bildes nach der Bearbeitung an die Beschreibung des Textes anzupassen. Der feste t_ref wird in nachfolgenden Formeln ignoriert. In CLIPVG ist das generierte Bild das Ergebnis einer differenzierbaren Darstellung von Vektorgrafiken. Darüber hinaus unterstützt CLIPVG die Zuweisung unterschiedlicher Textbeschreibungen zu jedem ROI. Zu diesem Zeitpunkt wird der gerichtete CLIP-Verlust in den folgenden ROI-CLIP-Verlust umgewandelt:

sind die Text- bzw. Bildcodecs von CLIP. ΔT und ΔI stellen die latenten Raumrichtungen von Text bzw. Bild dar. Der Zweck der Optimierung dieser Verlustfunktion besteht darin, die semantische Änderungsrichtung des Bildes nach der Bearbeitung an die Beschreibung des Textes anzupassen. Der feste t_ref wird in nachfolgenden Formeln ignoriert. In CLIPVG ist das generierte Bild das Ergebnis einer differenzierbaren Darstellung von Vektorgrafiken. Darüber hinaus unterstützt CLIPVG die Zuweisung unterschiedlicher Textbeschreibungen zu jedem ROI. Zu diesem Zeitpunkt wird der gerichtete CLIP-Verlust in den folgenden ROI-CLIP-Verlust umgewandelt:

seine zugehörige Textbeschreibung ist. R ist ein differenzierbarer Vektorrenderer und R(Θ) ist das gesamte gerenderte Bild.

seine zugehörige Textbeschreibung ist. R ist ein differenzierbarer Vektorrenderer und R(Θ) ist das gesamte gerenderte Bild.  ist das gesamte Eingabebild.

ist das gesamte Eingabebild.  stellt einen Zuschneidevorgang dar, d. h. das Zuschneiden des Bereichs

stellt einen Zuschneidevorgang dar, d. h. das Zuschneiden des Bereichs  aus Bild I. CLIPVG unterstützt auch ein Patch-basiertes Verbesserungsschema ähnlich dem in CLIPstyler, d. h. mehrere Patches können aus jedem ROI weiter zufällig beschnitten werden, und der CLIP-Verlust wird für jeden Patch basierend auf der Textbeschreibung berechnet, die dem ROI entspricht.

aus Bild I. CLIPVG unterstützt auch ein Patch-basiertes Verbesserungsschema ähnlich dem in CLIPstyler, d. h. mehrere Patches können aus jedem ROI weiter zufällig beschnitten werden, und der CLIP-Verlust wird für jeden Patch basierend auf der Textbeschreibung berechnet, die dem ROI entspricht.

ist der Gewichtsverlust, der jedem Bereich entspricht.

ist der Gewichtsverlust, der jedem Bereich entspricht. Experimentelle Ergebnisse

Mehr Anwendungen

Das obige ist der detaillierte Inhalt vonZum ersten Mal verlassen Sie sich nicht auf ein generatives Modell und lassen die KI Bilder in nur einem Satz bearbeiten!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1375

1375

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Mar 18, 2024 am 09:20 AM

Mar 18, 2024 am 09:20 AM

Heute möchte ich eine aktuelle Forschungsarbeit der University of Connecticut vorstellen, die eine Methode zum Abgleichen von Zeitreihendaten mit großen NLP-Modellen (Natural Language Processing) im latenten Raum vorschlägt, um die Leistung von Zeitreihenprognosen zu verbessern. Der Schlüssel zu dieser Methode besteht darin, latente räumliche Hinweise (Eingabeaufforderungen) zu verwenden, um die Genauigkeit von Zeitreihenvorhersagen zu verbessern. Titel des Papiers: S2IP-LLM: SemanticSpaceInformedPromptLearningwithLLMforTimeSeriesForecasting Download-Adresse: https://arxiv.org/pdf/2403.05798v1.pdf 1. Hintergrundmodell für große Probleme

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.