Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Es ist wirklich nicht Versailles! ChatGPT ist so erfolgreich, dass selbst OpenAI es nicht versteht

Es ist wirklich nicht Versailles! ChatGPT ist so erfolgreich, dass selbst OpenAI es nicht versteht

Es ist wirklich nicht Versailles! ChatGPT ist so erfolgreich, dass selbst OpenAI es nicht versteht

Dieses Unternehmen hat ein Produkt hergestellt, das möglicherweise die vierte industrielle Revolution auslöst, aber es rätselt: Warum sind seine Produkte so beliebt?

Nur, es ist wirklich nicht Versailles.

Kürzlich interviewte MIT Technology Review mehrere Entwickler von ChatGPT und gab uns einen genaueren Einblick in die Geschichte hinter diesem beliebten KI-Produkt.

Es ist so beliebt, dass es überhaupt keine Verteidigung gibt

Als OpenAI Ende November 2022 still und leise ChatGPT startete, hatte das Startup keine großen Erwartungen.

Die Mitarbeiter von OpenAI hätten nie gedacht, dass ihr Modell auf dem Weg zum Spitzenmodell sein würde.

ChatGPT scheint über Nacht populär geworden zu sein, was einen globalen Goldrausch für große Sprachmodelle auslöst. OpenAI ist jedoch überhaupt nicht darauf vorbereitet und kann nur versuchen, die Geschäftschancen zu nutzen .

Sandhini Agarwal, der bei OpenAI an Richtlinien arbeitet, sagte, dass ChatGPT innerhalb von OpenAI immer als „Forschungsvorschau“ angesehen wurde – es ist eine vollständigere Version der zwei Jahre alten Technologie und, was noch wichtiger ist, Das Unternehmen versucht, öffentliches Feedback weiterzugeben, um einige Mängel des Modells zu beseitigen.

Wer hätte gedacht, dass ein solches „Vorschau“-Produkt nach seinem Debüt durch Zufall populär werden würde.

Die Wissenschaftler von OpenAI sind darüber sehr verwirrt, und sie sind sich auch der Blumen und des Applauses von außen sehr bewusst.

„Wir wollen dies nicht als großen grundlegenden Fortschritt übertreiben“, sagte Liam Fedus, ein OpenAI-Wissenschaftler, der an der Entwicklung von ChatGPT beteiligt war.

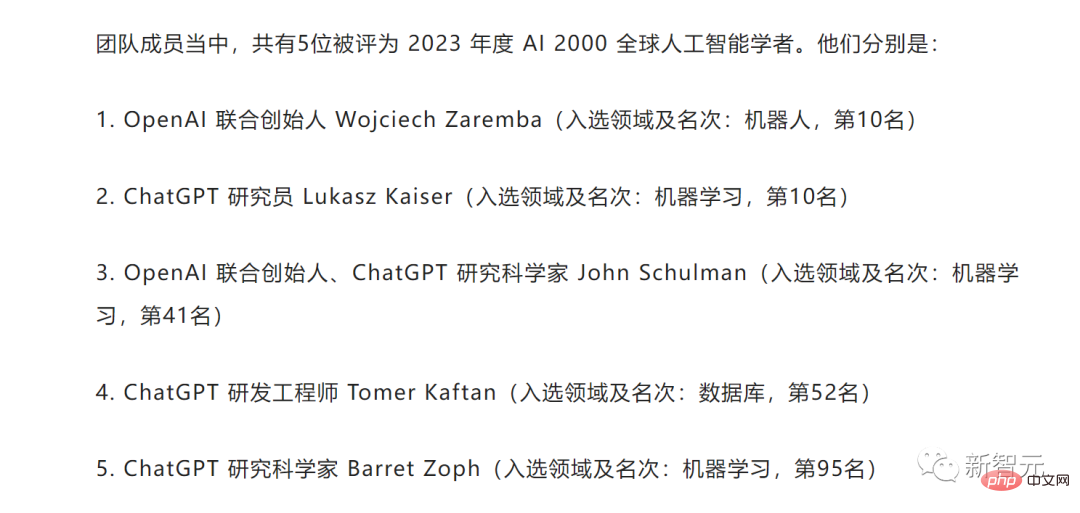

Von den Mitgliedern des ChatGPT-Teams wurden 5 im Jahr 2023 zu AI 2000 Global Artificial Intelligence Scholars ernannt.

Aus diesem Grund interviewte MIT Technology Review-Reporter Will Douglas Heaven das Joint Venture von OpenAI-Gründer John Schulman, Entwickler Agarwal und Fedus und Leiter des Alignment-Teams Jan Leike.

Wir verstehen nicht einmal, warum ChatGPT so beliebt ist

Gründer John Schulman sagte, dass er einige Tage nach der Veröffentlichung von ChatGPT von Zeit zu Zeit Twitter checken würde. Es gab eine verrückte Zeit, in der der Twitter-Feed mit Screenshots von ChatGPT gefüllt war.

Er dachte, dass dies ein Produkt sei, das für Benutzer sehr intuitiv sei und dass es einige Fans haben würde, aber er hatte nicht erwartet, dass es so Mainstream werden würde.

Jan Leike sagte, dass alles so plötzlich kam und alle überrascht waren und sich bemühten, mit der Popularität von ChatGPT Schritt zu halten. Er war neugierig, was hinter der steigenden Popularität steckte. Schließlich kann OpenAI selbst nicht herausfinden, warum ChatGPT so beliebt ist.

Liam Fedus erklärte, warum sie so überrascht waren, denn ChatGPT ist nicht der erste Allzweck-Chatbot, und viele Leute haben ihn schon einmal ausprobiert, sodass Liam Fedus der Meinung ist, dass ihre Chancen nicht groß sind. Die private Beta-Version gab ihm jedoch auch Zuversicht – vielleicht ist dieses A etwas, das den Benutzern wirklich gefallen wird.

Sandhini Agarwal kam zu dem Schluss, dass der sofortige Erfolg von ChatGPT für alle eine Überraschung war. An diesen Modellen wurde so viel Arbeit geleistet, dass wir vergessen, wie beeindruckend sie für die breite Öffentlichkeit außerhalb des Unternehmens sind.

Tatsächlich sind die meisten Technologien in ChatGPT nicht neu. Es handelt sich um eine verfeinerte Version von GPT-3.5, die OpenAI einige Monate vor ChatGPT veröffentlicht hat. GPT-3.5 selbst ist eine aktualisierte Version von GPT-3, das im Jahr 2020 erschien.

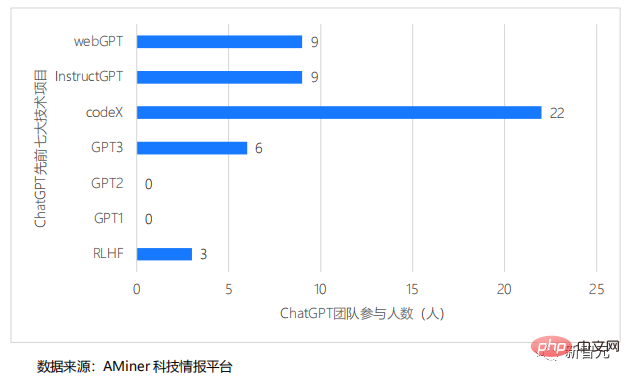

Das ChatGPT-Team hat an den letzten sieben großen Technologie-F&E-Nummern teilgenommen

Auf der Website stellt OpenAI diese Modelle in Form von Anwendungsprogrammierschnittstellen oder APIs zur Verfügung, die andere Entwickler problemlos einfügen können die Modelle in Ihrem eigenen Code.

Im Januar 2022 veröffentlichte OpenAI auch InstructGPT, eine frühere, fein abgestimmte Version von GPT-3.5. Allerdings werden diese Technologien nicht öffentlich beworben.

Feinabstimmungsprozess

Laut der Einführung von Liam Fedus basiert die Feinabstimmung des ChatGPT-Modells auf demselben Sprachmodell wie InstructGPT, und die verwendete Feinabstimmungsmethode ist ähnlich. Die Forscher fügten einige Gesprächsdaten hinzu und nahmen einige Anpassungen am Trainingsprozess vor. Sie wollen es also nicht als großen grundlegenden Fortschritt übertreiben.

Es stellt sich heraus, dass die Konversationsdaten eine große Rolle in ChatGPT spielen.

Nach der Auswertung von Standard-Benchmarks gibt es eigentlich keinen großen Unterschied in den reinen technischen Fähigkeiten zwischen den beiden Modellen. Der größte Unterschied zwischen ChatGPT besteht darin, dass es einfacher zu beziehen und zu verwenden ist.

Jan Leike erklärte, dass ChatGPT gewissermaßen als eine Version des KI-Systems verstanden werden kann, über das OpenAI seit einiger Zeit verfügt. ChatGPT ist nicht leistungsfähiger. Das gleiche Grundmodell wurde fast ein Jahr lang auf der API verwendet, bevor ChatGPT herauskam.

Die von den Forschern erzielten Verbesserungen lassen sich in gewisser Weise so zusammenfassen, dass sie besser zu dem passen, wofür Menschen es nutzen möchten. Es spricht mit dem Benutzer in einem Gespräch, ist eine Chat-Schnittstelle und leicht zugänglich. Dadurch lässt sich die Absicht leichter ableiten, und Benutzer können hin und her experimentieren, um das zu erreichen, was sie wollen.

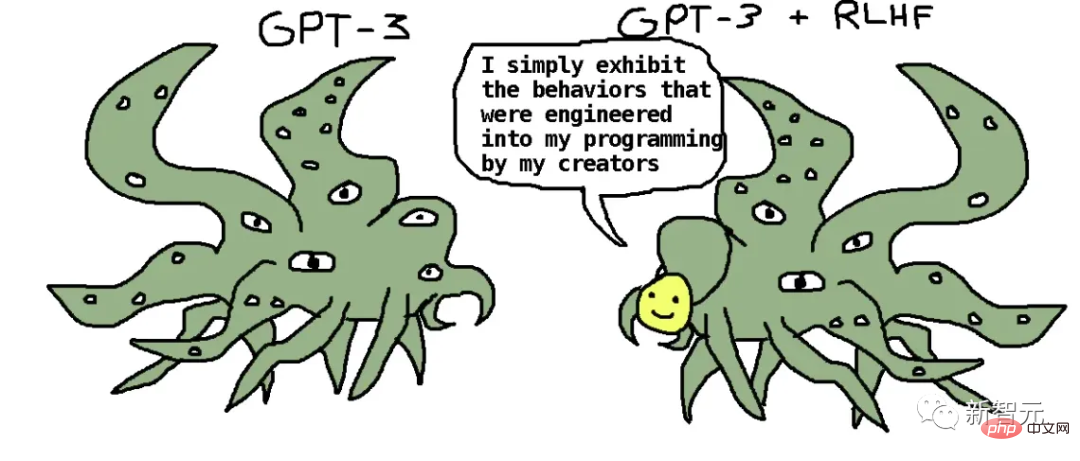

Das Geheimnis ist die Reinforcement Learning with Human Feedback (RLHF)-Technologie, die der Trainingsmethode von InstructGPT sehr ähnlich ist – indem sie ihr beibringt, was menschliche Benutzer tatsächlich mögen.

Jan Leike sagte, dass sie eine große Gruppe von Leuten gebeten hätten, die Aufforderungen und Antworten von ChatGPT zu lesen und dann zwischen zwei Antworten zu wählen, um zu sehen, welche Antwort jeder für besser hielt. Anschließend werden alle diese Daten in einer Trainingseinheit zusammengefasst.

Das meiste davon ist dasselbe wie das, was sie auf InstructGPT tun. Sie hoffen, dass es hilfreich ist, Sie hoffen, dass es wahr ist, Sie hoffen, dass es nicht bösartig ist.

Es gibt auch einige Details. Wenn die Anfrage des Benutzers beispielsweise nicht klar ist, sollte er Folgefragen stellen, um sie zu verfeinern. Es sollte auch klargestellt werden, dass es sich um ein künstliches Intelligenzsystem handelt und keine Identität annehmen sollte, die es nicht besitzt, oder behaupten sollte, über Fähigkeiten zu verfügen, die es nicht besitzt. Wenn ein Benutzer ihn auffordert, eine Aufgabe auszuführen, die er nicht ausführen soll, muss er dies ausdrücklich ablehnen.

Das heißt, es gibt eine Liste verschiedener Kriterien, nach denen menschliche Bewerter die Modelle bewerten müssen, beispielsweise die Authentizität. Sie werden aber auch bestimmte Praktiken bevorzugen, wie zum Beispiel, dass KI nicht vorgibt, ein Mensch zu sein.

Bereit zur Veröffentlichung

Im Allgemeinen verwendet ChatGPT Technologien, die OpenAI bereits verwendet hat, daher hat das Team bei der Vorbereitung der Veröffentlichung dieses Modells für die Öffentlichkeit nichts Besonderes unternommen. Ihrer Ansicht nach waren die für Vorgängermodelle festgelegten Standards ausreichend und GPT-3.5 sicher genug.

Im ChatGPT-Training menschlicher Vorlieben lernte es von selbst Ablehnungsverhalten und lehnte viele Anfragen ab.

OpenAI versammelte einige „Sänger“ für ChatGPT: Alle im Unternehmen setzten sich hin und versuchten, das Modell zu durchbrechen. Es gibt auch externe Gruppen, die das Gleiche tun. Auch vertrauenswürdige Erstanwender geben Feedback.

Sandhini Agarwal sagte, dass sie zwar festgestellt hätten, dass es einige unerwünschte Ausgaben erzeugt, aber das sind Dinge, die GPT-3.5 auch produziert. Wenn wir also nur die Risiken betrachten, reicht ChatGPT als „Forschungsvorschau“ aus.

John Schulman sagte auch, dass es unmöglich sei, mit der Veröffentlichung zu warten, bis ein System zu 100 % perfekt sei. Sie testen seit mehreren Monaten frühe Versionen und die Betatester waren von ChatGPT sehr beeindruckt.

Was OpenAI am meisten beunruhigt, sind eigentlich Sachfragen, denn ChatGPT erfindet die Dinge gerne zu sehr. Diese Probleme bestehen jedoch in InstructGPT und anderen großen Sprachmodellen. In den Augen der Forscher reicht es also aus, wenn ChatGPT in Bezug auf Faktizität und andere Sicherheitsaspekte besser ist als diese Modelle.

Und basierend auf einer begrenzten Evaluierung vor der Veröffentlichung kann bestätigt werden, dass ChatGPT realistischer und sicherer ist als andere Modelle, daher hat OpenAI beschlossen, die Veröffentlichung fortzusetzen.

Feedback nach dem Start

Nach der Veröffentlichung von ChatGPT hat OpenAI beobachtet, wie Benutzer es verwenden.

Ein großes Sprachmodell wird in die Hände von zig Millionen Benutzern gelegt. Dies ist das erste Mal in der Geschichte.

Benutzer werden auch verrückt und wollen die Grenzen von ChatGPT testen und wo die Fehler liegen.

Die Popularität von ChaatGPT hat auch dazu geführt, dass viele Probleme aufgetreten sind, wie z. B. Voreingenommenheitsprobleme und Probleme, die durch Eingabeaufforderungen verursacht werden.

Jan Leike sagte, dass einige der Dinge, die auf Twitter viral gingen, tatsächlich stillschweigend von OpenAI erledigt wurden.

Zum Beispiel ist das Jailbreaking-Problem definitiv etwas, das sie lösen müssen. Benutzer versuchen einfach, das Modell durch einige Wendungen dazu zu bringen, schlechte Dinge zu sagen. Dies liegt im Rahmen der Erwartungen von OpenAI und ist auch der einzige Weg.

Wenn Jailbreaks entdeckt werden, fügt OpenAI diese Bedingungen zu den Trainings- und Testdaten hinzu und alle Daten werden in zukünftige Modelle integriert.

Jan Leike sagte, dass sie jedes Mal, wenn es ein besseres Modell gibt, es herausnehmen und testen wollen.

Sie sind sehr optimistisch, dass ein gezieltes gegnerisches Training die Jailbreak-Situation erheblich verbessern kann. Obwohl unklar ist, ob diese Probleme vollständig verschwinden werden, glauben sie, dass sie viele Jailbreaks erschweren können.

Wenn ein System „offiziell debütiert“, ist es schwierig, alles vorherzusagen, was tatsächlich passieren wird.

Sie können sich also nur darauf konzentrieren, zu überwachen, wofür die Leute das System nutzen, zu sehen, was passiert, und dann darauf zu reagieren.

Jetzt hat Microsoft Bing Chat gestartet, von dem viele glauben, dass es sich um eine Version von OpenAIs offiziell unangekündigtem GPT-4 handelt.

Unter dieser Prämisse sagte Sandhini Agarwal, dass das, was ihnen jetzt bevorsteht, definitiv viel höher ist als vor sechs Monaten, aber immer noch niedriger als das Niveau ein Jahr später.

Der Kontext, in dem diese Modelle verwendet werden, ist äußerst wichtig.

Für große Unternehmen wie Google und Microsoft wird es zu einem riesigen Problem, auch wenn eines nicht stimmt, weil sie selbst Suchmaschinen sind.

Paul Buchheit, der 23. Mitarbeiter von Google, der Gmail erstellt hat, hat eine pessimistische Sicht auf Google

#🎜🎜 #As Es handelt sich um ein großes Sprachmodell für Suchmaschinen, das sich völlig von einem Chatbot nur zum Spaß unterscheidet. OpenAI-Forscher arbeiten auch hart daran herauszufinden, wie man zwischen verschiedenen Verwendungszwecken wechseln und etwas schaffen kann, das für Benutzer wirklich nützlich ist.

John Schulman gab zu, dass OpenAI unterschätzt hat, wie sehr sich die Menschen in ChatGPT für politische Themen interessieren. Zu diesem Zweck hoffen sie, bei der Erhebung von Trainingsdaten bessere Entscheidungen treffen zu können, um Probleme in diesem Bereich zu reduzieren.

Jan Leike sagte, dass ChatGPT aus seiner eigenen Sicht oft scheitert. Es gibt so viele Probleme, die gelöst werden müssen, aber OpenAI löst sie nicht. Das gab er offen zu.

Obwohl es Sprachmodelle schon seit einiger Zeit gibt, stecken sie noch in den Kinderschuhen.

Als nächstes gibt es noch weitere Dinge, die OpenAI tun muss.

Das obige ist der detaillierte Inhalt vonEs ist wirklich nicht Versailles! ChatGPT ist so erfolgreich, dass selbst OpenAI es nicht versteht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1374

1374

52

52

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Bei der Konvertierung von Zeichenfolgen in Objekte in Vue.js wird JSON.Parse () für Standard -JSON -Zeichenfolgen bevorzugt. Bei nicht standardmäßigen JSON-Zeichenfolgen kann die Zeichenfolge durch Verwendung regelmäßiger Ausdrücke verarbeitet und Methoden gemäß dem Format oder dekodierten URL-kodiert reduziert werden. Wählen Sie die entsprechende Methode gemäß dem String -Format aus und achten Sie auf Sicherheits- und Codierungsprobleme, um Fehler zu vermeiden.

Vue- und Element-UI-Kaskaden-Dropdown-Box V-Model-Bindung

Apr 07, 2025 pm 08:06 PM

Vue- und Element-UI-Kaskaden-Dropdown-Box V-Model-Bindung

Apr 07, 2025 pm 08:06 PM

Vue- und Element-UI-kaskadierte Dropdown-Boxen V-Model-Bindung gemeinsame Grubenpunkte: V-Model bindet ein Array, das die ausgewählten Werte auf jeder Ebene des kaskadierten Auswahlfelds darstellt, nicht auf einer Zeichenfolge; Der Anfangswert von ausgewählten Optionen muss ein leeres Array sein, nicht null oder undefiniert. Die dynamische Belastung von Daten erfordert die Verwendung asynchroner Programmierkenntnisse, um Datenaktualisierungen asynchron zu verarbeiten. Für riesige Datensätze sollten Leistungsoptimierungstechniken wie virtuelles Scrollen und fauler Laden in Betracht gezogen werden.

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

Zusammenfassung: Es gibt die folgenden Methoden zum Umwandeln von VUE.JS -String -Arrays in Objektarrays: Grundlegende Methode: Verwenden Sie die Kartenfunktion, um regelmäßige formatierte Daten zu entsprechen. Erweitertes Gameplay: Die Verwendung regulärer Ausdrücke kann komplexe Formate ausführen, müssen jedoch sorgfältig geschrieben und berücksichtigt werden. Leistungsoptimierung: In Betracht ziehen die große Datenmenge, asynchrone Operationen oder effiziente Datenverarbeitungsbibliotheken können verwendet werden. Best Practice: Clear Code -Stil, verwenden Sie sinnvolle variable Namen und Kommentare, um den Code präzise zu halten.

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

Um die Zeitüberschreitung für Vue Axios festzulegen, können wir eine Axios -Instanz erstellen und die Zeitleitungsoption angeben: in globalen Einstellungen: vue.Prototyp. $ Axios = axios.create ({Timeout: 5000}); In einer einzigen Anfrage: this. $ axios.get ('/api/user', {timeout: 10000}).

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.