Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Umfassende Analyse großer Modellparameter und effiziente Feinabstimmung, Tsinghua-Forschung veröffentlicht im Nature-Unterjournal

Umfassende Analyse großer Modellparameter und effiziente Feinabstimmung, Tsinghua-Forschung veröffentlicht im Nature-Unterjournal

Umfassende Analyse großer Modellparameter und effiziente Feinabstimmung, Tsinghua-Forschung veröffentlicht im Nature-Unterjournal

In den letzten Jahren hat das Team von Sun Maosong vom Fachbereich Informatik der Tsinghua-Universität die Mechanismen und Eigenschaften effizienter Feinabstimmungsmethoden für große Sprachmodellparameter eingehend untersucht und mit anderen relevanten Teams der Schule zusammengearbeitet, um das zu vervollständigen Das Forschungsergebnis „Efficient Fine-Tuning of Parameters for Large-Scale Pre-Trained Language Models“ (Parameter -efficient Fine-Tuning of Large-Scale Pre-Trained Language Models) wurde am 2. März in „Nature Machine Intelligence“ veröffentlicht. Die Forschungsergebnisse wurden gemeinsam von Lehrkräften und Studierenden der Fakultät für Informatik wie Sun Maosong, Li Juanzi, Tang Jie, Liu Yang, Chen Jianfei, Liu Zhiyuan und der Shenzhen International Graduate School Zheng Haitao vervollständigt. und Sun Maosong sind die entsprechenden Autoren des Artikels und haben einen Doktortitel im Fachbereich Informatik der Tsinghua-Universität. Sheng Dingning (Mentor Zheng Haitao) und Qin Yujia (Mentor Liu Zhiyuan) sind die Co-Erstautoren dieses Artikels.

Hintergrund und Überblick

Seit 2018 sind das Pre-Trained Language Model (PLM) und seine „Pre-Training-Fine-Tuning“-Methode zum Mainstream-Paradigma für Natural Language Processing (NLP)-Aufgaben geworden, bei denen zunächst großformatige Sprachverarbeitungsaufgaben zum Einsatz kommen. Skalieren Sie unbeschriftete Daten. Trainieren Sie ein großes Sprachmodell vorab durch selbstüberwachtes Lernen, um ein Basismodell zu erhalten, und verwenden Sie dann die beschrifteten Daten nachgelagerter Aufgaben, um überwachtes Lernen durchzuführen, um die Modellparameter zu optimieren und eine Anpassung an nachgelagerte Aufgaben zu erreichen.

Mit der Entwicklung der Technologie ist PLM zweifellos zur Infrastruktur für verschiedene NLP-Aufgaben geworden, und bei der Entwicklung von PLM gibt es einen scheinbar unumkehrbaren Trend: Die Größe des Modells wird immer größer. Größere Modelle erzielen nicht nur bessere Ergebnisse bei bekannten Aufgaben, sondern zeigen auch das Potenzial, komplexere unbekannte Aufgaben zu erledigen.

Größere Modelle stehen jedoch auch vor größeren Herausforderungen bei der Anwendung. Die traditionelle Methode der vollständigen Parameter-Feinabstimmung von vorab trainierten Modellen im extrem großen Maßstab wird eine große Menge an GPU-Rechenressourcen und Speicherressourcen verbrauchen enorme Kosten. Es ist entmutigend. Diese Kosten haben auch zu einer Art „Trägheit“ in der akademischen Welt geführt, was bedeutet, dass Forscher ihre Methoden nur an kleinen und mittelgroßen Modellen überprüfen und große Modelle gewöhnlich ignorieren.

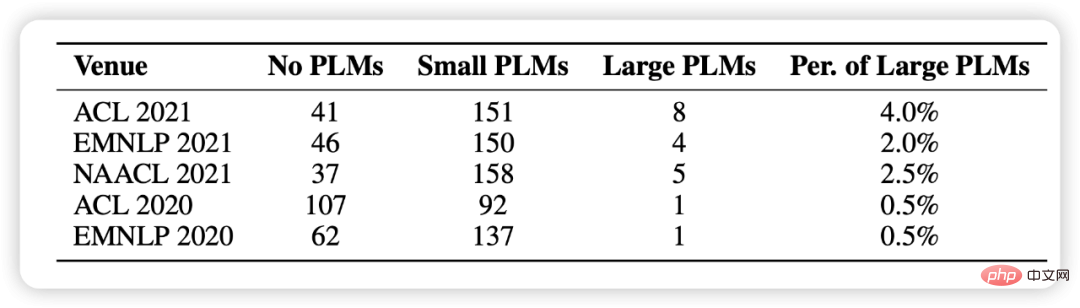

In den Statistiken dieses Artikels haben wir zufällig 1.000 Artikel aus den letzten fünf NLP-Konferenzen ausgewählt und festgestellt, dass die Verwendung vorab trainierter Modelle zu einem grundlegenden Forschungsparadigma geworden ist, es jedoch nur sehr wenige gibt, die große Modelle einbeziehen (Abbildung 1 gezeigt). .

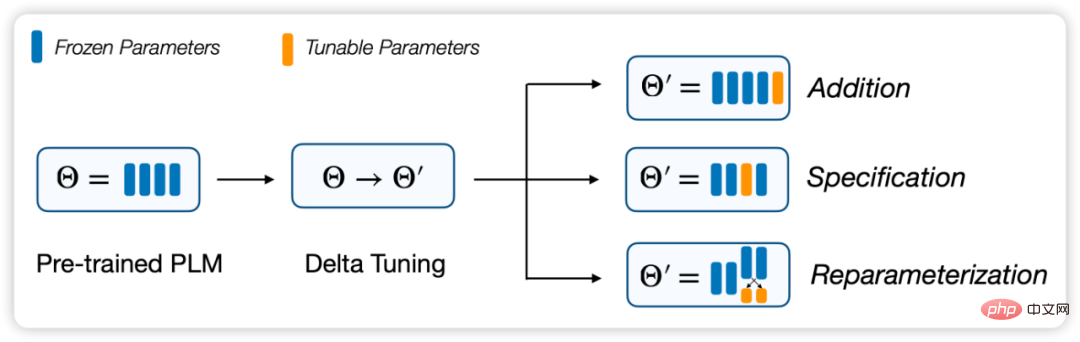

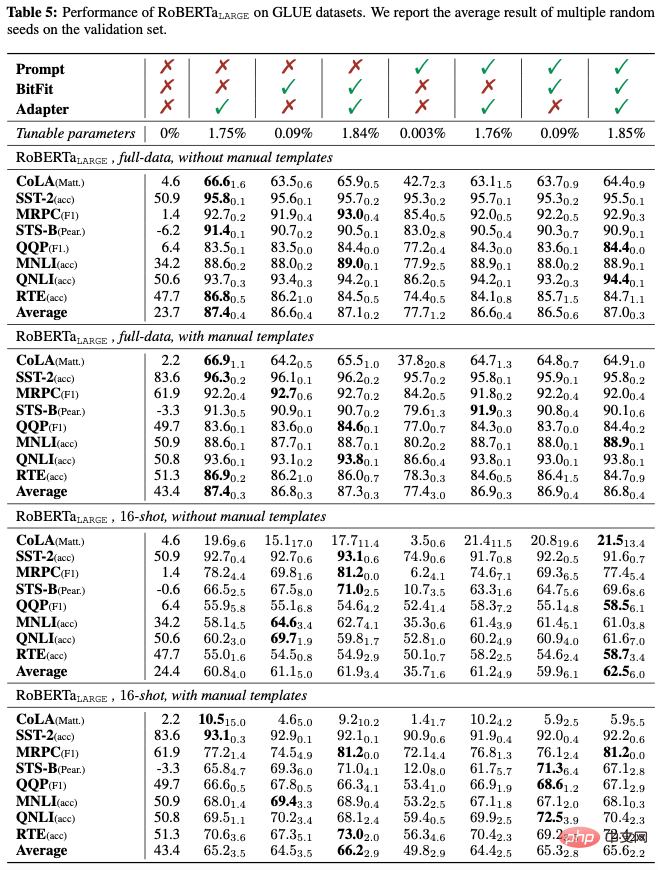

Figure 1: Statistische Verteilung vorgebliebener Modelle, die in 1000 zufällig ausgewählten Papieren verwendet werden. Im Vergleich zur Standard-Feinabstimmung mit vollständigen Parametern optimieren diese Methoden nur einen kleinen Teil der Modellparameter, während der Rest unverändert bleibt, wodurch die Rechen- und Speicherkosten erheblich gesenkt werden. Gleichzeitig ist die Leistung vergleichbar mit vollständige Parameter-Feinabstimmung. Wir glauben, dass diese Methoden im Wesentlichen eine „Inkrementierung“ (Delta Paremters) vornehmen, daher haben wir sie „Delta Tuning“ genannt.

In diesem Artikel definieren und beschreiben wir das Delta-Tuning-Problem und überprüfen frühere Forschungsergebnisse anhand eines einheitlichen Rahmens. In diesem Rahmen können bestehende Delta-Tuning-Methoden in drei Gruppen unterteilt werden: inkrementelle (additionsbasierte), spezifikationsbasierte (spezifikationsbasierte) und Reparametrisierungsmethoden (Reparametrisierung). Neben der praktischen Bedeutung glauben wir, dass Delta Tuning in gewissem Maße auch die Mechanismen hinter großen Modellen aufdeckt und uns dabei hilft, Methoden für große Modelle und sogar die Theorie tiefer neuronaler Netze weiterzuentwickeln. Zu diesem Zweck schlagen wir einen theoretischen Rahmen vor, um Delta Tuning aus den beiden Perspektiven Optimierung und optimale Steuerung zu diskutieren und als Leitfaden für das nachfolgende Struktur- und Algorithmusdesign zu dienen. Darüber hinaus führen wir einen umfassenden experimentellen Vergleich repräsentativer Methoden durch und demonstrieren einen umfassenden Leistungsvergleich verschiedener Methoden anhand von Ergebnissen zu mehr als 100 NLP-Aufgaben. Die experimentellen Ergebnisse umfassen die Untersuchung und Analyse der Leistung, Konvergenzleistung, Effizienzleistung, Skalierungsleistung, Generalisierungsleistung und Migrationsleistung von Delta Tuning. Wir haben außerdem OpenDelta entwickelt, ein Open-Source-Toolkit, das es Praktikern ermöglicht, Delta Tuning auf PLM effizient und flexibel zu implementieren.

- Papierlink: https://www.nature.com/articles/s42256-023-00626-4

- OpenDelta-Toolkit: https://github.com/thunlp/OpenDelta

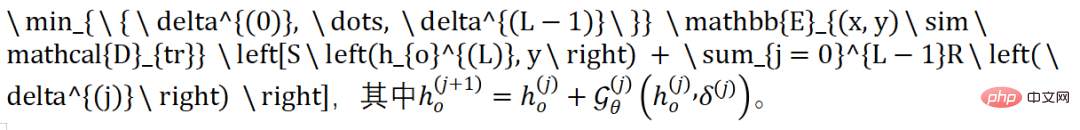

, wobei

der aktualisierte Wert aller Parameter in

relativ zu den Trainingsdaten ist. Im Delta-Tuning bezieht sich

auf die Änderung einer kleinen Anzahl von Parametern. Empirisch gesehen hat die Feinabstimmung aller Parameter

, während Delta Tuning

hat. Daher können wir das Parameter-effiziente Delta-Tuning basierend auf der angepassten Parameterform und -struktur in drei Strategien unterteilen und die vorherigen Methoden aussortieren:

Additionsbasierte Methode

Diese Klassenmethoden führen zusätzliche trainierbare neuronale Module ein oder Parameter, die im ursprünglichen Modell nicht vorhanden sind. Bei dieser Art von Methode haben wir, basierend auf der obigen Definition,

. Zu den gängigen inkrementellen Methoden gehören Adapter-Tuning, Präfix-Tuning, Prompt-Tuning usw. Sie fügen ausnahmslos kleine neuronale Module oder einstellbare Parameter in das Modell ein und erreichen eine effiziente Modellanpassung, indem sie nur diesen kleinen Teil der Parameter feinabstimmen. Unter diesen ist das Adapter-Tuning die Pionierarbeit dieser Art von Methode. Es beweist, dass das Hinzufügen eines einfachen neuronalen Netzwerks zu jeder Schicht bei vielen Aufgaben mit einer vollständigen Parameter-Feinabstimmung vergleichbar sein kann. Gleichzeitig zeigt Adapter sein Potenzial auch in Multitasking- und Mehrsprachenszenarien. Präfix-Tuning und Prompt Tuning sind in letzter Zeit sehr beliebte Delta-Tuning-Algorithmen. Sie fügen einige anpassbare Vektoren zur Feinabstimmung in die Eingabeschicht oder Präsentationsschicht ein. Unter diesen kann Prompt Tuning als vereinfachte Version von Prefix Tuning betrachtet werden, das heißt, es wird nur Soft Prompt zur Eingabeebene hinzugefügt. Dieser Ansatz hat den großen Vorteil, dass die interne Struktur des Modells nicht geändert werden muss. Da die Anzahl der Modellparameter gleichzeitig auf 10 Milliarden ansteigt, wurde auch nachgewiesen, dass er dies erreichen kann Gleicher Effekt wie die vollständige Parameter-Feinabstimmung bei einigen Daten. Diese Art von Methode steht jedoch auch vor großen Optimierungsproblemen. Experimente haben gezeigt, dass ihre Optimierungseffizienz oft geringer ist als bei anderen Feinabstimmungsparadigmen, ihre Konvergenzzeit länger ist und sie bei kleinen und mittelgroßen Modellen schlecht abschneidet.

Abbildung 3: Formaler Ausdruck von Delta Tuning

Spezifikationsbasierte Methode

Dieser Methodentyp legt fest, dass bestimmte Parameter im Originalmodell trainierbar werden, während andere Parameter eingefroren werden. Bei dieser Art von Methode können wir den Trainingsparametersatz als und die zu diesem Zeitpunkt aktualisierten Parameter als darstellen. dann der inkrementelle Wert, andernfalls. Die angegebene Methode führt keine neuen Parameter in das Modell ein und versucht auch nicht, die Struktur des Modells zu ändern. Stattdessen werden einige zu optimierende Parameter direkt angegeben. Die Idee ist einfach, funktioniert aber überraschend gut. Einige Methoden optimieren beispielsweise nur ein Viertel der letzten Schicht von BERT und RoBERTa und können 90 % der Leistung einer vollständigen Parameter-Feinabstimmung erzielen. Eine Arbeit von BitFit zeigt, dass das Modell durch einfaches Optimieren der Bias-Terme innerhalb des Modells und Einfrieren anderer Parameter immer noch über 95 % der Feinabstimmungsleistung für vollständige Parameter über mehrere Benchmarks hinweg reproduzieren kann. Empirische Ergebnisse von BitFit zeigen auch, dass selbst wenn wir einen kleinen Zufallsparametersatz für die Delta-Abstimmung verwenden (was offensichtlich die Leistung beeinträchtigt), das Modell beim GLUE-Benchmark immer noch akzeptable Ergebnisse liefern kann. Eine weitere wertvolle Beobachtung ist, dass unterschiedliche Bias-Terme während der Modellanpassung unterschiedliche Funktionen haben können.

Neben der manuellen oder heuristischen Angabe der zu aktualisierenden Parameter können wir auch eine solche Angabe erlernen. Diff Pruning ist eine der repräsentativen Arbeiten, die die fein abgestimmten Modellparameter in die Summe vorab trainierter Parameter und einen Differenzvektor umparametrisiert. Das Hauptproblem besteht derzeit darin, den Differenzvektor so spärlich wie möglich zu gestalten. Diese Arbeit reguliert den Vektor durch differenzierbare Näherung, um das Ziel der Sparsität zu erreichen. Tatsächlich verbraucht Diff Pruning mehr GPU-Speicher als die vollständige Parameter-Feinabstimmung, da während der Lernphase neue Parameter eingeführt werden, die optimiert werden müssen, was bei Anwendungen auf großen PLMs eine Herausforderung darstellen kann. Die Maskierungsmethode (Masking) erlernt eine selektive Maske für das PLM und aktualisiert nur die kritischen Gewichtungen für eine bestimmte Aufgabe. Um einen solchen Maskensatz zu erlernen, wird eine binäre Matrix in Bezug auf die Modellgewichte eingeführt, wobei jeder Wert durch eine Schwellenwertfunktion generiert wird. Während der Backpropagation wird die Matrix durch den Rauschschätzer aktualisiert.

Reparametrisierungsbasierte Methode

Dieser Methodentyp reparametrisiert den bestehenden Optimierungsprozess in eine Parameter-gültige Form, indem er ihn transformiert. Bezeichnen Sie den Satz von Parametern, die neu parametrisiert werden sollen, als . Unter der Annahme, dass jeder durch neue Parameter dargestellt wird, werden die aktualisierten Parameter als bezeichnet, wobei . Einfach ausgedrückt basieren Reparametrisierungsmethoden häufig auf einer ähnlichen Annahme: dass der Anpassungsprozess des vorab trainierten Modells von Natur aus einen niedrigen Rang oder eine niedrige Dimension aufweist. Dieser Prozess kann daher einem Parameter-effizienten Paradigma entsprechen.

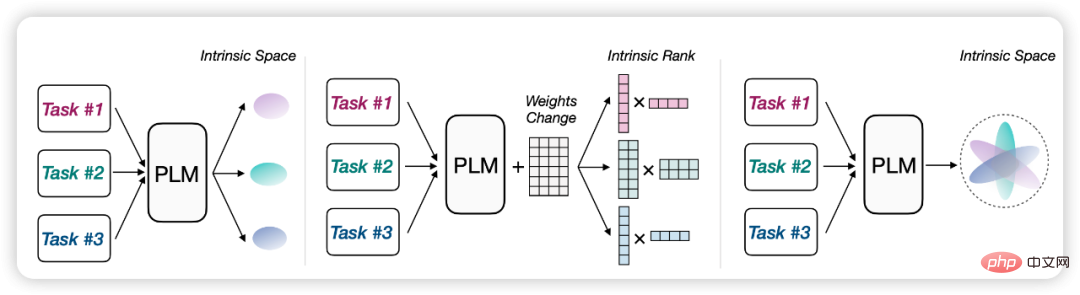

Zum Beispiel können wir davon ausgehen, dass die Modellanpassung eine „intrinsische Dimension“ hat. Indem wir den Feinabstimmungsprozess in einen Optimierungsprozess eines niedrigdimensionalen Unterraums umwandeln, können wir allein durch die Feinabstimmung beeindruckende Ergebnisse erzielen Die Parameter im Unterraum sind zufriedenstellend. In diesem Sinne kann PLM als allgemeines Komprimierungsframework dienen, um die Optimierungskomplexität von hohen auf niedrige Dimensionen zu komprimieren. Im Allgemeinen haben größere PLMs normalerweise kleinere intrinsische Abmessungen, und der Vortrainingsprozess reduziert implizit die intrinsischen Abmessungen des PLM. Inspiriert durch diese Beobachtungen wurde auch die reparametrisierte Delta-Tuning-Methode vorgeschlagen, die (einen Teil) der ursprünglichen Modellparameter mithilfe niedrigdimensionaler Ersatzparameter neu parametrisiert und nur die Ersatzparameter optimiert, wodurch die Rechen- und Speicherkosten gesenkt werden.

Eine weitere bekannte Arbeit, LoRA, geht davon aus, dass Gewichtsänderungen während der Modellanpassung einen niedrigen „intrinsischen Rang“ haben. Basierend auf dieser Annahme schlagen sie vor, die Low-Rank-Zerlegung für Änderungen in der ursprünglichen Gewichtsmatrix im Selbstaufmerksamkeitsmodul zu optimieren. Bei der Bereitstellung werden die optimierten Zerlegungsmatrizen mit niedrigem Rang multipliziert, um das Inkrement der Selbstaufmerksamkeitsgewichtsmatrix zu erhalten. Auf diese Weise kann LoRA die fein abgestimmte Leistung des GLUE-Benchmarks erreichen. Sie demonstrieren die Wirksamkeit ihres Ansatzes für PLMs unterschiedlicher Größe und Architektur, sogar GPT3.

Solche niedrigdimensionalen Annahmen eignen sich nicht nur für die Anpassung an Einzelaufgaben, sondern können auch auf Szenarien mit mehreren Aufgaben erweitert werden. IPT geht davon aus, dass für mehrere Aufgaben derselbe niedrigdimensionale Eigenunterraum existiert und dass allein durch Anpassen der Parameter des Unterraums bei mehr als 100 NLP-Aufgaben gleichzeitig zufriedenstellende Ergebnisse erzielt werden können. Anstatt zufällige Unterräume zu verwenden, versucht diese Methode, einen gemeinsamen Unterraum zu finden, der von mehreren NLP-Aufgaben gemeinsam genutzt wird. Experimente zeigen, dass in einem 250-dimensionalen niedrigdimensionalen Unterraum mehr als 80 % der Leistung von Prompt Tuning bei mehr als 100 NLP-Aufgaben reproduziert werden können, indem nur 250 Parameter angepasst werden.

Abbildung: Reparametrisierungsmethoden basieren oft auf ähnlichen niedrigdimensionalen oder niedrigrangigen Annahmen

Theoretische Perspektive des Delta-Tunings

Hat Delta-Tuning im Wesentlichen etwas gemeinsam? Wir glauben, dass die Delta-Tuning-Methode nicht nur einen hohen praktischen Wert hat, sondern auch eine weitreichende theoretische Bedeutung hat. Sie alle scheinen ausnahmslos eines zu beweisen: Das heißt, der Anpassungsprozess großer Modelle scheint ein sehr kostengünstiger Prozess zu sein (Im Vergleich zu (für das Vortraining) kann dies mit sehr wenigen Daten und sehr wenig Parameteroptimierung durchgeführt werden. Der Erfolg von Delta Tuning hat uns dazu inspiriert, den theoretischen Rahmen hinter der Modellanpassung weiter zu untersuchen. Dieser Artikel schlägt einen Rahmen aus zwei Perspektiven vor: Optimierung und optimale Steuerung, um Delta Tuning auf theoretischer Ebene zu erklären.

Optimierungswinkel

Delta-Tuning versucht, den Effekt einer vollständigen Parameter-Feinabstimmung auf das ursprüngliche große Sprachmodell zu erzielen, indem eine kleine Anzahl von Parametern feinabgestimmt und die Speichernutzung reduziert wird. Aus Optimierungssicht analysieren wir die Wirkung von Delta Tuning und diskutieren das Design einiger Delta Tuning-Methoden unter niedrigdimensionalen Annahmen. Nach der Verwendung von Delta Tuning können sich die Zielfunktion und die Parameter, von denen sie abhängt, ändern. Für die neue Zielfunktion werden nur die Parameter im Zusammenhang mit Delta Tuning optimiert. Wenn der Anfangswert gut genug ist, wird die Leistung des Modells unter bestimmten Annahmen nicht wesentlich beeinträchtigt. Um jedoch die Wirksamkeit von Delta Tuning sicherzustellen, ist es notwendig, die Struktur des Problems zu entwickeln, um diese neue Zielfunktion zu entwerfen. Der Ausgangspunkt besteht darin, die inhärenten niedrigdimensionalen Eigenschaften des Problems auszunutzen. Generell gibt es zwei Ideen, die sich in der Praxis als nützlich erwiesen haben:

- Lösungsvektoren in einem bestimmten niedrigdimensionalen Unterraum finden;

- Annäherung an das Ziel in einer bestimmten niedrigdimensionalen Funktionsraumfunktion.

Denn für die meisten Anwendungen im Deep Learning weist die Zielfunktion normalerweise viele lokale Mindestpunkte auf. Wenn der Anfangswert also in der Nähe eines lokalen Mindestpunkts liegt, sind nur einzelne Suchrichtungen wichtig, oder die Zielfunktion liegt darin Nachbarschaft kann durch einfachere Funktionen angenähert werden. Daher wird erwartet, dass beide Optimierungsideen gute Ergebnisse erzielen, und die Optimierung niedrigdimensionaler Parameter ist normalerweise effektiver und stabiler.

Eine niedrigdimensionale Darstellung des Lösungsraums. Untersuchungen haben gezeigt, dass die Parameteroptimierung vorab trainierter Sprachmodelle einer niedrigdimensionalen Mannigfaltigkeit folgt (Aghajanyan et al., 2021), sodass diese Mannigfaltigkeit in eine niedrigdimensionale Darstellung des Lösungsvektors eingebettet werden kann. Wenn diese niedrigdimensionale Darstellung genau ist, entspricht die Feinabstimmung der vollständigen Parameter am Originalmodell der Feinabstimmung dieses niedrigdimensionalen Parameters. Wenn in der niedrigdimensionalen Darstellung ein Fehler vorliegt und die Zielfunktion des vorab trainierten Modells und die neue Zielfunktion die Lipschitz-Kontinuität erfüllen, beträgt der endgültige Effektunterschied zwischen der Feinabstimmung der vollständigen Parameter und der Feinabstimmung der niedrigdimensionalen Parameter. Auch die Stimmung ist steuerbar.

Einige Delta-Tuning-Methoden profitieren von dieser Designidee. In LoRA (Hu et al., 2021a) verwendet die Gewichtsmatrix beispielsweise eine Low-Rank-Approximation; in BitFit (Zaken et al., 2021) und Diff Pruning (Guo et al., 2021) sind es nur einige ausgewählte Parameter Optimierung. Der Kern dieser Methoden besteht darin, Parameter in einem kleineren Teilraum des Lösungsvektors zu aktualisieren und letztendlich bessere Ergebnisse zu erzielen.

Niedrigdimensionale Darstellung des Funktionsraums. Ein anderer Ansatz besteht darin, direkt eine Näherungsfunktion der ursprünglichen Zielfunktion zu entwerfen und zu erwarten, dass der ungefähre Fehler dieser Funktion gering ist. Solche Funktionsnäherungen können inkrementelle Netzwerke (Houlsby et al., 2019) oder erweiterte Merkmalsräume (Lester et al., 2021) sein. Da es uns normalerweise mehr um die endgültige Auswirkung des Sprachmodells geht, ist es sinnvoll, die ungefähre Auswirkung auf die Zielfunktion selbst direkt zu berücksichtigen.

Es gibt in der Praxis viele verschiedene Möglichkeiten, solche Funktionsnäherungen zu konstruieren. Am einfachsten ist es, einige Parameter im Netzwerk festzulegen und nur den Rest zu optimieren. Bei dieser Methode wird davon ausgegangen, dass ein Teil des Netzwerks ungefähr die Leistung des gesamten Netzwerks widerspiegeln kann. Da die Rolle von Funktionen im Netzwerk durch den Datenfluss gekennzeichnet ist, können Darstellungen mit niedrigem Rang in den Datenpfad im ursprünglichen Netzwerk eingefügt werden, und das resultierende neue Modell ist ein inkrementelles Netzwerk, beispielsweise ein Adapter. Der Fehler der Funktion wird durch die Darstellungsleistung des Delta-Netzwerks bestimmt.

Wenn die autoregressive Struktur von Transformer entwickelt wird, können auch einige verfeinerte Funktionsnäherungen erhalten werden. Beispielsweise fügt die Prompt-Optimierung (Lester et al., 2021) eine Reihe von Prompt-Tokens als Präfixe zur Eingabe hinzu und optimiert lediglich die Parameter, von denen diese Prompt-Tokens abhängen. Diese Methode kann als Erweiterung des Funktionsraums betrachtet werden. Dank der Eigenschaften von Transformer kann eine solche Funktion die ursprüngliche Funktion besser annähern und das Sprachmodell anleiten, sich auf bestimmte Aufgaben zu konzentrieren. Zu den verwandten Methoden gehört die Präfixoptimierung (Li & Liang, 2021). Experimente haben gezeigt, dass die sofortige Optimierung bei größeren Modellen und größeren Datensätzen bessere Vorteile bietet. Dies ist auch sinnvoll, da diese Methoden im Wesentlichen niedrigdimensionale Funktionen verwenden, um hochdimensionale Funktionen anzunähern groß, es gibt natürlich mehr Freiheitsgrade, den Unterraum der Funktionsnäherung zu wählen.

Zwei niedrigdimensionale Darstellungen können normalerweise formal ähnliche Delta-Tuning-Methoden erhalten. (He et al., 2022) hat eine formal einheitliche Aussage zu Adapter, Präfix-Tuning und LoRA gemacht, die als Betrachtung verschiedener Delta-Tuning-Techniken aus der Perspektive der Funktionsnäherung angesehen werden kann. Unsere Diskussion zeigt, dass diese Delta-Tuning-Methoden auf niedrigdimensionalen Annahmen beruhen. Tatsächlich gibt es sogar gemeinsame niedrigdimensionale Unterräume für verschiedene Aufgaben (Qin et al., 2021b). Su et al. (2021) und unser experimenteller Teil zeigen auch die Übertragbarkeit von Delta Tuning auf verschiedene Aufgaben. Da der tatsächliche Effekt von Delta Tuning zwangsläufig aufgabenbezogen ist, ist es zum Erreichen des Effekts einer vollständigen Parameter-Feinabstimmung von Vorteil, die Struktur des Problems selbst besser zu untersuchen und zu nutzen oder einige Hybridalgorithmen zu entwerfen.

Optimaler Steuerwinkel

Basierend auf vergangenen Optimierungen Erläuterung der Theorie Durch Deep Learning aus der Steuerungsperspektive haben wir gezeigt, dass Delta Tuning als ein Prozess zur Suche nach dem optimalen Controller betrachtet werden kann. Bei einem autoregressiven Klassifizierungsmodell generiert das Modell im letzten Schritt Etikettenvorhersagen (beschriftet als Standort). Dieser Optimierungsprozess kann wie folgt ausgedrückt werden:

#🎜 🎜#

Die Funktion hier definiert die Vorwärtsausbreitung von Änderungen in PLM unter der Intervention von Delta. Insbesondere handelt es sich bei den lernbaren Aktivierungen um feste Parameter, sodass die Darstellung auf der Ebene korrekt in umgewandelt werden kann. Daher wird die Darstellungstransformation zwischen zwei aufeinanderfolgenden Schichten durch die Funktion und die Restverbindung in Transformer beschrieben. Ob es sich um die additionsbasierte Methode von Adapter und Präfix, die spezifizierte Methode von BitFit oder die stark parametrisierte Methode von LoRA handelt, wir können eine solche Funktion zur Darstellung von Delta Tuning ableiten (detaillierte Ableitung finden Sie im Artikel).

Wir betrachten die Softmax-Funktion und den Regularisierungsterm in Delta Tuning als Terminals, behandeln den Delta-Parameter als Betriebsverlust der Steuervariablen und formulieren das Delta-Tuning-Problem Da es sich um ein diskretes Zeitsteuerungsproblem handelt, entsprechen die Vorwärts- und Rückwärtsausbreitung im Delta-Tuning der Berechnung des komorphen Prozesses im Pontryagin-Maximumsprinzip. Zusammenfassend kann inkrementelles Tuning als der Prozess der Suche nach dem optimalen Controller für ein PLM für eine bestimmte nachgelagerte Aufgabe angesehen werden.

Unsere Analyse kann die Entwicklung neuartiger Delta-Tuning-Methoden inspirieren und wir zeigen auch, dass der Eingriff von Delta-Parametern in PLM dem Design des Controllers entspricht. Durch die Anwendung der Theorie des Controller-Designs erwarten wir, weitere Delta-Tuning-Methoden mit theoretischen Garantien dafür vorzuschlagen, dass die entworfene Delta-Struktur bei ausreichender PLM-Anregung prinzipiell interpretierbar ist.

Umfassende experimentelle Analyse von Delta TuningAls effiziente Methode zur Stimulierung und zum Aufruf von groß angelegtem PLM wird Delta Tuning in verschiedenen praktischen Anwendungen eingesetzt Anwendungsszenarien Hat großes Potenzial. In diesem Abschnitt führen wir systematische Experimente durch, um ein tieferes Verständnis der Eigenschaften verschiedener gängiger Delta-Tuning-Methoden zu erlangen.

1. Leistungs-, Konvergenz- und Effizienzanalyse

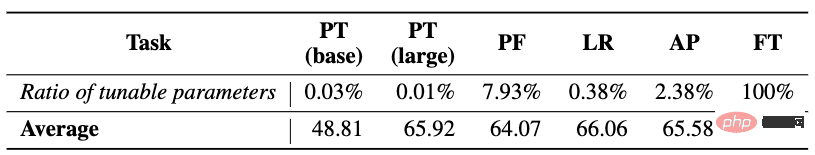

Wir wählen zunächst die vollständige Parameter-Feinabstimmung und vier repräsentative Delta-Tuning-Methoden aus (einschließlich Prompt Tuning (PT), Prefix-Tuning (PF), LoRA (LR) und Adapter (AP) ) Leistung, Konvergenz, und Effizienzanalysen werden ausführlich verglichen. Um vielfältigere Sprachmodellierungsfunktionen zu testen, haben wir mehr als 100 typische NLP-Aufgaben ausgewählt, darunter Textklassifizierung (z. B. Stimmungsklassifizierung, Inferenz natürlicher Sprache), Beantwortung von Fragen (z. B. extraktives Leseverständnis) und Sprachgenerierung (z. B. Textzusammenfassung). ) , Dialog) und andere Aufgaben sowie die Eingabe und Ausgabe aller Aufgaben werden im Sequenz-zu-Sequenz-Format modelliert, sodass es praktisch ist, dasselbe Modell (T5) zu verwenden, um alle Aufgaben einheitlich zu modellieren. Abgesehen davon, dass PT auf T5-Basis und T5-groß getestet wird, werden andere Methoden auf T5-Basis getestet.

Leistungsanalyse: Die experimentellen Ergebnisse sind in der obigen Tabelle aufgeführt. (1) Im Allgemeinen ist die Optimierung schwierig, da verschiedene Delta-Tuning-Methoden nur eine Feinabstimmung vornehmen Daher können sie in den meisten Fällen nicht mit FT in der Leistung mithalten, aber die Lücke zwischen den beiden ist nicht unüberwindbar, was das Potenzial für groß angelegte Anwendungen effizienter Parameteranpassung zeigt. (2) Obwohl die Designelemente der drei Methoden PF, LR und AP unterschiedlich sind, sind sie hinsichtlich der Leistung vergleichbar. Es ist möglich, dass einer von ihnen bei einigen Aufgaben eine bessere Leistung als die anderen (oder sogar FT) erbringt. Basierend auf den durchschnittlichen Ergebnissen lautet die Leistungseinstufung aller Methoden FT > LR > AP > PF > PT. Gleichzeitig haben wir auch festgestellt, dass die Leistung der Delta-Tuning-Methode nicht mit der Anzahl ihrer einstellbaren Parameter übereinstimmt, d. h. mehr einstellbare Parameter führen nicht unbedingt zu einer besseren Leistung. Im Gegensatz dazu ist das spezifische strukturelle Design von Delta-Tuning könnte eine wichtigere Rolle spielen. (3) PT ist unter diesen Methoden am einfachsten zu implementieren (das heißt, es verändert die interne Struktur des Modells nicht. In den meisten Fällen bleibt seine Leistung weit hinter anderen Delta-Tuning-Methoden zurück).

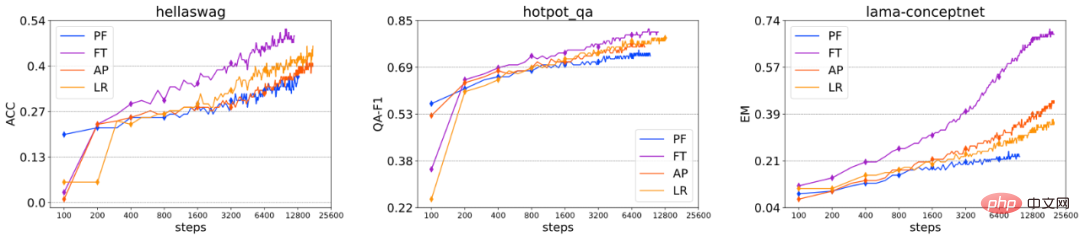

Konvergenzanalyse: Wir haben die Leistungsänderungen verschiedener Feinabstimmungsmethoden an einigen Datensätzen bei unterschiedlicher Anzahl von Trainingsschritten extrahiert, da PT im Vergleich zu anderen Methoden zu langsam konvergiert. Nicht enthalten das Bild oben. Wir können feststellen, dass die Reihenfolge der Konvergenzgeschwindigkeit dieser Feinabstimmungsmethoden im Allgemeinen ist: FT > AP ≈ LR > PF. Obwohl PF unter allen Delta-Tuning-Methoden die größte Anzahl einstellbarer Parameter aufweist, weist es dennoch einige Konvergenzschwierigkeiten auf, sodass die Konvergenzgeschwindigkeit nicht direkt mit der Anzahl der Parameter zusammenhängt, die fein abgestimmt werden können. In Experimenten haben wir außerdem herausgefunden, dass Leistung und Konvergenz bei jeder Delta-Tuning-Methode nicht von der Anzahl der einstellbaren Parameter, sondern stärker von der spezifischen Struktur abhängen. Insgesamt führen unsere Experimente zu sehr ähnlichen Schlussfolgerungen in Bezug auf Konvergenz und Gesamtleistung, und diese Schlussfolgerungen werden durch Ergebnisse einer großen Anzahl von Datensätzen gut gestützt.

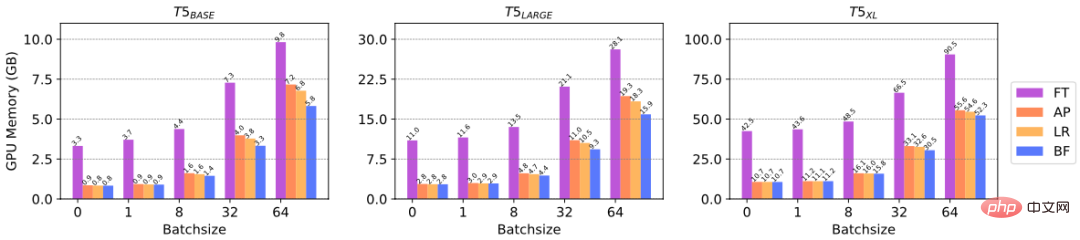

Effizienzanalyse: Delta Tuning kann die Gradientenberechnung von Parametern reduzieren und dadurch GPU-Speicher sparen, was die Effizienz der Rechenressourcen widerspiegelt. Um die Effizienzverbesserung von Delta Tuning beim GPU-Speicher konkret zu überprüfen, haben wir Experimente durchgeführt, um den GPU-Speicher zu vergleichen, der von verschiedenen Delta Tuning-Methoden zur Feinabstimmung bei PLMs unterschiedlicher Größe verbraucht wird. Konkret haben wir drei Maßstäbe von T5-Modellen ausgewählt, nämlich T5-Basis, T5-Groß und T5-XL, und den maximalen GPU-Speicher getestet, der bei verschiedenen Chargengrößen erreicht wurde. Für Experimente verwenden wir NVIDIA A100 (maximaler GPU-Speicher = 39,58 GB). Aus der obigen Abbildung können wir ersehen, dass Delta Tuning bis zu 3/4 des GPU-Speichers einsparen kann, wenn die Stapelgröße klein ist (z. B. 1, 8), und wenn die Stapelgröße groß ist, kann Delta Tuning sparen mindestens 1/3 des GPU-Speichers. Die oben genannten Ergebnisse spiegeln die Effizienz der Rechenressourcen von Delta Tuning wider.

2. Zusammensetzbarkeitsanalyse

Unter Berücksichtigung der Tatsache, dass verschiedene Delta-Tuning-Methoden miteinander kompatibel sind, was bedeutet, dass sie gleichzeitig auf demselben PLM angewendet werden können. Deshalb haben wir untersucht, ob eine Kombination von Delta Tuning zu einer Leistungsverbesserung führen würde. Insbesondere haben wir zwei Kombinationsmethoden untersucht: gleichzeitige Kombination und sequentielle Kombination, und drei repräsentative Delta-Tuning-Methoden ausgewählt, darunter Prompt Tuning, BitFit und Adapter.

Simultane Kombination: Wir untersuchen zunächst die Wirkung der gleichzeitigen Anwendung von drei Delta-Tuning-Methoden und führen Experimente an 8 GLUE-Unteraufgaben mit RoBERTa-large durch. Wir haben Experimente sowohl in Szenarien mit vollständigen Daten als auch in Szenarien mit geringen Ressourcen durchgeführt und die Auswirkungen künstlicher Eingabevorlagen auf die Leistung untersucht. Künstliche Vorlagen sollen die Lücke zwischen der Vorschulung und der nachgelagerten Aufgabenanpassung schließen.

Wie aus der obigen Tabelle ersichtlich ist, (1) Ob in Szenarien mit vollständigen Daten oder geringen Ressourcen, ob es eine manuelle Vorlage gibt oder nicht, die Einführung eines Adapters in der Kombination von Delta Tuning erfolgt fast immer unterstützt die durchschnittliche GLUE-Leistung; (2) Die Einführung von Prompt Tuning in der Kombination beeinträchtigt normalerweise die durchschnittliche Leistung, was darauf hindeutet, dass die Einführung von BitFit in der Kombination möglicherweise nicht mit den anderen beiden Delta-Tuning-Methoden kompatibel ist; Manuelle Vorlagen können die Zero-Shot-Leistung erheblich verbessern (von 23,7 auf 43,4), indem sie die Lücke zwischen nachgelagerter Aufgabenanpassung und Vortraining schließen. In Einstellungen mit wenigen Aufnahmen können künstliche Vorlagen auch die durchschnittliche Leistung deutlich verbessern. Wenn jedoch das Trainingsüberwachungssignal relativ reichlich vorhanden ist (im Volldatenszenario), zeigt die Einführung künstlicher Vorlagen nur eine schwache Leistungsverbesserung und kann sogar die Leistung beeinträchtigen.

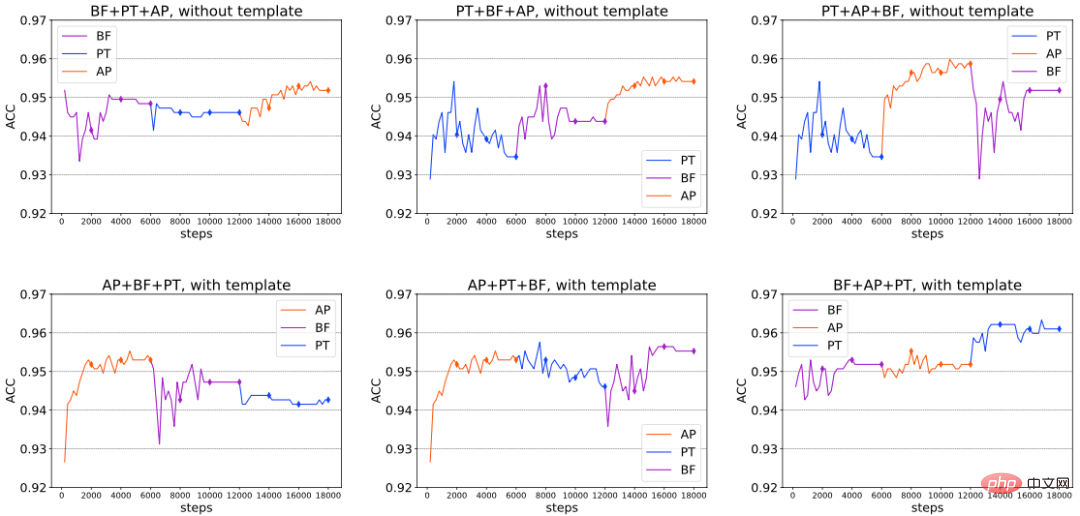

Sequentielle Kombination: Zusätzlich zur gleichzeitigen Kombination haben wir die Kompatibilität der oben genannten drei Delta-Tuning-Methoden weiter untersucht, wenn sie in einer bestimmten Reihenfolge eingeführt werden. Konkret unterteilen wir die gesamte Feinabstimmung in 3 Stufen. In jeder Stufe trainieren wir eine separate Delta-Tuning-Methode; in der folgenden Stufe fixieren wir die in der vorherigen Stufe trainierten Delta-Tuning-Parameter und optimieren nur die neu eingeführten Delta-Tuning-Parameter. Wir führen Experimente zu RoBERTa-large mit/ohne künstliche Vorlagen am SST-2-Stimmungsklassifizierungsdatensatz durch. Die Ergebnisse sind in der folgenden Abbildung (Auszug) dargestellt. Daraus können wir schließen, dass in einigen Fällen die Gesamtleistung durch die kontinuierliche Einführung neuer Delta-Tuning-Methoden kontinuierlich verbessert werden kann, wodurch gleichzeitig die Vorteile der sequentiellen Kombination überprüft werden. Wir haben auch festgestellt, dass es bei unterschiedlichen Einstellungen keine feste optimale Kombinationsreihenfolge gibt. Die optimale Kombination kann aufgrund unterschiedlicher nachgelagerter Aufgaben, verwendeter Modellarchitektur und anderer Faktoren variieren.

Analyse der Generalisierungslücke: Verschiedene Feinabstimmungsmethoden verfügen über unterschiedliche Speicherfähigkeiten (Memorisierung) und Generalisierungsfähigkeiten (Generalisierung) von Trainingsdaten. Zu diesem Zweck berichten wir über die Generalisierungslücke (Trainingssatzeffekt – Entwicklungssatzeffekt) von RoBERTa-large in der vollständigen Dateneinstellung. Die Ergebnisse sind in der folgenden Tabelle aufgeführt, aus der wir Folgendes ersehen können: (1) Eine einzelne Generalisierung Delta-Tuning-Methode Die Lücke ist immer kleiner als die Feinabstimmung, was bedeutet, dass eine Überparametrisierung dazu beitragen kann, sich die Trainingsmuster besser zu merken (überzupassen). Prompt Tuning weist tendenziell die kleinste Generalisierungslücke unter allen Delta-Tuning-Methoden auf. In Anbetracht der Tatsache, dass jede Delta-Tuning-Methode gut verallgemeinern und eine nicht triviale Leistung auf dem Entwicklungssatz zeigen kann, ist eine Überanpassung des Trainingssatzes möglicherweise keine notwendige Voraussetzung für eine gute Generalisierung. (2) Im Allgemeinen erhöht die Kombination mehrerer Delta-Tuning-Methoden die Generalisierung Lücke, die sogar ein Niveau erreicht, das mit der vollständigen Feinabstimmung vergleichbar ist. Dies zeigt, dass das Erinnern an den Trainingssatz (Auswendiglernen) möglicherweise keine allzu große Feinabstimmung erfordert. Mit anderen Worten: Wenn sich PLM an nachgelagerte Aufgaben anpasst, ist die Feinabstimmungskapazität des Modells immer noch gut genug, um es sich zu merken (3) Die Verwendung künstlicher Vorlagen hat im Allgemeinen keinen Einfluss auf die Generalisierungslücke.

3. Leistungsänderungen mit zunehmender Modellgröße

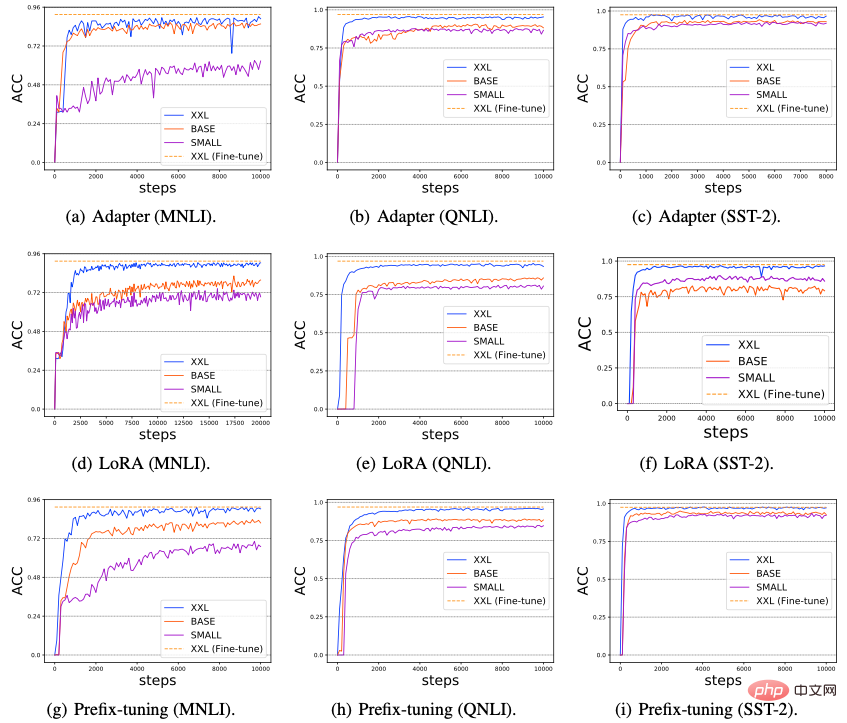

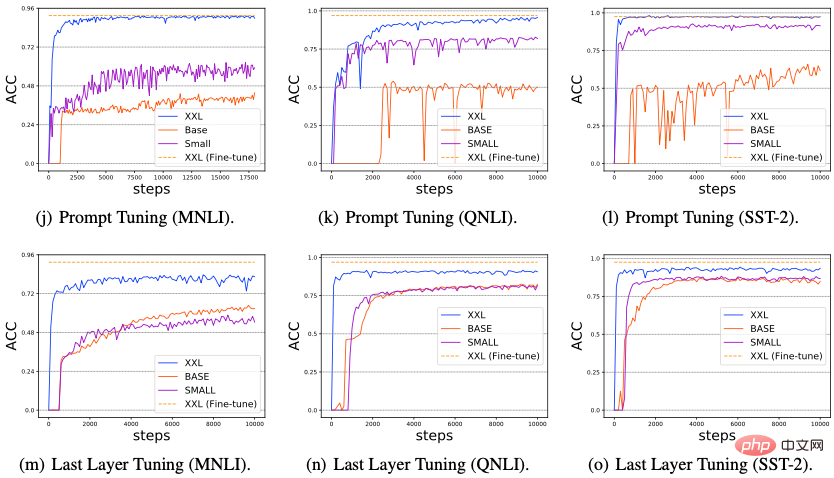

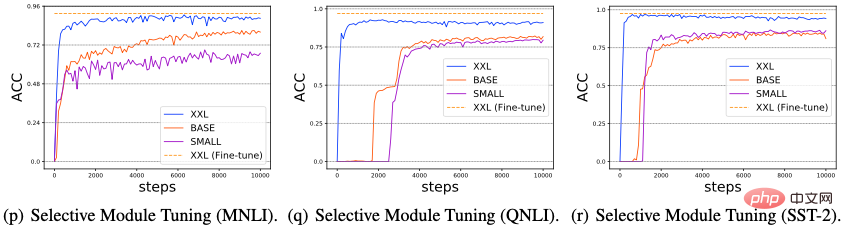

Wir haben die Auswirkungen einer Modellgrößenerhöhung auf die Leistung von Delta Tuning untersucht. Kürzlich haben einige Untersuchungen ergeben, dass die Leistung von Prompt Tuning mit zunehmender Größe des verwendeten PLM-Modells immer stärker wird und sogar ein Niveau erreichen kann, das mit der Feinabstimmung mit vollständigen Parametern vergleichbar ist. In diesem Abschnitt untersuchen wir, ob alle Delta-Tuning-Methoden die Leistungsfähigkeit der Skalierung aufweisen können. Insbesondere führten wir Experimente zu drei typischen NLP-Aufgaben durch: MNLI, QNLI und SST-2, wählten drei PLMs mit zunehmendem Maßstab aus (T5-small, T5-base, T5-xxl) und bewerteten die Leistung von sechs repräsentativen Delta-Tunings Methoden (Adapter, LoRA, Prefix-Tuning, Prompt Tuning, Last Layer Tuning und Selective Module Tuning) werden die Ergebnisse in der folgenden Abbildung dargestellt.

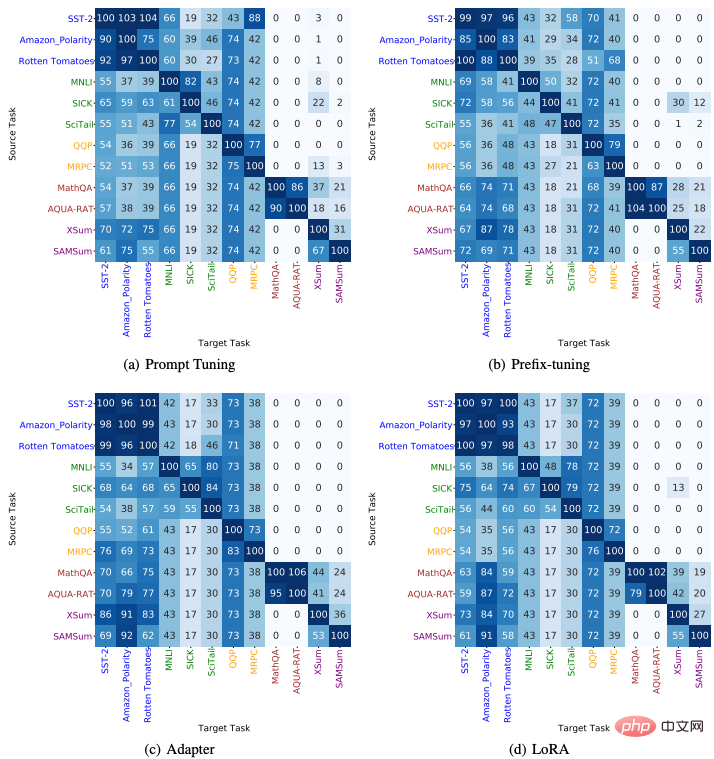

Aus der Abbildung (a-i) können wir beobachten, dass mit zunehmender PLM-Netzwerkskala die Leistung und Konvergenz aller Delta-Tuning-Methoden erheblich abnimmt Es wurde eine Verbesserung erzielt. (2) Darüber hinaus zeigt Abbildung (j-l), dass Prompt Tuning im Vergleich zu anderen Delta-Tuning-Methoden bei kleinen PLM-Modellen (T5-Small und T5-Base) häufig eine schlechte Leistung erbringt. Bei anderen Delta-Tuning-Methoden tritt dieses Problem jedoch nicht auf. (3) Basierend auf den vorhandenen Ergebnissen entwerfen wir in Abbildung 11 (m-o) und (p-r) außerdem zwei Delta-Tuning-Methoden: Last Layer Tuning und Selective Module Tuning. Beim Last Layer Tuning optimieren wir nur die letzte Ebene des T5-Encoders; beim Selective Module Tuning wählen wir zufällig einige Module im T5-Modell zur Feinabstimmung aus. Beide Methoden zeigen hervorragende Ergebnisse, insbesondere wenn der PLM-Umfang sehr groß ist, wobei das selektive Modul-Tuning etwas besser ist als das Last-Layer-Tuning. Diese Ergebnisse legen nahe, dass die Beschränkung feinabstimmbarer Parameter auf eine bestimmte Ebene möglicherweise keine gute Strategie ist. Wenn andererseits der Umfang von PLM sehr groß wird, kann eine Feinabstimmung durch zufällige Auswahl von Modulen über verschiedene Ebenen hinweg eine hervorragende Leistung erzielen. Insgesamt deuten die obigen Ergebnisse darauf hin, dass mit zunehmender Größe des PLM-Modells erhebliche Verbesserungen der Leistung/Konvergenzgeschwindigkeit verschiedener Feinabstimmungsmethoden ein häufiges Phänomen bei Delta Tuning sein können. Wir vermuten, dass dieses Phänomen existiert, weil größere PLMs normalerweise kleinere intrinsische Dimensionen haben (intrinsische Dimension). Daher können nur durch Anpassen einiger Parameter ausreichend starke Darstellungsmöglichkeiten für die Implementierung in nachgelagerten Aufgaben erzielt werden Es ist möglicherweise weniger wahrscheinlich, dass sie während der nachgelagerten Optimierung in lokale Optima fallen, wodurch die Konvergenz beschleunigt wird. 4. Übertragbarkeit zwischen Aufgaben 12 NLP-Aufgaben von 5 verschiedenen Typen (einschließlich Sentimentanalyse, Argumentation in natürlicher Sprache, Paraphrasenerkennung, Frage und Antwort, Zusammenfassung) und Übertragung der auf der Quellaufgabe trainierten Delta-Parameter auf die Zielaufgabe. Testen Sie den Zero-Shot-Migrationseffekt. Die Ergebnisse sind in der folgenden Abbildung dargestellt, aus der wir Folgendes entnehmen können: (1) Bei Aufgaben, die zur gleichen Kategorie gehören, ist die Übertragungsleistung zwischen ihnen normalerweise gut. (2) Bei Aufgaben unterschiedlichen Typs ist die Übertragungsleistung zwischen ihnen schlecht. 3) Darüber hinaus haben wir festgestellt, dass die aus Textgenerierungsaufgaben (wie Fragen und Antworten und Zusammenfassungen) trainierten Delta-Parameter auf Stimmungsanalyseaufgaben übertragen werden können und eine hervorragende Leistung erzielen, was darauf hindeutet, dass die Textgenerierungsaufgabe möglicherweise eine komplexere Aufgabe ist Zu den für die Aufgabe erforderlichen Sprachkenntnissen können Fähigkeiten zur Stimmungsanalyse gehören.

Delta Tuning App

Schnelles Training und Speicherplatzersparnis

. Transformer-Modelle sind zwar von Natur aus parallelisierbar, lassen sich aber aufgrund ihrer schieren Größe nur sehr langsam trainieren. Obwohl die Konvergenzrate von Delta Tuning möglicherweise langsamer ist als die herkömmliche Feinabstimmung vollständiger Parameter, wird die Trainingsgeschwindigkeit von Delta Tuning auch erheblich verbessert, da der Rechenaufwand feinabstimmbarer Parameter während der Backpropagation erheblich reduziert wird. Frühere Untersuchungen haben bestätigt, dass die Verwendung von Adaptern für die nachgelagerte Optimierung die Trainingszeit um 40 % verkürzen kann und gleichzeitig eine Leistung aufrechterhält, die mit der vollständigen Parameter-Feinabstimmung vergleichbar ist. Aufgrund ihrer geringen Größe können die trainierten Delta-Parameter auch Speicherplatz sparen, wodurch der Austausch zwischen Praktikern erleichtert und der Wissenstransfer gefördert wird.

Multitasking-Lernen. Der Aufbau allgemeiner künstlicher Intelligenzsysteme ist seit langem ein Ziel von Forschern. In jüngster Zeit haben sehr große PLMs (z. B. GPT-3) die erstaunliche Fähigkeit bewiesen, verschiedene Datenverteilungen gleichzeitig anzupassen und die nachgelagerte Leistung bei einer Vielzahl von Aufgaben zu erleichtern. Daher hat im Zeitalter der groß angelegten Vorschulung dem Multitasking-Lernen immer mehr Aufmerksamkeit geschenkt. Als effektive Alternative zu Feinabstimmungsmethoden mit vollständigen Parametern verfügt Delta Tuning über hervorragende Multitasking-Lernfähigkeiten bei relativ geringem zusätzlichem Speicher. Zu den erfolgreichen Anwendungen gehören mehrsprachiges Lernen, Leseverständnis und mehr. Darüber hinaus wird erwartet, dass Delta Tuning auch als potenzielle Lösung für katastrophales Vergessen beim kontinuierlichen Lernen dienen kann. Die im Vortraining erworbenen Sprachfähigkeiten werden in den Parametern des Modells gespeichert. Daher kann die Aktualisierung aller Parameter im PLM ohne Regularisierung zu schwerem und katastrophalem Vergessen führen, wenn das PLM sequentiell über eine Abfolge von Aufgaben hinweg trainiert wird. Da Delta Tuning nur minimale Parameter optimiert, könnte es eine mögliche Lösung sein, um das katastrophale Vergessensproblem zu mildern.

Zentralisierte Modellbereitstellung und paralleles Rechnen. Sehr großes PLM wird häufig als Dienst veröffentlicht, d. h. Benutzer nutzen das große Modell, indem sie mit vom Modellanbieter veröffentlichten APIs interagieren, anstatt das große Modell lokal zu speichern. Angesichts der unerträglichen Kommunikationskosten zwischen Benutzern und Dienstanbietern ist Delta Tuning aufgrund seines geringen Gewichts eindeutig eine wettbewerbsfähigere Option als die herkömmliche Feinabstimmung aller Parameter. Einerseits können Dienstanbieter die nachgelagerten Aufgaben unterstützen, die für die Schulung mehrerer Benutzer erforderlich sind, und dabei weniger Rechen- und Speicherplatz verbrauchen. Wenn man bedenkt, dass einige Delta-Tuning-Algorithmen von Natur aus parallelisierbar sind (z. B. Prompt Tuning und Prefix-Tuning usw.), kann Delta Tuning außerdem das parallele Training/Testen von Proben mehrerer Benutzer im selben Batch ermöglichen (In-Batch-Parallel-Computing). . Neuere Arbeiten haben auch gezeigt, dass die meisten Delta-Tuning-Methoden, wenn sie nicht von Natur aus parallelisierbar sind, in gewisser Weise geändert werden können, um parallele Berechnungen zu unterstützen. Wenn dem Benutzer andererseits die Gradienten des zentralen Modells nicht zur Verfügung stehen, ist Delta Tuning immer noch in der Lage, große PLMs durch einen Gradienten-freien Black-Box-Algorithmus und nur Aufrufe der Modellinferenz-API zu optimieren.

Das obige ist der detaillierte Inhalt vonUmfassende Analyse großer Modellparameter und effiziente Feinabstimmung, Tsinghua-Forschung veröffentlicht im Nature-Unterjournal. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins