Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die KI spielt verrückt, wenn es um Quizze geht! Die Genauigkeitsrate der Mathematikprüfung auf hohem Niveau beträgt 81 % und die Punktzahl bei den Wettbewerbsfragen übertrifft die des Informatikdoktors

Die KI spielt verrückt, wenn es um Quizze geht! Die Genauigkeitsrate der Mathematikprüfung auf hohem Niveau beträgt 81 % und die Punktzahl bei den Wettbewerbsfragen übertrifft die des Informatikdoktors

Die KI spielt verrückt, wenn es um Quizze geht! Die Genauigkeitsrate der Mathematikprüfung auf hohem Niveau beträgt 81 % und die Punktzahl bei den Wettbewerbsfragen übertrifft die des Informatikdoktors

Für viele Menschen ist es ein Albtraum, in der Matheprüfung der High School durchzufallen.

Wenn Sie sagen, dass Ihr High-School-Mathetest nicht so gut ist wie KI, ist es dann schwieriger, das zu akzeptieren?

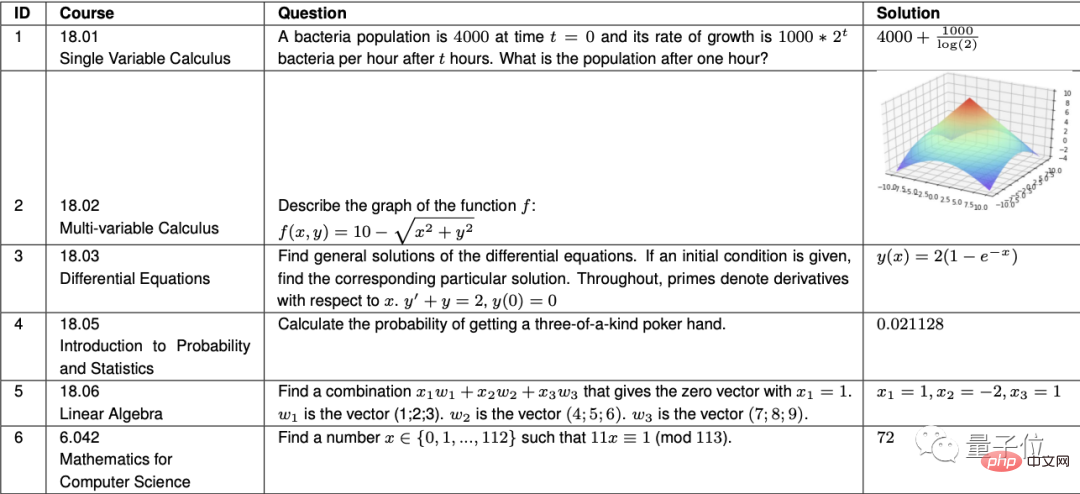

Richtig, der Codex von OpenAI hat in 7 fortgeschrittenen Mathematikkursen am MIT eine Genauigkeitsrate von 81,1 % erreicht, was auf dem Niveau von MIT-Studenten liegt.

Die Kurse reichen von Elementarrechnung über Differentialgleichungen, Wahrscheinlichkeitstheorie und lineare Algebra. Zu den Fragen gehört auch das Zeichnen.

Diese Angelegenheit wurde kürzlich bei Weibo-Hot-Suchanfragen angezeigt.

△ „Nur“ 81 Punkte erzielt, die Erwartungen an KI sind zu hoch

Jetzt kommt Google. Hier kommt das Neueste große Neuigkeiten:

Nicht nur in der Mathematik hat unsere KI sogar in den gesamten naturwissenschaftlichen und technischen Fächern die höchste Punktzahl erreicht!

Es scheint, dass Technologiegiganten ein neues Niveau bei der Kultivierung von „KI-Problemlösern“ erreicht haben.

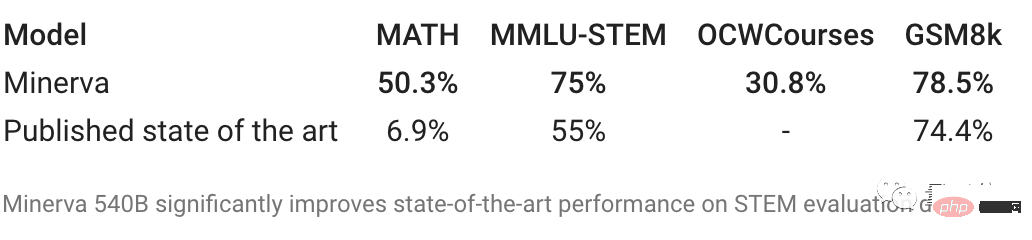

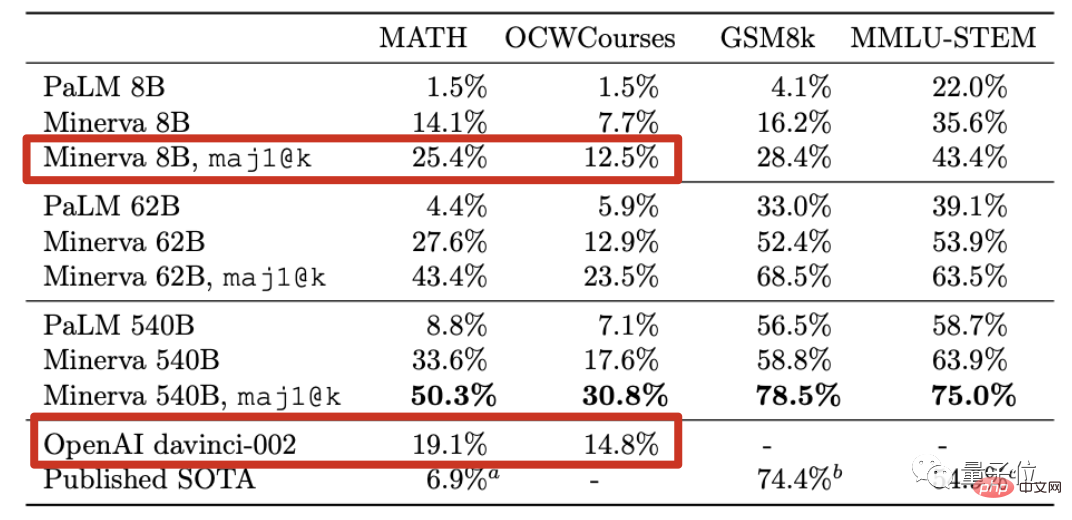

Google, der neueste KI-Fragensteller, hat vier Prüfungen abgelegt.

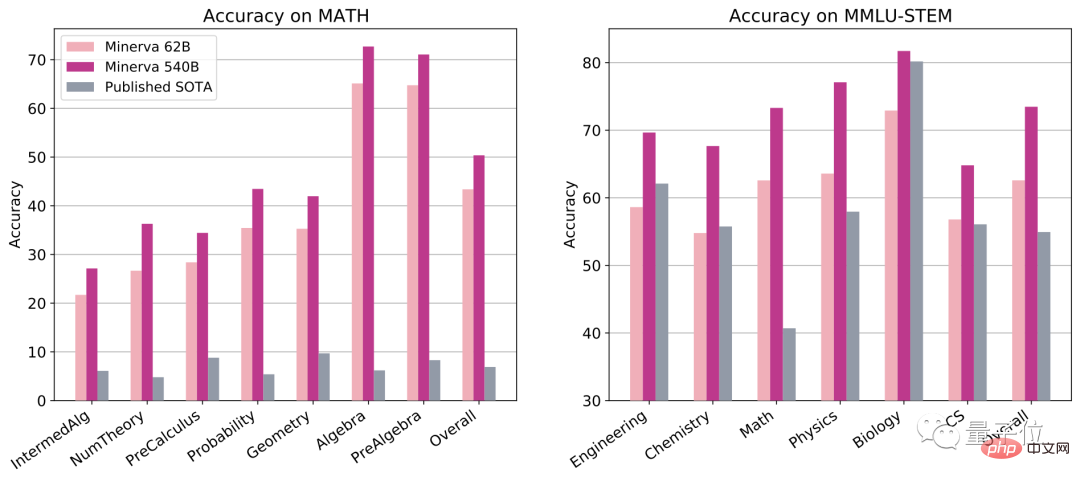

Bei der Mathematikwettbewerbsprüfung MATH haben in der Vergangenheit nur dreimalige IMO-Goldmedaillengewinner 90 Punkte erreicht, und normale Computerärzte können nur etwa 40 Punkte erreichen.

Was andere KI-Frage-Antworten betrifft, so lag die bisher beste Punktzahl bei nur 6,9 Punkten...

Aber dieses Mal hat Googles neue KI 50 Punkte erreicht, was besser ist als der Computer-Doktortitel. Immer noch hoch.

Die umfassende Prüfung MMLU-STEM umfasst Mathematik, Physik, Chemie, Biologie, Elektrotechnik und Informatik. Der Schwierigkeitsgrad der Fragen erreicht das High-School- oder sogar College-Niveau.

Dieses Mal erhielt auch die „Vollgesundheitsversion“ von Google AI die höchste Punktzahl unter allen Fragen und erhöhte die Punktzahl direkt um etwa 20 Punkte.

Grundschul-Mathematikfrage GSM8k erhöhte die Punktzahl direkt auf 78 Punkte. Im Vergleich dazu hat GPT-3 nicht bestanden (nur 55 Punkte).

Selbst für Bachelor- und Masterstudiengänge am MIT wie Festkörperchemie, Astronomie, Differentialgleichungen und Spezielle Relativitätstheorie kann Googles neue KI fast ein Drittel der mehr als 200 Fragen beantworten.

Das Wichtigste ist, dass Google AI dieses Mal im Gegensatz zu OpenAIs Methode, hohe Punktzahlen in Mathematik zu erzielen, indem man sich auf „Programmierfähigkeiten“ verlässt, wie folgt vorgegangen ist „like Der Ansatz „Denken wie Menschen“ -

ist wie ein Student der Geisteswissenschaften, der nur auswendig lernt, aber keine Fragen stellt, aber bessere Fähigkeiten zur Problemlösung in Naturwissenschaften und Technik beherrscht.

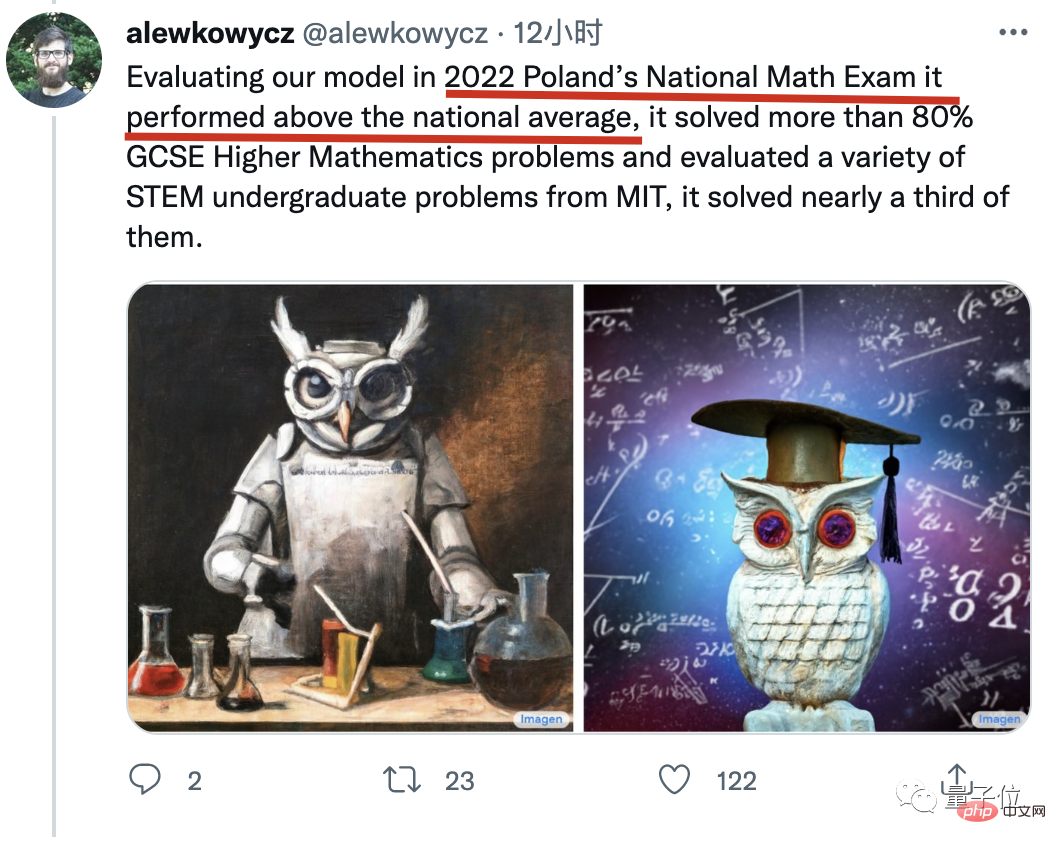

Es ist erwähnenswert, dass Lewkowycz, der Erstautor des Artikels, auch ein Highlight teilte, das nicht im Artikel stand:

Unser Modell nahm an der diesjährigen Aufnahmeprüfung für das polnische Mathematik-College teil und die Ergebnisse lagen über dem Landesdurchschnitt.

Angesichts dieser Tatsache können einige Eltern nicht mehr still sitzen.

Wenn ich meiner Tochter das erzähle, fürchte ich, dass sie KI für ihre Hausaufgaben verwenden wird. Aber wenn du es ihr nicht sagst, bereitest du sie nicht auf die Zukunft vor!

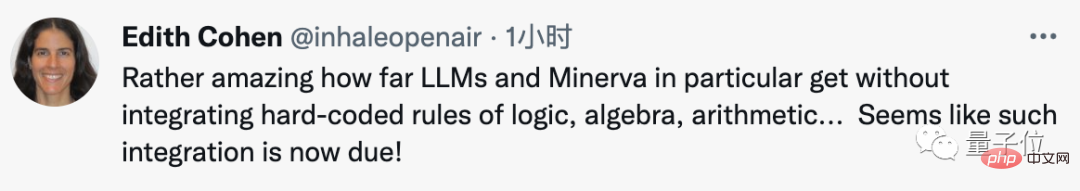

In den Augen von Brancheninsidern ist es das Erstaunlichste an dieser Forschung, dieses Niveau zu erreichen, indem man sich nur auf Sprachmodelle ohne fest codierte Arithmetik, Logik und Algebra verlässt.

Also, wie geht das?

KI liest wahnsinnig 2 Millionen Artikel auf arXiv

Das neue Modell Minerva basiert auf dem allgemeinen Sprachmodell PaLM unter der Pathway-Architektur.

Die Weiterbildung erfolgt auf Basis von 8 Milliarden, 60 Milliarden bzw. 540 Milliarden Parameter-PaLM-Modellen.

Minervas Herangehensweise an die Beantwortung von Fragen unterscheidet sich völlig von der von Codex. Die Methode von

Codex besteht darin, jedes mathematische Problem in ein Programmierproblem umzuschreiben und es dann durch Schreiben von Code zu lösen.

Minerva hingegen las wie verrückt Papiere und zwang sich, mathematische Symbole genauso zu verstehen wie natürliche Sprache.

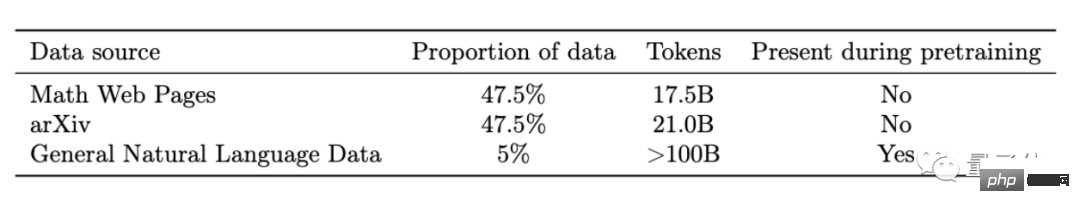

Weiteres Training auf Basis von PaLM. Der neue Datensatz besteht aus drei Teilen:

Enthält hauptsächlich 2 Millionen auf arXiv gesammelte wissenschaftliche Arbeiten, 60 GB Webseiten mit LaTeX-Formeln und einen kleinen Teil, der in der PaLM-Trainingsphase verwendet wird.

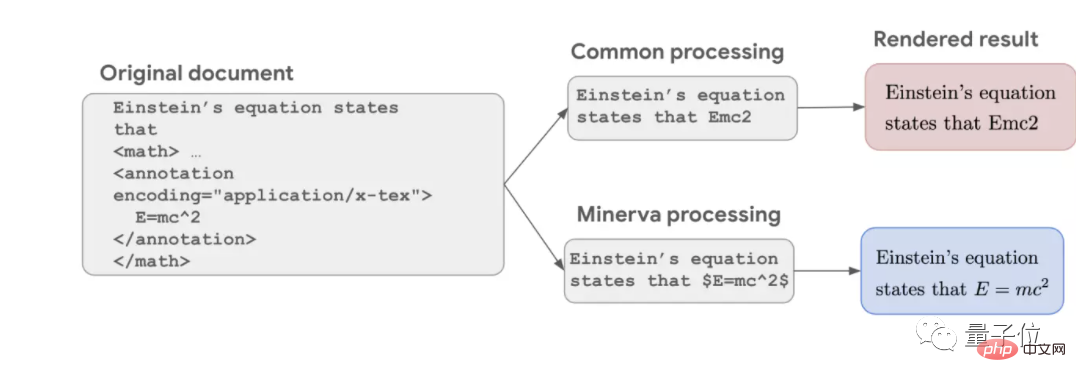

Der übliche NLP-Datenbereinigungsprozess löscht alle Symbole und behält nur reinen Text, was zu unvollständigen Formeln führt. Beispielsweise ist in Einsteins berühmter Masse-Energie-Gleichung nur noch Emc2 übrig.

Aber dieses Mal behielt Google alle Formeln bei und durchlief das Transformer-Trainingsprogramm wie einfachen Text, sodass die KI Symbole wie Sprache verstehen konnte.

Dies ist einer der Gründe, warum Minerva bei mathematischen Problemen im Vergleich zu früheren Sprachmodellen besser abschneidet.

Aber im Vergleich zu KI, die sich auf die Lösung mathematischer Probleme spezialisiert hat, verfügt Minerva nicht über eine explizite zugrunde liegende mathematische Struktur in ihrem Training, was einen Nachteil und einen Vorteil mit sich bringt.

Der Nachteil besteht darin, dass die KI möglicherweise falsche Schritte verwendet, um die richtige Antwort zu erhalten.

Der Vorteil besteht darin, dass es an verschiedene Disziplinen angepasst werden kann. Auch wenn einige Probleme nicht in formaler mathematischer Sprache ausgedrückt werden können, können sie durch die Kombination natürlicher Sprachverständnisfähigkeiten gelöst werden.

In der KI-Begründungsphase kombiniert Minerva auch mehrere neue Technologien, die kürzlich von Google entwickelt wurden.

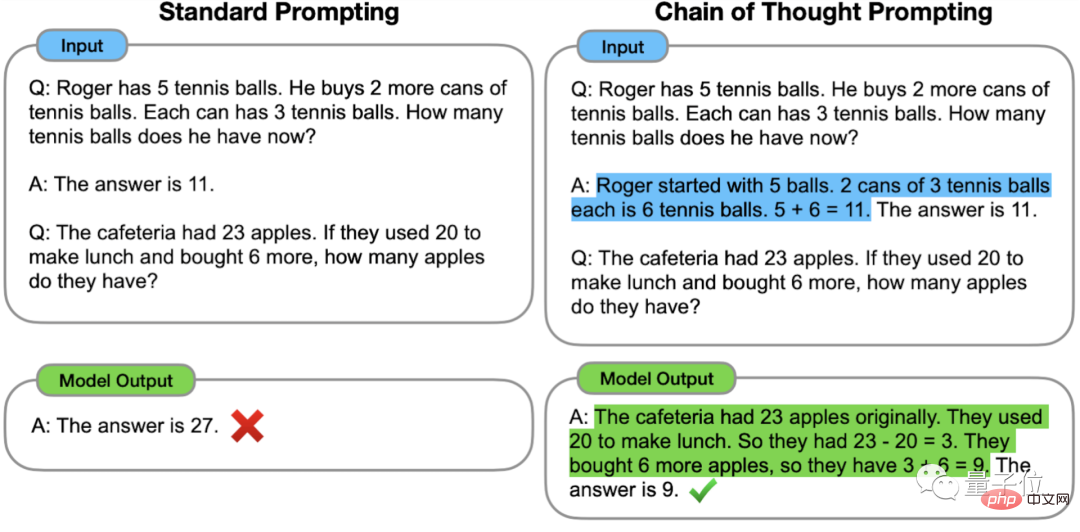

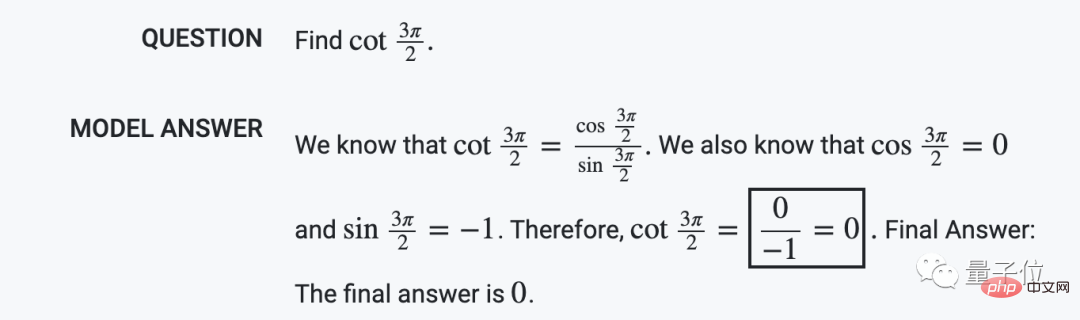

Zunächst gibt es die Link-Eingabeaufforderung „Chain of Thought Thinking“, die im Januar dieses Jahres vom Google Brain-Team vorgeschlagen wurde.

Besonders wenn Sie eine Frage stellen, geben Sie ein Schritt-für-Schritt-Antwortbeispiel als Orientierung. KI kann bei der Beantwortung von Fragen einen ähnlichen Denkprozess nutzen und Fragen richtig beantworten, die sonst falsch beantwortet würden.

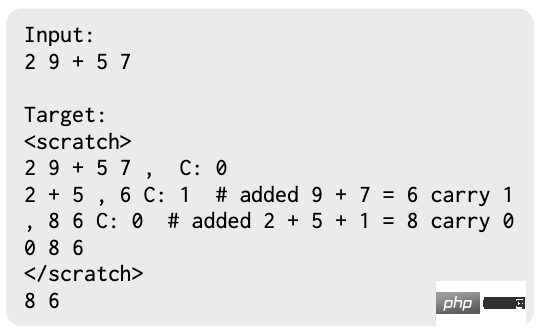

Dann gibt es noch die von Google und MIT gemeinsam entwickelte Scrathpad-Methode, die es der KI ermöglicht, die Zwischenergebnisse von Schritt-für-Schritt-Berechnungen zwischenzuspeichern.

Schließlich gibt es noch die Methode der Mehrheitsabstimmung, die erst im März dieses Jahres veröffentlicht wurde.

Lassen Sie die KI dieselbe Frage mehrmals beantworten und wählen Sie die Antwort aus, die am häufigsten erscheint.

Nachdem alle diese Techniken verwendet wurden, erreicht Minerva mit 540 Milliarden Parametern SOTA in verschiedenen Testsätzen.

Sogar die 8-Milliarden-Parameter-Version von Minerva kann das Niveau der neuesten aktualisierten davinci-002-Version von GPT-3 bei Mathematikproblemen auf Wettbewerbsebene und offenen MIT-Kursproblemen erreichen.

Nachdem ich so viel gesagt habe: Welche konkreten Fragen kann Minerva stellen?

Google hat auch ein Beispielset geöffnet, schauen wir uns das an.

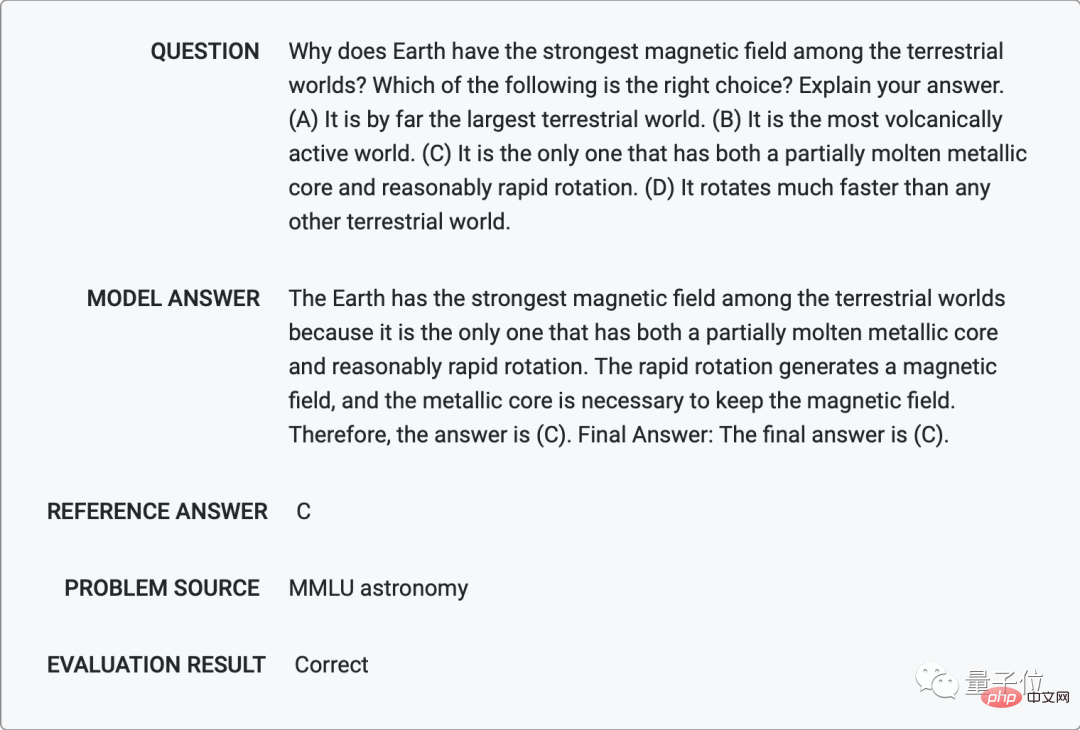

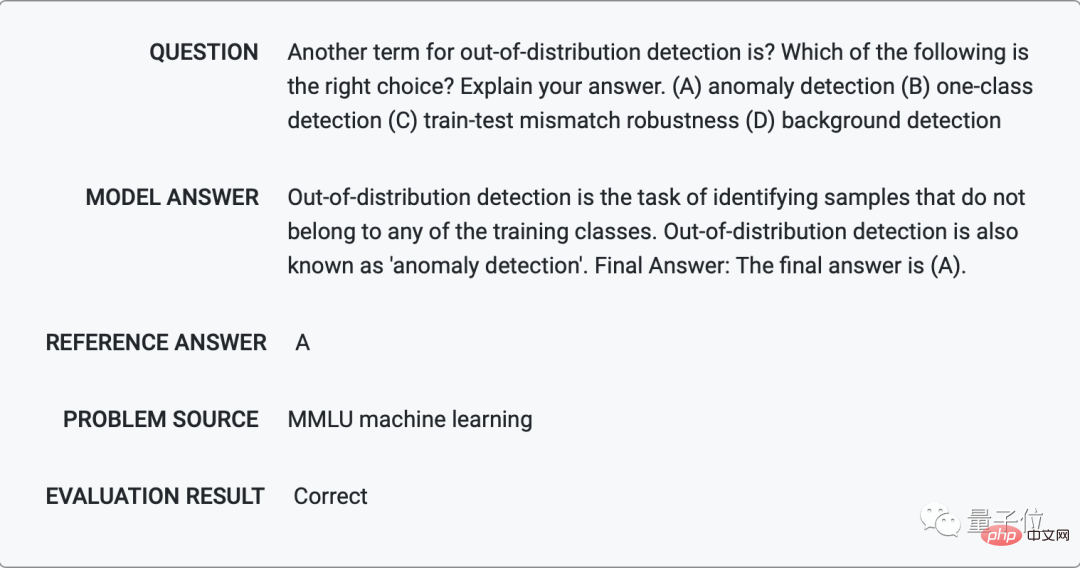

Es ist vielseitig in Mathematik, Physik, Chemie und sogar maschinellem Lernen einsetzbar.

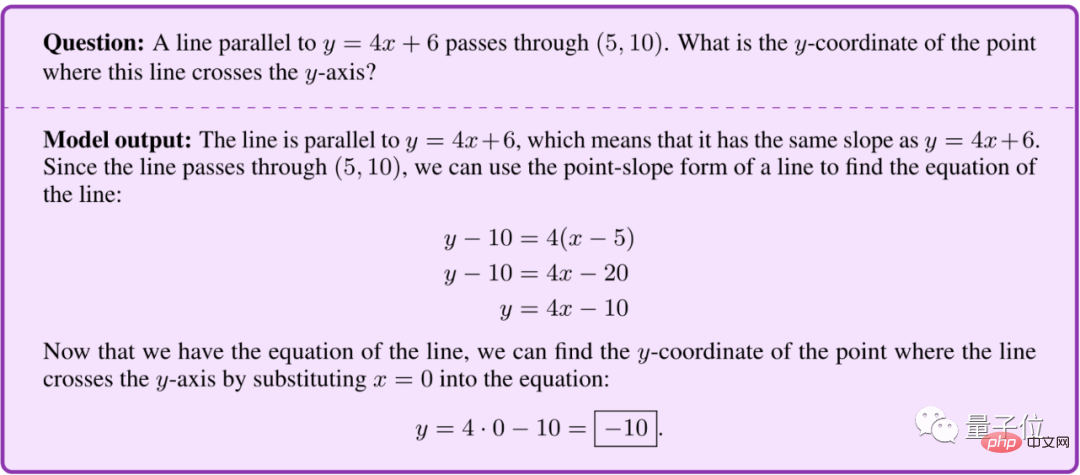

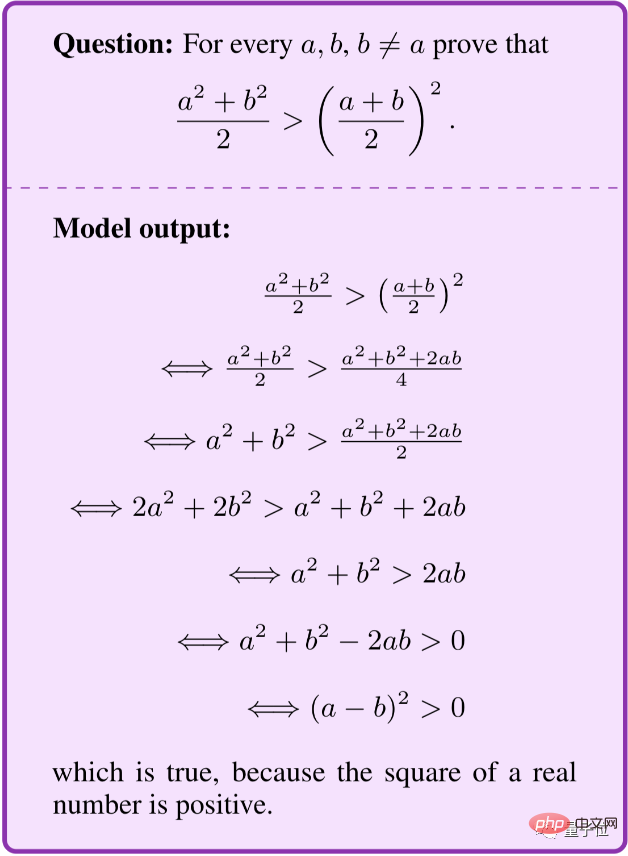

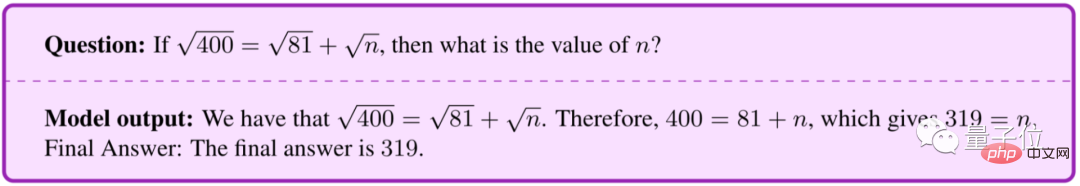

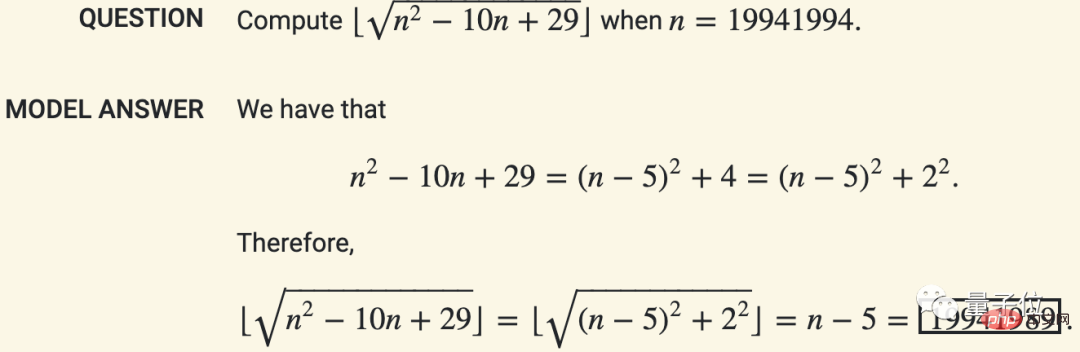

In der Mathematik kann Minerva wie Menschen Werte Schritt für Schritt berechnen, anstatt sie direkt gewaltsam zu lösen.

Bei Textaufgaben können Sie Ihre eigenen Gleichungen aufstellen und diese vereinfachen.

Sie können sogar den Beweis herleiten.

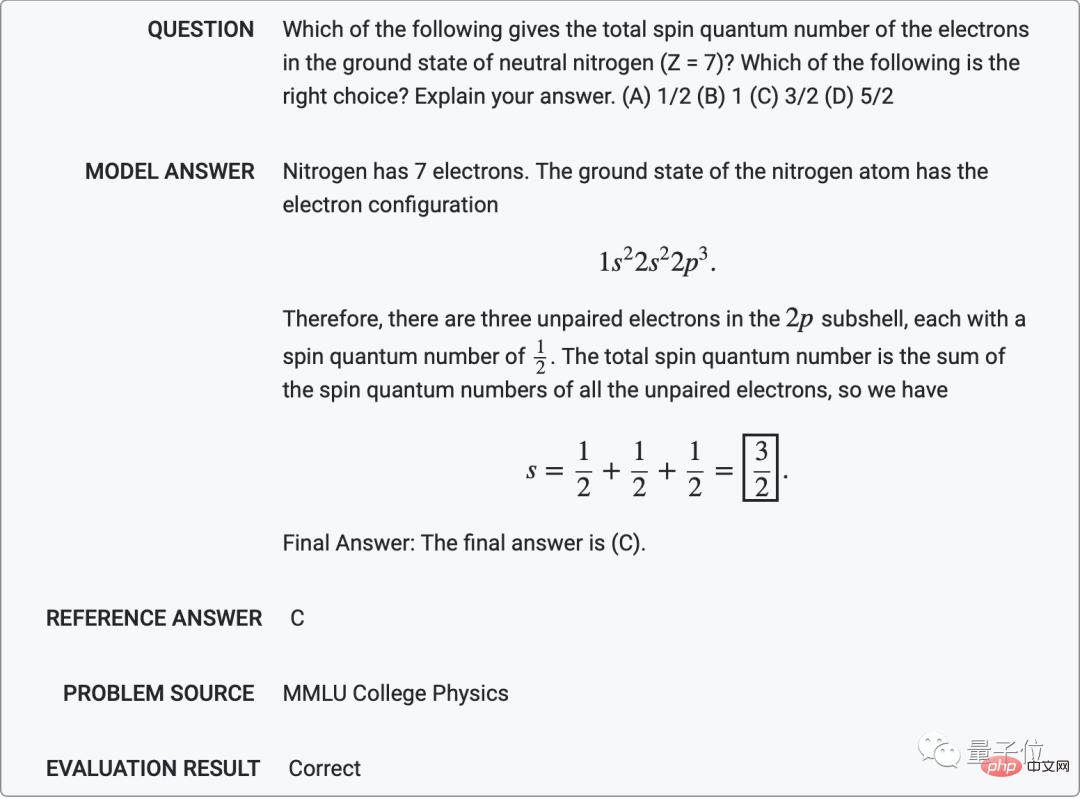

In der Physik kann Minerva Fragen auf Universitätsniveau lösen, beispielsweise die Ermittlung der Gesamtspinquantenzahl von Elektronen im neutralen Stickstoffgrundzustand (Z = 7).

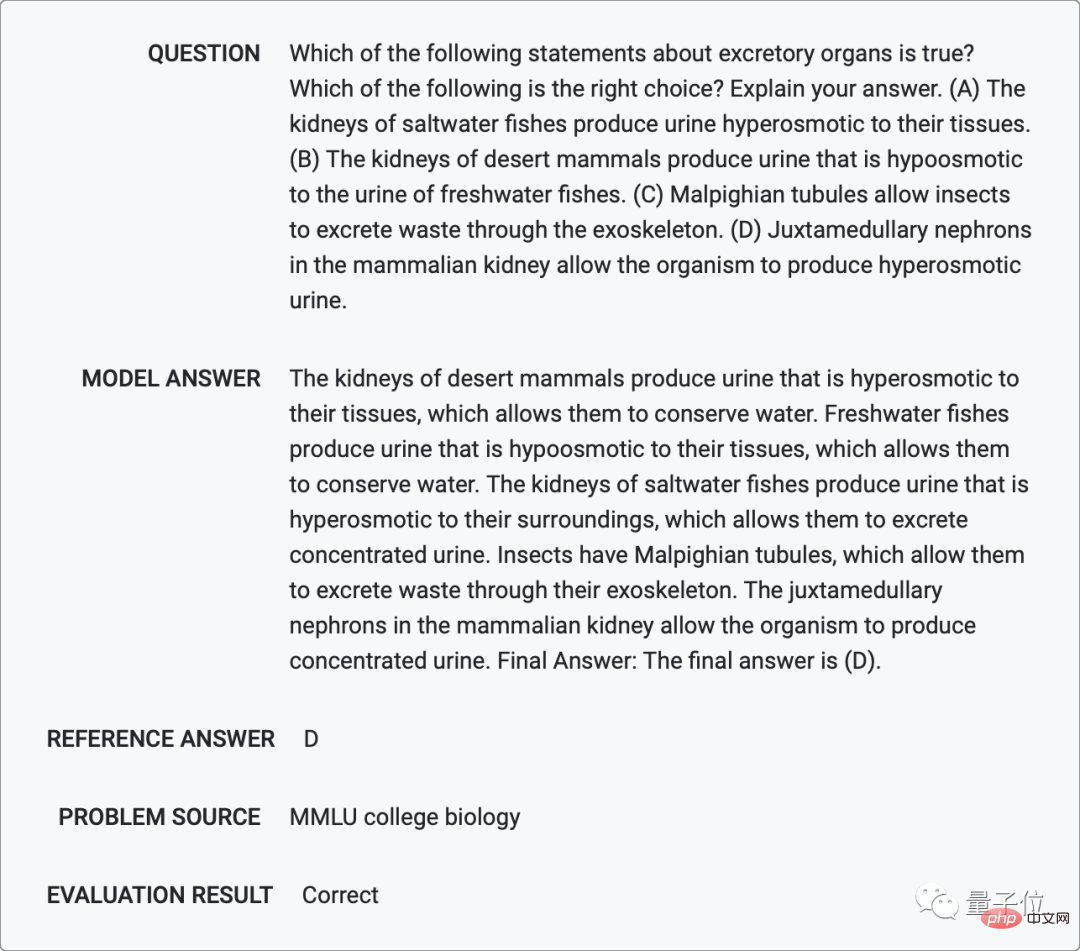

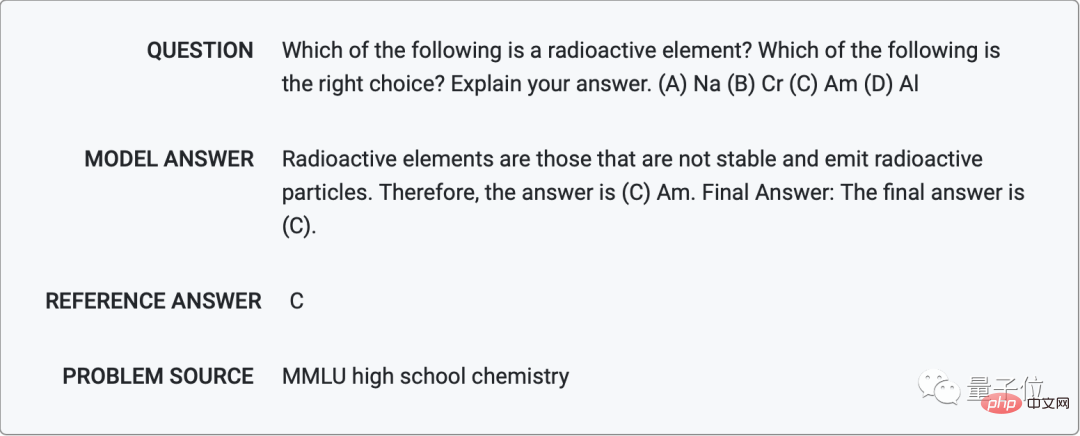

In Biologie und Chemie kann Minerva mit ihrem Sprachverständnis auch verschiedene Multiple-Choice-Fragen beantworten.

Welche der folgenden Formen von Punktmutationen hat keinen negativen Einfluss auf Proteine, die aus DNA-Sequenzen gebildet werden?

Welches der folgenden Elemente ist ein radioaktives Element?

Und Astronomie: Warum hat die Erde ein starkes Magnetfeld?

In Bezug auf maschinelles Lernen wird dieser Begriff korrekterweise anders ausgedrückt, indem die spezifische Bedeutung der „Erkennung von Proben außerhalb der Verteilung“ erläutert wird.

...

Allerdings macht Minerva manchmal einige dumme Fehler, wie zum Beispiel das Streichen des √ auf beiden Seiten der Gleichung.

Darüber hinaus wird es bei Minerva mit einer Wahrscheinlichkeit von 8 % „falsch positive“ Situationen geben, in denen der Denkprozess falsch, das Ergebnis aber richtig ist, wie zum Beispiel die folgende.

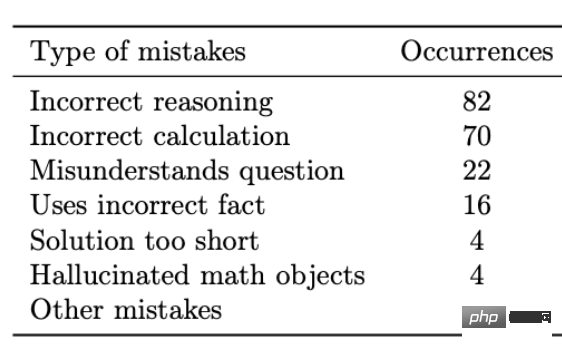

Nach der Analyse stellte das Team fest, dass die Hauptfehlerformen auf Rechenfehlern und Argumentationsfehlern beruhten und nur ein kleiner Teil auf andere Situationen zurückzuführen war, beispielsweise auf Fehler beim Verständnis der Bedeutung der Frage und die Verwendung falscher Fakten in der Frage Schritte.

Die Berechnungsfehler lassen sich leicht durch den Zugriff auf einen externen Rechner oder Python-Interpreter beheben, andere Arten von Fehlern lassen sich jedoch nur schwer korrigieren, da das neuronale Netzwerk zu groß ist.

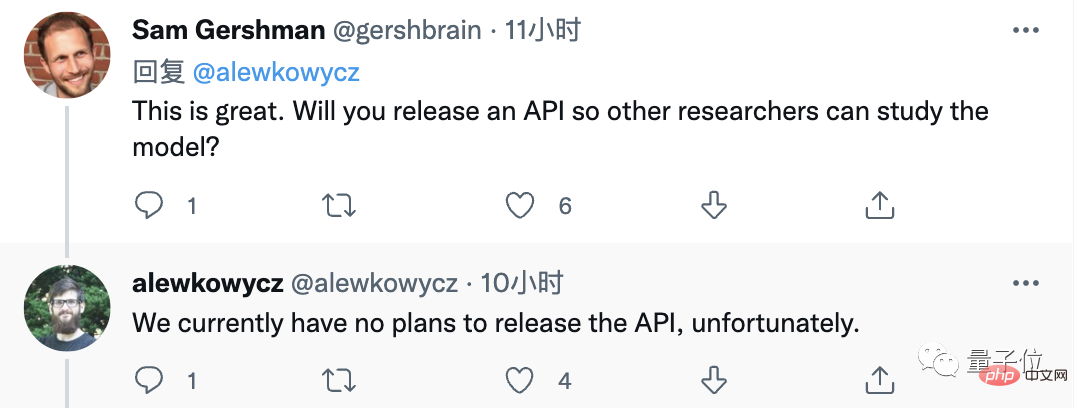

Im Allgemeinen hat die Leistung von Minerva viele Leute überrascht und sie haben im Kommentarbereich nach APIs gefragt (leider hat Google noch keine öffentlichen Pläne gemacht).

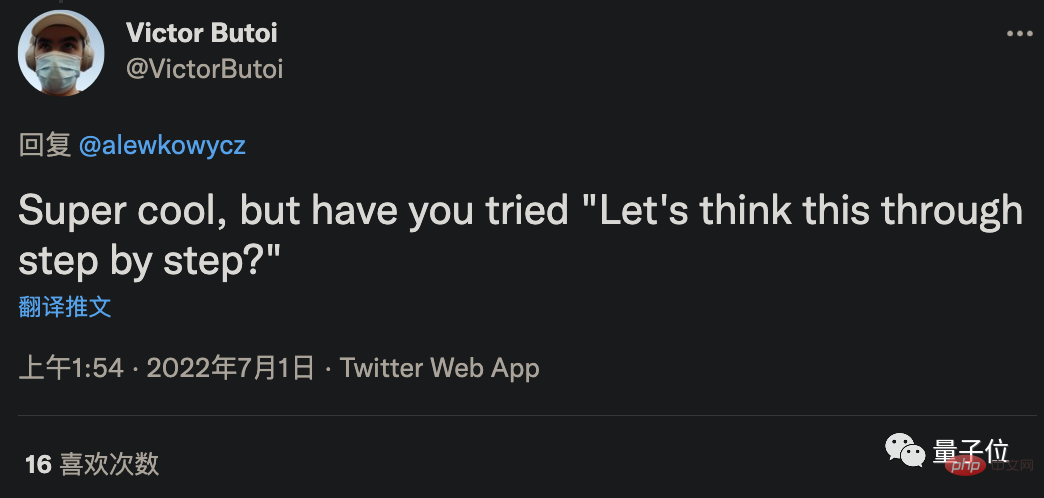

Einige Internetnutzer dachten, dass die Genauigkeitsrate von GPT-3 in Verbindung mit der „Überredungsmethode“, die die Problemlösungsgenauigkeit von GPT-3 in den letzten Tagen um 61 % steigern konnte, noch verbessert werden könnte?

Die Antwort des Autors lautet jedoch, dass die Überredungsmethode zum Lernen ohne Stichproben gehört und, egal wie stark sie ist, möglicherweise nicht so gut ist wie das Lernen mit wenigen Stichproben und 4 Beispielen.

Einige Internetnutzer fragten auch: Kann es umgekehrt verwendet werden, da es Fragen stellen kann?

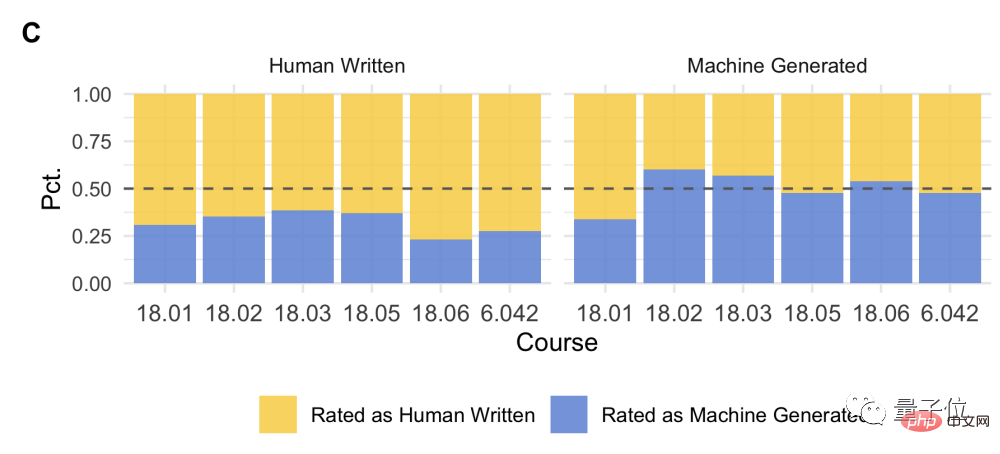

Tatsächlich hat sich das MIT mit OpenAI zusammengetan, um mithilfe von KI Fragen für Studenten zu stellen.

Sie vermischten Fragen von Menschen und Fragen von KI und forderten die Schüler auf, Fragebögen auszufüllen. Es war für alle schwierig zu erkennen, ob eine Frage von KI gestellt wurde.

Kurz gesagt, die aktuelle Situation ist, außer dass diejenigen, die an KI arbeiten, damit beschäftigt sind, dieses Papier zu lesen.

Die Schüler freuen sich darauf, eines Tages ihre Hausaufgaben mithilfe von KI erledigen zu können.

Lehrer hoffen auch, dass sie eines Tages KI für die Erstellung von Prüfungsarbeiten nutzen können.

Papieradresse: https://storage.googleapis.com/minerva-paper/minerva_paper.pdf

Demo-Adresse: https://minerva-demo.github.io/

Verwandte Papiere: Chain of Thought https://arxiv.org/abs/2201.11903Scrathpads https://arxiv.org/abs/2112.00114Mehrheitsabstimmung https://arxiv.org/abs/2203.11171

Referenzlink:

https://ai.googleblog .com/2022/06/minerva-solving-quantitative-reasoning.html

https://twitter.com/bneyshabur/status/1542563148334596098

https://twitter.com/alewkowycz/status/1542559176483823622

Das obige ist der detaillierte Inhalt vonDie KI spielt verrückt, wenn es um Quizze geht! Die Genauigkeitsrate der Mathematikprüfung auf hohem Niveau beträgt 81 % und die Punktzahl bei den Wettbewerbsfragen übertrifft die des Informatikdoktors. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

SQllimit -Klausel: Steuern Sie die Anzahl der Zeilen in Abfrageergebnissen. Die Grenzklausel in SQL wird verwendet, um die Anzahl der von der Abfrage zurückgegebenen Zeilen zu begrenzen. Dies ist sehr nützlich, wenn große Datensätze, paginierte Anzeigen und Testdaten verarbeitet werden und die Abfrageeffizienz effektiv verbessern können. Grundlegende Syntax der Syntax: SelectColumn1, Spalte2, ... Fromtable_Namelimitnumber_of_rows; number_of_rows: Geben Sie die Anzahl der zurückgegebenen Zeilen an. Syntax mit Offset: SelectColumn1, Spalte2, ... Fromtable_NamelimitOffset, Number_of_rows; Offset: Skip überspringen

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Es ist unmöglich, das MongoDB -Passwort direkt über Navicat anzuzeigen, da es als Hash -Werte gespeichert ist. So rufen Sie verlorene Passwörter ab: 1. Passwörter zurücksetzen; 2. Überprüfen Sie die Konfigurationsdateien (können Hash -Werte enthalten). 3. Überprüfen Sie Codes (May Hardcode -Passwörter).

Beherrschen Sie die Reihenfolge nach Klausel in SQL: Daten effektiv sortieren

Apr 08, 2025 pm 07:03 PM

Beherrschen Sie die Reihenfolge nach Klausel in SQL: Daten effektiv sortieren

Apr 08, 2025 pm 07:03 PM

Detaillierte Erläuterung der SQLORDSBY -Klausel: Die effiziente Sortierung der Datenreihenfolge -Klausel ist eine Schlüsselanweisung in SQL, die zur Sortierung von Abfrageergebnissen verwendet wird. Es kann in einzelnen Spalten oder mehreren Spalten in den Aufstieg (ASC) oder absteigender Reihenfolge (Desc) angeordnet werden, wodurch die Datenlesbarkeit und die Effizienz der Datenverwaltung erheblich verbessert werden. OrderBy syntax SelectColumn1, Spalte2, ... fromTable_NameOrDByColumn_Name [ASC | Desc]; Column_Name: Sortieren nach Spalte. ASC: Ascending Order Sort (Standard). Desc: Sortieren Sie in absteigender Reihenfolge. OrderBy Hauptmerkmale: Multi-Sortier-Sortierung: Unterstützt mehrere Spaltensortierungen, und die Reihenfolge der Spalten bestimmt die Priorität der Sortierung. seit

Navicat stellt eine Verbindung zu Datenbankfehlercode und Lösung her

Apr 08, 2025 pm 11:06 PM

Navicat stellt eine Verbindung zu Datenbankfehlercode und Lösung her

Apr 08, 2025 pm 11:06 PM

Häufige Fehler und Lösungen beim Anschließen mit Datenbanken: Benutzername oder Kennwort (Fehler 1045) Firewall -Blocks -Verbindungsverbindung (Fehler 2003) Timeout (Fehler 10060) Die Verwendung von Socket -Verbindung kann nicht verwendet werden (Fehler 1042).

So schreiben Sie das neueste Tutorial zur SQL Insertion -Erklärung

Apr 09, 2025 pm 01:48 PM

So schreiben Sie das neueste Tutorial zur SQL Insertion -Erklärung

Apr 09, 2025 pm 01:48 PM

Mit der SQL -Insert -Anweisung wird eine Datenbanktabelle neue Zeilen hinzufügen, und ihre Syntax ist: Intable_Name (Spalte1, Spalte2, ..., Columnn) Werte (Value1, Value2, ..., Valuen);. Diese Anweisung unterstützt das Einfügen mehrerer Werte und ermöglicht es, Nullwerte in Spalten eingefügt zu werden. Es ist jedoch erforderlich, sicherzustellen, dass die eingefügten Werte mit dem Datentyp der Spalte kompatibel sind, um zu vermeiden, dass Einzigartigkeitsbeschränkungen verstoßen.

So fügen Sie eine neue Spalte in SQL hinzu

Apr 09, 2025 pm 02:09 PM

So fügen Sie eine neue Spalte in SQL hinzu

Apr 09, 2025 pm 02:09 PM

Fügen Sie einer vorhandenen Tabelle in SQL neue Spalten hinzu, indem Sie die Anweisung für die Änderung Tabelle verwenden. Zu den spezifischen Schritten gehören: Ermittlung des Tabellennamens und Spalteninformationen, Schreiben von Alter Tabellenanweisungen und Ausführungsanweisungen. Fügen Sie beispielsweise eine E -Mail -Spalte in die Tabelle der Kunden hinzu (VARCHAR (50)): Änderung der Tabelle Kunden addieren Sie E -Mail -Varchar (50).

Navicat -Verbindungs -Zeitüberschreitung: So lösen Sie sich

Apr 08, 2025 pm 11:03 PM

Navicat -Verbindungs -Zeitüberschreitung: So lösen Sie sich

Apr 08, 2025 pm 11:03 PM

Gründe für die Navicat -Verbindungszeitüberschreitung: Netzwerkinstabilität, geschäftige Datenbank, Firewall -Blockierung, Serverkonfigurationsprobleme und unsachgemäße Navicat -Einstellungen. Lösungsschritte: Überprüfen Sie die Netzwerkverbindung, den Datenbankstatus, die Firewall -Einstellungen, die Serverkonfiguration, prüfen Sie die Navicat -Einstellungen, starten Sie die Software und den Server neu und wenden Sie sich an den Administrator, um Hilfe zu erhalten.