Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

ConvNeXt V2 verwendet hier nur die einfachste Faltungsarchitektur und ist hinsichtlich der Leistung Transformer nicht unterlegen

ConvNeXt V2 verwendet hier nur die einfachste Faltungsarchitektur und ist hinsichtlich der Leistung Transformer nicht unterlegen

ConvNeXt V2 verwendet hier nur die einfachste Faltungsarchitektur und ist hinsichtlich der Leistung Transformer nicht unterlegen

Nach Jahrzehnten der Grundlagenforschung hat das Gebiet der visuellen Erkennung eine neue Ära des groß angelegten Lernens visueller Darstellungen eingeläutet. Vorab trainierte großformatige Vision-Modelle sind zu einem unverzichtbaren Werkzeug für Feature-Learning und Vision-Anwendungen geworden. Die Leistung eines Lernsystems für visuelle Darstellung wird stark von drei Hauptfaktoren beeinflusst: der neuronalen Netzwerkarchitektur des Modells, der zum Trainieren des Netzwerks verwendeten Methode und den Trainingsdaten. Verbesserungen bei jedem Faktor tragen zu einer verbesserten Gesamtleistung des Modells bei.

Innovationen im Design neuronaler Netzwerkarchitekturen haben im Bereich des Repräsentationslernens schon immer eine wichtige Rolle gespielt. Die Convolutional Neural Network Architecture (ConvNet) hatte einen erheblichen Einfluss auf die Computer-Vision-Forschung und ermöglichte den Einsatz universeller Feature-Learning-Methoden bei verschiedenen visuellen Erkennungsaufgaben, ohne auf manuell implementiertes Feature-Engineering angewiesen zu sein. In den letzten Jahren hat die ursprünglich für die Verarbeitung natürlicher Sprache entwickelte Transformer-Architektur aufgrund ihrer Eignung für Modelle und Datensätze unterschiedlicher Größe auch in anderen Deep-Learning-Bereichen breite Anwendung gefunden.

Das Aufkommen der ConvNeXt-Architektur modernisiert das traditionelle ConvNet und beweist, dass sich reine Faltungsmodelle auch an Änderungen in der Modell- und Datensatzgröße anpassen können. Die gebräuchlichste Methode zur Erkundung des Designraums neuronaler Netzwerkarchitekturen besteht jedoch nach wie vor darin, die Leistung des überwachten Lernens auf ImageNet zu bewerten.

Eine weitere Idee besteht darin, den Schwerpunkt des visuellen Repräsentationslernens vom beschrifteten überwachten Lernen auf selbstüberwachtes Vortraining zu verlagern. Selbstüberwachte Algorithmen führten die maskierte Sprachmodellierung in das Sichtfeld ein und wurden schnell zu einer beliebten Methode zum Erlernen visueller Darstellungen. Beim selbstüberwachten Lernen wird jedoch typischerweise eine Architektur verwendet, die für überwachtes Lernen konzipiert ist, und es wird davon ausgegangen, dass die Architektur festgelegt ist. Beispielsweise verwendet Masked Autoencoder (MAE) eine visuelle Transformatorarchitektur.

Eine Möglichkeit besteht darin, diese Architekturen mit selbstüberwachten Lernrahmen zu kombinieren, aber dabei treten einige spezifische Probleme auf. Beispielsweise entsteht bei der Kombination von ConvNeXt mit MAE das folgende Problem: MAE verfügt über ein spezielles Encoder-Decoder-Design, das für die Sequenzverarbeitungsfähigkeiten des Transformators optimiert ist, wodurch sich der rechenintensive Encoder auf diese sichtbaren Patches konzentriert und dadurch das Vortraining reduziert wird Kosten. Dieses Design ist jedoch möglicherweise nicht mit dem Standard-ConvNet kompatibel, das dichte Schiebefenster verwendet. Ohne Berücksichtigung der Beziehung zwischen Architektur und Trainingszielen ist außerdem unklar, ob eine optimale Leistung erreicht werden kann. Tatsächlich zeigen bestehende Untersuchungen, dass es schwierig ist, ConvNet mit maskenbasiertem selbstüberwachtem Lernen zu trainieren, und experimentelle Beweise zeigen, dass Transformer und ConvNet beim Feature-Lernen unterschiedlich sein können, was sich auf die Qualität der endgültigen Darstellung auswirkt.

Zu diesem Zweck schlugen Forscher von KAIST, Meta und der New York University (darunter Liu Zhuang, Erstautor von ConvNeXt, und Xie Saining, Erstautor von ResNeXt) vor, gemeinsam die Netzwerkarchitektur und den maskierten Autoencoder darunter zu entwerfen Der Zweck dieses Frameworks besteht darin, maskenbasiertes selbstüberwachtes Lernen auf ConvNeXt-Modelle anzuwenden und Ergebnisse zu erzielen, die mit denen von Transformatoren vergleichbar sind.

Papieradresse: https://arxiv.org/pdf/2301.00808v1.pdf

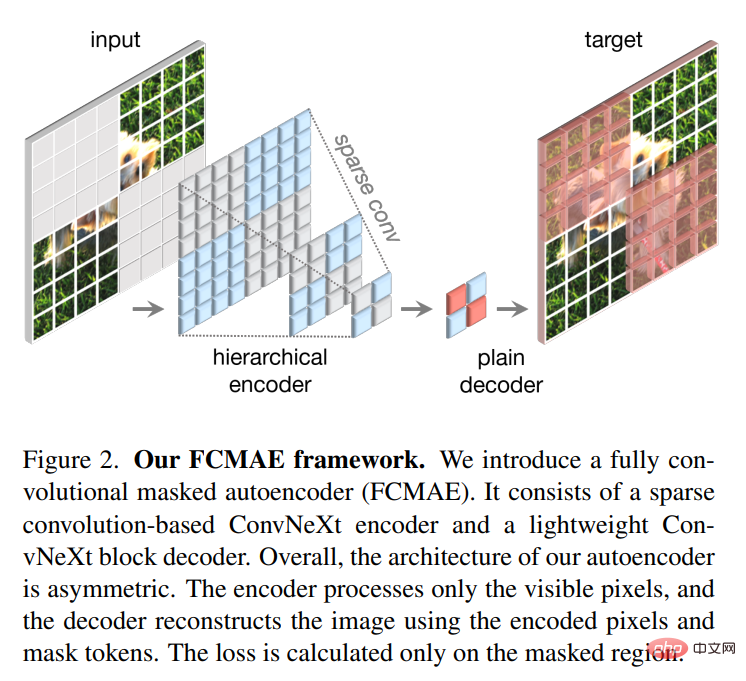

Beim Entwerfen eines maskierten Autoencoders behandelt diese Studie die Eingabe mit einer Maske als einen Satz spärlicher Patches , und spärliche Faltung wird verwendet, um die sichtbaren Teile zu verarbeiten. Die Idee wurde durch die Verwendung spärlicher Windungen bei der Verarbeitung großräumiger 3D-Punktwolken inspiriert. Konkret schlägt diese Forschung vor, ConvNeXt mit spärlichen Faltungen zu implementieren und dann während der Feinabstimmung die Gewichte ohne spezielle Verarbeitung wieder in standardmäßige dichte Netzwerkschichten umzuwandeln. Um die Effizienz vor dem Training weiter zu verbessern, ersetzt diese Studie den Transformatordecoder durch einen einzelnen ConvNeXt, wodurch das gesamte Design vollständig faltungsfähig wird. Die Forscher stellten fest, dass nach dem Hinzufügen dieser Änderungen die erlernten Funktionen nützlich waren und die Basisergebnisse verbesserten, die fein abgestimmte Leistung jedoch immer noch schlechter war als das transformatorbasierte Modell.

Dann analysierte die Studie den Funktionsraum von ConvNeXt mit verschiedenen Trainingskonfigurationen. Beim direkten Training von ConvNeXt auf maskierten Eingaben stellten die Forscher mögliche Probleme beim Zusammenbruch von Merkmalen in der MLP-Ebene fest. Um dieses Problem zu lösen, schlägt diese Studie vor, eine globale Antwortnormalisierungsschicht (Global Response Normalization Layer) hinzuzufügen, um den Funktionswettbewerb zwischen Kanälen zu verbessern. Diese Verbesserung ist am effektivsten, wenn das Modell mit maskierten Autoencodern vorab trainiert wird, was darauf hindeutet, dass die Wiederverwendung fester Architekturentwürfe aus überwachtem Lernen möglicherweise nicht der beste Ansatz ist.

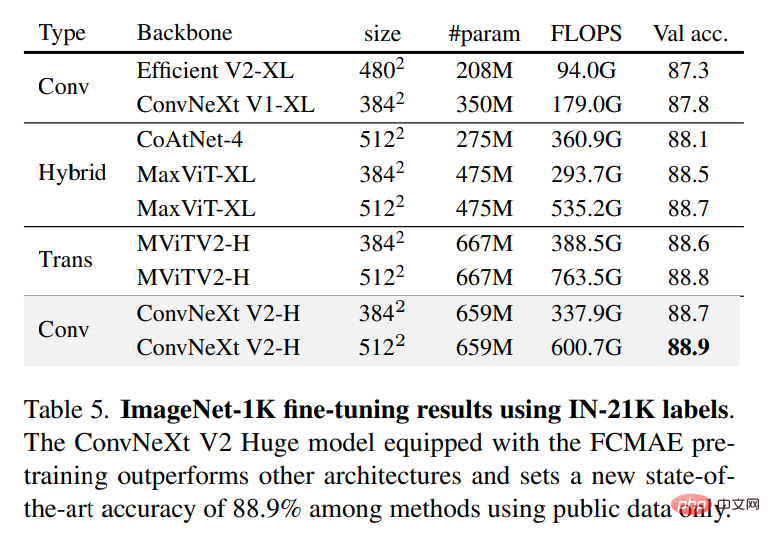

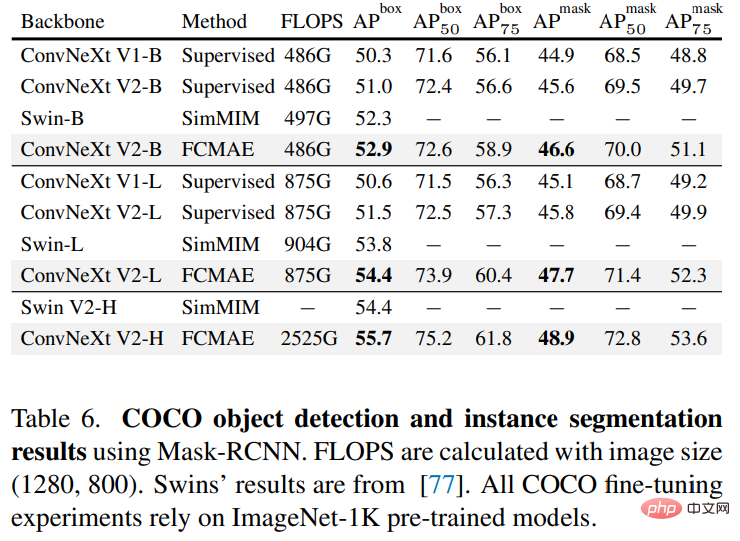

Basierend auf den oben genannten Verbesserungen schlägt diese Studie ConvNeXt V2 vor, das in Kombination mit maskierten Autoencodern eine bessere Leistung zeigt. Gleichzeitig stellten die Forscher fest, dass ConvNeXt V2 gegenüber reinem ConvNet bei verschiedenen Downstream-Aufgaben erhebliche Leistungsverbesserungen aufweist, darunter Klassifizierungsaufgaben auf ImageNet, Zielerkennung auf COCO und semantische Segmentierung auf ADE20K. Die in dieser Studie vorgeschlagene Methode ist konzeptionell einfach und basiert auf der vollständigen Faltungsmethode. Das Lernsignal wird generiert, indem die ursprüngliche visuelle Eingabe zufällig mit einem hohen Maskierungsverhältnis maskiert wird und das Modell dann die fehlenden Teile basierend auf dem verbleibenden Kontext vorhersagen lässt. Der Gesamtrahmen ist in der folgenden Abbildung dargestellt. Das

-Framework besteht aus einem auf spärlicher Faltung basierenden ConvNeXt-Encoder und einem leichtgewichtigen ConvNeXt-Decoder, wobei die Struktur des Autoencoders asymmetrisch ist. Der Encoder verarbeitet nur sichtbare Pixel, während der Decoder codierte Pixel und Maskentokens verwendet, um das Bild zu rekonstruieren. Gleichzeitig wird der Verlust nur im maskierten Bereich berechnet.

-Framework besteht aus einem auf spärlicher Faltung basierenden ConvNeXt-Encoder und einem leichtgewichtigen ConvNeXt-Decoder, wobei die Struktur des Autoencoders asymmetrisch ist. Der Encoder verarbeitet nur sichtbare Pixel, während der Decoder codierte Pixel und Maskentokens verwendet, um das Bild zu rekonstruieren. Gleichzeitig wird der Verlust nur im maskierten Bereich berechnet.

Globale Reaktionsnormalisierung

Es gibt viele Mechanismen im Gehirn, die die neuronale Diversität fördern. Beispielsweise kann die laterale Hemmung dazu beitragen, die Reaktion aktivierter Neuronen zu verbessern, indem sie den Kontrast und die Selektivität einzelner Neuronen gegenüber Reizen erhöht und gleichzeitig die Reaktionsvielfalt ganzer Neuronenpopulationen erhöht. Beim Deep Learning kann diese Form der lateralen Hemmung durch Antwortnormalisierung erreicht werden. In dieser Studie wird eine neue Antwortnormalisierungsschicht namens Global Response Normalization (GRN) eingeführt, die darauf abzielt, den Kontrast und die Selektivität zwischen Kanälen zu erhöhen. Die GRN-Einheit besteht aus drei Schritten: 1) globale Feature-Aggregation, 2) Feature-Normalisierung und 3) Feature-Kalibrierung. Wie in der Abbildung unten gezeigt, können GRN-Ebenen in den ursprünglichen ConvNeXt-Block zusammengeführt werden.

Die Forscher fanden anhand von Experimenten heraus, dass LayerScale bei der Anwendung von GRN nicht erforderlich ist und gelöscht werden kann. Unter Nutzung dieses neuen Blockdesigns erstellte die Studie eine Vielzahl von Modellen mit unterschiedlichen Effizienzen und Kapazitäten, die als ConvNeXt V2-Modellfamilie bezeichnet werden und von leichtgewichtig (Atto) bis rechenintensiv (Huge) reichen.

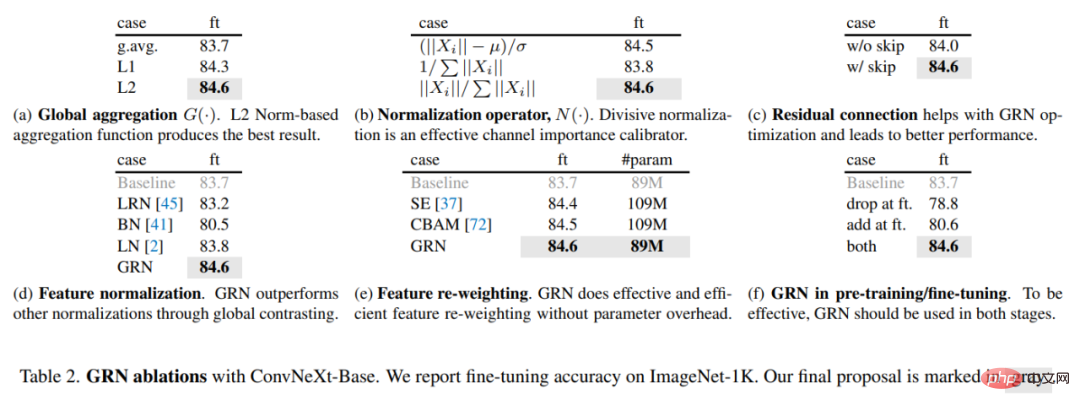

Um die Rolle von GRN zu bewerten, nutzte diese Studie das FCMAE-Framework, um ConvNeXt V2 vorab zu trainieren. Aus der visuellen Darstellung in Abbildung 3 unten und der Kosinus-Abstandsanalyse in Abbildung 4 lässt sich erkennen, dass ConvNeXt V2 das Problem des Merkmalkollapses effektiv lindert. Die Kosinus-Abstandswerte sind konstant hoch, was darauf hinweist, dass die Merkmalsvielfalt während der Übertragung von Netzwerkschichten erhalten bleiben kann. Dies ähnelt dem mit MAE vorab trainierten ViT-Modell. Dies zeigt, dass das Lernverhalten von ConvNeXt V2 dem von ViT unter einem ähnlichen Pre-Training-Framework für Maskenbilder ähnelt.

Um die Rolle von GRN zu bewerten, nutzte diese Studie das FCMAE-Framework, um ConvNeXt V2 vorab zu trainieren. Aus der visuellen Darstellung in Abbildung 3 unten und der Kosinus-Abstandsanalyse in Abbildung 4 lässt sich erkennen, dass ConvNeXt V2 das Problem des Merkmalkollapses effektiv lindert. Die Kosinus-Abstandswerte sind konstant hoch, was darauf hinweist, dass die Merkmalsvielfalt während der Übertragung von Netzwerkschichten erhalten bleiben kann. Dies ähnelt dem mit MAE vorab trainierten ViT-Modell. Dies zeigt, dass das Lernverhalten von ConvNeXt V2 dem von ViT unter einem ähnlichen Pre-Training-Framework für Maskenbilder ähnelt.

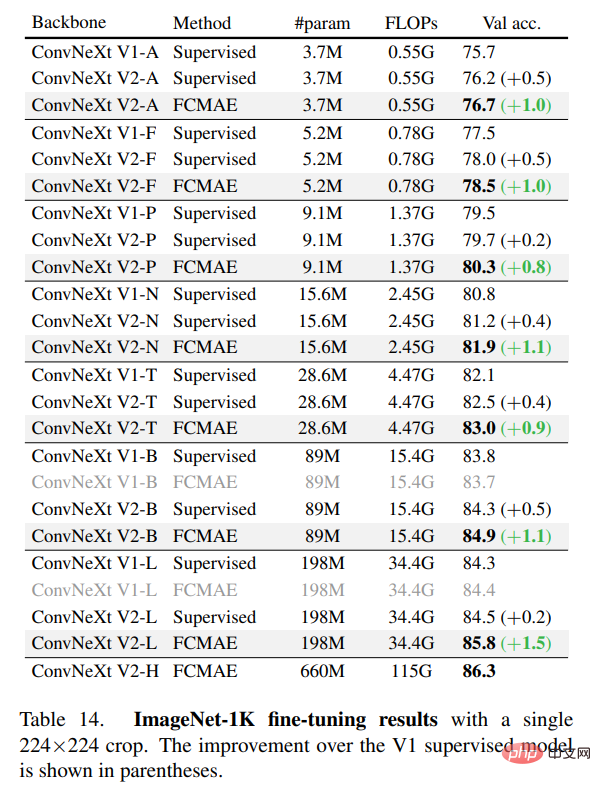

In der Studie wurde die Feinabstimmungsleistung weiter bewertet. Die Ergebnisse sind in der folgenden Tabelle aufgeführt.

Wenn es mit GRN ausgestattet ist, kann das vorab trainierte FCMAE-Modell das überwachte Modell, das mit 300 Epochen trainiert wurde, deutlich übertreffen. GRN verbessert die Darstellungsqualität durch die Verbesserung der Funktionsvielfalt, die für das maskenbasierte Vortraining von entscheidender Bedeutung ist und im ConvNeXt V1-Modell nicht vorhanden ist. Es ist erwähnenswert, dass diese Verbesserung ohne zusätzlichen Parameter-Overhead und ohne Erhöhung der FLOPS erreicht wird.

Abschließend untersuchte die Studie auch die Bedeutung von GRN für das Vortraining und die Feinabstimmung. Wie in Tabelle 2(f) unten gezeigt, sinkt die Leistung erheblich, unabhängig davon, ob GRN aus der Feinabstimmung entfernt wird oder neu initialisierte GRN während der Feinabstimmung hinzugefügt wird. Dies zeigt, dass GRN sowohl beim Vortraining als auch bei der Feinabstimmung wichtig ist.

Interessierte Leser können den Originaltext des Artikels lesen, um weitere Forschungsdetails zu erfahren.

Das obige ist der detaillierte Inhalt vonConvNeXt V2 verwendet hier nur die einfachste Faltungsarchitektur und ist hinsichtlich der Leistung Transformer nicht unterlegen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1386

1386

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Mar 18, 2024 am 09:20 AM

Mar 18, 2024 am 09:20 AM

Heute möchte ich eine aktuelle Forschungsarbeit der University of Connecticut vorstellen, die eine Methode zum Abgleichen von Zeitreihendaten mit großen NLP-Modellen (Natural Language Processing) im latenten Raum vorschlägt, um die Leistung von Zeitreihenprognosen zu verbessern. Der Schlüssel zu dieser Methode besteht darin, latente räumliche Hinweise (Eingabeaufforderungen) zu verwenden, um die Genauigkeit von Zeitreihenvorhersagen zu verbessern. Titel des Papiers: S2IP-LLM: SemanticSpaceInformedPromptLearningwithLLMforTimeSeriesForecasting Download-Adresse: https://arxiv.org/pdf/2403.05798v1.pdf 1. Hintergrundmodell für große Probleme

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren