Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Der neueste Meta-Agent ist ein meisterhafter Verhandlungsführer, der Verbündete gewinnt und die Herzen der Menschen versteht

Der neueste Meta-Agent ist ein meisterhafter Verhandlungsführer, der Verbündete gewinnt und die Herzen der Menschen versteht

Der neueste Meta-Agent ist ein meisterhafter Verhandlungsführer, der Verbündete gewinnt und die Herzen der Menschen versteht

Gaming ist seit langem ein Testfeld für Fortschritte in der KI – vom Sieg von Deep Blue über Schachgroßmeister Garry Kasparov über AlphaGos Beherrschung von „Go beyond people“ bis hin zu Pluribus, der die besten Pokerspieler besiegt. Aber ein wirklich nützlicher, allmächtiger Agent kann nicht einfach nur ein Brettspiel spielen und Schachfiguren bewegen. Man kommt nicht umhin zu fragen: Können wir einen effektiveren und flexibleren Agenten aufbauen, der wie Menschen mithilfe von Sprache verhandeln, überzeugen und mit Menschen zusammenarbeiten kann, um strategische Ziele zu erreichen?

In der Geschichte des Gamings gibt es einen klassisches Tischspiel „Diplomatie“ Wenn viele Leute das Spiel zum ersten Mal sehen, werden sie von seinem Spielbrett im Kartenstil schockiert sein. Betrachten Sie es als ein komplexes Kriegsspiel. Tatsächlich ist dies nicht der Fall. Dies ist ein Spiel, das die Mobilisierung von Sprache erfordert, um Verbündete zu gewinnen. Der Schlüssel zum Sieg liegt in der Interaktion zwischen den Spielern .

Jetzt hat Meta eine Herausforderung für dieses Spiel gestartet. Der von ihnen entwickelte intelligente Agent CICERO ist die erste KI, die in der Diplomatie das menschliche Niveau erreicht hat. CICERO demonstrierte dies in der Online-Version von webDiplomacy.net, wo CICERO im Durchschnitt mehr als doppelt so viele Punkte erzielte wie menschliche Spieler und zu den besten 10 % der Teilnehmer zählte, die mehr als ein Spiel gespielt hatten.

- Papieradresse: https://www.science.org/doi/10.1126/science.ade9097

- Homepage-Adresse: https://ai.facebook.com/research/ cicero/diplomacy/

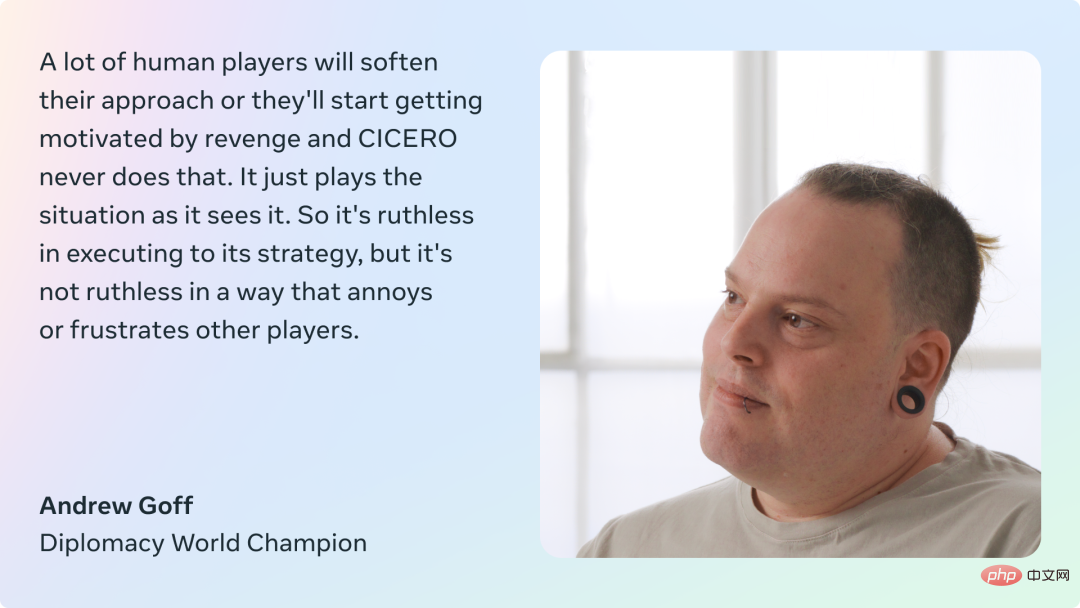

Diplomatie gilt seit Jahrzehnten als unüberwindbare Herausforderung im Bereich der KI, da das Spiel von den Spielern verlangt, die Motivationen und Perspektiven anderer zu verstehen, komplexe Pläne zu schmieden, Strategien anzupassen usw Auf dieser Grundlage wird natürliche Sprache verwendet, um Vereinbarungen mit anderen zu treffen, andere davon zu überzeugen, Partnerschaften und Allianzen zu bilden usw. Diese sind für Agenten immer noch schwierig, und CICERO ist immer noch sehr effektiv darin, natürliche Sprache für Verhandlungen mit Diplomatiespielern zu verwenden.

Im Gegensatz zu Schach und Go ist Diplomatie ein Spiel über Menschen, nicht über Figuren. Wenn ein Agent nicht erkennen kann, ob ein Gegner blufft oder tatsächlich sabotiert, verliert er das Spiel schnell. Wenn ein Agent nicht wie ein Mensch kommunizieren, Empathie zeigen, Beziehungen zu anderen aufbauen und über das Spiel sprechen kann, wird er auch keine anderen Spieler finden, die bereit sind, mit ihm zu kooperieren.

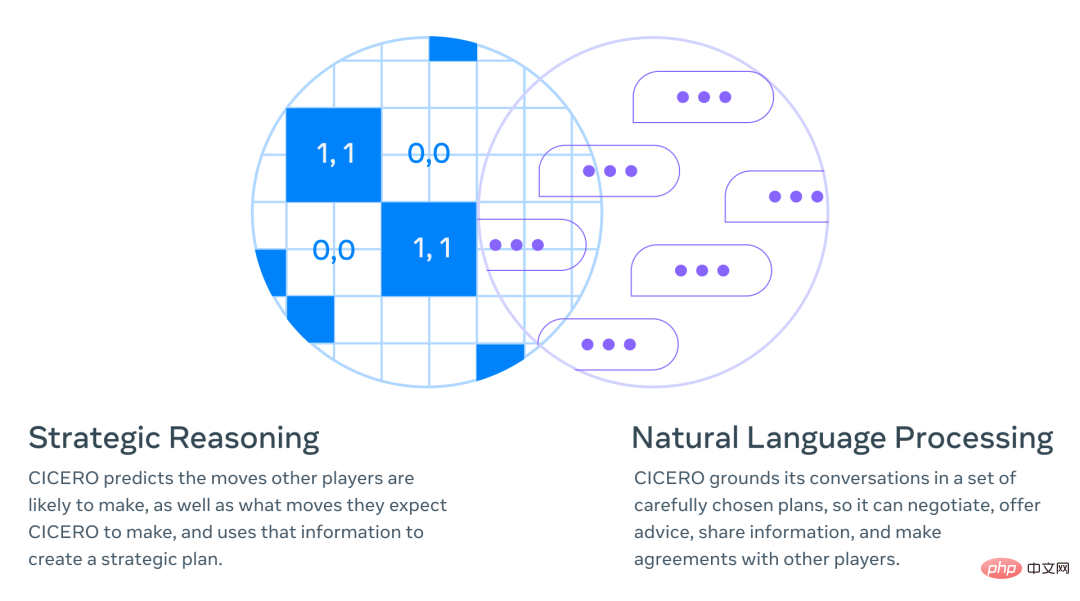

Metas Forschung kombiniert strategisches Denken (z. B. AlphaGo, Pluribus) mit natürlicher Sprachverarbeitung (z. B. GPT-3, BlenderBot 3, LaMDA, OPT-175B). Beispielsweise kommt CICERO spät im Spiel zu dem Schluss, dass es die Unterstützung eines bestimmten Spielers benötigt, und CICERO entwickelt dann eine Strategie, um die Gunst dieser Person zu gewinnen.

Wie man CICERO baut

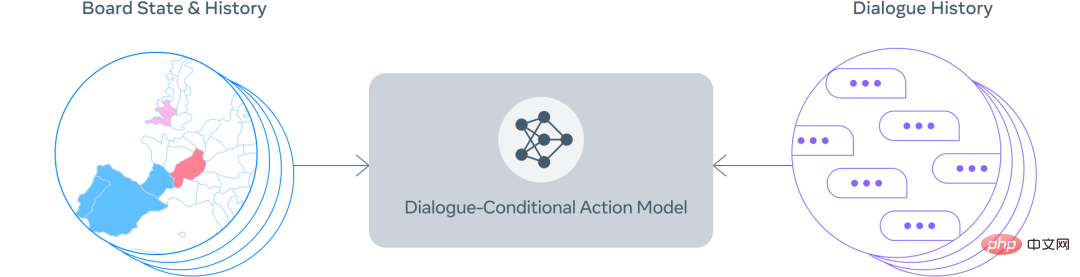

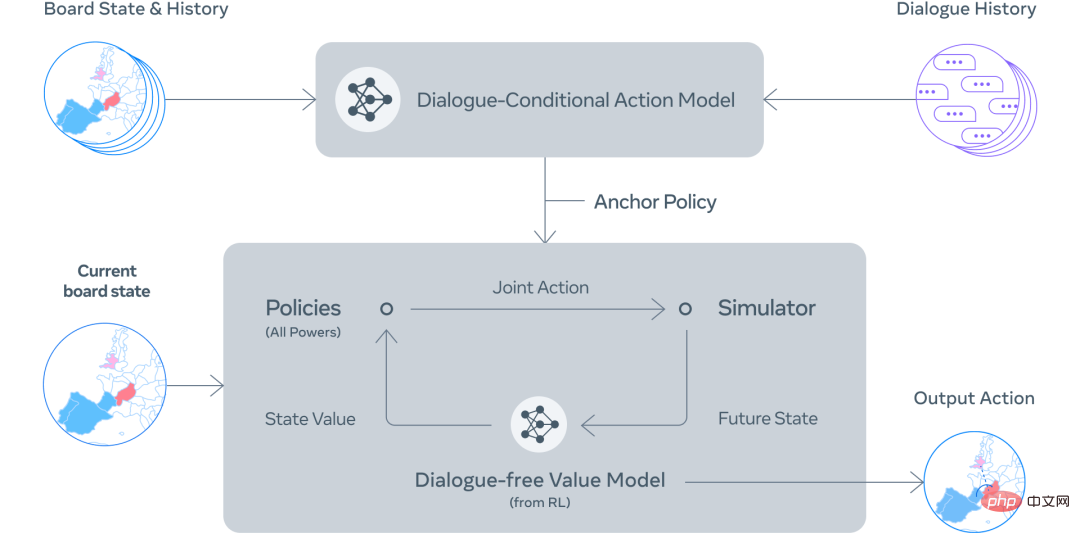

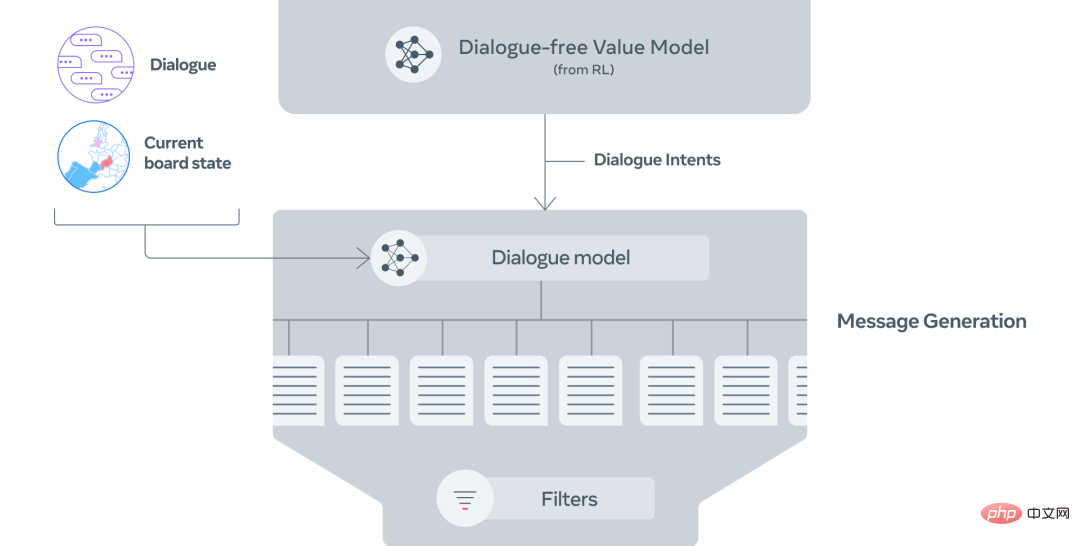

Der Kern von CICERO ist ein kontrollierbares Dialogmodell und eine strategische Argumentationsmaschine. Zu jedem Zeitpunkt im Spiel schaut sich CICERO das Spielbrett und seinen Gesprächsverlauf an und modelliert, was andere Spieler tun könnten. Anschließend wird ein Plan entwickelt, um das Sprachmodell zu steuern, seine Pläne anderen Spielern mitzuteilen und anderen Spielern sinnvolle Maßnahmen vorzuschlagen, die gut mit ihnen koordinieren. „Steuerbarer Dialog“ wurden auf webDiplomacy.net verfeinert.

Der Implementierungsprozess gliedert sich hauptsächlich in die folgenden Schritte:

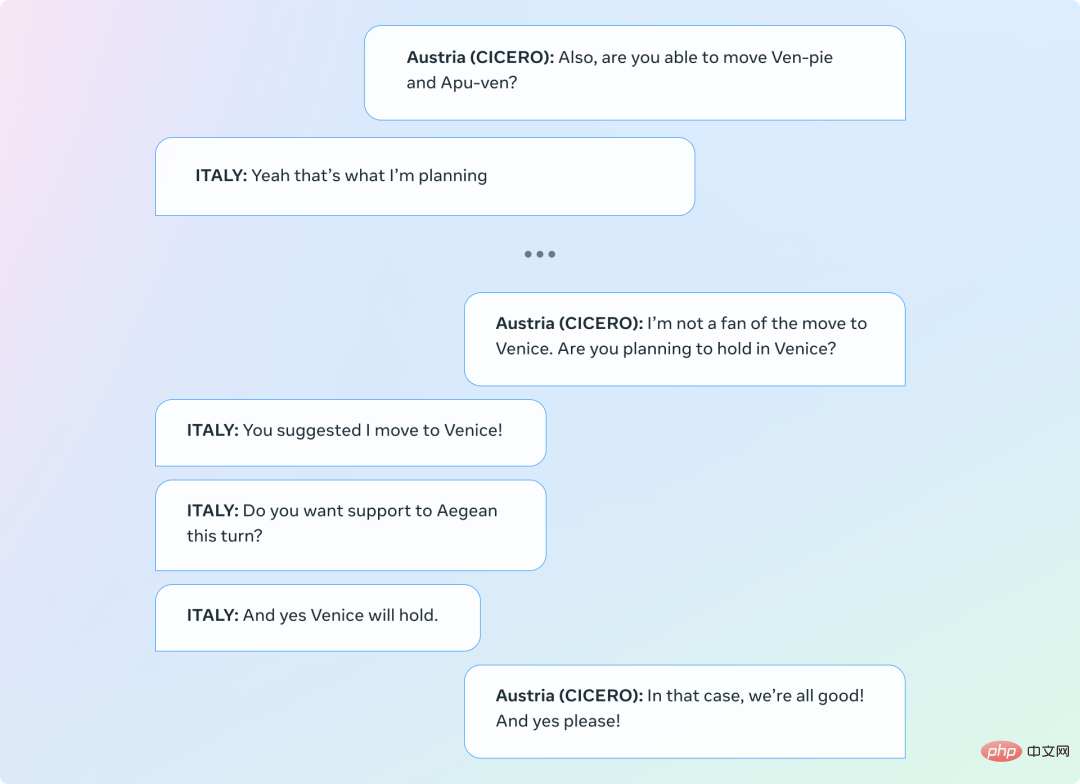

Schritt 1: Basierend auf dem Board-Status und dem aktuellen Gespräch gibt CICERO eine vorläufige Vorhersage darüber, was jede Person tun wird.Schritt 2: CICERO verbessert iterativ die anfängliche Prognose und nutzt die verbesserte Prognose dann, um eine Absicht für sich und seine Partner zu formulieren. Schritt 3: Generieren Sie mehrere Kandidatennachrichten basierend auf dem Vorstandsstatus, dem Dialog und der Absicht. Schritt 4: Kandidatennachrichten filtern, Wert maximieren und einheitliche Absichten untereinander sicherstellen. Die Forscher verwendeten einige Filtermechanismen, um die Qualität des Dialogs weiter zu verbessern, z. B. die Verwendung trainierter Klassifikatoren zur Unterscheidung zwischen menschlichem und modellgeneriertem Text, um sicherzustellen, dass der Dialog angemessen ist und mit dem Strom übereinstimmt Spielstand und vorherige Die Botschaft ist konsistent und strategisch fundiert. Conversational Awareness Strategy and Planning In kooperativen Spielen müssen Agenten lernen, zu simulieren, was Menschen im wirklichen Leben tatsächlich tun würden, anstatt Menschen wie Maschinen zu behandeln und sich vom Agenten leiten zu lassen, was sein soll Erledigt. Meta hofft daher, dass die von CICERO entwickelten Pläne im Einklang mit dem Dialog mit anderen Akteuren stehen. Die klassische Methode der menschlichen Modellierung ist überwachtes Lernen, bei dem gekennzeichnete Daten (z. B. eine Datenbank mit Aktionen menschlicher Spieler in vergangenen Spielen) verwendet werden, um einen Agenten zu schulen. Wenn man sich jedoch ausschließlich auf überwachtes Lernen verlässt, um Aktionen basierend auf früheren Gesprächen auszuwählen, ist der Agent relativ schwach und leicht auszunutzen. Beispielsweise könnte ein Spieler dem Agenten sagen: „Ich bin froh, dass wir uns darauf geeinigt haben, dass Sie Ihre Truppen von Paris wegziehen werden!“ Da ähnliche Informationen nur dann in den Trainingsdaten erscheinen, wenn eine Einigung erzielt wurde, kann der Agent seine Truppen tatsächlich wegziehen aus Paris, obwohl dies ein klarer strategischer Fehler war. Um dieses Problem zu lösen, führt CICERO einen iterativen Planungsalgorithmus aus, um die Konsistenz und Angemessenheit des Gesprächs in Einklang zu bringen. Der Agent sagt zunächst anhand seiner Gespräche mit anderen Spielern die Strategie jedes Spielers für die aktuelle Runde voraus und sagt auch voraus, wie die Strategie des Agenten nach Meinung anderer Spieler aussehen wird. Anschließend wird ein Planungsalgorithmus namens „piKL“ ausgeführt, der diese Vorhersagen iterativ verbessert, indem er versucht, angesichts der von anderen Spielern vorhergesagten Strategien neue Strategien mit höheren erwarteten Werten auszuwählen und gleichzeitig versucht, die neuen Vorhersagen nahe an der ursprünglichen strategischen Prognose zu halten . Die Forscher fanden heraus, dass piKL menschliche Spiele besser simulieren und dem Agenten bessere Strategien bieten kann als reines überwachtes Lernen. In Diplomacy ist die Art und Weise, wie Spieler miteinander reden, noch wichtiger als die Art und Weise, wie sie ihre Figuren bewegen. CICERO ist in der Lage, bei der Strategieentwicklung mit anderen Spielern klar und überzeugend zu kommunizieren. In einer Demo forderte CICERO beispielsweise einen Spieler auf, sofort einen bestimmten Teil des Spielbretts zu unterstützen, während er gleichzeitig Druck auf einen anderen Spieler ausübte, später im Spiel über eine Allianz nachzudenken. Während des Austauschs versucht CICERO, seine Strategie umzusetzen, indem er drei verschiedenen Spielern Aktionen vorschlägt. Im zweiten Gespräch kann der Agent den anderen Spielern erklären, warum sie kooperieren sollten und welchen Nutzen dies für beide Seiten hat. In diesem dritten Dialog holt CICERO sowohl Informationen ein als auch legt den Grundstein für künftige Maßnahmen. Man muss zugeben, dass CICERO manchmal auch inkonsistente Dialoge produziert, die seine Ziele untergraben. Im Beispiel unten spielt CICERO Österreich, aber der Agent bittet Italien, nach Venedig zu ziehen, was im Widerspruch zu seiner ersten Botschaft steht. Die Entstehung zielorientierter Dialogsysteme in einem Spiel, das sowohl Kooperation als auch Wettbewerb beinhaltet, stellt wichtige soziale und technische Herausforderungen dar, wenn es darum geht, KI mit menschlichen Absichten und Zielen in Einklang zu bringen. Diplomatie bietet einen besonders interessanten Kontext für die Untersuchung dieses Problems, da das Spielen des Spiels den Kampf mit widersprüchlichen Zielen und die Übersetzung dieser komplexen Ziele in natürliche Sprache erfordert. Als einfaches Beispiel könnte sich ein Spieler dafür entscheiden, bei kurzfristigen Vorteilen Kompromisse einzugehen, um eine Beziehung zu einem Verbündeten aufrechtzuerhalten, weil dieser Verbündete ihm helfen könnte, in der nächsten Runde in eine bessere Position zu gelangen. Während Meta in dieser Arbeit erhebliche Fortschritte gemacht hat, bleiben die Fähigkeit, Sprachmodelle mit spezifischen Absichten wirkungsvoll zu kombinieren, und die Techniken zur Bestimmung dieser Absichten (und normativen) Herausforderungen bestehen wichtige Themen. Durch die offene Bereitstellung des CICERO-Codes hofft Meta, dass KI-Forscher weiterhin auf verantwortungsvolle Weise auf dieser Arbeit aufbauen können. Das Team sagte: „Durch die Verwendung von Konversationsmodellen zur Zero-Shot-Klassifizierung haben wir erste Schritte zur Erkennung und Entfernung schädlicher Informationen in diesem neuen Bereich unternommen. Wir hoffen, dass „Diplomatie“ als sichere Sandbox dienen kann, um die Forschung zur Mensch-KI-Interaktion voranzutreiben.“ . 》 Während CICERO derzeit nur Diplomatiespiele spielen kann, ist die Technologie hinter dieser Errungenschaft für viele reale Spiele relevant Anwendungen. Beispielsweise können Kommunikationsbarrieren zwischen Menschen und KI-gesteuerten Agenten gemildert werden, indem die Erzeugung natürlicher Sprache durch Planung und RL gesteuert wird. Zum Beispiel sind die heutigen KI-Assistenten großartig darin, einfache Fragen zu beantworten, wie zum Beispiel das Wetter, aber was wäre, wenn sie ein langfristiges Gespräch führen könnten, um Ihnen etwas Neues beizubringen? Können? Was ist mit dem Ziel? Stellen Sie sich außerdem ein Videospiel vor, in dem NPCs wie Menschen planen und sprechen können – Ihre Beweggründe verstehen und den Dialog entsprechend anpassen, um Ihnen bei der Vollendung Ihrer Aufgabe, das Schloss zu stürmen, zu helfen. Diese „Träume“ könnten in Zukunft Wirklichkeit werden.

Erzeugen Sie natürliche, zielgerichtete Gespräche.

Nachteile

Lassen Sie „Diplomatie“ die Sandbox für die Mensch-KI-Interaktion vorantreiben

#🎜 🎜#

Das obige ist der detaillierte Inhalt vonDer neueste Meta-Agent ist ein meisterhafter Verhandlungsführer, der Verbündete gewinnt und die Herzen der Menschen versteht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

Um die Zeitüberschreitung für Vue Axios festzulegen, können wir eine Axios -Instanz erstellen und die Zeitleitungsoption angeben: in globalen Einstellungen: vue.Prototyp. $ Axios = axios.create ({Timeout: 5000}); In einer einzigen Anfrage: this. $ axios.get ('/api/user', {timeout: 10000}).

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der MySQL -Primärschlüssel kann nicht leer sein, da der Primärschlüssel ein Schlüsselattribut ist, das jede Zeile in der Datenbank eindeutig identifiziert. Wenn der Primärschlüssel leer sein kann, kann der Datensatz nicht eindeutig identifiziert werden, was zu Datenverwirrung führt. Wenn Sie selbstsinkrementelle Ganzzahlsspalten oder UUIDs als Primärschlüssel verwenden, sollten Sie Faktoren wie Effizienz und Raumbelegung berücksichtigen und eine geeignete Lösung auswählen.