Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Alumni der Shanghai Jiao Tong University gewannen den besten Beitrag und die Auszeichnungen für CoRL 2022, die wichtigste Robotikkonferenz, wurden bekannt gegeben

Alumni der Shanghai Jiao Tong University gewannen den besten Beitrag und die Auszeichnungen für CoRL 2022, die wichtigste Robotikkonferenz, wurden bekannt gegeben

Alumni der Shanghai Jiao Tong University gewannen den besten Beitrag und die Auszeichnungen für CoRL 2022, die wichtigste Robotikkonferenz, wurden bekannt gegeben

Seit der ersten Veranstaltung im Jahr 2017 hat sich CoRL zu einer der weltweit führenden akademischen Konferenzen an der Schnittstelle von Robotik und maschinellem Lernen entwickelt. CoRL ist eine eingleisige Konferenz für Roboterlernforschung, die mehrere Themen wie Robotik, maschinelles Lernen und Steuerung, einschließlich Theorie und Anwendungen, abdeckt.

Die CoRL-Konferenz 2022 findet vom 14. bis 18. Dezember in Auckland, Neuseeland, statt.

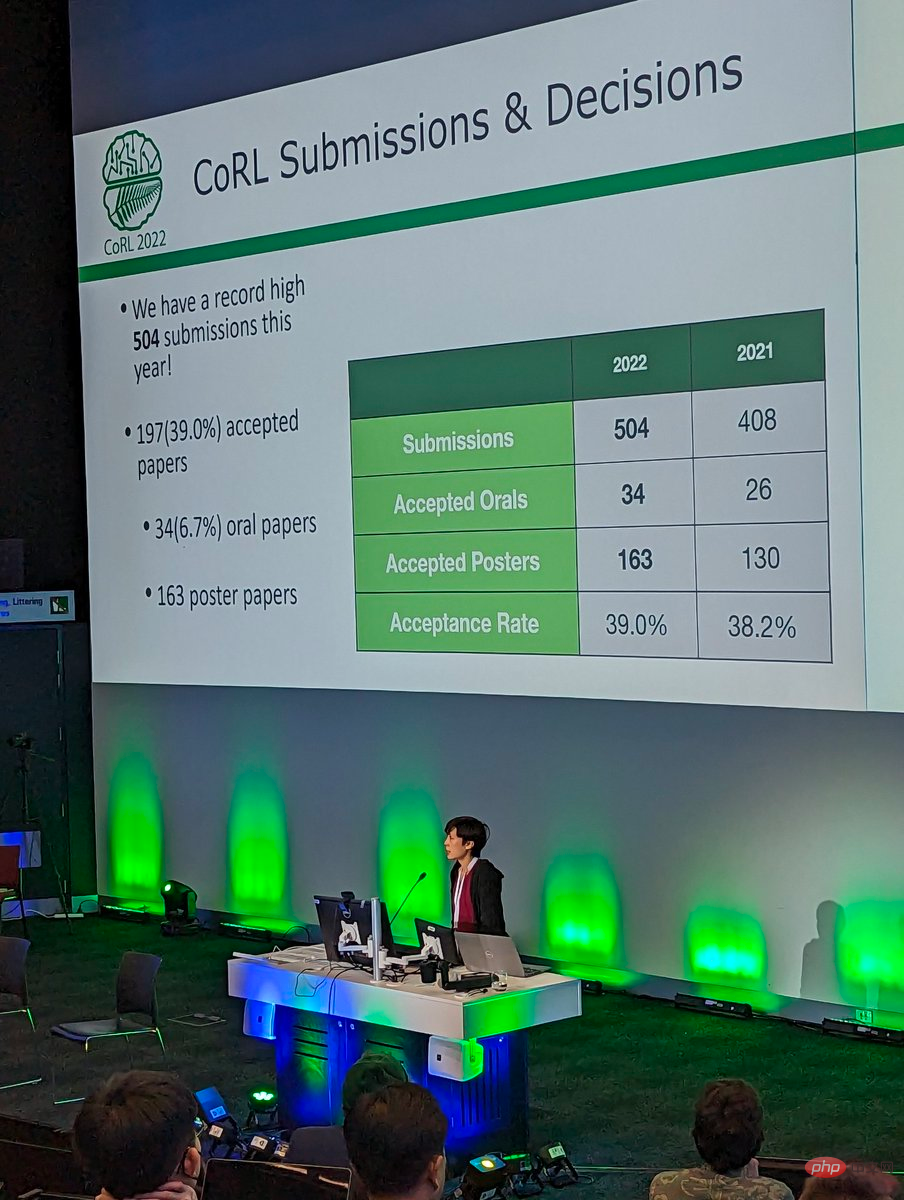

Diese Konferenz erhielt insgesamt 504 Einreichungen und nahm schließlich 34 mündliche Beiträge und 163 Posterbeiträge an, mit einer Annahmequote von 39 %.

Derzeit hat CoRL 2022 alle Auszeichnungen bekannt gegeben, darunter den Best Paper Award, den Best System Paper Award und den Special Innovation Award. Kun Huang, ein Master-Absolvent des GRASP Laboratory der University of Pennsylvania und Absolvent der Shanghai Jiao Tong University, gewann den Preis für den besten Beitrag der Konferenz.

Best Paper Award

Gewinner des Best Paper Award dieser Konferenz ist eine Studie der University of Pennsylvania.

- Papiertitel: Training Robots to Evaluate Robots: Beispielbasierte interaktive Belohnungsfunktionen für Policy Learning

- Autoren: Kun Huang, Edward Hu, Dinesh Jayaraman

- Link zum Papier: https://openreview.net/pdf?id=sK2aWU7X9b8 Die Studie legt nahe, dass dieses interaktive Verhalten automatisch erworben werden könnte, indem ein Roboter trainiert wird, die Ergebnisse seiner Versuche, die Fertigkeit auszuführen, auszuwerten. Diese Bewertungen wiederum dienen als IRFs (interaktive Belohnungsfunktionen), mit denen verstärkte Lernstrategien trainiert werden, um Zielfähigkeiten wie das Festziehen von Tischbeinen auszuführen. Darüber hinaus kann IRF als Verifizierungsmechanismus dienen, um die Ausführung von Online-Aufgaben auch nach Abschluss der vollständigen Schulung zu verbessern. Für jede gegebene Aufgabe ist das IRF-Training sehr praktisch und erfordert keine weiteren Spezifikationen.

Bewertungsergebnisse zeigen, dass IRF durch Zugriff auf Demos oder sorgfältig gestaltete Belohnungen erhebliche Leistungsverbesserungen erzielen und sogar die Ausgangswerte übertreffen kann. Im Bild unten muss der Roboter beispielsweise zuerst die Tür schließen und dann den symmetrischen Türgriff drehen, um die Tür vollständig zu verriegeln.

Beispieldemonstration für Türverriegelung

Der Zweck des folgenden Experiments besteht darin, drei optisch identische Blöcke zu einem stabilen Turm zu stapeln, wobei ein kleiner Block deutlich größer als die anderen beiden Blöcke ist Die beste Strategie besteht darin, es unten zu platzieren.

Stacked Evaluation Beispieldemonstration

Um die Robustheit und Allgemeingültigkeit des Algorithmus zu überprüfen, wurde er in dieser Studie in einem echten Roboter-Anziehexperiment mit einer D'Claw mit 9 Gelenken getestet. Der Zweck dieser Aufgabe besteht darin, das 4-Stift-Ventil um ca. 180° im Uhrzeigersinn in den festgezogenen Zustand zu drehen (weiße Linie auf der Ventilbasis).

Vorstellung an den Autor

Es gibt dieses Mal drei Autoren, die den CoRL 2022 Best Paper Award gewonnen haben, nämlich Kun Huang, Edward Hu und Dinesh Jayaraman.

Dinesh Jayaraman ist Assistenzprofessor am GRASP Laboratory der University of Pennsylvania. Er leitet die Forschungsgruppe Perception, Action, and Learning (PAL) und widmet sich der Forschung zu Schnittpunkten von Computer Vision, maschinellem Lernen und Robotik.

Kun Huang ist Meister des GRASP-Labors an der University of Pennsylvania und studiert Reinforcement Learning unter der Leitung von Professor Dinesh Jayaraman. Er erhielt seinen BS in Informatik von der University of Michigan, wo er zusammen mit Professor Dmitry Berenson an der Wahrnehmung von Robotern arbeitete. Kun Huang schloss sein Bachelor-Studium an der Shanghai Jiao Tong University ab. Seine Forschungsinteressen umfassen Robotik und reale Anwendungen. Kun Huang absolvierte während seines Masterstudiums ein Praktikum bei Waymo und wird nach seinem Abschluss als Ingenieur für maschinelles Lernen bei Cruise einsteigen.

Linkedin-Homepage: https://www.linkedin.com/in/kun-huang-620034171/

Edward S. Hu ist Doktorand im GRASP Laboratory der University of Pennsylvania unter der Aufsicht von Professor Dinesh Jayaraman. Zu seinen Forschungsschwerpunkten gehört modellbasiertes Reinforcement Learning. Edward erhielt seinen Master- und Bachelor-Abschluss in Informatik von der University of Southern California, wo er zusammen mit Professor Joseph J. Lim an Verstärkungs- und Nachahmungslernen bei Robotern arbeitete.

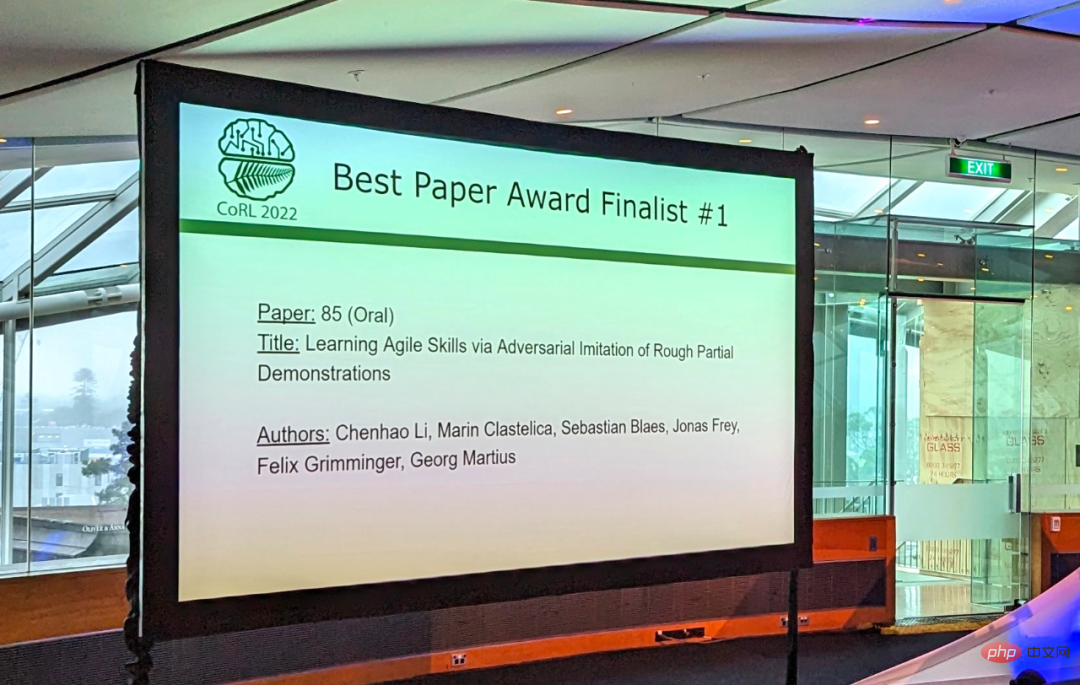

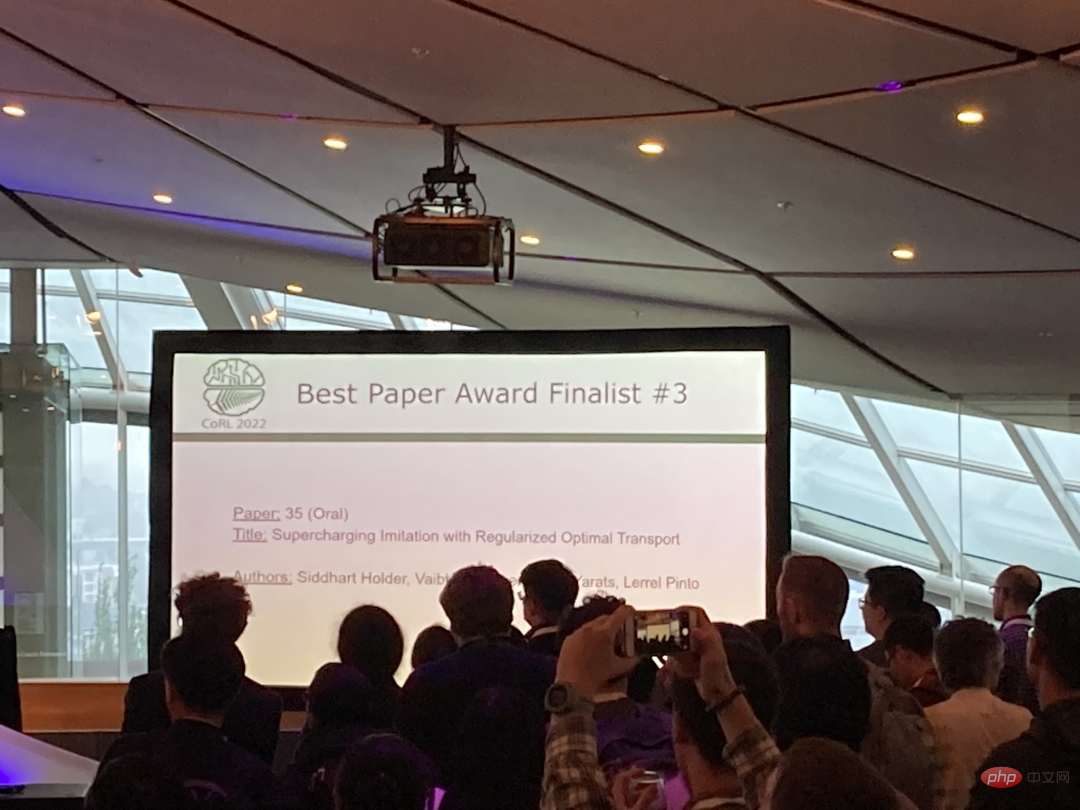

Best Paper Shortlist

Insgesamt 3 Beiträge wurden auf dieser Konferenz für den Best Paper Award nominiert. Mit Ausnahme des endgültigen Gewinnerbeitrags sind die anderen 2 Beiträge:

- Beitrag Titel: Erlernen agiler Fähigkeiten durch kontroverse Nachahmung rauer Teildemonstrationen

- Autoren: Chenhao Li, Marin Vlastelica, Sebastian Blaes, Jonas Frey, Felix Grimminger, Georg Martius

- Link zum Papier: https://arxiv.org/ pdf/2206.11693.pdf Link zum Papier: https://arxiv.org/pdf/2206.15469.pdf

Best System Paper Award

Best System Paper Award

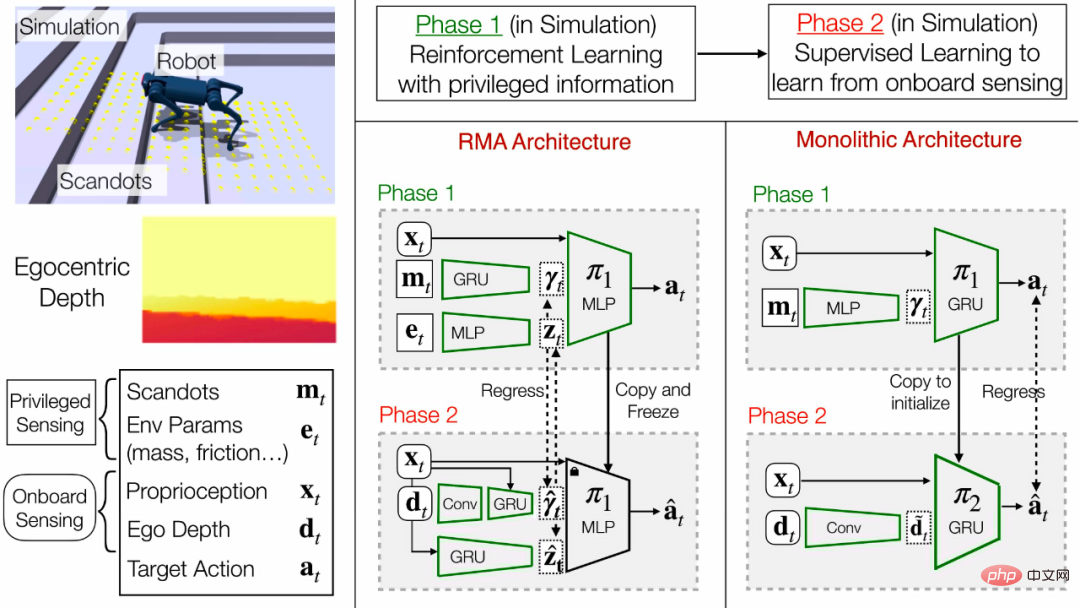

- Der Gewinner des Best System Paper Award auf dieser Konferenz ist eine Studie von CMU und UC Berkeley. : 题 Titel der Abschlussarbeit: Fortbewegung mit Beinen in anspruchsvollem Gelände MIT EGOCENTER VISION

- Autor: Ananye Agarwal, Ashish Kumar, Jitendra Malik, DEEPAK PATHAK

- Link zur Abschlussarbeit: https: // arxiv.org/pdf/2211.07638.pdf

Zusammenfassung:

Tiere sind in der Lage, ihre Sehkraft zu nutzen, um präzise und agile Bewegungen auszuführen, und die Nachahmung dieser Fähigkeit ist seit langem ein Ziel in der Robotik. Der traditionelle Ansatz besteht darin, das Problem in eine Phase der Höhenkartierung und der Planung von Stützpunkten zu unterteilen. Allerdings ist die Höhenkartierung anfällig für Störungen und großflächiges Rauschen, erfordert spezielle Hardware und ist biologisch nicht durchführbar.In diesem Artikel schlagen die Forscher das erste End-to-End-Fortbewegungssystem vor, das Treppen, Bordsteine, Trittsteine und Lücken überqueren kann, und demonstrieren es an einem mittelgroßen Vierbeinerroboter mit einer einzigen nach vorne gerichteten Tiefenkamera dieses Ergebnis erzielt. Aufgrund der geringen Größe des Roboters besteht die Notwendigkeit, spezielle Gangmuster zu entdecken, die anderswo nicht zu finden sind. Die Kamera muss die Strategie beherrschen, sich vergangene Informationen zu merken, um das Gelände dahinter und darunter abzuschätzen.

Die Forscher trainierten die Strategie des Roboters in einer simulierten Umgebung. Das Training ist in zwei Phasen unterteilt: Zuerst wird mithilfe von Reinforcement Learning eine Richtlinie für Deep-Image-Varianten mit geringem Rechenaufwand trainiert, und dann wird sie mithilfe von Deep Supervised Learning zu einer endgültigen Richtlinie verfeinert.

Die finale Strategie ist auf die reale Welt übertragbar und kann auf der begrenzten Rechenleistung des Roboters in Echtzeit ausgeführt werden. Es kann ein breites Spektrum von Geländen durchqueren und ist gleichzeitig robust gegenüber Störungen wie rutschigem Untergrund und felsigem Gelände.

Trittsteine und Lücken

Der Roboter kann in verschiedenen Konfigurationen über Barhocker steigen und die Schrittlänge anpassen, um große Lücken zu überbrücken. Da sich in der Nähe der Hinterfüße keine Kameras befinden, muss sich der Roboter die Position des Barhockers merken und seine Hinterfüße entsprechend platzieren.

Treppen und Bordsteine

Der Roboter kann Treppen bis zu einer Höhe von 24 cm und einer Breite von 30 cm erklimmen. Strategien gelten für verschiedene Treppen und Bordsteine unter verschiedenen Lichtverhältnissen. Auf ungleichmäßigen Treppenabständen bleibt der Roboter zunächst stecken, kann diese Hindernisse aber mit der Zeit durch sein Kletterverhalten überwinden.

Unstrukturiertes Gelände

Der Roboter kann unstrukturiertes Gelände durchqueren, das nicht in eine seiner Trainingskategorien fällt, was die Generalisierungsfähigkeiten des Systems demonstriert.

Bewegung im Dunkeln

Die Tiefenkamera projiziert mithilfe von Infrarotlicht Muster, um die Tiefe auch bei praktisch keinem Umgebungslicht genau abzuschätzen.

Robustheit

Die Strategie ist robust gegenüber hohen Kräften (Werfen eines 5-kg-Gewichts aus großer Höhe) und rutschigen Oberflächen (auf eine Plastikfolie gegossenes Wasser). In dieser Studie gibt es vier Autoren.

Jitendra Malik ist derzeit Arthur J. Chick-Professor am Fachbereich Elektrotechnik und Informatik an der UC Berkeley. Zu seinen Forschungsgebieten gehören Computer Vision, Computermodellierung des menschlichen Sehens, Computergrafik und biologische Bildanalyse.

Jitendra Malik ist derzeit Arthur J. Chick-Professor am Fachbereich Elektrotechnik und Informatik an der UC Berkeley. Zu seinen Forschungsgebieten gehören Computer Vision, Computermodellierung des menschlichen Sehens, Computergrafik und biologische Bildanalyse.

Einer der Autoren dieser preisgekrönten Studie, Ashish Kumar, ist sein Doktorand. Deepak Pathak ist derzeit Assistenzprofessor an der Carnegie Mellon University. Er erhielt seinen Doktortitel von der University of California, Berkeley und seine Forschungsthemen umfassen maschinelles Lernen, Robotik und Computer Vision.

Ananye Agarwal, eine der Autoren dieser preisgekrönten Studie, ist seine Doktorandin.

Darüber hinaus hat Deepak Pathak eine weitere Forschung auf der Shortlist für den Best System Paper Award dieser Konferenz.

- Titel des Papiers: Deep Whole-Body Control: Learning a Unified Policy for Manipulation and Locomotion

- Autoren: Zipeng Fu, Xuxin Cheng, Deepak Pathak

- Link zum Papier: https://arxiv.org/abs /2210.10044

Spezieller Innovationspreis

Diese Konferenz hat auch einen besonderen Innovationspreis verliehen. Diese Forschung wurde gemeinsam von vielen Forschern von Google durchgeführt.

- Titel des Papiers: Do As I Can, Not As I Say: Grounding Language in Robotic Affordances

- Autoren: Brian Ichter, Anthony Brohan, Michael Ahn usw.

- Link zum Papier: https: //arxiv.org/pdf/2204.01691.pdf

Zusammenfassung des Papiers:Große Sprachmodelle können eine große Menge an semantischem Wissen über die Welt kodieren, und dieses Wissen ist für Roboter sehr nützlich. Allerdings haben Sprachmodelle den Nachteil, dass sie keine Erfahrung mit der realen Welt haben, was es schwierig macht, Semantik zu nutzen, um Entscheidungen für eine bestimmte Aufgabe zu treffen.

Forscher von Google schlagen vor, eine reale Grundlage für große Sprachmodelle zu schaffen, indem vorab trainierte Fähigkeiten verwendet werden, um das Modell darauf zu beschränken, natürliche Sprachoperationen zu entwickeln, die sowohl machbar als auch kontextuell angemessen sind. Roboter können als „Hände und Augen“ von Sprachmodellen dienen, die hochgradiges semantisches Wissen über die Aufgabe liefern. Diese Studie zeigt, wie Fertigkeiten auf niedrigem Niveau mit großen Sprachmodellen kombiniert werden können, sodass das Sprachmodell hochstufiges Wissen über die Prozesse liefert, die komplexe und zeitintensive Anweisungen ausführen, während die mit diesen Fertigkeiten verbundenen Wertfunktionen die Möglichkeit bieten, eine Verbindung herzustellen dieses Wissen auf spezifische physikalische Umgebungen zu übertragen.

Die Forscher nutzten dieses Prinzip, als sie ein großes Sprachmodell (LLM) mit den physischen Aufgaben des Roboters kombinierten: Neben der einfachen Interpretation einer Anweisung durch das LLM kann es auch zur Bewertung einer einzelnen Aktion zur Vervollständigung der gesamten Chancen verwendet werden Sind fortgeschrittene Anweisungen hilfreich? Einfach ausgedrückt kann jede Aktion eine Sprachbeschreibung haben, und wir können das Prompt-Sprachmodell verwenden, um diese Aktionen bewerten zu lassen. Wenn jede Aktion über eine entsprechende Affordance-Funktion verfügt, ist es darüber hinaus möglich, ihre Erfolgswahrscheinlichkeit anhand des aktuellen Zustands (z. B. einer Lernwertfunktion) zu quantifizieren. Das Produkt zweier Wahrscheinlichkeitswerte ist die Wahrscheinlichkeit, dass der Roboter eine für die Anweisung hilfreiche Aktion erfolgreich abschließen kann. Sortieren Sie eine Reihe von Aktionen nach dieser Wahrscheinlichkeit und wählen Sie die Aktion mit der höchsten Wahrscheinlichkeit aus.

Das folgende Beispiel zeigt einen Roboter, der beim Aufheben eines Apfels hilft:

Das obige ist der detaillierte Inhalt vonAlumni der Shanghai Jiao Tong University gewannen den besten Beitrag und die Auszeichnungen für CoRL 2022, die wichtigste Robotikkonferenz, wurden bekannt gegeben. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

Der Ameca der zweiten Generation ist da! Er kann fließend mit dem Publikum kommunizieren, sein Gesichtsausdruck ist realistischer und er kann Dutzende Sprachen sprechen.

Mar 04, 2024 am 09:10 AM

Der Ameca der zweiten Generation ist da! Er kann fließend mit dem Publikum kommunizieren, sein Gesichtsausdruck ist realistischer und er kann Dutzende Sprachen sprechen.

Mar 04, 2024 am 09:10 AM

Der humanoide Roboter Ameca wurde auf die zweite Generation aufgerüstet! Kürzlich erschien auf der World Mobile Communications Conference MWC2024 erneut der weltweit fortschrittlichste Roboter Ameca. Rund um den Veranstaltungsort lockte Ameca zahlreiche Zuschauer an. Mit dem Segen von GPT-4 kann Ameca in Echtzeit auf verschiedene Probleme reagieren. „Lass uns tanzen.“ Auf die Frage, ob sie Gefühle habe, antwortete Ameca mit einer Reihe von Gesichtsausdrücken, die sehr lebensecht aussahen. Erst vor wenigen Tagen stellte EngineeredArts, das britische Robotikunternehmen hinter Ameca, die neuesten Entwicklungsergebnisse des Teams vor. Im Video verfügt der Roboter Ameca über visuelle Fähigkeiten und kann den gesamten Raum und bestimmte Objekte sehen und beschreiben. Das Erstaunlichste ist, dass sie es auch kann

Wie kann KI Roboter autonomer und anpassungsfähiger machen?

Jun 03, 2024 pm 07:18 PM

Wie kann KI Roboter autonomer und anpassungsfähiger machen?

Jun 03, 2024 pm 07:18 PM

Im Bereich der industriellen Automatisierungstechnik gibt es zwei aktuelle Hotspots, die kaum zu ignorieren sind: Künstliche Intelligenz (KI) und Nvidia. Ändern Sie nicht die Bedeutung des ursprünglichen Inhalts, optimieren Sie den Inhalt, schreiben Sie den Inhalt neu, fahren Sie nicht fort: „Darüber hinaus sind beide eng miteinander verbunden, da Nvidia nicht auf seine ursprüngliche Grafikverarbeitungseinheit (GPU) beschränkt ist ) erweitert es seine GPU. Die Technologie erstreckt sich auf den Bereich der digitalen Zwillinge und ist eng mit neuen KI-Technologien verbunden. „Vor kurzem hat NVIDIA eine Zusammenarbeit mit vielen Industrieunternehmen geschlossen, darunter führende Industrieautomatisierungsunternehmen wie Aveva, Rockwell Automation und Siemens und Schneider Electric sowie Teradyne Robotics und seine Unternehmen MiR und Universal Robots. Kürzlich hat Nvidia gesammelt

Nach 2 Monaten kann der humanoide Roboter Walker S Kleidung falten

Apr 03, 2024 am 08:01 AM

Nach 2 Monaten kann der humanoide Roboter Walker S Kleidung falten

Apr 03, 2024 am 08:01 AM

Herausgeber des Machine Power Report: Wu Xin Die heimische Version des humanoiden Roboters + eines großen Modellteams hat zum ersten Mal die Betriebsaufgabe komplexer flexibler Materialien wie das Falten von Kleidung abgeschlossen. Mit der Enthüllung von Figure01, das das multimodale große Modell von OpenAI integriert, haben die damit verbundenen Fortschritte inländischer Kollegen Aufmerksamkeit erregt. Erst gestern veröffentlichte UBTECH, Chinas „größter Bestand an humanoiden Robotern“, die erste Demo des humanoiden Roboters WalkerS, der tief in das große Modell von Baidu Wenxin integriert ist und einige interessante neue Funktionen aufweist. Jetzt sieht WalkerS, gesegnet mit Baidu Wenxins großen Modellfähigkeiten, so aus. Wie Figure01 bewegt sich WalkerS nicht umher, sondern steht hinter einem Schreibtisch, um eine Reihe von Aufgaben zu erledigen. Es kann menschlichen Befehlen folgen und Kleidung falten

Der erste Roboter erscheint, der menschliche Aufgaben autonom erledigt, mit fünf flexiblen Fingern und übermenschlicher Geschwindigkeit, und große Modelle unterstützen das Training im virtuellen Raum

Mar 11, 2024 pm 12:10 PM

Der erste Roboter erscheint, der menschliche Aufgaben autonom erledigt, mit fünf flexiblen Fingern und übermenschlicher Geschwindigkeit, und große Modelle unterstützen das Training im virtuellen Raum

Mar 11, 2024 pm 12:10 PM

Diese Woche gab FigureAI, ein Robotikunternehmen, an dem OpenAI, Microsoft, Bezos und Nvidia beteiligt sind, bekannt, dass es fast 700 Millionen US-Dollar an Finanzmitteln erhalten hat und plant, im nächsten Jahr einen humanoiden Roboter zu entwickeln, der selbstständig gehen kann. Und Teslas Optimus Prime hat immer wieder gute Nachrichten erhalten. Niemand zweifelt daran, dass dieses Jahr das Jahr sein wird, in dem humanoide Roboter explodieren. SanctuaryAI, ein in Kanada ansässiges Robotikunternehmen, hat kürzlich einen neuen humanoiden Roboter auf den Markt gebracht: Phoenix. Beamte behaupten, dass es viele Aufgaben autonom und mit der gleichen Geschwindigkeit wie Menschen erledigen kann. Pheonix, der weltweit erste Roboter, der Aufgaben autonom in menschlicher Geschwindigkeit erledigen kann, kann jedes Objekt sanft greifen, bewegen und elegant auf der linken und rechten Seite platzieren. Es kann Objekte autonom identifizieren

Zehn humanoide Roboter gestalten die Zukunft

Mar 22, 2024 pm 08:51 PM

Zehn humanoide Roboter gestalten die Zukunft

Mar 22, 2024 pm 08:51 PM

Die folgenden 10 humanoiden Roboter prägen unsere Zukunft: 1. ASIMO: ASIMO wurde von Honda entwickelt und ist einer der bekanntesten humanoiden Roboter. Mit einer Höhe von 1,20 m und einem Gewicht von 50 kg ist ASIMO mit fortschrittlichen Sensoren und künstlichen Intelligenzfunktionen ausgestattet, die es ihm ermöglichen, sich in komplexen Umgebungen zurechtzufinden und mit Menschen zu interagieren. Aufgrund seiner Vielseitigkeit eignet sich ASIMO für eine Vielzahl von Aufgaben, von der Unterstützung von Menschen mit Behinderungen bis hin zur Durchführung von Präsentationen bei Veranstaltungen. 2. Pepper: Pepper wurde von Softbank Robotics entwickelt und möchte ein sozialer Begleiter für Menschen sein. Mit seinem ausdrucksstarken Gesicht und der Fähigkeit, Emotionen zu erkennen, kann Pepper an Gesprächen teilnehmen, im Einzelhandel helfen und sogar pädagogische Unterstützung leisten. Pfeffer

Der Kehr- und Wischroboter Cloud Whale Xiaoyao 001 hat ein „Gehirn'! |. Erfahrung

Apr 26, 2024 pm 04:22 PM

Der Kehr- und Wischroboter Cloud Whale Xiaoyao 001 hat ein „Gehirn'! |. Erfahrung

Apr 26, 2024 pm 04:22 PM

Kehr- und Wischroboter gehören in den letzten Jahren zu den beliebtesten Smart-Home-Geräten bei Verbrauchern. Die damit verbundene Bequemlichkeit der Bedienung oder sogar die Notwendigkeit einer Bedienung ermöglicht es faulen Menschen, ihre Hände frei zu haben, was es den Verbrauchern ermöglicht, sich von der täglichen Hausarbeit zu „befreien“ und mehr Zeit mit den Dingen zu verbringen, die sie in getarnter Form genießen. Aufgrund dieser Begeisterung stellen fast alle Haushaltsgerätemarken auf dem Markt ihre eigenen Kehr- und Wischroboter her, was den gesamten Markt für Kehr- und Wischroboter sehr lebendig macht. Allerdings wird die schnelle Expansion des Marktes unweigerlich eine versteckte Gefahr mit sich bringen: Viele Hersteller werden die Taktik des Maschinenmeeres nutzen, um schnell mehr Marktanteile zu erobern, was zu vielen neuen Produkten ohne Upgrade-Punkte führen wird Es handelt sich um „Matroschka“-Modelle. Keine Übertreibung. Allerdings sind das nicht alle Kehr- und Wischroboter

Der humanoide Roboter kann zaubern. Lassen Sie das Programmteam der Frühlingsfest-Gala mehr erfahren

Feb 04, 2024 am 09:03 AM

Der humanoide Roboter kann zaubern. Lassen Sie das Programmteam der Frühlingsfest-Gala mehr erfahren

Feb 04, 2024 am 09:03 AM

Roboter haben im Handumdrehen gelernt, zu zaubern? Es war zu sehen, dass es zuerst den Wasserlöffel auf dem Tisch aufhob und damit dem Publikum bewies, dass nichts darin war ... Dann nahm es den eiähnlichen Gegenstand in seine Hand und stellte den Wasserlöffel zurück auf den Tisch und begann „einen Zauber zu wirken“... …Gerade als es den Wasserlöffel wieder aufhob, geschah ein Wunder. Das ursprünglich hineingelegte Ei verschwand und das Ding, das heraussprang, verwandelte sich in einen Basketball ... Schauen wir uns noch einmal die fortlaufenden Aktionen an: △ Diese Animation zeigt eine Reihe von Aktionen mit doppelter Geschwindigkeit und läuft nur durch Zuschauen reibungslos ab Das Video kann wiederholt mit 0,5-facher Geschwindigkeit verstanden werden. Schließlich habe ich die Hinweise entdeckt: Wenn meine Handgeschwindigkeit schneller wäre, könnte ich es möglicherweise vor dem Feind verbergen. Einige Internetnutzer beklagten, dass die magischen Fähigkeiten des Roboters sogar noch höher seien als ihre eigenen: Mag war derjenige, der diese Magie für uns ausgeführt hat.