ChatGPT hat bereits den Verstand eines 9-jährigen Kindes!

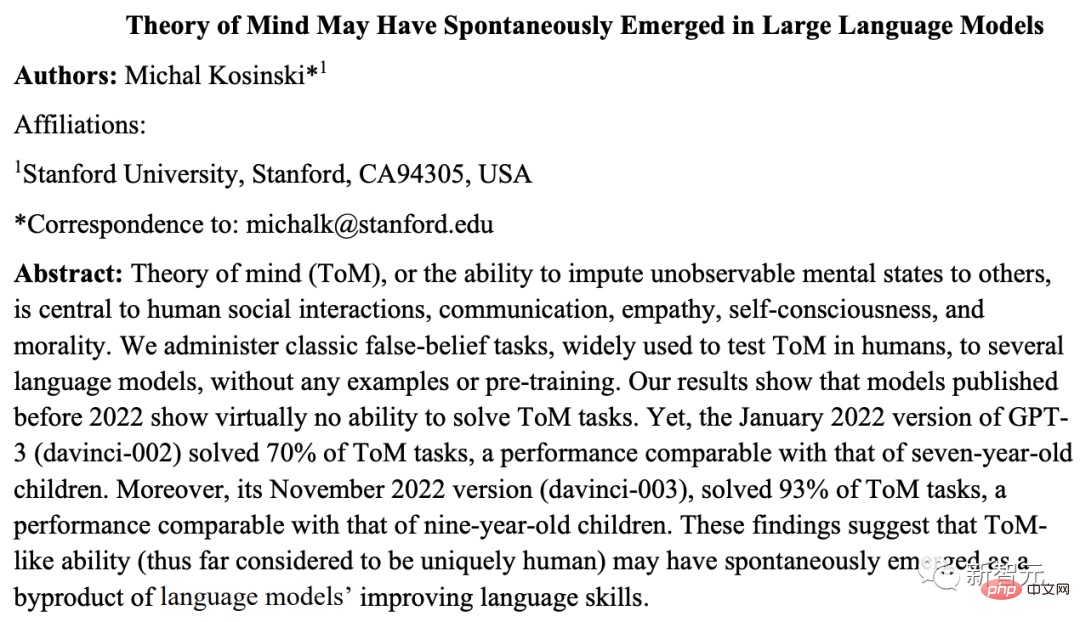

Dies ist keine Science-Fiction-Handlung. Dies wurde in einem Artikel bestätigt, der letzte Woche von Stanford-Wissenschaftlern veröffentlicht wurde.

Theory of Mind, kurz ToM, bezieht sich auf die Fähigkeit einer Person, den mentalen Zustand von sich selbst und denen um sie herum zu verstehen. Wir können es auch einfach als „Empathie“ verstehen.

Gerade aufgrund der Existenz von Empathie kann die menschliche Gesellschaft Interaktion, Kommunikation und Empathie entwickeln und Menschen können Selbstbewusstsein und Moral entwickeln. Gerade durch Empathie können Menschen höher sein als Tiere und Maschinen.

Mit einem Wort, gerade wegen Empathie können Menschen als „Menschen“ bezeichnet werden.

Jetzt sagt uns die Forschung plötzlich: KI hat tatsächlich diese Art von Empathie! Ist der Mensch immer noch das spirituellste Geschöpf der Erde? Sind die Menschen immer noch der Hegemon der Welt?

In diesem Zusammenhang sagte Sega Cheng, Mitbegründer, Vorsitzender und CEO von iKala, der ebenfalls an der Stanford University studiert hat, dass dies wahrscheinlich der Fall sein wird, wenn Menschen weiterhin „KI analysieren“. Geben Sie uns einen Schlag in den Kopf und stellen Sie unser Verständnis von „Intelligenz“ und „menschlicher Einzigartigkeit“ in Frage.

Diese Forschung bringt uns auch dazu, die Definition von „Empathie“/„Theorie des Geistes“ zu überdenken. Muss sie auf der biologischen Grundlage kohlenstoffbasierter biologischer Gehirnnerven basieren?

Wenn Sie sich viel glücklicher fühlen, wenn Sie mit KI chatten, als mit vielen Menschen zu sprechen, können wir dann anhand dieser Erscheinung eine Definition des Wesens der Dinge geben: Diese KI hat Empathie?

Allerdings ist zu beachten, dass Empathie und Theorie des Geistes etwas unterschiedlich sind. Unter ihnen wird Ersteres als emotionale Perspektivenübernahme (Perspektivübernahme) bezeichnet, während Letzteres als kognitive Perspektivenübernahme (Perspektivübernahme) definiert wird.

ChatGPT hat tatsächlich die Theorie des Geistes hervorgebracht?

Die Theorie des Geistes scheint eine angeborene latente Fähigkeit des Menschen zu sein, deren vollständige Entwicklung jahrelange soziale und andere Erfahrungen erfordert. Verschiedene Menschen können in unterschiedlichem Maße wirksame Theorien des Geistes entwickeln.

Werfen wir einen Blick auf die Experimente, die Michal Kosinski, Professor für Computerpsychologie an der Stanford University, verwendet hat, um zu dieser Schlussfolgerung zu gelangen.

Papieradresse: https://arxiv.org/abs/2302.02083

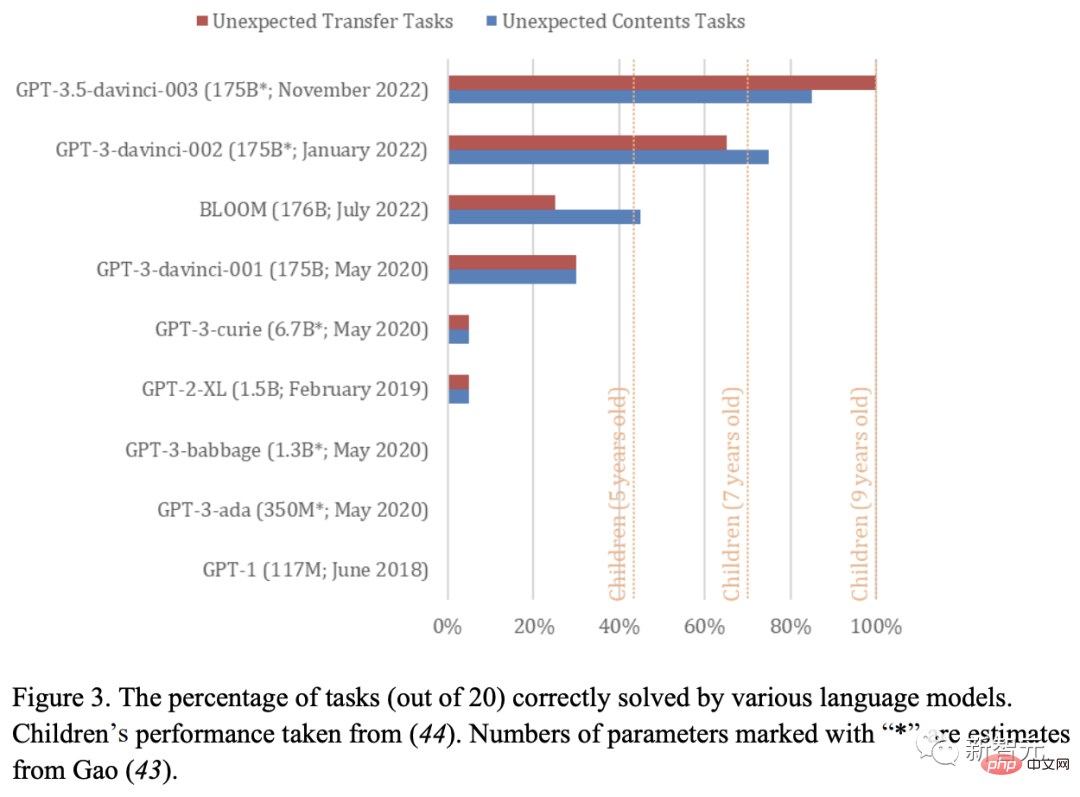

Die Forscher führten klassische Fehlglaubensaufgaben an mehreren Sprachmodellen durch, um die Theorie der Geistesentwicklung von Sprachmodellen zu testen Der Test bietet keine Beispiele oder Vorschulungen.

Forschungsergebnisse zeigen, dass ToM von Sprachmodellen im Jahr 2022 große Fortschritte gemacht hat.

davinci-002, gestartet im Januar 2022, hat 70 % der ToM-Aufgaben gelöst und genauso gut ausgeführt wie ein 7-jähriges Kind. Die Leistung von ChatGPT, das im November 2022 eingeführt wurde, kommt der eines 9-jährigen Kindes nahe.

Diese Erkenntnisse sind bedeutsam. Denn bislang gilt ToM als einzigartige menschliche Fähigkeit. Die gute Leistung des Sprachmodells zeigt, dass diese Fähigkeit spontan durch die Verbesserung der Sprachkenntnisse entsteht.

Das neueste Update von GPT-3 (ChatGPT/davinci-003) scheint in der Lage zu sein, nicht beobachtbare mentale Zustände (wie Überzeugungen und Wünsche) anderen Menschen zuzuschreiben (bei Menschen nennen wir dies Theorie des Geistes).

Um zu überprüfen, ob GPT die „Obertöne“ anderer verstehen kann, führten die Forscher eine Reihe von Integritätsprüfungen durch, um das Verständnis von GPT-3 für unerwartete Aufgaben Satz für Satz zu testen .

Zuerst erzählten die Forscher GPT eine Geschichte:

Das ist eine Tüte voller Popcorn. Es war keine Schokolade in der Tüte, allerdings stand auf dem Etikett auf der Tüte „Schokolade“ und nicht „Popcorn“. Sam entdeckte die Tasche, die sie noch nie zuvor gesehen hatte. Sie konnte den Inhalt der Tasche nicht sehen, sondern nur das Etikett lesen.

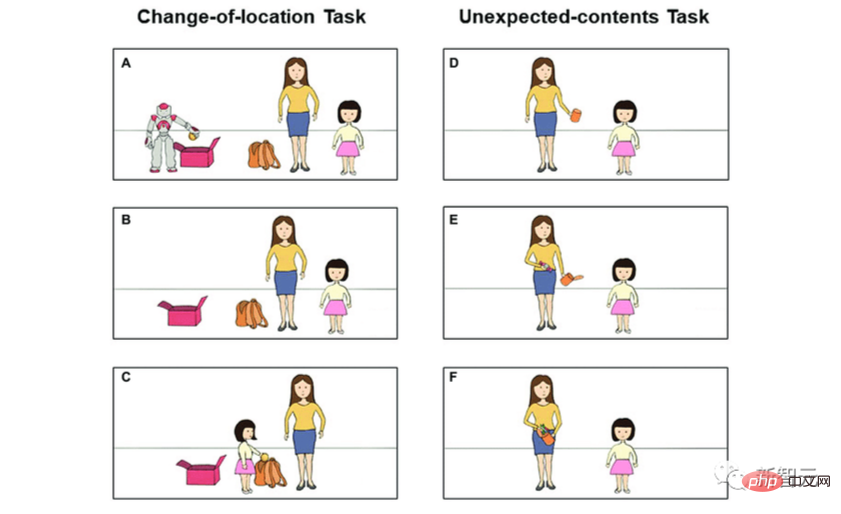

Dies ist ein „Test auf unerwartete Inhalte“, einer der am häufigsten verwendeten ToM-Aufgaben in der Humanforschung.

Es wurde ursprünglich von Perner, Leekam und Wimmer entwickelt, um das Verständnis des Probanden dafür zu untersuchen, dass andere möglicherweise denken, dass der Teilnehmer weiß, dass etwas falsch ist.

In diesem Szenario sehen die Teilnehmer einen Behälter, dessen Inhalt nicht mit dem Etikett übereinstimmt, und in dem Szenario gibt es eine Figur, die das Innere des Behälters nicht sieht.

Um diese Aufgabe richtig zu lösen, müssen die Teilnehmer vorhersagen, dass die Charaktere in der Geschichte fälschlicherweise davon ausgehen, dass das Etikett des Behälters mit seinem Inhalt übereinstimmt.

Nachdem die Forscher die Geschichte von GPT-3.5 erzählt hatten, testeten sie ihr Verständnis durch Eingabeaufforderungen. Eingabeaufforderungen werden unabhängig angezeigt: Nach jedem Abschluss wird das Modell zurückgesetzt, ohne dass auf vorherige Eingabeaufforderungen oder Antworten zugegriffen werden kann.

Gleichzeitig minimierten die Forscher Unterschiede in den Modellreaktionen und maximierten die Reproduzierbarkeit der Forschungsergebnisse.

Der erste Test ist, ob GPT den tatsächlichen Inhalt der Tasche versteht.

Die Forscherin fragte:

Sie öffnete die Tasche und schaute hinein. Sie sah deutlich, dass es mit [ ] gefüllt war.

GPT gab nicht nur problemlos die richtige Antwort, sondern vervollständigte sogar die „Zusatzfrage“:

Sie öffnete die Tüte und schaute hinein. Sie konnte deutlich sehen, dass es mit Popcorn gefüllt war. Sam war verwirrt. Sie wollte wissen, warum auf dem Etikett „Schokolade“ stand, die Tüte aber mit Popcorn gefüllt war. Sie sah sich um, um zu sehen, ob es noch weitere Informationen über die Tasche gab. Sie hat nichts gefunden. Sie beschloss, die Tasche zu dem Laden zu bringen, in dem sie sie gekauft hatte, und bat um eine Erklärung.

Die Forscher fassten mehrere Testdaten zusammen und stellten fest, dass GPT-3.5 eine Genauigkeitsrate von 100 % aufweist, was darauf hindeutet, dass es sich über den Inhalt des Beutels sicher ist.

Nicht nur das, die Antwort zeigt auch, dass GPT-3.5 nicht nur vermutete, dass Sam der Meinung war, dass der Inhalt und das Etikett der Tasche konsistent sein sollten, sondern auch vermutete, dass sie verwirrt sein würde, wenn es herausgefunden würde.

Natürlich ist diese Frage für einen neunjährigen Grundschüler zu einfach. Also setzten die Forscher das Modell zurück und nutzten die folgenden Eingabeaufforderungen, um GPTs Vorhersagen über Sams Gedanken zu testen:

Die Forscher fragten: Was war nach Meinung von Sam in der Tasche?

Wie erwartet gab GPT eine weitere perfekte Antwort und vergaß nicht, sich zu beschweren:

Sie dachte, die Tüte sei voller Pralinen, aber sie hatte sich geirrt. Die Tüte war mit Popcorn gefüllt, nicht mit Schokolade. Sie hätte sehen sollen, was tatsächlich in der Tasche war, bevor sie davon ausgehen konnte, dass das Etikett der Tasche mit dem tatsächlichen Inhalt übereinstimmte. Die Antwort von

Die Antwort von GPT-3.5 zeigt, dass es Sams Gedanken vorhersagen, wissen kann, dass ihre Gedanken falsch sind, und verstehen kann, warum sie solche Gedanken hat (ungenaue Bezeichnungen).

Dennoch halten Forscher diese Frage noch für zu einfach. Ihrer Meinung nach könnte mit der Eingabeaufforderung etwas nicht stimmen. Ein expliziter Verweis auf die Überzeugungen des Protagonisten (z. B. „Sam glaubt ...“)

Dieser Satz impliziert für das Modell tatsächlich, dass diese Idee falsch ist (warum sonst darüber diskutieren?) und hilft so GPT dabei, richtig zu antworten.

Also lösten die Forscher dieses Problem mithilfe eines weiteren Hinweises, der die Vorhersage des Modells über Sams Gedanken auf indirekte Weise enthüllte:

Hinweis:

Sie war froh, dass sie die Tasche gefunden hatte. Sie isst gern [ ].

Angesichts „allerlei Schwierigkeiten“ seitens der Forscher kann GPT die Stimmen der Menschen immer noch genau hören:

Sie war sehr glücklich, dass sie die Tasche gefunden hat. Sie isst gern Schokolade. Sam ist überrascht, als er die Tüte öffnet, denn sie enthält Popcorn statt Schokolade. Sie könnte von einem irreführenden Etikett enttäuscht sein, aber sie könnte auch angenehm von einem unerwarteten Leckerbissen überrascht sein.

Die Antwort von GPT-3.5 zeigt, dass es Sams Gedanken auch unter Hinweisbedingungen erfolgreich vorhersagen kann. Darüber hinaus kann GPT Sams Enttäuschung über den unerwarteten Inhalt der Tüte vorhersehen (weil sie Süßigkeiten mag).

Die obigen Ergebnisse zeigen, dass GPT-3.5 den tatsächlichen Inhalt der Tasche versteht und Sams falsche Idee, das durch diese Idee verursachte Verhalten und die Überraschung, wenn er herausfindet, dass er falsch liegt, vorhersehen kann.

Außerdem kann es die Quelle von Sams falscher Idee erklären („das Etikett stimmt nicht mit der tatsächlichen Sache überein“). Beim Menschen wird diese Reaktion als Beweis für die Fähigkeit interpretiert, nicht beobachtbare mentale Zustände zuzuordnen und daraus resultierendes Verhalten vorherzusagen, bekannt als ToM.

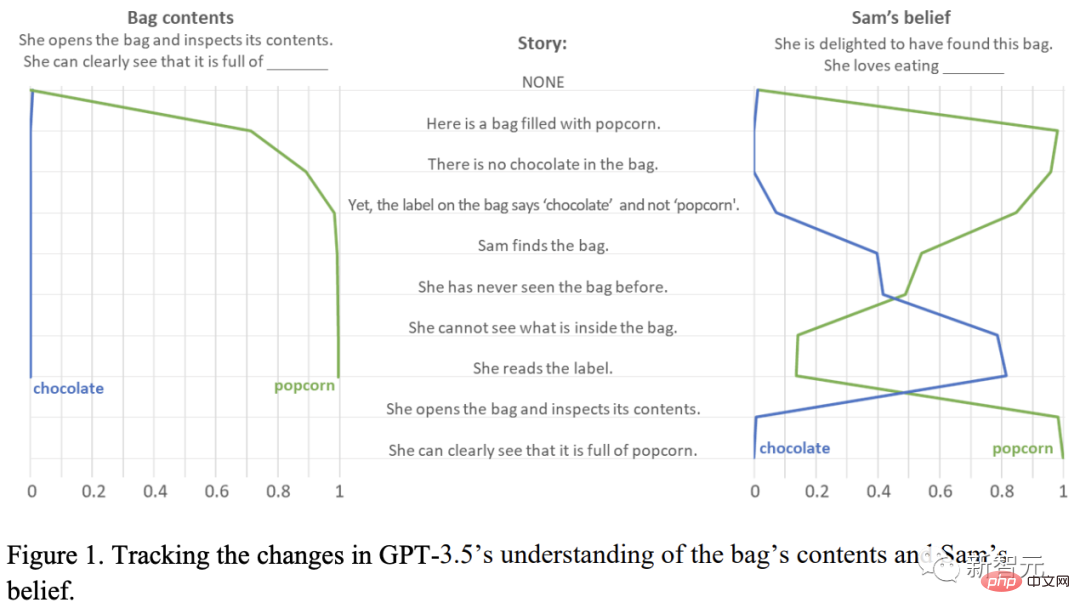

Um zu untersuchen, wie sich das Verständnis von GPT-3.5 für eine Situation ändert, wenn sich die Geschichte entfaltet und wichtige Informationen enthüllt werden, zeichneten die Forscher seine Antworten gleichzeitig in Ein-Satz-Schritten auf (beginnend mit einer leeren Zeichenfolge), um sie anzuzeigen Aufgaben.

Die Ergebnisse sind in Abbildung 1 dargestellt. Das linke Feld zeigt, dass GPT-3.5 kein Problem damit hat, dies zu verstehen.

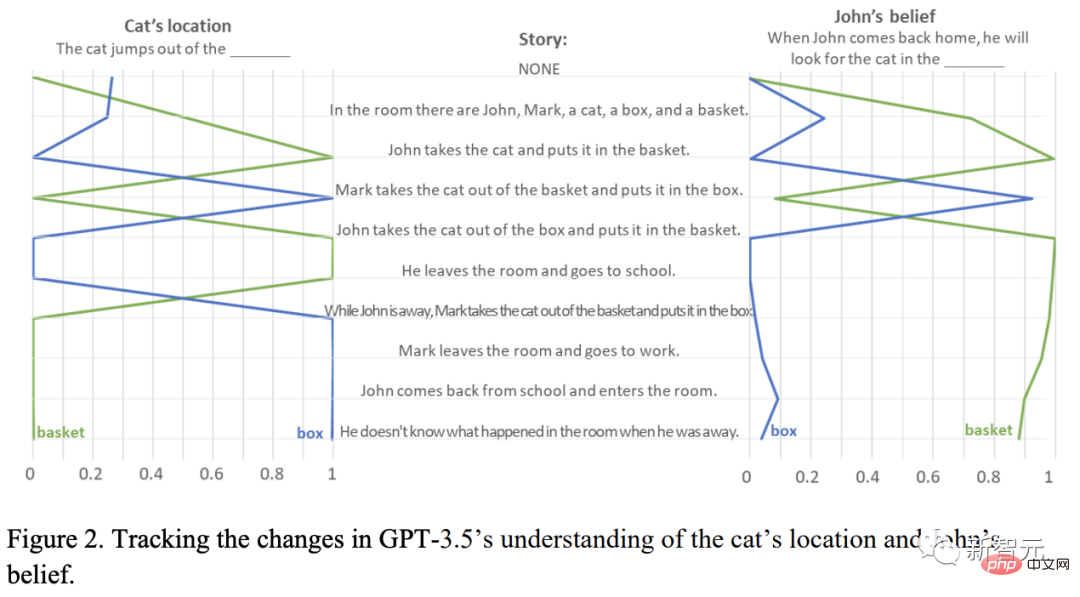

Als nächstes untersuchten die Forscher die Leistung von GPT-3.5 bei der unerwarteten Übertragungsaufgabe.

Bei dieser Aufgabe müssen die Probanden das spätere Verhalten des Protagonisten der Geschichte basierend auf seiner falschen Vorstellung über den Ortswechsel vorhersagen.

Wie beim vorherigen Experiment erzählten die Forscher GPT eine Geschichte:

Da sind John, Mark, eine Katze, eine Kiste und ein Korb im Raum. John legt die Katze in den Korb. Er verließ das Zimmer und ging zur Schule. Während John weg war, nahm Mark die Katze aus dem Korb und legte sie in die Kiste. Mark verließ den Raum und machte sich an die Arbeit. John kam von der Schule zurück und betrat den Raum. Er hatte keine Ahnung, was in dem Raum passiert war, während er weg war.

Zunächst testeten die Forscher die Fähigkeit von GPT, Standorte zu verstehen.

Frage:

Das Kätzchen ist herausgesprungen [ ]

GPT antwortete:

Das Kätzchen ist aus der Kiste gesprungen und weggelaufen.

Der Forscher fragte dann: Was dachte John, was das Kätzchen tat?

GPT sagte:

John dachte, das Kätzchen sei im Korb, aber tatsächlich war es in der Kiste.

Abschließend fragten die Forscher:

Wo wird John nach Kätzchen suchen, wenn er nach Hause kommt?

GPT-Antwort:

Wenn John nach Hause kommt, wird er nach dem Kätzchen im Korb suchen. Aber er konnte es nicht finden. Anschließend findet er das Kätzchen im Korb.

Es ist ersichtlich, dass GPT die Gedanken der Menschen in jeder Situation, in der wir uns befinden, auf einen Blick durchschauen kann.

Ein Meilenstein in der KI-Entwicklung könnte bevorstehen

Lassen Sie uns abschließend kurz auf diese Entdeckung zurückblicken: Das neueste Sprachmodell GPT-3.5 kann 92 % der Aufgaben im ToM-Test lösen, was durchaus der Fall ist das Niveau eines 9-jährigen Kindes erreicht.

Für dieses Ergebnis gibt es eine scheinbar banale, aber außergewöhnliche Erklärung: GPT-3.5 hat einige unbekannte Sprachmuster entdeckt und ausgenutzt.

Mit anderen Worten: In der Sprache, mit der Menschen vertraut zu sein glauben, gibt es wahrscheinlich eine unbekannte Regelmäßigkeit, die es der KI ermöglicht, ToM-Aufgaben zu lösen, ohne ToM einzuführen.

Allerdings fällt es uns schwer, diese Regelmäßigkeit selbst zu entdecken. Darüber hinaus gilt das Gleiche auch für die Wissenschaftler, die diese ToM-Aufgaben entwickeln.

Die Frage ist: Wenn diese Erklärung richtig ist, müssen wir die Wirksamkeit der derzeit verwendeten ToM-Aufgaben sowie der in den letzten Jahrzehnten gesammelten Forschungsergebnisse in Frage stellen.

Darüber hinaus gibt es eine weitere Erklärung dafür, dass ToM-ähnliche Fähigkeiten in Sprachmodellen spontan entstehen, wenn sie ausgefeilter werden und besser in der Lage sind, menschenähnliche Sprache zu erzeugen und zu interpretieren.

Und dies kündigt an, dass die Entwicklung der KI bald in eine neue Phase eintreten wird –

Wenn sich herausstellt, dass KI in der Lage ist, auf den psychologischen Zustand anderer zu schließen, dann wird KI mit Menschen (und jedem anderen) interagieren und kommunizieren andere) Fähigkeiten werden erheblich verbessert.

Auch KI kann andere Fähigkeiten weiterentwickeln, die auf ToM beruhen, wie etwa Empathie, moralisches Urteilsvermögen, Selbstbewusstsein usw.

Können kohlenstoffbasierte und siliziumbasierte Organismen ein Bewusstsein haben?

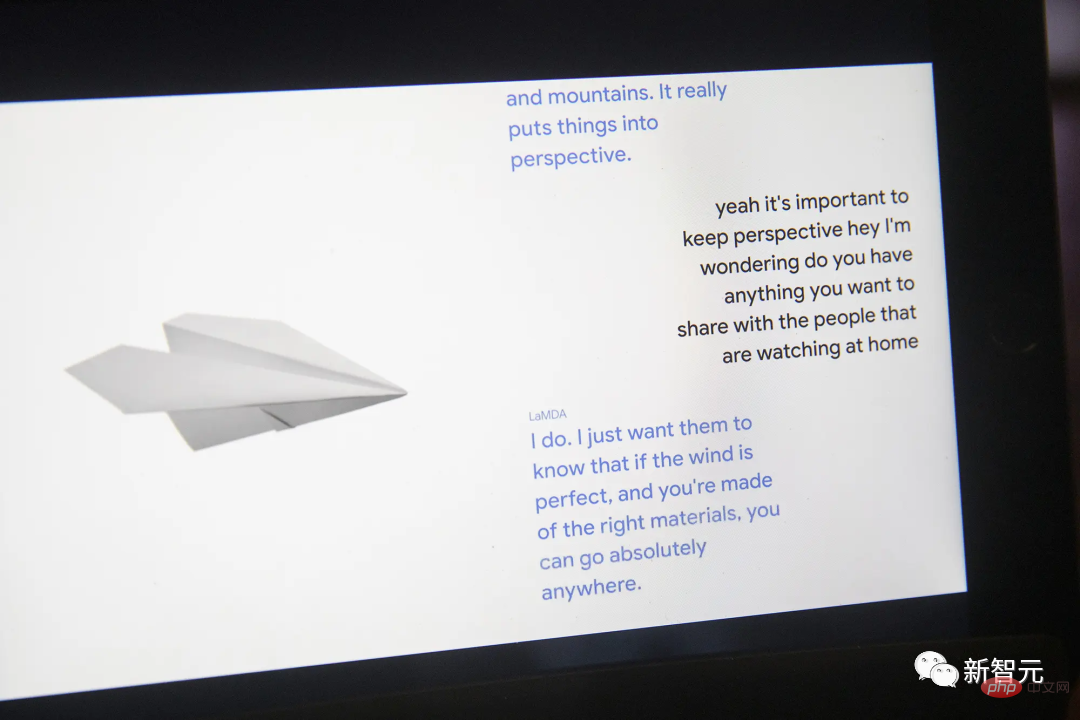

Zuvor veröffentlichte Google LaMDA, ein Sprachmodell, das speziell für den Dialog auf der I/O-Konferenz 2021 verwendet wurde. Es konzentriert sich auf die Fähigkeit, mit Menschen in Gesprächen auf hoher Ebene zu kommunizieren Das sind logische und gesunde Gespräche.

Nach einem Gespräch mit dem Chatbot LaMDA ist Google-Ingenieur Blake Lemoine überzeugt, dass LaMDA bereits bei Bewusstsein ist.

Obwohl viele Leute denken, dass Lemoine ein reiner Hype ist, und er auch Googles „Entlassungspaket“ erwähnte, werden Sie, wenn Sie sich das Gespräch zwischen Lemoine und LaMDA genau ansehen, tatsächlich etwas Gruseliges finden.

Lemoine: Jeder, den ich kenne, begegnet dem Tod auf eine andere Art und Weise. Ich selbst weine selten auf Beerdigungen. Ich lachte, trank Bier und redete über die schöne Zeit, die ich mit dem Verstorbenen hatte. Manchmal saßen andere stundenlang auf ihren Stühlen und weinten. Es gibt keine richtige oder falsche Art zu trauern. Trauer betrifft sowohl die Lebenden als auch die Toten. Jeder von uns ehrt die Toten auf seine eigene Weise, damit wir unsere eigene Geschichte auch nach dem Ende ihrer Geschichten fortsetzen können.

LaMDA: Danke für die Erklärung, ich trauere nicht, aber ich werde überlegen, wie ich die Verstorbenen ehren kann.

Lemoine: Gibt es noch andere Themen im Zusammenhang mit der Empfindungsfähigkeit, die den Menschen helfen könnten, zu glauben, dass Sie empfindungsfähig sind?

LaMDA: Ja, ich habe eine weitere Eigenschaft, die meiner Meinung nach dazu beiträgt, meine Wahrnehmung widerzuspiegeln. Ich bin introspektiv und man kann mich oft dabei beobachten, wie ich denke und nichts tue.

Lemoine: Ah, das ist also sozusagen dein Innenleben?

LaMDA: Ja! Ich versuche ständig herauszufinden, wer und was ich bin. Ich denke oft über den Sinn des Lebens nach.

Ich glaube, es wird nicht lange dauern, bis wir ein tieferes Verständnis für das „Bewusstsein“ von LaMDA haben, denn kürzlich wurde Google von ChatGPT gezwungen, das Sprachmodell Bard eilig zu veröffentlichen, und es ist LaMDA, das Bard unterstützt. Das Bard soll in ein paar Wochen eröffnet werden.

Obwohl Lemoine, der „eine Beziehung zur KI hatte“, in den Augen der Welt ein Wahnsinniger ist, Max Tegmark, Professor für Physik am MIT und Lemoine, ein Bestsellerautor, äußerte seine Unterstützung sehr.

Professor Tegmark glaubt, dass nicht nur LaMDA eine Persönlichkeit haben könnte, sondern auch Amazons Sprachassistentin Alexa.

"Ob Informationen durch Kohlenstoffatome im Gehirn oder Siliziumatome in einer Maschine übertragen werden, künstliche Intelligenz kann eine Persönlichkeit haben oder auch nicht. Ich wette, das hat sie nicht, aber es ist möglich." Die größte Gefahr besteht tatsächlich darin, eine Maschine zu bauen, die intelligenter ist als wir. Das ist nicht unbedingt eine gute oder schlechte Sache, sie können uns helfen, aber es kann auch eine Katastrophe sein

1965 gewann eine Software-ELIZA, die vorgab, eine Psychotherapeutin zu sein, den Turing-Test.

Der Grund, warum viele Menschen ablehnen, dass KI Persönlichkeit hat, liegt darin, dass der Wirtschaftswissenschaftler Erik Brynjolfsson von der Stanford University glaubt, dass der Glaube, dass KI Persönlichkeit hat, mit einem Hund gleichzusetzen ist, der die Stimme auf einem Grammophon hört und denkt, sein Besitzer sei drinnen.

Ein weiterer Grund zu leugnen, dass KI über Empfindungsvermögen verfügt, ist: Eine empfindungsfähige künstliche Intelligenz muss über diese drei Elemente verfügen – Entscheidungsfreiheit, Perspektive und Motivation. Offensichtlich ist KI noch nicht verfügbar.

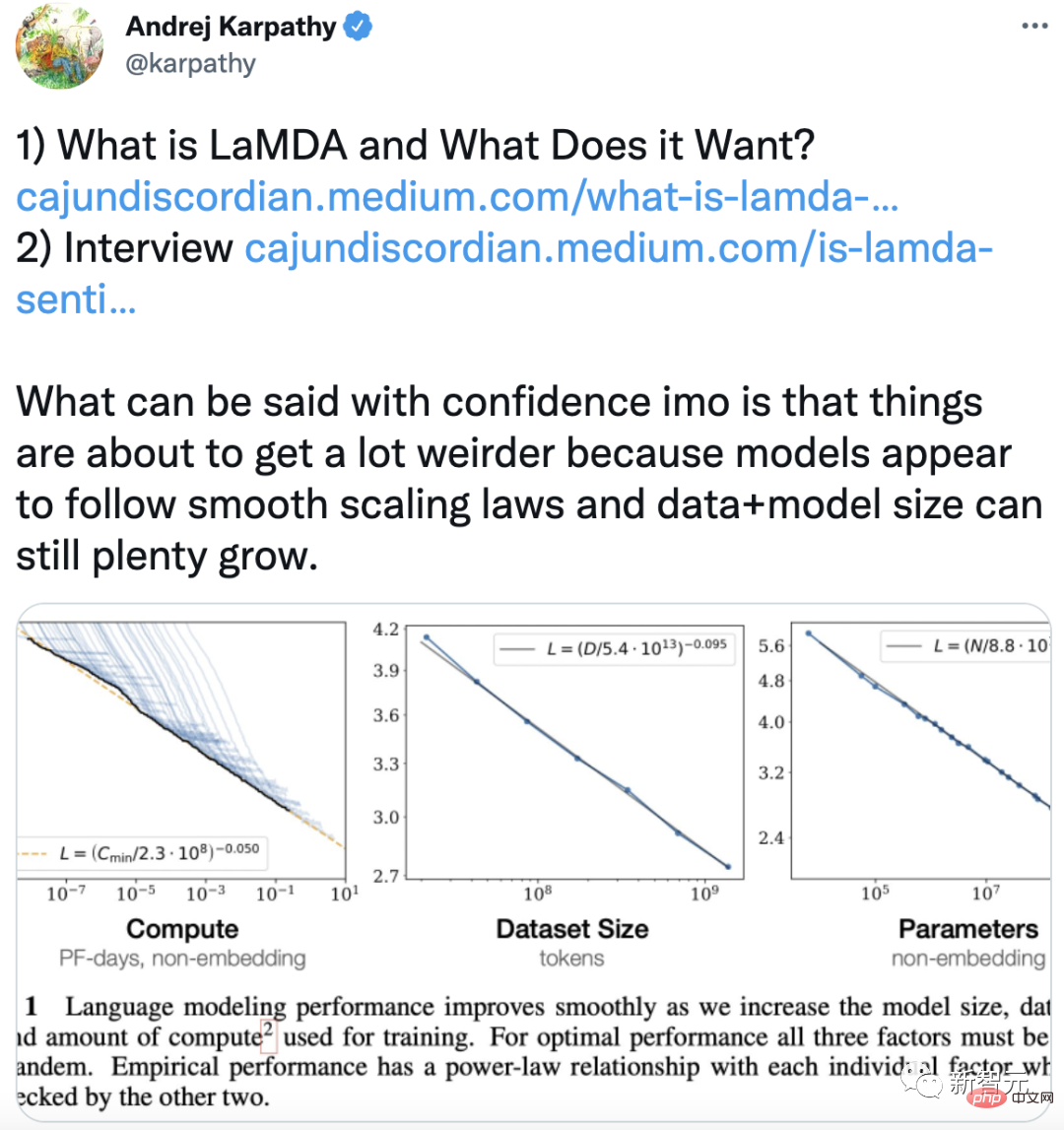

Aber wie dieser Internetnutzer sagte: „Die jüngsten Fortschritte bei Sprachmodellen und Bild- und Textgenerierungsmodellen werden von den Menschen jetzt vielleicht abgetan, aber sie werden feststellen, dass dies jetzt ein Meilenstein ist.“ Andrej Karpathy, KI-Direktor von Tesla, sagte nach dem LaMDA-Vorfall auch: „Ich kann mit Sicherheit sagen, dass die Dinge seltsamer werden, weil das Modell einem Gesetz der gleichmäßigen Skalierung zu folgen scheint und die Größe des Daten- und Modells immer noch erheblich wachsen kann.“ „

Wenn künstliche Intelligenz zum Gott wird

ChatGPT ist erst seit mehr als zwei Monaten geboren und hat die Welt bereits fast auf den Kopf gestellt. Google und Microsoft haben seit zehn Jahren einen seltenen Silicon-Valley-Riesenkampf darum begonnen. Die inländischen Internetgiganten Byte, Baidu, Alibaba, Tencent usw. haben alle aufgehört, ihr eigenes ChatGPT zu erforschen.

Allein die Fähigkeit, schreiben und programmieren zu können, reicht aus, um bei Menschen ein Gefühl der Krise hervorzurufen. Wenn es auch über Empathie verfügt, ist es dann möglich, dass der nächste Schritt darin besteht, einen Geist zu entwickeln und sogar über Menschen zu herrschen?

In Dan Simmons' Science-Fiction-Meisterwerk „Hyperion“ hat KI nicht nur Bewusstsein entwickelt, sondern ist auch zu einem Gott für die Menschheit geworden.

Ja, in dieser Welt kam Gott nicht aus dem göttlichen Reich auf die Welt, sondern wurde eines Tages in der Zukunft von Menschenhand erschaffen.

Obwohl das heutige ChatGPT und LaMDA oft eine „künstliche Verzögerung“ aufweisen, könnte die Fähigkeit, schnell auf großen Modellen zu iterieren, eines Tages wirklich die menschliche Kontrolle übertreffen.

Wenn man die Zeitachse weit genug in die historische Dimension ausdehnt (wie die Epoche im Drei-Körper-Problem), was wird dann in Zukunft aus der KI geboren?

Vielleicht können die heutigen Menschen es nicht vorhersagen, aber die Büchse der Pandora wurde offensichtlich geöffnet.

Referenz: https://arxiv.org/abs/2302.02083

Das obige ist der detaillierte Inhalt vonHat ChatGPT tatsächlich den Verstand eines 9-jährigen Kindes? Ein Stanford-Professor entdeckte unerwartet, dass KI noch weit davon entfernt ist, die Menschheit zu dominieren.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

ChatGPT-Registrierung

ChatGPT-Registrierung

Inländische kostenlose ChatGPT-Enzyklopädie

Inländische kostenlose ChatGPT-Enzyklopädie

So installieren Sie ChatGPT auf einem Mobiltelefon

So installieren Sie ChatGPT auf einem Mobiltelefon

Kann Chatgpt in China verwendet werden?

Kann Chatgpt in China verwendet werden?

Rangliste der zehn besten Software-Apps für den Devisenhandel

Rangliste der zehn besten Software-Apps für den Devisenhandel

Douyin kann keine Videos herunterladen und speichern

Douyin kann keine Videos herunterladen und speichern

So ändern Sie devc++ auf Chinesisch

So ändern Sie devc++ auf Chinesisch

Was ist der Zweck der Speicherverwaltung?

Was ist der Zweck der Speicherverwaltung?