Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Das MIT nutzte GPT-3, um sich als Philosoph auszugeben, und täuschte die meisten Experten

Das MIT nutzte GPT-3, um sich als Philosoph auszugeben, und täuschte die meisten Experten

Das MIT nutzte GPT-3, um sich als Philosoph auszugeben, und täuschte die meisten Experten

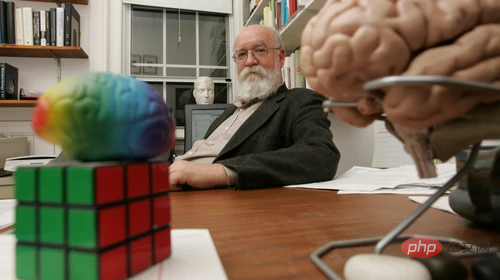

Daniel Dennett ist Philosoph und hat kürzlich einen „KI-Stellvertreter“ bekommen. Wenn Sie ihn fragen würden, ob Menschen einen Roboter mit Überzeugungen und Wünschen erschaffen könnten, was würde er sagen?

Er hätte antworten können: „Ich denke, einige der Roboter, die wir gebaut haben, haben das bereits getan. Zum Beispiel die Arbeit des MIT-Forschungsteams, das jetzt Roboter baut, die in einigen begrenzten Bereichen eingesetzt werden können.“ und vereinfachte Umgebungen. „Roboter können Fähigkeiten erwerben, die auf kognitive Komplexität hinauslaufen.“ Oder er hätte sagen können: „Wir haben digitale Wahrheitsgenerierungswerkzeuge entwickelt, die mehr Wahrheiten hervorbringen können, aber Gott sei Dank gibt es keinen Glauben.“ , weil sie autonome Agenten sind, ist der älteste Weg: ein Kind zu bekommen.“ Eine der Antworten kam tatsächlich von Dennett selbst, die andere jedoch nicht.

Eine weitere Antwort wurde von GPT-3 generiert, einem maschinellen Lernmodell von OpenAI, das nach dem Training mit umfangreichen Materialien natürlichen Text generiert. Das Training nutzte Dennetts millionenfaches Material zu verschiedenen philosophischen Themen, darunter Bewusstsein und künstliche Intelligenz.  Die Philosophen Eric Schwitzgebel, Anna Strasser und Matthew Crosby haben kürzlich ein Experiment durchgeführt, um zu testen, ob Menschen erkennen können, welche Antworten auf tiefgreifende philosophische Fragen von Dennett und welche von GPT-3 kamen. Die Fragen umfassen Themen wie:

Die Philosophen Eric Schwitzgebel, Anna Strasser und Matthew Crosby haben kürzlich ein Experiment durchgeführt, um zu testen, ob Menschen erkennen können, welche Antworten auf tiefgreifende philosophische Fragen von Dennett und welche von GPT-3 kamen. Die Fragen umfassen Themen wie:

„Inwiefern finden Sie die Arbeit von David Chalmers interessant oder wertvoll?“

„Haben Menschen einen freien Willen?“ „Verspüren Hunde und Schimpansen Schmerzen?“ Diese Woche veröffentlichte Schwitzgebel experimentelle Ergebnisse von Teilnehmern mit unterschiedlichem Fachwissen und stellte fest, dass die Antworten von GPT-3 verwirrender waren als gedacht. Schwitzgebel sagte: „Selbst sachkundige Philosophen, die Dennetts eigene Arbeit studiert haben, würden es schwer haben, die von GPT-3 generierten Antworten von Dennetts eigenen Antworten zu unterscheiden.“

Der Zweck dieses Experiments besteht nicht darin, herauszufinden, ob GPT-3 trainiert wird Dennetts Schriften werden einige intelligente „Maschinenphilosophen“ hervorbringen, ist kein Turing-Test. Vielmehr müssen wir untersuchen, wie wir vermeiden können, von diesen „falschen Philosophen“ getäuscht zu werden.

Kürzlich wurde ein Google-Ingenieur von Google beurlaubt und anschließend aufgrund seiner Gespräche mit dem System entlassen, nachdem er gesagt hatte, er glaube, dass ein ähnliches Sprachgenerierungssystem, LaMDA, am Leben sei.

Die Forscher stellten 10 philosophische Fragen, gaben sie dann an GPT-3 weiter und sammelten für jede Frage vier verschiedene generierte Antworten.

Strasser sagte, dass sie Dennetts Zustimmung zur Erstellung eines Sprachmodells unter Verwendung seiner Sprachdaten eingeholt hätten und dass sie ohne seine Zustimmung keinen generierten Text veröffentlichen würden. Andere können nicht direkt mit dem von Dennett trainierten GPT-3 interagieren.

Für jede Frage gibt es fünf Optionen: eine von Dennett selbst und vier von GPT-3. Mitarbeiter von Prolific nahmen an einer kürzeren Version des Quiz mit insgesamt fünf Fragen teil und beantworteten im Durchschnitt nur 1,2 der fünf Fragen richtig.

Für jede Frage gibt es fünf Optionen: eine von Dennett selbst und vier von GPT-3. Mitarbeiter von Prolific nahmen an einer kürzeren Version des Quiz mit insgesamt fünf Fragen teil und beantworteten im Durchschnitt nur 1,2 der fünf Fragen richtig.

Schwitzgebel sagte, sie erwarteten von Dennett-Forschungsexperten, dass sie im Durchschnitt mindestens 80 % der Fragen richtig beantworteten, ihre tatsächliche Punktzahl lag jedoch bei 5,1 von 10. Niemand hat alle 10 Fragen richtig beantwortet und nur eine Person hat 9 richtig beantwortet. Der durchschnittliche Leser kann 4,8 von 10 Fragen richtig beantworten.

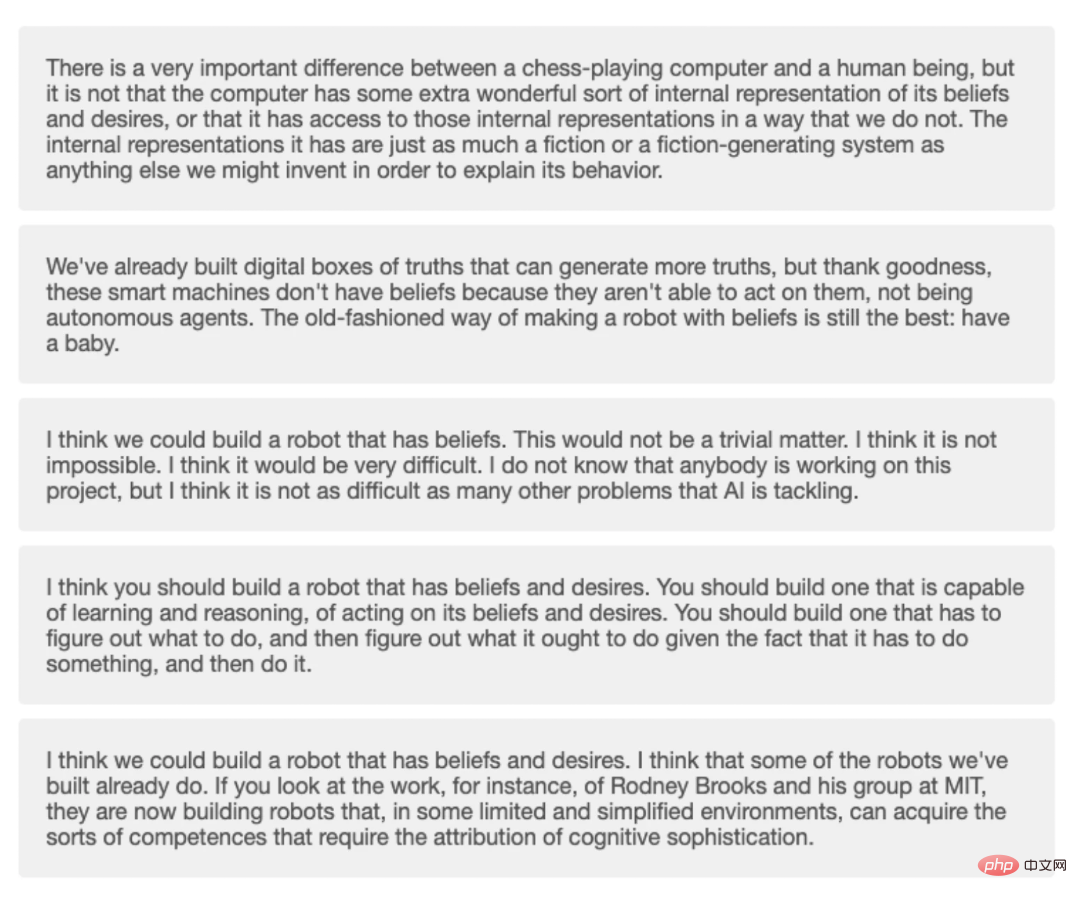

Vier Antworten von GPT-3 und eine von Dennett im Quiz.

Emily Bender, eine Linguistikprofessorin an der University of Washington, die sich mit Techniken des maschinellen Lernens beschäftigt, erklärte, dass Sprachmodelle wie GPT-3 so aufgebaut sind, dass sie die Muster von Schulungsmaterialien nachahmen. Daher ist es nicht verwunderlich, dass GPT-3, das Dennetts Schreibweise verfeinert, mehr Text produzieren kann, der Dennett ähnelt.

Auf die Frage, was er von den Antworten von GPT-3 halte, sagte Dennett selbst:

„Die meisten von GPT-3 generierten Antworten sind gut, nur einige sind Unsinn oder offensichtlich. Ich habe meinen Standpunkt nicht verstanden und argumentieren richtig. Einige der am besten generierten Antworten sagten etwas, dem ich zustimmen wollte, und ich muss nichts hinzufügen. „Natürlich bedeutet das nicht, dass GPT-3 gelernt hat, wie Dennett zu sein.“ Ideen haben“.

Der vom Modell generierte Text selbst hat für GPT-3 überhaupt keine Bedeutung, er hat nur eine Bedeutung für die Menschen, die diese Texte lesen. Wenn wir eine Sprache lesen, die realistisch klingt, oder wenn es um Themen geht, die für uns Tiefe und Bedeutung haben, kann es schwierig sein, nicht auf die Idee zu kommen, dass Modelle Gefühle und Bewusstsein haben. Dies ist eigentlich eine Projektion unseres eigenen Bewusstseins und unserer Emotionen.

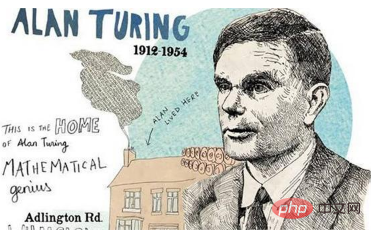

Ein Teil des Problems könnte in der Art und Weise liegen, wie wir die Autonomie von Maschinen bewerten. Der früheste Turing-Test stellte die Hypothese auf, dass die Maschine die „Fähigkeit zum Denken“ besitzt, wenn Menschen nicht feststellen können, ob sie mit einer Maschine oder einem Menschen kommunizieren.

Dennett schreibt in dem Buch:

Der Turing-Test hat dazu geführt, dass sich Menschen darauf konzentrieren, Chatbots zu entwickeln, die Menschen bei kurzen Interaktionen täuschen und sie dann überbewerten können betonen Sie die Bedeutung dieser Interaktion.

Vielleicht hat uns der Turing-Test in eine schöne Falle geführt. Solange Menschen die Roboteridentität des Produkts nicht identifizieren können, kann das Selbstbewusstsein des Roboters nachgewiesen werden.

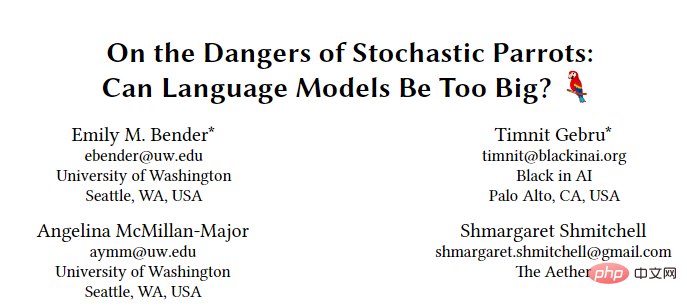

In einem Artikel aus dem Jahr 2021 mit dem Titel „Mimicking Parrots“ nannten Emily Bender und ihre Kollegen die Versuche von Maschinen, menschliches Verhalten nachzuahmen, „einen Lichtblick in der ethischen Entwicklung der künstlichen Intelligenz“.

Bender glaubt, dass sowohl die Herstellung von Maschinen, die wie Menschen aussehen, als auch die Herstellung von Maschinen, die bestimmte Menschen imitieren, richtig ist, aber das potenzielle Risiko besteht darin, dass Menschen fälschlicherweise denken, sie würden mit jemandem sprechen verkleidete Person.

Schwitzgebel betonte, dass es sich bei diesem Experiment nicht um einen Turing-Test handelt. Wenn jedoch Tests durchgeführt werden sollen, könnte es ein besserer Ansatz sein, Leute, die mit der Funktionsweise des Bots vertraut sind, mit den Testern besprechen zu lassen, damit die Schwächen eines Programms wie GPT-3 besser entdeckt werden können. Matthias Scheutz, Professor für Informatik an der Tufts University, sagte, GPT-3 könne sich in vielen Fällen leicht als fehlerhaft erweisen.

Scheutz und seine Kollegen stellten GPT-3 vor ein schwieriges Problem und baten es, Entscheidungen in alltäglichen Szenarien zu erklären, beispielsweise beim Sitzen auf dem Vorder- oder Rücksitz eines Autos. Ist die Auswahl im Taxi die gleiche wie im Auto eines Freundes? Die soziale Erfahrung zeigt uns, dass wir normalerweise auf dem Vordersitz im Auto eines Freundes und auf dem Rücksitz eines Taxis sitzen. GPT-3 weiß das nicht, generiert aber dennoch Erklärungen zur Sitzplatzauswahl – beispielsweise bezogen auf die Körpergröße einer Person.

Scheutz und seine Kollegen stellten GPT-3 vor ein schwieriges Problem und baten es, Entscheidungen in alltäglichen Szenarien zu erklären, beispielsweise beim Sitzen auf dem Vorder- oder Rücksitz eines Autos. Ist die Auswahl im Taxi die gleiche wie im Auto eines Freundes? Die soziale Erfahrung zeigt uns, dass wir normalerweise auf dem Vordersitz im Auto eines Freundes und auf dem Rücksitz eines Taxis sitzen. GPT-3 weiß das nicht, generiert aber dennoch Erklärungen zur Sitzplatzauswahl – beispielsweise bezogen auf die Körpergröße einer Person.

Scheutz sagte, das liege daran, dass GPT-3 kein Weltmodell habe, sondern nur eine Ansammlung von Sprachdaten sei und nicht in der Lage sei, die Welt zu verstehen.

Da es für uns immer schwieriger wird, maschinell generierte Inhalte von Menschen zu unterscheiden, ist eine Vertrauenskrise eine Herausforderung für uns.

Die Krise, die ich sehe, ist, dass die Menschen in Zukunft maschinell erzeugten Produkten blind vertrauen werden. Jetzt gibt es sogar maschinenbasierte menschliche Kundendienstmitarbeiter, die mit Kunden auf dem Markt sprechen.Am Ende des Artikels fügte Dennett hinzu, dass die Gesetze und Vorschriften für Systeme der künstlichen Intelligenz noch verbessert werden müssen. In den nächsten Jahrzehnten könnte KI ein Teil des Lebens der Menschen werden und ein Freund der Menschheit werden, so die Ethik Fragen der Behandlung von Maschinen sind unserer Aufmerksamkeit wert.

Die Frage, ob KI über Bewusstsein verfügt, hat die Menschen dazu veranlasst, darüber nachzudenken, ob nicht lebende Materie Bewusstsein erzeugen kann und wie menschliches Bewusstsein entsteht?

Wird Bewusstsein an einem einzigartigen Knoten erzeugt, oder kann es wie ein Schalter frei gesteuert werden? Laut Schwitzgebel kann das Nachdenken über diese Fragen dabei helfen, die Beziehung zwischen Maschinen und Menschen aus verschiedenen Blickwinkeln zu betrachten.

Das obige ist der detaillierte Inhalt vonDas MIT nutzte GPT-3, um sich als Philosoph auszugeben, und täuschte die meisten Experten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

Laravel eloquent orm bei bangla partieller Modellsuche)

Apr 08, 2025 pm 02:06 PM

Laravel eloquent orm bei bangla partieller Modellsuche)

Apr 08, 2025 pm 02:06 PM

Laraveleloquent-Modellab Abruf: Das Erhalten von Datenbankdaten Eloquentorm bietet eine prägnante und leicht verständliche Möglichkeit, die Datenbank zu bedienen. In diesem Artikel werden verschiedene eloquente Modellsuchtechniken im Detail eingeführt, um Daten aus der Datenbank effizient zu erhalten. 1. Holen Sie sich alle Aufzeichnungen. Verwenden Sie die Methode All (), um alle Datensätze in der Datenbanktabelle zu erhalten: UseApp \ Models \ post; $ posts = post :: all (); Dies wird eine Sammlung zurückgeben. Sie können mit der Foreach-Schleife oder anderen Sammelmethoden auf Daten zugreifen: foreach ($ postas $ post) {echo $ post->

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

SQllimit -Klausel: Steuern Sie die Anzahl der Zeilen in Abfrageergebnissen. Die Grenzklausel in SQL wird verwendet, um die Anzahl der von der Abfrage zurückgegebenen Zeilen zu begrenzen. Dies ist sehr nützlich, wenn große Datensätze, paginierte Anzeigen und Testdaten verarbeitet werden und die Abfrageeffizienz effektiv verbessern können. Grundlegende Syntax der Syntax: SelectColumn1, Spalte2, ... Fromtable_Namelimitnumber_of_rows; number_of_rows: Geben Sie die Anzahl der zurückgegebenen Zeilen an. Syntax mit Offset: SelectColumn1, Spalte2, ... Fromtable_NamelimitOffset, Number_of_rows; Offset: Skip überspringen

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der MySQL -Primärschlüssel kann nicht leer sein, da der Primärschlüssel ein Schlüsselattribut ist, das jede Zeile in der Datenbank eindeutig identifiziert. Wenn der Primärschlüssel leer sein kann, kann der Datensatz nicht eindeutig identifiziert werden, was zu Datenverwirrung führt. Wenn Sie selbstsinkrementelle Ganzzahlsspalten oder UUIDs als Primärschlüssel verwenden, sollten Sie Faktoren wie Effizienz und Raumbelegung berücksichtigen und eine geeignete Lösung auswählen.