Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Neueste Fortschritte bei Sparse-Modellen! Ma Yi + LeCun bündeln ihre Kräfte: „White Box' unbeaufsichtigtes Lernen

Neueste Fortschritte bei Sparse-Modellen! Ma Yi + LeCun bündeln ihre Kräfte: „White Box' unbeaufsichtigtes Lernen

Neueste Fortschritte bei Sparse-Modellen! Ma Yi + LeCun bündeln ihre Kräfte: „White Box' unbeaufsichtigtes Lernen

Kürzlich haben Professor Ma Yi und Turing-Award-Gewinner Yann LeCun gemeinsam auf der ICLR 2023 einen Artikel veröffentlicht, in dem sie eine minimalistische und interpretierbare unbeaufsichtigte Lernmethode beschreiben, die keinen Rückgriff auf Datenverbesserung oder Hyperparameteranpassung oder andere technische Designs erfordert und mit der Sie nahezu eine Leistung erzielen können die SOTA-SSL-Methode.

Link zum Papier: https://arxiv.org/abs/2209.15261 Merkmalsanalyse) kombiniert.

Durch die Verwendung einer einschichtigen deterministischen spärlichen Mannigfaltigkeitstransformation kann eine KNN-Top-1-Genauigkeit von 99,3 % auf MNIST, eine KNN-Top-1-Genauigkeit von 81,1 % auf CIFAR-10 und eine KNN-Top-1-Genauigkeit von 81,1 % auf CIFAR-100 erreicht werden . 53,2 % KNN-Top-1-Genauigkeit erreicht.

Durch einfache Graustufenverbesserung erreichte die Genauigkeit des Modells auf CIFAR-10 und CIFAR-100 83,2 % bzw. 57 %. Diese Ergebnisse verringerten die Lücke zwischen der einfachen „White-Box“-Methode und der SOTA-Methode deutlich .

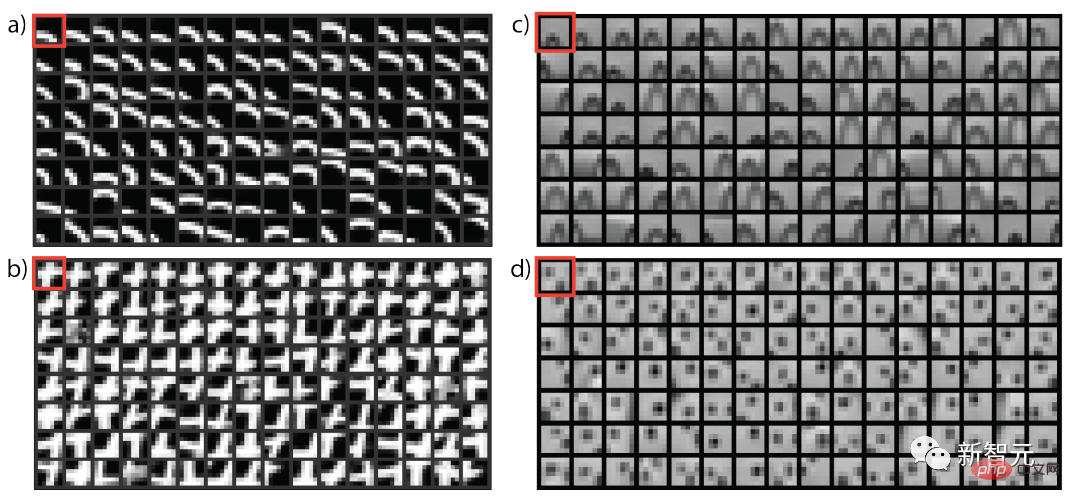

Darüber hinaus bietet der Artikel auch eine visuelle Erklärung, wie eine unbeaufsichtigte Darstellungstransformation durchgeführt wird. Diese Methode ist eng mit der selbstüberwachten Methode der latenten Einbettung verwandt und kann als die einfachste VICReg-Methode angesehen werden.

Obwohl zwischen unserem einfachen konstruktiven Modell und dem SOTA-Ansatz immer noch eine kleine Leistungslücke besteht, gibt es Hinweise darauf, dass dies eine vielversprechende Richtung ist, um ein prinzipielles, unbeaufsichtigtes White-Box-Lernen zu erreichen.

Der Erstautor des Artikels, Yubei Chen, ist Postdoktorand am Center for Data Science (CDS) und Meta Basic Artificial Intelligence Research (FAIR) an der New York University. Er hat seinen Abschluss gemacht mit einem Doktortitel in theoretischer Neurologie vom Redwood Center der University of California, Berkeley Science und dem Berkeley Artificial Intelligence Institute (BAIR), mit einem Bachelor-Abschluss von der Tsinghua University.

Die Hauptforschungsrichtung ist die Schnittstelle zwischen computergestütztem neurowissenschaftlichem Lernen und tiefem unbeaufsichtigtem (selbstüberwachtem) Lernen. Die Forschungsergebnisse verbessern das Verständnis der rechnerischen Prinzipien des unbeaufsichtigten Repräsentationslernens im Gehirn und in der Maschine. und umformen. Ein Verständnis der Statistik natürlicher Signale.

Professor Ma Yi erhielt 1995 einen Doppel-Bachelor-Abschluss in Automatisierung und angewandter Mathematik von der Tsinghua-Universität, 1997 einen Master-Abschluss in EECS von der University of California, Berkeley sowie einen Master-Abschluss in Mathematik und einen Doktortitel in EECS 2000. Derzeit ist er Professor am Fachbereich Elektrotechnik und Informatik der University of California, Berkeley, und außerdem IEEE Fellow, ACM Fellow und SIAM Fellow.

Yann LeCuns berühmtestes Werk ist die Verwendung von Faltungs-Neuronalen Netzen (CNN) in der optischen Zeichenerkennung und Computer Vision. Er ist auch als Vater der Faltungsnetze bekannt und gewann gemeinsam mit Bengio und Hinton den höchsten Preis Auszeichnung bei den Informatikpreisen Turing Award.

Beginnen Sie mit dem einfachsten unüberwachten LernenUnüberwachtes Repräsentationslernen hat in den letzten Jahren enorme Fortschritte gemacht und wird voraussichtlich eine starke Skalierbarkeit beim datengesteuerten maschinellen Lernen bieten.

Allerdings ist noch unklar, was eine erlernte Darstellung ist und wie genau sie auf unbeaufsichtigte Weise gebildet wird. Darüber hinaus ist immer noch unklar, ob es einen gemeinsamen Satz von Prinzipien gibt, die allen diesen unbeaufsichtigten Darstellungen zugrunde liegen.

Viele Forscher haben erkannt, wie wichtig es ist, das Modellverständnis zu verbessern, und haben einige bahnbrechende Maßnahmen ergriffen, um zu versuchen, die SOTA-Methode zu vereinfachen, Verbindungen zu klassischen Methoden herzustellen, verschiedene Methoden zu vereinheitlichen und Darstellungen zu visualisieren und diese Methoden aus theoretischer Sicht zu analysieren , mit der Hoffnung, eine andere Computertheorie zu entwickeln: eine, die es uns ermöglicht, einfache, vollständig interpretierbare „White-Box“-Modelle aus Daten zu erstellen, die auf ersten Prinzipien basieren und auch Einblicke in das Verständnis der Prinzipien des unbeaufsichtigten Lernens im menschlichen Gehirn liefern können Anleitung.

In dieser Arbeit machten die Forscher einen weiteren kleinen Schritt in Richtung dieses Ziels und versuchten, das einfachste unbeaufsichtigte „White-Box“-Lernmodell zu erstellen, das keine tiefen Netzwerke, Projektionsköpfe, Datenerweiterung oder andere verschiedene technische Designs erfordert.

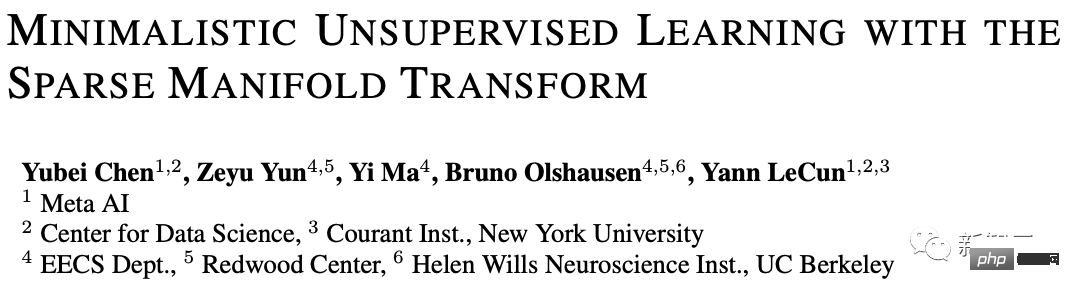

Durch die Verwendung zweier klassischer Prinzipien des unbeaufsichtigten Lernens, nämlich Sparsity und Spectral Embedding, wird ein zweischichtiges Modell erstellt, das Ergebnisse auf mehreren Standarddatensätzen erzielt, die nicht signifikante Basisergebnisse erzielen.

Experimentelle Ergebnisse zeigen, dass das zweischichtige Modell, das auf der Transformation dünner Mannigfaltigkeiten basiert, dasselbe Ziel hat wie die selbstüberwachte Methode mit latenter Einbettung und die beste Leistung auf MNIST ohne Datenerweiterung erzielt. Die höchste Genauigkeit der Stufe 1 von KNN beträgt 99,3 %, und die höchste Genauigkeit der Stufe 1 von KNN beträgt 81,1 % bei CIFAR-10 und die Genauigkeit beträgt 53,2 % bei CIFAR-100.

Durch einfache Graustufenverbesserung haben wir außerdem eine KNN-Top-1-Genauigkeit von 83,2 % auf CIFAR-10 und 57 % KNN-Top-1-Genauigkeit auf CIFAR-100 erreicht.

Diese Ergebnisse sind ein wichtiger Schritt, um die Lücke zwischen „White-Box“-Modellen und selbstüberwachten SOTA-Modellen (SSL) zu schließen. Obwohl die Lücke immer noch erheblich ist, glauben die Forscher, dass eine weitere Verringerung der Lücke das Potenzial für eine Verbesserung birgt Auch das Erlernen eines tieferen Verständnisses ist ein vielversprechender Forschungsweg, der zur praktischen Anwendung dieser Theorie führt.

Drei grundlegende Fragen

Was ist unbeaufsichtigte (selbstüberwachte) Neupräsentation? sind mehr an nützlichen Transformationen interessiert.

Ein Makroziel des unbeaufsichtigten Re-Präsentationslernens besteht darin, eine Funktion zu finden, die die Originaldaten in einen neuen Raum umwandelt, sodass „ähnliche“ Dinge gleichzeitig näher platziert werden, der neue Raum nicht zusammengeklappt wird trivial, das heißt, die geometrische oder zufällige Struktur der Daten muss erhalten bleiben.Wird dieses Ziel erreicht, dann werden „unähnliche“ Inhalte naturgemäß weit entfernt im Darstellungsraum platziert.

Woher kommt Ähnlichkeit?

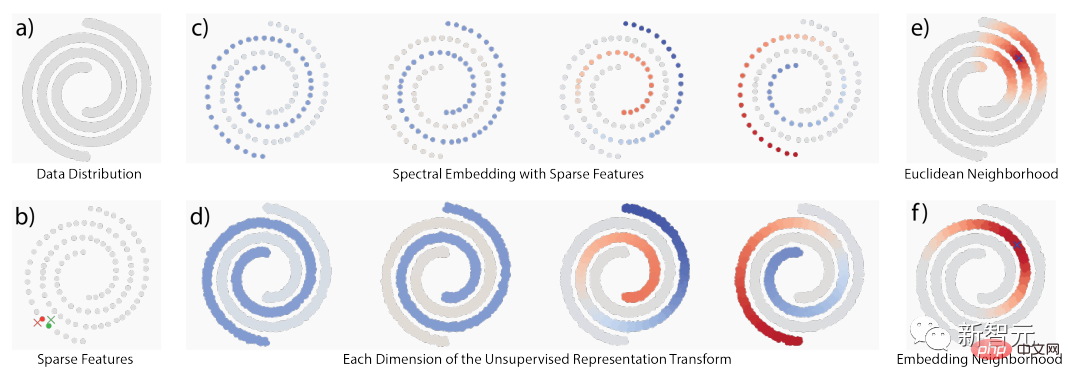

Die Ähnlichkeit beruht hauptsächlich auf drei klassischen Ideen: 1) zeitliches Zusammentreffen, 2) räumliches Zusammentreffen und 3) lokale Nachbarschaften im ursprünglichen Signalraum.

Wenn es sich bei der zugrunde liegenden Struktur um eine geometrische Struktur handelt, überschneiden sich diese Ideen in erheblichem Maße. Wenn es sich jedoch um eine zufällige Struktur handelt, unterscheiden sie sich auch konzeptionell von der vielfältigen Struktur Struktur.

Unter Verwendung der Lokalität schlagen verwandte Arbeiten zwei unbeaufsichtigte Lernmethoden vor: vielfältiges Lernen und statistische Modellierung des gleichzeitigen Auftretens. Viele dieser Ideen haben die Formulierung der Abstammungszerlegung oder der Aufschlüsselung eng verwandter Matrizen erreicht.

Im Gegensatz dazu folgt die statistische Modellierung des gleichzeitigen Auftretens einem probabilistischen Konzept, da einige Strukturen nicht durch kontinuierliche Mannigfaltigkeiten modelliert werden können, sodass sie auch das Mannigfaltigkeitskonzept ergänzt.

Eines der offensichtlichsten Beispiele stammt aus der natürlichen Sprache, wo die Originaldaten im Grunde nicht aus glatter Geometrie stammen. Beispielsweise können die Einbettungen von „Seattle“ und „Dallas“ sogar sehr ähnlich sein obwohl dies nicht der Fall ist. Der Hauptgrund für das häufige gleichzeitige Auftreten ist, dass sie ähnliche Kontextmuster aufweisen.

Die Perspektiven von Wahrscheinlichkeit und Mannigfaltigkeit ergänzen einander beim Verständnis von „Ähnlichkeit“. Sobald es eine Definition von Ähnlichkeit gibt, kann eine Transformation konstruiert werden, um ähnliche Konzepte näher zu bringen. Wie wird in diesem Artikel eine Repräsentationstransformation etabliert? Grundprinzipien: Sparsity und niedriger Rang Im Allgemeinen kann Sparsity verwendet werden, um Lokalität und Zerlegung im Datenraum zu handhaben, um Unterstützung herzustellen. Anschließend werden Niederfrequenzfunktionen verwendet, um Darstellungstransformationen zu konstruieren, um ähnliche Werte zu transformieren dem Ähnlichkeitspunkt auf dem Träger zugeordnet. Der gesamte Prozess kann auch als spärliche Mannigfaltigkeitstransformation bezeichnet werden.

Das obige ist der detaillierte Inhalt vonNeueste Fortschritte bei Sparse-Modellen! Ma Yi + LeCun bündeln ihre Kräfte: „White Box' unbeaufsichtigtes Lernen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1370

1370

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins