Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wanzi Interpretations erste Rezension zu „Face Restoration'! Gemeinsam herausgegeben von NTU, Sun Yat-sen, Australian National University, Imperial College usw.

Wanzi Interpretations erste Rezension zu „Face Restoration'! Gemeinsam herausgegeben von NTU, Sun Yat-sen, Australian National University, Imperial College usw.

Wanzi Interpretations erste Rezension zu „Face Restoration'! Gemeinsam herausgegeben von NTU, Sun Yat-sen, Australian National University, Imperial College usw.

In den letzten Jahren hat Deep Learning mit der Entwicklung des Deep Learning und dem Aufkommen großer Datensätze in vielen Bereichen Fortschritte gemacht, aber der Aufgabe „Gesichtswiederherstellung“ fehlt noch eine systematische Überprüfung.

Kürzlich haben Forscher der Nanjing University, der Australian National University, der Sun Yat-sen University, des Imperial College London und Tencent den Forschungsfortschritt der auf Deep Learning basierenden Gesichtswiederherstellungstechnologie umfassend überprüft und zusammengefasst und eine Überprüfung der Gesichtswiederherstellungsmethoden durchgeführt . Klassifizierung, Netzwerkarchitektur, Verlustfunktion und Benchmark-Datensätze werden diskutiert und eine systematische Leistungsbewertung bestehender SOTA-Methoden durchgeführt.

Papierlink: https://arxiv.org/abs/2211.02831

Repository-Link: https://github.com/TaoWangzj/Awesome-Face-Restoration

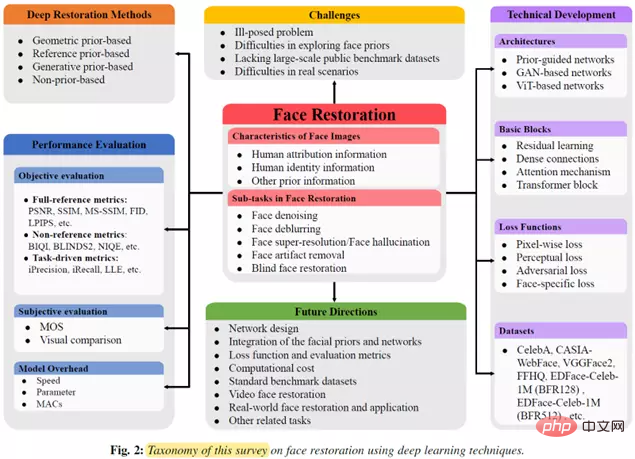

Dieser Artikel ist auch menschlich Die erste Übersicht im Bereich der Gesichtswiederherstellung. Die wichtigsten Beiträge sind:

1 Überprüfung der wichtigsten Verschlechterungsmodelle und häufig verwendeten Bewertungsindikatoren bei der Gesichtswiederherstellungsaufgabe und Zusammenfassung der Merkmale der Gesichtsbildausprägung

2. Fasst die aktuellen Herausforderungen bei der Gesichtssanierung zusammen, klassifiziert und skizziert bestehende Methoden. Die Methoden umfassen hauptsächlich zwei Kategorien: Deep-Learning-Wiederherstellungsmethoden basierend auf Priors und Deep-Learning-Restaurierungsmethoden ohne Priors

3 Die in den Methoden verwendeten grundlegenden Netzwerkarchitekturen, grundlegenden Netzwerkmodule, Verlustfunktionen und Standarddaten werden festgelegt.

4. Durchführung einer systematischen experimentellen Bewertung bestehender SOTA-Methoden anhand öffentlicher Benchmark-Datensätze

5. Analyse der zukünftigen Entwicklungsaussichten der Gesichtswiederherstellungsaufgabe.

Gesamtarchitektur des Artikels

Forschungshintergrund

Face Restoration (FR) ist ein spezifisches Bildwiederherstellungsproblem bei Sehschwächen mit dem Ziel, Gesichter aus Eingabegesichtern mit geringer Qualität wiederherzustellen Aus den Bildern werden qualitativ hochwertige Gesichtsbilder wiederhergestellt. Im Allgemeinen kann das Degradationsmodell wie folgt beschrieben werden:

wobei I(lq) ein Gesichtsbild mit geringer Qualität ist, D eine Degradationsfunktion ist, die nicht mit Rauschen korreliert, und n additives Gaußsches Rauschen ist. Wenn die Abbaufunktion D unterschiedlich ist, entspricht sie unterschiedlichen Abbaumodellen. Daher kann die FR-Aufgabe als der umgekehrte Prozess zur Lösung des obigen Degradationsmodells betrachtet werden, der wie folgt ausgedrückt werden kann:

Nach verschiedenen Degradationsfunktionen können Gesichtswiederherstellungsaufgaben hauptsächlich in unterteilt werden Folgende fünf Kategorien entsprechen jeweils unterschiedlichen Degradationsmodellen:

1. Gesichtsentrauschung (FDN): Entfernen Sie Rauschen in Gesichtsbildern und stellen Sie hochwertige Gesichter wieder her. 2. Gesichtsunschärfe (FDB): Entfernen Sie Unschärfe in Gesichtsbildern und stellen Sie hochwertige Gesichter wieder her. Auflösung von Gesichtern;

4. Entfernen Sie Artefakte, die während des Gesichtsbildkomprimierungsprozesses auftreten, und stellen Sie hochwertige Gesichter wieder her Wiederherstellung (BFR): Wiederherstellen unbekannter, verschlechterter Gesichter mit geringer Qualität. Gesichter werden in Gesichter mit hoher Qualität wiederhergestellt Gesichtswiederherstellungsaufgaben können verwendet werden. Die vorherigen Informationen des Gesichtsbildes werden verwendet, um den Gesichtswiederherstellungsprozess zu unterstützen. Die vorherigen Informationen können hauptsächlich in die folgenden drei Teile unterteilt werden:

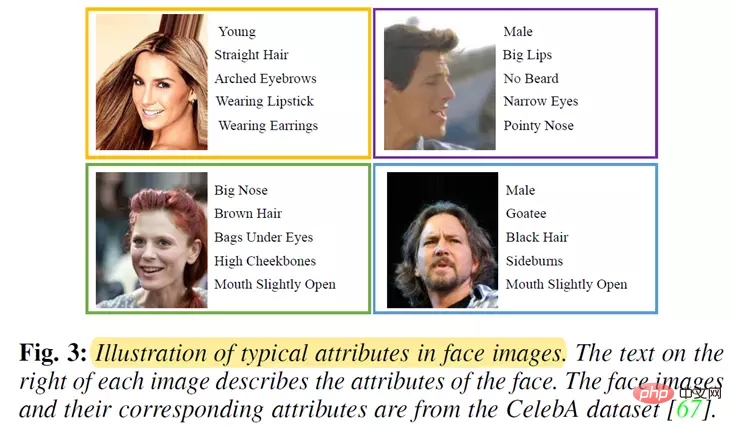

Attributinformationen der Person: wie Geschlecht, Alter, ob eine Brille getragen werden soll, wie in der Abbildung unten dargestellt;

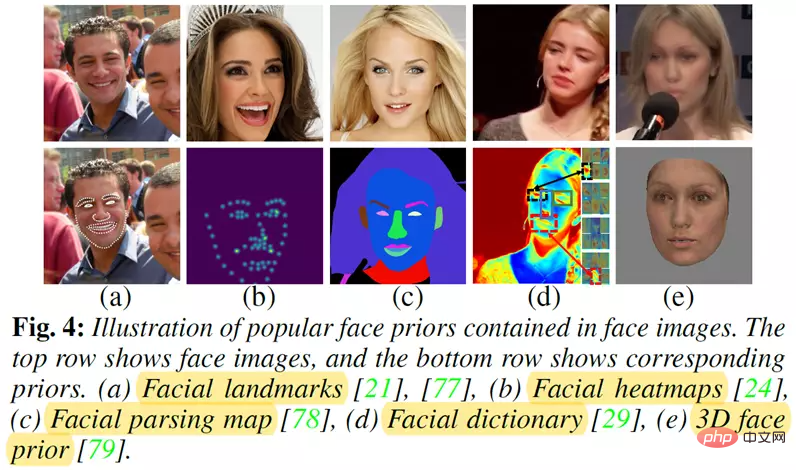

Andere vorherige Informationen: wie in der Abbildung unten dargestellt , Repräsentativ: Zu den Priors gehören Gesichts-Orientierungspunkte, Gesichts-Heatmaps, Gesichts-Parsing-Karten und 3D-Gesichts-Prioritäten .

Da die Art der Verschlechterung und die Verschlechterungsparameter von Gesichtsbildern mit geringer Qualität im Voraus unbekannt sind, ist die Schätzung hochwertiger Gesichtsbilder aus Bildern mit Verschlechterung ein schlecht gestelltes Problem.

Andererseits ist die Verschlechterung von Gesichtsbildern in tatsächlichen Szenarien komplex und vielfältig. Daher ist es eine Herausforderung, ein effektives und robustes Gesichtswiederherstellungsmodell zu entwerfen, um dieses schlecht gestellte Problem zu lösen.

2. Es ist schwierig, unbekannte Gesichter zu erkunden.

3. Mangel an großen öffentlichen Benchmark-Datensätzen.

Mit der Entwicklung der Deep-Learning-Technologie haben Deep-Learning-basierte Methoden beeindruckende Leistungen bei der Gesichtswiederherstellung gezeigt. Die meisten auf Deep Learning basierenden Methoden zur Gesichtswiederherstellung stützen sich stark auf große Datensätze, um das Netzwerk zu trainieren. Allerdings werden die meisten aktuellen Gesichtswiederherstellungsmethoden normalerweise anhand nicht öffentlicher Datensätze trainiert oder getestet. Daher ist es derzeit schwierig, einen direkten und fairen Vergleich bestehender Methoden zur Gesichtswiederherstellung durchzuführen.Darüber hinaus schränkt der Mangel an qualitativ hochwertigen und groß angelegten Benchmarks das Potenzial des Modells ein. Allerdings ist es immer noch schwierig, groß angelegte Gesichtsdaten zu erhalten, sodass es schwierig ist, einen vernünftigen öffentlichen Benchmark-Datensatz für Gesichtswiederherstellungsaufgaben zu erstellen.

4. Der Gesichtswiederherstellungsalgorithmus verfügt in tatsächlichen Szenarien nur über eine begrenzte Verallgemeinerungsfähigkeit.

Obwohl Deep-Learning-basierte Methoden gute Ergebnisse bei der Gesichtswiederherstellung erzielt haben, basieren die meisten Methoden auf überwachten Trainingsstrategien.Das heißt, diese Methoden erfordern gepaarte Datensätze (Bildpaare mit niedriger und hoher Qualität). Wenn diese Bedingung nicht erfüllt ist, wird ihre Leistung stark beeinträchtigt.

Andererseits ist es schwierig, große Datensätze mit gepaarten Stichproben in realen Szenarien zu sammeln. Daher verfügen Algorithmen, die auf synthetischen Datensätzen trainiert werden, über schwache Generalisierungsfähigkeiten in realen Szenarien, wodurch die Anwendbarkeit des Modells in realen Szenarien eingeschränkt wird. Daher ist es eine Herausforderung, die Generalisierungsfähigkeit von Gesichtsalgorithmen in tatsächlichen Szenarien zu verbessern. Zusammenfassung und Klassifizierung von Methoden zur GesichtswiederherstellungBisher haben Forscher viele Algorithmen zur Gesichtswiederherstellung vorgeschlagen, um zu versuchen, die oben genannten Herausforderungen zu lösen. Die folgende Abbildung zeigt einen prägnanten Meilenstein der auf Deep Learning basierenden Gesichtswiederherstellungsmethode.Wie in der Abbildung gezeigt, hat die Anzahl der auf Deep Learning basierenden Methoden zur Gesichtswiederherstellung seit 2015 von Jahr zu Jahr zugenommen.

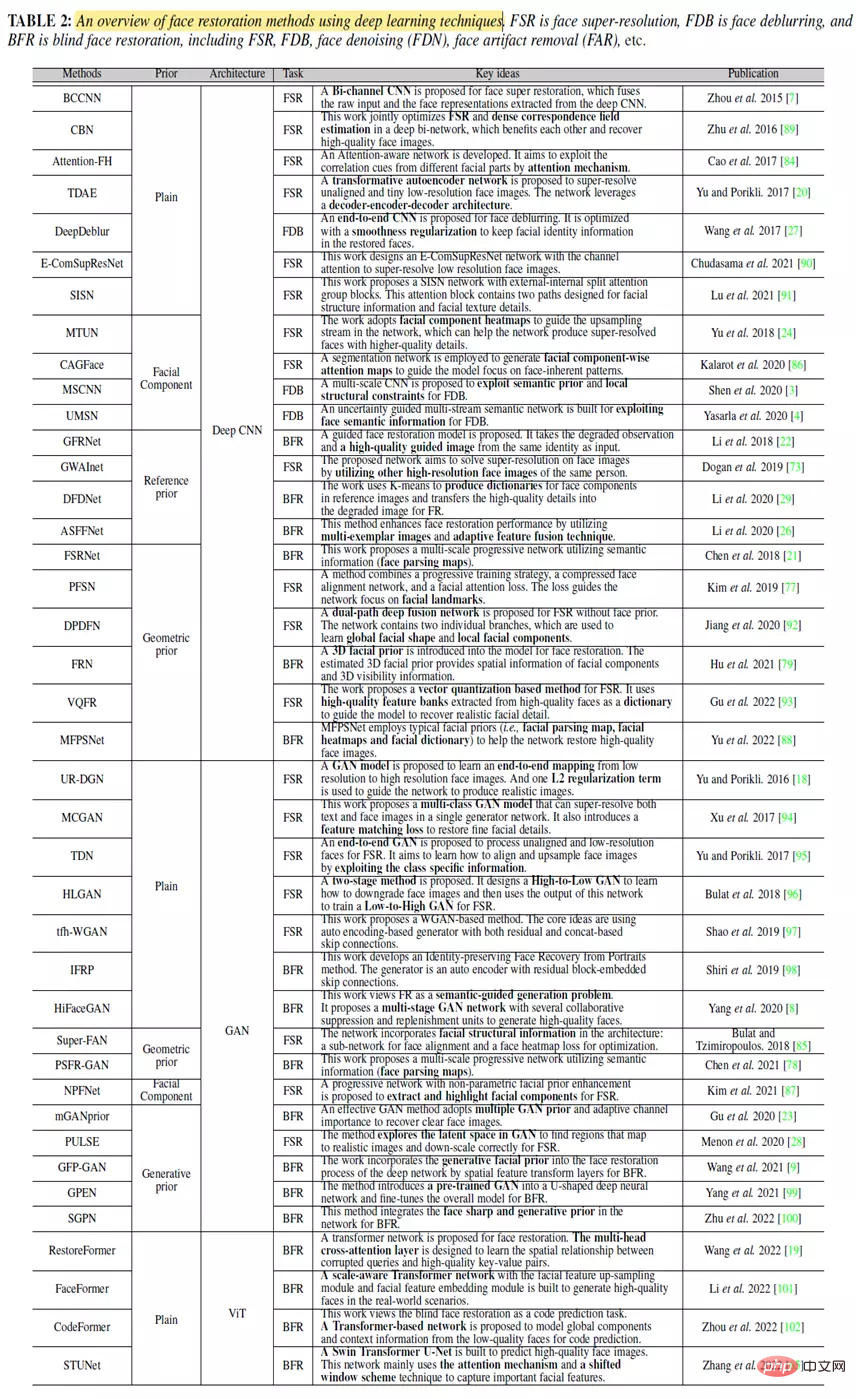

Diese Methoden zur Gesichtswiederherstellung sind in zwei Kategorien unterteilt: Prior-basierte Deep-Learning-Restaurierungsmethoden und nicht-Prior-basierte Deep-Learning-Restaurierungsmethoden. Die auf Priors basierenden Deep-Learning-Restaurierungsmethoden unterteilen wir in drei Kategorien: Deep-Learning-Restaurierungsmethoden auf Basis geometrischer Priors, Tiefenrestaurierungsmethoden auf Basis von Referenz-Priors und Tiefenrestaurierungsmethoden auf Basis generativer Priors. Das Folgende ist eine kurze Einführung in repräsentative Gesichtswiederherstellungsalgorithmen. Geometrische Prior-basierte Tiefenwiederherstellungsmethoden Diese Methode nutzt hauptsächlich die einzigartige geometrische Form und räumliche Verteilungsinformationen des Gesichts im Bild, um dem Modell dabei zu helfen, nach und nach qualitativ hochwertige Gesichter wiederherzustellen. Zu den typischen geometrischen Prioritäten gehören Gesichtsmarkierungen, Gesichtswärmekarten, Gesichtsanalysekarten und Gesichtskomponenten. Zu den repräsentativen Arbeiten gehören: SuperFAN: Es ist die erste End-to-End-Methode, mit der gleichzeitig eine Gesichts-Superauflösung und richtungsweisende Positionierungsaufgaben erreicht werden können. Die Kernidee dieser Methode besteht darin, eine gemeinsame Aufgabentrainingsstrategie zu verwenden, um das Netzwerk anzuleiten, mehr Gesichtsgeometrieinformationen zu lernen, um das Modell dabei zu unterstützen, eine effiziente Gesichtssuperauflösung und Gesichtsmarkierungspositionierung zu erreichen. MTUN: Es handelt sich um eine Gesichtswiederherstellungsmethode, die zwei Zweignetzwerke enthält. Das erste Zweignetzwerk wird verwendet, um eine Superauflösung von Gesichtsbildern zu erreichen, und der zweite Zweig wird verwendet, um die Wärmekarte der Gesichtszusammensetzung abzuschätzen.Diese Methode zeigt, dass die Verwendung von Gesichtselementinformationen in Gesichtsbildern geringer Qualität die Leistung der algorithmischen Gesichtswiederherstellung weiter verbessern kann.

PSFR-GAN: Es handelt sich um eine Methode zur Wiederherstellung blinder Gesichter, die auf einem progressiven Multiskalennetzwerk basiert. Die Kernidee dieser Methode besteht darin, die Gesichtsdetails des Gesichts durch semantikbewusste Stilübertragung schrittweise wiederherzustellen, indem Gesichtsbilder mit geringer Qualität in mehreren Maßstäben und menschliche Analysekarten als Eingabe verwendet werden.

Referenzbasierte Tiefenwiederherstellungsmethoden

In der Vergangenheit stützten sich Gesichtswiederherstellungsmethoden nur auf verschlechterte Bilder, um Gesichtsbilder zu schätzen. Der Prozess der Gesichtsbildverschlechterung ist jedoch in der Regel sehr pathologisch, diese Methoden können kein genaues Gesicht erhalten Priors nur durch verschlechterte Bilder

Daher wird eine andere Art von Methode verwendet, um Gesichtsstrukturen oder Gesichtskomponenten zu erhalten, indem zunächst zusätzliche hochwertige Gesichtsbilder als Gesichtsreferenz verwendet werden, um das Modell für eine effiziente Gesichtswiederherstellung zu leiten :

GFRNet: Dieses Netzwerkmodell besteht aus einem Verzerrungsnetzwerk (WarpNet) und einem Rekonstruktionsnetzwerk (RecNet), um Informationen zur Verzerrungsführung bereitzustellen. Es korrigiert die Gesichtshaltung und den Gesichtsausdruck, indem es Flussfelder erzeugt, um Referenzbilder zu verzerren. Hochwertige Bilder und verzerrte Führungsinformationen gleichzeitig zur Generierung hochwertiger Gesichtsbilder: Diese Arbeit basiert auf der kontradiktorischen Generierung hochwertiger Gesichtsbilder Mit GFRNet verlässt sich GWAInet in der Trainingsphase nicht auf Gesichtsmarkierungen. Erhöht die Robustheit des Modells.

DFDNet: Diese Methode verwendet zunächst den K-Means-Algorithmus ein tiefes Wörterbuch für wahrnehmungsbedeutende Gesichtskomponenten (d. h. linkes/rechtes Auge, Nase und Mund) aus qualitativ hochwertigen Bildern, wählen Sie dann die ähnlichsten Komponentenmerkmale aus dem generierten Komponentenwörterbuch aus, übertragen Sie Details auf Gesichtsbilder mit geringer Qualität und führen Sie sie aus das Modell zur Durchführung der Gesichtswiederherstellung

Generative Prior Based Deep Restoration Methods)

Mit der schnellen Entwicklung von Generative Adversarial Networks (GAN) hat die Forschung herausgefunden, dass vorab trainierte Gesichts-GAN-Modelle wie StyleGAN und StyleGAN2 können umfassendere Gesichtsprioritäten (wie Geometrie und Gesichtstextur) bereitstellen.

Daher begannen Forscher, das von GAN generierte vorherige Hilfsmodell für die Gesichtswiederherstellung zu verwenden:

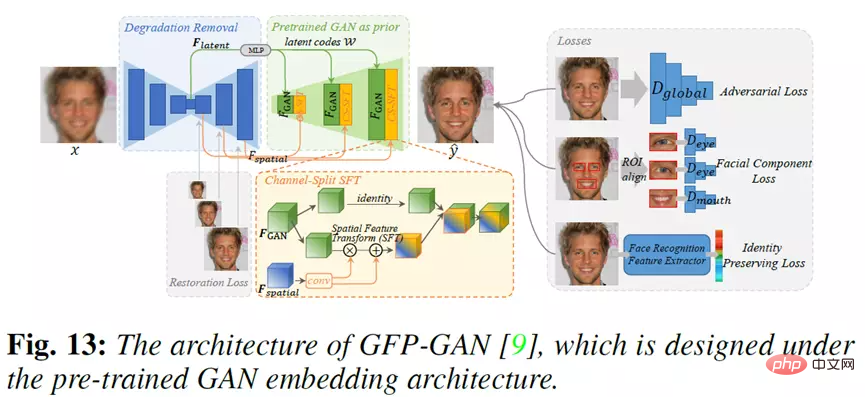

PULSE: Der Kern Ein Teil dieser Arbeit besteht darin, den latenten Code des vorab trainierten StyleGAN iterativ zu optimieren, bis die Ausgabe und der Abstand zwischen den Eingaben unter dem Schwellenwert liegen, was eine effiziente Gesichts-Superauflösung ermöglicht Priors in vorab trainierten GAN-Modellen als generative Priors, um das Modell zur Gesichtswiederherstellung zu führen. Diese Methode besteht hauptsächlich aus einem Degradationsentfernungsmodul und einem Prior-Modul, das auf einem vorab trainierten GAN-Modell basiert eine latente Codeverbindung und mehrere Ebenen zur Konvertierung räumlicher Merkmale der Kanalsegmentierung

GPEN: Die Kernidee dieser Methode besteht darin, die Vorteile verschiedener Frameworks von GAN und DNN effektiv zu integrieren, um eine effiziente Gesichtswiederherstellung zu erreichen. GPEN lernt zunächst ein GAN-Modell zum Generieren hochwertiger Gesichtsbilder, bettet dieses vorab trainierte GAN-Modell dann als A-priori-Decoder ein und optimiert schließlich dieses tiefe Faltungsnetzwerk, um eine Gesichtserkennung zu erreichen. Nicht-prior-basierte Tiefenwiederherstellungsmethoden: (Nicht-prior-basierte Tiefenwiederherstellungsmethoden) Obwohl die meisten Gesichtswiederherstellungsmethoden, die auf tiefem Lernen basieren, mithilfe von Gesichts-Prioritäten zufriedenstellende Menschen wiederherstellen können, verlassen sich jedoch auf das Gesicht Priors erhöht die Kosten für die Erstellung von Gesichtsbildern etwas. Um dieses Problem zu lösen, zielt eine andere Methodenklasse darauf ab, ein End-to-End-Netzwerkmodell zu entwerfen, um die Zuordnungsfunktion zwischen Gesichtsbildern niedriger und hoher Qualität direkt zu erlernen, ohne zusätzliche Gesichtsbilder einzuführen. Zu den repräsentativen Arbeiten gehören: BCCNN: ein zweikanaliges Faltungs-Neuronales Netzwerkmodell für die Superauflösung von Gesichtern. Es besteht aus einem Merkmalsextraktor und einem Bildgenerator, wobei der Merkmalsextraktor robuste Gesichtsdarstellungen aus Gesichtsbildern mit niedriger Auflösung extrahiert und der Bildgenerator die extrahierte Gesichtsdarstellung adaptiv mit dem Eingabegesicht abgleicht. Die Bilder werden fusioniert, um ein hochauflösendes Bild zu erzeugen . HiFaceGAN: Diese Methode wandelt das Problem der Gesichtswiederherstellung in ein semantisch gesteuertes Generierungsproblem um und entwirft das HifaceGAN-Modell, um eine Gesichtswiederherstellung zu erreichen. Dieses Netzwerkmodell ist ein mehrstufiges Framework, das mehrere kooperative Hemmmodule und Ergänzungsmodule enthält. Dieses strukturelle Design verringert die Abhängigkeit des Modells von degenerierten Prioritäten oder Trainingsstrukturen. RestoreFormer: Dies ist eine End-to-End-Methode zur Gesichtswiederherstellung, die auf Transformer basiert. Es untersucht hauptsächlich den Vollraum-Aufmerksamkeitsmechanismus zur Modellierung von Kontextinformationen. Die Kernidee dieser Methode besteht hauptsächlich aus zwei Punkten. Der erste besteht darin, eine Multi-Head-Cross-Attention-Schicht vorzuschlagen, um die Interaktion zwischen beschädigten Abfragen und hochwertigen Schlüssel-Wert-Paaren im gesamten Raum zu lernen. Der zweite Punkt besteht darin, dass die Schlüssel-Wert-Paare im Aufmerksamkeitsmechanismus aus hochwertigen Wörterbüchern entnommen werden, die hochwertige Gesichtsmerkmale enthalten.Die folgende Abbildung fasst die Merkmale der auf Deep Learning basierenden Methoden zur Gesichtswiederherstellung in den letzten Jahren umfassend zusammen.

wobei „Einfach“ eine Tiefenwiederherstellungsmethode darstellt, die auf einem Nicht-Vorhergehenden basiert, „Gesichtskomponente“ und „Geometrischer Prior“ zwei Arten von Tiefenwiederherstellungsmethoden darstellen, die auf einem geometrischen Vorhergehenden basieren, und „Referenz-Priorit“ die Tiefe basierend auf einem Referenz-Vorhergehenden darstellt . Wiederherstellungsmethode, Generative Prior bedeutet eine nicht auf Prior basierende Tiefenwiederherstellungsmethode, Deep CNN, GAN und ViT bedeuten, dass das Modell ein tiefes Faltungs-Neuronales Netzwerk, ein generatives gegnerisches Netzwerk und eine Visual Transformer-Netzwerkstruktur verwendet.

Überprüfung der technologischen Entwicklung

Dieser Abschnitt gibt einen umfassenden Überblick über den technologischen Entwicklungsprozess von Methoden zur Gesichtswiederherstellung, die auf Deep Learning basieren. Er fasst und analysiert hauptsächlich die folgenden Aspekte: die grundlegende Architektur des Netzwerkmodells, die grundlegende Verwendung von Vom Modell verwendete Module, Verlustfunktionen und gesichtsbezogene Benchmark-Datensätze.

Netzwerkarchitektur

Die Netzwerkarchitektur bestehender Deep-Learning-basierter Gesichtswiederherstellungsmethoden ist hauptsächlich in drei Kategorien unterteilt: Methoden, die auf vorheriger Anleitung basieren, Methoden, die auf der GAN-Netzwerkstruktur basieren, und Methoden, die auf der ViT-Netzwerkstruktur basieren Verfahren. Daher diskutieren wir diese Entwicklungen in diesem Abschnitt.

Methoden basierend auf vorheriger Anleitung

Diese Art von Methode kann hauptsächlich in vier Typen unterteilt werden, nämlich die Gesichtswiederherstellungsmethode basierend auf der Vor-Vorher-Gesichtswiederherstellung (Vor-Vor-Gesichtswiederherstellungsmethode), die gemeinsame vorherige Schätzung und das Gesicht Wiederherstellungsmethode (Gelenk-Prior-Gesichtswiederherstellungsmethode), Gesichtswiederherstellungsmethode basierend auf einem Zwischen-Prior (Vor-Prior-Gesichtswiederherstellungsmethode), Gesichtswiederherstellungsmethode basierend auf einem Referenz-Prior (Referenz-Prior-Gesichtswiederherstellungsmethode).

Das prägnante Strukturdiagramm der oben genannten vier Methoden lautet wie folgt:

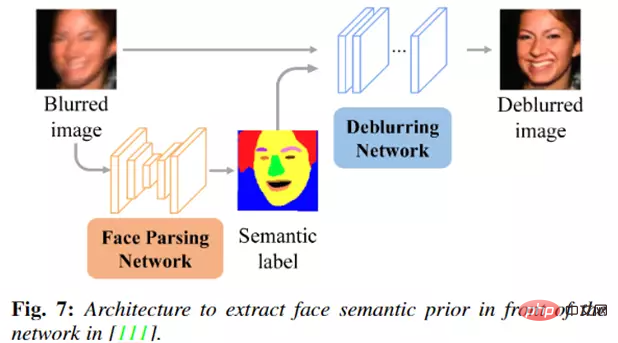

Gesichtswiederherstellungsmethoden, die auf Pre-Prior basieren, verwenden normalerweise zuerst ein Prior-Schätznetzwerk (z. B. Face-Prior-Schätznetzwerk oder Pre-Training). (Gesichts-GAN-Modell) schätzt Gesichtsprioritäten aus Eingabebildern geringer Qualität und nutzt dann ein Netzwerk, um anhand der Gesichtsprioritäten und Gesichtsbilder hochwertige Gesichter zu generieren.

Die typische Methode ist in der folgenden Abbildung dargestellt. Die Forscher haben ein Netzwerk zur Gesichtsanalyse entworfen, um zunächst semantische Gesichtsbezeichnungen aus den eingegebenen unscharfen Gesichtsbildern zu extrahieren und dann die unscharfen Bilder und semantischen Gesichtsbezeichnungen in einen Entunschärfealgorithmus einzugeben gleichzeitig zu vernetzen, um klare Gesichtsbilder zu erzeugen.

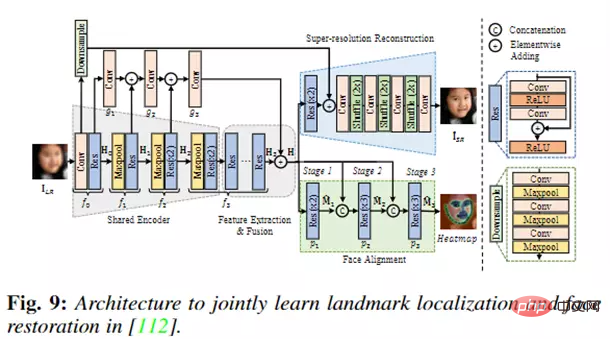

Die gemeinsame Methode zur vorherigen Schätzung und Gesichtswiederherstellung untersucht hauptsächlich die komplementäre Beziehung zwischen der Aufgabe zur vorherigen Schätzung des Gesichts und der Aufgabe zur Gesichtswiederherstellung. Diese Art von Methode trainiert normalerweise das Gesichtswiederherstellungsnetzwerk und das vorherige Schätzungsnetzwerk gemeinsam, sodass diese Art von Methode die Vorteile beider Teilaufgaben berücksichtigt, was die Leistung der Gesichtswiederherstellungsaufgabe direkt verbessern kann.

Die typische Methode ist in der folgenden Abbildung dargestellt. Die Forscher haben ein Netzwerkmodell vorgeschlagen, das Gesichtsausrichtung und Gesichts-Superauflösung kombiniert. Diese Methode schätzt gemeinsam die Orientierungspunktposition des Gesichts und das hochauflösende Gesichtsbild.

Die Kernidee der Gesichtswiederherstellungsmethode basierend auf dem Zwischen-Prior besteht darin, zunächst ein Wiederherstellungsnetzwerk zu verwenden, um ein grobes Gesichtsbild zu erzeugen, und dann die Gesichts-Prior-Informationen aus dem groben Bild abzuschätzen Dies ist effizienter als direkt. Genauere vorherige Informationen können aus eingegebenen Bildern mit geringer Qualität erhalten werden.

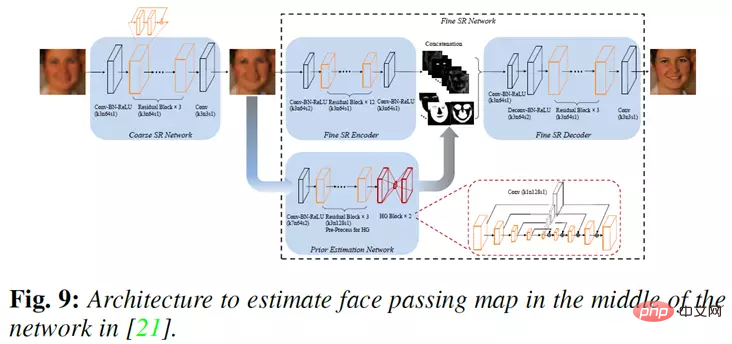

Die typische Methode ist in der folgenden Abbildung dargestellt. Die Forscher haben das FSRNet-Netzwerkmodell vorgeschlagen, das eine Face-Prior-Schätzung in der Mitte des Netzwerks durchführt.

Konkret verwendet FSRNet zunächst ein grobes SR-Netzwerk, um das Bild grob wiederherzustellen, und verwendet dann einen feinen SR-Encoder und ein vorheriges Schätzungsnetzwerk, um eine vorherige Schätzung und Verfeinerung des Bildes durchzuführen und vorherige Informationen werden gleichzeitig in einen feinen SR-Decoder eingegeben, um das Endergebnis wiederherzustellen.

Methoden basierend auf der GAN-Netzwerkstruktur

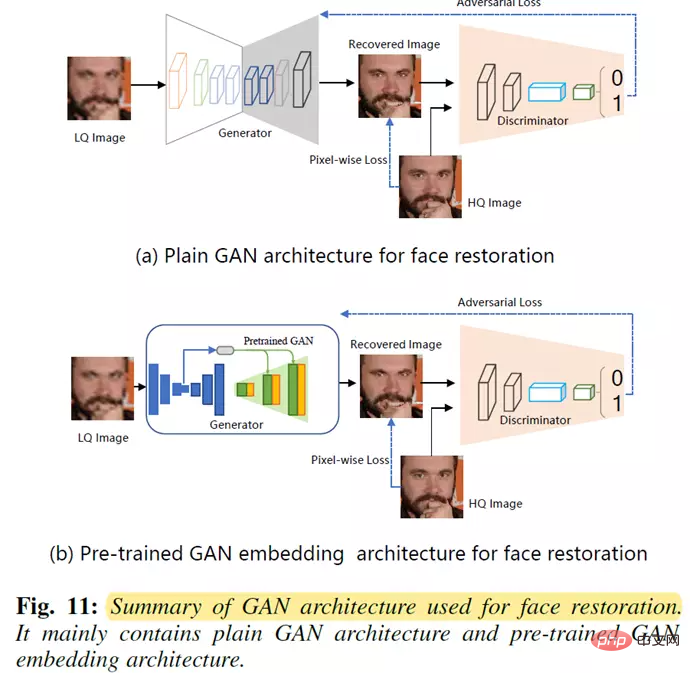

Dieser Methodentyp ist hauptsächlich in zwei Typen unterteilt: Methoden basierend auf der einfachen GAN-Architektur (Plain GAN-Methode) und Methoden basierend auf vorab trainierte GAN-Einbettungsmethode (vorab trainierte GAN-Einbettungsmethode).

Das prägnante Strukturdiagramm dieser beiden Methoden lautet wie folgt:

Methoden, die auf der gewöhnlichen GAN-Architektur basieren, führen normalerweise zu gegnerischen Verlusten im Netzwerkmodell und verwenden dann gegnerische Lernstrategien, um den Diskriminator und den Generator (Gesichtswiederherstellungsnetzwerk) gemeinsam zu optimieren und realistischere Gesichtsbilder zu erzeugen.

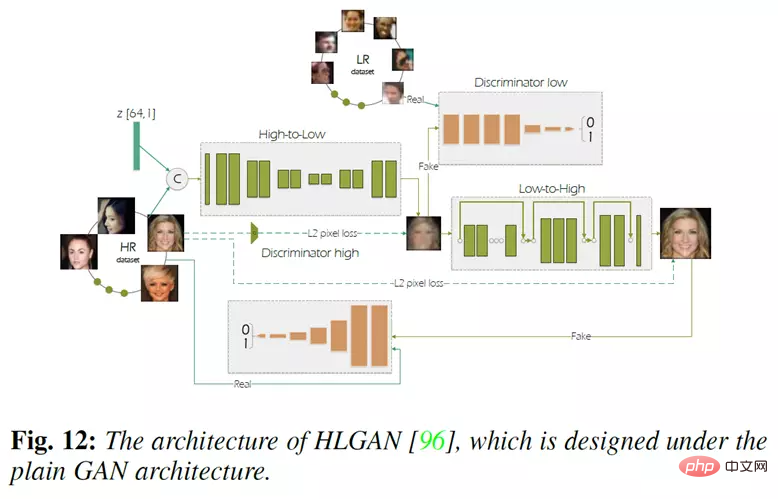

Die typische Methode ist in der folgenden Abbildung dargestellt. Die Forscher schlugen das HLGAN-Netzwerkmodell vor, das aus zwei generativen kontradiktorischen Netzwerken besteht.

Das erste ist das High-to-Low-GAN-Netzwerk, das ungepaarte Bilder zum Trainieren verwendet, um den Degradationsprozess hochauflösender Bilder zu lernen. Die Ausgabe des ersten Netzwerks (d. h. Gesichtsbilder mit niedriger Auflösung) wird verwendet, um das zweite Low-to-High-GAN-Netzwerk zu trainieren, um eine Superauflösung des Gesichts zu erreichen.

Die Kernidee der Methode, die auf der vorab trainierten GAN-Einbettungsstruktur basiert, besteht darin, das Potenzial im vorab trainierten Gesichts-GAN-Modell (z. B. StyleGAN) zu nutzen und dann zu verschmelzen potenzielle Prior-in-the-Face-Restaurierung Dabei wird mithilfe potenzieller Priors und kontradiktorischer Lernstrategien eine effiziente Gesichtsrestaurierung erreicht.

Die typische Methode ist in der folgenden Abbildung dargestellt. Die Forscher haben ein GFP-GAN-Modell entworfen, das hauptsächlich ein Degradationsentfernungsmodul und ein A-priori-Modul enthält, die auf dem vorab trainierten GAN-Modell basieren Code und mehrere Kanalsegmentierungsschichten zur räumlichen Merkmalstransformation für eine effiziente Informationsübertragung.

Methode basierend auf der ViT-Netzwerkstruktur

Vor kurzem hat die Visual Transformer (ViT)-Netzwerkarchitektur hervorragende Leistungen in Bereichen wie der Verarbeitung natürlicher Sprache und Computer Vision gezeigt, was auch Transformer inspiriert hat Anwendung der Architektur zur Bewältigung von Restaurierungsaufgaben.

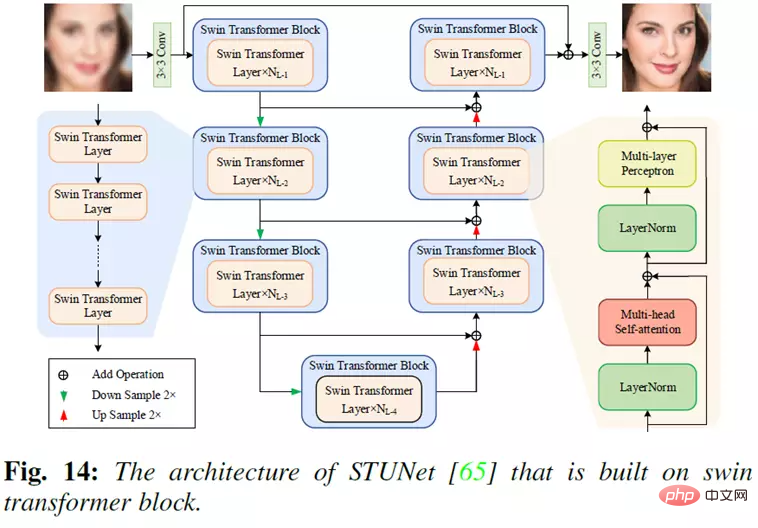

Die typische Methode ist in der folgenden Abbildung dargestellt. Basierend auf Swin Transformer schlugen Forscher ein End-to-End-Swin Transformer U-Net (STUNet)-Netzwerk für die Gesichtswiederherstellung vor.

In STUNet nutzt das Transformatormodul den Selbstaufmerksamkeitsmechanismus und die Shift-Window-Strategie, um dem Modell zu helfen, sich auf wichtigere Funktionen zu konzentrieren, die für die Wiederherstellung des Gesichts von Vorteil sind. Diese Methode hat eine gute Leistung erzielt.

Häufig verwendete Module in Netzwerkmodellen

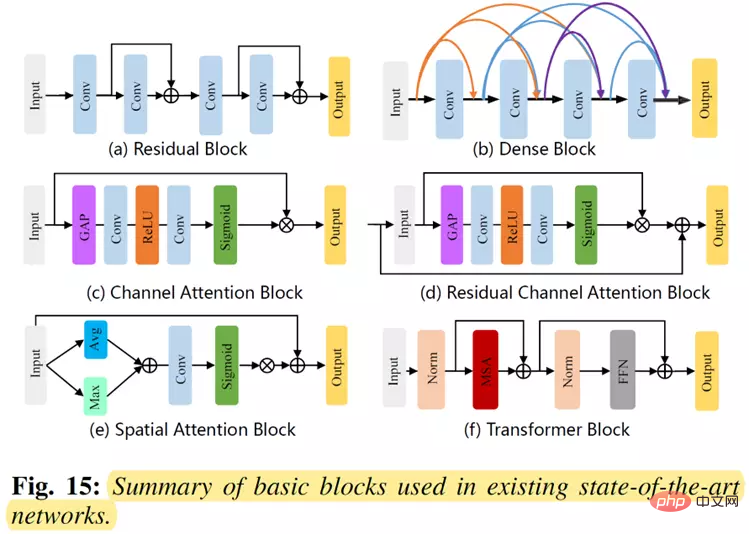

Im Bereich der Gesichtswiederherstellung haben Forscher verschiedene Arten von Basismodulen entwickelt, um leistungsstarke Netzwerke zur Gesichtswiederherstellung aufzubauen. Häufig verwendete Grundmodule sind in der folgenden Abbildung dargestellt. Zu diesen Grundmodulen gehören hauptsächlich das Restmodul (Restblock), das Dichtemodul (Dense Block), das Aufmerksamkeitsmodul (Kanalaufmerksamkeitsblock, der Restkanalaufmerksamkeitsblock, der räumliche Aufmerksamkeitsblock) und das Transformatormodul. (Transformatorblock).

Verlustfunktion

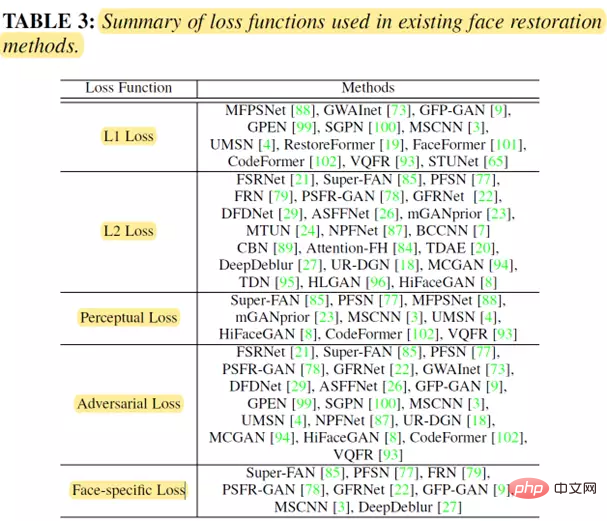

Übliche Verlustfunktionen bei Gesichtswiederherstellungsaufgaben umfassen hauptsächlich die folgenden Kategorien: Pixelweiser Verlust (hauptsächlich einschließlich L1- und L2-Verluste), Wahrnehmungsverlust, gegnerischer Verlust, gesichtsspezifisch Verlust. Verschiedene Gesichtswiederherstellungsmethoden und die von ihnen verwendeten Verlustfunktionen sind in der folgenden Tabelle zusammengefasst:

Datensatz

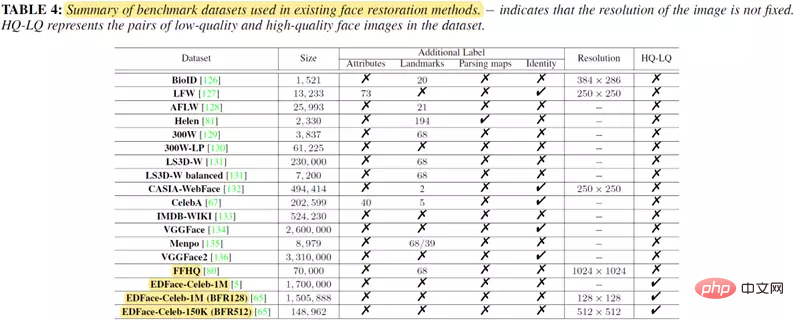

Die öffentlichen Datensätze und zugehörigen statistischen Informationen im Zusammenhang mit der Gesichtswiederherstellungsaufgabe werden wie folgt zusammengefasst: folgt:

Leistungsvergleich

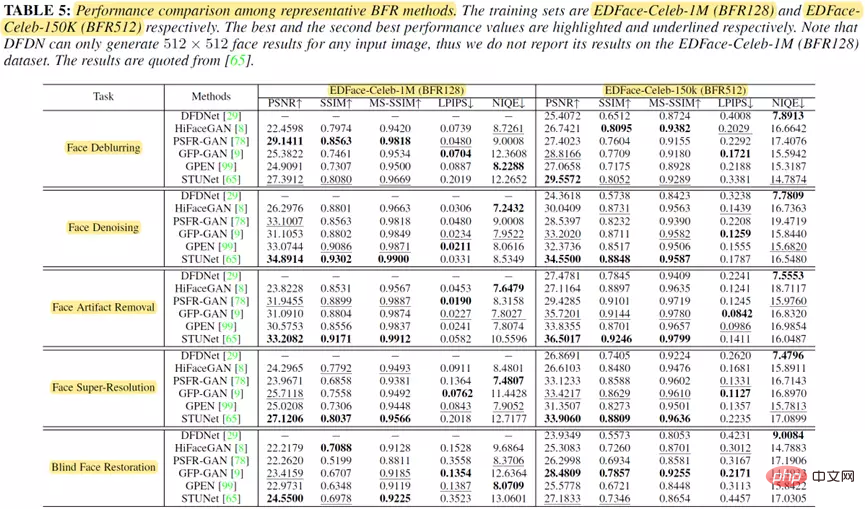

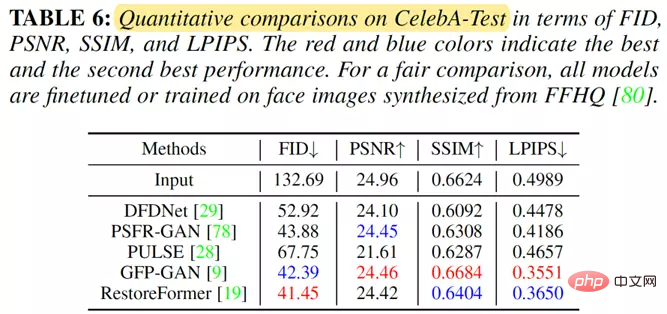

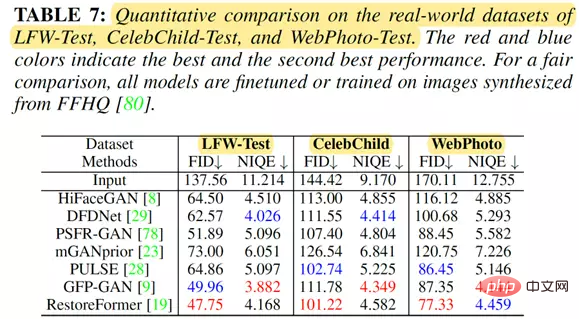

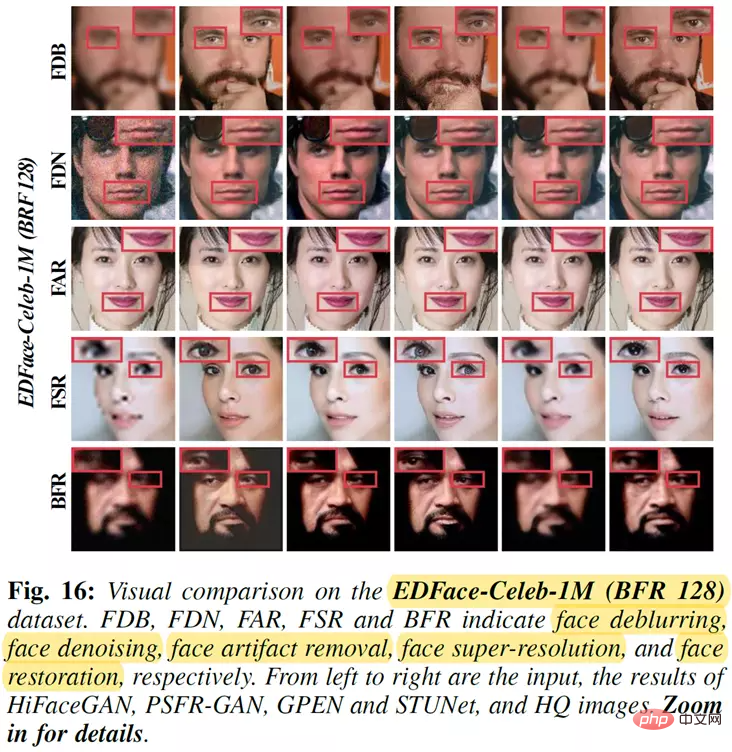

Dieser Artikel fasst die Leistung einiger repräsentativer Methoden zur Gesichtswiederherstellung in Bezug auf PSNR/SSIM/MS-SSIM/LPIPS/NIQE

zusammen und testet sie Vergleich quantitativer Ergebnisse

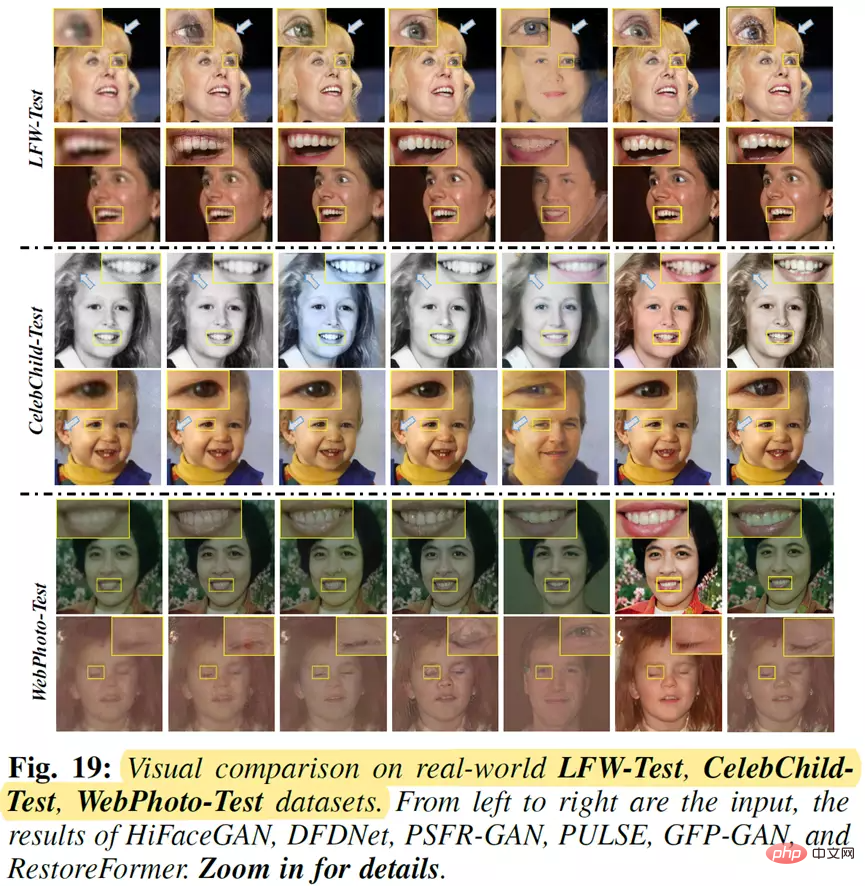

Qualitativer Ergebnisvergleich

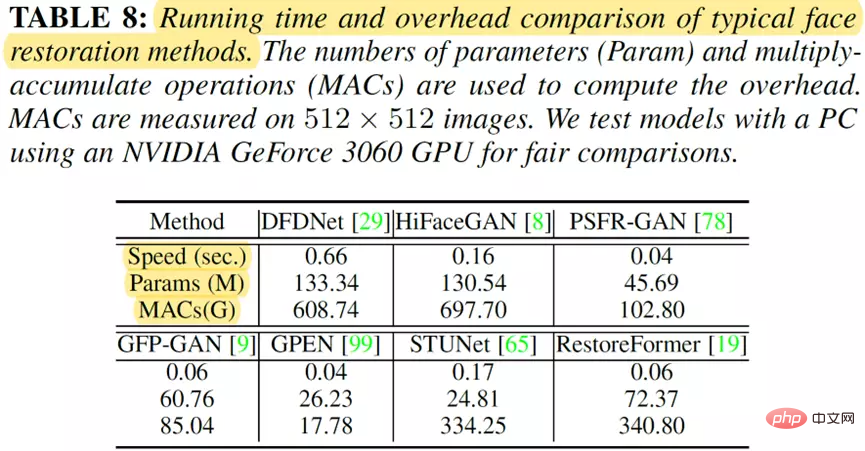

Methodenkomplexitätsvergleich

Zukünftige Entwicklungsrichtung

Obwohl basierend auf Deep Learning Face Die Sanierungsmethoden haben einige Fortschritte gemacht, aber es gibt immer noch viele Herausforderungen und ungelöste Probleme.

Netzwerkstrukturdesign

Bei Methoden zur Gesichtswiederherstellung, die auf Deep Learning basieren, kann die Netzwerkstruktur einen erheblichen Einfluss auf die Leistung der Methode haben.

Zum Beispiel weisen aktuelle Transformer-basierte Methoden aufgrund der leistungsstarken Funktionen der Transformer-Architektur häufig eine bessere Leistung auf. GAN-basierte Methoden können optisch ansprechendere Gesichtsbilder erzeugen.

Daher lohnt es sich beim Entwurf eines Netzwerks, von verschiedenen Strukturen wie CNN, GAN und ViT zu lernen und zu recherchieren.

Andererseits enthalten aktuelle Transformer-basierte Modelle normalerweise größere Parameter und erfordern höhere Rechenkosten, was ihre Bereitstellung in Edge-Geräten erschwert.

Daher ist die Frage, wie man ein leichtes Netzwerk mit leistungsstarker Leistung entwirft, eine weitere mögliche Forschungsrichtung für zukünftige Arbeiten.

Die Verschmelzung von Gesichtspriorität und Netzwerk

Als Bildwiederherstellungsaufgabe in einem bestimmten Bereich können Gesichtsmerkmale für Gesichtswiederherstellungsaufgaben verwendet werden. Beim Entwerfen von Modellen zielen viele Methoden darauf ab, Gesichtsprioritäten zu nutzen, um realistische Gesichtsdetails wiederherzustellen.

Obwohl einige Methoden versuchen, geometrische Prioritäten, Gesichtskomponenten, generative Prioritäten oder 3D-Prioriten in den Prozess der Gesichtswiederherstellung einzuführen, ist es für diese Aufgabe immer noch eine vielversprechende Aufgabe, frühere Informationen sinnvoller in das Netzwerk zu integrieren.

Darüber hinaus ist die weitere Gewinnung neuer gesichtsbezogener Priors, wie Priors aus vorab trainierten GANs oder Datenstatistiken im Netzwerk, eine weitere Richtung dieser Aufgabe.

Verlustfunktion und Bewertungsindex

Für die Gesichtswiederherstellungsaufgabe sind die am häufigsten verwendeten Verlustfunktionen L1-Verlust, L2-Verlust, Wahrnehmungsverlust, gegnerischer Verlust und gesichtsspezifischer Verlust, wie in Tabelle 3 gezeigt.

Bestehende Methoden verwenden normalerweise keine einzelne Verlustfunktion, sondern kombinieren mehrere Verlustfunktionen mit entsprechenden Gewichten, um das Modell zu trainieren. Es ist jedoch unklar, wie eine sinnvollere Verlustfunktion zur Steuerung des Modelltrainings entworfen werden kann.

Daher wird in Zukunft erwartet, dass mehr Arbeiten nach genaueren Verlustfunktionen (z. B. universellen oder gesichtsaufgabengesteuerten Verlustfunktionen) suchen, um die Entwicklung der Gesichtswiederherstellungsaufgabe zu fördern. Darüber hinaus kann die Verlustfunktion die Bewertungsergebnisse des Modells direkt beeinflussen. Wie in den Tabellen 5, 6 und 7 gezeigt, erzielen L1-Verlust und L2-Verlust tendenziell bessere Ergebnisse in Bezug auf PSNR, SSIM und MS-SSIM.

Wahrnehmungsverlust und kontroverser Verlust führen tendenziell zu erfreulicheren Ergebnissen (d. h. zu hohen LPIPS-, FID- und NIQE-Werten). Daher ist die Entwicklung von Indikatoren, die sowohl menschliche als auch maschinelle Aspekte berücksichtigen können, um die Modellleistung vernünftiger zu bewerten, auch eine sehr wichtige Richtung für die Zukunft.

Rechenaufwand

Bestehende Gesichtswiederherstellungsmethoden verbessern normalerweise die Wiederherstellungsleistung, indem sie die Tiefe oder Breite des Netzwerks erheblich erhöhen, während der Rechenaufwand des Modells ignoriert wird.

Der hohe Rechenaufwand verhindert den Einsatz dieser Methoden in ressourcenbeschränkten Umgebungen, wie z. B. mobilen oder eingebetteten Geräten.

Wie in Tabelle 8 gezeigt, verfügt die hochmoderne Methode RestoreFormer beispielsweise über eine Rechenmenge von 72,37 Millionen Parametern und 340,80 G MACs, was ihre Bereitstellung in realen Anwendungen sehr schwierig macht. Daher ist die Entwicklung von Modellen mit geringerem Rechenaufwand eine wichtige Zukunftsrichtung.

Benchmark-Datensatz

Im Gegensatz zu anderen Low-Level-Sehaufgaben wie Bildunschärfe, Bildrauschen und Bildenttrübung gibt es nur wenige Standardbewertungsbenchmarks für die Gesichtswiederherstellung.

Zum Beispiel werden die meisten Methoden zur Gesichtswiederherstellung normalerweise an privaten Datensätzen (synthetischer Trainingssatz von FFHQ) experimentiert.

Forscher könnten versucht sein, Daten zu verwenden, die gegenüber ihrer vorgeschlagenen Methode verzerrt sind. Um einen fairen Vergleich durchführen zu können, erfordert die Folgearbeit andererseits viel Zeit, um private Datensätze zu synthetisieren und andere Vergleichsmethoden neu zu trainieren. Darüber hinaus sind die in jüngster Zeit weit verbreiteten Datensätze oft klein und für Deep-Learning-Methoden ungeeignet.

Daher ist die Entwicklung von Standard-Benchmark-Datensätzen eine Richtung für die Aufgabe der Gesichtswiederherstellung. Wir gehen davon aus, dass Forscher in der Community in Zukunft mehr Standard- und qualitativ hochwertige Benchmark-Datensätze erstellen werden.

Video-Gesichtswiederherstellung

Mit der Beliebtheit mobiler Geräte wie Mobiltelefone und Kameras ist die Aufgabe der Video-Gesichtswiederherstellung immer wichtiger geworden. Die bestehenden Arbeiten konzentrieren sich jedoch hauptsächlich auf Bild-Gesichtswiederherstellungsaufgaben, während videobezogene Gesichtswiederherstellungsarbeiten weniger verbreitet sind.

Andererseits haben sich andere Low-Level-Vision-Aufgaben wie Video-Unschärfe, Video-Superauflösung und Video-Rauschunterdrückung in den letzten Jahren rasant entwickelt.

Daher ist die Video-Gesichtswiederherstellung eine mögliche Richtung für die Community. Die Aufgabe der Videogesichtswiederherstellung kann unter den folgenden zwei Gesichtspunkten betrachtet werden.

Zunächst können wir für den Benchmark-Datensatz die Erstellung eines hochwertigen Videodatensatzes für diese Aufgabe in Betracht ziehen, der das Design und die Bewertung videobezogener Algorithmen schnell fördern kann, was der Entwicklung der Gesichtswiederherstellungs-Community zugute kommt

Zweitens sollten wir für Videowiederherstellungsmethoden videobasierte Methoden zur Gesichtswiederherstellung entwickeln, indem wir die räumlichen und zeitlichen Informationen zwischen aufeinanderfolgenden Videobildern vollständig berücksichtigen.

Realistische Gesichtswiederherstellung und Anwendungen

Bestehende Methoden basieren auf synthetischen Daten, um Netzwerkmodelle zu trainieren. Allerdings zeigt das trainierte Netzwerk in realen Szenarien nicht unbedingt eine gute Generalisierungsfähigkeit.

Wie in Abbildung 19 dargestellt, funktionieren die meisten Methoden zur Gesichtswiederherstellung nicht gut, wenn sie mit realen Gesichtsbildern konfrontiert werden. Denn zwischen synthetischen Daten und realen Daten besteht eine große Datendomänenlücke.

Obwohl einige Methoden einige Lösungen zur Lösung dieses Problems eingeführt haben, wie z. B. unbeaufsichtigte Techniken oder das Erlernen echter Bildverschlechterungstechniken. Sie stützen sich jedoch immer noch auf einige spezifische Annahmen, dass alle Bilder eine ähnliche Verschlechterung aufweisen.

Daher bleiben reale Anwendungen eine herausfordernde Richtung für die Aufgabe der Gesichtswiederherstellung.

Darüber hinaus haben einige Methoden gezeigt, dass die Gesichtswiederherstellung die Leistung nachfolgender Aufgaben wie Gesichtsverifizierung und Gesichtserkennung verbessern kann. Allerdings ist auch die Kombination der Gesichtswiederherstellungsaufgabe mit diesen Aufgaben in einem Rahmen eine zukünftige Forschungsrichtung. Weitere verwandte Aufgaben , Farbverbesserung und Restaurierung alter Fotos.

Zum Beispiel zielt die Gesichtswiederherstellung darauf ab, fehlende Bereiche eines Gesichtsbildes durch Abgleichen oder Lernen wiederherzustellen. Es muss nicht nur semantisch neue Pixel für fehlende Gesichtskomponenten generieren, sondern auch die Konsistenz der Gesichtsstruktur und des Gesichtsaussehens aufrechterhalten. Bei der Restaurierung alter Fotos geht es um die Wiederherstellung alter Fotos, deren Beeinträchtigung sehr vielfältig und komplex ist (z. B. Rauschen, Unschärfe und Verblassen).

Darüber hinaus konzentrieren sich einige Aufgaben auf die Übertragung des Gesichtsstils, wie z. B. die Übersetzung von Angesicht zu Angesicht und die Analyse des Gesichtsausdrucks, die sich von Aufgaben zur Gesichtswiederherstellung unterscheiden.

Daher ist die Anwendung bestehender Gesichtswiederherstellungsmethoden auf diese damit verbundenen Aufgaben auch eine vielversprechende Richtung, die weitere Anwendungen auslösen kann.

Referenz: https://arxiv.org/abs/2211.02831

Das obige ist der detaillierte Inhalt vonWanzi Interpretations erste Rezension zu „Face Restoration'! Gemeinsam herausgegeben von NTU, Sun Yat-sen, Australian National University, Imperial College usw.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Können Online-Karten noch so sein? MapTracker: Nutzen Sie Tracking, um das neue SOTA von Online-Karten zu realisieren!

Apr 25, 2024 pm 05:01 PM

Können Online-Karten noch so sein? MapTracker: Nutzen Sie Tracking, um das neue SOTA von Online-Karten zu realisieren!

Apr 25, 2024 pm 05:01 PM

Wie oben geschrieben und nach persönlichem Verständnis des Autors ermöglicht dieser Algorithmus eine hochpräzise Online-Kartenerstellung. Unsere Methode MapTracker sammelt Sensorströme in Speicherpuffern für zwei Anzeigen: 1) Rasterlatenten im BEV-Raum (Bird's Eye View) und 2) Vektorlatenten auf Straßenelementen (d. h. Zebrastreifen, Fahrspurlinien und Straßengrenzen). Die Methode stützt sich auf das Abfrageausbreitungsparadigma bei der Objektverfolgung, das die verfolgten Straßenelemente des vorherigen Frames explizit mit dem aktuellen Frame verknüpft und gleichzeitig eine Teilmenge von Speicherlatenzen mit Distanzschritten zum Open-Source-Link zusammenführt: https://map-tracker .github.io/ Zusammenfassend sind die Hauptbeiträge dieses Artikels wie folgt: Ein neuer

So fügen Sie während der Bearbeitung die Gesichter von Personen zum Video hinzu

Feb 23, 2024 pm 12:50 PM

So fügen Sie während der Bearbeitung die Gesichter von Personen zum Video hinzu

Feb 23, 2024 pm 12:50 PM

Es gibt eine sehr gute P-Bild-Funktion beim Bearbeiten. Wie fügt man also Gesichter zu Videos hinzu? Benutzer müssen das Material in die Timeline importieren, dann Keying auswählen, auf Smart Keying klicken, um eine kreisförmige Maske zu verwenden, und schließlich das Gesicht einfach ausschneiden . In dieser Einführung zum Hinzufügen von Gesichtern zu Videos erfahren Sie genau, wie Sie diese Funktion verwenden. Werfen Sie also einen Blick darauf. „Tutorial zur Verwendung von Videoausschnitten“ So fügen Sie per Videoausschnitt Gesichter zu Videos hinzu. Antwort: Sie müssen das Material auf die Timeline ziehen und dann das Gesicht mithilfe von Smart Keying ausschneiden. Spezifische Methoden: 1. Zuerst müssen Sie das Material importieren und es dann zur Timeline hinzufügen. 2. Klicken Sie oben rechts auf „Keying“. 3. Wählen Sie „Smart Keying“, suchen Sie die Maske und wählen Sie die kreisförmige Maske aus. 4. Zum Schluss graben Sie einfach den Kopf des Porträts aus.

Lesen Sie alle generativen SOTA-Modelle in einem Artikel: eine vollständige Übersicht über 21 Modelle in neun Kategorien!

May 02, 2023 pm 03:43 PM

Lesen Sie alle generativen SOTA-Modelle in einem Artikel: eine vollständige Übersicht über 21 Modelle in neun Kategorien!

May 02, 2023 pm 03:43 PM

In den letzten zwei Jahren gab es in der KI-Branche einen Anstieg der Veröffentlichung groß angelegter generativer Modelle, insbesondere nach der Open Source von StableDiffusion und der offenen Schnittstelle von ChatGPT, was die Begeisterung der Branche für generative Modelle weiter angeregt hat Modelle. Es gibt jedoch viele Arten von generativen Modellen, und wenn Sie nicht aufpassen, verpassen Sie möglicherweise Sota. Kürzlich haben Forscher der Päpstlichen Universität Comillas, Spanien, die neuesten Fortschritte in der KI in verschiedenen Bereichen umfassend untersucht Generative Modelle werden nach Aufgabenmodi und -feldern in neun Kategorien unterteilt und 21 im Jahr 2022 veröffentlichte generative Modelle zusammengefasst. Sie können die Entwicklung generativer Modelle sofort verstehen! Link zum Papier: https://arxiv.org/abs/2301.04655生

Mit Java implementierte Technologien und Anwendungen für gesichtsbezogene Aufgaben

Jun 18, 2023 pm 09:13 PM

Mit Java implementierte Technologien und Anwendungen für gesichtsbezogene Aufgaben

Jun 18, 2023 pm 09:13 PM

Mit der kontinuierlichen Entwicklung und Anwendung der Gesichtserkennungstechnologie spielt Java als weit verbreitete Programmiersprache in Unternehmens- und wissenschaftlichen Forschungsbereichen auch eine wichtige Rolle bei gesichtsbezogenen Aufgaben. In diesem Artikel wird die Implementierung der Gesichtserkennung mit Java vorgestellt Aufgabentechnologien und -anwendungen. Gesichtserkennung Die Gesichtserkennung ist die Grundlage der Gesichtserkennungstechnologie. Ihr Hauptzweck besteht darin, die Position eines Gesichts in einem Bild oder Video automatisch zu erkennen. Es gibt zwei Hauptmethoden zur Implementierung der Gesichtserkennung in Java: OpenCV und JavaCV. OpenCV ist eine auf einer C++-Bibliothek basierende Entwicklung

Die Zhejiang-Universität schlägt die neue SOTA-Technologie SIFU vor: Nur ein Bild kann ein hochwertiges 3D-Modell des menschlichen Körpers rekonstruieren

Jan 18, 2024 pm 02:15 PM

Die Zhejiang-Universität schlägt die neue SOTA-Technologie SIFU vor: Nur ein Bild kann ein hochwertiges 3D-Modell des menschlichen Körpers rekonstruieren

Jan 18, 2024 pm 02:15 PM

In vielen Bereichen wie AR, VR, 3D-Druck, Szenenaufbau und Filmproduktion sind hochwertige 3D-Modelle des bekleideten menschlichen Körpers sehr wichtig. Die Erstellung von Modellen mit herkömmlichen Methoden erfordert viel Zeit und erfordert spezielle Ausrüstung und Techniker. Stattdessen nutzen wir in unserem täglichen Leben meist unsere Handykameras oder Porträtfotos, die wir im Internet finden. Daher kann eine Methode, die ein 3D-Modell des menschlichen Körpers aus einem einzigen Bild genau rekonstruieren kann, die Kosten erheblich senken und den unabhängigen Erstellungsprozess vereinfachen. Vergleich der technischen Vorgehensweise früherer Methoden (links) und dieser Methode (rechts). Frühere Deep-Learning-Modelle, die für die 3D-Rekonstruktion des menschlichen Körpers verwendet werden, erfordern häufig drei Schritte: Extrahieren von 2D-Merkmalen aus Bildern, Übertragen von 2D-Merkmalen in den 3D-Raum und 3D-Merkmale. zur Rekonstruktion des menschlichen Körpers. Allerdings sind diese Methoden im 2D-Spezialbereich begrenzt

KI kann 82 % der Probleme in mathematischen Datenbanken nachweisen. Das neue SOTA wurde erreicht und basiert immer noch auf Transformer.

Apr 10, 2023 am 08:51 AM

KI kann 82 % der Probleme in mathematischen Datenbanken nachweisen. Das neue SOTA wurde erreicht und basiert immer noch auf Transformer.

Apr 10, 2023 am 08:51 AM

Es muss gesagt werden, dass Wissenschaftler in letzter Zeit besessen davon waren, KI-Matheunterricht zu erteilen. Nein, auch das Facebook-Team machte mit und schlug ein neues Modell vor, das die Demonstration von Theoremen vollständig automatisieren kann und deutlich besser als SOTA ist. Wissen Sie, je komplexer mathematische Theoreme werden, desto schwieriger wird es, sie allein durch menschliche Anstrengung zu beweisen. Daher ist der Einsatz von Computern zur Demonstration mathematischer Theoreme zu einem Forschungsschwerpunkt geworden. OpenAI hat zuvor ein auf diese Richtung spezialisiertes GPT-f-Modell vorgeschlagen, das 56 % der Probleme in Metamath demonstrieren kann. Die neueste, dieses Mal vorgeschlagene Methode kann diese Zahl auf 82,6 % erhöhen. Gleichzeitig sagen Forscher, dass diese Methode weniger Zeit in Anspruch nimmt und den Rechenverbrauch im Vergleich zu GPT-f auf ein Zehntel der ursprünglichen Zeit reduzieren kann. Katastrophe

So verwischen Sie Gesichter in Echtzeit mit Python

Apr 07, 2023 pm 04:43 PM

So verwischen Sie Gesichter in Echtzeit mit Python

Apr 07, 2023 pm 04:43 PM

Übersetzer |. Bugatti Review |. Chonglou Sie können Gesichtsunschärfe aus mehreren Gründen verwenden, um Gesichter in Videos oder Bildern auszublenden. Datenschutz- und Sicherheitsbedenken sind die Hauptgründe. Die meisten Video-Sharing-Plattformen und Videobearbeitungsprogramme verfügen über integrierte Gesichtsunschärfefunktionen. Mit den Bibliotheken Python, OpenCV und NumPy können Sie Ihr eigenes Programm zur Gesichtsunschärfe von Grund auf erstellen. 1. Richten Sie eine Umgebung ein. Um das Studium dieses Artikels abzuschließen, müssen Sie mit den Grundkenntnissen von Python vertraut sein und über ein grundlegendes Verständnis der Verwendung der NumPy-Bibliothek verfügen. Öffnen Sie eine beliebige Python-IDE, mit der Sie vertraut sind. Erstellen Sie eine virtuelle Umgebung, um die erforderlichen Bibliotheken zu installieren. Erstellen Sie eine neue Python-Datei. Gehen Sie zum Terminal und führen Sie die folgenden Befehle aus, um die erforderlichen Bibliotheken zu installieren.

Golang-Bildmanipulation: Erfahren Sie, wie Sie Bilder entfernen und wiederherstellen

Aug 19, 2023 am 10:51 AM

Golang-Bildmanipulation: Erfahren Sie, wie Sie Bilder entfernen und wiederherstellen

Aug 19, 2023 am 10:51 AM

Golang-Bildmanipulation: Erfahren Sie, wie Sie Bilder entfernen und wiederherstellen. Einführung: Im modernen Social-Media-Zeitalter werden Bilder überall verwendet. Manchmal müssen wir jedoch möglicherweise bestimmte Bearbeitungen am Bild durchführen, z. B. das Entfernen unnötiger Elemente oder das Wiederherstellen einiger geänderter oder beschädigter Bilder. In diesem Artikel erfahren Sie, wie Sie mit Golang Bilder entfernen und wiederherstellen. Bildentfernungsverarbeitung Unter Bildentfernungsverarbeitung versteht man das Entfernen bestimmter Elemente aus dem Bild, sodass sie nicht mehr im Bild erscheinen. Diese Funktion wird in einigen Anwendungen verwendet