Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

OpenAI-Forscher: So implementieren Sie überwachtes Lernen, wenn die Daten nicht ausreichen

OpenAI-Forscher: So implementieren Sie überwachtes Lernen, wenn die Daten nicht ausreichen

OpenAI-Forscher: So implementieren Sie überwachtes Lernen, wenn die Daten nicht ausreichen

Dieser Artikel stammt von Lei Feng.com. Wenn Sie ihn erneut drucken möchten, besuchen Sie bitte die offizielle Website von Lei Feng.com, um eine Genehmigung zu beantragen.

In realen Anwendungen sind Daten leicht zu erhalten, gekennzeichnete Daten sind jedoch selten.

Wenn bei einer überwachten Lernaufgabe das Problem unzureichender gekennzeichneter Daten auftritt, können im Allgemeinen die folgenden vier Lösungen in Betracht gezogen werden:

1. Vortraining + Feinabstimmung: Trainieren Sie zunächst eine groß angelegte unbeaufsichtigte Aufgabe Datenkorpus auf einem Vortraining leistungsstarker aufgabenunabhängiger Modelle (z. B. Vortraining eines Sprachmodells auf Freitext durch selbstüberwachtes Lernen oder Vortraining eines Visionsmodells auf unbeschrifteten Bildern), bevor eine kleine Menge beschrifteter Beispiele für nachgelagerte Aufgaben zur Feinabstimmung verwendet wird das Modell.

2. Halbüberwachtes Lernen: Gleichzeitiges Lernen aus beschrifteten und unbeschrifteten Proben. Forscher haben diese Methode verwendet, um zahlreiche Untersuchungen zu visuellen Aufgaben durchzuführen.

3. Aktives Lernen: Die Kosten für die Kennzeichnung sind hoch. Auch wenn das Kostenbudget begrenzt ist, hoffen wir, so viele Etikettendaten wie möglich zu sammeln. Aktives Lernen lernt, die wertvollsten unbeschrifteten Proben auszuwählen und diese Daten im anschließenden Erfassungsprozess zu sammeln, um dem Modell dabei zu helfen, den gewünschten Effekt so weit wie möglich mit begrenztem Budget zu erzielen.

4. Vortraining + automatische Generierung von Datensätzen: Mit einem leistungsstarken vorab trainierten Modell können mit dem Modell automatisch viel mehr beschriftete Proben generiert werden. Aufgrund des Erfolgs des Wenig-Schuss-Lernens erfreut sich diese Methode besonders im Sprachbereich großer Beliebtheit.

Dieser Artikel stellt die Methode des halbüberwachten Lernens umfassend vor. Der Autor ist OpenAI-Forscherin Lilian Weng. Blog-Adresse: https://lilianweng.github.io/

1 Was ist halbüberwachtes Lernen?

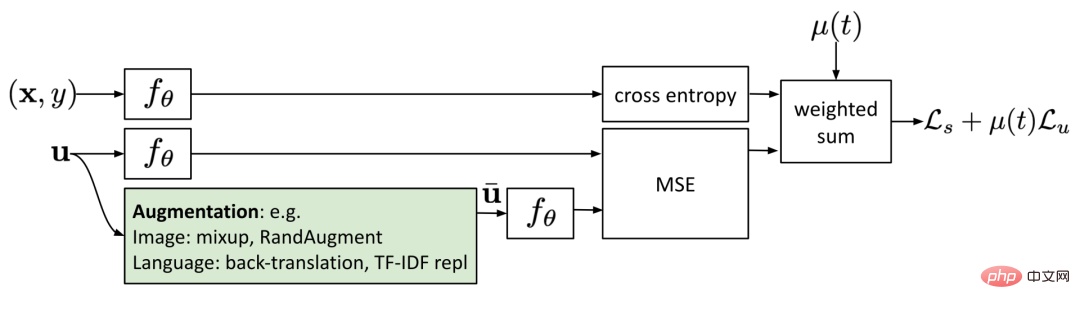

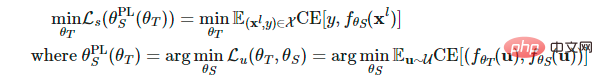

Halbüberwachtes Lernen verwendet sowohl beschriftete als auch unbeschriftete Daten, um das Modell zu trainieren. Interessanterweise konzentriert sich der Großteil der vorhandenen Literatur zum halbüberwachten Lernen auf Sehaufgaben. Die Methode „Vortraining + Feinabstimmung“ ist das gängigere Paradigma bei Sprachaufgaben. Die Verluste aller in diesem Artikel genannten Methoden bestehen aus zwei Teilen:  . Der Überwachungsverlust

. Der Überwachungsverlust lässt sich sehr einfach berechnen, wenn alle Proben beschriftete Proben sind. Wir müssen uns auf die Gestaltung unbeaufsichtigter Verluste konzentrieren

lässt sich sehr einfach berechnen, wenn alle Proben beschriftete Proben sind. Wir müssen uns auf die Gestaltung unbeaufsichtigter Verluste konzentrieren . Der gewichtete Term

. Der gewichtete Term  wählt normalerweise die Steigungsfunktion, wobei t die Anzahl der Trainingsschritte ist. Mit zunehmender Anzahl der Trainingszeiten nimmt der Anteil von

wählt normalerweise die Steigungsfunktion, wobei t die Anzahl der Trainingsschritte ist. Mit zunehmender Anzahl der Trainingszeiten nimmt der Anteil von  zu. Haftungsausschluss: Dieser Artikel deckt nicht alle halbüberwachten Methoden ab, sondern konzentriert sich nur auf die Optimierung der Modellarchitektur. Informationen zur Verwendung generativer Modelle und graphbasierter Methoden beim halbüberwachten Lernen finden Sie im Dokument „An Overview of Deep Semi-Supervised Learning“.

zu. Haftungsausschluss: Dieser Artikel deckt nicht alle halbüberwachten Methoden ab, sondern konzentriert sich nur auf die Optimierung der Modellarchitektur. Informationen zur Verwendung generativer Modelle und graphbasierter Methoden beim halbüberwachten Lernen finden Sie im Dokument „An Overview of Deep Semi-Supervised Learning“.

2 Symbol-Erklärungstabelle

Symbol |

Bedeutung |

|

Anzahl eindeutiger Tags. |

|

Label-Datensatz, wobei |

|

Unbeschrifteter Datensatz. |

|

Der gesamte Datensatz, einschließlich beschrifteter und unbeschrifteter Proben. |

|

kann unbeschriftete Proben oder beschriftete Proben darstellen. |

|

Verbesserte unbeschriftete Proben oder beschriftete Proben. |

|

i-te Probe. |

|

steht für Verlust, überwachten Verlust bzw. unbeaufsichtigten Verlust |

|

| Unbeaufsichtigtes Abnehmen, wobei die Anzahl der Trainingsschritte erhöht wird durch Erhöhung. |

|

Die bedingte Wahrscheinlichkeit der Kennzeichnung des Datensatzes angesichts der Eingabe. |

|

Das mit gewichtetem θ generierte neuronale Netzwerk ist das Modell, das voraussichtlich trainiert wird. |

|

Ein Vektor von Ausgabewerten der logischen Funktion f. |

|

Vorhergesagte Etikettenverteilung. Die Abstandsfunktion zwischen zwei Verteilungen, wie etwa mittlerer quadratischer Fehler, Kreuzentropie, KL-Divergenz usw. |

|

Lehrer Gleitende durchschnittlich gewichtete Hyperparameter für die Modellgewichte. |

|

α ist der Koeffizient der gemischten Stichprobe, |

|

Schärfen Sie die Temperatur der vorhergesagten Verteilung . |

|

Wählen Sie den Konfidenzschwellenwert für qualifizierte Vorhersageergebnisse aus. |

3 Annahmen

In der vorhandenen Forschungsliteratur werden die folgenden Annahmen diskutiert, um bestimmte Designentscheidungen in halbüberwachten Lernmethoden zu unterstützen.

Annahme 1: Glätteannahmen

Wenn zwei Datenproben in einem hochdichten Bereich des Merkmalsraums nahe beieinander liegen, sollten ihre Beschriftungen gleich oder sehr ähnlich sein.

Annahme 2: Clusterannahmen

Der Merkmalsraum weist sowohl dichte als auch spärliche Bereiche auf. Dicht gruppierte Datenpunkte bilden natürlicherweise Cluster. Proben im selben Cluster sollten die gleiche Bezeichnung haben. Dies ist eine kleine Erweiterung von Annahme 1. Annahme 3: Annahmen zur Trennung mit niedriger Dichte auf jeweils zwei Cluster, was zum Scheitern von Annahme 1 und Annahme 2 führt.

Annahme 4: Annahmen zur Mannigfaltigkeit

Hochdimensionale Daten befinden sich in der Regel auf niedrigdimensionalen Mannigfaltigkeiten. Obwohl Daten aus der realen Welt in sehr hohen Dimensionen beobachtet werden können (z. B. Bilder von Objekten/Szenen aus der realen Welt), können sie tatsächlich durch Mannigfaltigkeiten mit niedrigeren Dimensionen erfasst werden. Dabei werden bestimmte Eigenschaften der Daten erfasst und einige ähnliche Datenpunkte eng gruppiert (Bilder von realen Objekten/Szenen werden beispielsweise nicht aus einer gleichmäßigen Verteilung aller Pixelkombinationen abgeleitet). Dadurch kann das Modell eine effizientere Darstellungsmethode erlernen, um Ähnlichkeiten zwischen unbeschrifteten Datenpunkten zu entdecken und zu bewerten. Dies ist auch die Grundlage des Repräsentationslernens. Eine ausführlichere Erläuterung dieser Annahme finden Sie im Artikel „How to Understand Popular Assumptions in Semi-Supervised Learning“.

Link: https://stats.stackexchange.com/questions/66939/what-is-the-manifold-assumption-in-semi-supervised-learning

4 Konsistenz-Regularisierung)

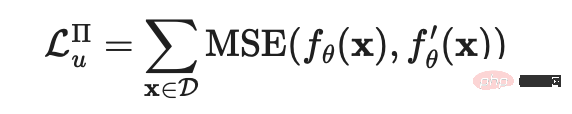

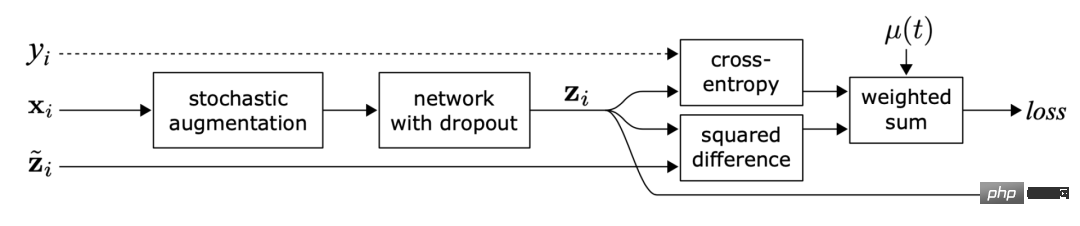

Konsistenz Bei der Regularisierung, auch Konsistenztraining genannt, wird davon ausgegangen, dass bei gleicher Eingabe Zufälligkeit im neuronalen Netzwerk (z. B. Verwendung des Dropout-Algorithmus) oder Datenerweiterungstransformation die Modellvorhersage nicht verändert. Jede Methode in diesem Abschnitt weist einen Konsistenz-Regularisierungsverlust auf:. Mehrere selbstüberwachte Lernmethoden wie SimCLR, BYOL und SimCSE haben diese Idee übernommen. Verschiedene erweiterte Versionen desselben Beispiels erzeugen dieselbe Darstellung. Die Forschungsmotivationen für das Cross-View-Training in der Sprachmodellierung und das Multi-View-Lernen beim selbstüberwachten Lernen sind dieselben. (1).Π-Modell

Sajjadi et al. schlugen in dem 2016 veröffentlichten Artikel „Regularization With Stochastic Transformations and Perturbations for Deep Semi-Supervised Learning“ einen unbeaufsichtigten Lernverlust vor, der durch zufällige Transformation (z. B. Dropout) zwei Versionen desselben Datenpunkts erzeugen kann , zufälliges maximales Pooling) und minimieren Sie die Differenz zwischen den beiden Ausgabeergebnissen nach dem Durchlaufen des Netzwerks. Dieser Verlust kann auf unbeschriftete Datensätze angewendet werden, da deren Beschriftungen nicht explizit verwendet werden. Laine und Aila gaben dieser Verarbeitungsmethode später in der 2017 veröffentlichten Arbeit „Temporal Ensembling for Semi-Supervised Learning“ einen Namen, der als Π-Modell bezeichnet wurde.  Unter diesen bezieht sich

Unter diesen bezieht sich  auf die Werte verschiedener zufälliger Verstärkungs- oder Dropout-Masken, die auf dasselbe neuronale Netzwerk angewendet werden. Dieser Verlust nutzt den gesamten Datensatz.

auf die Werte verschiedener zufälliger Verstärkungs- oder Dropout-Masken, die auf dasselbe neuronale Netzwerk angewendet werden. Dieser Verlust nutzt den gesamten Datensatz.

(2) Zeitliche Integration (Temporal ensembling)

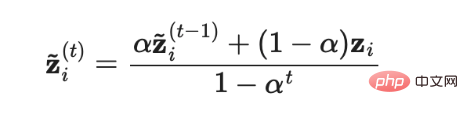

Abbildung 2: Übersicht über die zeitliche Integration. Sein Lernziel besteht darin, Etikettenvorhersagen für den exponentiellen gleitenden Durchschnitt (EMA) jeder Stichprobe zu treffen. (Bildquelle: Laine und Ailas Aufsatz „Sequential Integration of Semi-supervised Learning“ aus dem Jahr 2017)

DasΠ-Modell erfordert, dass jede Probe das neuronale Netzwerk zweimal durchläuft, was den Rechenaufwand verdoppelt. Um die Kosten zu senken, verwendet das zeitliche Ensemblemodell kontinuierlich den exponentiellen gleitenden Durchschnitt (EMA) der Echtzeit-Modellvorhersagen für jede Trainingsprobe  als Lernziel, und der EMA muss in jeder Iteration nur einmal berechnet und aktualisiert werden . Da die Ausgabe

als Lernziel, und der EMA muss in jeder Iteration nur einmal berechnet und aktualisiert werden . Da die Ausgabe  des sequentiellen Integrationsmodells auf 0 initialisiert wird, wird sie durch Division durch

des sequentiellen Integrationsmodells auf 0 initialisiert wird, wird sie durch Division durch  normalisiert, um diese Startverzerrung zu korrigieren. Aus dem gleichen Grund verfügt auch der Adam-Optimierer über einen solchen Bias-Korrekturterm.

normalisiert, um diese Startverzerrung zu korrigieren. Aus dem gleichen Grund verfügt auch der Adam-Optimierer über einen solchen Bias-Korrekturterm.  wobei

wobei  die Ensemblevorhersage in der t-ten Iteration und

die Ensemblevorhersage in der t-ten Iteration und  die Modellvorhersage in der aktuellen Runde ist. Es ist zu beachten, dass

die Modellvorhersage in der aktuellen Runde ist. Es ist zu beachten, dass  nach der Bias-Korrektur, da

nach der Bias-Korrektur, da  = 0, genau dem Modellvorhersagewert

= 0, genau dem Modellvorhersagewert  in der ersten Iteration entspricht.

in der ersten Iteration entspricht.

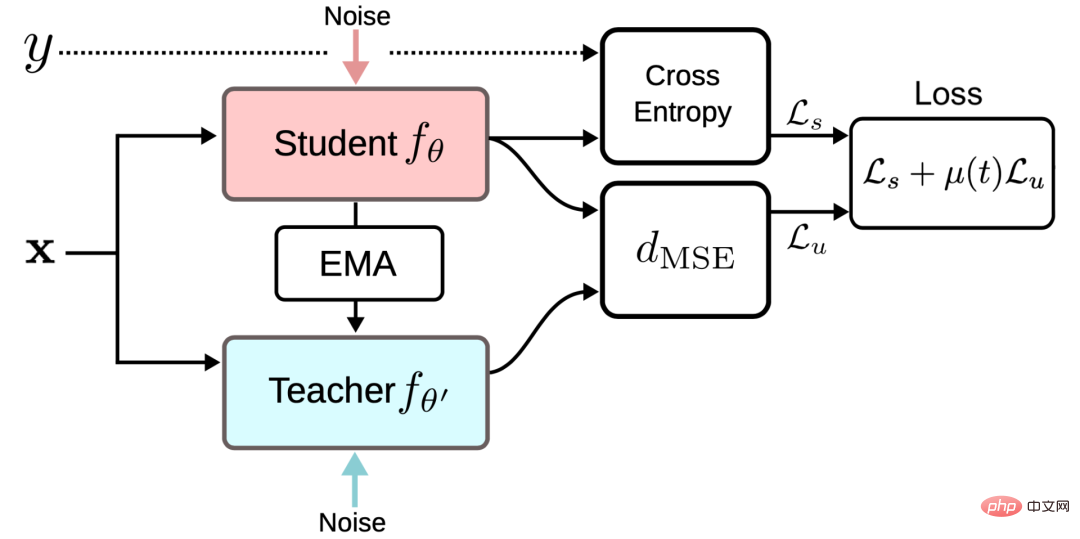

(3) Mean Teachers

Abbildung 3: Überblick über das Mean Teacher-Framework (Bildquelle: Tarvaninen und Valpolas 2017er Aufsatz „The Mean Teacher Model Is Better“) halbüberwachte Deep-Learning-Ergebnisse》)

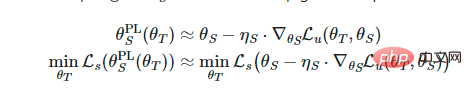

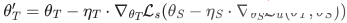

Das zeitliche Ensemblemodell verfolgt den exponentiellen gleitenden Durchschnitt der Label-Vorhersagen für jede Trainingsprobe als Lernziel. Allerdings ändert sich diese Label-Vorhersage nur bei jeder Iteration, was diesen Ansatz umständlich macht, wenn der Trainingsdatensatz groß ist. Um das Problem der langsamen Zielaktualisierungsgeschwindigkeit zu überwinden, veröffentlichten Tarvaninen und Valpola im Jahr 2017 den Artikel „Mittelmäßige Lehrer sind bessere Vorbilder: Gewichtete durchschnittliche Konsistenz, Zieloptimierung, halbüberwachte Deep-Learning-Ergebnisse“ (Mittelmäßige Lehrer sind bessere Vorbilder: Gewicht- (Gemittelte Konsistenzziele verbessern halbüberwachte Deep-Learning-Ergebnisse.) wird der Mean Teacher-Algorithmus vorgeschlagen, der das Ziel aktualisiert, indem er den gleitenden Durchschnitt der Modellgewichte anstelle der Modellausgabe verfolgt. Das ursprüngliche Modell mit einem Gewicht von θ wird als Student-Modell bezeichnet, und ein Modell, dessen Gewicht das gleitende Durchschnittsgewicht mehrerer aufeinanderfolgender Student-Modelle θ′ ist, wird als Mean Teacher-Modell bezeichnet:

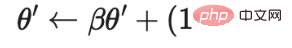

Der Konsistenz-Regularisierungsverlust ist der Abstand zwischen den Vorhersagen des Student-Modells und des Teacher-Modells, und dieser Abstand sollte minimiert werden. Das Mean Teacher-Modell kann genauere Vorhersagen liefern als das Student-Modell. Diese Schlussfolgerung wird im empirischen Experiment bestätigt, wie in Abbildung 4 dargestellt.

Abbildung 4: Klassifizierungsfehler des Π-Modells und des Mean-Teacher-Modells im SVHN-Datensatz. Das Mean Teacher-Modell (dargestellt durch die orange Linie) schneidet besser ab als das Student-Modell (dargestellt durch die blaue Linie). (Bildquelle: Tarvaninens und Valpolas Aufsatz aus dem Jahr 2017 „The Mean Teacher Model is a Better-Performing Exemplar Model: Weighted Average Consistency Objective Optimization Semi-supervised Deep Learning Results“)

Laut seiner Ablationsforschung:

- Eingabeverbesserungsmethoden (z. B. zufälliges Umdrehen von Eingabebildern, Gaußsches Rauschen) oder Dropout-Verarbeitung des Student-Modells sind erforderlich, damit das Modell eine gute Leistung erzielt. Im Lehrermodus ist keine Dropout-Verarbeitung erforderlich.

- Die Leistung reagiert empfindlich auf den Zerfallshyperparameter β des exponentiellen gleitenden Durchschnitts. Eine bessere Strategie besteht darin, in der Wachstumsphase einen kleineren β=0,99 und in der späteren Phase, wenn die Verbesserung des Student-Modells nachlässt, einen größeren β=0,999 zu verwenden.

- Es wurde festgestellt, dass der mittlere quadratische Fehler (MSE) der Konsistenzkostenfunktion eine bessere Leistung erbringt als andere Kostenfunktionen wie die KL-Divergenz.

(4) Verrauschte Proben als Lernziele verwenden

Mehrere neuere Methoden zum Konsistenztraining lernen, den Vorhersageunterschied zwischen der ursprünglichen unbeschrifteten Probe und der entsprechenden erweiterten Version zu minimieren. Diese Idee ist dem Π-Modell sehr ähnlich, aber sein Konsistenz-Regularisierungsverlust funktioniert nur bei unbeschrifteten Daten. Abbildung 5: Konsistenztraining mit verrauschten Proben Eingaben und trainiert das Modell, um gegen solche gegnerischen Angriffe robust zu sein.

Die Anwendungsformel dieser Methode beim überwachten Lernen lautet wie folgt:

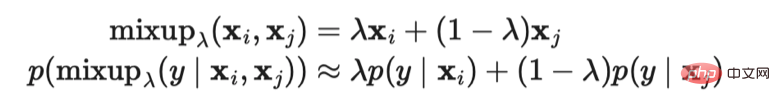

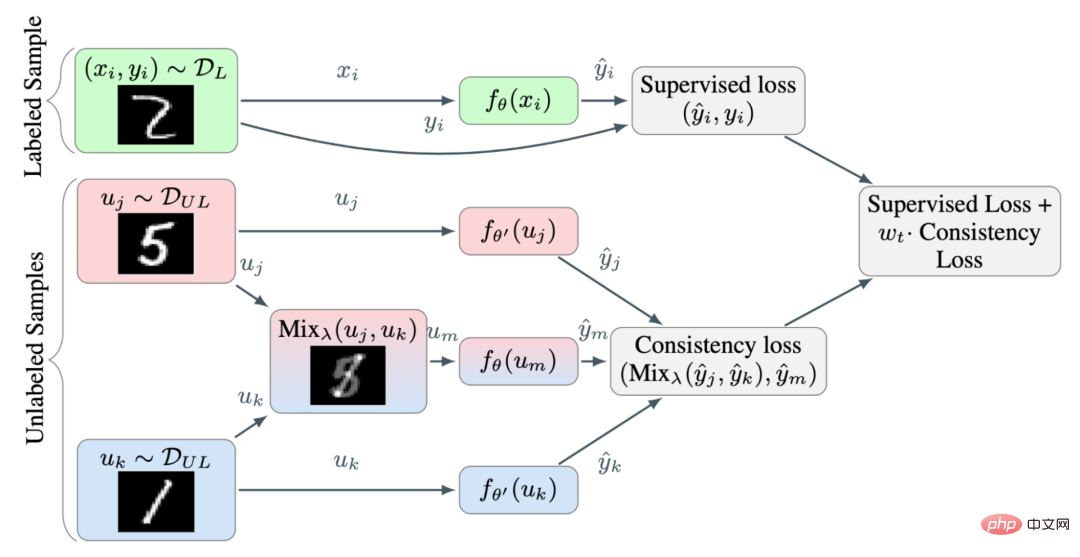

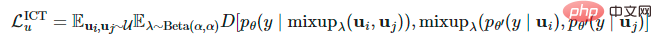

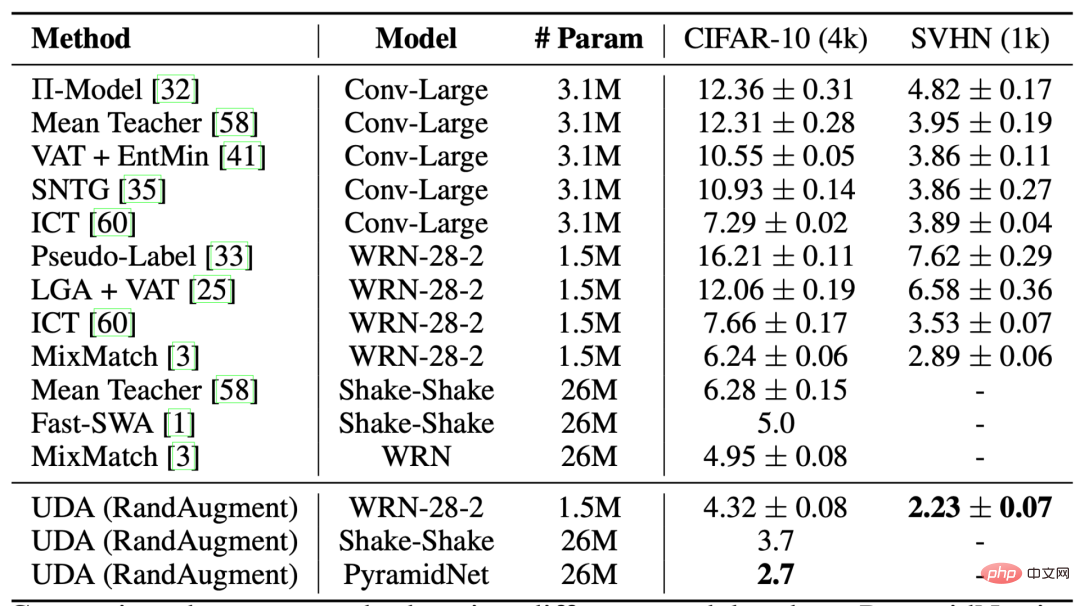

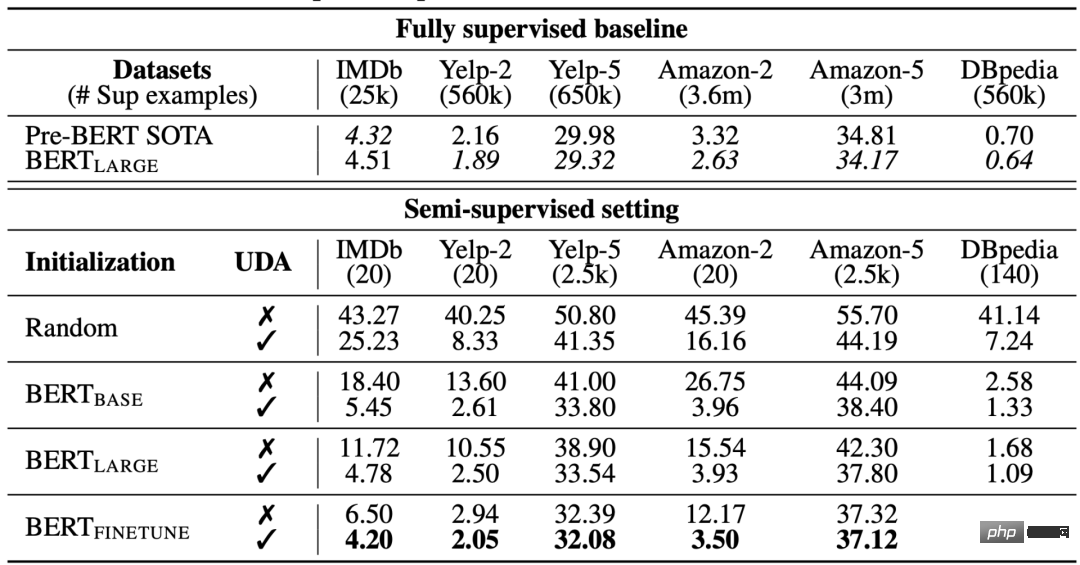

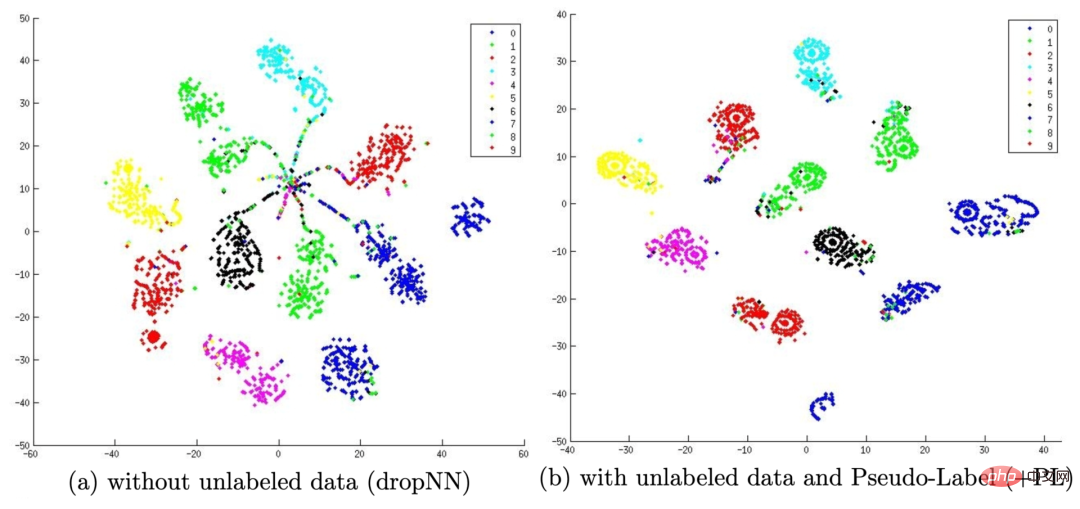

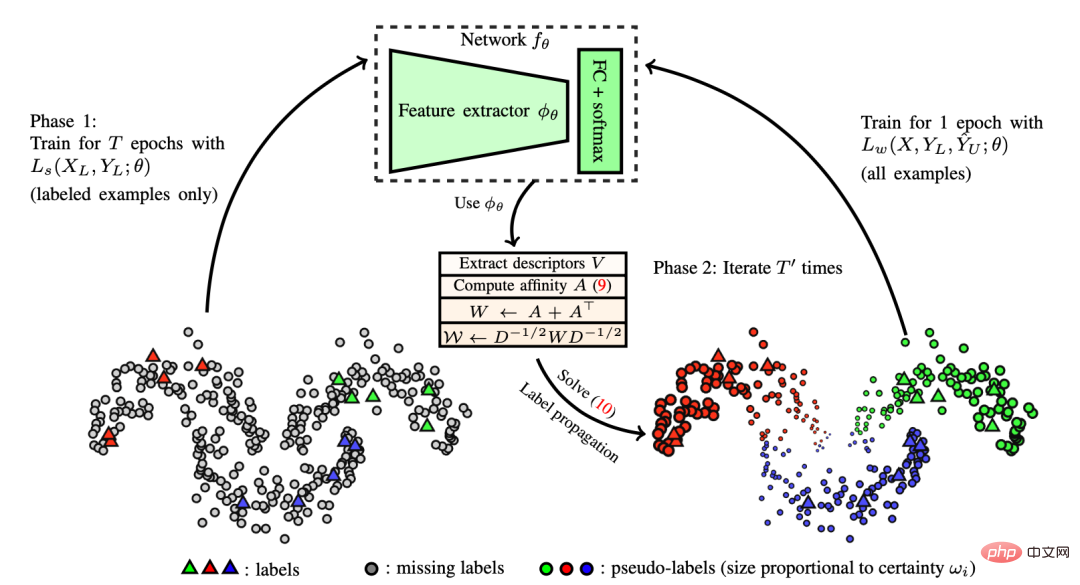

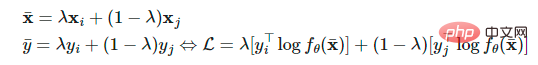

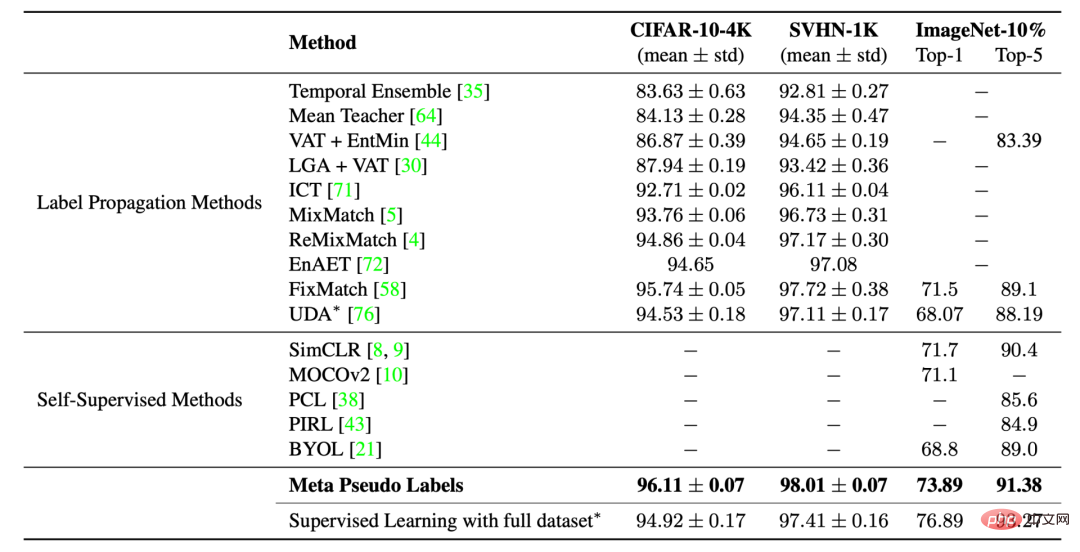

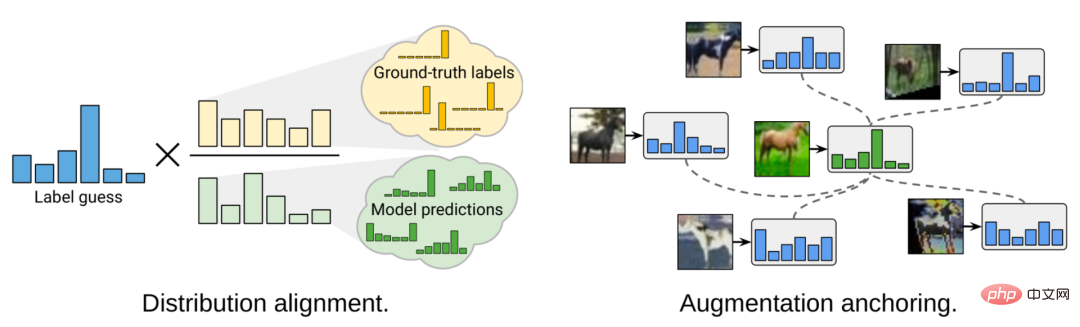

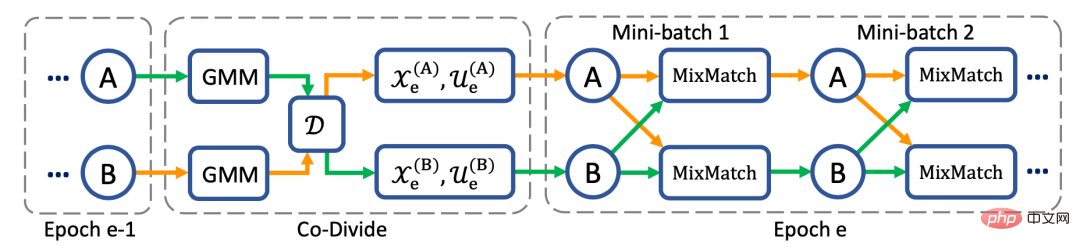

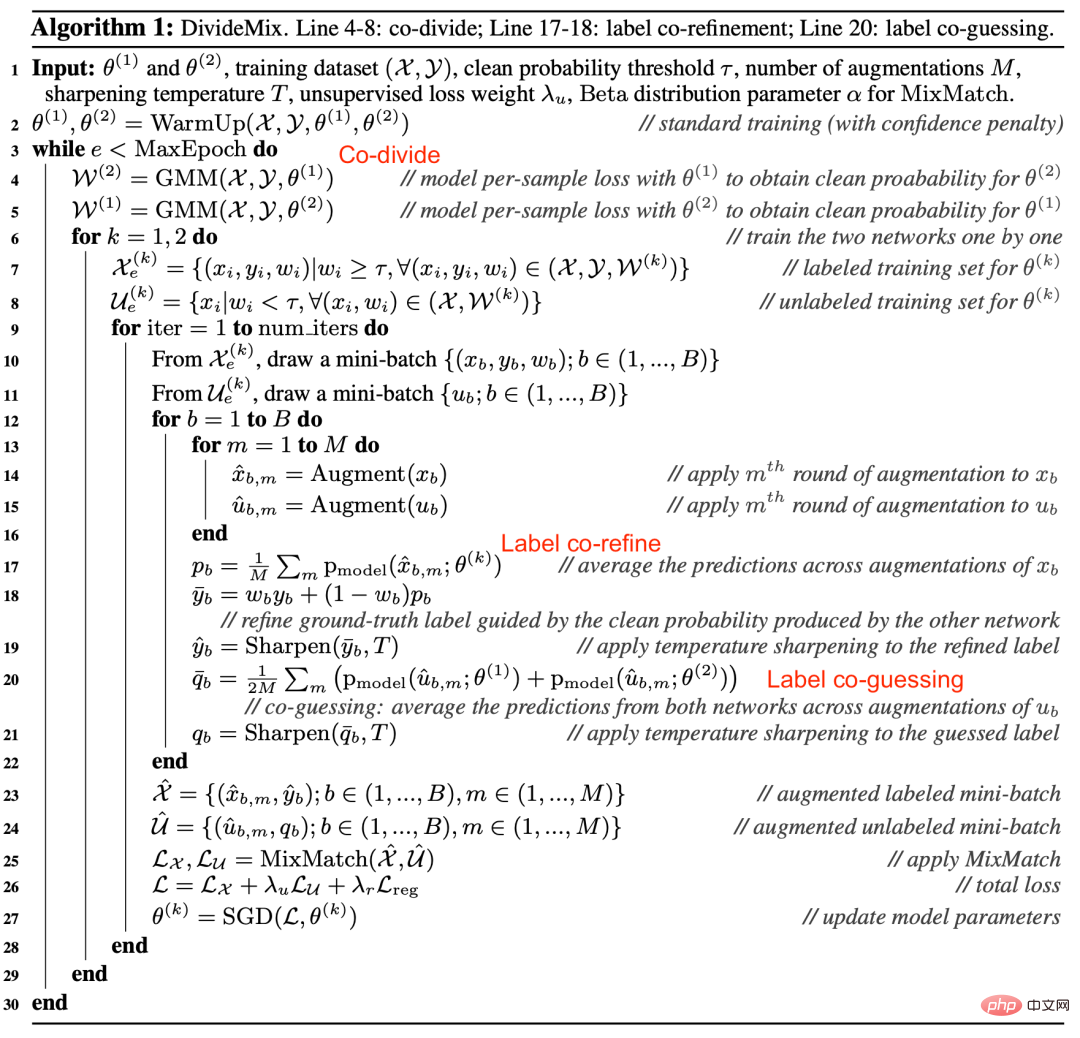

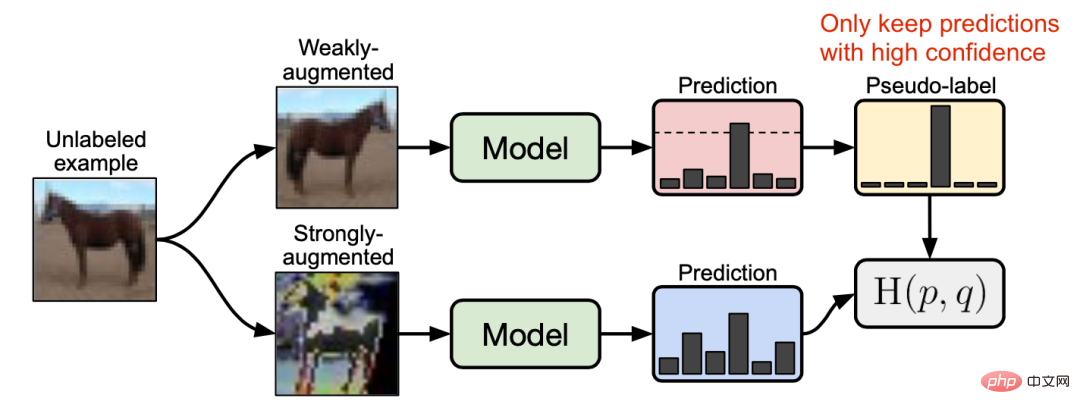

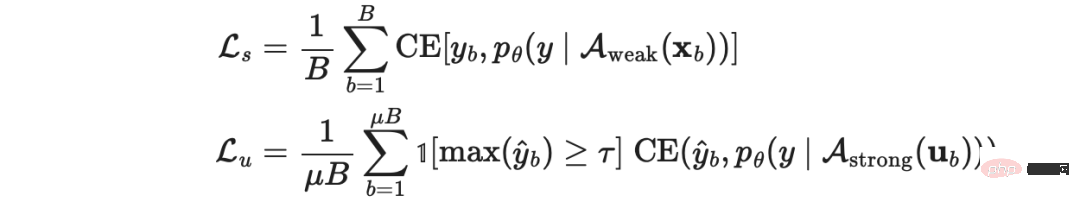

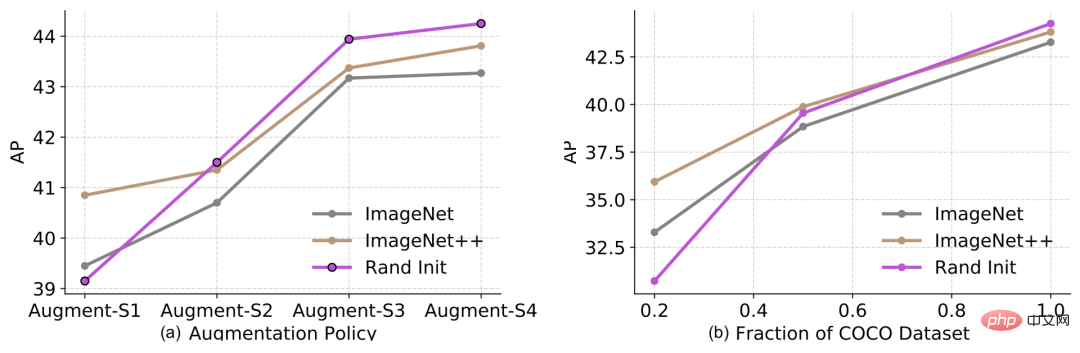

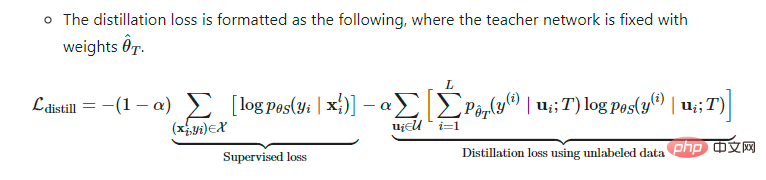

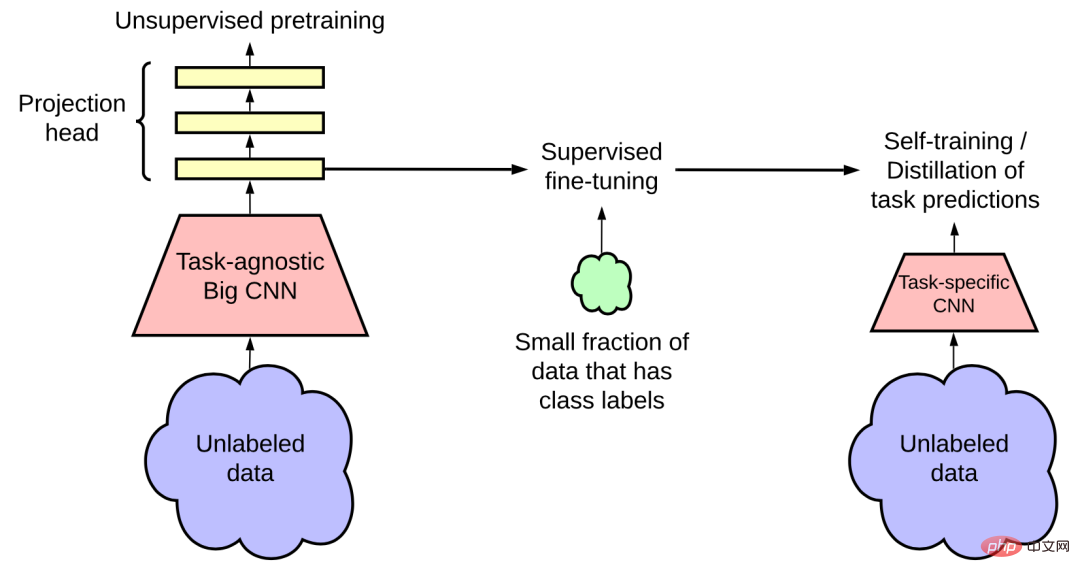

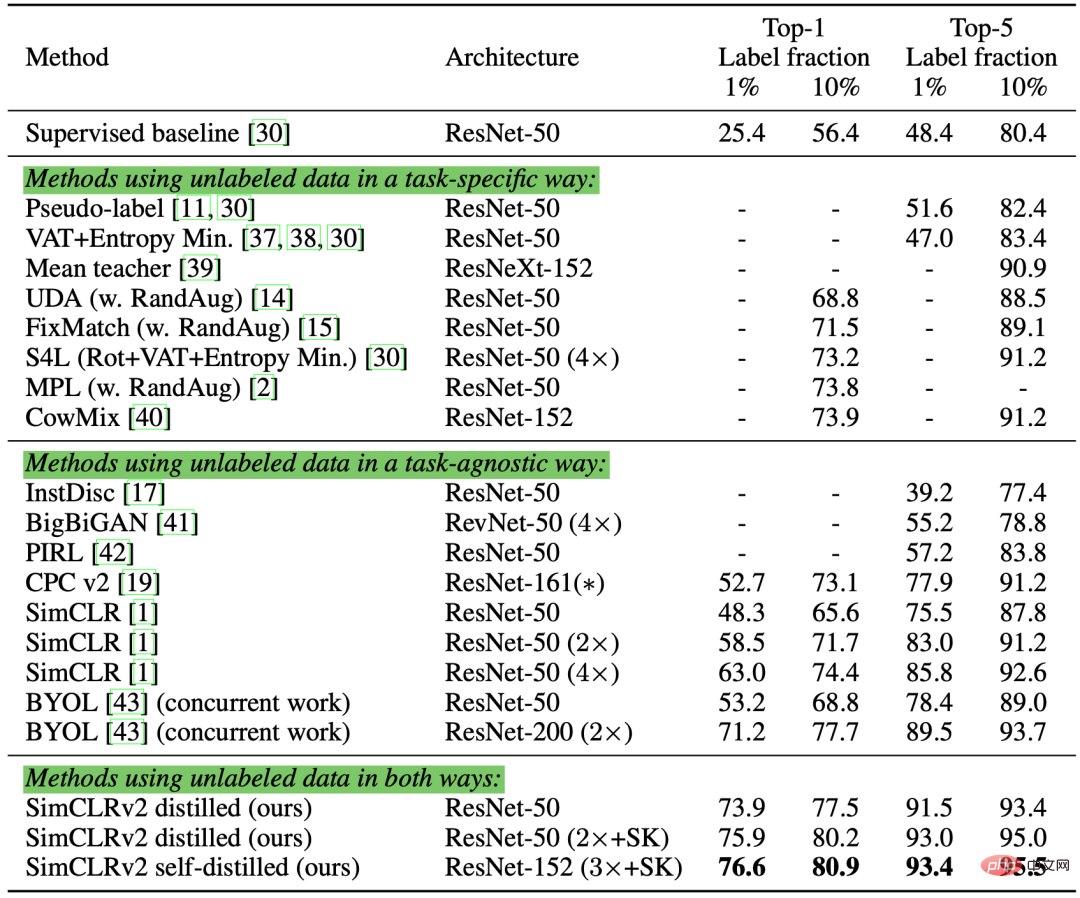

wobei Der Mehrwertsteuerverlust gilt sowohl für gekennzeichnete als auch für unbeschriftete Proben. Es berechnet die negative Glätte der Vorhersagemannigfaltigkeit des aktuellen Modells an jedem Datenpunkt. Durch die Optimierung dieses Verlusts kann die Vorhersagemannigfaltigkeit glatter werden. Verma et al. schlugen im Artikel „Interpolation Consistency Training for Semi-Supervised Learning“ aus dem Jahr 2019 vor, den Datensatz so zu stärken, dass die Modellvorhersagen und die Interpolation der entsprechenden Bezeichnungen gleich sind konsistent wie möglich. Hongyi Zhang et al. schlugen in der Arbeit „Mixup: Beyond Empirical Risk Minimization“ aus dem Jahr 2018 die MixUp-Methode vor, die zwei Bilder durch eine einfache gewichtete Summe mischt. Das Interpolationskonsistenztraining basiert auf dieser Idee und ermöglicht es dem Vorhersagemodell, Beschriftungen für eine gemischte Stichprobe zu generieren, die mit der vorhergesagten Interpolation der entsprechenden Eingabe übereinstimmen: wobei Abbildung 6: Übersicht über das Interpolationskonsistenztraining. Verwenden Sie die MixUp-Methode, um mehr Interpolationsbeispiele mit Interpolationsbezeichnungen als Lernziel zu generieren. (Bildquelle: Verma et al.s Artikel „Interpolation Consistency Training for Semi-supervised Learning“ aus dem Jahr 2019) Da die Wahrscheinlichkeit, dass zwei zufällig ausgewählte unbeschriftete Stichproben zu unterschiedlichen Kategorien gehören, sehr hoch ist (z 1000 in der ImageNet-Zielkategorie), sodass die Anwendung der Mixup-Methode zwischen zwei zufälligen unbeschrifteten Stichproben wahrscheinlich eine Interpolation nahe der Entscheidungsgrenze erzeugt. Nach der Low-Density-Separation-Hypothese liegen Entscheidungsgrenzen häufig in Gebieten mit geringer Dichte. wobei Für das Bildfeld verwendet UDA die RandAugment-Methode, die von Cubuk et al. im Artikel „RandAugment: Praktische automatisierte Datenerweiterung mit Vorschlag in einem reduzierten Suchraum“ vorgeschlagen wurde. Es tastet die in der Python-Bildverarbeitungsbibliothek PIL verfügbaren Erweiterungsoperationen einheitlich ab, ohne dass Lernen oder Optimierung erforderlich sind, und ist daher viel kostengünstiger als die Verwendung der AutoAugment-Methode. Abbildung 7: Vergleich verschiedener halbüberwachter Lernmethoden in der CIFAR-10-Klassifizierung. Beim Training an 50.000 Proben ohne RandAugment-Verarbeitung betragen die Fehlerraten von Wide-ResNet-28-2 und PyramidNet+ShakeDrop unter vollständiger Aufsicht **5,4** bzw. **2,7**. Für den Sprachbereich verwendet UDA eine Kombination aus Rückübersetzung und Wortersetzung basierend auf TF-IDF. Die Rückübersetzung behält die Bedeutung auf hoher Ebene bei, bestimmte Wörter selbst jedoch nicht, während die TF-IDF-basierte Wortersetzung nicht informative Wörter mit niedrigen TF-IDF-Werten entfernt. In Experimenten zu Sprachaufgaben stellten Forscher fest, dass UDA das Transferlernen und das Repräsentationslernen ergänzt. Beispielsweise kann die Feinabstimmung des BERT-Modells für unbeschriftete Daten in der Domäne (d. h. in Abbildung 8) die Leistung weiter verbessern. Abbildung 8: Vergleich unbeaufsichtigter Datenverbesserungsmethoden mit unterschiedlichen Initialisierungseinstellungen für verschiedene Textklassifizierungsaufgaben. (Bildquelle: Artikel „Unsupervised Data Augmentation for Consistency Training“ von Xie et al. aus dem Jahr 2020). Maskierung: Wenn die Vorhersagesicherheit der Stichprobe unter dem Schwellenwert liegt, wird sie maskiert. Schärfung der Vorhersageverteilung: Verwenden Sie niedrige Temperaturen ist die Verteilung der Schärftemperatur. Lee et al.s 2013 erschienene Arbeit „Pseudo-Label: The Simple and Efficient Semi-Supervised Pseudo-labeling“ wird in der Lernmethode für tiefe neuronale Netze vorgeschlagen, die unbeschrifteten Proben Pseudo-Label zuweist Basierend auf der maximalen Softmax-Wahrscheinlichkeit, die vom aktuellen Modell vorhergesagt wird, und trainiert das Modell dann gleichzeitig an markierten und nicht markierten Proben unter einer vollständig überwachten Einstellung. Abbildung 9: (a) zeigt die t-SNE-Visualisierungsergebnisse der Testausgabe auf dem MINIST-Testsatz nach dem Training des Modells mit nur 600 beschrifteten Daten, (b) zeigt die Verwendung von 600 beschrifteten Daten nach dem Training Das Modell mit 60.000 Pseudo-Labels unbeschrifteter Daten, die t-SNE-Visualisierungsergebnisse der Testausgabe werden auf dem MINIST-Testsatz getestet. Pseudo-Labels ermöglichen es dem erlernten Einbettungsraum, eine bessere Trennung zu erreichen. (Bildquelle: Die Arbeit von Lee et al. aus dem Jahr 2013 „Pseudo-Labeling: Eine einfache und effiziente halbüberwachte Lernmethode für tiefe neuronale Netze“) Das Training mit Pseudo-Labels ist natürlich ein iterativer Prozess. Hier wird das Modell, das Pseudobezeichnungen generiert, als Lehrermodell bezeichnet, und das Modell, das Pseudobezeichnungen zum Lernen verwendet, wird als Schülermodell bezeichnet. Iscen et al. schlugen in dem 2019 veröffentlichten Artikel „Label Propagation for Deep Semi-supervised Learning“ das Konzept der Label-Propagation vor Feature-Einbettungen. Die Pseudomarkierungen werden dann von bekannten Proben auf unbeschriftete Proben „verbreitet“, wobei die Ausbreitungsgewichte proportional zu den paarweisen Ähnlichkeitswerten im Diagramm sind. Vom Konzept her ähnelt es dem k-NN-Klassifikator, bei dem beide das Problem haben, dass sie sich nicht gut auf große Datensätze skalieren lassen. Abbildung 10: Schematische Darstellung des Funktionsprinzips der Etikettenweitergabe. (Bildquelle: Das 2019 von Iscen et al. veröffentlichte Papier „Label Propagation for Deep Semi-supervised Learning“) Selbsttraining ist kein neues Konzept, Scudder et al . In der 1965 veröffentlichten Arbeit „Probability of error of some adaptive Pattern-Recognition Machines“ veröffentlichten Nigram & Ghani et al. auf der CIKM 2000 die Arbeit „Analyse der Wirksamkeit und Anwendbarkeit von „Co-Training“ beinhaltet alle dieses Konzept. Es handelt sich um einen iterativen Algorithmus, der nacheinander die folgenden zwei Schritte ausführt, bis jede unbeschriftete Probe mit einer Beschriftung übereinstimmt: In dem 2020 von Xie et al. veröffentlichten Artikel „Selbsttraining mit Noisy Student verbessert die ImageNet-Klassifizierung“ wird Selbsttraining auf Deep Learning angewendet und es wurden großartige Ergebnisse erzielt. Bei der ImageNet-Klassifizierungsaufgabe trainierten die Forscher zunächst ein EfficientNet-Modell als Lehrermodell, um Pseudobezeichnungen für 300 Millionen unbeschriftete Bilder zu generieren, und trainierten dann ein größeres EfficientNet-Modell als Schülermodell, um echte beschriftete Bilder und Pseudobezeichnungen zu lernen. Ein Schlüsselelement in ihrem Versuchsaufbau ist die Hinzufügung von Rauschen während des Trainings des Student-Modells, während das Teacher-Modell während des Pseudo-Label-Generierungsprozesses kein Rauschen hinzufügt. Daher heißt ihre Methode „Noisy Student“, die Zufallstiefen-, Dropout- und RandAugment-Methoden verwendet, um dem Student-Modell Rauschen hinzuzufügen. Das Student-Modell schneidet besser ab als das Teacher-Modell, was vor allem auf die Vorteile des Hinzufügens von Rauschen zurückzuführen ist. Das zusätzliche Rauschen hat den verstärkenden Effekt, dass die vom Modell erzeugten Entscheidungsgrenzen sowohl für beschriftete als auch für unbeschriftete Daten geglättet werden. Es gibt mehrere andere wichtige technische Einstellungen für das Selbsttraining des Studentenmodells, darunter: Das Hinzufügen von Rauschen zum Student-Modell verbessert auch die gegnerische Robustheit gegenüber FGSM (schneller Gradientenzeichenangriff, der den Verlustgradienten der Eingabedaten nutzt und die Eingabedaten anpasst, um den Verlust zu maximieren), selbst wenn das Modell richtet sich nicht gegen Gegner. Robustheit optimieren. Du et al. haben in der Arbeit „Selbsttraining verbessert das Vortraining für das Verständnis natürlicher Sprache“ die SentAugment-Methode vorgeschlagen, die darauf abzielt, das Problem des Selbsttrainings im Sprachbereich zu lösen Unzureichende Etikettendaten in der Domäne. Es stützt sich auf Satzvektoren, um unbeschriftete domäneninterne Stichproben aus großen Korpora zu finden, und verwendet die abgerufenen Sätze zum Selbsttraining. Bestätigungsverzerrung ist das Problem der Bereitstellung falscher Pseudobezeichnungen, weil das Lehrermodell nicht ausgereift genug ist. Eine Überanpassung an die falschen Bezeichnungen führt möglicherweise nicht zu einem besseren Student-Modell. Um die Bestätigungsverzerrung zu reduzieren, schlugen Eric Arazo und andere im Artikel „Pseudo-Labeling and Confirmation Bias in Deep Semi-Supervised Learning“ zwei neue Methoden vor. Eine davon ist die Mixup-Methode unter Verwendung von Soft-Labels. Wenn Wenn zu wenige beschriftete Proben vorhanden sind, reicht die Verwendung der Mixup-Methode nicht aus. Daher haben die Autoren des Artikels eine Überabtastung der Etikettenproben durchgeführt, um eine Mindestanzahl an Etikettenproben in jeder Minicharge festzulegen. Dies funktioniert besser als die Gewichtskompensation für beschriftete Proben, da sie häufiger aktualisiert wird, statt seltener und größerer Aktualisierungen – die eigentlich instabiler sind. Wie die Konsistenzregulierung sind auch Datenerweiterungs- und Dropout-Methoden wichtig, um die Rolle von Pseudo-Labels zu spielen. Hieu Pham et al. schlugen im Papier „Meta Pseudo Labels“ von 2021 Meta-Pseudo-Labels vor und passten das Teacher-Modell kontinuierlich an, basierend auf dem Feedback des Student-Modells zu seiner Leistung im Label-Datensatz. Das Teacher-Modell und das Student-Modell werden gleichzeitig trainiert, das Teacher-Modell lernt, bessere Pseudo-Labels zu generieren, und das Student-Modell lernt aus den Pseudo-Labels. Setzen Sie die Gewichtungen des Teacher-Modells und des Student-Modells auf Allerdings ist die Optimierung der obigen Gleichung keine leichte Aufgabe. In Anlehnung an die Idee von MAML (Model-Agnostic Meta-Learnin) ähnelt es der Durchführung einer einstufigen Gradientenaktualisierung auf Aufgrund der Verwendung weicher Pseudoetiketten ist die obige Zielfunktion eine differenzierbare Funktion. Wenn jedoch harte Pseudobezeichnungen verwendet werden, handelt es sich um nicht differenzierbare Funktionen, sodass Methoden des verstärkenden Lernens wie REINFORCE erforderlich sind. Der Optimierungsprozess wird abwechselnd zwischen zwei Modellen durchgeführt: Abbildung 11: Leistungsvergleich von Meta-Pseudo-Labeling und anderen halbüberwachten oder selbstüberwachten Lernmethoden bei Bildklassifizierungsaufgaben. (Bildquelle: Hieu Pham et al.s 2021er Artikel „Meta Pseudo Labels“) kann die beiden Methoden der Konsistenzregularisierung und Pseudoetiketten kombinieren und auf halbüberwacht anwenden Lernen. Die von Berthelot et al. im Artikel „MixMatch: A Holistic Approach to Semi-Supervised Learning“ aus dem Jahr 2019 vorgeschlagene MixMatch-Methode ist ein ganzheitlicher Ansatz für halbüberwachtes Lernen, der unbeschriftete Daten verwendet durch die Integration folgender Methoden: Anhand eines Stapels beschrifteter Daten wobei Abbildung 12: Der „Label-Schätzungsprozess“ in MixMatch: Mittelung der mit K erweiterten unbeschrifteten Stichproben, Korrektur der vorhergesagten Randverteilung und schließlich Schärfung der Verteilung. (Bildquelle: Artikel von Berthelot et al. aus dem Jahr 2019 „MixMatch: A Holistic Method for Semi-supervised Learning“) Laut der Ablationsforschung dieses Artikels ist die MixUp-Verbesserung unbeschrifteter Daten besonders wichtig. Das Entfernen der Temperature Sharpening auf der Pseudo-Label-Verteilung kann die Leistung erheblich beeinträchtigen. Für die Etikettenschätzung ist auch die Berechnung des Durchschnitts mehrerer erweiterter Versionen unbeschrifteter Daten unerlässlich. Im Artikel „ReMixMatch: Semi-Supervised Learning with Distribution Alignment and Augmentation Anchoring“ aus dem Jahr 2020 schlugen Berthelot et al. die ReMixMatch-Methode weiter vor, indem sie die folgenden zwei neuen Mechanismen einführten zur Verbesserung der MixMatch-Methode: Abbildung 13: Darstellung zweier Verbesserungen der MixMatch-Methode durch die ReMixMatch-Methode. (Bildquelle: Artikel von Berthelot et al. aus dem Jahr 2020 „ReMixMatch: Halbüberwachtes Lernen mit Verteilungsausrichtung und verbesserter Verankerung“) 1. Diese Methode bringt die Randverteilung Es ist zu beachten, dass die Entropieminimierung kein sinnvolles Ziel ist, wenn die Randverteilung inkonsistent ist. Darüber hinaus ist die Annahme, dass die Klassenverteilungen auf beschrifteten und unbeschrifteten Daten übereinstimmen, tatsächlich zu absolut und unter realen Bedingungen möglicherweise nicht unbedingt korrekt. 2. Augmentationsverankerung. Bei einer unbeschrifteten Stichprobe wird zunächst eine schwach verbesserte „verankerte“ Version generiert und dann die CTAugment-Methode (Control Theory Augment) verwendet, um den Durchschnitt von K stark verbesserten Versionen zu berechnen. CTAugment prüft nur erweiterte Versionen des Talkback-Modells, deren Vorhersagen innerhalb der Toleranz des Netzwerks bleiben. ReMixMatch-Verlust besteht aus den folgenden Elementen: Junnan Li et al. schlugen die DivideMix-Methode in der Arbeit „DivideMix: Lernen mit lauten Etiketten als halbüberwachtes Lernen“ vor. Lernen mit lauten Etiketten, LNL). Es modelliert die Verlustverteilung jeder Probe durch ein Gaußsches Mischungsmodell (GMM), das die Trainingsdaten dynamisch in einen beschrifteten Datensatz mit sauberen Proben und einen unbeschrifteten Datensatz mit verrauschten Proben aufteilt. In Anlehnung an die Idee von Arazo et al. im Artikel „Unsupervised Label Noise Modeling and Loss Correction“ aus dem Jahr 2019 passen sie einen Kreuzentropieverlust an jedes binäre Gaußsche Mischungsmodell an . Es wird erwartet, dass saubere Proben schneller einen geringeren Verlust aufweisen als verrauschte Proben. Das Gaußsche Mischungsmodell mit kleinerem Mittelwert entspricht der Clusterung von Clean Labels, die hier als c bezeichnet wird. Wenn die A-Posteriori-Wahrscheinlichkeit des Gaußschen Mischungsmodells Der Prozess der Datenclusterung wird als Co-Divide bezeichnet. Um Bestätigungsverzerrungen zu vermeiden, trainiert die DividImax-Methode zwei gekreuzte Netzwerke gleichzeitig, wobei jedes Netzwerk einen separaten Teil des Datensatzes vom anderen Netzwerk verwendet, ähnlich wie Double Q-Learning funktioniert. Abbildung 14: DivideMix trainiert zwei Netzwerke unabhängig voneinander, um Bestätigungsfehler zu reduzieren. Die beiden Netzwerke führen gleichzeitig kollaborative Partitionierung, kollaborative Verfeinerung und kollaboratives Erraten durch. (Bildquelle: Artikel „DivideMix: Using Noisy Label Learning to Implement Semi-supervised Learning“ von Junnan Li et al. aus dem Jahr 2020) , und hat während des Trainings die folgenden Verbesserungen vorgenommen: Label-Co-Verfeinerung: Es kombiniert linear das Ground-Truth-Label mit der Netzwerkvorhersage , wobei Bedingungen, Durchschnitt mehrerer erweiterter Versionen. Label-Co-Rateing: Mittelt die Vorhersagen zweier Modelle anhand unbeschrifteter Datenproben. Abbildung 15: DivideMix-Algorithmus. (Bildquelle: Artikel von Junnan Li et al. aus dem Jahr 2020 „DivideMix: Using Noisy Label Learning to Implement Semi-supervised Learning“) Artikel von Sohn et al. aus dem Jahr 2020 „FixMatch: Verwendung von Konsistenz Die in „FixMatch: Simplifying Semi-Supervised Learning with Consistency and Confidence“ vorgeschlagene FixMatch-Methode generiert durch eine schwache Verbesserungsmethode Pseudoetiketten für unbeschriftete Proben und behält nur Vorhersagen mit hoher Konfidenz bei. Hier helfen sowohl eine schwache Verbesserung als auch eine Filterung mit hoher Konfidenz, qualitativ hochwertige, glaubwürdige Pseudo-Label-Ziele zu generieren. FixMatch sagt dann diese Pseudo-Labels anhand einer stark erweiterten Stichprobe voraus. Abbildung 16: Darstellung der Funktionsweise der FixMatch-Methode. (Bildquelle: Artikel von Sohn et al. aus dem Jahr 2020 „FixMatch: Vereinfachung halbüberwachten Lernens mithilfe von Konsistenz und Vertrauen“) Entscheidung Hyperparameter der relativen Größen von und . Schwache Verbesserung : Datenverbesserungsmethoden wie AutoAugment, Cutout, RandAugment und CTAugment. Laut der Ablationsstudie von FixMatch, Dieser Ansatz trainiert ein aufgabenunabhängiges Modell vorab anhand eines großen Korpus unbeaufsichtigter Daten durch selbstüberwachtes Lernen und trainiert das Modell dann anhand eines kleinen beschrifteten Datensatzes für nachgelagerte Aufgaben . Feinabstimmung, ein gängiges Paradigma, insbesondere bei Sprachaufgaben. Untersuchungen zeigen, dass Modelle zusätzliche Vorteile erzielen können, wenn sie halbüberwachtes Lernen mit Vortraining kombinieren. In der Arbeit „Rethinking Pre-training and Self-training“ von Zoph et al. aus dem Jahr 2020 wurde untersucht, wie viel effektiver Selbsttraining ist als Vortraining. Ihr Versuchsaufbau besteht darin, ImageNet für das Vortraining oder Selbsttraining zu verwenden, um die COCO-Ergebnisse zu verbessern. Es ist wichtig zu beachten, dass bei der Verwendung von ImageNet zum Selbsttraining Beschriftungen verworfen werden und ImageNet-Beispiele nur als unbeschriftete Datenpunkte verwendet werden. He Kaiming und andere haben in der Arbeit „Rethinking ImageNet Pre-Training“ aus dem Jahr 2018 bewiesen, dass die Wirkung des ImageNet-Klassifizierungs-Pre-Trainings nicht sehr gut ist, wenn die nachgelagerten Aufgaben (z. B. Zielerkennung) sehr unterschiedlich sind. Abbildung 18: (a) Ergebnisse der Datenerweiterung (von schwach nach stark) und (b) Einfluss der Etikettendatensatzgröße auf die Objekterkennungsleistung. In der Legende: „Rand Init“ stellt ein mit Zufallsgewichten initialisiertes Modell dar; „ImageNet“ wird mit einem vorab trainierten Modell mit einer Top-1-Genauigkeit von 84,5 % im ImageNet-Datensatz initialisiert; 1 Genauigkeitsrate von 84,5 % für den ImageNet-Datensatz -1 wird mit einem vorab trainierten Modell mit einer Genauigkeit von 86,9 % initialisiert. (Bildquelle: Aufsatz „Rethinking Pre-training and Self-Training“ von Zoph et al. aus dem Jahr 2020) Dieses Experiment ergab eine Reihe interessanter Erkenntnisse: In der Arbeit „Big Self-Supervised Models are Strong Semi-Supervised Learners“ aus dem Jahr 2020 (Big Self-Supervised Models are Strong Semi-Supervised Learners) schlugen Ting Chen et al. Schrittverfahren), das die Vorteile des selbstüberwachten Vortrainings, der überwachten Feinabstimmung und des Selbsttrainings kombiniert: 1 Verwenden Sie unbeaufsichtigte oder unterüberwachte Methoden, um ein großes Modell zu trainieren; .Führen Sie eine überwachte Feinabstimmung des Modells an einigen beschrifteten Beispielen durch, wobei die Verwendung eines großen (tiefen und breiten) neuronalen Netzwerks von entscheidender Bedeutung ist, denn je größer das Modell, desto besser die Leistung mit weniger beschrifteten Beispielen. 3. Verwenden Sie Pseudoetiketten im Selbsttraining, um unbeschriftete Beispiele zu destillieren. a. Das Wissen eines großen Modells kann in ein kleines Modell destilliert werden, da diese aufgabenspezifische Verwendung nicht die zusätzliche Kapazität der erlernten Darstellung erfordert. b Die Destillationsverlustformel lautet wie folgt, wobei das Lehrernetzwerk festgelegt ist und das Gewicht Abbildung 19: Rahmenwerk für halbüberwachtes Lernen verwendet labelfreies über aufgabenunabhängiges, unbeaufsichtigtes Vortraining (links) und aufgabenspezifisches Selbsttraining und Destillation (rechts) Datenkorpus. (Bildquelle: Artikel von Ting Chen et al. aus dem Jahr 2020 „Großmaßstäbliche selbstüberwachte Modelle sind leistungsstarke halbüberwachte Lernende“) Die Autoren des Artikels führten Experimente zur ImageNet-Klassifizierungsaufgabe durch. Das selbstüberwachte Vortraining nutzt SimCLRv2, eine direkte Verbesserung von SimCLR. Ihre Beobachtungen in der empirischen Studie bestätigten einige der von Zoph et al. im Jahr 2020 vorgeschlagenen Ergebnisse: Durch die Zusammenfassung neuerer halbüberwachter Lernmethoden können wir feststellen, dass viele Methoden zielgerichtet sind Zur Reduzierung der Bestätigungsverzerrung: Wenden Sie durch fortschrittliche Datenerweiterungsmethoden effektives und vielfältiges Rauschen auf Proben an.  die wahre Verteilung ist, eine One-Hot-Codierung, die sich dem Ground-Truth-Label annähert,

die wahre Verteilung ist, eine One-Hot-Codierung, die sich dem Ground-Truth-Label annähert,  die Modellvorhersage ist und

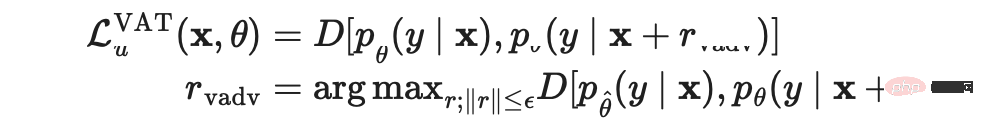

die Modellvorhersage ist und  die Distanzfunktion ist, die die Differenz zwischen den beiden Verteilungen berechnet. Miyato et al. schlugen in dem 2018 veröffentlichten Artikel „Virtual Adversarial Training: A Regularization Method for Supervised and Semi-Supervised Learning“ (Virtual Adversarial Training, VAT) ein virtuelles gegnerisches Training vor Bereich des halbüberwachten Lernens. Da

die Distanzfunktion ist, die die Differenz zwischen den beiden Verteilungen berechnet. Miyato et al. schlugen in dem 2018 veröffentlichten Artikel „Virtual Adversarial Training: A Regularization Method for Supervised and Semi-Supervised Learning“ (Virtual Adversarial Training, VAT) ein virtuelles gegnerisches Training vor Bereich des halbüberwachten Lernens. Da  unbekannt ist, ersetzt die Mehrwertsteuer den unbekannten Begriff durch die Vorhersage des aktuellen Modells der ursprünglichen Eingabe, wenn die aktuellen Gewichte auf

unbekannt ist, ersetzt die Mehrwertsteuer den unbekannten Begriff durch die Vorhersage des aktuellen Modells der ursprünglichen Eingabe, wenn die aktuellen Gewichte auf  eingestellt sind. Es ist zu beachten, dass

eingestellt sind. Es ist zu beachten, dass  ein fester Wert des Modellgewichts ist, sodass keine Gradientenaktualisierungen für

ein fester Wert des Modellgewichts ist, sodass keine Gradientenaktualisierungen für  durchgeführt werden.

durchgeführt werden.

den gleitenden Durchschnitt von θ von darstellt der Mean Teacher-Modellwert.

den gleitenden Durchschnitt von θ von darstellt der Mean Teacher-Modellwert.

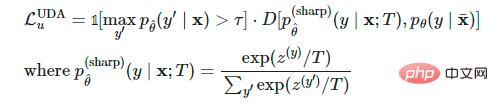

den gleitenden Durchschnitt von θ darstellt. Ähnlich wie bei der Mehrwertsteuer lernt die von Xie et al. im Artikel „Unsupervised Data Augmentation for Consistency Training“ aus dem Jahr 2020 vorgeschlagene Unsupervised Data Augmentation (UDA), unbeschriftete Stichproben zu liefern und dieselbe Ausgabe wie die erweiterte Stichprobe vorherzusagen. UDA konzentriert sich insbesondere auf die Untersuchung, wie sich die „Qualität“ von Lärm auf die Leistung von halbüberwachtem Lernen durch konsistentes Training auswirkt. Um aussagekräftige und effiziente Rauschproben zu generieren, ist der Einsatz fortschrittlicher Methoden zur Datenerweiterung von entscheidender Bedeutung. Eine gute Datenerweiterungsmethode sollte in der Lage sein, effizientes (d. h. Etiketten nicht änderndes) und vielfältiges Rauschen mit gezielten induktiven Vorspannungen zu erzeugen.

den gleitenden Durchschnitt von θ darstellt. Ähnlich wie bei der Mehrwertsteuer lernt die von Xie et al. im Artikel „Unsupervised Data Augmentation for Consistency Training“ aus dem Jahr 2020 vorgeschlagene Unsupervised Data Augmentation (UDA), unbeschriftete Stichproben zu liefern und dieselbe Ausgabe wie die erweiterte Stichprobe vorherzusagen. UDA konzentriert sich insbesondere auf die Untersuchung, wie sich die „Qualität“ von Lärm auf die Leistung von halbüberwachtem Lernen durch konsistentes Training auswirkt. Um aussagekräftige und effiziente Rauschproben zu generieren, ist der Einsatz fortschrittlicher Methoden zur Datenerweiterung von entscheidender Bedeutung. Eine gute Datenerweiterungsmethode sollte in der Lage sein, effizientes (d. h. Etiketten nicht änderndes) und vielfältiges Rauschen mit gezielten induktiven Vorspannungen zu erzeugen.

in Softmax, um die Vorhersagewahrscheinlichkeitsverteilung zu schärfen.

in Softmax, um die Vorhersagewahrscheinlichkeitsverteilung zu schärfen.

der Vorhersage-Konfidenzschwellenwert ist,

5 Pseudo-Labeling

5 Pseudo-Labeling

Warum funktionieren Pseudo-Tags? Pseudo-Labeling entspricht tatsächlich einer Entropie-Regularisierung, die die bedingte Entropie der Klassenwahrscheinlichkeit unbeschrifteter Daten minimiert und dadurch eine Trennung mit geringer Dichte zwischen Klassen erreicht. Mit anderen Worten: Die vorhergesagten Klassenwahrscheinlichkeiten berechnen tatsächlich die Klassenüberlappung, und die Minimierung der Entropie ist gleichbedeutend mit einer Reduzierung der Klassenüberlappung und damit der Dichtetrennung.

Warum funktionieren Pseudo-Tags? Pseudo-Labeling entspricht tatsächlich einer Entropie-Regularisierung, die die bedingte Entropie der Klassenwahrscheinlichkeit unbeschrifteter Daten minimiert und dadurch eine Trennung mit geringer Dichte zwischen Klassen erreicht. Mit anderen Worten: Die vorhergesagten Klassenwahrscheinlichkeiten berechnen tatsächlich die Klassenüberlappung, und die Minimierung der Entropie ist gleichbedeutend mit einer Reduzierung der Klassenüberlappung und damit der Dichtetrennung.

(1) Label-Propagation

(2) Selbsttraining

(3) Bestätigungsverzerrung reduzieren (Bestätigungsverzerrung)

zwei Stichproben und ihre entsprechenden echten Labels und Pseudo-Labels vorhanden sind, kann die Interpolations-Label-Gleichung in den Kreuzentropieverlust der Softmax-Ausgabe umgewandelt werden:

zwei Stichproben und ihre entsprechenden echten Labels und Pseudo-Labels vorhanden sind, kann die Interpolations-Label-Gleichung in den Kreuzentropieverlust der Softmax-Ausgabe umgewandelt werden:

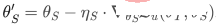

bzw.

bzw.  . Der Verlust des Student-Modells auf den beschrifteten Proben wird als Funktion von

. Der Verlust des Student-Modells auf den beschrifteten Proben wird als Funktion von

definiert und tendiert dazu, diesen Verlust durch die Optimierung des Teacher-Modells entsprechend zu minimieren .

definiert und tendiert dazu, diesen Verlust durch die Optimierung des Teacher-Modells entsprechend zu minimieren .

, während mehrstufige

, während mehrstufige

-Berechnungen durchgeführt werden.

-Berechnungen durchgeführt werden.

können wir über die Funktion Pseudoetiketten generieren

können wir über die Funktion Pseudoetiketten generieren  und mithilfe eines einstufigen stochastischen Gradientenabstiegs optimieren

und mithilfe eines einstufigen stochastischen Gradientenabstiegs optimieren  :

:  .

.  verwenden wir Aktualisierungen des Schülermodells zur Optimierung erneut

verwenden wir Aktualisierungen des Schülermodells zur Optimierung erneut  :

:  . Darüber hinaus werden UDA-Objekte auf das Teacher-Modell angewendet, um eine konsistente Regularisierung zu integrieren.

. Darüber hinaus werden UDA-Objekte auf das Teacher-Modell angewendet, um eine konsistente Regularisierung zu integrieren.

6 Konsistenzregularisierung + Pseudoetiketten

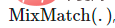

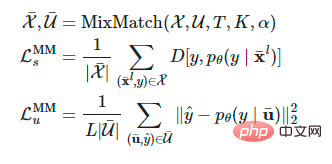

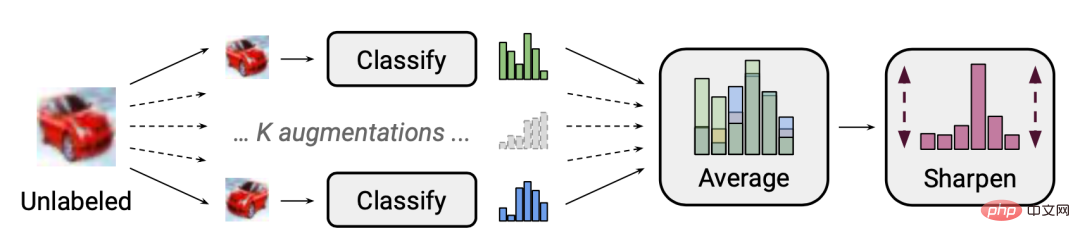

(1) MixMatch

und unbeschrifteter Daten

und unbeschrifteter Daten  wird die erweiterte Version durch die Operation

wird die erweiterte Version durch die Operation  erhalten.

erhalten.  und

und  repräsentieren jeweils die erweiterte Probe und die vorhergesagte Bezeichnung für die unbeschriftete Probe.

repräsentieren jeweils die erweiterte Probe und die vorhergesagte Bezeichnung für die unbeschriftete Probe.

die Schärfungstemperatur ist, die zur Reduzierung der geschätzten Etikettenüberlappung verwendet wird; K ist die Anzahl der erweiterten Versionen, die für jede unbeschriftete Probe generiert werden;

die Schärfungstemperatur ist, die zur Reduzierung der geschätzten Etikettenüberlappung verwendet wird; K ist die Anzahl der erweiterten Versionen, die für jede unbeschriftete Probe generiert werden;  ist ein Parameter in der MixMatch-Funktion. Für jedes

ist ein Parameter in der MixMatch-Funktion. Für jedes  generiert MixMatch K erweiterte Versionen,

generiert MixMatch K erweiterte Versionen,  entspricht k bis 1, ..., K erweiterte Versionen von

entspricht k bis 1, ..., K erweiterte Versionen von  , und das Modell errät die Pseudobezeichnung basierend auf dem Durchschnitt

, und das Modell errät die Pseudobezeichnung basierend auf dem Durchschnitt  .

.

nahe an die Randverteilung der Grundwahrheitsbezeichnungen. Sei

nahe an die Randverteilung der Grundwahrheitsbezeichnungen. Sei  die Klassenverteilung von Ground-Truth-Labels und

die Klassenverteilung von Ground-Truth-Labels und  der gleitende Durchschnitt der vorhergesagten Klassenverteilung für unbeschriftete Daten. Die Vorhersagen des Modells für unbeschriftete Proben

der gleitende Durchschnitt der vorhergesagten Klassenverteilung für unbeschriftete Daten. Die Vorhersagen des Modells für unbeschriftete Proben  werden auf

werden auf  normalisiert, um der wahren Randverteilung zu entsprechen.

normalisiert, um der wahren Randverteilung zu entsprechen.

(2) DivideMix

(d. h. die Wahrscheinlichkeit, dass die Probe zum sauberen Probensatz gehört) größer als der Schwellenwert ist, wird die Probe als saubere Probe betrachtet, andernfalls wird sie als Rauschprobe betrachtet.

(d. h. die Wahrscheinlichkeit, dass die Probe zum sauberen Probensatz gehört) größer als der Schwellenwert ist, wird die Probe als saubere Probe betrachtet, andernfalls wird sie als Rauschprobe betrachtet.

(3) FixMatch

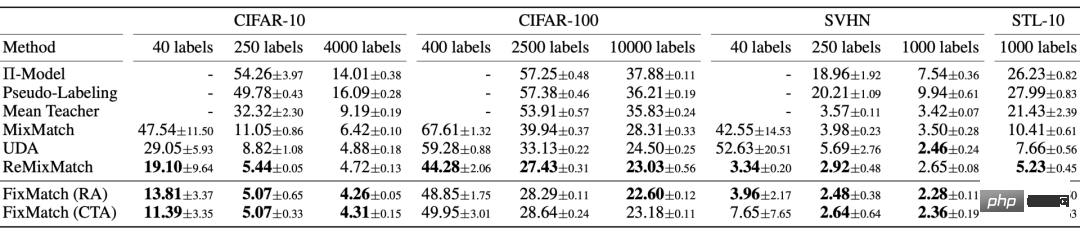

Abbildung 17: Leistung von FixMatch und mehreren anderen halbüberwachten Lernmethoden für Bildklassifizierungsaufgaben. (Bildquelle: Artikel von Sohn et al. aus dem Jahr 2020 „FixMatch: Vereinfachung halbüberwachten Lernens mit Konsistenz und Vertrauen“)

Abbildung 17: Leistung von FixMatch und mehreren anderen halbüberwachten Lernmethoden für Bildklassifizierungsaufgaben. (Bildquelle: Artikel von Sohn et al. aus dem Jahr 2020 „FixMatch: Vereinfachung halbüberwachten Lernens mit Konsistenz und Vertrauen“)

7 Kombiniert mit leistungsstarkem Vortraining

ist.

ist.

Abbildung 20: Leistungsvergleich von SimCLRv2 + halbüberwachter Destillation bei der ImageNet-Klassifizierung. (Bildquelle: Artikel von Ting Chen et al. aus dem Jahr 2020 „Groß angelegte selbstüberwachte Modelle sind leistungsstarke halbüberwachte Lernende“)

Abbildung 20: Leistungsvergleich von SimCLRv2 + halbüberwachter Destillation bei der ImageNet-Klassifizierung. (Bildquelle: Artikel von Ting Chen et al. aus dem Jahr 2020 „Groß angelegte selbstüberwachte Modelle sind leistungsstarke halbüberwachte Lernende“)

<span style="color: rgb(215, 58, 73); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">@</span><span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">article</span>{<span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">weng2021semi</span>,<span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">title</span> <span style="color: rgb(215, 58, 73); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">=</span> <span style="color: rgb(102, 153, 0); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">"Learning with not Enough Data Part 1: Semi-Supervised Learning"</span>,<span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">author</span><span style="color: rgb(215, 58, 73); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">=</span> <span style="color: rgb(102, 153, 0); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">"Weng, Lilian"</span>,

Das obige ist der detaillierte Inhalt vonOpenAI-Forscher: So implementieren Sie überwachtes Lernen, wenn die Daten nicht ausreichen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1374

1374

52

52

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Bei der Konvertierung von Zeichenfolgen in Objekte in Vue.js wird JSON.Parse () für Standard -JSON -Zeichenfolgen bevorzugt. Bei nicht standardmäßigen JSON-Zeichenfolgen kann die Zeichenfolge durch Verwendung regelmäßiger Ausdrücke verarbeitet und Methoden gemäß dem Format oder dekodierten URL-kodiert reduziert werden. Wählen Sie die entsprechende Methode gemäß dem String -Format aus und achten Sie auf Sicherheits- und Codierungsprobleme, um Fehler zu vermeiden.

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

Zusammenfassung: Es gibt die folgenden Methoden zum Umwandeln von VUE.JS -String -Arrays in Objektarrays: Grundlegende Methode: Verwenden Sie die Kartenfunktion, um regelmäßige formatierte Daten zu entsprechen. Erweitertes Gameplay: Die Verwendung regulärer Ausdrücke kann komplexe Formate ausführen, müssen jedoch sorgfältig geschrieben und berücksichtigt werden. Leistungsoptimierung: In Betracht ziehen die große Datenmenge, asynchrone Operationen oder effiziente Datenverarbeitungsbibliotheken können verwendet werden. Best Practice: Clear Code -Stil, verwenden Sie sinnvolle variable Namen und Kommentare, um den Code präzise zu halten.

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

Um die Zeitüberschreitung für Vue Axios festzulegen, können wir eine Axios -Instanz erstellen und die Zeitleitungsoption angeben: in globalen Einstellungen: vue.Prototyp. $ Axios = axios.create ({Timeout: 5000}); In einer einzigen Anfrage: this. $ axios.get ('/api/user', {timeout: 10000}).

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

Die MySQL -Leistungsoptimierung muss von drei Aspekten beginnen: Installationskonfiguration, Indexierung und Abfrageoptimierung, Überwachung und Abstimmung. 1. Nach der Installation müssen Sie die my.cnf -Datei entsprechend der Serverkonfiguration anpassen, z. 2. Erstellen Sie einen geeigneten Index, um übermäßige Indizes zu vermeiden und Abfrageanweisungen zu optimieren, z. B. den Befehl Erklärung zur Analyse des Ausführungsplans; 3. Verwenden Sie das eigene Überwachungstool von MySQL (ShowProcessList, Showstatus), um die Datenbankgesundheit zu überwachen und die Datenbank regelmäßig zu sichern und zu organisieren. Nur durch kontinuierliche Optimierung dieser Schritte kann die Leistung der MySQL -Datenbank verbessert werden.

die One-Hot-Darstellung des wahren Labels ist.

die One-Hot-Darstellung des wahren Labels ist.