Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Den größten ViT der Geschichte bequem trainiert? Google aktualisiert das visuelle Sprachmodell PaLI: unterstützt mehr als 100 Sprachen

Den größten ViT der Geschichte bequem trainiert? Google aktualisiert das visuelle Sprachmodell PaLI: unterstützt mehr als 100 Sprachen

Den größten ViT der Geschichte bequem trainiert? Google aktualisiert das visuelle Sprachmodell PaLI: unterstützt mehr als 100 Sprachen

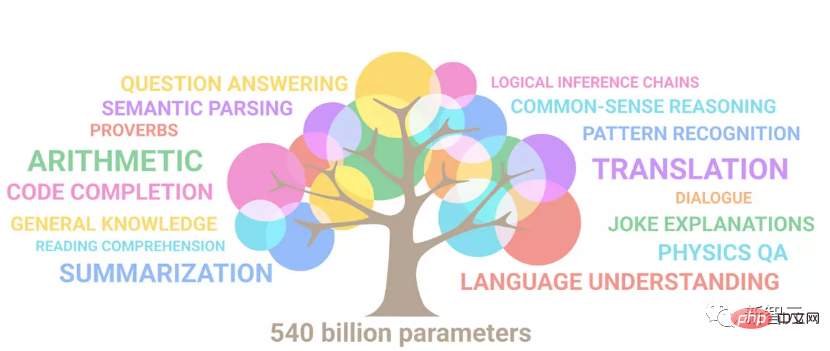

Der Fortschritt der natürlichen Sprachverarbeitung ist in den letzten Jahren größtenteils auf groß angelegte Sprachmodelle zurückzuführen. Mit jedem neuen Modell steigt die Menge an Parametern und Trainingsdaten auf ein neues Niveau Gleichzeitig werden auch die bestehenden Benchmark-Rankings abgeschlachtet!

Zum Beispiel Im April dieses Jahres veröffentlichte Google 540 Milliarden Parameter-Sprachmodell PaLM#🎜🎜 # (Pathways Language Model) hat den Menschen in einer Reihe von Sprach- und Argumentationstests erfolgreich übertroffen, insbesondere aufgrund seiner hervorragenden Leistung in Lew-Shot-Lernszenarien mit kleinen Stichproben , was PaLM auch als die Entwicklung der nächsten Generation betrachtet Richtung von Sprachmodellen.

Ähnlich Visuelle Sprache #是 bewirkt energisch Wunder, Sie können die Leistung verbessern, indem Sie die Größe des Modells erhöhen. Wenn nur ein visuelles Sprachmodell für Multitasking

ist, ist es natürlich nicht sehr universell und braucht # 🎜🎜# um mehr zu unterstützen Es kann nur die Ein- und Ausgabe einer Spracheerfolgen. Kürzlich hat Google die PaLM-Erweiterung auf PALI (Pathways Language and Image Model) aktualisiert, das sowohl

mehrere Sprache und Die Fähigkeit,zu verstehen, während über 100 Sprachen unterstützt, um eine Vielzahl von Bild- und Sprachanwendungen in den Bereichen Sehen, Sprache und Multimodalität durchzuführen, wie z. B. visuelle Fragenbeantwortung, Bild Beschreibung (Bildunterschrift), Objekterkennung, Bildklassifizierung, OCR, Textbegründung usw.

Papierlink: https://arxiv.org/abs/2209.06794#🎜 🎜 #

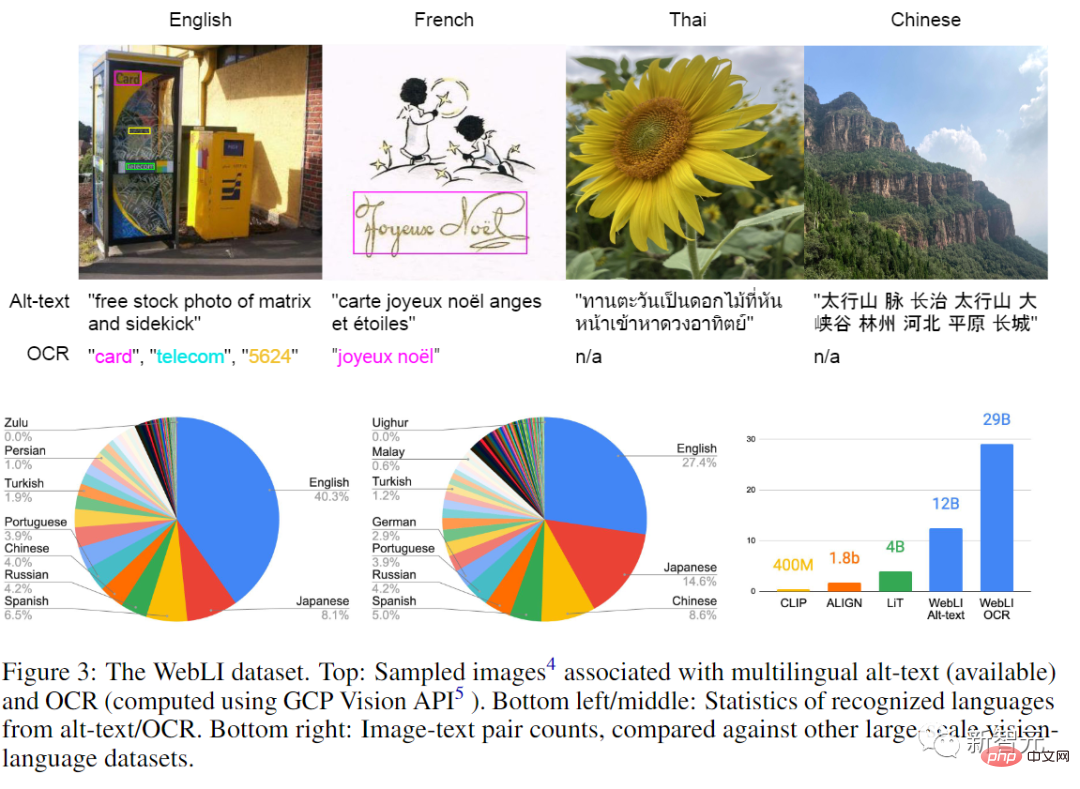

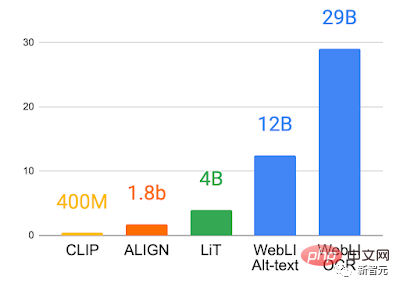

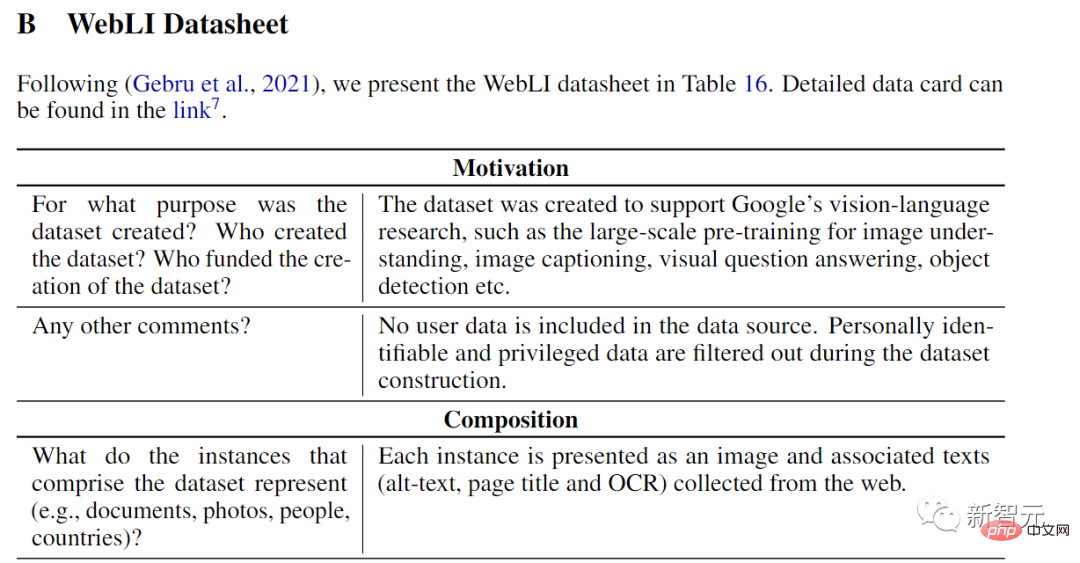

Das Modell wird mithilfe einer öffentlichen Bildsammlung trainiert, die automatisch gecrawlte Anmerkungen in 109 Sprachen enthält , Es heißt auch WebLI

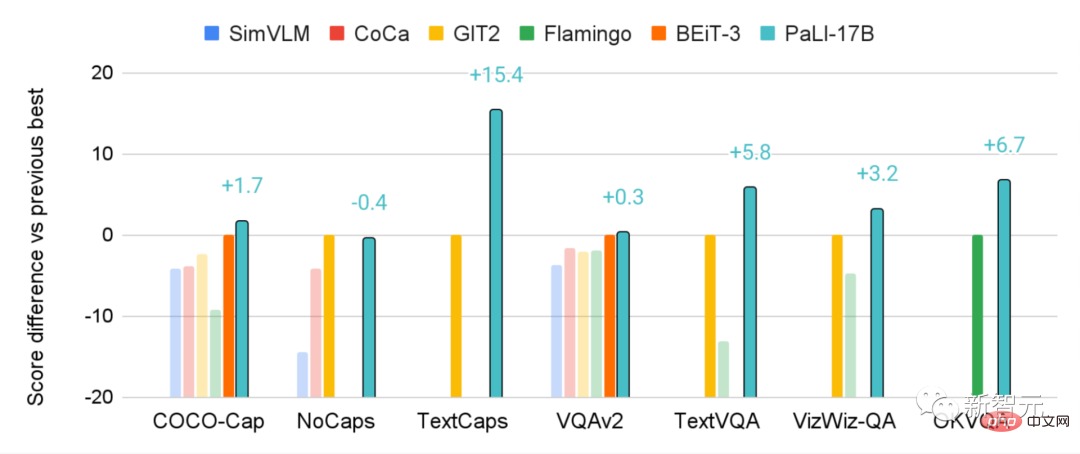

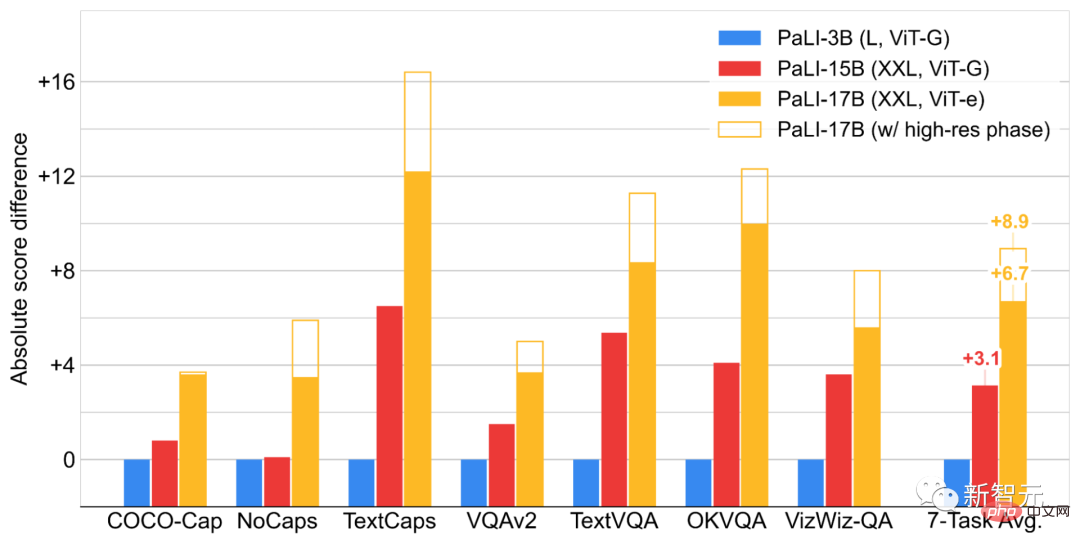

Datensatz im Artikel.Auf WebLI vortrainierte PaLI-Modelle erreichen modernste Leistung bei mehreren Bild- und Sprach-Benchmarks wie COCO-Captions, TextCaps, VQAv2, OK- VQA, TextVQA usw. haben auch die Maßstäbe früherer Modelle für mehrsprachige visuelle Untertitel und visuelle Fragenbeantwortung übertroffen. Modellarchitektur

Eines der Ziele von PALI ist das Studium von Sprache

undVisuellem #🎜 🎜#Ist die Beziehung zwischen der

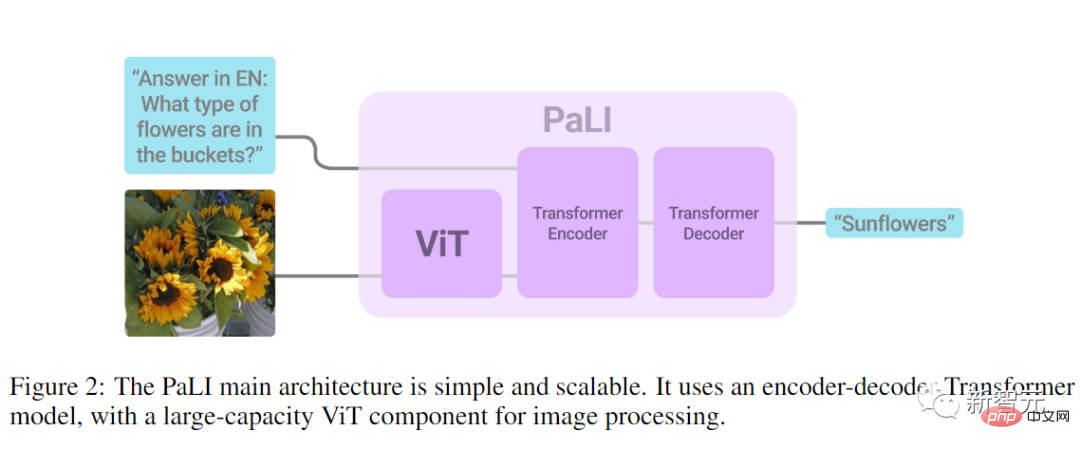

Leistung und Skalierungdes Modells dieselbe, insbesondere die Skalierbarkeit des Sprach-Bild-Modells? Das architektonische Design des Modells ist also sehr einfach, hauptsächlich aus Gründen der Bequemlichkeit von Experimenten, insbesondere der Wiederverwendbarkeit und Skalierbarkeit.

Das Modell besteht aus einem Transformer-Encoder, der Eingabetext verarbeitet, und einem autoregressiven Transformer-Decoder, der Ausgabetext generiert.

Bei der Verarbeitung von Bildern enthält die Eingabe in den Transformer-Encoder auch visuelle Wörter, die die von ViT verarbeiteten Bilder darstellen.

Bei der Verarbeitung von Bildern enthält die Eingabe in den Transformer-Encoder auch visuelle Wörter, die die von ViT verarbeiteten Bilder darstellen.

Ein Schlüsseldesign des PaLI-Modells ist die Wiederverwendung. Die Forscher verwendeten die Gewichte zuvor trainierter einmodaler Seh- und Sprachmodelle (wie mT5-XXL und große ViTs). ) Als Keimzelle des Modells überträgt diese Wiederverwendung nicht nur die Fähigkeiten des einmodalen Trainings, sondern spart auch Rechenkosten.

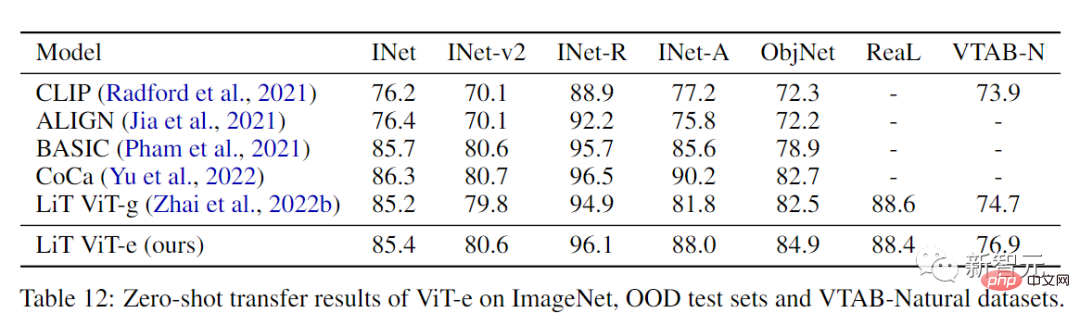

Die visuelle Komponente des Modells verwendet

Die bisher größte ViT-Architektur, ViT-e, was dem 1,8-Milliarden-Parameter entspricht Das ViT-G-Modell hat die gleiche Struktur und verwendet die gleichen Trainingsparameter. Der Unterschied besteht darin, dass es auf 4 Milliarden Parameter erweitert wurde.

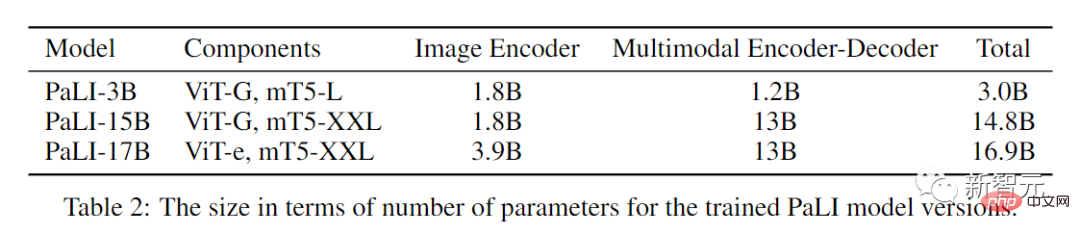

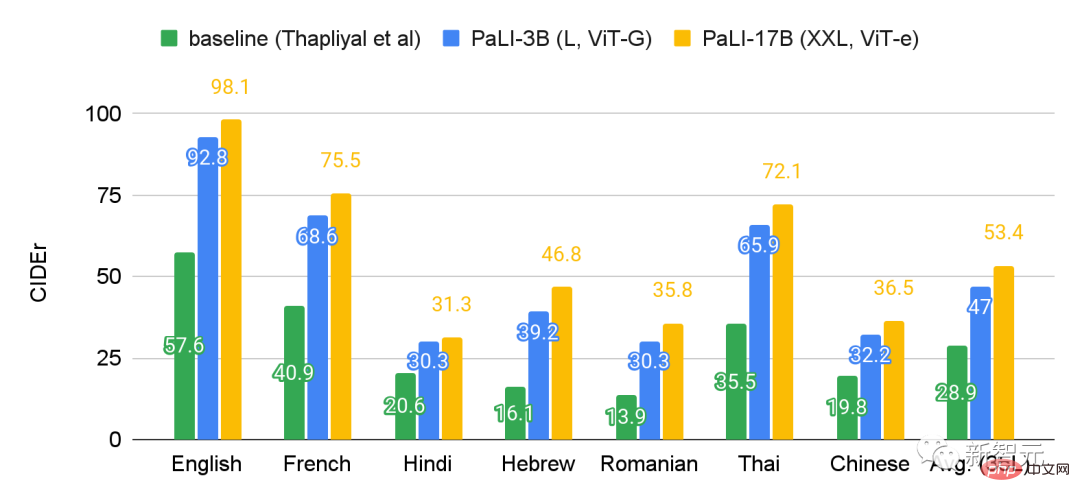

Obwohl Skalierungsgesetze sowohl im visuellen als auch im sprachlichen Bereich untersucht wurden, wurde das Skalierungsverhalten im kombinierten Modell von Vision und Sprache weniger erforscht Die Größe des Backbone-Modells kann zu einer Sättigung der Gewinne bei Klassifizierungsaufgaben führen. Die Forscher haben dies auch weiter bestätigt, und es kann beobachtet werden, dass ViT-e auf ImageNet nur geringfügig besser ist als ViT-G, ViT-e jedoch eine große Verbesserung gegenüber der visuellen Sprachaufgabe von PaLI aufweist. Beispielsweise übertrifft ViT-e ViT-G bei der COCO-Untertitelaufgabe um fast 3 CIDEr-Punkte. 3 Punkte mehr als ViT-G in Aufgaben. Dies deutet auch auf Raum für die Verwendung größerer ViT-Skelettmodelle in visuellen Sprachaufgaben in der Zukunft hin. Die Forscher übernahmen mT5-Backbone als Sprachmodellierungskomponente und verwendeten vorab trainiertes mT5-Large (1 Milliarde Parameter) und mT5-XXL (13 Milliarden Parameter), um den Sprach-Encoder-Decoder von PaLI zu initialisieren wird dann weiterhin gemischt in vielen Sprachaufgaben trainiert, einschließlich reiner Sprachverständnisaufgaben, was auch dazu beiträgt, ein katastrophales Vergessen der Sprachverständnis- und Produktionsfähigkeiten von mT5 zu vermeiden. Endlich habe ich drei PALI-Modelle in verschiedenen Größen bekommen. Ausführliche Forschung im Zusammenhang mit Deep Learning zeigt, dass der erforderliche Trainingsdatensatz umso größer ist, je größer das Modell ist. Um das Potenzial von Sprach-Bild-Vortrainingsmodellen umfassend zu untersuchen und auszuschöpfen, haben Forscher eine große Menge an Bild- und Textdaten aus dem Internet gecrawlt und einen neuen Datensatz WebLI erstellt, der 120 Bilder in 109 Sprachen enthält Milliarden Alternativtexte und 10 Milliarden Bilder. Zusätzlich zur Verwendung von Webtext für Anmerkungen verwendeten die Forscher auch die Cloud Vision API, um eine OCR-Erkennung an Bildern durchzuführen, und erhielten so 29 Milliarden Bild-OCR-Datenpaare. Die Bilder in den Trainings-, Validierungs- und Testteilen von 68 gemeinsamen visuellen und visuellen Sprachdatensätzen wurden mithilfe der Beinahe-Duplizierung dedupliziert, um Datenlecks bei nachgelagerten Bewertungsaufgaben zu vermeiden. Um die Datenqualität weiter zu verbessern, werden die Forscher auch anhand der modalübergreifenden Ähnlichkeit von „Bild und Alt-Text“ punkten, den Schwellenwert anpassen und schließlich nur 10 % davon beibehalten Bilder, insgesamt 1 Milliarde Bilder werden zum Trainieren von PaLI verwendet Da die visuelle Sprachaufgabe multimodal ist, muss das Modell über mehrere semantische Verarbeitungsfähigkeiten verfügen und unterschiedliche Ziele verfolgen. Beispielsweise erfordern einige Aufgaben eine lokale Lokalisierung von Objekten, um die Aufgabe genau zu lösen, während andere Aufgaben möglicherweise globalere semantische Informationen erfordern. Ebenso erfordern einige Sprachaufgaben möglicherweise lange Antworten, während andere möglicherweise kompakte Antworten erfordern. Um all diese inkonsistenten Ziele anzugehen, nutzen Forscher den Reichtum der WebLI-Pre-Training-Daten und führen eine Pre-Training-Task-Mischung ein, um Modelle für verschiedene nachgelagerte Anwendungen vorzubereiten. Um das Modell vielseitiger für die Lösung verschiedener Aufgaben zu machen, hat der Autor alle Aufgaben in einer einzigen gemeinsamen API klassifiziert (Eingabe: Bild + Text; Ausgabe: Text), wodurch mehrere Bild- und Sprachaufgaben ausgeführt werden können Aus Wissensaustausch, der auch mit vorab trainierten Einstellungen geteilt wird. Die für das Vortraining verwendeten Ziele werden als gewichtete Mischung in dieselbe API projiziert, mit dem Ziel, sowohl die Fähigkeit zur Wiederverwendung von Modellkomponenten aufrechtzuerhalten als auch das Modell für die Ausführung neuer Aufgaben zu trainieren. Das Modell verwendet die Open-Source-Frameworks T5X und Flaxformer und wird mit Flax in JAX trainiert. Der visuelle Teil von ViT-e verwendet das Open-Source-Framework BigVision, um die Wortvektoren des Sprachteils und die von generierten Patch-Vektoren zu kaskadieren Der visuelle Teil: Als Eingabe für den multimodalen Encoder-Decoder wird der Encoder mithilfe des mT5-XXL-Vortrainings initialisiert. Während des Trainingsprozesses von PaLI werden die Gewichte der visuellen Komponenten eingefroren und nur die Gewichte des multimodalen Encoder-Decoders aktualisiert. Im experimentellen Teil verglichen die Forscher PaLI anhand gängiger visueller Sprach-Benchmarks, und das PaLI-Modell erzielte bei diesen Aufgaben Ergebnisse auf dem neuesten Stand der Technik und übertraf sogar sehr große Modelle, die in der vorherigen Literatur vorgeschlagen wurden. Zum Beispiel schneidet das PALI mit 17 Milliarden Parametern bei einigen VQA- und Bildbeschriftungsaufgaben besser ab als das Flamingo-Modell mit 80 Milliarden Parametern. Und PALI behält auch bei einzelnen Sprach- oder einzelnen visuellen Aufgaben gute Leistungen bei, obwohl dies nicht das Haupttrainingsziel von PALI ist. Wir untersuchen auch, wie Bild- und Sprachmodellkomponenten im Hinblick auf die Modellskalierung interagieren und wo das Modell die größten Gewinne bringt. Die abschließende Schlussfolgerung ist, dass die gemeinsame Skalierung (Skalierung) dieser beiden Komponenten die beste Leistung erbringt. Insbesondere ist die Skalierung der visuellen Komponente, die relativ wenige Parameter erfordert, am kritischsten, während die Skalierung auch für die Verbesserung der Leistung bei mehrsprachigen Aufgaben wichtig ist . Nach der Evaluierung von PaLI auf dem Benchmark Crossmodal-3600 in 35 Sprachen können wir feststellen, dass die mehrsprachige Titelaufgabe mehr von der Erweiterung des PaLI-Modells profitiert. Um zu vermeiden, dass in großen Sprach- und Bildmodellen unfaire Vorurteile entstehen oder verstärkt werden, müssen die verwendeten Daten und die Art und Weise, wie die Modelle diese Daten verwenden, transparent sein und die Fairness der Modelle getestet werden und verantwortungsvolle Datenanalyse durchführen, daher stellt der Artikel sowohl eine Datenkarte als auch eine Modellkarte bereit

Datensatz in 109 Sprachen

Training großer Modelle

Das obige ist der detaillierte Inhalt vonDen größten ViT der Geschichte bequem trainiert? Google aktualisiert das visuelle Sprachmodell PaLI: unterstützt mehr als 100 Sprachen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Gerüchten zufolge sollen Google Pixel 9 und Pixel 9 Pro bei der Veröffentlichung über die Creative Assistant AI verfügen

Jun 22, 2024 am 10:50 AM

Gerüchten zufolge sollen Google Pixel 9 und Pixel 9 Pro bei der Veröffentlichung über die Creative Assistant AI verfügen

Jun 22, 2024 am 10:50 AM

Derzeit werden voraussichtlich im Herbst vier neue Pixel-Smartphones auf den Markt kommen. Um es noch einmal zusammenzufassen: Es wird gemunkelt, dass die Serie beim Start das Pixel 9 und das Pixel 9 Pro beinhalten wird. Allerdings wird das Pixel 9 Pro eher ein Konkurrent des iPhone 16 Pro als ein Pixel 8 Pro sein (aktuell).

Google Pixel 9 Pro XL wird im Desktop-Modus getestet

Aug 29, 2024 pm 01:09 PM

Google Pixel 9 Pro XL wird im Desktop-Modus getestet

Aug 29, 2024 pm 01:09 PM

Google hat den DisplayPort Alternate Mode mit der Pixel-8-Serie eingeführt und ist auch in der neu eingeführten Pixel-9-Reihe vorhanden. Während es hauptsächlich dazu dient, das Smartphone-Display mit einem angeschlossenen Bildschirm zu spiegeln, können Sie es auch für den Desktop verwenden

Google Tensor G4 von Pixel 9 Pro XL hinkt Tensor G2 in Genshin Impact

Aug 24, 2024 am 06:43 AM

Google Tensor G4 von Pixel 9 Pro XL hinkt Tensor G2 in Genshin Impact

Aug 24, 2024 am 06:43 AM

Google hat kürzlich auf die Leistungsbedenken bezüglich des Tensor G4 der Pixel-9-Reihe reagiert. Das Unternehmen sagte, dass der SoC nicht darauf ausgelegt sei, Benchmarks zu schlagen. Stattdessen konzentrierte sich das Team darauf, dass es in den Bereichen, in denen Google das c wünscht, eine gute Leistung erbringt

Google AI kündigt Gemini 1.5 Pro und Gemma 2 für Entwickler an

Jul 01, 2024 am 07:22 AM

Google AI kündigt Gemini 1.5 Pro und Gemma 2 für Entwickler an

Jul 01, 2024 am 07:22 AM

Google AI hat damit begonnen, Entwicklern Zugriff auf erweiterte Kontextfenster und kostensparende Funktionen zu bieten, beginnend mit dem großen Sprachmodell Gemini 1.5 Pro (LLM). Bisher über eine Warteliste verfügbar, das vollständige 2-Millionen-Token-Kontextfenster

Der APK-Teardown der Google-App-Beta enthüllt neue Erweiterungen für den Gemini AI-Assistenten

Jul 30, 2024 pm 01:06 PM

Der APK-Teardown der Google-App-Beta enthüllt neue Erweiterungen für den Gemini AI-Assistenten

Jul 30, 2024 pm 01:06 PM

Googles KI-Assistent Gemini dürfte noch leistungsfähiger werden, wenn man den APK-Teardown des neuesten Updates (v15.29.34.29 Beta) in Betracht zieht. Berichten zufolge könnte der neue KI-Assistent des Tech-Giganten mehrere neue Erweiterungen erhalten. Diese Erweiterungen wi

Google Pixel 9-Smartphones werden trotz siebenjähriger Update-Verpflichtung nicht mit Android 15 auf den Markt kommen

Aug 01, 2024 pm 02:56 PM

Google Pixel 9-Smartphones werden trotz siebenjähriger Update-Verpflichtung nicht mit Android 15 auf den Markt kommen

Aug 01, 2024 pm 02:56 PM

Die Pixel-9-Serie ist fast da, die Veröffentlichung ist für den 13. August geplant. Jüngsten Gerüchten zufolge werden Pixel 9, Pixel 9 Pro und Pixel 9 Pro XL das Pixel 8 und Pixel 8 Pro (aktuell 749 US-Dollar bei Amazon) widerspiegeln und mit 128 GB Speicher beginnen.

Der neue Google Pixel-Desktopmodus wird in einem neuen Video als mögliche Alternative zu Motorola Ready For und Samsung DeX vorgestellt

Aug 08, 2024 pm 03:05 PM

Der neue Google Pixel-Desktopmodus wird in einem neuen Video als mögliche Alternative zu Motorola Ready For und Samsung DeX vorgestellt

Aug 08, 2024 pm 03:05 PM

Es sind einige Monate vergangen, seit Android Authority einen neuen Android-Desktop-Modus vorgestellt hat, den Google in Android 14 QPR3 Beta 2.1 versteckt hat. Wir kommen direkt auf den Fersen, als Google die DisplayPort-Alt-Modus-Unterstützung für Pixel 8 und Pixel 8 hinzufügt

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten