Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Basierend auf GAN wird ein flüssiges Video generiert, und der Effekt ist sehr beeindruckend: keine Texturanhaftung, Reduzierung des Jitters

Basierend auf GAN wird ein flüssiges Video generiert, und der Effekt ist sehr beeindruckend: keine Texturanhaftung, Reduzierung des Jitters

Basierend auf GAN wird ein flüssiges Video generiert, und der Effekt ist sehr beeindruckend: keine Texturanhaftung, Reduzierung des Jitters

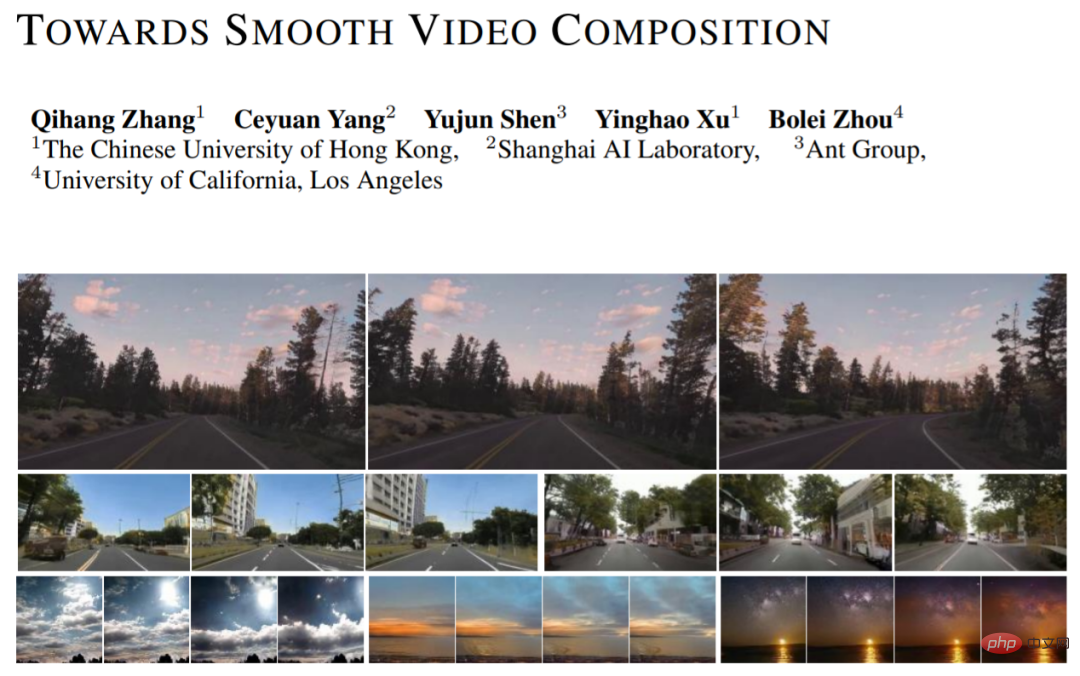

In den letzten Jahren hat die Forschung zur Bildgenerierung auf Basis des Generative Adversarial Network (GAN) erhebliche Fortschritte gemacht. Neben der Möglichkeit, hochauflösende, realistische Bilder zu erzeugen, sind auch viele innovative Anwendungen entstanden, wie z. B. personalisierte Bildbearbeitung, Bildanimation usw. Allerdings ist die Verwendung von GAN zur Videogenerierung immer noch ein herausforderndes Problem.

Neben der Modellierung von Einzelbildbildern erfordert die Videogenerierung auch das Erlernen komplexer zeitlicher Zusammenhänge. Kürzlich haben Forscher der Chinesischen Universität Hongkong, des Shanghai Artificial Intelligence Laboratory, des Ant Technology Research Institute und der University of California, Los Angeles eine neue Methode zur Videogenerierung vorgeschlagen (Towards Smooth Video Composition). In dem Artikel führten sie detaillierte Modellierungen und Verbesserungen der Zeitreihenbeziehungen verschiedener Zeitspannen (kurzfristiger Bereich, mittlerer Bereich, langer Bereich) durch und erzielten erhebliche Verbesserungen gegenüber früheren Arbeiten an mehreren Datensätzen. Diese Arbeit bietet einen einfachen und effektiven neuen Maßstab für die GAN-basierte Videogenerierung.

- Papieradresse: https://arxiv.org/pdf/2212.07413.pdf

- Projektcode-Link: https://github.com/genforce/StyleSV

Modellarchitektur

Das auf GAN basierende Bildgenerierungsnetzwerk kann wie folgt ausgedrückt werden: I = G(Z), wobei Z eine Zufallsvariable, G das Generierungsnetzwerk und I das generierte Bild ist. Wir können dieses Framework einfach auf die Kategorie der Videogenerierung erweitern: I_i=G(z_i), i=[1,...,N], wobei wir N Zufallsvariablen z_i gleichzeitig abtasten und jede Zufallsvariable z_i eine generiert entsprechender A-Rahmen des Bildes I_i. Das generierte Video kann durch Stapeln der generierten Bilder in der Zeitdimension erhalten werden.

MoCoGAN, StyleGAN-V und andere Arbeiten haben auf dieser Basis einen entkoppelten Ausdruck vorgeschlagen: I_i=G(u, v_i), i=[1,...,N], wobei u den Kontrollinhalt darstellt. Der Zufall Variable, v_i stellt die Zufallsvariable dar, die die Aktion steuert. Diese Darstellung geht davon aus, dass alle Frames denselben Inhalt haben und eine einzigartige Bewegung aufweisen. Durch diesen entkoppelten Ausdruck können wir Actionvideos mit konsistenten Inhaltsstilen und veränderbarem Realismus besser erstellen. Das neue Werk übernimmt das Design von StyleGAN-V und nutzt es als Basis.

Schwierigkeiten bei der Videogenerierung: Wie lassen sich zeitliche Zusammenhänge effektiv und sinnvoll modellieren?

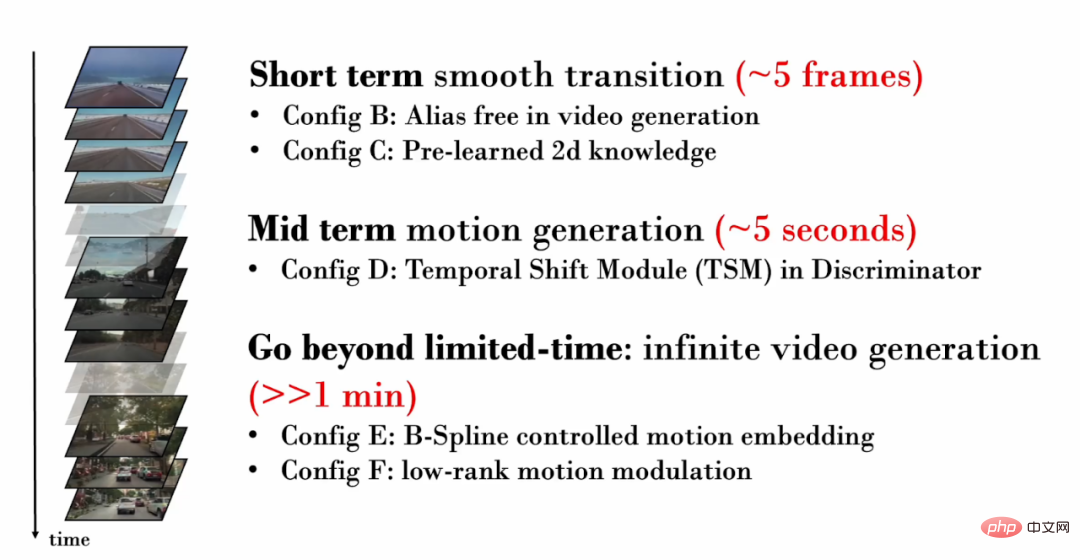

Die neue Arbeit konzentriert sich auf die zeitlichen Beziehungen verschiedener Zeitspannen (kurzer Zeitbereich, mittlerer Bereich, langer Bereich) und führt eine detaillierte Modellierung bzw. Verbesserung durch:

1. Kurze Zeit (~5 Frames ) Timing-Beziehung

Betrachten wir zunächst ein Video mit nur wenigen Bildern. Diese kurzen Videobilder enthalten oft sehr ähnliche Inhalte und zeigen nur sehr subtile Bewegungen. Daher ist es wichtig, subtile Bewegungen zwischen den Bildern realistisch zu erzeugen. In den von StyleGAN-V generierten Videos kommt es jedoch zu schwerwiegendem Textur-Sticking.

Texturhaftung bezieht sich auf die Tatsache, dass ein Teil des generierten Inhalts von bestimmten Koordinaten abhängig ist, wodurch das Phänomen des „Klebens“ an einem festen Bereich entsteht. Im Bereich der Bilderzeugung lindert StyleGAN3 das Problem der Texturanhaftung durch detaillierte Signalverarbeitung, erweiterten Füllbereich und andere Vorgänge. Diese Arbeit bestätigt, dass dieselbe Technik immer noch für die Videogenerierung effektiv ist.

In der folgenden Visualisierung verfolgen wir Pixel an derselben Stelle in jedem Frame des Videos. Es ist leicht zu erkennen, dass im StyleGAN-V-Video einige Inhalte lange Zeit an festen Koordinaten „klebrig“ waren und sich im Laufe der Zeit nicht bewegt haben, wodurch ein „Pinselphänomen“ in der Visualisierung entsteht. In den durch das neue Werk generierten Videos weisen alle Pixel eine natürliche Bewegung auf.

Forscher fanden jedoch heraus, dass die Referenzierung des Rückgrats von StyleGAN3 die Qualität der Bilderzeugung verringert. Um dieses Problem zu lösen, führten sie ein Vortraining auf Bildebene ein. In der Vortrainingsphase muss das Netzwerk nur die Generierungsqualität eines bestimmten Bildes im Video berücksichtigen und muss nicht die Modellierung des Zeitbereichs erlernen, was das Erlernen von Kenntnissen über die Bildverteilung erleichtert.

2. Zeitbeziehung mittlerer Länge (~5 Sekunden)

Da das generierte Video mehr Bilder hat, können spezifischere Aktionen angezeigt werden. Daher ist es wichtig sicherzustellen, dass das generierte Video realistische Bewegungen aufweist. Wenn wir beispielsweise ein Fahrvideo aus der ersten Person erstellen möchten, sollten wir eine sich allmählich zurückziehende Boden- und Straßenszene generieren und das herannahende Auto sollte ebenfalls einer natürlichen Fahrbahn folgen.

Im kontradiktorischen Training ist das diskriminierende Netzwerk von entscheidender Bedeutung, um sicherzustellen, dass das generative Netzwerk ausreichend Trainingsaufsicht erhält. Um sicherzustellen, dass das generative Netzwerk realistische Aktionen generieren kann, muss das diskriminierende Netzwerk daher bei der Videogenerierung die zeitlichen Beziehungen in mehreren Bildern modellieren und die erzeugte unrealistische Bewegung erfassen. In früheren Arbeiten verwendete das Diskriminanznetzwerk jedoch nur eine einfache Verkettungsoperation, um eine zeitliche Modellierung durchzuführen: y = cat (y_i), wobei y_i das Einzelbildmerkmal und y das Merkmal nach der Zeitbereichsfusion darstellt.

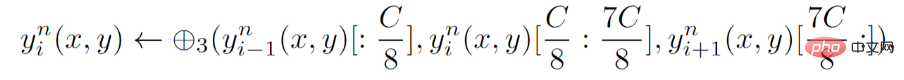

Für das Diskriminanznetzwerk schlägt die neue Arbeit eine explizite Timing-Modellierung vor, das heißt die Einführung des Temporal Shift Module (TSM) auf jeder Schicht des Diskriminanznetzwerks. TSM kommt aus dem Bereich der Aktionserkennung und realisiert den zeitlichen Informationsaustausch durch einfache Schichtoperationen:

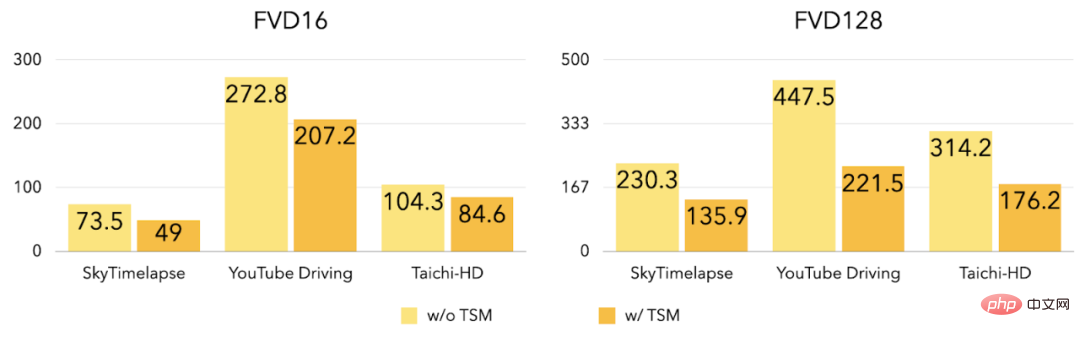

Experimente zeigen, dass nach der Einführung von TSM FVD16 und FVD128 in den drei Datensätzen stark reduziert wurden.

3. Unendlich lange Videogenerierung

Die zuvor eingeführten Verbesserungen konzentrieren sich hauptsächlich auf die Generierung kurzer und mittellanger Videos, und das neue Werk untersucht weiter, wie man hochwertige Videos generiert. Hochwertige Videos in beliebiger Länge (einschließlich unbegrenzter Länge). Frühere Arbeiten (StyleGAN-V) können unendlich lange Videos erzeugen, aber das Video enthält sehr offensichtliches periodisches Jitter:

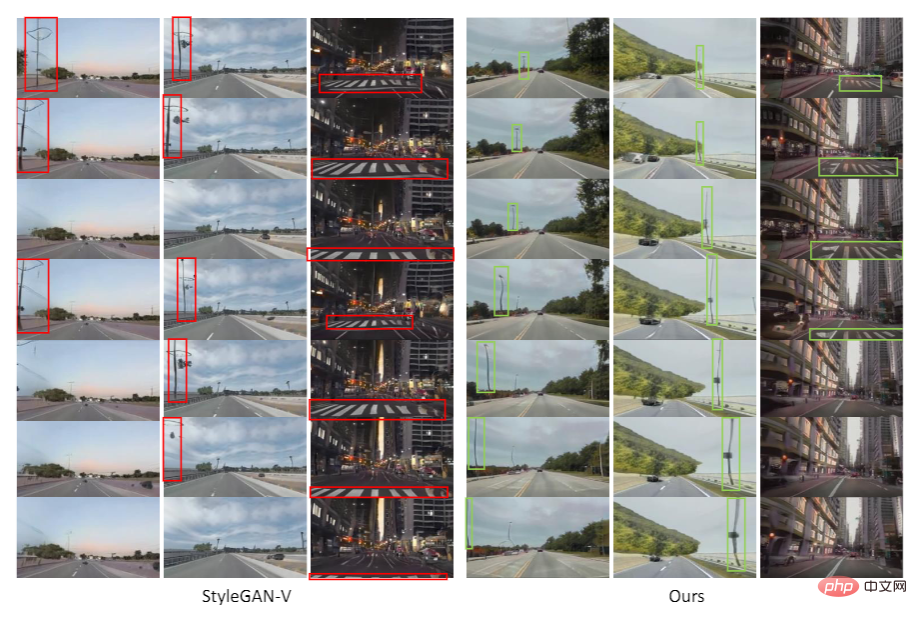

Wie in der Abbildung gezeigt, wurde das in StyleGAN-V generierte Video im Video als Das Fahrzeug bewegt sich vorwärts, der Zebrastreifen bewegte sich ursprünglich normal rückwärts, wechselte dann aber plötzlich zum Vorwärtsfahren. Diese Arbeit ergab, dass Diskontinuität in Bewegungsmerkmalen (Bewegungseinbettung) dieses Jitter-Phänomen verursachte.

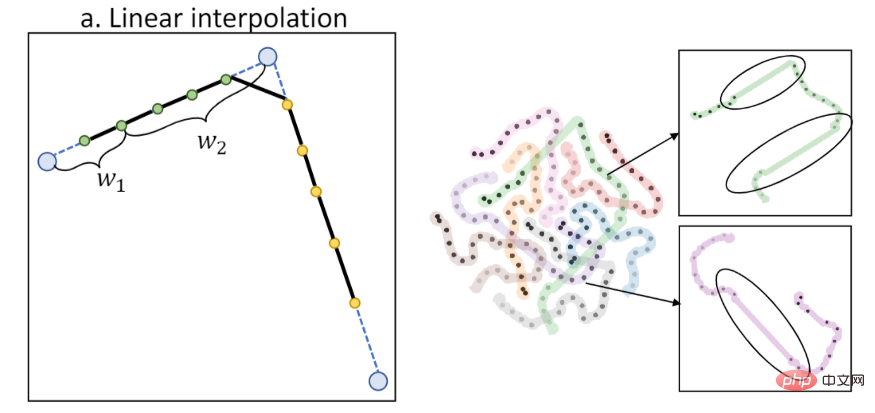

Frühere Arbeiten verwendeten lineare Interpolation zur Berechnung von Aktionsmerkmalen. Die lineare Interpolation führt jedoch zu einer Diskontinuität erster Ordnung, wie in der folgenden Abbildung dargestellt (links ist das Interpolationsdiagramm, rechts ist die T-SNE-Feature-Visualisierung). :

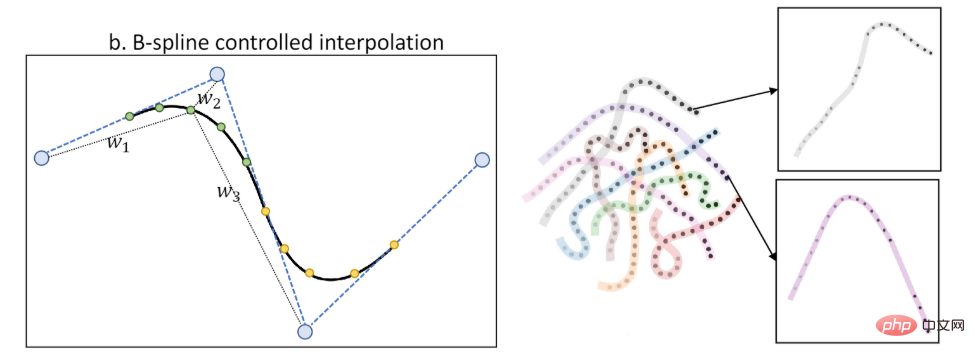

Diese Arbeit schlägt die Bewegungseigenschaften der B-Spline-Steuerung (B-Spline-basierte Bewegungseinbettung) vor. Durch Interpolation über B-Spline können zeitlich glattere Aktionsmerkmale erzielt werden, wie in der Abbildung gezeigt (links ist das Interpolationsdiagramm, rechts ist die T-SNE-Merkmalsvisualisierung):

Durch die Einführung der Aktionsmerkmale der B-Spline-Steuerung lindert die neue Arbeit das Jitter-Phänomen:

Wie in der Abbildung gezeigt, werden in dem von StyleGAN-V generierten Video Straßenlaternen und das Der Boden ändert plötzlich die Bewegungsrichtung. In den durch das neue Werk generierten Videos ist die Bewegungsrichtung einheitlich und natürlich.

Gleichzeitig schlägt das neue Werk auch eine Beschränkung der Aktionsfunktionen auf einen niedrigen Rang vor, um das Auftreten periodisch wiederkehrender Inhalte weiter zu verringern.

Experimente

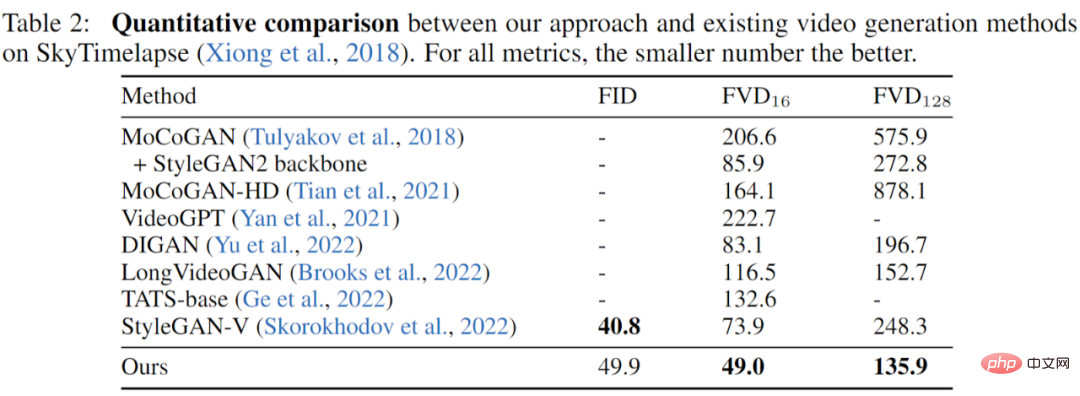

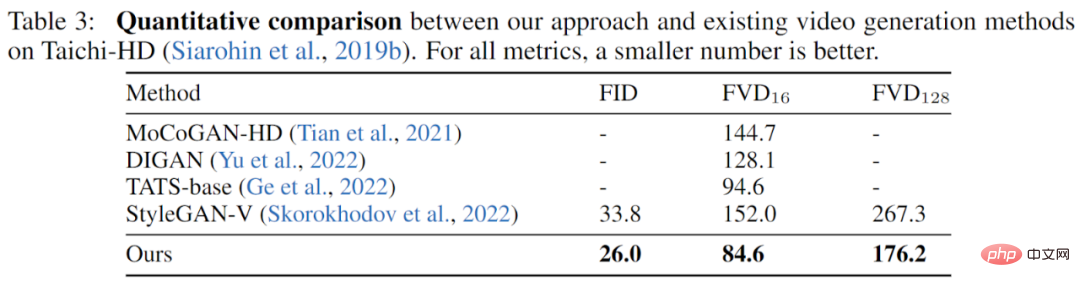

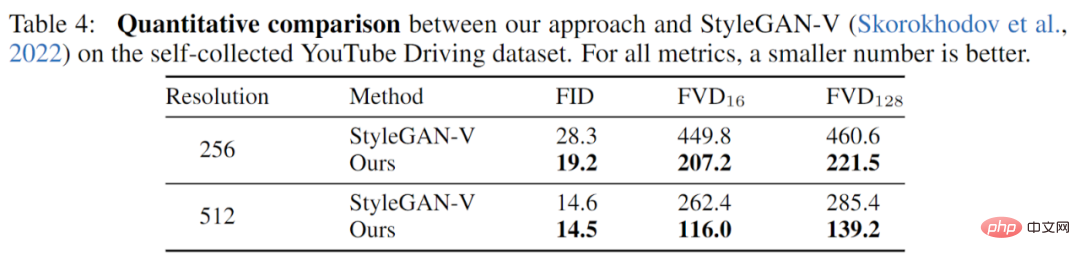

Die Arbeit wurde vollständig an drei Datensätzen (YouTube Driving, Timelapse, Taichi-HD) experimentiert und vollständig mit früheren Arbeiten verglichen. Die Ergebnisse zeigen, dass die neue Arbeit eine bessere Leistung in der Bildqualität (FID) aufweist. und die Videoqualität (FVD) wurde vollständig verbessert.

SkyTimelapse Experimentelle Ergebnisse:

Taichi-HD Experimentelle Ergebnisse:

Ergebnisse des YouTube-Fahrversuchs:

Zusammenfassung

Die neue Arbeit schlägt einen neuen Benchmark für die Videogenerierung basierend auf dem GAN-Modell vor. Ausgehend von der zeitlichen Beziehung verschiedener Skalen werden neuartige und wirksame Verbesserungen vorgeschlagen. Experimente mit mehreren Datensätzen zeigen, dass das neue Werk erfolgreich eine Videoqualität erreicht, die die früherer Arbeiten deutlich übertrifft.

Das obige ist der detaillierte Inhalt vonBasierend auf GAN wird ein flüssiges Video generiert, und der Effekt ist sehr beeindruckend: keine Texturanhaftung, Reduzierung des Jitters. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

So schreiben Sie einen Roman in der Tomato Free Novel-App. Teilen Sie das Tutorial zum Schreiben eines Romans in der Tomato Novel-App

Mar 28, 2024 pm 12:50 PM

So schreiben Sie einen Roman in der Tomato Free Novel-App. Teilen Sie das Tutorial zum Schreiben eines Romans in der Tomato Novel-App

Mar 28, 2024 pm 12:50 PM

Tomato Novel ist eine sehr beliebte Roman-Lesesoftware. Jeder Roman und Comic ist sehr interessant und möchte auch Romane schreiben Also, wie schreiben wir den Roman darin? Meine Freunde wissen es nicht, also lasst uns gemeinsam auf diese Seite gehen und uns eine Einführung zum Schreiben eines Romans ansehen. Teilen Sie das Tomato-Roman-Tutorial zum Schreiben eines Romans. 1. Öffnen Sie zunächst die kostenlose Tomato-Roman-App auf Ihrem Mobiltelefon und klicken Sie auf „Personal Center – Writer Center“. 2. Gehen Sie zur Seite „Tomato Writer Assistant“ – klicken Sie auf „Neues Buch erstellen“. am Ende des Romans.

Ist es ein Verstoß, die Videos anderer Leute auf Douyin zu posten? Wie werden Videos ohne Rechtsverletzung bearbeitet?

Mar 21, 2024 pm 05:57 PM

Ist es ein Verstoß, die Videos anderer Leute auf Douyin zu posten? Wie werden Videos ohne Rechtsverletzung bearbeitet?

Mar 21, 2024 pm 05:57 PM

Mit dem Aufkommen von Kurzvideoplattformen ist Douyin zu einem unverzichtbaren Bestandteil des täglichen Lebens eines jeden geworden. Auf TikTok können wir interessante Videos aus aller Welt sehen. Manche Leute posten gerne die Videos anderer Leute, was die Frage aufwirft: Verstößt Douyin gegen das Posten der Videos anderer Leute? In diesem Artikel wird dieses Problem erörtert und Ihnen erklärt, wie Sie Videos ohne Rechtsverletzung bearbeiten und Probleme mit Rechtsverletzungen vermeiden können. 1. Verstößt es gegen Douyins Veröffentlichung von Videos anderer Personen? Gemäß den Bestimmungen des Urheberrechtsgesetzes meines Landes stellt die unbefugte Nutzung der Werke des Urheberrechtsinhabers ohne die Erlaubnis des Urheberrechtsinhabers einen Verstoß dar. Daher stellt das Posten von Videos anderer Personen auf Douyin ohne die Erlaubnis des ursprünglichen Autors oder Urheberrechtsinhabers einen Verstoß dar. 2. Wie bearbeite ich ein Video ohne Urheberrechtsverletzung? 1. Verwendung von gemeinfreien oder lizenzierten Inhalten: Öffentlich

So stellen Sie gelöschte Kontakte auf WeChat wieder her (ein einfaches Tutorial erklärt Ihnen, wie Sie gelöschte Kontakte wiederherstellen)

May 01, 2024 pm 12:01 PM

So stellen Sie gelöschte Kontakte auf WeChat wieder her (ein einfaches Tutorial erklärt Ihnen, wie Sie gelöschte Kontakte wiederherstellen)

May 01, 2024 pm 12:01 PM

Leider löschen Menschen aus bestimmten Gründen oft versehentlich bestimmte Kontakte. WeChat ist eine weit verbreitete soziale Software. Um Benutzern bei der Lösung dieses Problems zu helfen, wird in diesem Artikel erläutert, wie gelöschte Kontakte auf einfache Weise wiederhergestellt werden können. 1. Verstehen Sie den WeChat-Kontaktlöschmechanismus. Dies bietet uns die Möglichkeit, gelöschte Kontakte wiederherzustellen. Der Kontaktlöschmechanismus in WeChat entfernt sie aus dem Adressbuch, löscht sie jedoch nicht vollständig. 2. Nutzen Sie die integrierte „Kontaktbuch-Wiederherstellung“-Funktion von WeChat, um Zeit und Energie zu sparen. Mit dieser Funktion können Benutzer schnell gelöschte Kontakte wiederherstellen. 3. Rufen Sie die WeChat-Einstellungsseite auf und klicken Sie auf die untere rechte Ecke, öffnen Sie die WeChat-Anwendung „Me“ und klicken Sie auf das Einstellungssymbol in der oberen rechten Ecke, um die Einstellungsseite aufzurufen.

Wie kann man mit dem Posten von Videos auf Douyin Geld verdienen? Wie kann ein Neuling mit Douyin Geld verdienen?

Mar 21, 2024 pm 08:17 PM

Wie kann man mit dem Posten von Videos auf Douyin Geld verdienen? Wie kann ein Neuling mit Douyin Geld verdienen?

Mar 21, 2024 pm 08:17 PM

Douyin, die nationale Kurzvideoplattform, ermöglicht uns nicht nur, in unserer Freizeit eine Vielzahl interessanter und neuartiger Kurzvideos zu genießen, sondern gibt uns auch eine Bühne, um uns zu zeigen und unsere Werte zu verwirklichen. Wie kann man also Geld verdienen, indem man Videos auf Douyin veröffentlicht? Dieser Artikel wird diese Frage ausführlich beantworten und Ihnen dabei helfen, mit TikTok mehr Geld zu verdienen. 1. Wie kann man mit dem Posten von Videos auf Douyin Geld verdienen? Nachdem Sie ein Video gepostet und eine bestimmte Anzahl an Aufrufen auf Douyin erreicht haben, haben Sie die Möglichkeit, am Werbe-Sharing-Plan teilzunehmen. Diese Einkommensmethode ist eine der bekanntesten unter Douyin-Benutzern und stellt auch für viele YouTuber die Haupteinnahmequelle dar. Douyin entscheidet anhand verschiedener Faktoren wie Kontogewicht, Videoinhalt und Publikumsfeedback, ob Möglichkeiten zum Teilen von Werbung bereitgestellt werden sollen. Die TikTok-Plattform ermöglicht es Zuschauern, ihre Lieblingsschöpfer durch das Versenden von Geschenken zu unterstützen.

So posten Sie Videos auf Weibo, ohne die Bildqualität zu komprimieren_So posten Sie Videos auf Weibo, ohne die Bildqualität zu komprimieren

Mar 30, 2024 pm 12:26 PM

So posten Sie Videos auf Weibo, ohne die Bildqualität zu komprimieren_So posten Sie Videos auf Weibo, ohne die Bildqualität zu komprimieren

Mar 30, 2024 pm 12:26 PM

1. Öffnen Sie zunächst Weibo auf Ihrem Mobiltelefon und klicken Sie unten rechts auf [Ich] (wie im Bild gezeigt). 2. Klicken Sie dann oben rechts auf [Zahnrad], um die Einstellungen zu öffnen (wie im Bild gezeigt). 3. Suchen und öffnen Sie dann [Allgemeine Einstellungen] (wie im Bild gezeigt). 4. Geben Sie dann die Option [Video Follow] ein (wie im Bild gezeigt). 5. Öffnen Sie dann die Einstellung [Video-Upload-Auflösung] (wie im Bild gezeigt). 6. Wählen Sie abschließend [Originalbildqualität] aus, um eine Komprimierung zu vermeiden (wie im Bild gezeigt).

Wie veröffentliche ich Xiaohongshu-Videowerke? Worauf sollte ich beim Posten von Videos achten?

Mar 23, 2024 pm 08:50 PM

Wie veröffentliche ich Xiaohongshu-Videowerke? Worauf sollte ich beim Posten von Videos achten?

Mar 23, 2024 pm 08:50 PM

Mit dem Aufkommen von Kurzvideoplattformen ist Xiaohongshu für viele Menschen zu einer Plattform geworden, auf der sie ihr Leben teilen, sich ausdrücken und Traffic gewinnen können. Auf dieser Plattform ist die Veröffentlichung von Videoarbeiten eine sehr beliebte Art der Interaktion. Wie veröffentlicht man also Xiaohongshu-Videoarbeiten? 1. Wie veröffentliche ich Xiaohongshu-Videowerke? Stellen Sie zunächst sicher, dass Sie einen Videoinhalt zum Teilen bereit haben. Sie können zum Fotografieren Ihr Mobiltelefon oder eine andere Kameraausrüstung verwenden, Sie müssen jedoch auf die Bildqualität und die Klarheit des Tons achten. 2. Bearbeiten Sie das Video: Um die Arbeit attraktiver zu gestalten, können Sie das Video bearbeiten. Sie können professionelle Videobearbeitungssoftware wie Douyin, Kuaishou usw. verwenden, um Filter, Musik, Untertitel und andere Elemente hinzuzufügen. 3. Wählen Sie ein Cover: Das Cover ist der Schlüssel, um Benutzer zum Klicken zu bewegen. Wählen Sie ein klares und interessantes Bild als Cover, um Benutzer zum Klicken zu bewegen.

Das Geheimnis des Ausbrütens mobiler Dracheneier wird gelüftet (Schritt für Schritt erfahren Sie, wie Sie mobile Dracheneier erfolgreich ausbrüten)

May 04, 2024 pm 06:01 PM

Das Geheimnis des Ausbrütens mobiler Dracheneier wird gelüftet (Schritt für Schritt erfahren Sie, wie Sie mobile Dracheneier erfolgreich ausbrüten)

May 04, 2024 pm 06:01 PM

Mobile Spiele sind mit der Entwicklung der Technologie zu einem festen Bestandteil des Lebens der Menschen geworden. Mit seinem niedlichen Drachenei-Bild und dem interessanten Schlüpfvorgang hat es die Aufmerksamkeit vieler Spieler auf sich gezogen, und eines der Spiele, das viel Aufmerksamkeit erregt hat, ist die mobile Version von Dragon Egg. Um den Spielern dabei zu helfen, ihre eigenen Drachen im Spiel besser zu kultivieren und zu züchten, erfahren Sie in diesem Artikel, wie Sie Dracheneier in der mobilen Version ausbrüten. 1. Wählen Sie den geeigneten Drachenei-Typ aus, der Ihnen gefällt und zu Ihnen passt, basierend auf den verschiedenen Arten von Drachenei-Attributen und -Fähigkeiten, die im Spiel zur Verfügung stehen. 2. Verbessern Sie die Stufe der Brutmaschine, indem Sie Aufgaben erledigen und Requisiten sammeln. Die Stufe der Brutmaschine bestimmt die Schlüpfgeschwindigkeit und die Erfolgsquote beim Schlüpfen. 3. Sammeln Sie die Ressourcen, die die Spieler zum Schlüpfen benötigen

Schneller Meister: So eröffnen Sie zwei WeChat-Konten auf Huawei-Handys!

Mar 23, 2024 am 10:42 AM

Schneller Meister: So eröffnen Sie zwei WeChat-Konten auf Huawei-Handys!

Mar 23, 2024 am 10:42 AM

In der heutigen Gesellschaft sind Mobiltelefone zu einem unverzichtbaren Bestandteil unseres Lebens geworden. Als wichtiges Werkzeug für unsere tägliche Kommunikation, Arbeit und unser Leben wird WeChat häufig genutzt. Allerdings kann es bei der Abwicklung unterschiedlicher Transaktionen erforderlich sein, zwei WeChat-Konten zu trennen, was erfordert, dass das Mobiltelefon die gleichzeitige Anmeldung bei zwei WeChat-Konten unterstützt. Als bekannte inländische Marke werden Huawei-Mobiltelefone von vielen Menschen genutzt. Wie können also zwei WeChat-Konten auf Huawei-Mobiltelefonen eröffnet werden? Lassen Sie uns das Geheimnis dieser Methode lüften. Zunächst müssen Sie zwei WeChat-Konten gleichzeitig auf Ihrem Huawei-Mobiltelefon verwenden. Der einfachste Weg ist