Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Ein Artikel, der die Multisensorfusion für autonomes Fahren kurz analysiert

Ein Artikel, der die Multisensorfusion für autonomes Fahren kurz analysiert

Ein Artikel, der die Multisensorfusion für autonomes Fahren kurz analysiert

Was haben intelligente vernetzte Autos mit autonomem Fahren zu tun?

Der Kern des autonomen Fahrens liegt im Auto. Was ist also das intelligente Netzwerkverbindungssystem? Der Träger der intelligenten Netzwerkverbindung ist auch das Auto, aber der Kern ist das Netzwerk, das verbunden werden muss. Das eine ist ein Netzwerk aus Sensoren und intelligenten Steuerungssystemen im Auto, das andere ist ein Netzwerk, das alle Autos verbindet und gemeinsam nutzt. Bei der Netzwerkverbindung geht es darum, ein Auto in ein großes Netzwerk einzubinden, um wichtige Informationen wie Standort, Route, Geschwindigkeit und andere Informationen auszutauschen. Das Entwicklungsziel des intelligenten Netzwerksystems besteht darin, die Sicherheit und den Komfort des Autos durch das Design und die Optimierung der internen Sensoren und Steuerungssysteme des Autos zu verbessern und das Auto menschlicher zu machen. Das ultimative Ziel ist natürlich, fahrerlos zu werden Fahren.

Die drei Kernhilfssysteme autonomer Fahrzeuge: Umgebungswahrnehmungssystem, Entscheidungs- und Planungssystem sowie Steuerungs- und Ausführungssystem, die auch die intelligenten vernetzten Fahrzeuge sind Sie müssen selbst drei wichtige technische Probleme lösen.

Welche Rolle spielt das Umweltbewusstseinssystem im intelligenten Netzwerkverbindungssystem?

Was ist Umweltsensorik und was umfasst sie hauptsächlich?

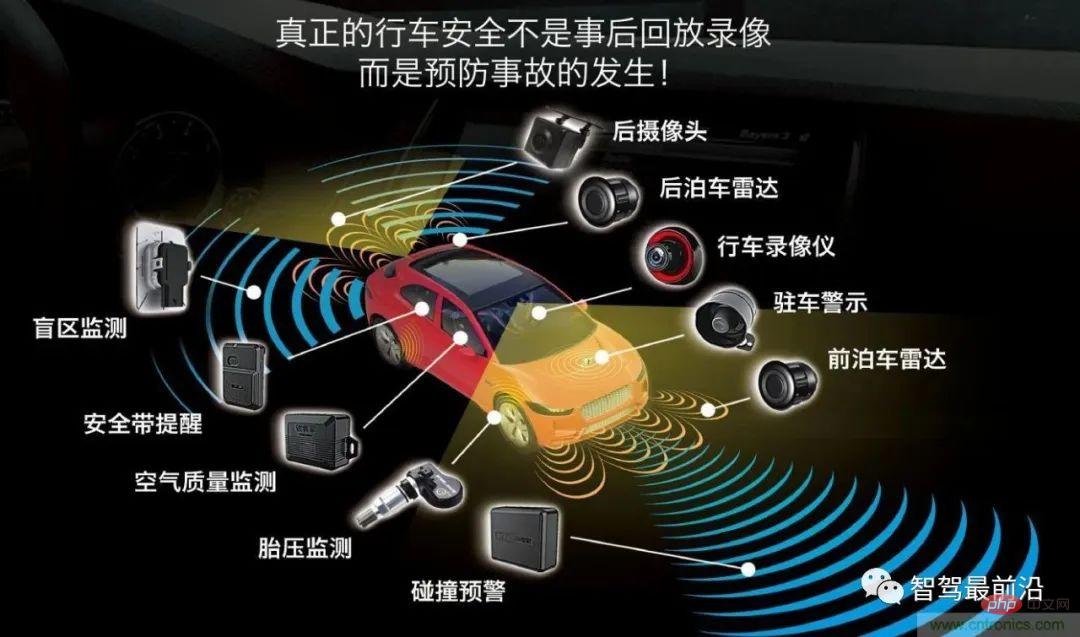

Die Umgebungswahrnehmung umfasst hauptsächlich drei Aspekte: Sensorik, Wahrnehmung und Positionierung. Zu den Sensoren gehören Kameras, Millimeterwellenradar, Lidar und Ultraschallwellen, die am Fahrzeug angebracht sind, um Daten zu sammeln, Farben zu identifizieren und Entfernungen zu messen.

Wenn ein intelligentes Auto die vom Sensor erhaltenen Daten nutzen möchte, um intelligentes Fahren zu erreichen, werden die durch den Sensor erhaltenen Daten verwendet Der Sensor muss eine (Wahrnehmungs-)Algorithmusverarbeitung durchlaufen, die in Datenergebnisse zusammengestellt wird, um den Austausch von Informationen über Fahrzeuge, Straßen, Personen usw. zu realisieren, damit Fahrzeuge automatisch analysieren können, ob das Fahrzeug sicher oder gefährlich fährt, sodass Fahrzeuge kann intelligentes Fahren nach den Wünschen der Menschen realisieren und letztendlich die Entscheidungsfindung und die Ziele des autonomen Fahrens ersetzen.

Dann wird es hier ein zentrales technisches Problem geben. Wie können die von mehreren Sensoren gescannten Daten zu vollständigen Objektbilddaten werden?

Multisensor-Fusionstechnologie

Die Hauptfunktion des Die Kamera erkennt die Objektfarbe, wird jedoch durch Regenwetter beeinträchtigt. Millimeterwellenradar kann die Nachteile von Kameras ausgleichen, die durch Regenwetter beeinträchtigt werden, und entfernte Hindernisse wie Fußgänger, Straßensperren usw. erkennen, kann dies jedoch nicht Identifizieren Sie die spezifische Form von Hindernissen. Laserradar kann den Mangel des Millimeterwellenradars ausgleichen, das die spezifische Form von Hindernissen nicht identifizieren kann . Um die von verschiedenen Sensoren gesammelten externen Daten zu fusionieren und dem Controller eine Entscheidungsgrundlage zu geben, ist es notwendig, den Multisensor-Fusionsalgorithmus zu einer Panoramawahrnehmung zu verarbeiten.

Was ist Multisensorfusion (Fusionsalgorithmusverarbeitung) und was sind die wichtigsten Fusionsalgorithmen?

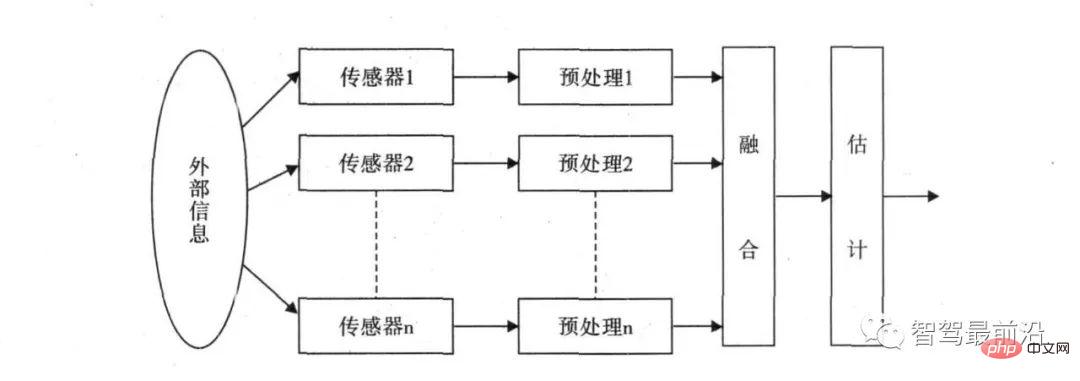

Das Grundprinzip der Multi-Sensor-Fusion ähnelt dem Prozess der umfassenden Informationsverarbeitung durch das menschliche Gehirn. Es nutzt verschiedene Sensoren, um mehrstufige und... Multi-Space-Informationsergänzung und optimierte Kombinationsverarbeitung. Das Ergebnis ist eine konsistente Interpretation der beobachteten Umgebung. In diesem Prozess müssen Daten aus mehreren Quellen für eine angemessene Kontrolle und Nutzung vollständig genutzt werden. Das ultimative Ziel der Informationsfusion besteht darin, durch Kombinationen von Informationen auf mehreren Ebenen und mit mehreren Aspekten auf der Grundlage der erhaltenen getrennten Beobachtungsinformationen nützlichere Informationen abzuleiten jeden Sensor. Dabei wird nicht nur der kooperative Betrieb mehrerer Sensoren genutzt, sondern auch Daten aus anderen Informationsquellen umfassend verarbeitet, um die Intelligenz des gesamten Sensorsystems zu verbessern.

Das Konzept der Multisensor-Datenfusion wurde erstmals im militärischen Bereich eingesetzt Bei der Entwicklung des autonomen Fahrens werden verschiedene Radargeräte zur Fahrzeugzielerkennung eingesetzt. Da verschiedene Sensoren Probleme mit der Datengenauigkeit haben, stellt sich die Frage, wie die endgültigen zusammengeführten Daten ermittelt werden können. Beispielsweise meldet das Lidar, dass der Abstand zum vorausfahrenden Fahrzeug 5 m beträgt, das Millimeterwellenradar meldet, dass der Abstand zum vorausfahrenden Fahrzeug 5,5 m beträgt, und die Kamera ermittelt, dass der Abstand zum vorausfahrenden Fahrzeug 4 m beträgt. Wie soll der Zentralprozessor das endgültige Urteil fällen? Dann ist eine Reihe von Multi-Data-Fusion-Algorithmen erforderlich, um dieses Problem zu lösen.

Häufig verwendete Methoden der Multisensorfusion werden in zwei Kategorien unterteilt: zufällige und künstliche Intelligenz. Die KI-Kategorie umfasst hauptsächlich Fuzzy-Logik-Methoden und künstliche neuronale Netzwerkmethoden. Zu den stochastischen Methoden gehören hauptsächlich Algorithmen wie Bayes-Filterung und Kalman-Filterung. Derzeit werden bei der Automobilfusionserkennung hauptsächlich Zufallsfusionsalgorithmen verwendet.

Der Fusionswahrnehmungsalgorithmus autonomer Fahrzeuge verwendet hauptsächlich den Kalman-Filteralgorithmus, der den Systemzustand mithilfe von Systemeingangs- und -ausgangsbeobachtungsdaten optimal abschätzt. Dies ist derzeit der beste Algorithmus zur Lösung der meisten Probleme effiziente Methode.

Mehrere Sensoren müssen von Fusionsalgorithmen verarbeitet werden, um das Problem der Multisensorfusion zu lösen. Die meisten Jobanforderungen in der Kategorie Fusionssensorik erfordern die Fähigkeit, mehrere zu beherrschen Das Funktionsprinzip und die Dateneigenschaften des Signals sowie die Fähigkeit, Fusionsalgorithmen für die Softwareentwicklung und Sensorkalibrierungsalgorithmen sowie Punktwolkendatenverarbeitung, Deep-Learning-Erkennungsalgorithmen usw. zu beherrschen.

Der dritte Teil der Umgebungswahrnehmung – Positionierung (Slam)

Slam wird als gleichzeitige Positionierung und Zuordnung bezeichnet. Dabei wird davon ausgegangen, dass die Szene statisch ist und die Bewegung der Kamera verwendet wird, um die Bildsequenz zu erhalten und die 3 zu erhalten -D-Szene. Strukturelles Design ist eine wichtige Aufgabe der Computer Vision. Die von der Kamera erhaltenen Daten werden von einem Algorithmus verarbeitet, der visuell ist.

Neben dem visuellen Slam umfassen die Methoden zur Positionierung des Umgebungsbewusstseins auch Lidar-Slam, GPS/IMU und hochpräzise Karten. Die von diesen Sensoren gewonnenen Daten müssen von Algorithmen verarbeitet werden, um Datenergebnisse zu erzeugen, die eine Standortinformationsgrundlage für autonome Fahrentscheidungen liefern. Wenn Sie daher im Bereich der Umweltwahrnehmung arbeiten möchten, können Sie nicht nur die Position des Fusion-Sensing-Algorithmus, sondern auch das Slam-Feld auswählen.

Das obige ist der detaillierte Inhalt vonEin Artikel, der die Multisensorfusion für autonomes Fahren kurz analysiert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Oben geschrieben und persönliches Verständnis des Autors. Dreidimensionales Gaussplatting (3DGS) ist eine transformative Technologie, die in den letzten Jahren in den Bereichen explizite Strahlungsfelder und Computergrafik entstanden ist. Diese innovative Methode zeichnet sich durch die Verwendung von Millionen von 3D-Gaußkurven aus, was sich stark von der Neural Radiation Field (NeRF)-Methode unterscheidet, die hauptsächlich ein implizites koordinatenbasiertes Modell verwendet, um räumliche Koordinaten auf Pixelwerte abzubilden. Mit seiner expliziten Szenendarstellung und differenzierbaren Rendering-Algorithmen garantiert 3DGS nicht nur Echtzeit-Rendering-Fähigkeiten, sondern führt auch ein beispielloses Maß an Kontrolle und Szenenbearbeitung ein. Dies positioniert 3DGS als potenziellen Game-Changer für die 3D-Rekonstruktion und -Darstellung der nächsten Generation. Zu diesem Zweck geben wir erstmals einen systematischen Überblick über die neuesten Entwicklungen und Anliegen im Bereich 3DGS.

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich während des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt hätte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randfälle bei autonomen Fahrzeugen, also mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschränken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gelöst, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschränkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen gehören eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der „Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randfälle in autonomen Fahrzeugen (AVs). Randfälle sind mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

0. Vorab geschrieben&& Persönliches Verständnis, dass autonome Fahrsysteme auf fortschrittlichen Wahrnehmungs-, Entscheidungs- und Steuerungstechnologien beruhen, indem sie verschiedene Sensoren (wie Kameras, Lidar, Radar usw.) verwenden, um die Umgebung wahrzunehmen, und Algorithmen und Modelle verwenden für Echtzeitanalysen und Entscheidungsfindung. Dies ermöglicht es Fahrzeugen, Verkehrszeichen zu erkennen, andere Fahrzeuge zu erkennen und zu verfolgen, das Verhalten von Fußgängern vorherzusagen usw. und sich so sicher an komplexe Verkehrsumgebungen anzupassen. Diese Technologie erregt derzeit große Aufmerksamkeit und gilt als wichtiger Entwicklungsbereich für die Zukunft des Transportwesens . eins. Aber was autonomes Fahren schwierig macht, ist herauszufinden, wie man dem Auto klarmachen kann, was um es herum passiert. Dies erfordert, dass der dreidimensionale Objekterkennungsalgorithmus im autonomen Fahrsystem Objekte in der Umgebung, einschließlich ihrer Standorte, genau wahrnehmen und beschreiben kann.

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

Originaltitel: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Paper-Link: https://arxiv.org/pdf/2402.02519.pdf Code-Link: https://github.com/HKUST-Aerial-Robotics/SIMPL Autor: Hong Kong University of Science und Technologie DJI-Papieridee: Dieses Papier schlägt eine einfache und effiziente Bewegungsvorhersagebasislinie (SIMPL) für autonome Fahrzeuge vor. Im Vergleich zum herkömmlichen Agent-Cent

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

Vorab geschrieben und Ausgangspunkt Das End-to-End-Paradigma verwendet ein einheitliches Framework, um Multitasking in autonomen Fahrsystemen zu erreichen. Trotz der Einfachheit und Klarheit dieses Paradigmas bleibt die Leistung von End-to-End-Methoden für das autonome Fahren bei Teilaufgaben immer noch weit hinter Methoden für einzelne Aufgaben zurück. Gleichzeitig erschweren die in früheren End-to-End-Methoden weit verbreiteten Funktionen der dichten Vogelperspektive (BEV) die Skalierung auf mehr Modalitäten oder Aufgaben. Hier wird ein Sparse-Search-zentriertes End-to-End-Paradigma für autonomes Fahren (SparseAD) vorgeschlagen, bei dem die Sparse-Suche das gesamte Fahrszenario, einschließlich Raum, Zeit und Aufgaben, ohne dichte BEV-Darstellung vollständig abbildet. Insbesondere ist eine einheitliche, spärliche Architektur für die Aufgabenerkennung einschließlich Erkennung, Verfolgung und Online-Zuordnung konzipiert. Zudem schwer

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Im vergangenen Monat hatte ich aus bekannten Gründen einen sehr intensiven Austausch mit verschiedenen Lehrern und Mitschülern der Branche. Ein unvermeidliches Thema im Austausch ist natürlich End-to-End und der beliebte Tesla FSDV12. Ich möchte diese Gelegenheit nutzen, einige meiner aktuellen Gedanken und Meinungen als Referenz und Diskussion darzulegen. Wie definiert man ein durchgängiges autonomes Fahrsystem und welche Probleme sollten voraussichtlich durchgängig gelöst werden? Gemäß der traditionellsten Definition bezieht sich ein End-to-End-System auf ein System, das Rohinformationen von Sensoren eingibt und für die Aufgabe relevante Variablen direkt ausgibt. Bei der Bilderkennung kann CNN beispielsweise als End-to-End bezeichnet werden, verglichen mit der herkömmlichen Methode zum Extrahieren von Merkmalen + Klassifizieren. Bei autonomen Fahraufgaben werden Eingabedaten verschiedener Sensoren (Kamera/LiDAR) benötigt