Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Entfernen Sie Hautunreinheiten und Falten mit einem Klick: Detaillierte Interpretation des hochauflösenden Porträt-Hautschönheitsmodells ABPN der DAMO Academy

Entfernen Sie Hautunreinheiten und Falten mit einem Klick: Detaillierte Interpretation des hochauflösenden Porträt-Hautschönheitsmodells ABPN der DAMO Academy

Entfernen Sie Hautunreinheiten und Falten mit einem Klick: Detaillierte Interpretation des hochauflösenden Porträt-Hautschönheitsmodells ABPN der DAMO Academy

Mit der boomenden Entwicklung der digitalen Kulturindustrie wird die Technologie der künstlichen Intelligenz zunehmend im Bereich der Bildbearbeitung und -verschönerung eingesetzt. Unter diesen ist die Hautverschönerung von Porträts zweifellos eine der am weitesten verbreiteten und gefragtesten Technologien. Herkömmliche Schönheitsalgorithmen nutzen filterbasierte Bildbearbeitungstechnologie, um automatisierte Hauterneuerungs- und Hautunreinheiten-Entfernungseffekte zu erzielen, und werden häufig in sozialen Netzwerken, Live-Übertragungen und anderen Szenarien eingesetzt.

In der professionellen Fotobranche mit hohen Schwellenwerten sind jedoch aufgrund der hohen Anforderungen an Bildauflösung und Qualitätsstandards immer noch manuelle Retuschierer die Hauptproduktivität der Porträt-Hautretusche, einschließlich Hautglättung und Hautunreinheitenentfernung, Aufhellung usw Reihe anderer Aufgaben. Normalerweise beträgt die durchschnittliche Bearbeitungszeit für die Hautverschönerung eines hochauflösenden Porträts durch einen professionellen Retuscheur 1–2 Minuten. In Bereichen wie Werbung, Film und Fernsehen, die eine höhere Genauigkeit erfordern, ist die Bearbeitungszeit länger.

Im Vergleich zur Hauterneuerung in interaktiven Unterhaltungsszenen stellt die verfeinerte Hautverschönerung auf Werbe- und Studioebene höhere Anforderungen und Herausforderungen an den Algorithmus. Einerseits gibt es viele Arten von Hautunreinheiten, darunter Akne, Akneflecken, Sommersprossen, ungleichmäßiger Hautton usw Die Haut muss so weit wie möglich erhalten bleiben, ihre Textur verbessern und eine hochpräzise Hautmodifikation erreichen. Nicht zuletzt hat die in der professionellen Fotografie übliche Bildauflösung 4K oder sogar 8K erreicht stellt große Anforderungen an die Verarbeitungseffizienz des Algorithmus.

Ausgehend von der Erzielung einer intelligenten Hautverschönerung auf professionellem Niveau haben wir daher eine Reihe ultrafeiner lokaler Retuschealgorithmen ABPN für hochauflösende Bilder entwickelt, die sowohl bei der Hautverschönerung als auch bei der Faltenentfernung in Kleidung implementiert wurden Aufgaben in ultraklaren Bildern. Sehr gute Ergebnisse und Anwendungen.

- Papier: https://openaccess.thecvf.com/content/CVPR2022/papers/Lei_ABPN_Adaptive_Blend_Pyramid_Network_for_Real-Time_Local_Retouching_of_CVPR_2022_paper.pdf

- Modell & Code: https://www.model Scope.c n/models/damo/ cv_unet_skin-retouching/summary

Verwandte Arbeit

3.1 Traditioneller Schönheitsalgorithmus

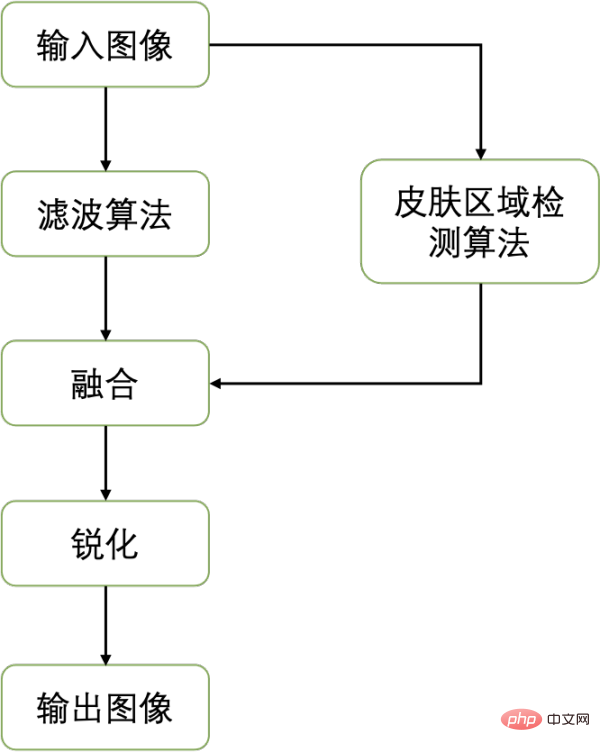

Der Kern des traditionellen Schönheitsalgorithmus besteht darin, die Pixel im Hautbereich glatter zu machen und die Auffälligkeit von Defekten zu reduzieren, wodurch er hergestellt wird Die Haut sieht glatter aus. Im Allgemeinen können bestehende Verschönerungsalgorithmen in drei Schritte unterteilt werden: 1) Bildfilteralgorithmus, 2) Bildfusion und 3) Schärfung. Der Gesamtprozess ist wie folgt:

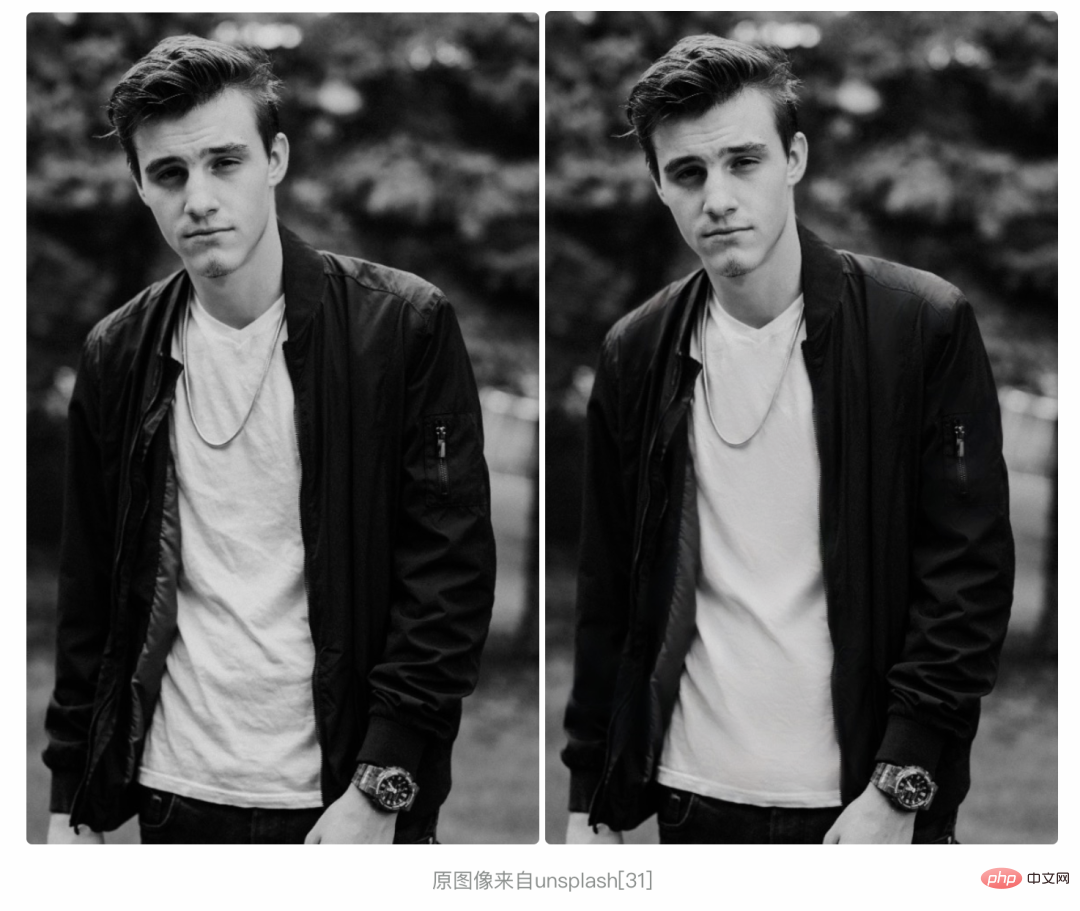

Um den Hautbereich zu glätten und gleichzeitig die Kanten im Bild beizubehalten, verwendet der traditionelle Schönheitsalgorithmus zunächst kantenerhaltende Filter (z. B. bilaterale Filterung, geführte Filterung usw.). ), um das Bild zu verarbeiten. Im Gegensatz zum häufig verwendeten Mittelwertfilter und Gaußschen Filter berücksichtigt der kantenerhaltende Filter die Änderungen der Pixelwerte in verschiedenen Bereichen und verwendet unterschiedliche Gewichte für die Kantenteile mit großen Pixeländerungen und die Pixel im mittleren Bereich mit sanfte Veränderungen, wodurch die Bildkantenreserve erreicht wird. Um den Hintergrundbereich nicht zu beeinträchtigen, werden dann normalerweise Segmentierungserkennungsalgorithmen verwendet, um den Hautbereich zu lokalisieren und die Fusion des Originalbilds und des geglätteten Bilds zu steuern. Schließlich kann das Schärfen die Hervorhebung der Kanten und die sensorische Klarheit weiter verbessern. Das folgende Bild zeigt die Wirkung des aktuellen traditionellen Schönheitsalgorithmus:

Das Originalbild stammt von unsplash [31]

Aus Sicht der Wirkung gibt es zwei Hauptprobleme Der traditionelle Schönheitsalgorithmus: 1) Die Verarbeitung von Fehlern ist nicht adaptiv und kann verschiedene Arten von Fehlern nicht gut verarbeiten. 2) Die Glättungsbehandlung führt zum Verlust der Hautstruktur und -textur. Diese Probleme machen sich besonders bei hochauflösenden Bildern bemerkbar.

3.2 Bestehende Deep-Learning-Algorithmen

Um eine adaptive Modifikation verschiedener Hautbereiche und unterschiedlicher Schönheitsfehler zu erreichen, scheinen datengesteuerte Deep-Learning-Algorithmen eine bessere Lösung zu sein. Unter Berücksichtigung der Relevanz der Aufgabe diskutierten und verglichen wir die Anwendbarkeit von vier bestehenden Methoden: Bild-zu-Bild-Übersetzung, Fotoretusche, Bildinpainting und hochauflösende Bildbearbeitung für Hautverschönerungsaufgaben.

- 3.2.1 Bild-zu-Bild Übersetzung

Bild-zu-Bild Übersetzung) Aufgabe war ursprünglich von pix2pix [1] definiert, das eine große Anzahl von Computer-Vision-Aufgaben in Pixel-zu-Pixel-Vorhersageaufgaben zusammenfasst und einen allgemeinen Rahmen vorschlägt, der auf bedingten generativen gegnerischen Netzwerken basiert, um solche Probleme zu lösen. Basierend auf pix2pix [1] wurden verschiedene Methoden zur Lösung des Bildübersetzungsproblems vorgeschlagen, darunter Methoden mit gepaarten Bildern [2, 3, 4, 5] und Methoden mit ungepaarten Bildern [6,7,8,9]. Einige Arbeiten konzentrieren sich auf bestimmte spezifische Bildübersetzungsaufgaben (z. B. semantische Bildsynthese [2, 3, 5], Stilübertragung usw. [9, 10, 11, 12]) und haben beeindruckende Ergebnisse erzielt. Die meisten der oben genannten Bildübersetzungen konzentrieren sich jedoch hauptsächlich auf die Gesamttransformation von Bild zu Bild und berücksichtigen nicht die lokalen Bereiche, was ihre Leistung bei Hautverschönerungsaufgaben einschränkt. Profitieren Sie von tiefen Faltungen Die Entwicklung neuronaler Netze und lernbasierter Methoden [13, 14, 15, 16] haben in den letzten Jahren hervorragende Ergebnisse im Bereich der Bildretusche gezeigt. Allerdings konzentrieren sich bestehende Retuschealgorithmen, ähnlich wie die meisten Bildübersetzungsmethoden, hauptsächlich auf die Manipulation einiger Gesamteigenschaften des Bildes, wie z. B. Farbe, Beleuchtung, Belichtung usw. Der Retusche lokaler Bereiche wird wenig Aufmerksamkeit geschenkt, und die Hautretusche ist genau eine lokale Retuscheaufgabe (lokale Fotoretusche), die eine Retusche des Zielbereichs erfordert, während der Hintergrundbereich unverändert bleibt.

- 3.2.3 Bild-Inpainting

Bildvervollständigung (Bild-Inpainting )-Algorithmus wird häufig verwendet, um die fehlenden Teile des Bildes zu vervollständigen, und weist große Ähnlichkeit mit der Aufgabe der Hautverschönerung auf. Mit leistungsstarken Feature-Learning-Funktionen haben Methoden, die auf tiefen generativen Netzwerken basieren [17, 18, 19, 20], in den letzten Jahren große Fortschritte bei Inpainting-Aufgaben gemacht. Allerdings basieren Inpainting-Methoden auf der Maske des Zielbereichs als Eingabe, und bei der Hautverschönerung und anderen lokalen Modifikationsaufgaben ist das Erhalten einer genauen Zielbereichsmaske selbst eine sehr anspruchsvolle Aufgabe. Daher können die meisten Bild-Inpainting-Aufgaben nicht direkt zur Hautverschönerung verwendet werden. In den letzten Jahren haben einige Blindbild-Inpainting-Methoden [21, 22, 23] ihre Abhängigkeit von Masken beseitigt und eine automatische Erkennung und Vervollständigung von Zielbereichen erreicht. Dennoch weisen diese Methoden, wie die meisten anderen Bild-Inpainting-Methoden, zwei Probleme auf: a) mangelnde vollständige Nutzung der Textur- und semantischen Informationen des Zielbereichs und b) große Rechenkomplexität und Schwierigkeiten bei der Anwendung auf Bilder mit ultrahoher Auflösung.

- 3.2.4 Hochauflösende Bildbearbeitung

In der Reihenfolge Um die Bearbeitung hochauflösender Bilder zu erreichen, reduzieren Methoden wie [15, 24, 25, 26] die räumliche und zeitliche Belastung, indem sie die Hauptrechenlast von hochauflösenden Bildern auf Bilder mit niedriger Auflösung übertragen. Obwohl sie hinsichtlich der Effizienz eine hervorragende Leistung erzielen, sind die meisten dieser Methoden aufgrund der mangelnden Berücksichtigung lokaler Bereiche nicht für lokale Modifikationsaufgaben wie die Hautverschönerung geeignet. Zusammenfassend lässt sich sagen, dass es schwierig ist, die meisten vorhandenen Deep-Learning-Methoden direkt auf Hautverschönerungsaufgaben anzuwenden. Der Hauptgrund dafür ist, dass sie nicht auf lokale Bereiche eingehen oder große Berechnungsmengen erfordern und sich nur schwer auf hochauflösende Bilder anwenden lassen.

- Lokales Retusche-Framework basierend auf einer adaptiven Mischpyramide

- Die Essenz der Hautschönheit liegt in der Bearbeitung von Bildern, die sich von den meisten anderen unterscheidet Bildtransformationen Die Sache ist, dass diese Bearbeitung lokal ist. Ähnlich dazu gibt es Aufgaben wie Faltenbeseitigung an Kleidung und Produktmodifikation. Diese Art der lokalen Bildretusche weist starke Gemeinsamkeiten auf. Wir fassen die drei Hauptschwierigkeiten und Herausforderungen zusammen: 1) Genaue Positionierung des Zielbereichs. 2) Lokale Generierung (Änderung) mit globaler Konsistenz und Detailtreue. 3) Bildverarbeitung mit ultrahoher Auflösung. Zu diesem Zweck schlagen wir ein lokales Retusche-Framework vor, das auf Adaptive Blend Pyramid (ABPN: Adaptive Blend Pyramid Network for Real-Time Local Retouching of Ultra High-Resolution Photo, CVPR2022,[27]) basiert, um eine ultrahohe Auflösung für verfeinerte lokale Bilder zu erreichen Retusche von Bildern, wir werden die Details zur Umsetzung unten vorstellen.

4.1 Gesamtnetzwerkstruktur

Wie in der Abbildung oben gezeigt, besteht die Netzwerkstruktur hauptsächlich aus zwei Teilen: der kontextbewussten lokalen Modifikationsschicht (LRL) und der adaptiven Mischpyramidenschicht (BPL). Der Zweck von LRL besteht darin, das heruntergesampelte Bild mit niedriger Auflösung lokal zu modifizieren und ein Ergebnisbild mit niedriger Auflösung zu generieren, wobei die globalen Kontextinformationen und lokalen Texturinformationen vollständig berücksichtigt werden. Darüber hinaus wird BPL verwendet, um die in LRL generierten Ergebnisse mit niedriger Auflösung schrittweise auf Ergebnisse mit hoher Auflösung zu skalieren. Unter anderem haben wir ein adaptives Mischmodul (ABM) und sein Umkehrmodul (R-ABM) entwickelt. Mithilfe der Zwischenmischschicht Bi können wir eine adaptive Konvertierung und Aufwärtserweiterung zwischen dem Originalbild und dem Ergebnisbild realisieren und so eine leistungsstarke Skalierbarkeit aufweisen und Detailtreuefunktionen. Wir haben eine große Anzahl von Experimenten in den beiden Datensätzen Gesichtsmodifikation und Kleidungsmodifikation durchgeführt und die Ergebnisse zeigen, dass unsere Methode den bestehenden Methoden in Bezug auf Wirksamkeit und Effizienz deutlich voraus ist. Es ist erwähnenswert, dass unser Modell die Echtzeit-Inferenz von 4K-Bildern mit ultrahoher Auflösung auf einer einzigen P100-Karte erreicht. Im Folgenden stellen wir LRL, BPL bzw. Netzwerktrainingsverlust vor.

4.2 Kontextbewusste lokale Retuscheschicht

In LRL wollen wir die beiden in 3 genannten Herausforderungen lösen: präzise Positionierung des Zielbereichs und globale Sichtbarkeit Konsistente lokale Generierung. Wie in Abbildung 3 dargestellt, besteht LRL aus einem gemeinsamen Encoder, einem Maskenvorhersagezweig (MPB) und einem lokalen Modifikationszweig (LRB).

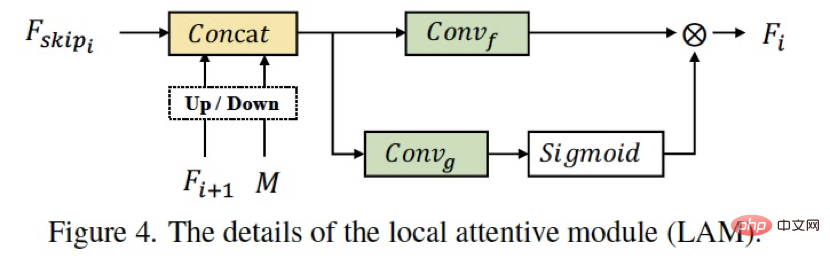

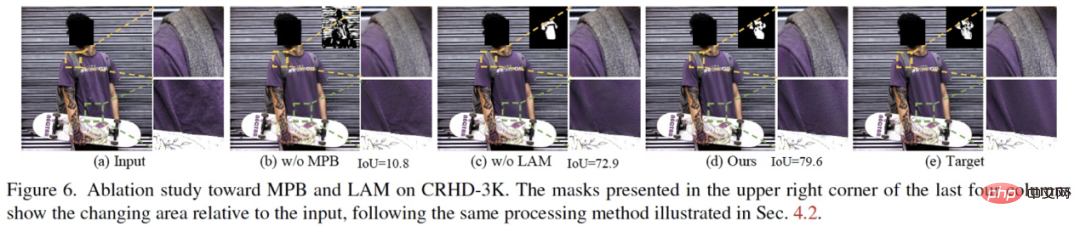

Im Allgemeinen verwenden wir eine Multi-Task-Struktur, um eine explizite Zielbereichsvorhersage und lokale Änderungsanleitung zu erreichen. Unter anderem kann die Struktur des gemeinsam genutzten Encoders das gemeinsame Training der beiden Zweige nutzen, um Funktionen zu optimieren und die globalen semantischen Informationen des Änderungszweigs und die lokale Wahrnehmung des Ziels zu verbessern. Die meisten Bildübersetzungsmethoden verwenden die traditionelle Encoder-Decoder-Struktur, um die lokale Bearbeitung direkt zu implementieren, ohne die Zielpositionierung und -generierung zu entkoppeln, wodurch der Generierungseffekt begrenzt wird (die Kapazität des Netzwerks ist im Gegensatz dazu begrenzt). Aufgabenentkopplung und gegenseitiger Nutzen. Im lokalen Modifikationszweig LRB haben wir LAM entworfen (Abbildung 4), das den räumlichen Aufmerksamkeitsmechanismus und den Merkmalsaufmerksamkeitsmechanismus gleichzeitig verwendet, um eine vollständige Verschmelzung von Merkmalen und die Erfassung der Semantik und Textur des Zielbereichs zu erreichen. Das Ablationsexperiment (Abbildung 6) demonstriert die Wirksamkeit jedes Moduldesigns.

4.3 Adaptive Blend Pyramid Layer

LRL implementiert lokale Modifikation bei niedriger Auflösung. Wie kann man das Ergebnis der Modifikation auf eine hohe Auflösung erweitern und gleichzeitig die Detailtreue verbessern? Dies ist das Problem, das wir in diesem Teil lösen wollen.

- 4.3.1 Adaptive Blend-Modul

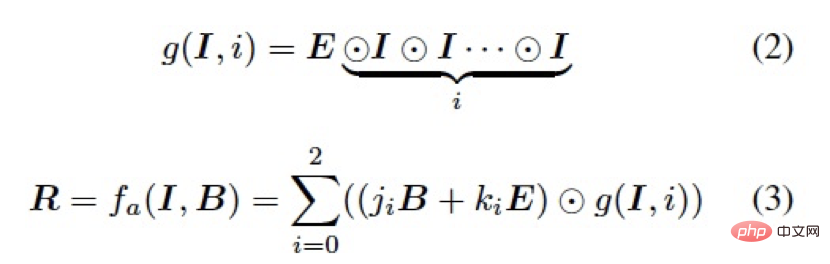

Im Bereich der Bildbearbeitung wird die Mischebene häufig zum Mischen mit dem Bild (Basisebene) in verschiedenen Modi verwendet, um eine Vielzahl von Bildbearbeitungsaufgaben zu erreichen. wie Kontrastverstärkungs-, Vertiefungs- und Aufhellungsoperationen usw. Im Allgemeinen können wir bei einem gegebenen Bild  und einer Mischebene

und einer Mischebene  die beiden Ebenen mischen, um das Bildbearbeitungsergebnis

die beiden Ebenen mischen, um das Bildbearbeitungsergebnis  wie folgt zu erhalten:

wie folgt zu erhalten:

wobei f eine feste Schritt-für-Schritt-Pixelzuordnung ist Funktion, die normalerweise durch den Mischmodus bestimmt wird. Aufgrund der Konvertierungsfähigkeit ist es schwierig, einen bestimmten Mischmodus und eine feste Funktion f direkt auf eine Vielzahl von Bearbeitungsaufgaben anzuwenden. Um uns besser an die Datenverteilung und die Konvertierungsmodi verschiedener Aufgaben anzupassen, haben wir auf den in der Bildbearbeitung häufig verwendeten Soft-Light-Modus zurückgegriffen und ein adaptives Mischmodul (ABM) wie folgt entwickelt:

stellt das Hadmard-Produkt dar, und sind lernbare Parameter, die gemeinsam genutzt werden Von allen ABM-Modulen im Netzwerk und den folgenden R-ABM-Modulen repräsentiert alle konstanten Matrizen mit einem Wert von 1.

- 4.3.2 Reverse Adaptive Blend Modul

#🎜🎜 #, um die gemischte Schicht B zu erhalten, lösen wir Formel 3 und konstruieren ein umgekehrtes adaptives Mischmodul (R-ABM) wie folgt: #🎜 🎜##🎜 🎜#

Im Allgemeinen erzielen das ABM-Modul und das R-ABM-Modul durch die Verwendung der Mischschicht als Vermittler das Bild I und das Ergebnis R. Adaptive Konvertierung zwischen den beiden, verglichen Um die Ergebnisse mit niedriger Auflösung direkt zu erweitern, indem wir Operationen wie Faltungs-Upsampling (wie Pix2PixHD) verwenden, verwenden wir Hybridschichten, um dieses Ziel zu erreichen, was zwei Vorteile hat: 1) Bei der lokalen Änderungsaufgabe zeichnet die Hybridschicht hauptsächlich die lokale Transformation auf Informationen zwischen zwei Bildern, was bedeutet, dass sie weniger irrelevante Informationen enthalten und durch ein leichtgewichtiges Netzwerk leichter optimiert werden können. 2) Die Mischschicht wirkt direkt auf das Originalbild, um die endgültige Änderung zu erreichen. Dabei können die Informationen des Bildes selbst vollständig genutzt werden, wodurch ein hohes Maß an Detailtreue erreicht wird.

Im Allgemeinen erzielen das ABM-Modul und das R-ABM-Modul durch die Verwendung der Mischschicht als Vermittler das Bild I und das Ergebnis R. Adaptive Konvertierung zwischen den beiden, verglichen Um die Ergebnisse mit niedriger Auflösung direkt zu erweitern, indem wir Operationen wie Faltungs-Upsampling (wie Pix2PixHD) verwenden, verwenden wir Hybridschichten, um dieses Ziel zu erreichen, was zwei Vorteile hat: 1) Bei der lokalen Änderungsaufgabe zeichnet die Hybridschicht hauptsächlich die lokale Transformation auf Informationen zwischen zwei Bildern, was bedeutet, dass sie weniger irrelevante Informationen enthalten und durch ein leichtgewichtiges Netzwerk leichter optimiert werden können. 2) Die Mischschicht wirkt direkt auf das Originalbild, um die endgültige Änderung zu erreichen. Dabei können die Informationen des Bildes selbst vollständig genutzt werden, wodurch ein hohes Maß an Detailtreue erreicht wird.

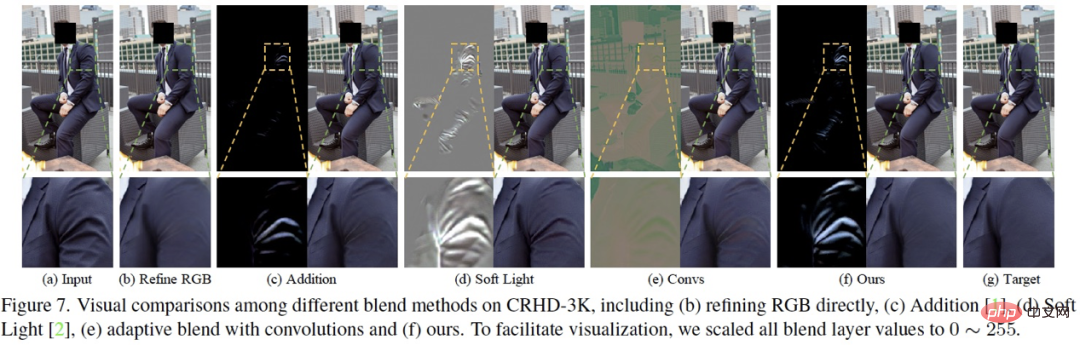

Tatsächlich gibt es viele alternative Funktionen oder Strategien für das adaptive Hybridmodul, die wir im Artikel beschreiben Die Motivation für das Design und der Vergleich mit anderen Lösungen werden im Detail vorgestellt und hier nicht weiter ausgeführt. Abbildung 7 zeigt den Ablationsvergleich zwischen unserer Methode und anderen Hybridmethoden.

Tatsächlich gibt es viele alternative Funktionen oder Strategien für das adaptive Hybridmodul, die wir im Artikel beschreiben Die Motivation für das Design und der Vergleich mit anderen Lösungen werden im Detail vorgestellt und hier nicht weiter ausgeführt. Abbildung 7 zeigt den Ablationsvergleich zwischen unserer Methode und anderen Hybridmethoden.

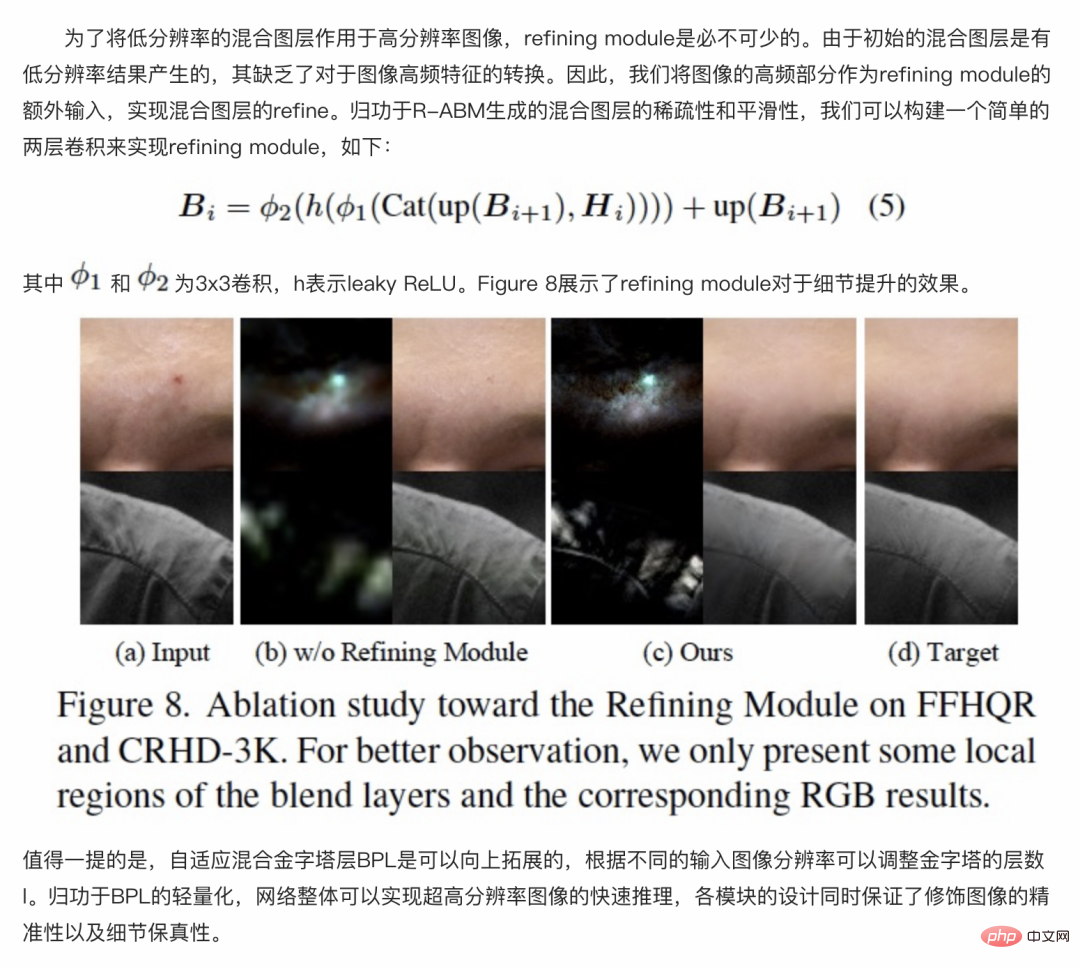

4.3.3 Verfeinerungsmodul

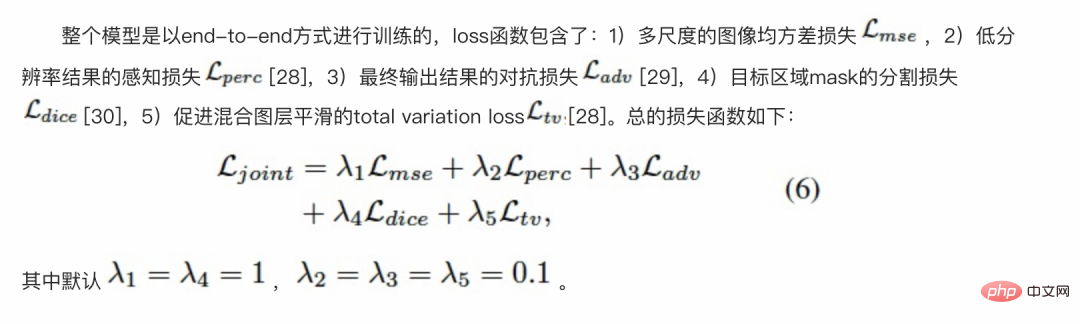

# ###### 🎜🎜#4.4 Verlustfunktion ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜

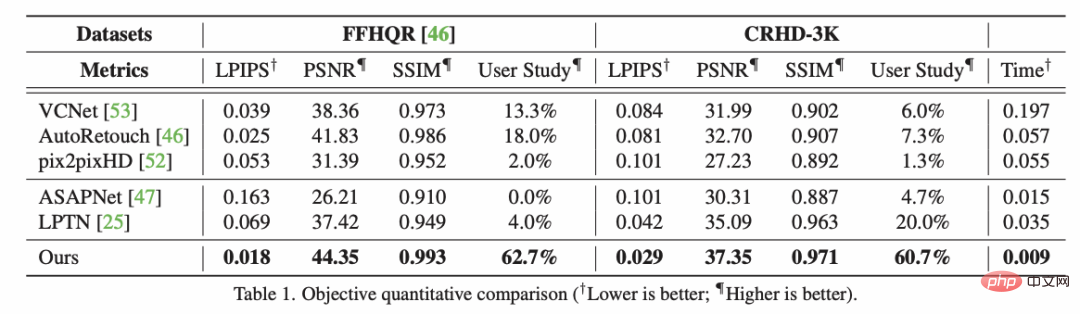

🎜🎜 ## 🎜. 🎜# #🎜 🎜 #5.1 Vergleich mit der SOTA-Methode

#🎜 🎜 #5.1 Vergleich mit der SOTA-Methode

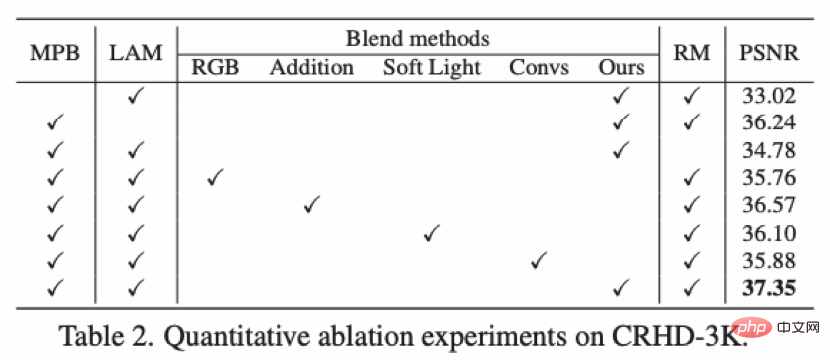

#🎜 🎜 #5.2 Ablationsexperiment # 🎜🎜#

# 🎜🎜#

5.3 Laufgeschwindigkeit und Speicherverbrauch

# 🎜🎜#

EffektanzeigeBeauty-Effektanzeige: #🎜🎜 #

# 🎜🎜#

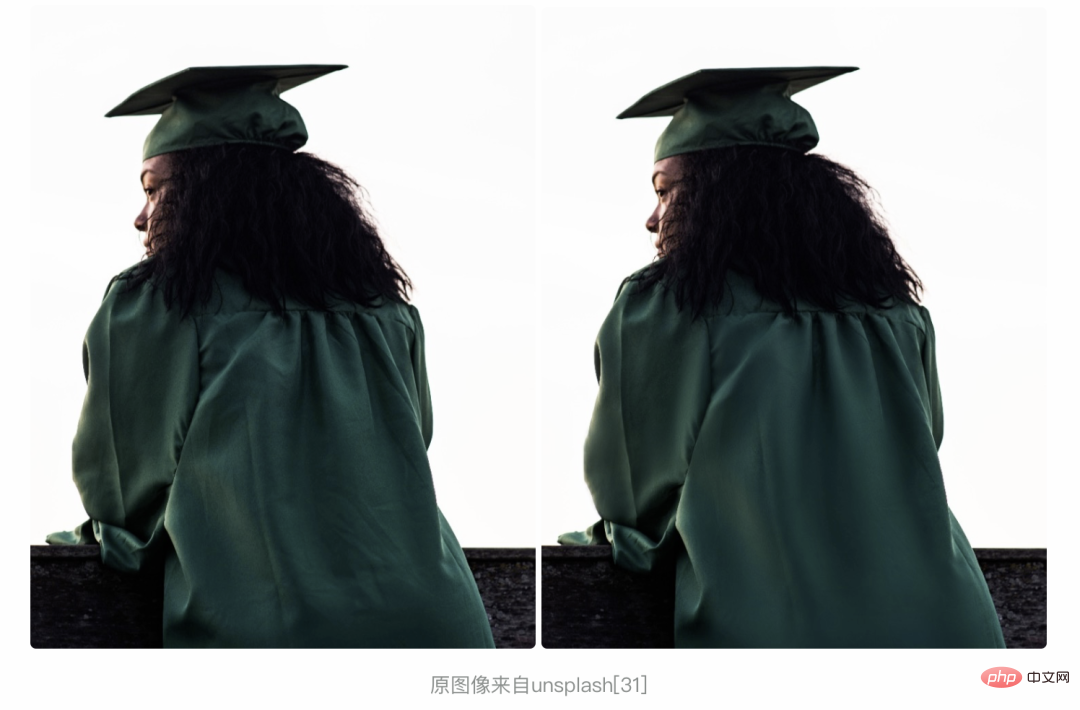

Originalbild von Unsplash [31]#🎜 🎜#

Das Originalbild stammt aus dem Gesichtsdatensatz FFHQ [32]# 🎜🎜#

Es ist ersichtlich, dass das von uns vorgeschlagene lokale Retusche-Framework im Vergleich zum herkömmlichen Schönheitsalgorithmus die Textur und Textur der Haut vollständig beibehält und gleichzeitig Hautfehler beseitigt, wodurch eine feine und intelligente Hautoptimierung erreicht wird. Darüber hinaus haben wir diese Methode auf den Bereich der Faltenentfernung in Kleidung ausgeweitet und folgende gute Ergebnisse erzielt:

Das obige ist der detaillierte Inhalt vonEntfernen Sie Hautunreinheiten und Falten mit einem Klick: Detaillierte Interpretation des hochauflösenden Porträt-Hautschönheitsmodells ABPN der DAMO Academy. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1386

1386

52

52

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

Die Installation von MySQL auf CentOS umfasst die folgenden Schritte: Hinzufügen der entsprechenden MySQL Yum -Quelle. Führen Sie den Befehl mySQL-server aus, um den MySQL-Server zu installieren. Verwenden Sie den Befehl mySQL_SECURE_INSTALLATION, um Sicherheitseinstellungen vorzunehmen, z. B. das Festlegen des Stammbenutzerkennworts. Passen Sie die MySQL -Konfigurationsdatei nach Bedarf an. Tune MySQL -Parameter und optimieren Sie Datenbanken für die Leistung.

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

Eine vollständige Anleitung zum Anzeigen von GitLab -Protokollen unter CentOS -System In diesem Artikel wird in diesem Artikel verschiedene GitLab -Protokolle im CentOS -System angezeigt, einschließlich Hauptprotokolle, Ausnahmebodi und anderen zugehörigen Protokollen. Bitte beachten Sie, dass der Log -Dateipfad je nach GitLab -Version und Installationsmethode variieren kann. Wenn der folgende Pfad nicht vorhanden ist, überprüfen Sie bitte das GitLab -Installationsverzeichnis und die Konfigurationsdateien. 1. Zeigen Sie das Hauptprotokoll an. Verwenden Sie den folgenden Befehl, um die Hauptprotokolldatei der GitLabRails-Anwendung anzuzeigen: Befehl: Sudocat/var/log/gitlab/gitlab-rails/production.log Dieser Befehl zeigt das Produkt an

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Pytorch Distributed Training on CentOS -System erfordert die folgenden Schritte: Pytorch -Installation: Die Prämisse ist, dass Python und PIP im CentOS -System installiert sind. Nehmen Sie abhängig von Ihrer CUDA -Version den entsprechenden Installationsbefehl von der offiziellen Pytorch -Website ab. Für CPU-Schulungen können Sie den folgenden Befehl verwenden: PipinstallTorChTorChVisionTorChaudio Wenn Sie GPU-Unterstützung benötigen, stellen Sie sicher, dass die entsprechende Version von CUDA und CUDNN installiert ist und die entsprechende Pytorch-Version für die Installation verwenden. Konfiguration der verteilten Umgebung: Verteiltes Training erfordert in der Regel mehrere Maschinen oder mehrere Maschinen-Mehrfach-GPUs. Ort

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Docker verwendet Linux -Kernel -Funktionen, um eine effiziente und isolierte Anwendungsumgebung zu bieten. Sein Arbeitsprinzip lautet wie folgt: 1. Der Spiegel wird als schreibgeschützte Vorlage verwendet, die alles enthält, was Sie für die Ausführung der Anwendung benötigen. 2. Das Union File System (UnionFS) stapelt mehrere Dateisysteme, speichert nur die Unterschiede, speichert Platz und beschleunigt. 3. Der Daemon verwaltet die Spiegel und Container, und der Kunde verwendet sie für die Interaktion. 4. Namespaces und CGroups implementieren Container -Isolation und Ressourcenbeschränkungen; 5. Mehrere Netzwerkmodi unterstützen die Containerverbindung. Nur wenn Sie diese Kernkonzepte verstehen, können Sie Docker besser nutzen.

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek: